メタデータインポートを使って複数のデータソースから一括でメタデータを取り込む

この記事の位置づけ

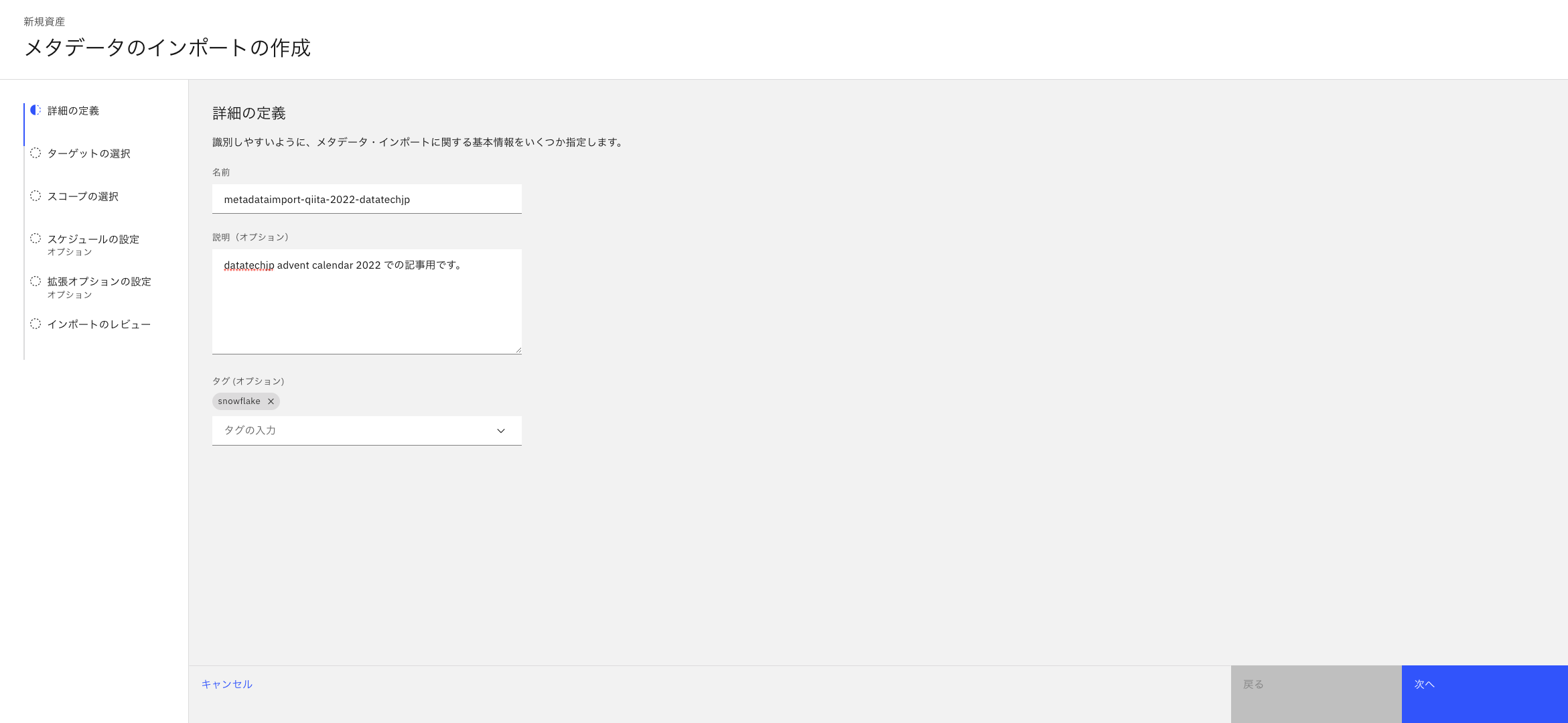

- この記事は、[datatech-jp Advent Calendar 2022] (https://qiita.com/advent-calendar/2022/datatech-jp) の12/21分として記載します。

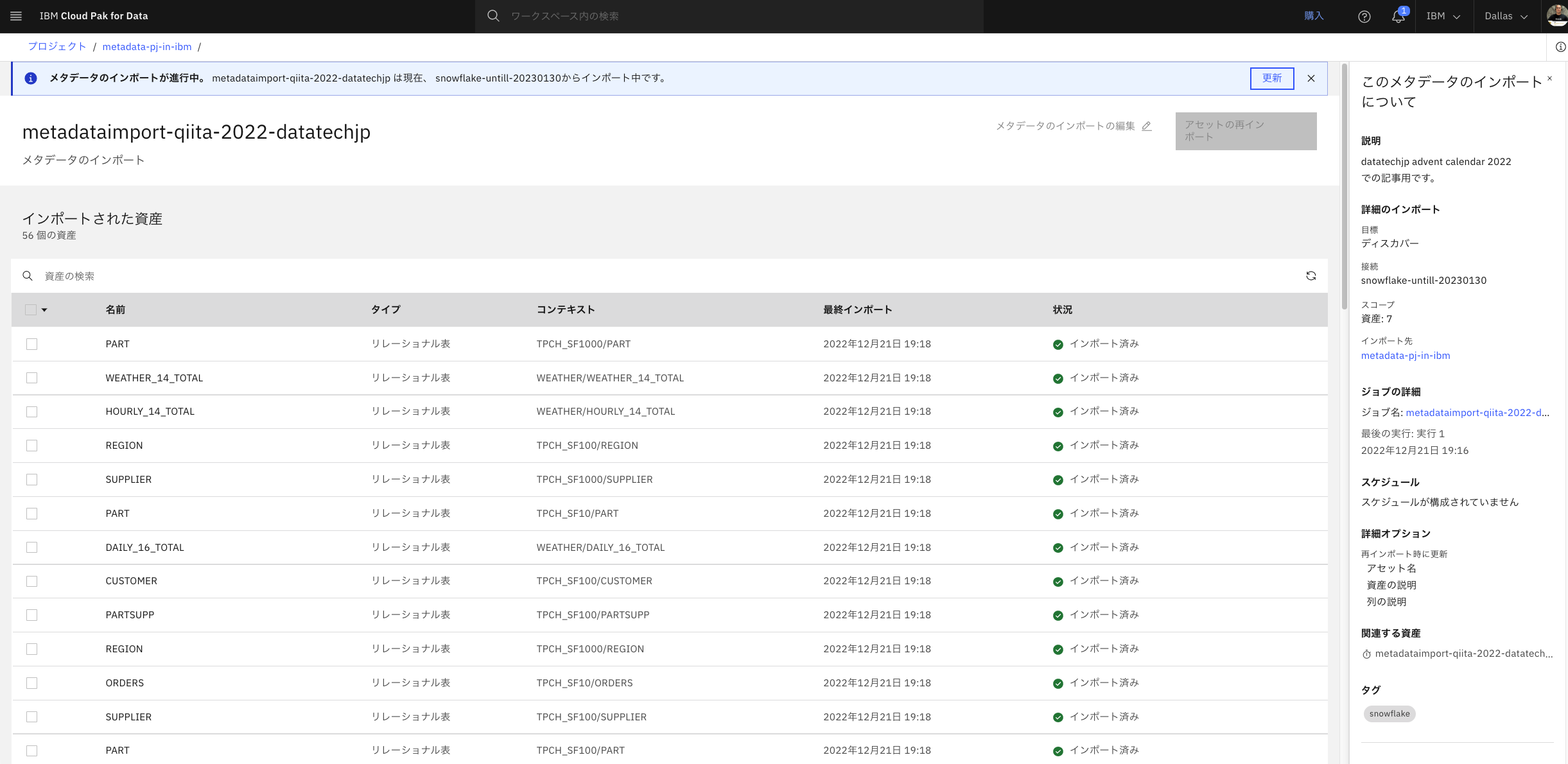

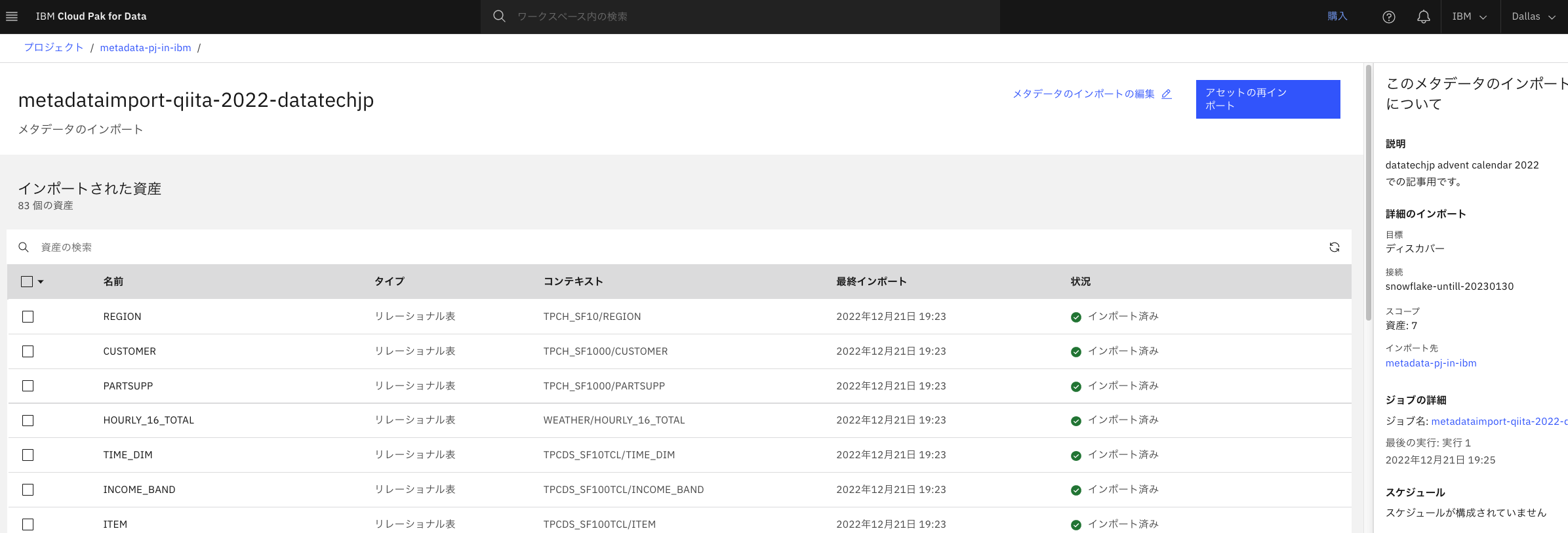

- SaaS版のデータカタログであるWatson Knowledge Catalogにおいて、メタデータインポート機能を使って、スキーマごとに一括でテーブルを取り込んでみます。

前提事項

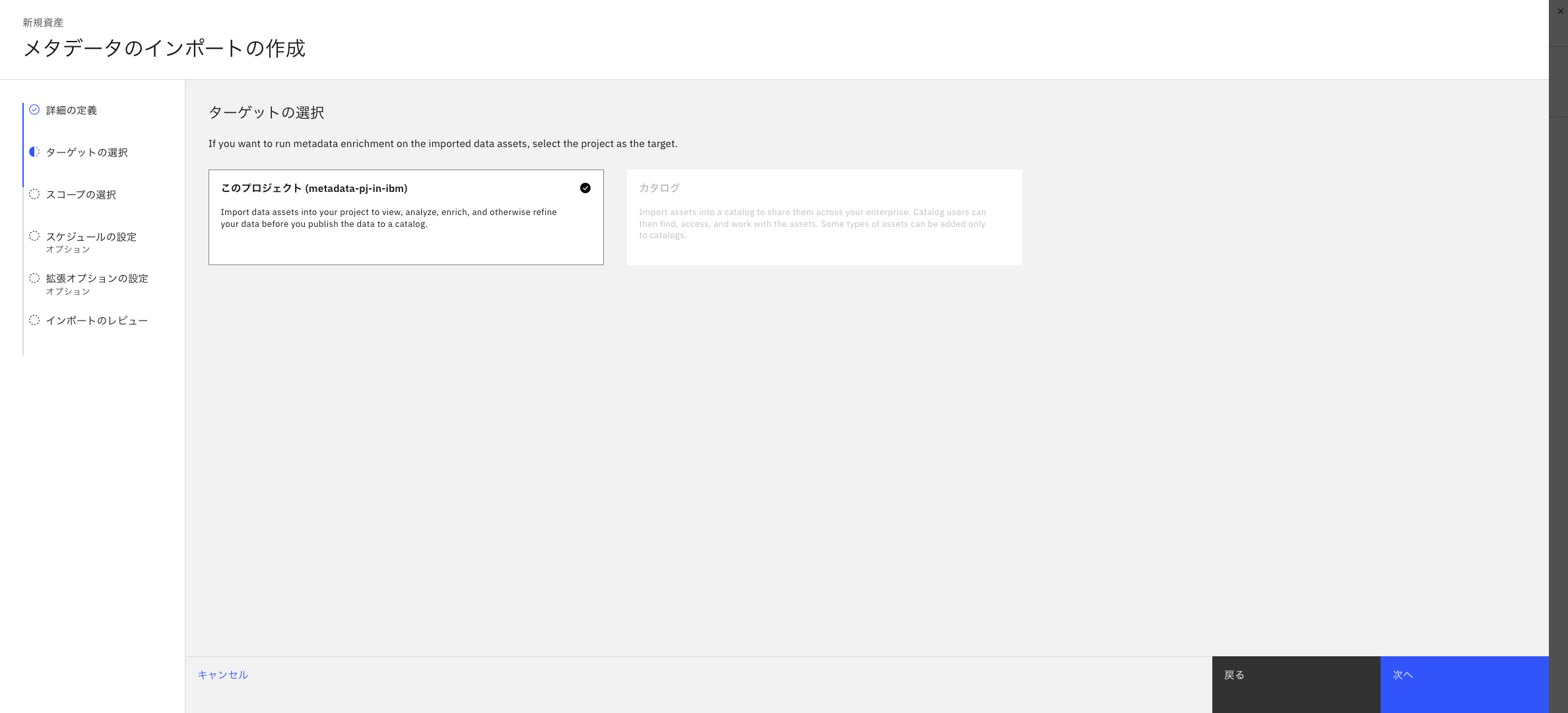

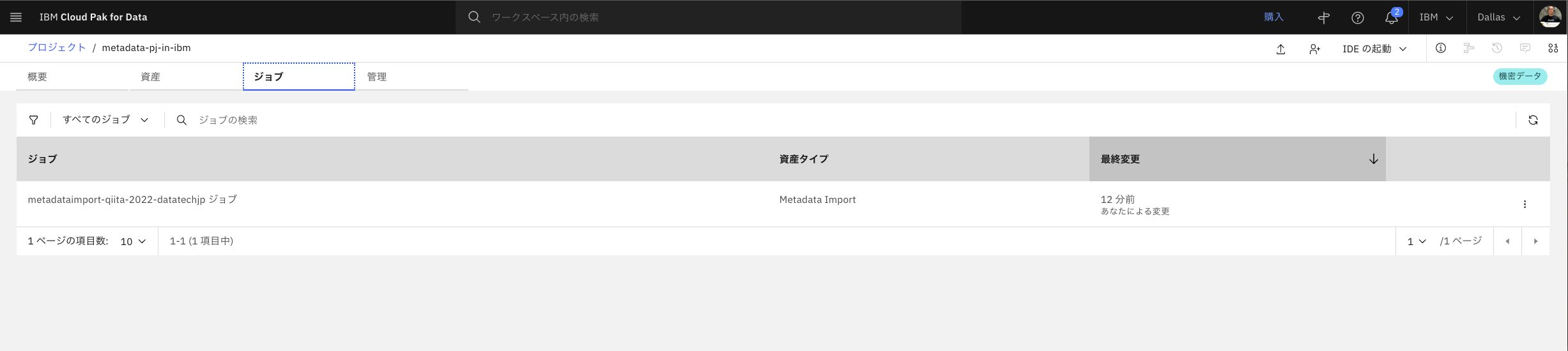

- メタデータインポートを実施するプロジェクトと呼ばれる箱を準備する

- ここでは「metadata-pj-in-ibm」というプロジェクトを準備します。

- メタデータを取り込む元となるデータソースへの接続情報画、上記プロジェクトに格納されていること。

- ここではSnowflakeへの接続情報を格納します。

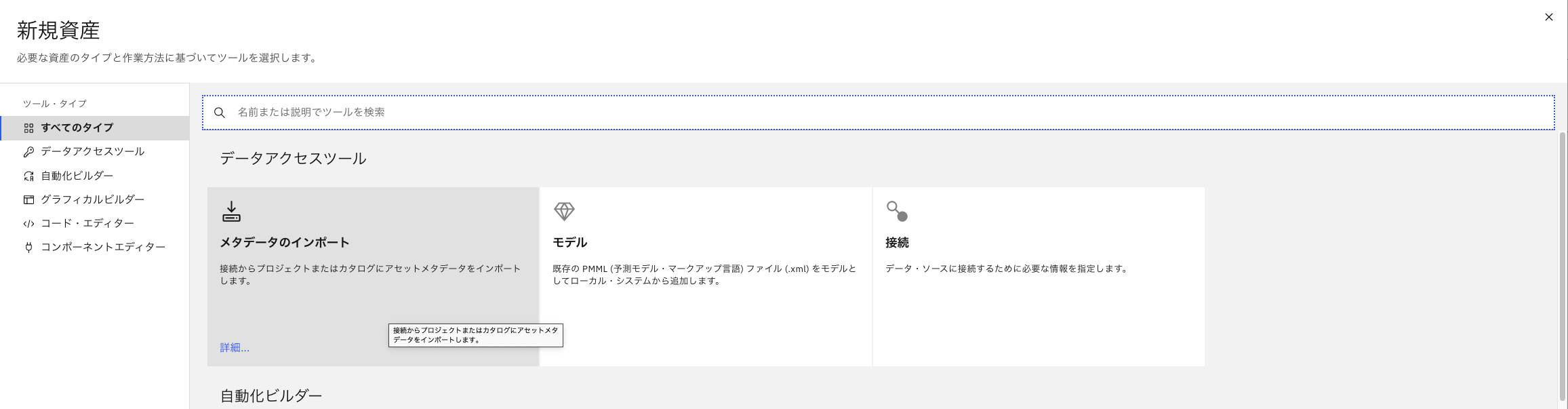

メタデータインポートを作成

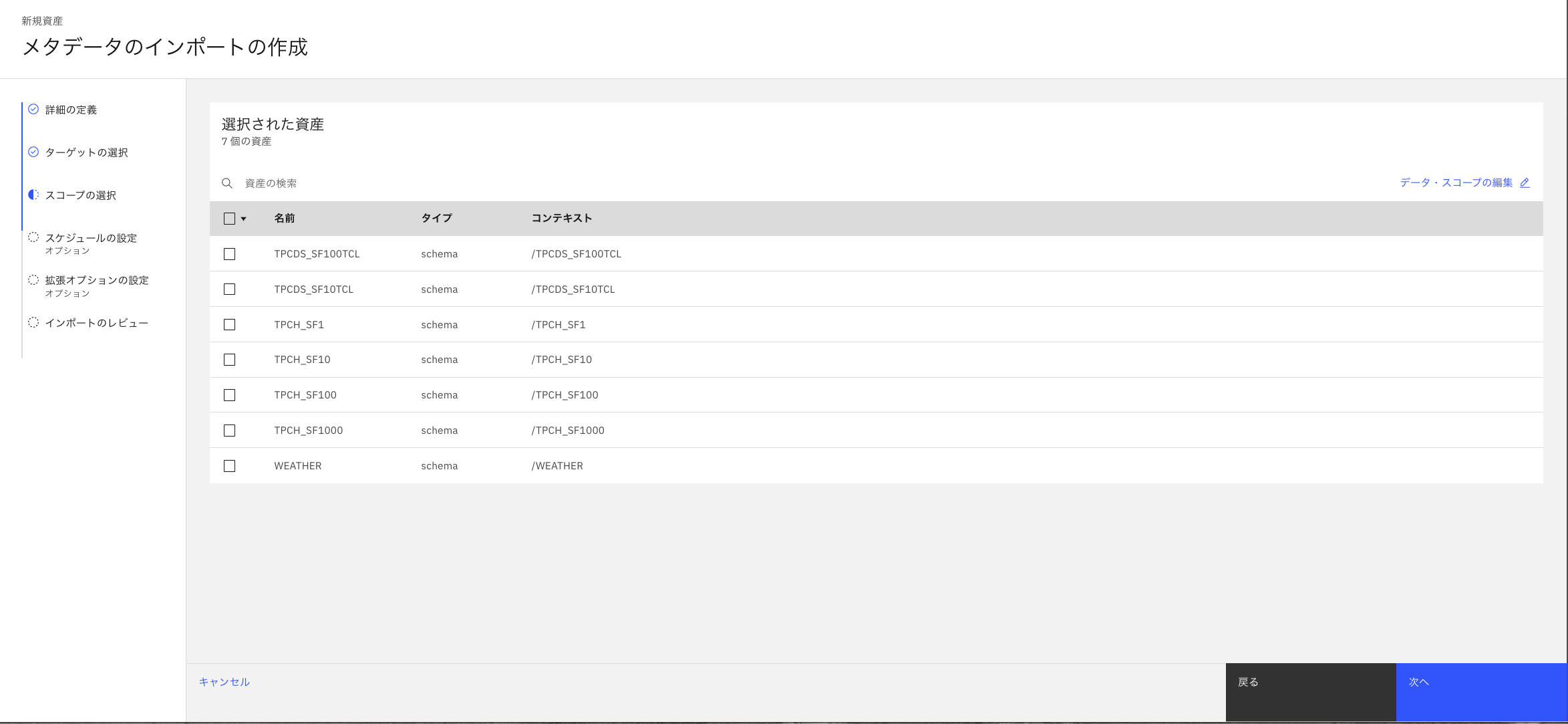

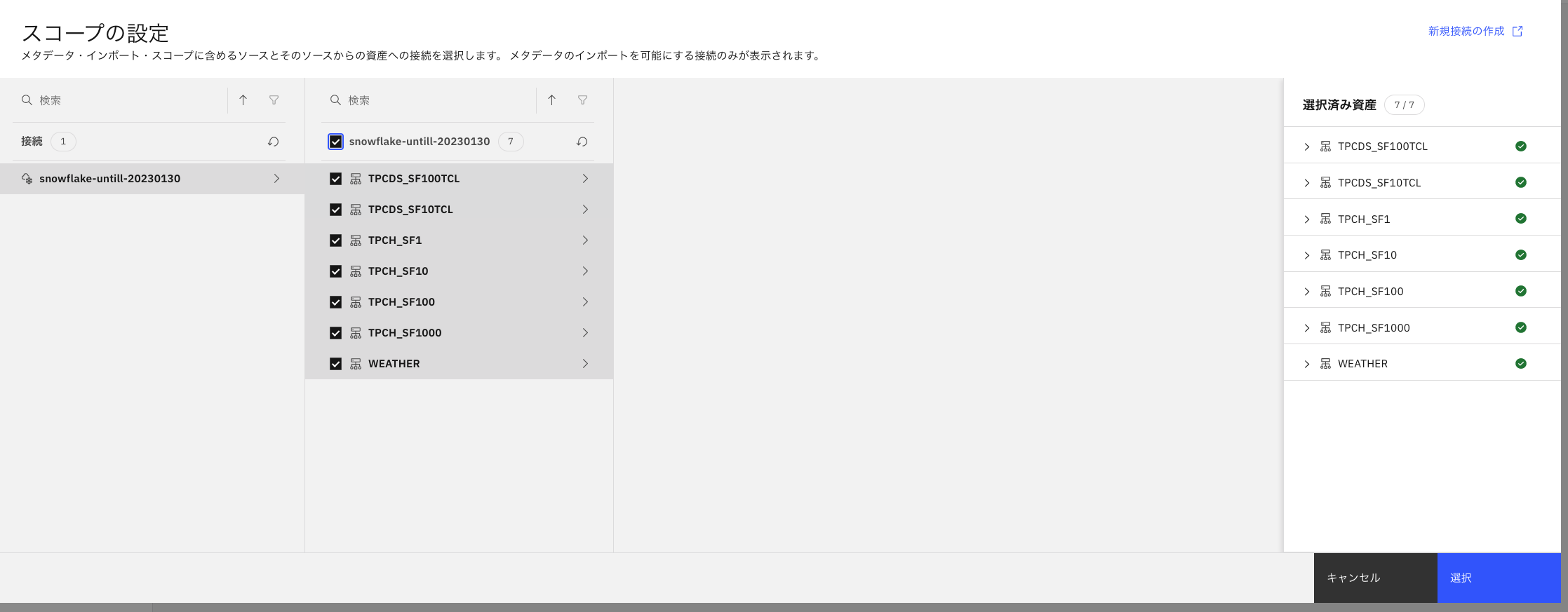

- メタデータを取り込む対象を選択します。ここでは対象となるSnowflake配下のすべてのスキーマをどかんと一括で取り込んじゃいましょう。

- たしか60億行くらいあるテーブルもあったはずですが、メタデータを取り込むだけなので、元テーブルの巨大さはあまり関係ないはずです。

- 対象となるチェックボックスを選択し、画面右下の青い「選択」ボタンをクリックします。

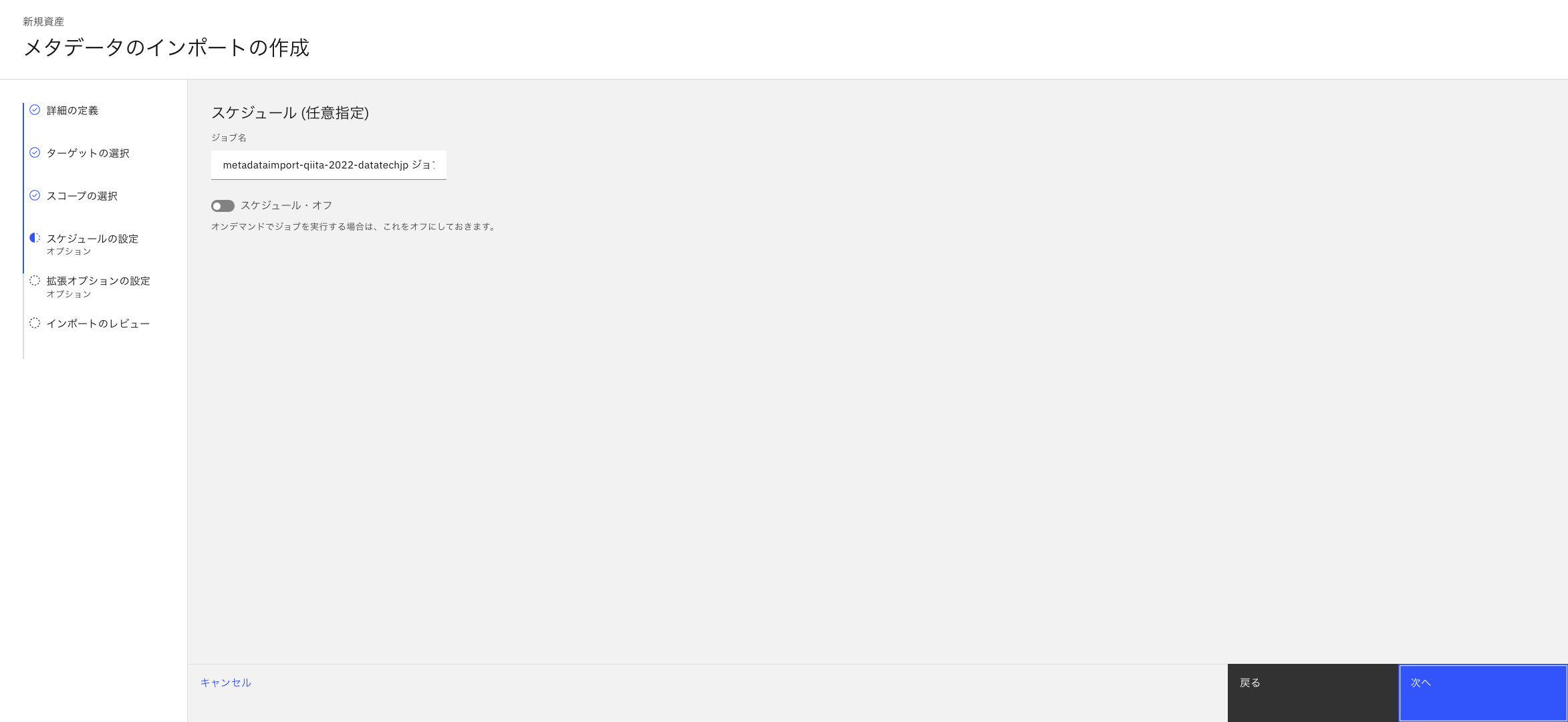

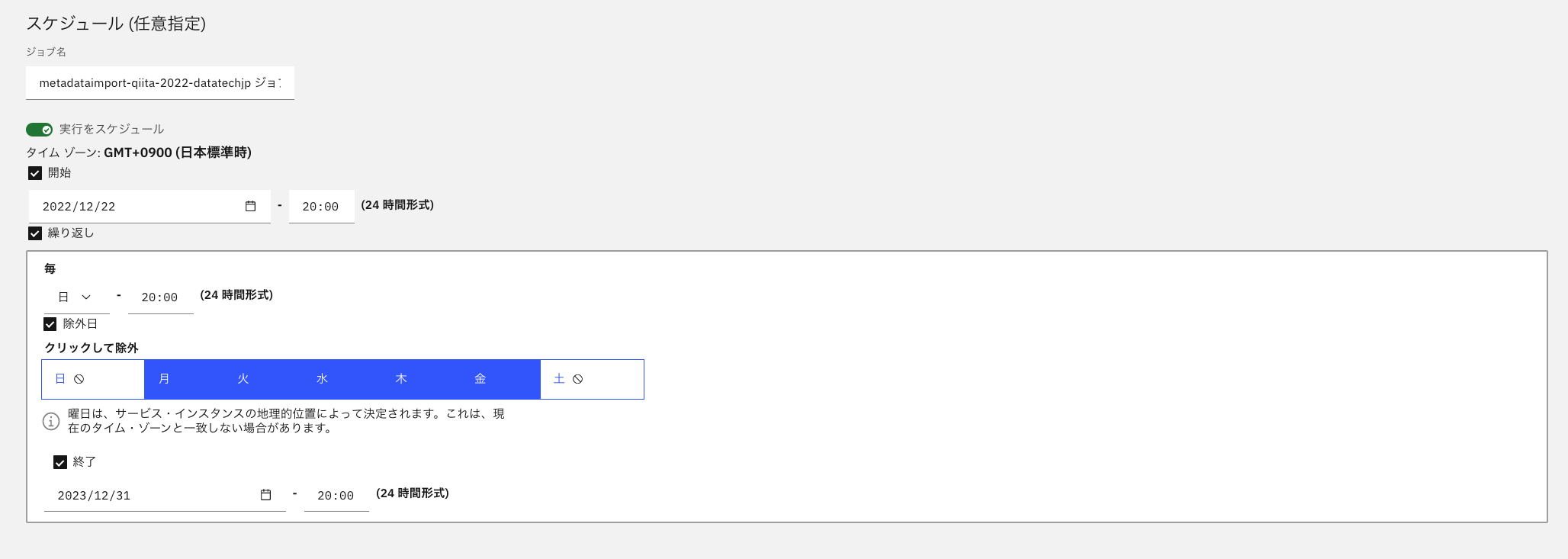

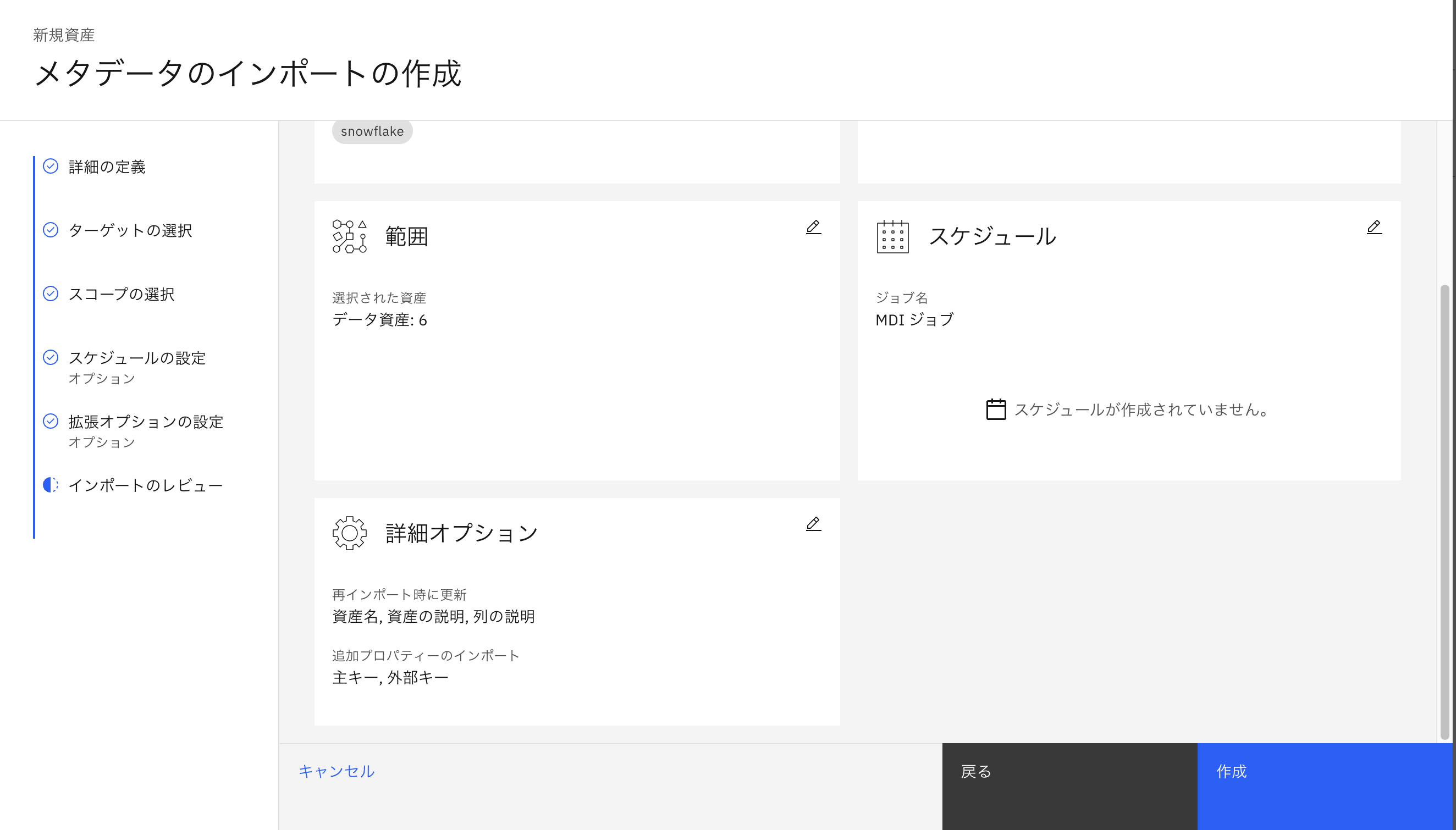

- しかし、仮にスケジューリングする場合は以下のように実施します。

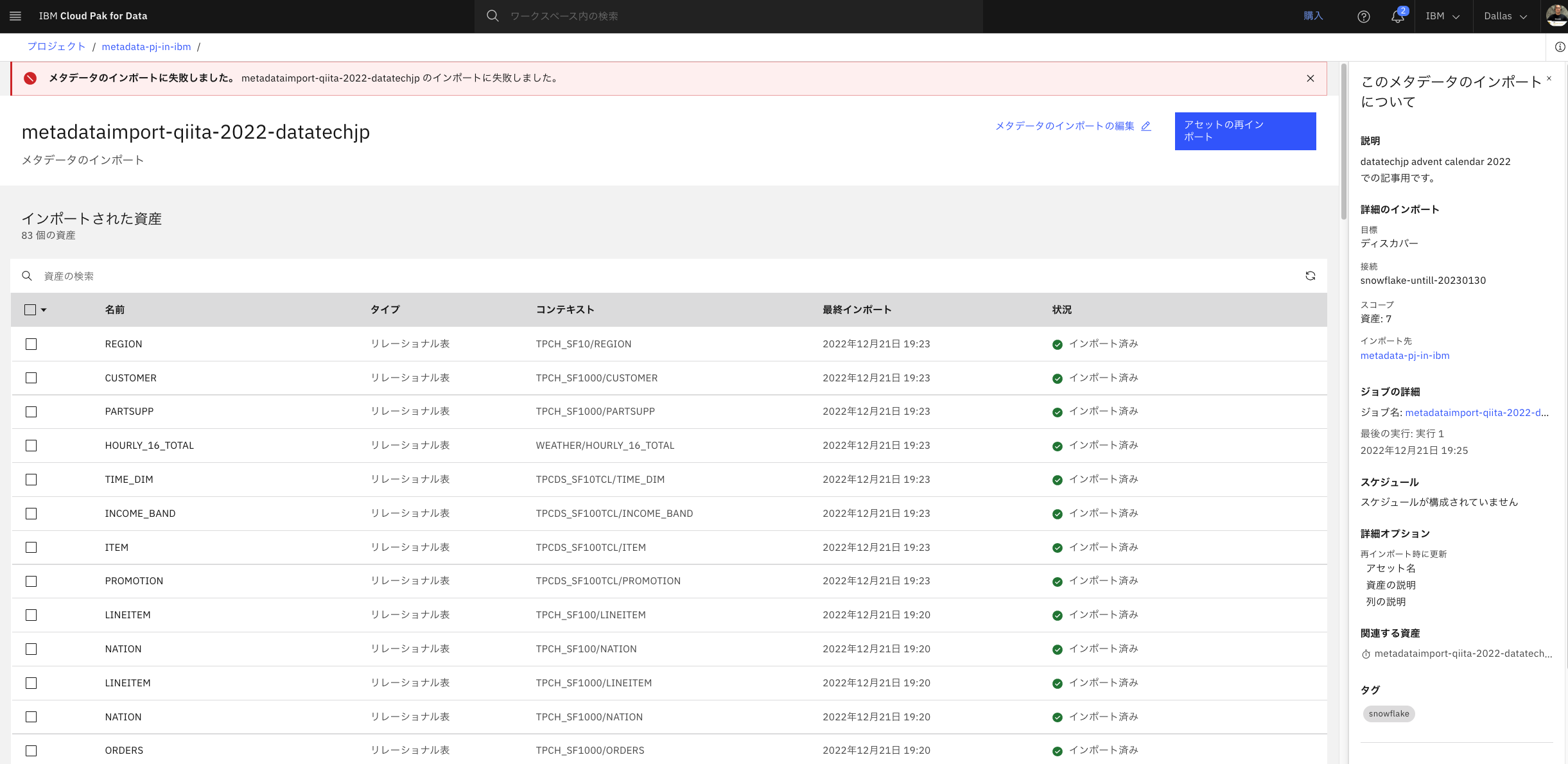

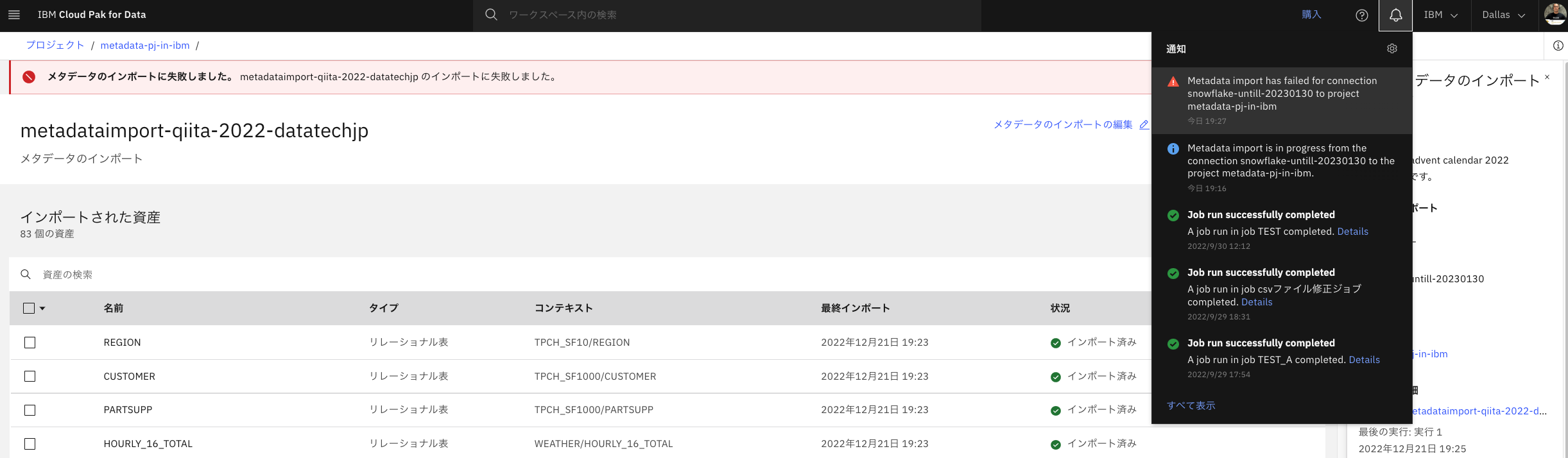

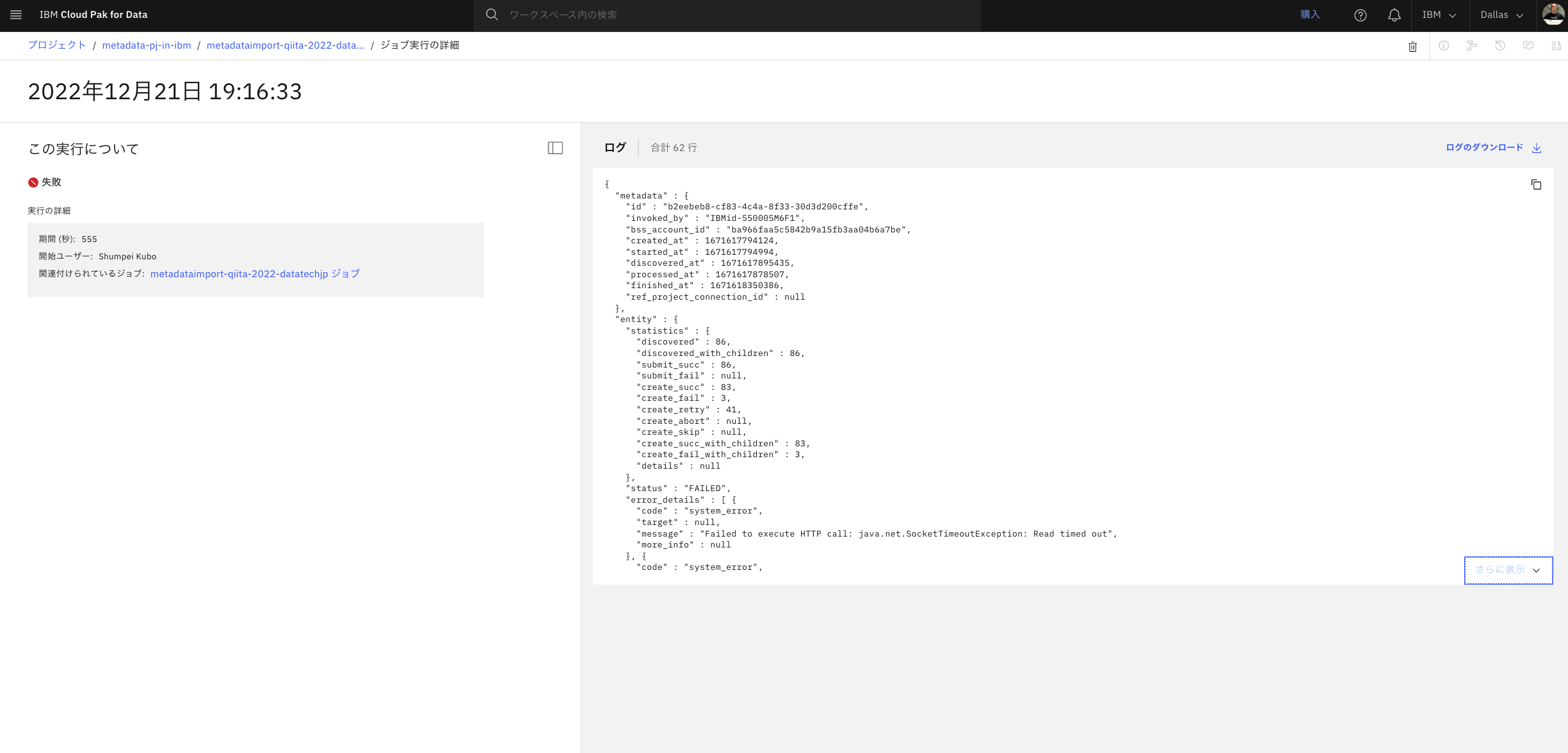

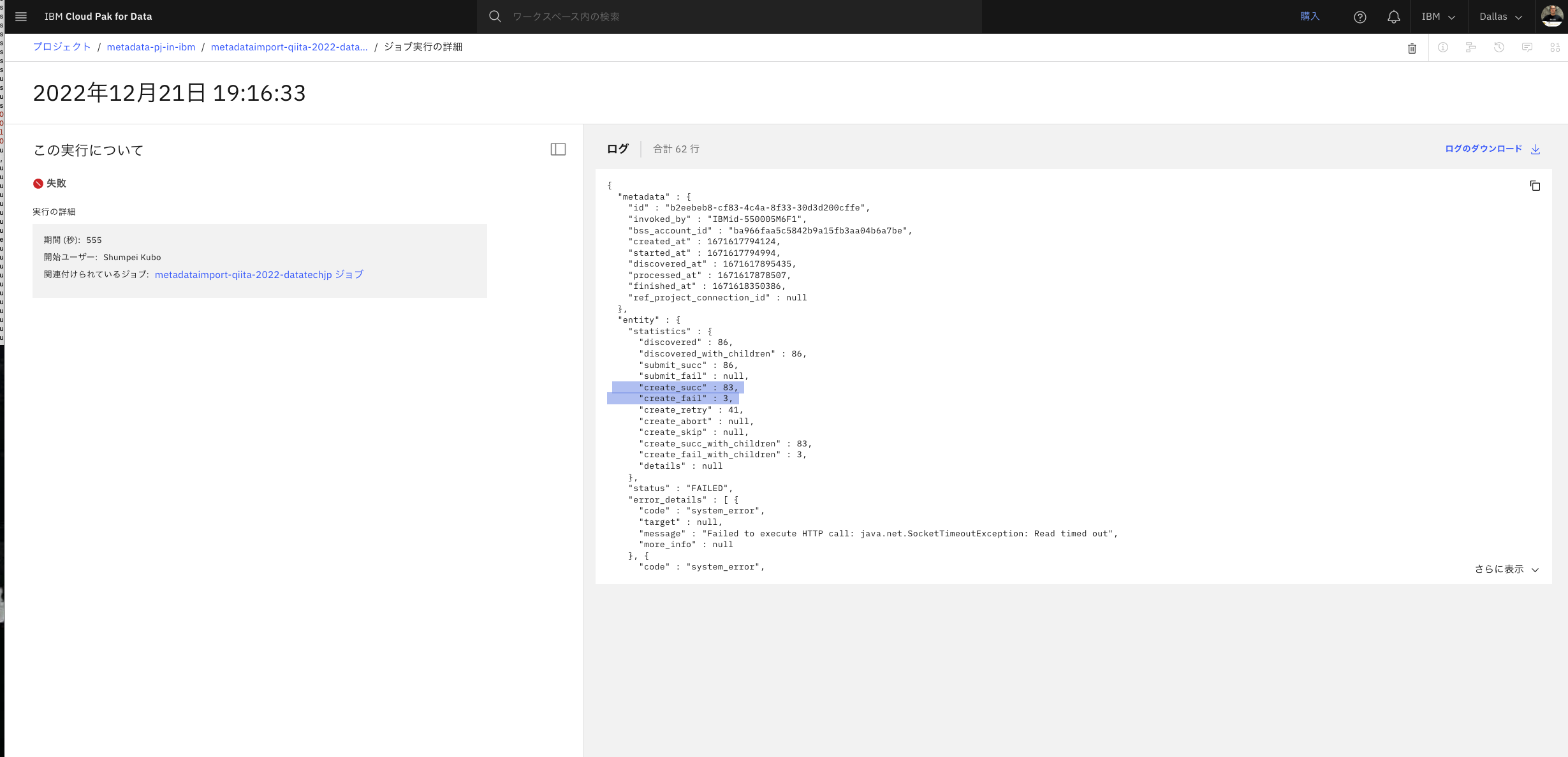

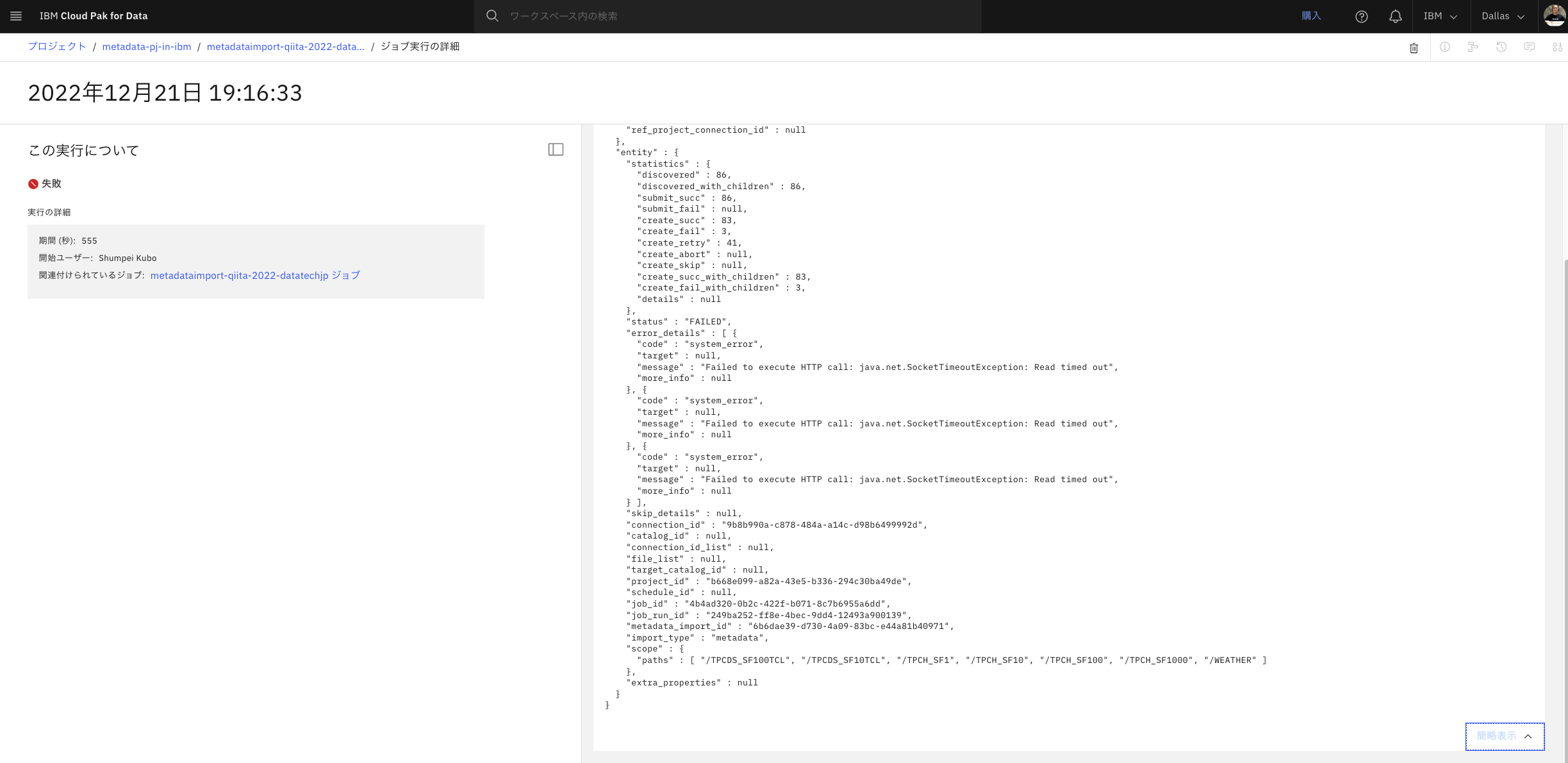

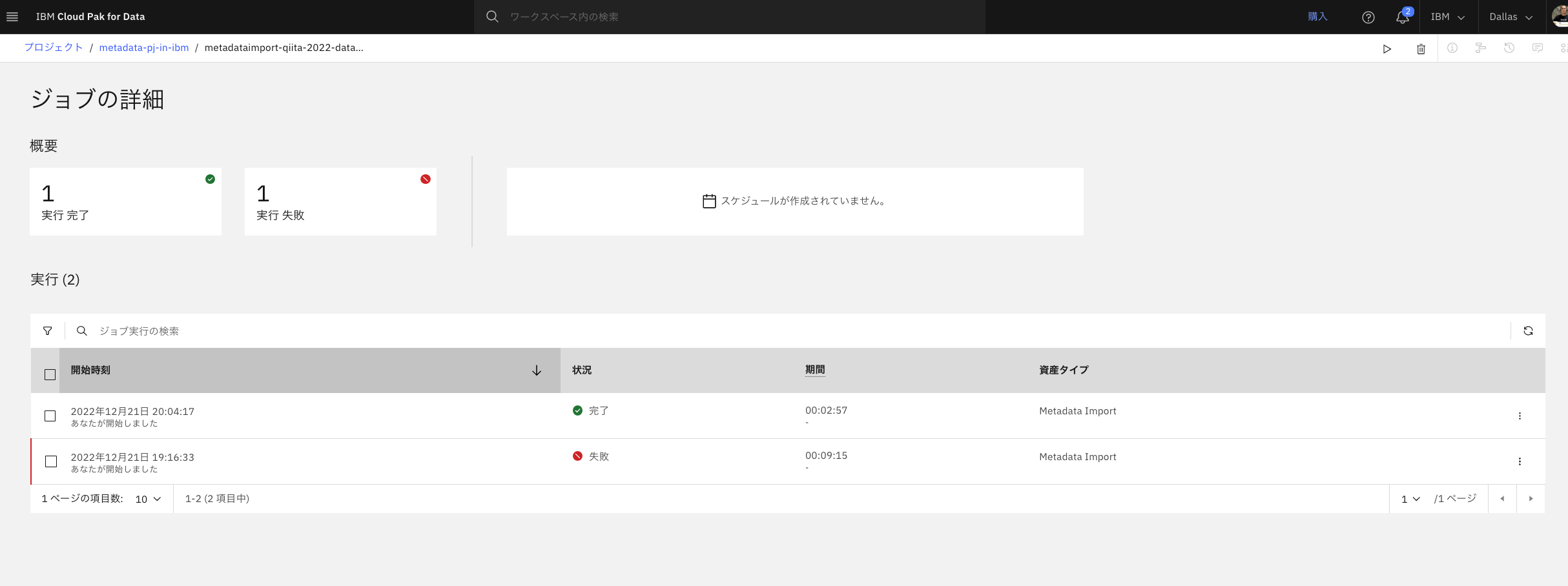

- これ以上の詳細については、サポートとの確認が必要ですかねえ。Read Timed Out と出ていましたが、タイムアウトかなあ。

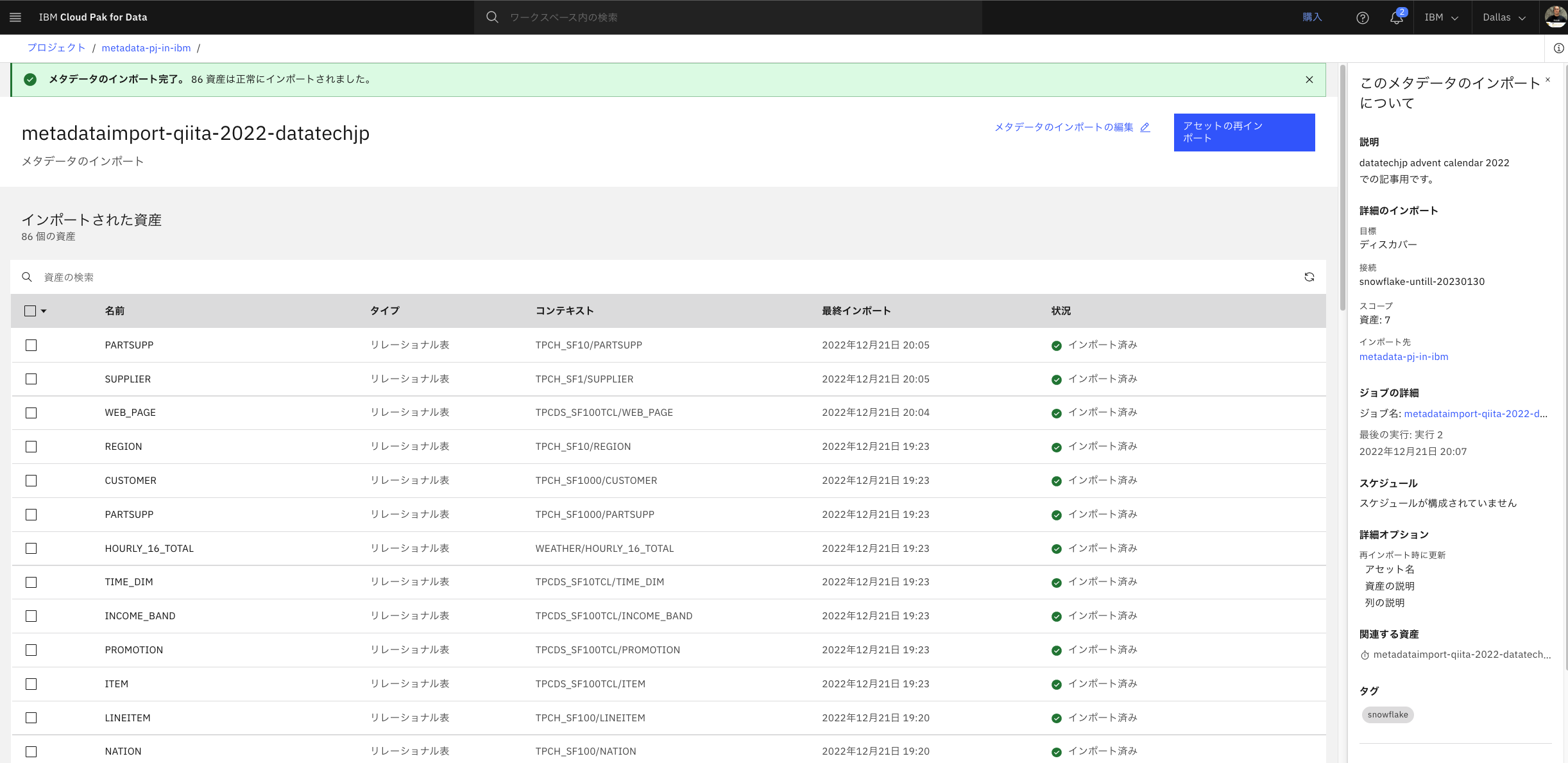

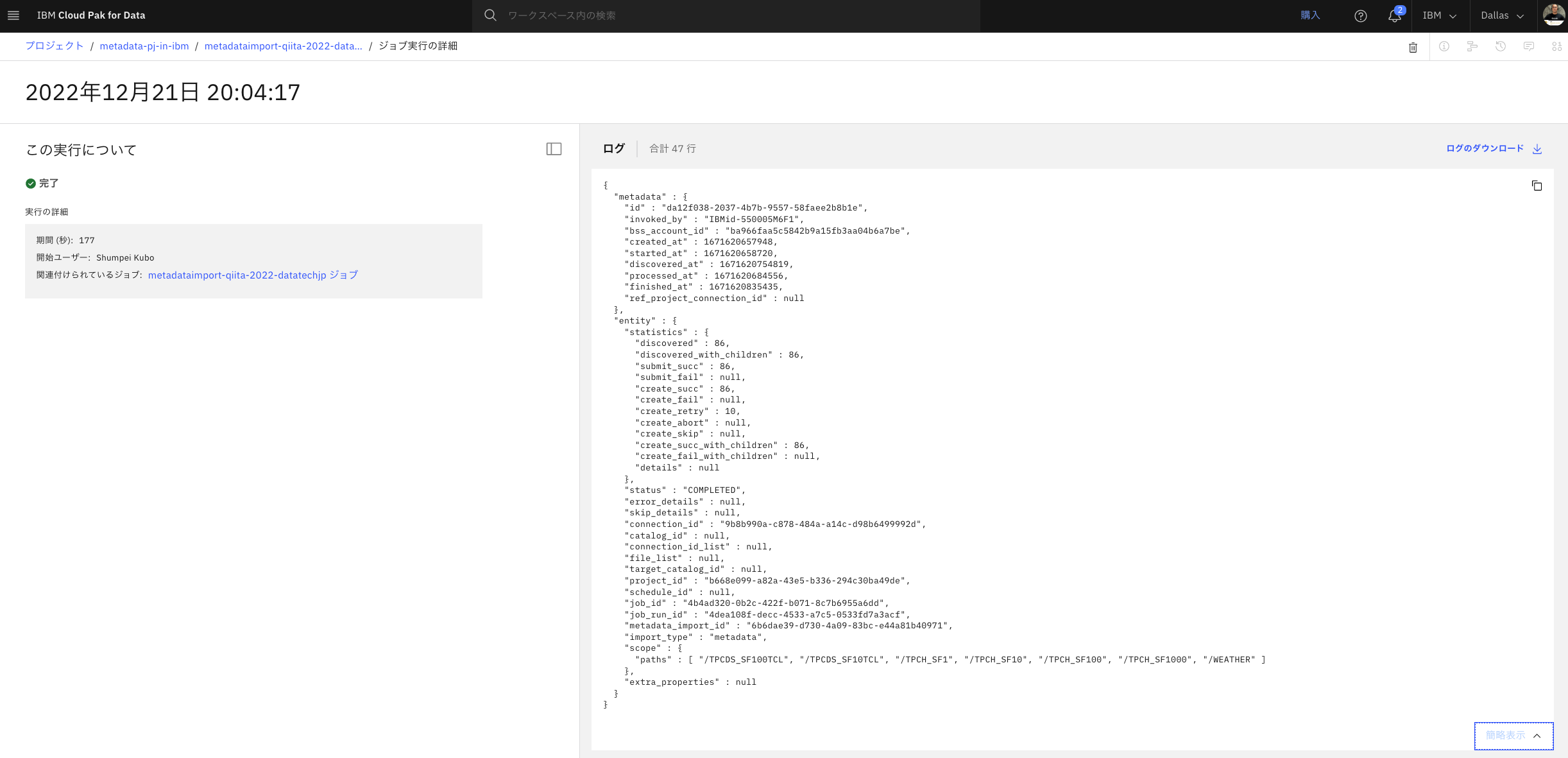

- あとで再実施したらすべて正常終了しました。

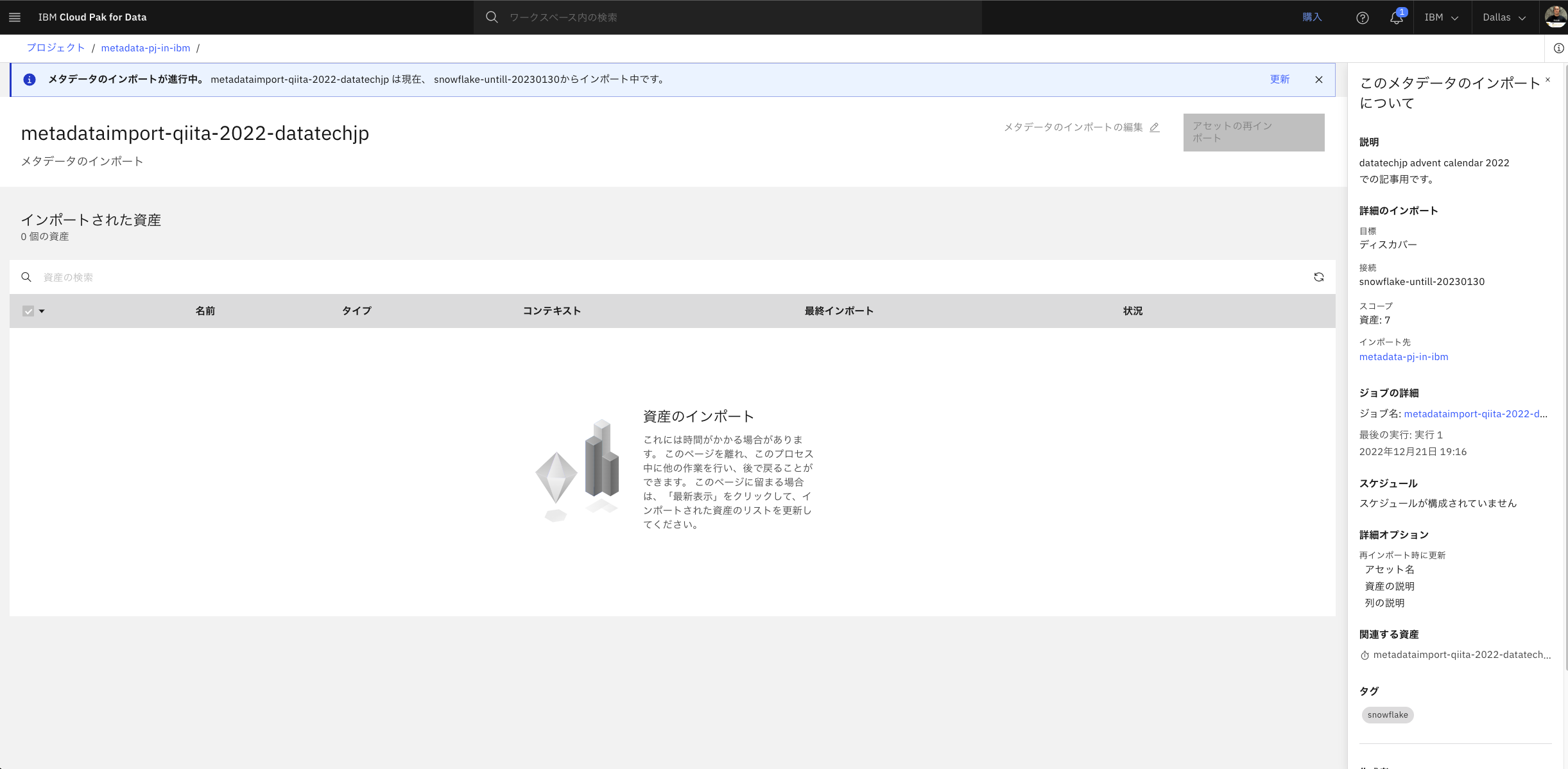

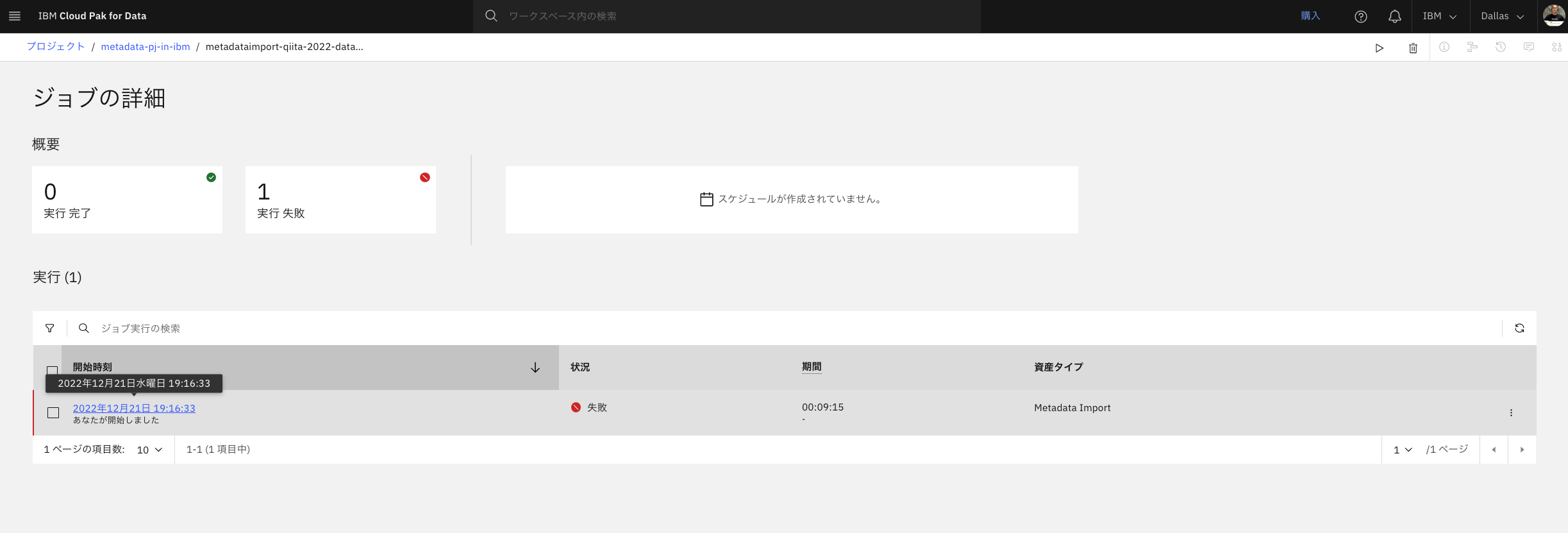

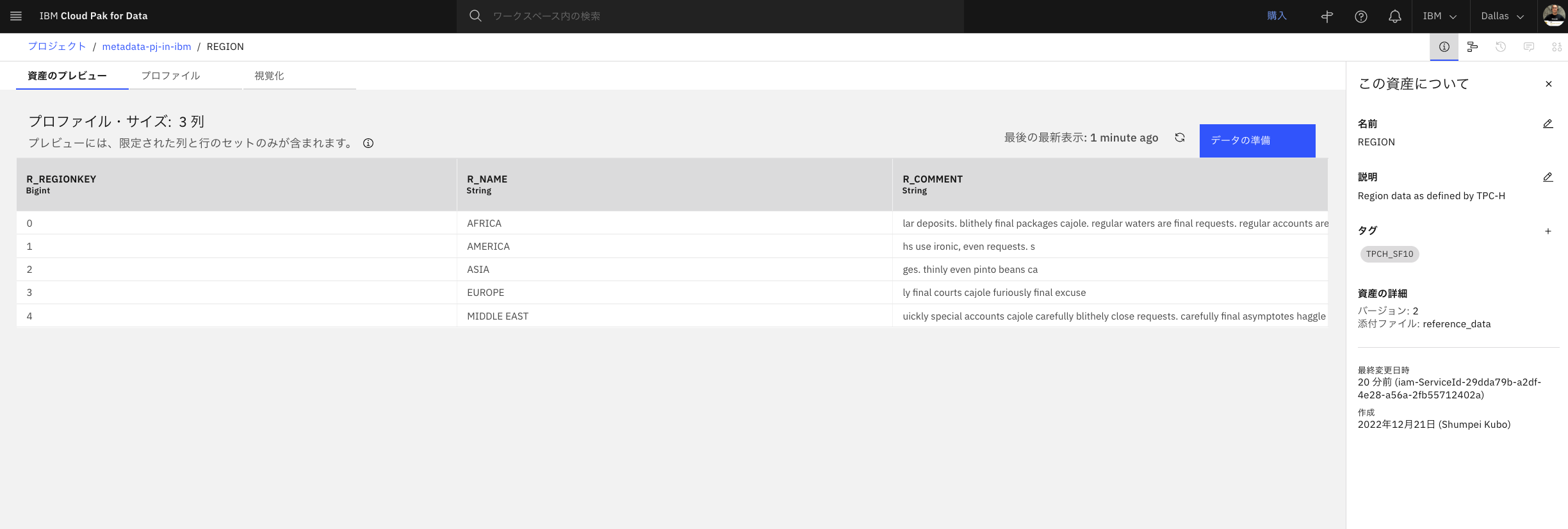

結果確認

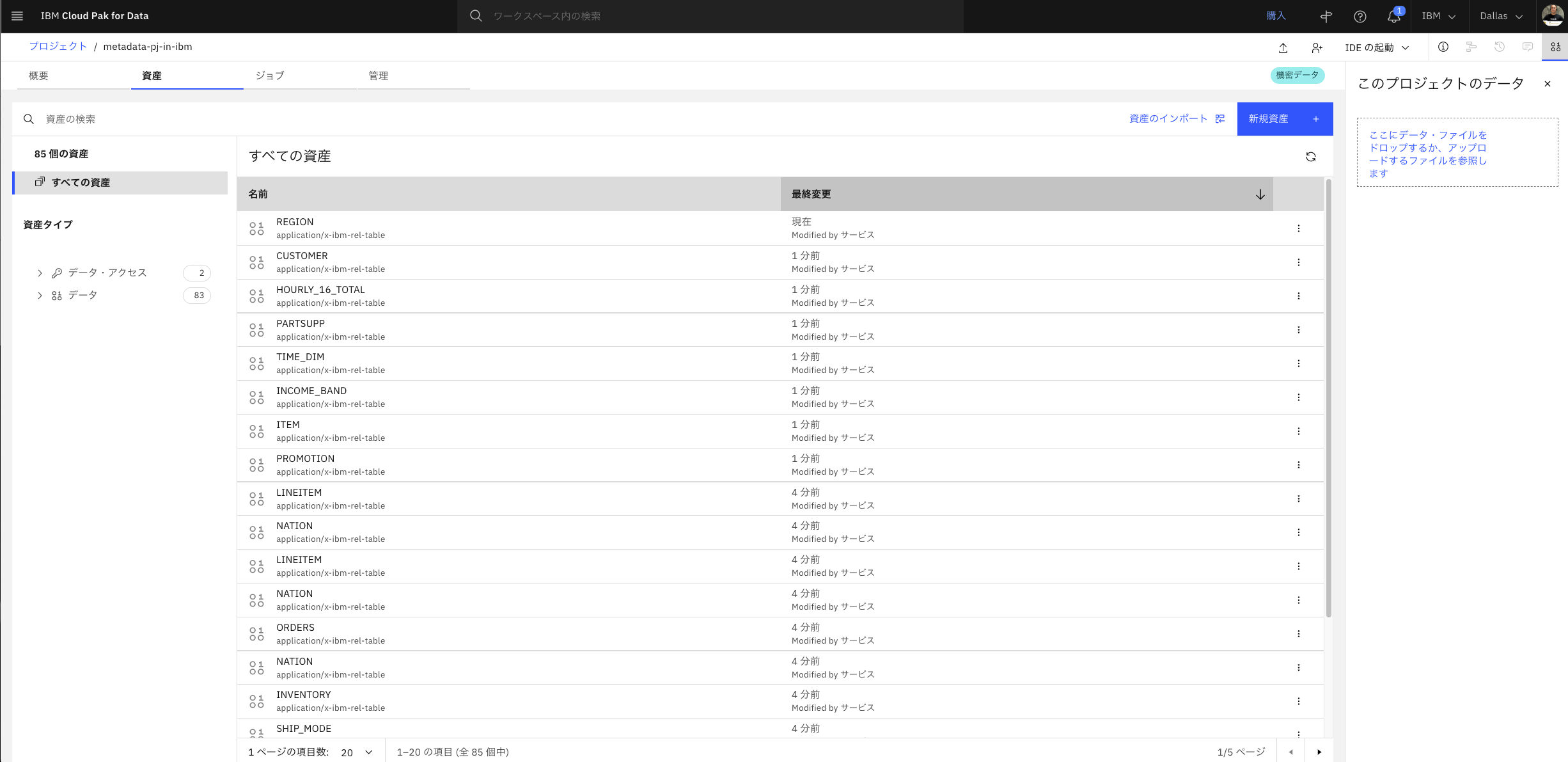

WKC側の確認

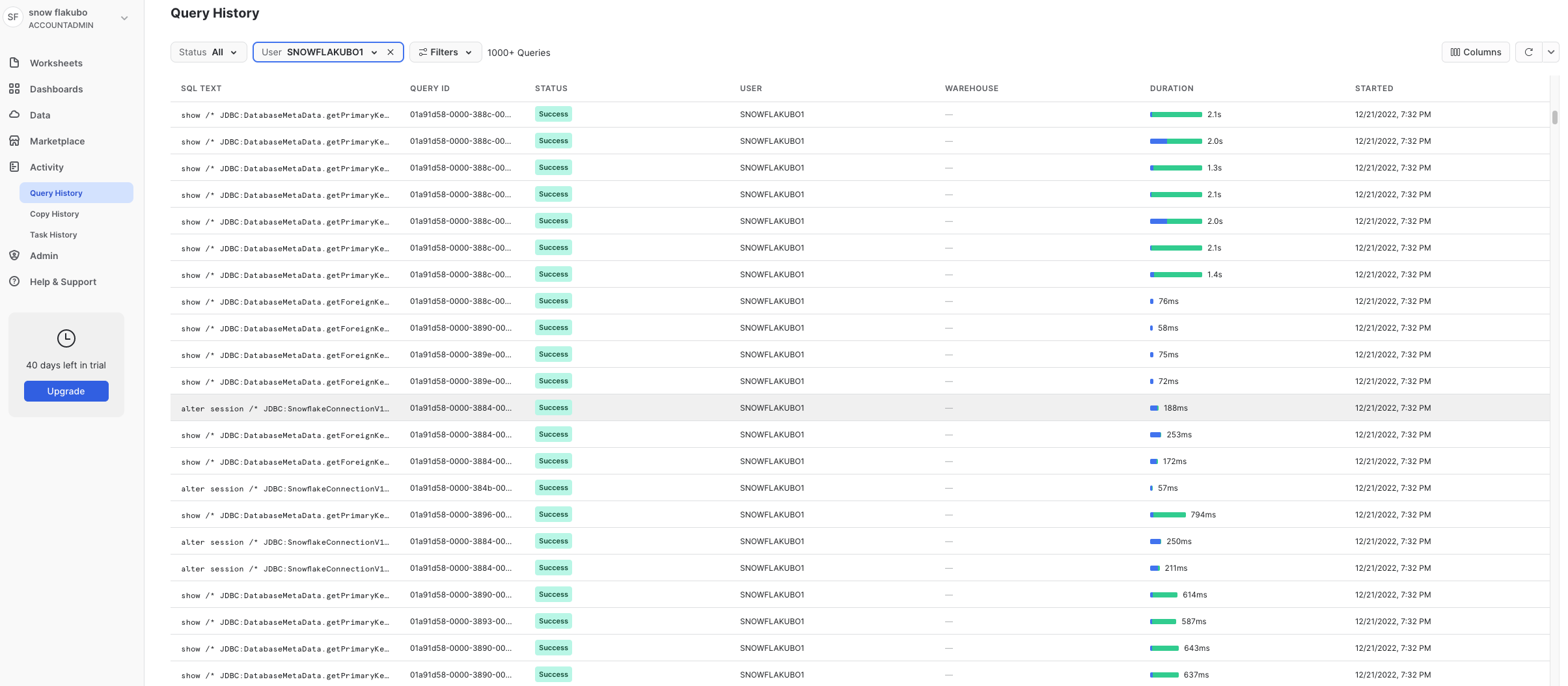

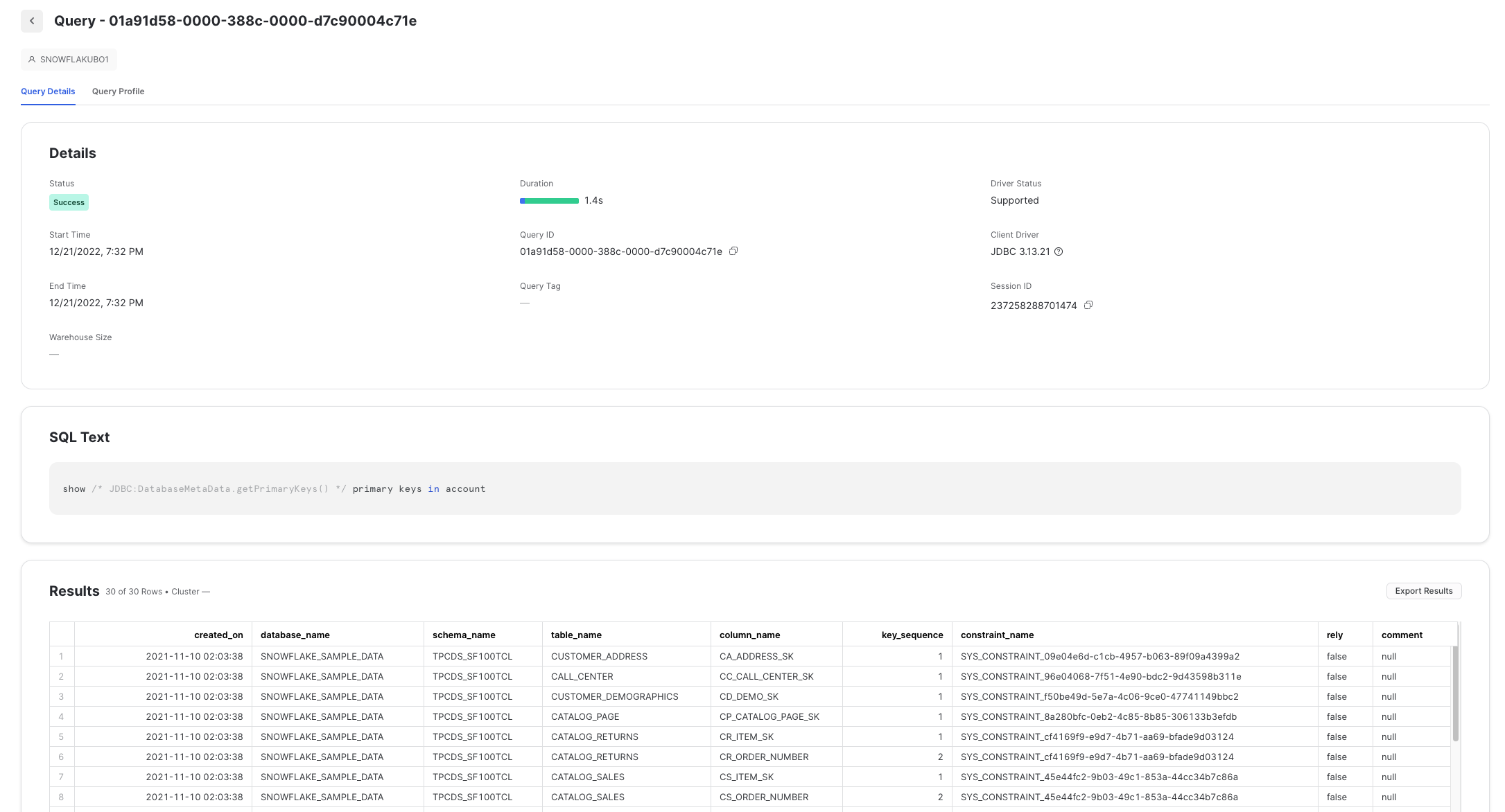

Snowflake側の確認

再インポートしてみる。

効果

- 80を超えるテーブル群のメタデータを、少しのエラーはありましたが、15分もかからずにすべてを自動的に取り込むことができました。

最後に

この記事としては以上です。

この次としては、取り込んだメタデータに対してビジネス用語等を紐付けるメタデータエンリッチメントについての記事も書いてみたいと思います。

もしこの記事を読んで興味を持たれた方は、この記事の大本となる、IBM Cloud Pak for Data as a Service ハンズオン資料 目次 から内容を見てみてください。