ここ数か月、LM Studioを使っていて、生成AIの応答速度を可能な範囲で早くしたくなってきた。

しかたないので(?)GPUを換装する。

旧:GeForce GTX 1650(4GB)

新:GeForce RTX 2060(12GB)

どちらも約6年半前の古いグラフィックボードだ。

今回の換装で重視したのは、メモリー容量。「4GB」のモデルから「12GB」になれば生成AIの応答速度の向上が体感できるのではないかと思って手に入れた。

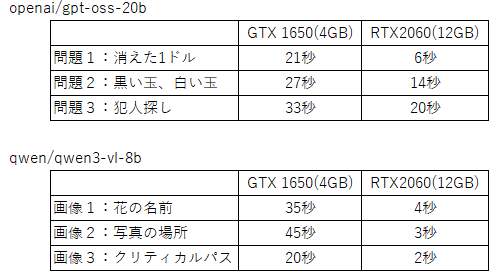

で、前の記事(以下参考)で書いた生成AIへの質問をやって時間が変わるか試してみた。

なお、どの秒数も質問を送信してから回答が"始まる"までの秒数です。

ちなみに、論理クイズの確認に使ったモデルはopenai/gpt-oss-20b(容量:11.3GB)

画像読み込みの確認に使ったのはqwen/qwen3-vl-8b(容量:6GB)

アタリマエながら、GPUにすべてが乗るサイズのモデルだとかなり高速の応答が来るようになった。

前は30秒以上かかっていた質問に3秒前後で回答が来るので体感はかなり良くなった。

openai/gpt-oss-20b も展開後の容量が12GBをちょっと超えるので、私のGPUにはすべて乗らないが、それでも体感できる速度向上が見られた。

GPUの性能があがるとローカル生成AIの応答性能も向上する、という当たり前の話でした。