ローカルLLMとして「LM Studio」が評判だったので使ってみた

結論から言うと、いろいろなモデルを簡単に試せたり、ローカルで http アクセスして呼べたり、かなり便利なのでオススメです。

手順は以下

1.LM Studio のダウンロード

以下からWindowsのインストラーをダウンロードして、インストールする。

https://lmstudio.ai/

インストールで聞かれる質問は2つ。好みで答えてよい。

- 現在のユーザのみにインストールするか?は好きな方を答えてOK

- インストール先は初期値のままでOK(もちろん、変えても良い)

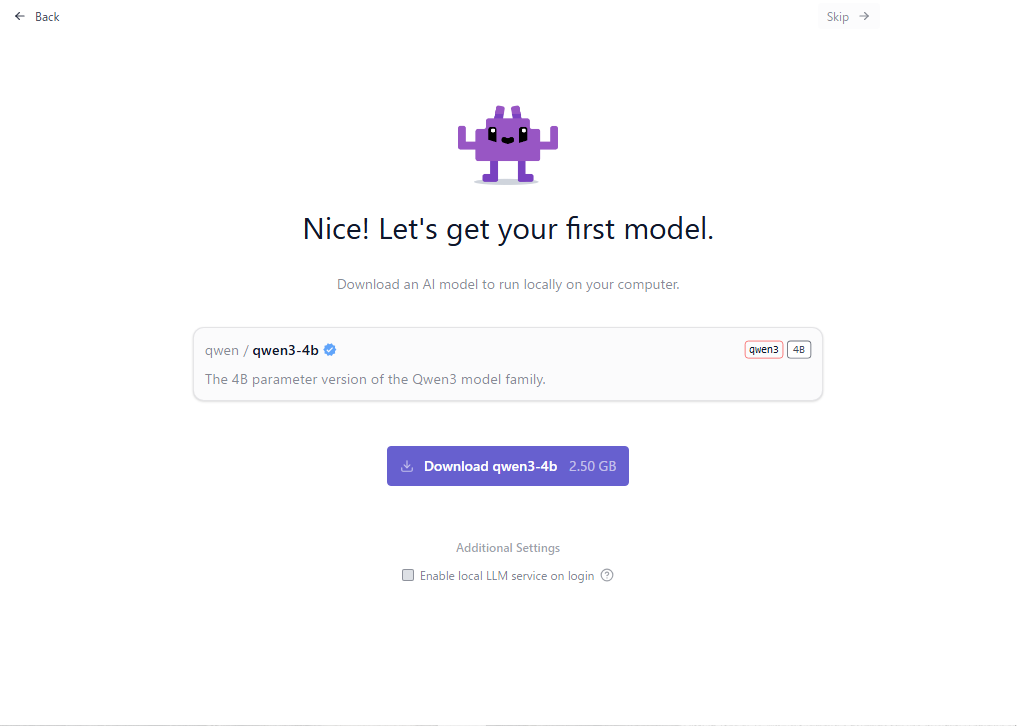

2.LM Studioの初期画面

インストールが終わったら LM Studio を起動する。

- Get Started →

- 好きなユーザレベルを選ぶ(私は「PowerUser」にしました)

- 最初にモデルを選ぼうになるので、まずはオススメのモデルを入れてよい(私は qwen3-4bをお勧めされました)

モデルが入ったら「Start a New Chat」でチャット画面が開いて利用できるようになる。

モデルを後で選びたければ、右上の「Skip」で進むこともできる。

ちなみに、同じ画面に「Enable local LLM service on login」の設定がある。LLMをサービスとして常駐させるならONにしても良い。

なお、この設定を後で変える時は「App Settings」>「Developer」で変更できる。

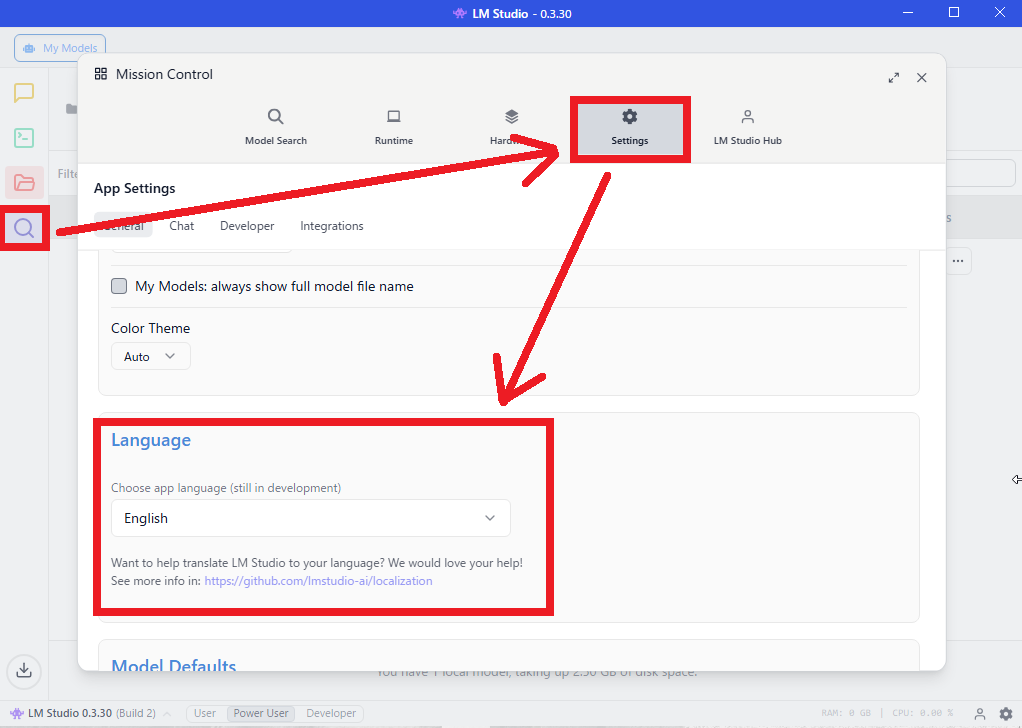

3.日本語表示に変える

初期状態では英語表示になるので、日本語にする。

- 画面左側の虫眼鏡マーク(あるいは画面右下の小さい歯車マーク)で設定画面を開く

- 「Setting」>「Language」で日本語に変えることができる。

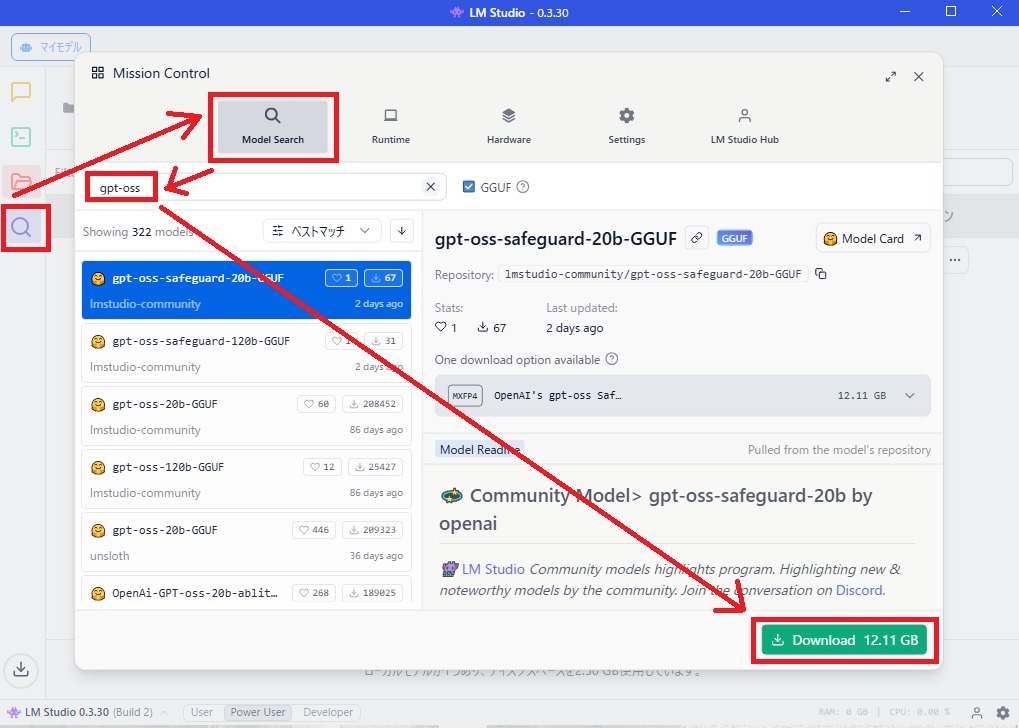

4.好きなモデルを入れる

起動したら、左側メニューにある虫眼鏡マークから、モデルの検索とダウンロードができる。

gpt-oss、Qwen、Gemma、DeepSeek など色々なモデルが自由に選べるので選ぶ。

ダウンロード画面を開くと容量も書いているので確認できる。

なお、初期値ではダウンロード先は「C:\Users[ユーザ名].lmstudio\models」になっている。

1つのモデルが数GBのサイズなので、容量に注意しよう

5.好きなモデルを読み込んで会話する

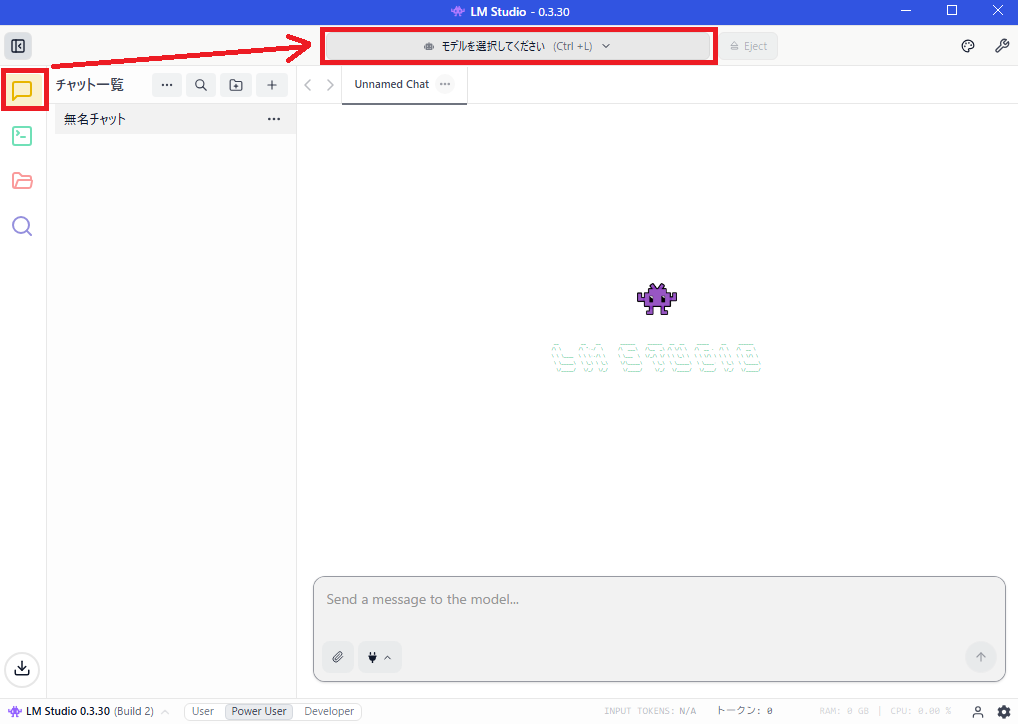

左側メニューの「吹き出し」を押すとチャット画面を開ける

もしモデルが未選択であれば、ダウンロードしたモデルを選択する。

あとは、オンラインで使うAIツールと同じようにチャットで会話できる。

結果

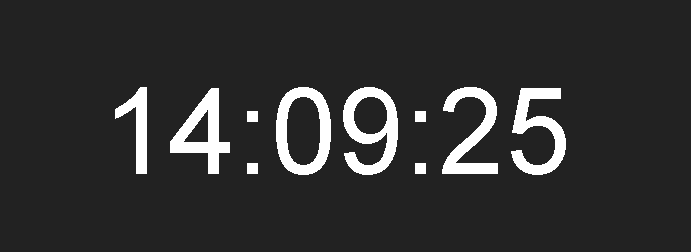

例えば、「gpt-oss-safeguard-20b」にこんな指示をしてみた。

※ハイフンを使うと、段落を付けて構造化できるので便利です。

以下の条件でhtmlファイル1つを作成してください

- やりたいこと

-- パソコンの画面に大きく現在時刻(時:分:秒)を表示したい

- 条件

-- 作成するのはHTMLファイル1つで、名前は「時刻表示.html」

-- プログラム言語はJavaScriptで、HTML内に書く(別ファイルにしない)

-- HTMLファイルをローカル(パソコン内)に置いてブラウザで開いて使用する

-- 時刻は画面の中央に大きく表示され、離れた人でも読み取れる

-- 時刻は「15:12:59」のように、時:分:秒 の形式とする

-- ブラウザの再読み込みをしなくても、自動的に最新の時刻が表示され続ける

で、ローカルAIが作ってくれた結果がこんなかんじ。

「離れた人でも読み取れる」といった言葉を入れたからか、黒背景で白文字にすることなど配慮してくれている。

どことも通信せず、ローカルでここまで動くのは素晴らしい!

新しいモデルが公開されると、かなり早く LM Studioでもダウンロードできるようになるので、色々なモデルを試したい人にもオススメです。

ちなみに私のブログの以下の記事に書いたのと同じ方法でPDFを読ませて質問したら、かなりちゃんとした答えをしてくれました。

これはOllamaとの違いというより、読み込んだモデルの近いですが……。

PDFを読ませる用途でも使えそうです。