データは今やビジネスの成功に不可欠な要素ですが、その膨大な海から必要な情報を見つけ出し、活用することは容易ではありません。この複雑な作業は、多くの企業にとって頭痛の種となっており、時間とリソースの大幅な浪費につながっています。

そこで、この問題を解決する鍵となるのが「クローリング」と「スクレイピング」です。これらの技術を理解し、適切に活用することで、効率的なデータ収集が可能となり、ビジネスのインサイト獲得や意思決定のスピードを大幅に向上させることができます。

本記事では、クローリングとスクレイピングの基本から、それぞれの違い、そしてどのようにビジネスに活かすべきかを詳しく解説します。最後には、これらの技術を実際に適用するためのアクションプランを提供しますので、ぜひご覧ください。

クローリングとは?

クローリングは、ウェブクローラー(またはスパイダーとも呼ばれる)という自動化されたソフトウェアによって、ウェブページを系統的に巡回し、データを収集するコンピューター技術です。

ウェブクローラーは、リンクをたどりながらウェブページ内のコンテンツをダウンロードし、その情報を検索エンジンのデータベースに保存します。これにより、ユーザーが検索クエリを入力したときに、関連するウェブページを迅速に見つけ出すことができます。

クローリングの流れ

クローリングのプロセスでは、まずウェブクローラーが特定のウェブページにアクセスします。次に、そのページ上のリンクを辿り、新たに発見したページにもアクセスしていきます。この一連のプロセスを繰り返すことで、インターネット上の膨大な情報が検索エンジンによって整理され、ユーザーが情報を探しやすくなります。例えば、Google検索のウェブクローラーであるGooglebotはインターネット上の新しい、または更新されたページを定期的にチェックし、その情報をGoogleの検索インデックスに追加します。これにより、Google検索を使用するユーザーは、最新の情報に基づいた検索結果を得ることができます。

このようにクローリングは、検索エンジンに欠かせない技術であり、現代のインターネット検索の基盤を形成しています。

スクレイピングとは?

スクレイピングは、ウェブページから特定のデータを収集し、それを整理して利用しやすい形にする技術です。多くのウェブサイトは、情報を視覚的に表示するためにHTMLやJavaScriptなどを使用していますが、これらの形式ではデータの再利用や分析が難しいことがあります。スクレイピングは、このようなデータを構造化された形式(例えば、CSVやデータベース)に変換し、よりアクセスしやすく、分析しやすいものにします。

スクレイピングの流れ

スクレイピングのプロセスでは、スクレイピングツールやスクリプトがウェブページにアクセスし、必要なデータを識別します。その後、データは抽出され、指定された形式に変換されます。この変換により、データは表計算ソフトウェアで開いたり、データベースにインポートしたり、プログラムでさらに処理したりすることが可能になります。

例えば、オンラインショップの商品価格を比較するためにスクレイピングを使用することができます。スクレイピングツールは、複数のショッピングサイトから商品の価格情報を収集し、それを一つの表にまとめることができます。その結果、消費者は最も安い商品を簡単に見つけることができます。

このようにスクレイピングは、特定の情報を効率的に収集し、価値あるインサイト(洞察)を得るために必要な技術です。

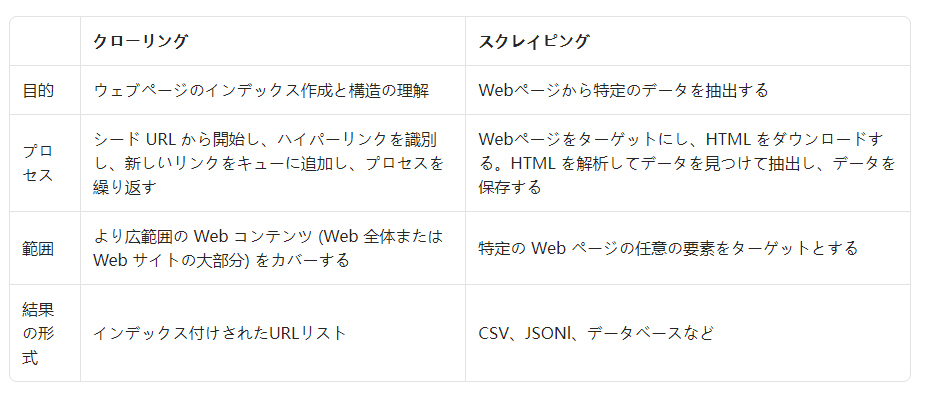

【表あり】クローリングとスクレイピングの違いとは

クローリングとスクレイピングは、どちらもウェブ上の情報を収集する手段ですが、目的とする作業の焦点が異なります。まずクローリングは、ウェブ上を自動で巡回し情報を収集する過程に焦点を当てています。一方、スクレイピングは、収集したデータから特定の情報を抽出・加工する作業に焦点を置いています。

例えば、検索エンジンのボットがウェブサイトを巡回してインデックスを作成するのはクローリングの一例です。対して、特定のウェブサイトから特定のデータ、例えば商品の価格や在庫情報などを抽出するのはスクレイピングです。

したがって、クローリングは情報収集の「手段」であり、スクレイピングはその収集した情報を「目的の形に加工する手法」という点で違いがあります。

以下の表は、クローリングとスクレイピングの違いを一目で理解できるようにまとめたものです。

クローリングとスクレイピングの使うべき場面を紹介

ウェブ上の情報を取り扱う際、クローリングとスクレイピングはそれぞれ異なるシナリオで最適な選択となります。どちらの技術を選ぶべきかは、目的とする情報の種類、必要とするデータの範囲、そして最終的な目標によって決まります。ここでは、それぞれの技術が適している具体的な利用シーンを詳しく解説します。クローリングを使うべき場面

クローリングは、大量のウェブページから情報を収集する必要がある場合に適しています。クローリングはウェブサイト全体をシステマティックに巡回し、リンクをたどりながらデータを集めるプロセスです。これにより、広範囲のデータを効率的に収集することができます。例えば、検索エンジンがインターネット上の新しいまたは更新されたコンテンツを発見するためにクローリングを使用します。また、市場調査を行う際にも、関連する業界のウェブサイト全体から情報を収集するためにクローリングが用いられます。

したがって、大規模なデータセットを生成し、ウェブの広範囲な情報を概観したい場合には、クローリングが最適な手法です。

<クローリングを使うべき場面>

- 検索エンジンの最適化 (SEO) :ウェブサイトが検索ランキングで上位に来るように、検索エンジンの視点を解析する。

- 市場調査:競合の動きを探り出し、業界の最新トレンドを把握する。

- コンテンツの集約:分析のために多様なウェブサイトからURLを収集する。

- リンク監査:ウェブサイトのリンクが正常に機能しているかをチェックし、壊れたリンクを特定する。

- Web アーカイブ:記録保持やコンプライアンスのためにウェブページを保存する。

- ソーシャル メディアのモニタリング:ブランドやコンテンツに関する言及がどのように拡散しているかを追跡する。

- 盗作検出:オリジナルコンテンツが無断でコピーまたは使用されていないかを監視する。

- 地理的ターゲット コンテンツ:異なる地域で表示されるウェブコンテンツの違いを比較する。 ニュースとイベントの追跡:トレンドのトピックや現在のイベントに関する情報をニュースサイトやソーシャルメディアから収集する。

スクレイピングを使うべき場面

スクレイピングは、特定のデータをターゲットにして、より集中的に情報を抽出する必要がある場合に適しています。スクレイピングは特定の情報をピンポイントで取り出し、加工することに特化しています。これにより、必要なデータのみを効率的に収集し、加工することが可能です。

例えば、競合他社の商品価格を追跡するためにウェブサイトから価格情報のみを抽出する場合や、特定のニュースサイトから最新の記事のみを収集する場合にスクレイピングが使用されます。

したがって、特定の情報に焦点を当て、それを分析やレポートのために利用したい場合には、スクレイピングが最適な手法です。

<スクレイピングを使うべき場面>

- 価格監視:ECサイトの価格変動を追跡し、賢明な購入や販売の決定を支援する。

- 競合情報: 競合他社のウェブサイトにおける製品更新やコンテンツの変更を監視する。

- センチメント分析: 顧客のレビューやコメントから市場の傾向や世論を分析する。

- データジャーナリズム: 調査報道や詳細な記事作成のために必要なデータを収集する。

- 見込み客の発掘: 潜在顧客の連絡先情報を集め、営業リストを構築する。

- 株式市場分析: 株価や市場の動き、金融ニュースを収集し、投資戦略を練る。

- 気象データ収集: 研究やビジネス上の意思決定のために気象情報を収集する。

- 求人情報のモニタリング: 特定のスキルセットや業界、地域に関連する求人を把握する。

- 不動産市場調査: 不動産価格や家賃、地域情報を集め、市場動向を分析する。

- 学術研究: 研究データを集め、学術プロジェクトのためのデータセットを構築する。

- ソーシャルメディア分析: 投稿やいいね、フォロワー数を抽出し、ブランドや競合の分析を行う。

- 旅行料金の集計: 航空券やホテル、レンタカーの料金を比較サイト用に集める。

- イベント監視: イベントの詳細やチケット価格、空席状況を追跡し、最新情報を提供する。

クローリングとスクレイピングに使われるプログラミング言語

クローリングとスクレイピングの実装には、特定のプログラミング言語が適しています。これらの言語は、それぞれ独自のライブラリやフレームワークを持ち、データの収集と処理において優れた機能を提供します。ここでは、それぞれの言語がどのようにこれらのタスクに役立つか、そしてその選択がプロジェクトにどのように影響を与えるかを探ります。Python

Pythonはその直感的な構文と強力なライブラリのおかげで、データ収集の分野で最も好まれる言語の一つです。クローリングには、高度なデータ収集を可能にするScrapyや、よりシンプルなタスクに適したMechanicalSoupなどがあります。スクレイピングでは、HTMLやXMLの解析に優れたBeautifulSoupや、ウェブリクエストの送信に特化したRequestsが、データ抽出の精度と効率を高めます。これらのツールは、データサイエンスや機械学習の分野での応用にも適しており、Pythonの多様性をさらに広げています。Ruby

Rubyは、その生産性の高さとコードの美しさで知られており、クローリングとスクレイピングのタスクにも適しています。クローリングでは、Anemoneのようなライブラリがウェブの深淵を探索するのに役立ちます。スクレイピングに関しては、NokogiriがXMLやHTMLの解析において強力なツールとして広く利用されています。特にRubyのコードは初心者でも比較的読みやすく、保守が容易なため、長期的なプロジェクトやチームでの開発に適しています。

PHP

PHPはウェブ開発における長い歴史を持ち、クローリングとスクレイピングの分野でもその地位を確立しています。他の言語と比べて文法の自由度が高いため、初心者は基本を学んだ後にPHPの世界に足を踏み入れることが推奨されます。PHPは特にウェブサイトのバックエンドとの連携が得意であり、CMSやEコマースシステムとの統合において強みを発揮します。

JavaScript

JavaScriptは、もともとはフロントエンド開発のための言語でしたが、Node.jsの登場によりバックエンドでもその力を発揮するようになりました。Node.jsを用いたクローリングでは、非同期処理が可能なNode-crawlerが効率的なデータ収集を実現します。スクレイピングにおいても、CheerioやPuppeteerなどのライブラリがリッチなウェブコンテンツの取得を容易にします。JavaScriptのこのような応用は、リアルタイムでのデータ処理や、ウェブベースのアプリケーションとのシームレスな統合を求めるプロジェクトに特に有効です。

クローリングとスクレイピングの組み合わせ方法

クローリングとスクレイピングは、ウェブデータの収集と分析において、それぞれ独立した役割を持ちながらも、組み合わせて使用することでその効果を大いに高めることができます。この組み合わせ技術は、特定のデータが必要であるが、そのデータがどこに存在するのか不明な場合に特に有効です。一般的なプロセスは、まずクローリングでウェブを広範囲にわたって探索し、関連するURLを収集することから始まります。この段階では、目的のデータが含まれている可能性のあるウェブページを大量に識別します。次に、収集したURLの中から、実際に必要なデータを含むページを特定し、スクレイピングを用いて目的の情報を抽出します。

このハイブリッドアプローチにより、データの収集はより目的に沿ったものとなり、無駄なリソースの消費を減らすことができます。また、この方法は、特定のキーワードやパターンに基づいてデータを抽出する際にも有効で、必要な情報を迅速かつ正確に取得することが可能になります。

さらに、このアプローチを取る際には、クローリングで得られたデータを用いてスクレイピングの精度を高めるための機械学習モデルを訓練することも考えられます。これにより、データ収集の自動化と最適化がさらに進み、時間とコストの節約につながります。また、収集したデータの質を維持しつつ、スケーラビリティを向上させることができるでしょう。

スクレイピングの違法性について

スクレイピングの合法性は、多くの場合、対象となるウェブサイトの利用規約、抽出するデータの性質、およびそのデータの使用方法によって異なります。一般的に、公開されている情報をスクレイピングすること自体は違法ではありませんが、著作権で保護されたコンテンツや個人情報を無断で収集・使用することは法的問題を引き起こす可能性があります。したがってスクレイピングを実施する際には、常に関連する法律や規制を遵守する必要があります。とりわけ近年では、多くのウェブサイトが利用規約において、自サイトからのデータの自動抽出を禁止しています。

また、著作権法はオリジナルのコンテンツを保護しており、これを無断でコピーすることは違法行為にあたることが多いです。さらに、データ保護法規、特にEUの一般データ保護規則(GDPR)のような規制は、個人データの収集と処理に厳しい制限を設けています。

例えば、公共の情報を収集することは合法である可能性が高いですが、ログインが必要なサイトからのデータ収集や、個人を特定できる情報の収集は、違法となるリスクがあるため注意しましょう。また、収集したデータの使用目的が合法的であることを確認し、個人情報に関しては特に慎重に扱う必要があります。

まとめ

本記事では、ウェブクローリングとウェブスクレイピングの基本的な概念から、それぞれの違い、適切な使用シーンについて詳しく解説しました。クローリングはウェブページを自動で巡回し、リンクを追跡して情報を収集するプロセスであり、スクレイピングは特定のデータを抽出するための技術です。プログラミング技術を身につけ、これらの技術を使いこなすことで、データドリブンな意思決定に役立つでしょう。

一方、忘れてはいけないことは、データの収集はあくまで手段であり、目的ではないということです。実際にはそのデータからインサイト(洞察)を得て、改善や新たな施策の実施といった具体的なアクションにつなげることが大切です。したがって、ノーコードで誰でもかんたんに操作できるOctoparseなどを使って、データ収集プロセスの効率化を図ることをおすすめします。

元記事:https://www.octoparse.jp/blog/explanation-of-what-is-the-difference-between-crawling-and-scraping