text2animation

ちまたで話題となっているテキストから画像を生成するAI「StableDiffusion」と2つの入力画像から複数の中間フレームを合成するフレーム補間アルゴリズム「FILM: Frame Interpolation for Large Motion」を用いて、StableDiffusionで作成した画像を使ったアニメーションを生成するプログラム”text2animation”を作ってみました。

GoogleColaboratory上で動作します。

https://colab.research.google.com/github/noriakihanya/text2animation/blob/main/text2animation.ipynb

※「StableDiffusion」への入力は日本語にも対応

- text2animation

https://github.com/noriakihanya/text2animation - StableDiffusion

https://github.com/CompVis/stable-diffusion - FILM: Frame Interpolation for Large Motion

https://github.com/google-research/frame-interpolation

デモ

使用方法概略

- Access Tokensの取得

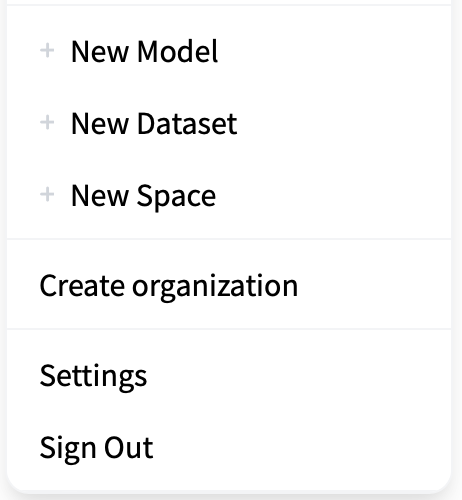

まずはHuggingFaceのサイトでアカウントを作成し、CompVis/stable-diffusion-v1-4へのAccess Tokensを取得

https://huggingface.co

画面右上のアカウントのアイコンから[Settings]->[Access Tokens]に移動しTokenをコピーする

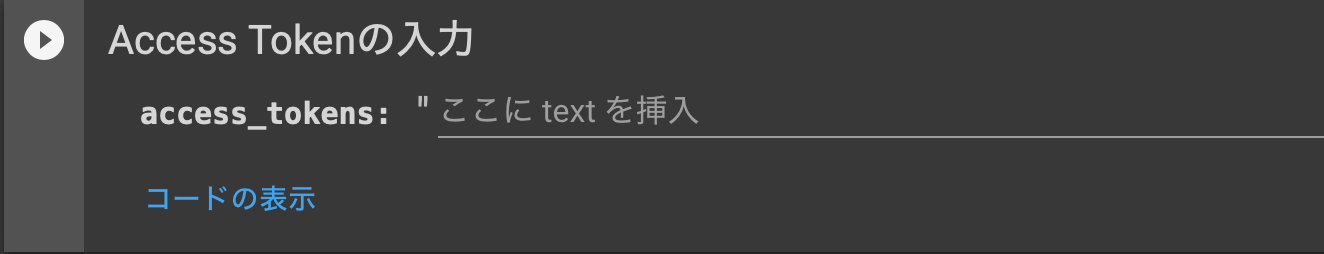

- Access Tokensの入力

コピーしたAccess Tokensを入力する

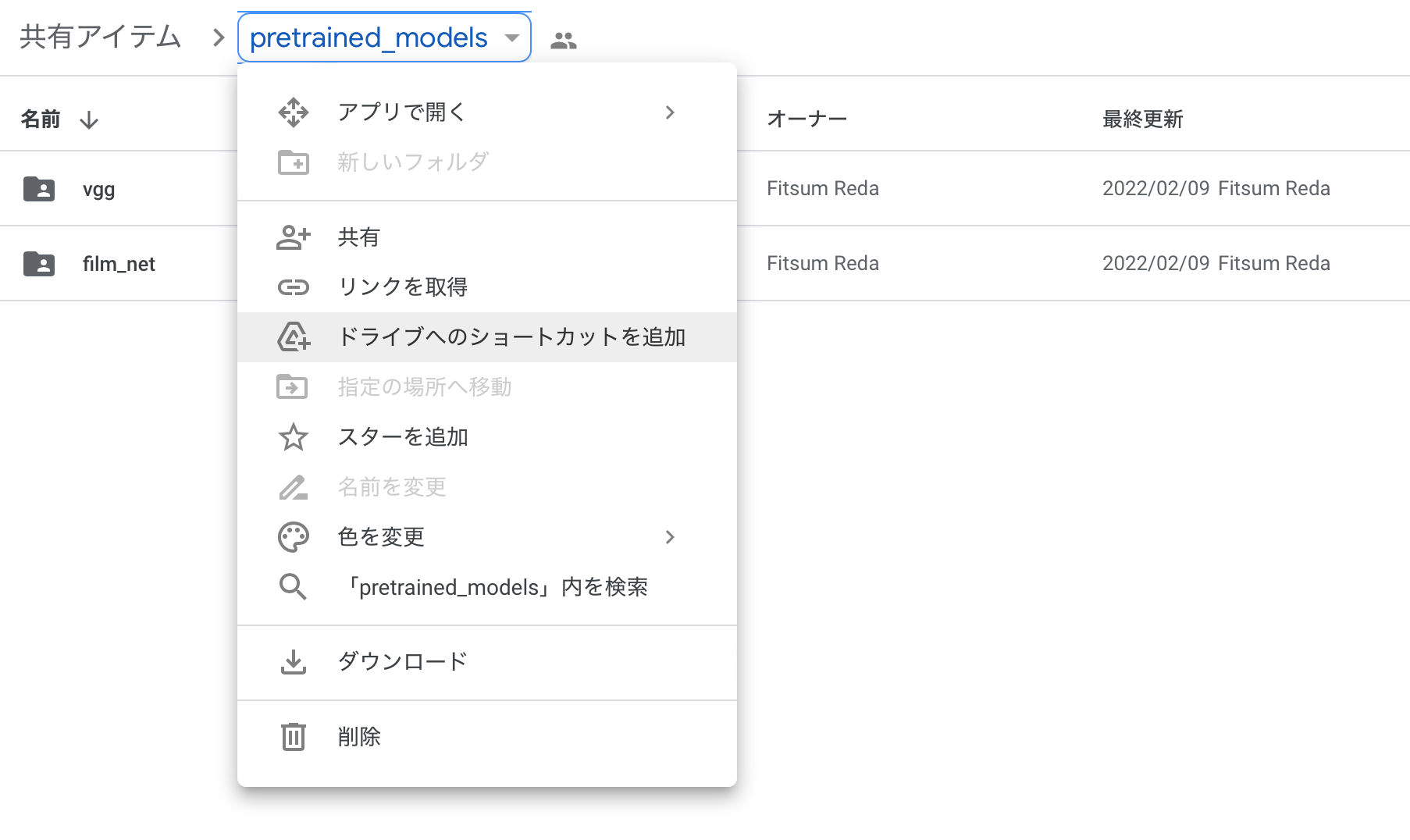

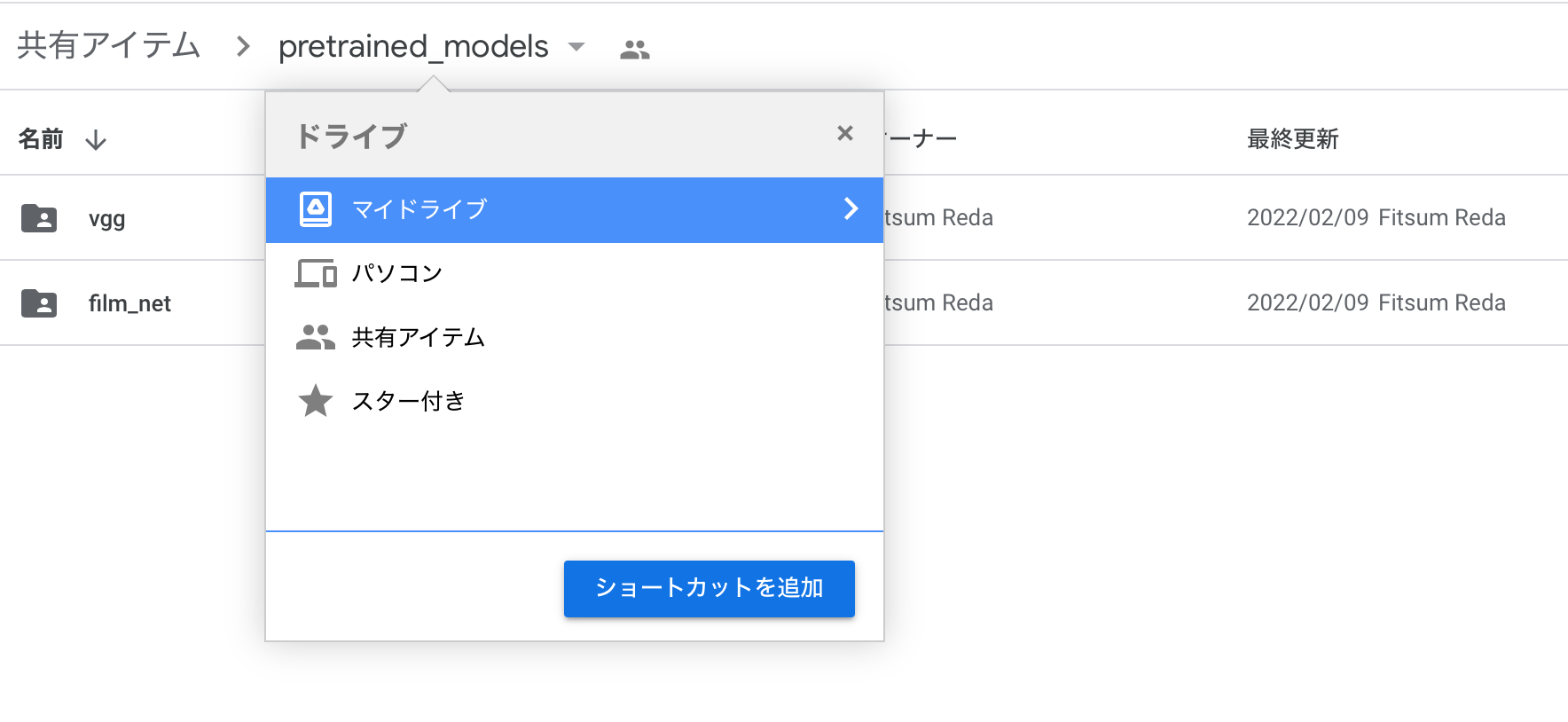

- FILMの学習済みモデルのロード

FILMのモデルはColabからダウンロードできないため、GoogleDriveのMyDriveにモデルのショートカットを追加しロードできるようにする

- 生成したい画像イメージを入力

日本語入力に対応しているため、'日本語入力'か'英語入力'を選択する

英語入力にはあらかじめいくつか選択肢を用意しているが、任意の文字列を入力することも可能

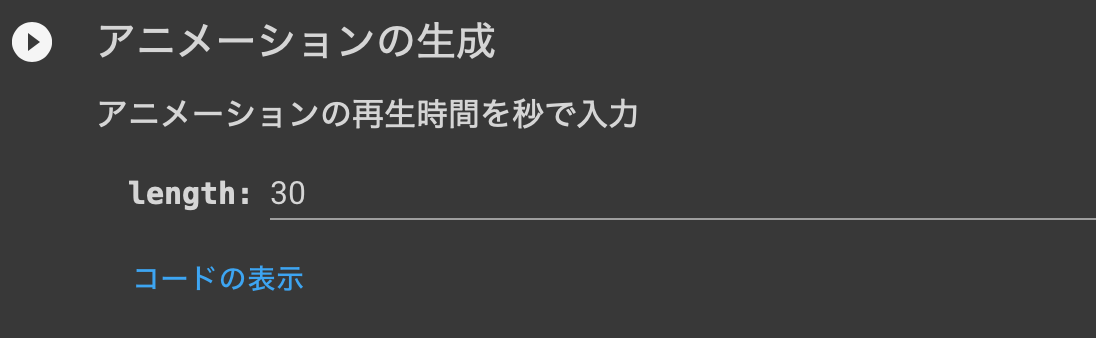

- アニメーションの再生時間を入力

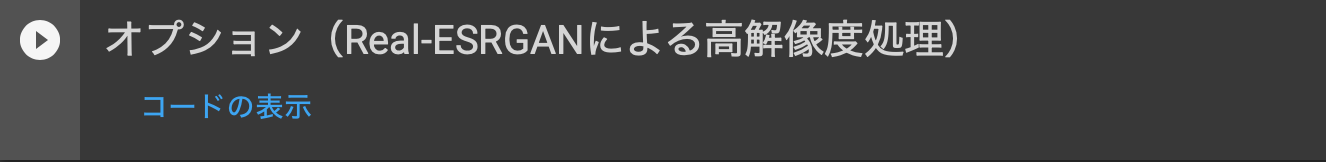

- Real-ESRGANによる高解像度処理

オプションとして、Real-ESRGANによる高解像度処理が使用できます。

- Real-ESRGAN

https://github.com/NightmareAI/Real-ESRGAN

最後に

生成した画像がアニメーションでは一瞬で通りすぎてしまうので、生成画像が長く再生されるよう調整したい。

また、アニメをもっと簡単に編集できる機能も付けてみたい。

参考サイト

https://www.12-technology.com/2022/08/stable-diffusion-aipython.html

https://www.12-technology.com/2022/02/film.html