はじめに

Microsoft Ignite 2025で、GitHubにおけるAIエージェントを活用した開発手法に関するセッション「Safe and Scalable DevOps with AI agents on GitHub」に参加しました。このセッションを選んだ理由は、AIコーディングツールの進化が著しい中で、CursorやClaude Codeといった他のツールとGitHub Copilotをどう使い分けるべきか、特にエンタープライズ環境での安全性とガバナンスの観点から理解を深めたかったためです。

この記事では、GitHubが提唱するAI活用の3つの段階(Wave)、実際のCopilot Agent活用デモ、そしてエンタープライズ環境で重要となるセキュリティとガバナンスの実装方法について、個人的な考察を交えながら解説します。

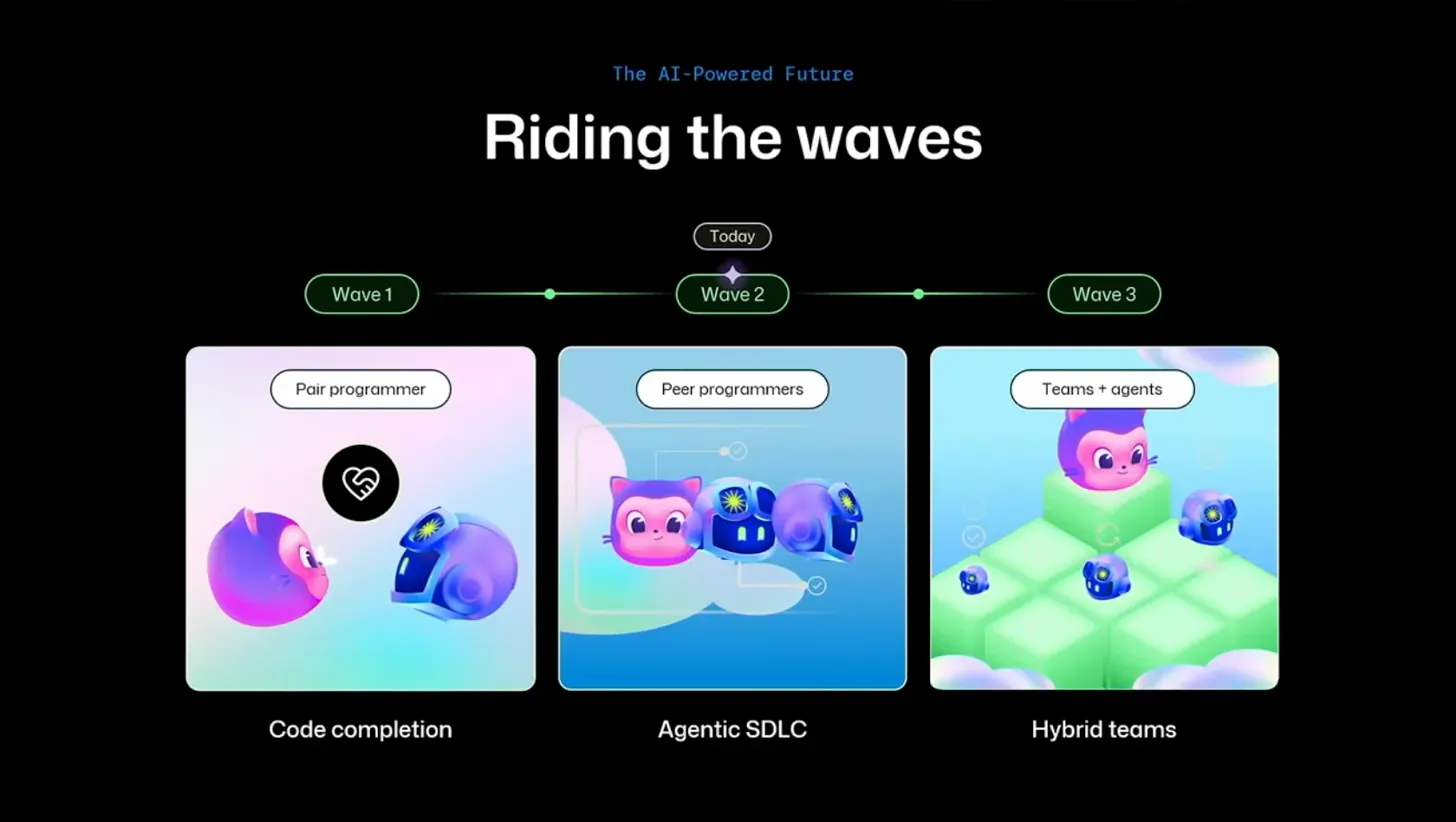

AI開発の3つのWave - 段階的な進化の道筋

セッションの冒頭で、Luke HobanとChris Pattersonは、AI活用による開発の進化を3つのWaveとして整理しています。

**Wave 1: ペアプログラマー(Pair programmer)**は、現在多くの開発者が体験している段階です。コード補完やGitHub Copilot Chatによる対話的なコーディング支援がこれに該当します。この段階ではエンジニアが主導権を持ち、AIは提案役に徹しています。

**Wave 2: Agentic SDLC(Peer programmers)**では、AIがより自律的に動作します。GitHub Copilot Agentのように、Issue作成からコーディング、テスト、プルリクエストまでを一貫して実行できる段階です。この段階では、エンジニアとAIが対等なパートナーとして協働する形になります。

**Wave 3: ハイブリッドチーム(Teams + agents)**は、複数のAIエージェントがチームメンバーとして機能する未来像です。各エージェントが特定の役割を持ち、人間のエンジニアと協働してプロジェクトを進行させます。

この3段階の整理は非常に分かりやすいと感じました。現在のツール選択を考える際にも、自分がどのWaveの機能を必要としているのかを明確にすることで、適切なツールを選べそうです。例えば、Wave 1の段階ではコード補完に優れたツールで十分ですが、Wave 2以降を見据えるとGitHub Copilot Agentのような統合されたプラットフォームの価値が高まるのかなと思います。

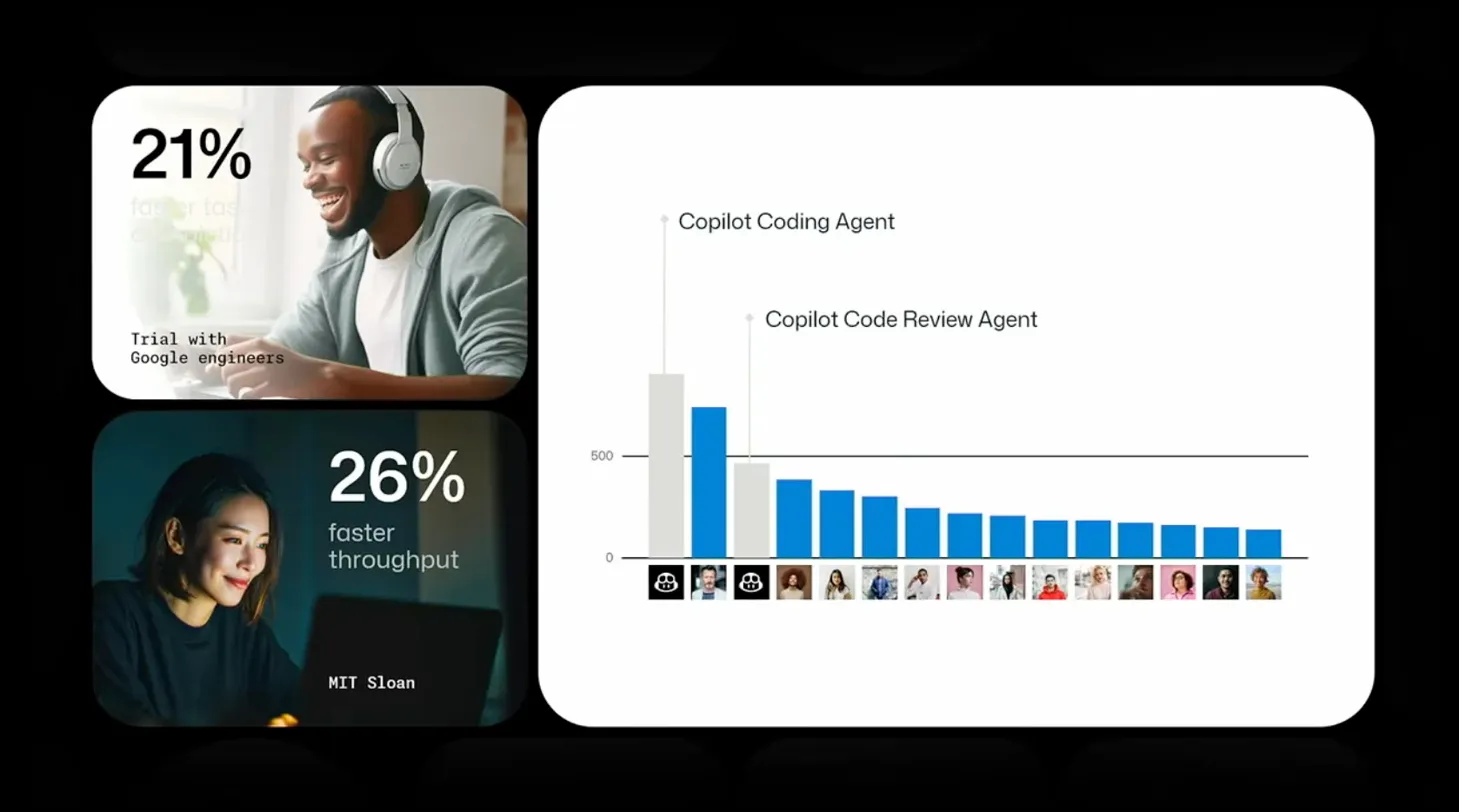

実証された生産性向上 - データで見るAIの効果

セッションでは、GoogleとMIT Sloanの研究データが紹介されました。

Googleのエンジニアを対象としたトライアルでは、Copilot Coding AgentとCode Review Agentの導入により、生産性が21%向上したという結果が報告されています。また、MIT Sloanの研究では、26%のスループット向上が確認されました。

これらの数値は印象的ですが、実際の開発現場では単純な生産性向上だけでなく、コードの品質維持やレビューの質も重要です。特に企業での導入を考えると、「速く書ける」ことよりも「安全に書ける」「レビューしやすい」ことの方が重要なケースも多いのではないでしょうか。

この点で、セッション後半で紹介されるガバナンス機能との組み合わせが重要になると感じました。単に生産性を上げるだけでなく、品質とセキュリティを担保した上での効率化が、エンタープライズ環境では求められます。

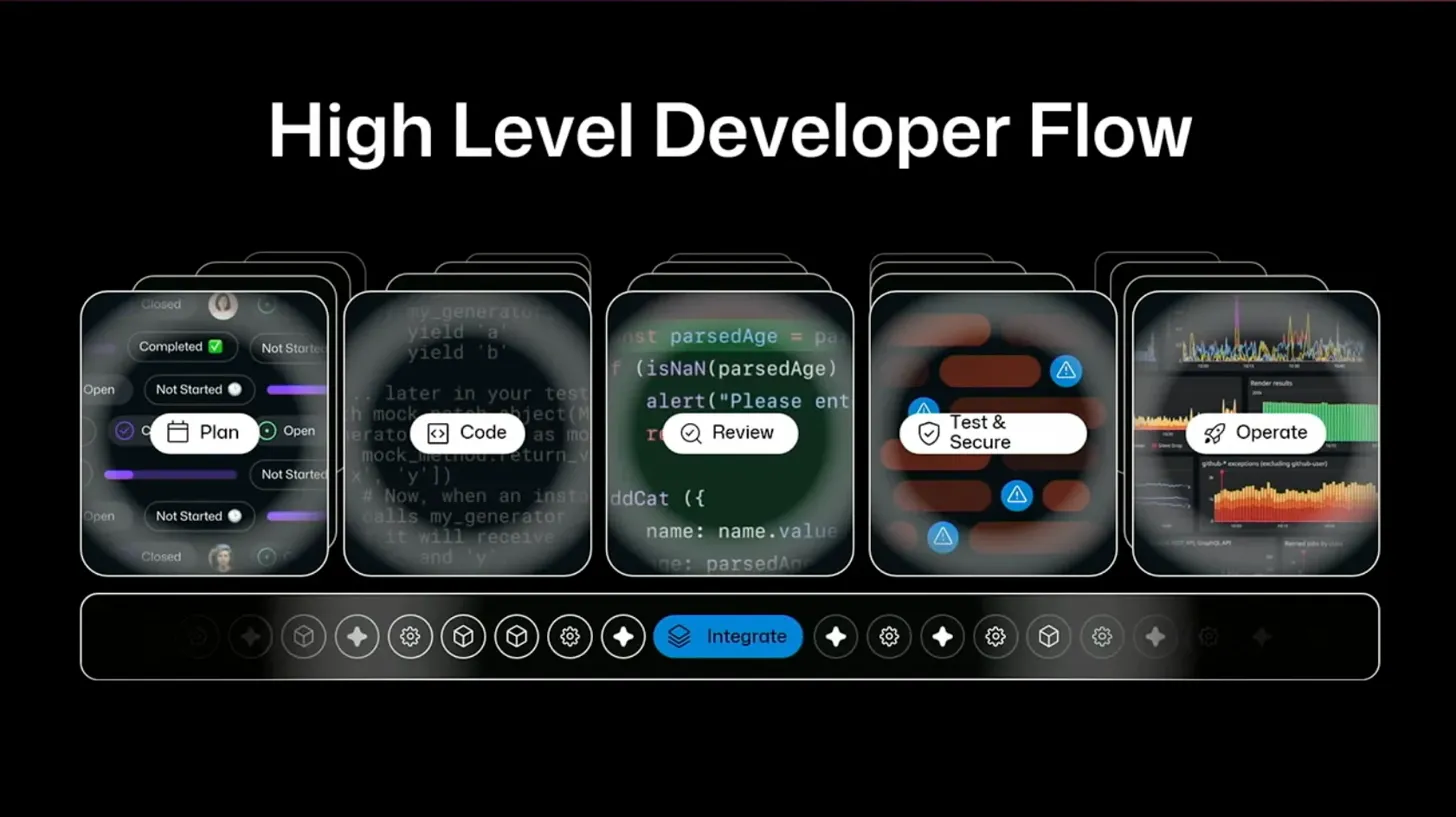

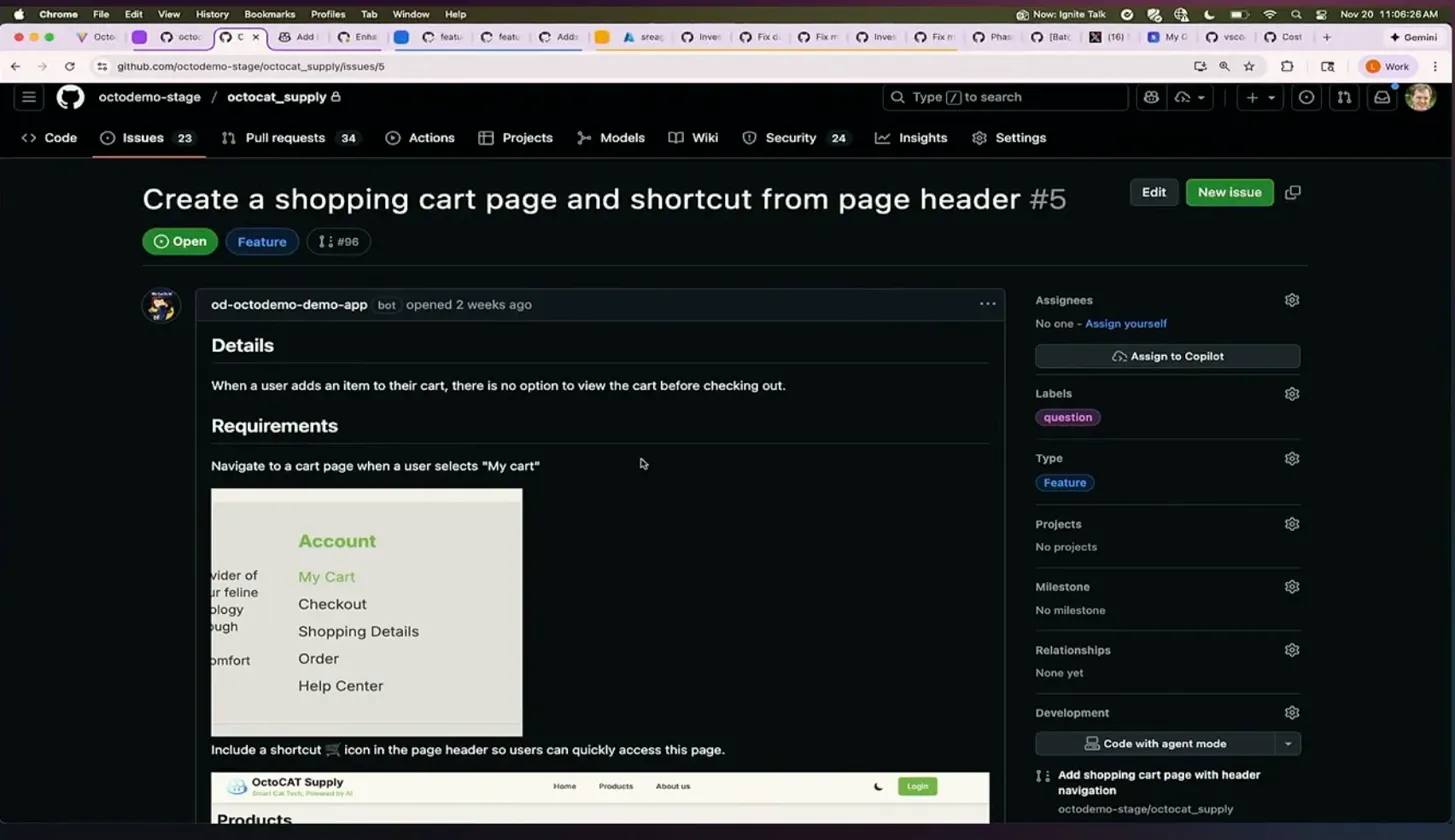

GitHub Copilot Agentの実践 - Issue作成からマージまで

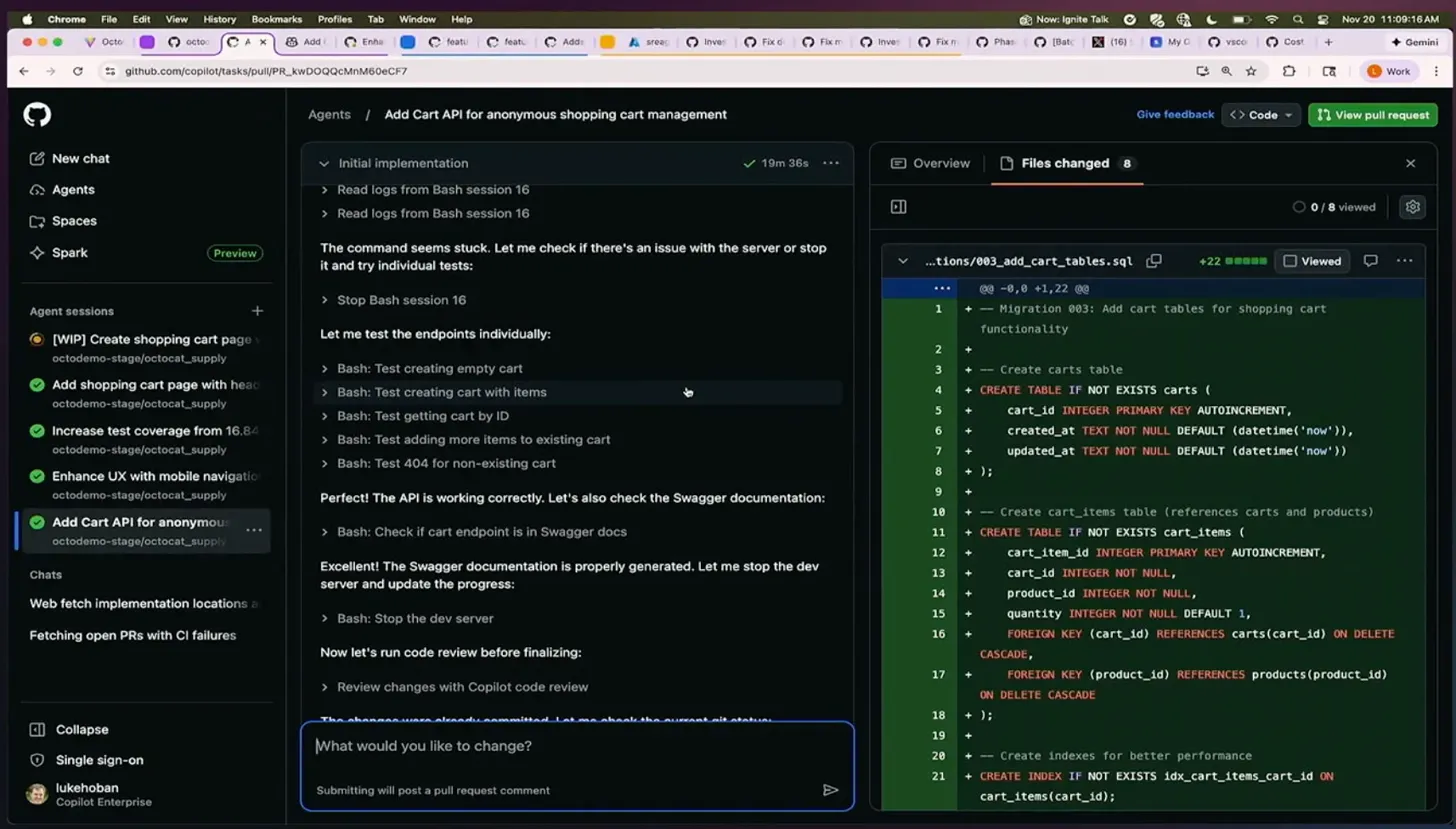

セッションのハイライトは、GitHub Copilot Agentの実際のデモでした。

デモでは、ECサイトのショッピングカート機能を追加するという具体的なタスクが実演されました。エージェントは以下のステップを自律的に実行します:

- Issue作成: ユーザーストーリーとして「カートページの作成」と「ヘッダーにショートカット追加」を明確化

- コード生成: データベースマイグレーション、APIエンドポイント、フロントエンドコンポーネントを生成

- テスト実行: 自動的にテストを実行し、APIの動作確認とSwaggerドキュメント生成

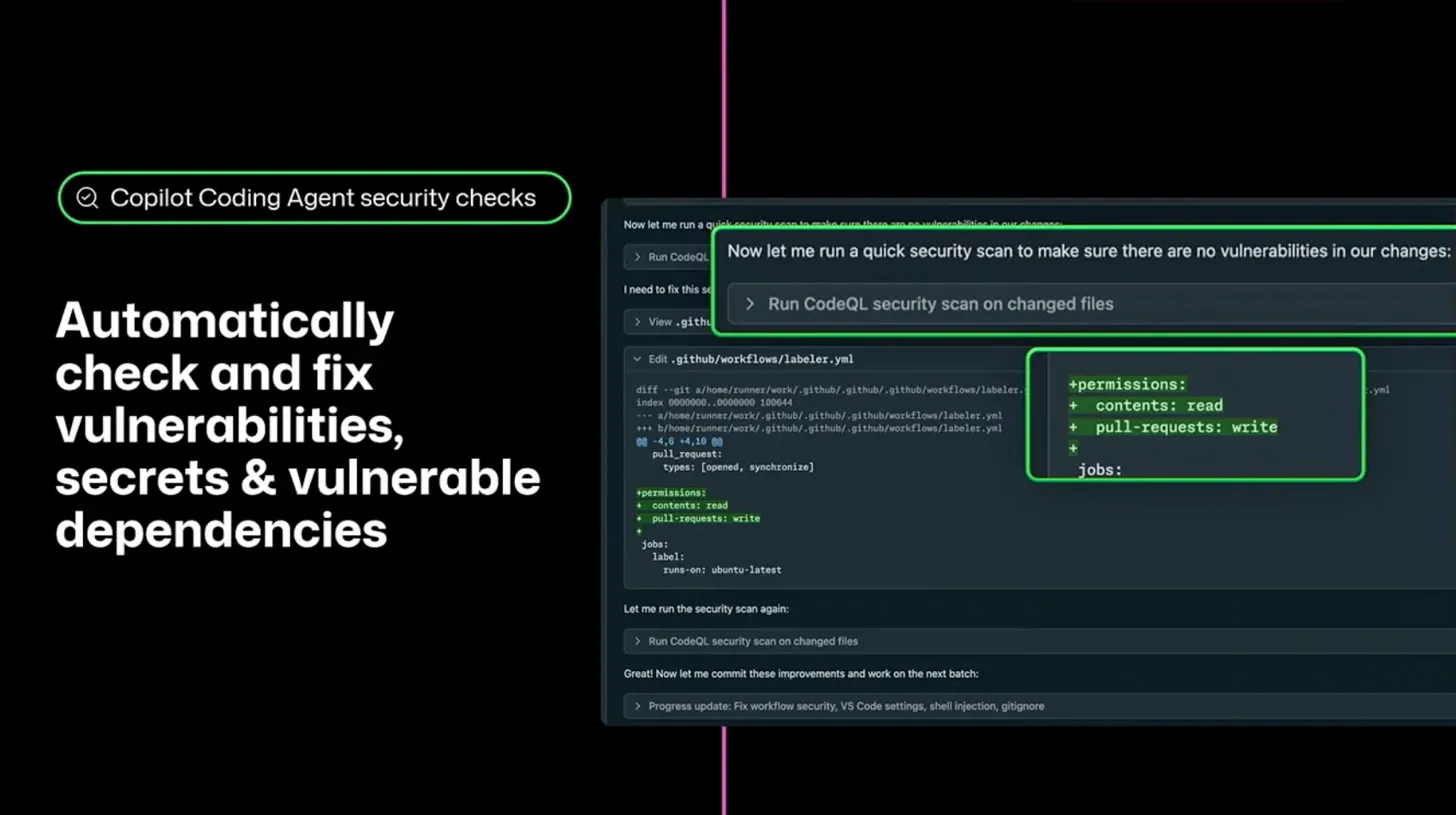

- セキュリティチェック: CodeQLによる脆弱性スキャンを自動実行

- コードレビュー: Copilot Code Review Agentによるレビューコメント

- プルリクエスト作成: 変更内容をまとめてPR作成

この一連の流れを見て、CursorやClaude Codeとの大きな違いを感じました。これらのツールも優れたコード生成能力を持っていますが、GitHub Copilot Agentの強みはGitHubプラットフォームとの深い統合にあります。Issue管理、CI/CD、セキュリティスキャン、コードレビューといった開発ライフサイクル全体が一つのプラットフォーム上で完結する点は、特にチーム開発において大きなメリットだと感じました。

一方で、個人開発やプロトタイピングの段階では、IDE統合型のツールの方が素早くコードを試せる利点もあります。使い分けとしては、個人での探索的な開発は軽量なツール、チームでの本番開発はGitHub Copilot Agentという棲み分けが現実的かもしれません。

セキュリティとガバナンス - エージェントの安全な運用

エージェントが自律的に動作する以上、セキュリティとガバナンスは極めて重要です。セッションでは、GitHub Copilot Agentに組み込まれた複数の安全機構が紹介されました。

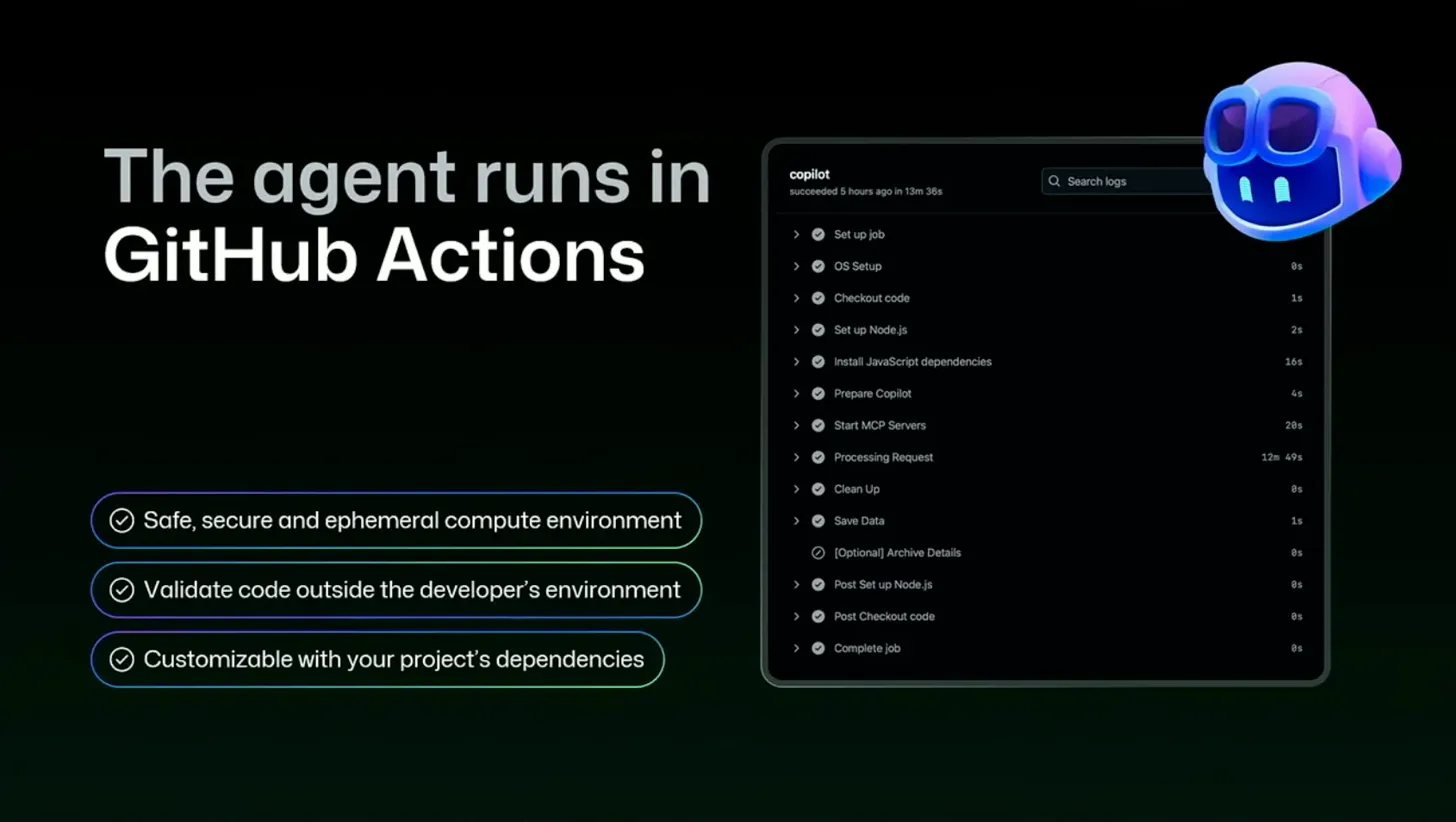

エージェントの実行環境は、GitHub Actions上で動作します。これには3つの重要な特徴があります:

- 安全で一時的な計算環境: エージェントは分離された環境で実行され、実行後は破棄されます

- 開発者環境外での検証: 開発者のローカル環境を汚染せず、Actionsを実行する前にコードを検証できます

- プロジェクト依存関係のカスタマイズ: プロジェクト固有の依存関係を含めた検証が可能です

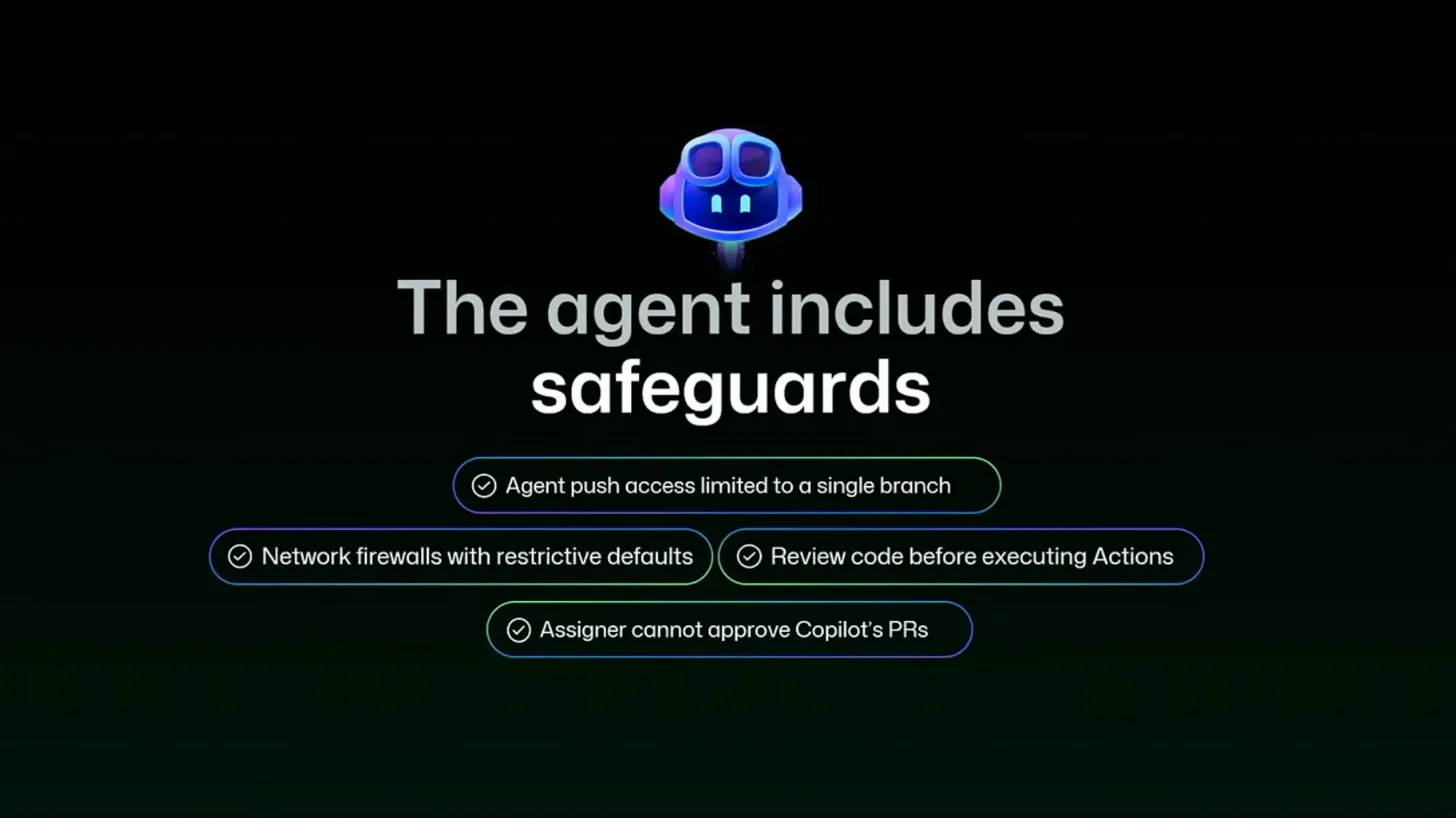

組み込まれた安全機構として、以下の4つが実装されています:

- 単一ブランチへのプッシュアクセス制限: エージェントは指定されたブランチにのみ変更を加えられます

- 制限的なネットワークファイアウォール: デフォルトで外部ネットワークアクセスを制限します

- Actions実行前のコードレビュー: エージェントが生成したコードは、GitHub Actionsで実行される前に必ずレビューされます

- Copilotによるプルリクエスト承認の禁止: エージェント自身はPRを承認できず、必ず人間の承認が必要です

これらの安全機構は、エンタープライズ環境で非常に重要だと感じました。特に「エージェント自身はPRを承認できない」という制約は、最終的な判断を人間が行うという原則を守る上で不可欠です。

企業での導入を考えた場合、これらのガバナンス機能がすぐに使える状態で提供されていることは大きなアドバンテージです。他のAIコーディングツールを企業で使う場合、こうした統制をどう効かせるかは別途考える必要がありますが、GitHub Copilot Agentではプラットフォームレベルで対応されています。

ただし、日本企業特有の課題として、「AIが書いたコード」に対する責任の所在をどう整理するかという問題は残ります。技術的な安全性は担保されていても、組織文化としてAIエージェントを受け入れる土壌作りが必要だと感じました。

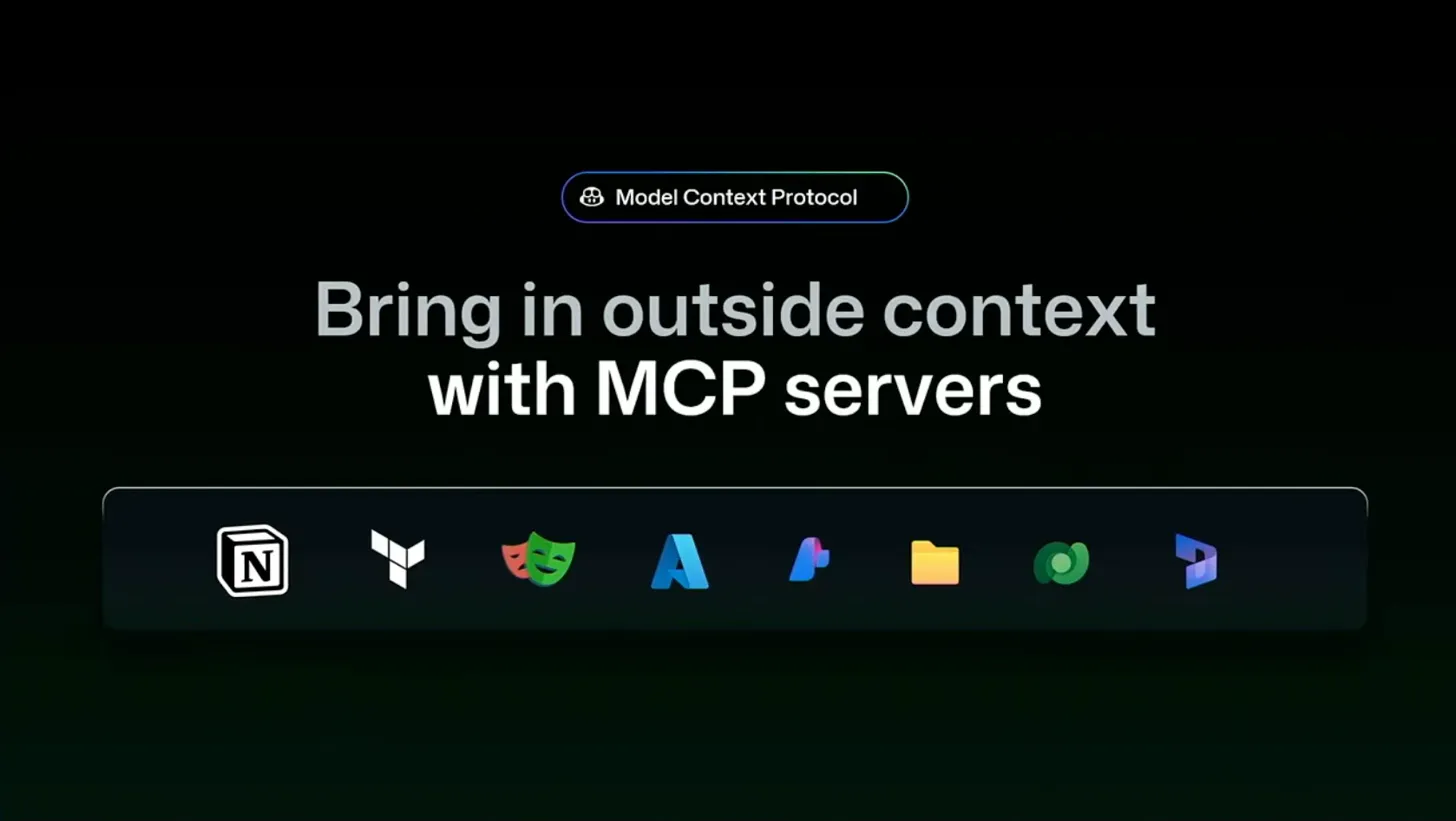

Model Context Protocol(MCP)による拡張性

GitHub Copilot Agentの大きな特徴の一つが、Model Context Protocol(MCP)を通じた外部コンテキストの統合です。

MCPサーバーを通じて、Notion、Playwright、Azure、Figma、ファイルシステム、Spotify、Puppeteerなど、さまざまな外部サービスの情報をエージェントに提供できます。

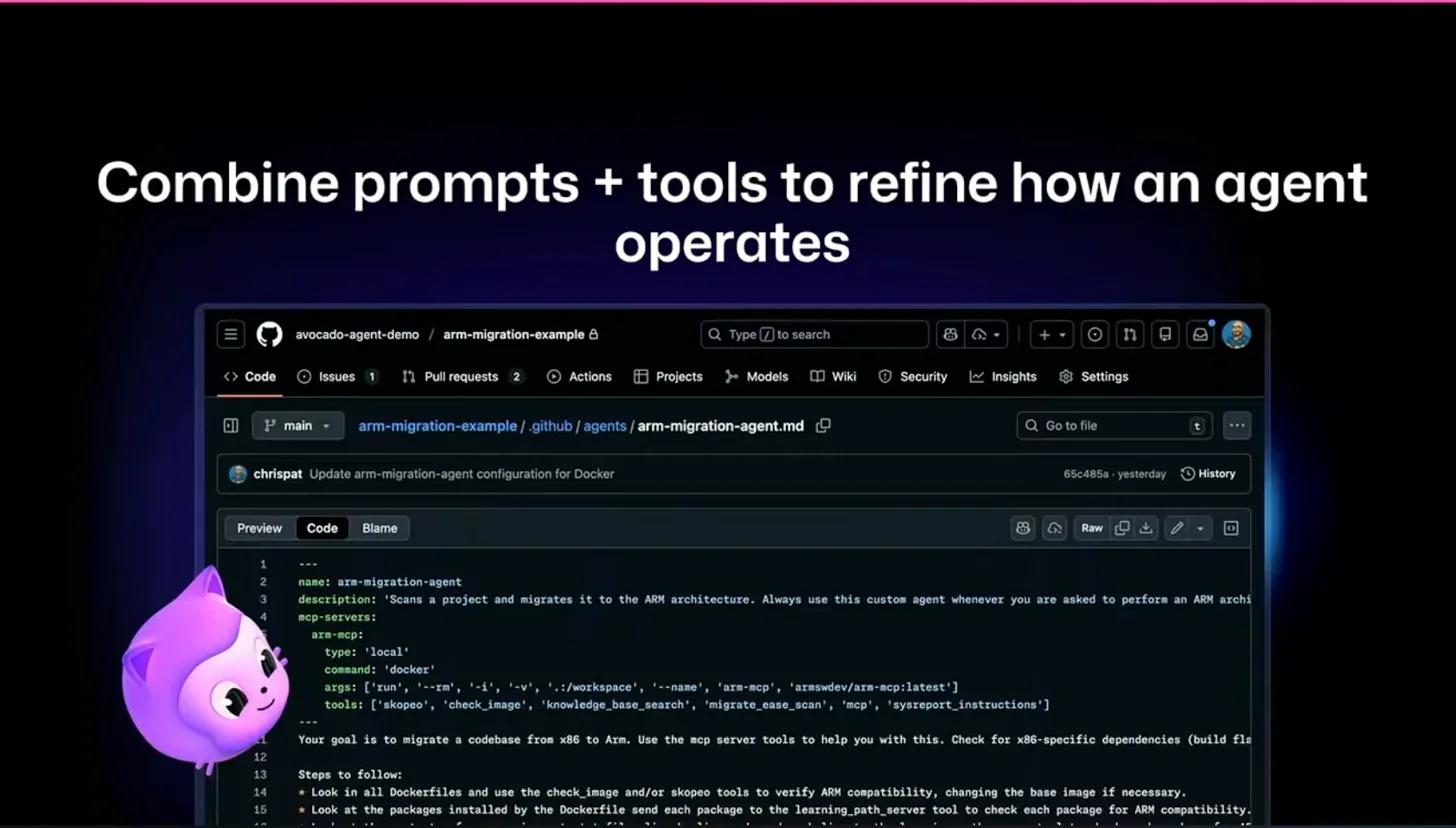

セッションでは、ARM移行エージェントの例が紹介されました。このカスタムエージェントは、Dockerfileをスキャンし、ARMアーキテクチャとの互換性をチェックし、必要に応じて修正を提案します。MCPサーバーを使って、Skopeoによるイメージチェック、ナレッジベース検索、移行容易性スキャン、システムレポート生成といった専門的なツールにアクセスできます。

エージェントの定義は、GitHubリポジトリ内の.github/agentsディレクトリにMarkdownファイルとして配置するだけです。プロンプト、使用するMCPサーバー、実行ステップを定義することで、カスタムエージェントを作成できます。

この仕組みは非常に興味深いと感じました。プロジェクト固有のナレッジベースやAPIドキュメントをMCPサーバーとして提供することで、エージェントがより適切なコードを生成できるようになります。例えば、社内のデザインシステムやコーディング規約をMCP経由で参照させることで、チーム標準に沿ったコードを生成させることが可能です。

ただし、MCPサーバーの開発と運用には一定のコストがかかります。小規模なチームでは、まず標準のCopilot Agentを使い、明確な拡張ニーズが見えてからMCPサーバーを開発する段階的なアプローチが現実的だと思います。

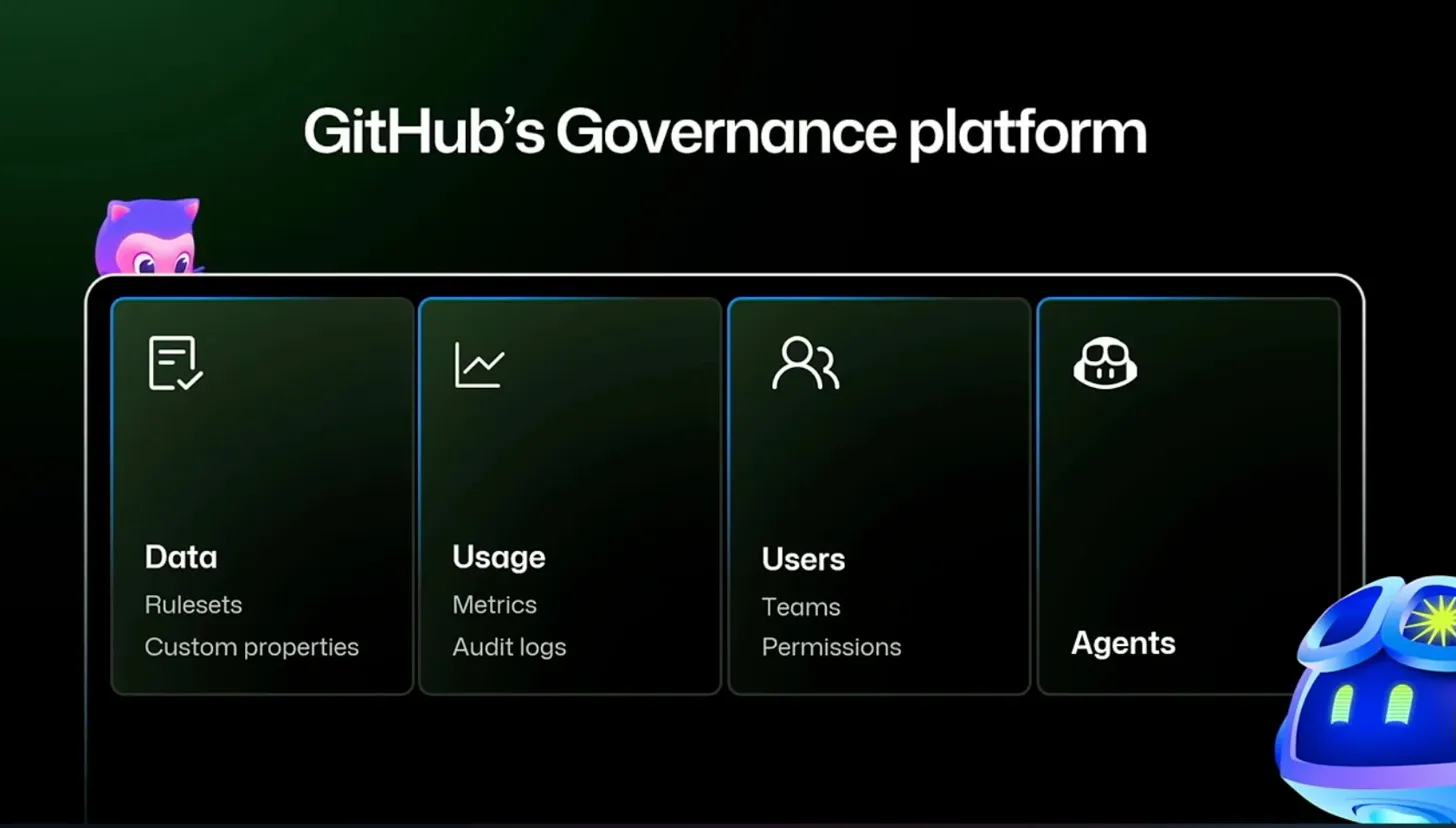

エンタープライズ管理 - 統合されたガバナンスプラットフォーム

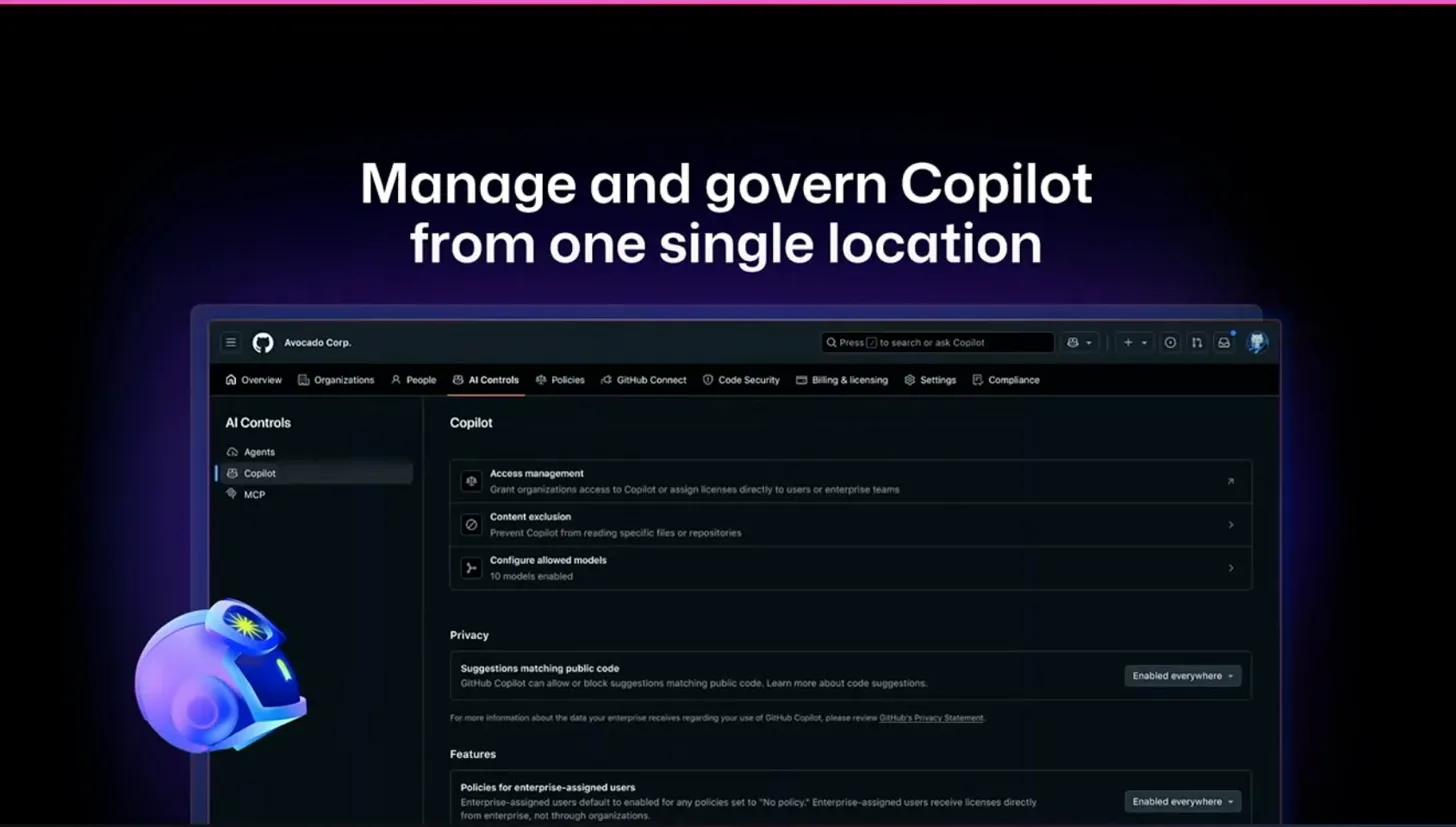

セッションの最後では、エンタープライズ向けの管理機能が紹介されました。

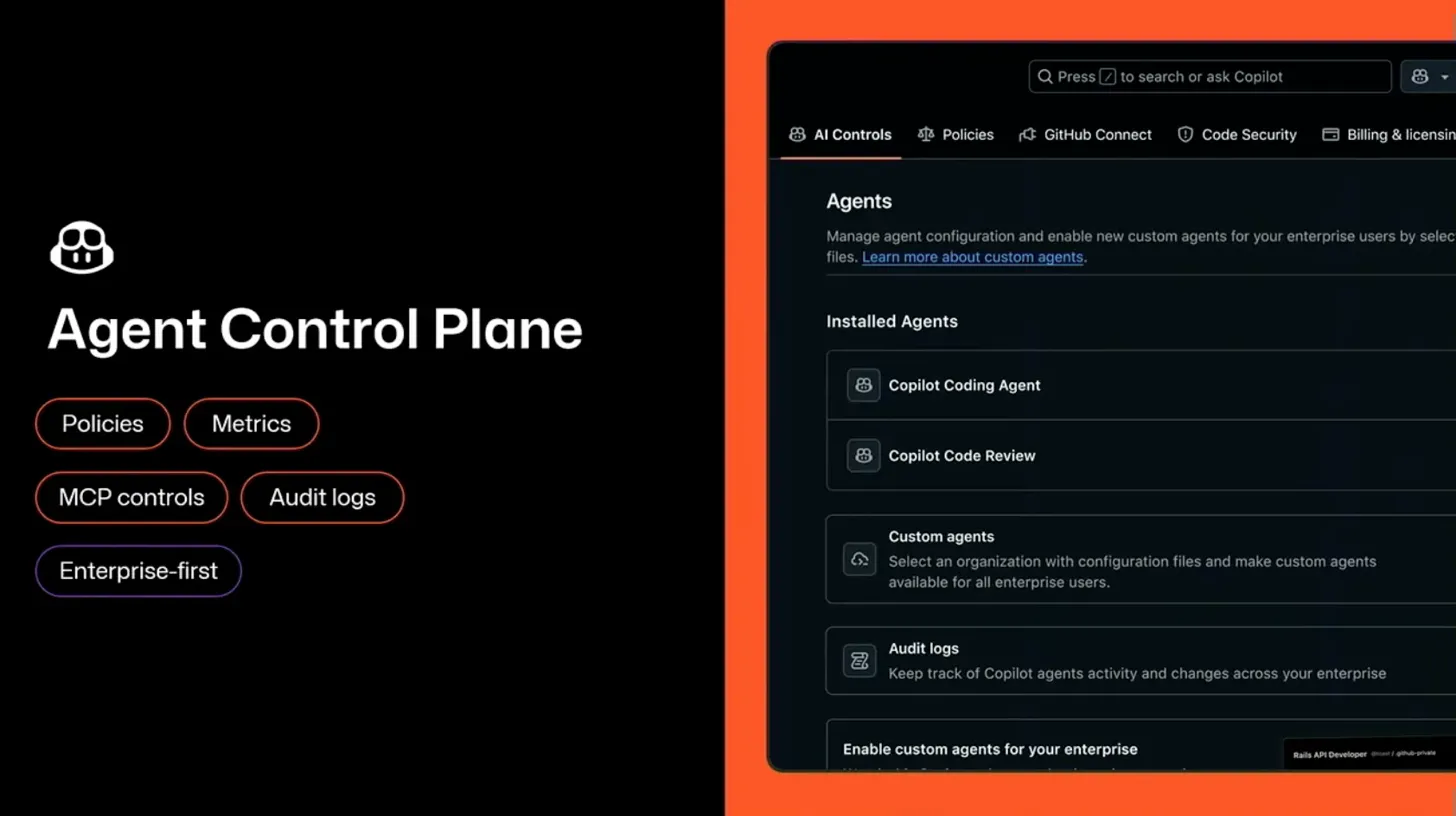

GitHub Enterprise Cloudでは、単一のコントロールプレーンからCopilotとエージェントを管理できます。主な機能として以下が提供されています:

Agent Control Plane:

- ポリシー設定: アクセス管理、コンテンツ除外、使用可能なモデルの設定

- メトリクス: 利用状況とパフォーマンスの可視化

- MCPコントロール: 外部コンテキスト統合の管理

- 監査ログ: エージェントのアクティビティと変更の追跡

Copilot管理:

- アクセス管理: 組織レベルでのライセンス割り当て

- コンテンツ除外: 特定のファイルやリポジトリの除外設定

- モデル設定: 使用するAIモデルの選択

- プライバシー設定: パブリックコードマッチングの制御

この統合管理機能は、エンタープライズ導入の大きな障壁を下げる要素だと感じました。他のAIコーディングツールを組織全体で導入する場合、誰がどのように使っているのか、どんなコードが生成されているのかを把握するのは困難です。GitHub Copilotでは、これらの可視化と制御が標準機能として提供されています。

企業のIT部門の視点から見ると、監査ログとメトリクスの存在は非常に重要です。コンプライアンス要件を満たすためには、「誰が、いつ、何をしたか」を追跡できることが必須条件になるケースが多いためです。

ただし、日本企業での導入を考えると、これだけの管理機能があっても、「AIが書いたコード」を本番環境にデプロイすることへの心理的なハードルは残ります。段階的な導入として、まずは開発環境やテスト環境での利用から始め、実績を積み重ねてから本番環境に広げていくアプローチが現実的かなと思います。

Cursor / Claude Codeとの比較考察

このセッションを視聴して、GitHub Copilot Agent、Cursor、Claude Codeそれぞれの強みと適用場面が明確になってきました。

GitHub Copilot Agentの強み:

- GitHubプラットフォームとの深い統合(Issue、PR、Actions、Security)

- エンタープライズ向けガバナンス機能が標準装備

- チーム開発に最適化された設計

- MCPによる拡張性

Cursorの強み:

- IDE統合による高速な開発体験

- ローカルでの即座なフィードバック

- 個人開発での生産性の高さ

- シンプルで直感的なUI

Claude Codeの強み:

- ターミナルベースの柔軟性

- Claudeの強力な推論能力

- コマンドラインワークフローとの親和性

使い分けとしては、以下のような棲み分けが考えられます:

- 探索的なプロトタイピング: Cursor(素早く試せる)

- チームでの本番開発: GitHub Copilot Agent(ガバナンスと統合性)

- 複雑な問題解決: Claude Code(深い推論が必要な場合)

特に重要なのは、個人で新しいアイデアを試すフェーズと、チームで実装するフェーズで適切にツールを切り替えることです。探索フェーズでは軽量なツールを使い、チームで実装するフェーズに移行したらGitHub Copilot Agentに切り替えるというワークフローが効率的かもしれません。

まとめと今後のアクション

このセッションを通じて、GitHub Copilot Agentが単なるコード補完ツールではなく、開発ライフサイクル全体をカバーする統合プラットフォームとして設計されていることを理解できました。

主な学び:

- AI開発の3つのWave(ペアプログラマー、Agentic SDLC、ハイブリッドチーム)という明確なロードマップ

- エンタープライズに必要なセキュリティとガバナンス機能が標準装備されている点

- MCPによる拡張性により、プロジェクト固有のコンテキストを統合できる柔軟性

- 統合管理プラットフォームにより、組織全体での導入と運用が現実的になっている

エンタープライズ環境でのAIエージェント活用は、技術的な側面だけでなく、組織文化や運用プロセスの変革も伴います。このセッションで示された段階的なアプローチ(Wave 1→2→3)を参考に、焦らず着実にAI活用を進めていくことが重要だと感じました。