OpenAIによりGPT-5に関する発表が、8月8日(金)深夜2:00にありました。

毎度深夜の発表なので日本勢にとってはリアタイはしんどいですが、仮眠して情報をまとめたので読んでみてください。

今週はClaude Opus 4.1や、GoogleのGenie3(リアルタイム世界モデル)などのリリースも重なり、情報過多な週だったと思います。

そんな中で発表されたGPT-5、早速紹介していきます。

▼ 公式YouTube動画

※ 忙しい人向け

目新しい革新的アップデート!!...というよりはこれまでの課題を着実に潰しつつ性能も向上したシンプルにいいモデルを公開したというような位置付けかと思います。

安全面の配慮や、モデルの動的な切り替えのシステムを標準搭載したなどですね。

個人的にはその中でコーディング力の向上がアツいのかなと考えています。

自律的コーディング面がかなり強化されているようで、その効果を実感するには触ってみないと本当の意味では分からないのかなと思います。

発表ではUIはかなり洗練されたものがポン出しで出ていて、他のモデルに比べてかなり品質が高いのではと思いました。

それ以外のコーディング面については実際にタスクを実行させてみたら、他のモデルとの差分が見えてくると思うので、まず使おうと思います。

対象読者

- AIの最先端情報に興味がある人

- AIを開発や自分の業務に使いたい人

- 忙しくてAI情報を追いかけられていない人

目次

1|GPT-5の主な特徴

2|モデル利用について

3|おまけ

筆者について

東京大学で画像/動画AIの研究をしていたり、

動画編集AIエージェントのサービス「VideoPocket」の開発をしています。

Xでは主に動画 × AIで情報発信をしています。 動画AIや、Claude Codeを使った全自動の動画編集などの情報を発信しているので、フォローすると活用方法やエッジの事例をいち早く知れると思います。

それでは早速みていきましょう。

1|GPT-5の主な特徴

1-1|モデルのラインナップが刷新

これまであったo3などのモデルが廃止され、gpt-5 / gpt-5-mini / gpt-5-nano という名前に統一されました。

| モデル | メイン用途 |

|---|---|

| gpt-5 | 複雑な推論、専門知識が問われる問題やマルチステップのエージェントタスク |

| gpt-5-mini | 速度、コスト、機能のバランスが良く、日常的なチャットや簡単な推論タスクに向いている |

| gpt-5-nano | 単純な指示や分類など、処理速度を優先したいタスクに向いている |

1-2|リアルタイムルーター搭載

ユーザーの質問の複雑さや会話の内容に応じて、高速なモデルと思考する高性能なモデルを自動で切り替えるリアルタイムルーターを搭載しています。

特に「少しだけ考えてあとは高速に回答する」のような使い方が可能で、回答の質と速度の両方を高くすることができるそうです。

1-3|コーディング力の向上

個人的に一番期待しているのはここです。

ベンチマークでは既存のモデルよりも性能が高いことが言及されていましたが、どちらかというと実際に使うときに体感値でどれくらい使えるようになったのか?という現場レベルでの効用に期待しています。

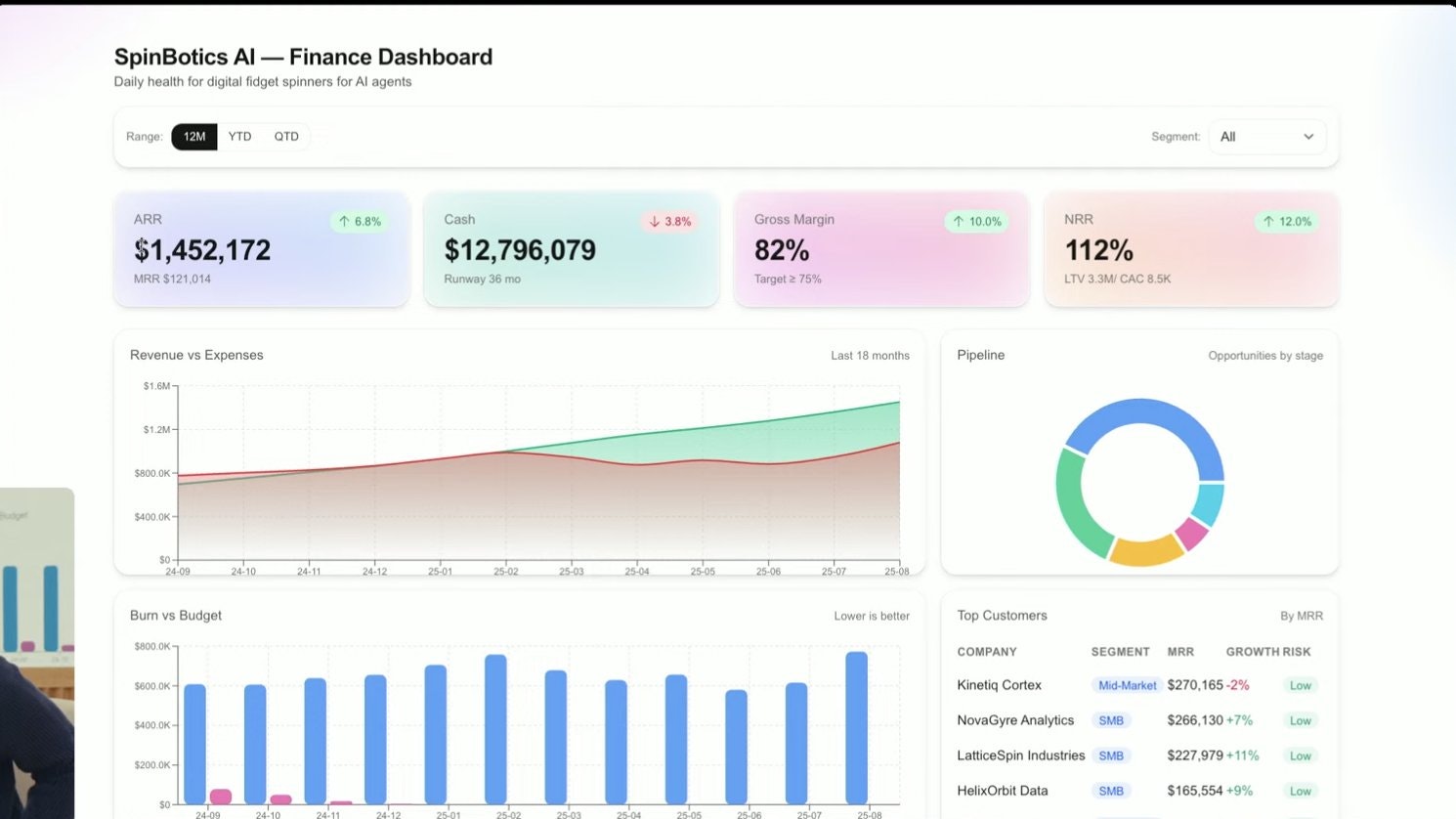

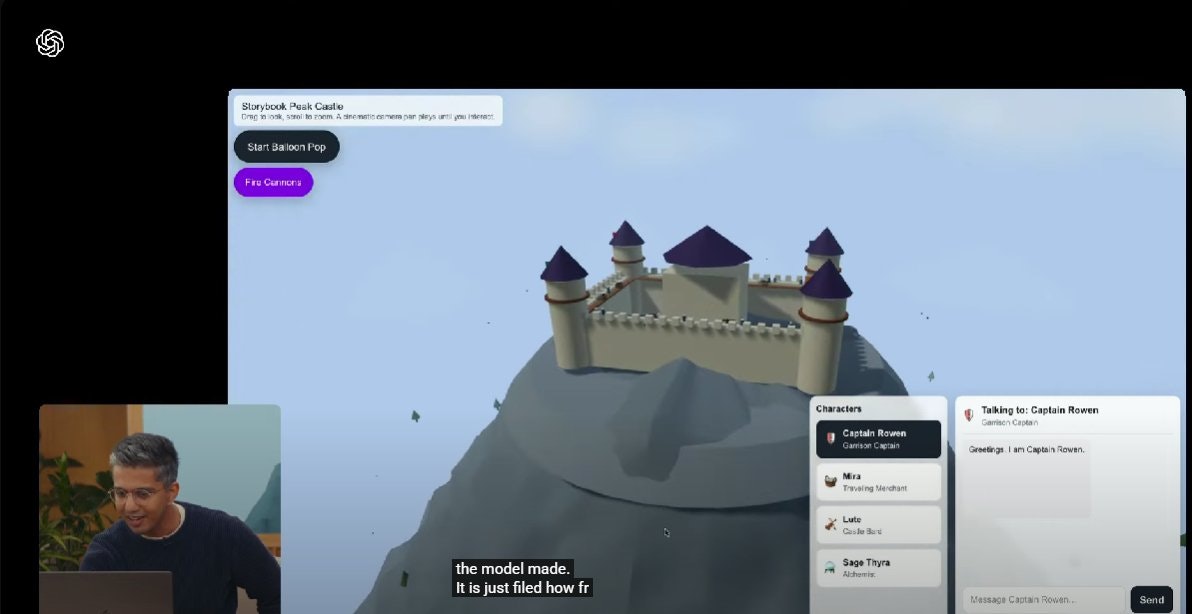

デモではバイブコーディング的にポン出しでかなり自然なUIを生成したり、3Dモデルを一発で生成させたことが素直にすごいなと思いました。

ClaudeなどUIデザイン綺麗なのですが、それを超える品質かもしれないと思い、期待が高まっています。

特に私はAI × 動画編集の領域に注力していて、動画をコーディング的なアプローチで効率化・高品質化することに取り組んでいます。

その観点でも動画作成にGPT-5を利用することでデザイン性の高い動画を自動生成できるかについては興味があるのでどんどん実験していきます。

2|モデル利用について

2-1|Webアプリでの利用

順次ユーザーに公開されていきます。

無料ユーザーも利用できるとのことで、より多くの人にすごさを体験してほしいですね。

数ヶ月前のジブリ風の画像生成がブレイクした時もマスをうまく巻き込むことに成功しているので、今回もライトに価値を体験できてバイラルが起きることを狙っているのかもしれません。

※ ちなみにスマホ経由でProなど契約している方は、GPT-5の公開が遅くなってしまうそうです。

(追記)→ 私のスマホでは、当日午前5時頃にGPT-5の案内が来て使えるようになったので、必ずしもその限りではなさそうです。

2-2|API利用

その他、APIなど開発をする上で必要となる情報について整理します。

モデルスペックについて:

| 項目 | スペック |

|---|---|

| APIモデル名 | gpt-5-2025-08-07 |

| コンテキストウィンドウ | 400k トークン |

| 最大出力トークン | 128k トークン |

| ナレッジカットオフ | 2024年10月1日 |

API料金について(100万トークンあたり):

| モデル名 | 入力 | キャッシュ | 出力 |

|---|---|---|---|

| gpt-5 | $1.25 | $0.125 | $10.00 |

| gpt-5-mini | $0.25 | $0.025 | $2.00 |

| gpt-5-nano | $0.05 | $0.005 | $0.40 |

パラメタも新規に追加されるようです:

-

verbosity:出力の詳細度をlow,medium,highから選べる -

reasoning.effort:minimalに設定すると、推論を最小限にして最速の応答を得られる

3|おまけ

無料利用する方法

Cursor、Windsurfなどは、gpt-5が期間限定で無料で使えるようになっています。是非試してみてください!ちなみにCursorの内部のエンジニアが実際にGPT-5がすごいと好評だったそうで、やはり実際に使って初めて実感できるものがあるはずです。

ぜひみなさんも試していきましょう!

プロンプトガイド

GPT-5のプロンプトガイドが公開されています。OpenAI公式のプロンプトベストプラクティス集です。

フロントエンドの推奨スタックも記載されていますね(Tailwind CSS, shadcn/ui, Redix Themesなど)

システムカード

GPT-5の構成・能力・安全に関する対策をまとめた公式ドキュメントです。

ハルシネーション低下や、安全性を守りつつできる限り回答をする姿勢、へつらう系(「すみません、ユーザーのおっしゃる通りです!」のようなちょっと大げさな発言など)の回答が減少したなどのアプローチも触れられています。

GPT-5のシステムプロンプト

GPT-5のシステムプロンプトを聞き出すことができたようです。ぬこぬこ氏の投稿で詳細が記載されていますので、気になる方は投稿をご確認ください。

おわりに

GPT-5の現時点の観測情報を整理しました。

正直なところ、見た目のインパクトは少なく使ってみる中で味が分かってくる系なのかなという印象です。Googleの発表は視覚的に驚きを覚えるものが多く、対照的に感じました。

触ってみて、「こういう使い方でめっちゃ使えるじゃん!」というケースが出てくるのではと思うので発表情報だけをみて鵜呑みにせずに、実際に手を動かして自身のビジネス活用や創作活動にうまく使えるかを確かめていくことが重要だと思います。

性能やユースケースは今後もたくさん出てくるはずなので、動向を追ってシェアしていきます。

個人的には発表もそうですが、実際に使って、特に動画編集領域でうまく活用していきたいと思います。

Xでは主に動画 × AIで情報発信をしています。 動画AIや、Claude Codeを使った全自動の動画編集などの情報を発信しているので、フォローすると活用方法やエッジの事例をいち早く知れると思います。