「AI で何か作りたい」と思った瞬間、選択肢の多さに途方に暮れたことはありませんか?

LLM だけでも GPT-5、Claude 4.5、Gemini 3、Llama 4、DeepSeek…。フレームワークは LangGraph、CrewAI、OpenAI Agents SDK。RAG? ベクトル DB? MCP? —— どこから手をつければいいのか、全体像がまったく見えない。

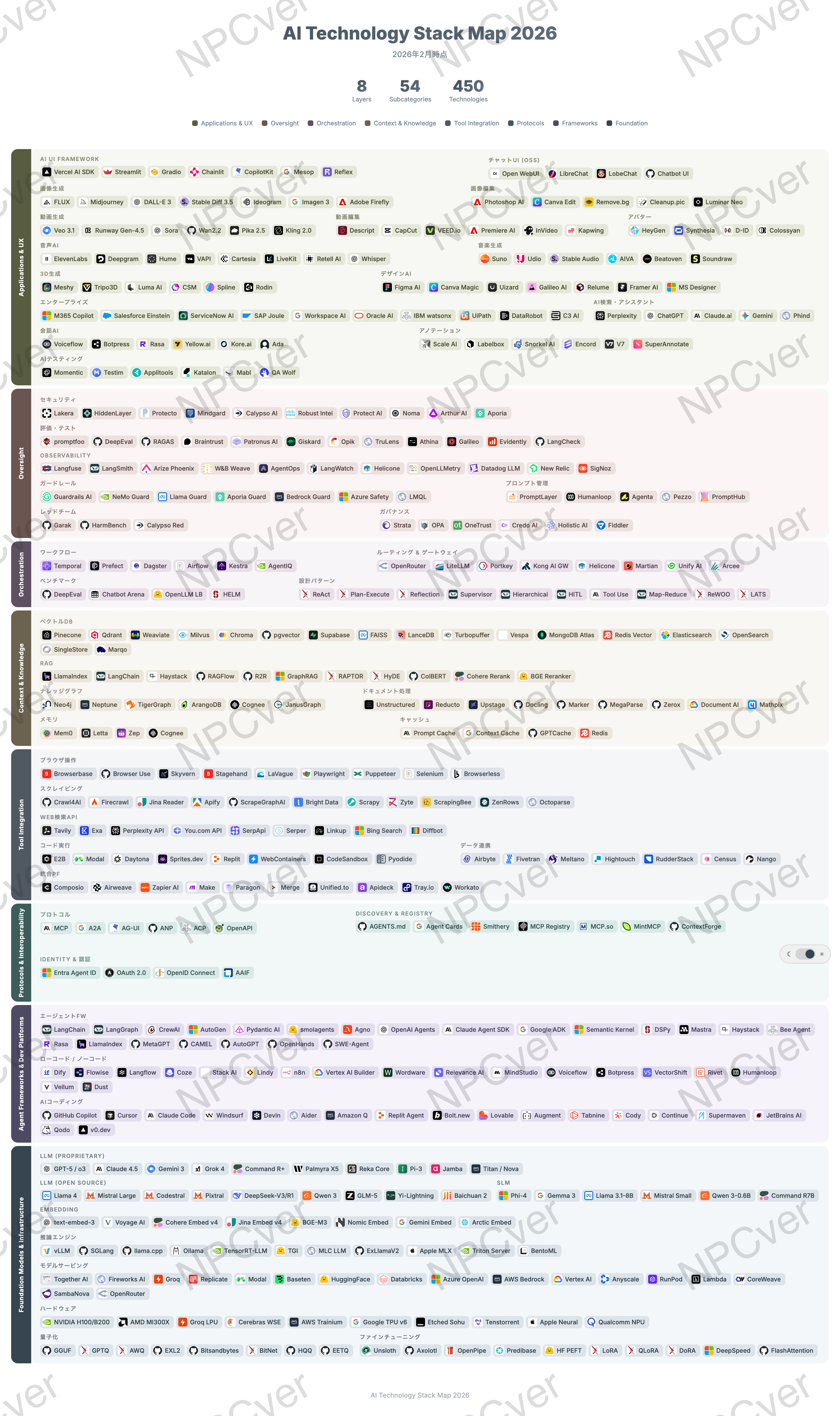

そこで、2026 年 2 月時点の AI 技術スタックを 8 層に分類し、460 のツール・サービスをマッピングしました。この記事では、各層のポイントを解説しつつ、マップ全体から見えてきた 7 つのインサイトを共有します。

マップの全体像

まず、8 層の構造を一覧で示します。上がユーザーに近い層、下がインフラに近い層です。

| Layer | 名称 | 役割 | 主なサブカテゴリ | ツール数 |

|---|---|---|---|---|

| 8 | Applications & UX | ユーザーが触れる世界 | AI UI, 画像/動画/音声/3D生成, エンタープライズ | 96 |

| 7 | Oversight | 安全に運用する仕組み | セキュリティ, 評価, Observability, ガードレール, ガバナンス | 55 |

| 6 | Orchestration | 全体を統制する | ワークフロー, ルーティング, ベンチマーク, 設計パターン | 28 |

| 5 | Context & Knowledge | 知識を与える | ベクトルDB, RAG, ナレッジグラフ, メモリ, キャッシュ | 56 |

| 4 | Tool Integration | 外部と繋ぐ | ブラウザ操作, スクレイピング, コード実行, データ連携 | 60 |

| 3 | Protocols | 共通言語を定める | MCP, A2A, AG-UI, Discovery, Identity | 17 |

| 2 | Frameworks & Platforms | 開発する | エージェントFW, ローコード/ノーコード, AIコーディング | 56 |

| 1 | Foundation Models & Infra | 土台を支える | LLM, SLM, Embedding, 推論エンジン, HW, 量子化 | 92 |

| 合計 53 サブカテゴリ | 460 |

この表から一つ明確なことがあります。「AI = LLM」ではない。LLM は Layer 1 のサブカテゴリの一つにすぎず、プロダクトを作るには残り 7 層のツールとインフラが必要です。

Layer 1: Foundation Models & Infrastructure — 土台

最も分厚い層です。9 つのサブカテゴリに 92 のツールがひしめいています。

Proprietary vs Open Source — 性能差はほぼ消滅

2026 年 2 月時点の主要 LLM を並べるとこうなります:

Proprietary: GPT-5 / o3 (OpenAI), Claude 4.5 Opus/Sonnet (Anthropic), Gemini 3 (Google), Grok 4 (xAI) ほか

Open Source: Llama 4 (Meta), DeepSeek-V3/R1, Qwen 3 (Alibaba), Mistral Large ほか

注目すべきは、オープンソースとプロプライエタリの性能差がほぼなくなったことです。2025 年の分析によると、MMLU ベンチマークでのスコア差は 17.5 ポイントからわずか 0.3 ポイントまで縮小しています。

特に DeepSeek-R1 のインパクトは大きく、671B パラメータのモデルを わずか 550 万ドル(GPT-4 の約 1/18) で開発。入力トークンあたりのコストは Claude 3.5 Sonnet の 214 分の 1 です。2025 年 1 月のリリース時には米国テック株で 1 兆ドルの時価総額が吹き飛ぶほどの衝撃を与えました。

SLM(Small Language Model)の台頭

Phi-4 (Microsoft)、Gemma 3 (Google)、Mistral Small など、エッジデバイスで動く小型モデルが実用レベルに到達しています。すべてのユースケースに巨大モデルが必要なわけではなく、コスト・レイテンシ・プライバシーの観点から SLM の重要性は増す一方です。

推論エンジンと量子化 — 隠れた勝負どころ

vLLM、SGLang、llama.cpp、Ollama などの推論エンジンと、GGUF、GPTQ、AWQ などの量子化技術は地味ですが極めて重要です。同じモデルでも推論基盤の選び方で速度もコストも桁が変わります。

ハードウェア — NVIDIA 一強に挑戦者たち

NVIDIA H100/B200 が依然として圧倒的ですが、Groq LPU(推論特化)、Cerebras WSE(ウエハスケール)、AWS Trainium、Google TPU v6 などが追い上げています。Gartner によると 2026 年の AI サーバー支出は 3,300 億ドルに達する見込みです。

Layer 2: Agent Frameworks & Dev Platforms — 開発

エージェントフレームワーク群雄割拠

2026 年はまさに「エージェントフレームワーク戦国時代」です。マップには 21 ものフレームワークが並んでいます:

LangGraph, CrewAI, AutoGen, Pydantic AI, smolagents, Agno, OpenAI Agents SDK, Claude Agent SDK, Google ADK, Semantic Kernel, DSPy, Mastra, Haystack, Bee Agent, LlamaIndex, MetaGPT...

Gartner は、2028 年までにエンタープライズソフトウェアの 33% がエージェント AI を組み込むと予測しています(2024 年は 1% 未満)。主要プレイヤーの棲み分けはこうなりつつあります:

| フレームワーク | 強み | 向いているユースケース |

|---|---|---|

| LangGraph | 状態管理、循環ワークフロー | 複雑なマルチステップ処理 |

| CrewAI | ロールベースの協調 | チーム型マルチエージェント |

| OpenAI Agents SDK | OpenAI エコシステム統合 | GPT 中心のプロジェクト |

| Claude Agent SDK | コード実行、長コンテキスト | 開発タスク自動化 |

| Google ADK | Google Cloud 統合 | エンタープライズ GCP 環境 |

AI コーディングツール — 開発者自身のスタックが変わった

GitHub Copilot、Cursor、Claude Code、Windsurf、Devin、Aider…。開発者の 85% が AI コーディングツールを日常的に使用している現在、AI はもはやプロダクトの材料であるだけでなく、プロダクトを作るツールそのものです。

SWE-bench(実際の GitHub Issue を解決するベンチマーク)では、Claude 4.5 Opus が 80.9% でトップ。ただし、それでも 5 つに 1 つのタスクは人間の介入が必要です。

ローコード / ノーコード — AI 民主化の最前線

Dify、Flowise、Langflow、Coze、n8n。コードを書かずにエージェントを構築できるプラットフォームが 18 個もあります。エンジニア以外のチームメンバーが AI を使い始める入口として、この層の成長は見逃せません。

Layer 3: Protocols & Interoperability — 接続の共通言語

8 層の中で最もツール数が少ない(17 個)にもかかわらず、最も重要な層かもしれません。

MCP がデファクトスタンダードへ

Anthropic が 2024 年 11 月にリリースした Model Context Protocol (MCP) は、わずか 1 年で 5,500 以上の MCP サーバーが登録され、上位 20 サーバーだけで月間 18 万回以上検索されるエコシステムに成長しました(出典)。OpenAI、Google、Microsoft もすべて MCP をサポートしています。

MCP、A2A (Google)、AG-UI (CopilotKit) の 3 つのプロトコルが並立していますが、現時点では MCP がツール接続の標準として圧倒的なリードを持っています。

Discovery & Registry — エージェントを「見つける」仕組み

AGENTS.md、Agent Cards、Smithery、MCP Registry — これらはエージェントやツールの「電話帳」です。エージェントが他のエージェントやツールを自動的に発見し、接続する未来に向けた基盤がここにあります。

Identity & 認証 — エージェントにも ID が必要

Microsoft の Entra Agent ID は象徴的です。人間だけでなくエージェントにも認証とアクセス制御が必要な時代が来ています。OAuth 2.0 や OpenID Connect がエージェント時代にどう拡張されるかは、今後の重要な論点です。

Layer 4: Tool Integration — 外部世界との接点

エージェントが「頭脳」なら、この層は「手足」です。

ブラウザ操作 & スクレイピング

Browserbase、Browser Use、Stagehand、Playwright — エージェントが 実際にブラウザを操作してウェブ上のタスクをこなすためのツールです。2025 年から急速に成熟しました。

コード実行環境

E2B、Modal、Daytona — エージェントに 安全なサンドボックスでコードを実行させるためのインフラです。「考えるだけ」から「実際に動かす」への進化を支える縁の下の力持ちです。

統合プラットフォーム

Composio、Zapier AI、Make — エージェントと外部 SaaS を一括で接続するプラットフォーム。個別の API 連携を一つずつ作る必要がなくなります。

Layer 5: Context & Knowledge — エージェントの知識と記憶

ベクトル DB の選択肢が爆発

Pinecone、Qdrant、Weaviate、Milvus、Chroma、pgvector、FAISS…。このサブカテゴリだけで 17 プロダクトが存在します。逆に言えば、それだけ正解が定まっていない領域です。

ベクトル DB 選定の実務的なポイント: まずは pgvector(PostgreSQL 拡張)か Chroma(軽量 OSS)で始めて、スケールが必要になったら専用 DB を検討するのが現実的です。

RAG の進化 — 単純な検索を超えて

基本的な RAG(ベクトル検索 → LLM に渡す)はもはやスタートラインです。GraphRAG(Microsoft)、RAPTOR、HyDE、ColBERT、Reranker… RAG の精度を上げるための技術が急速に発展しています。

メモリ — エージェントの「記憶」設計

Mem0、Letta、Zep — エージェントが会話をまたいで情報を記憶するためのシステムです。一回きりのチャットから、継続的に学習するアシスタントへの進化に必要不可欠な層です。

Layer 6: Orchestration — 統制と設計

ワークフローエンジン

Temporal、Prefect、Dagster — エージェントをプロダクションで安定稼働させるための基盤です。PoC では不要でも、本番運用には必須になります。

ルーティング & ゲートウェイ

OpenRouter、LiteLLM、Portkey — 複数のモデルプロバイダー間をコスト・レイテンシ・性能で自動的に切り替えるルーター。モデルが乱立する時代だからこそ、この層が生きてきます。

設計パターン — エージェントの「思考戦略」

ReAct、Plan-Execute、Reflection、Supervisor、HITL(Human-in-the-Loop)— これらはエージェントがどうタスクに取り組むかを定義するアーキテクチャパターンです。フレームワーク選びの前に、まずどのパターンが自分のユースケースに合うかを考えることが重要です。

Layer 7: Oversight — 安全の番人

セキュリティ & ガードレール

Lakera、Guardrails AI、NeMo Guardrails、Llama Guard — エージェントの暴走を防ぐ仕組みです。プロンプトインジェクション対策、有害出力のフィルタリング、PII(個人情報)の保護を担います。

評価・テスト

promptfoo、DeepEval、RAGAS — LLM の出力品質をどう測るかは、従来のソフトウェアテストとは根本的に異なる課題です。この層の 12 プロダクトの存在が、その難しさを物語っています。

Observability

Langfuse、LangSmith、Arize Phoenix — エージェントの実行ログ、トレース、コストを可視化するツール。「AI がなぜそう判断したか」を追跡できなければ、本番運用は不可能です。

ガバナンス & レッドチーム

OPA、Credo AI、Garak、HarmBench — AI のリスク管理とコンプライアンスを担う層。規制が強化される 2026 年以降、ここの重要性は増す一方です。

Layer 8: Applications & UX — ユーザーが触れる世界

最も多くのサブカテゴリ(15 個)を持つ層です。

AI UI Framework

Vercel AI SDK、Streamlit、Gradio、Chainlit、CopilotKit — チャット以外の AI インターフェースを作るためのフレームワーク。「テキストボックスとチャットバブル」だけが AI UI ではありません。

マルチモーダル生成の爆発

画像(FLUX, Midjourney, DALL-E 3)、動画(Veo 3.1, Sora, Runway Gen-4.5)、音声(ElevenLabs, Deepgram)、3D(Meshy, Luma AI)、音楽(Suno, Udio)— 生成 AI は あらゆるメディアに拡大しています。この領域だけで 50 以上のツールがあります。

エンタープライズ AI

M365 Copilot、Salesforce Einstein、SAP Joule、IBM watsonx — 大企業の 87% が AI を導入し、年間平均 650 万ドルを投資しています。生成 AI だけでも 2025 年の企業支出は 370 億ドルに達しました(前年比 3.2 倍)。興味深いのは、エンタープライズ LLM 支出の 40% を Anthropic が占めている点です。

8 層マップから見えた 7 つのインサイト

1.「モデル」はスタックの 1/8 に過ぎない

多くの人が AI = LLM だと思っていますが、LLM(Layer 1 の一部)はスタック全体の ほんの一角です。実際にプロダクトを作るには、残り 7 層のツールとインフラが必要です。モデル選びに時間をかけすぎて、他の層を軽視すると確実に失敗します。

2. プロトコル層(Layer 3)が最も若く、最もインパクトが大きい

17 ツールしかない最小の層ですが、MCP は AI 時代の HTTP になりうる存在です。5,500 以上のサーバー、リモートサーバー数が半年で 4 倍 — わずか 1 年でこの規模に達したプロトコルは異例です。A2A、AG-UI との標準化競争の行方は、エコシステム全体の構造を左右します。

3. Oversight 層の厚みが「成熟度のバロメーター」

Layer 7 には 7 サブカテゴリ・55 ツールがあります。セキュリティ、評価・テスト、Observability、ガードレール、プロンプト管理、レッドチーム、ガバナンス — これだけのカテゴリが生まれているのは、AI が本番環境で動き始めた証拠です。PoC で終わらせないために、この層への投資は避けて通れません。

4.「Agent」がスタック全体を貫く縦軸になった

エージェントは特定の層に属するものではありません。Layer 1 のモデルを使い、Layer 2 のフレームワークで構築され、Layer 3 のプロトコルで外部と繋がり、Layer 4 のツールを操作し、Layer 5 の知識を参照し、Layer 6 のパターンで統制され、Layer 7 で監視され、Layer 8 でユーザーに届く — 全 8 層を横断する存在です。だからこそ、個々のツール選びの前に全体像を把握することが重要です。

5. 実務者へ: まず Layer 6(設計パターン)と Layer 7(Oversight)から始めよ

フレームワークやモデルの選定(Layer 1-2)から始めがちですが、**先に決めるべきは「エージェントにどう考えさせるか」(Layer 6 の設計パターン)と「どう安全に運用するか」(Layer 7)**です。ReAct か Plan-Execute か、HITL をどこに入れるか、評価指標は何か — これらが決まれば、ツール選定は自然と絞り込めます。

スタートアップなら Layer 1 → 2 → 5 → 8 の最短経路で MVP を出し、その後 Layer 6 → 7 を強化する流れが現実的です。エンタープライズなら Layer 7 → 6 → 3 のガバナンスファーストで進めるべきでしょう。

6. OSS と商用の境界が溶けている — 「選ぶ」より「組み合わせる」時代

各層を見渡すと、OSS と商用が完全に共存しています。LLM では DeepSeek(OSS)と GPT-5(商用)が同レベル。ベクトル DB では pgvector(OSS)と Pinecone(商用)が共存。フレームワークではほぼ全てが OSS。

89% の組織が何らかのオープンソース AI を活用している現在、**「OSS か商用か」の二択ではなく、「どの層でどちらを使うか」**を考えるのが実務的です。

7. 未来予測: 次に起きる 3 つの統合

このマップは現時点のスナップショットですが、半年後にはかなり違う景色になっているはずです。

予測 ①: エージェント FW の統合(Layer 2)

21 ものフレームワークは多すぎます。Microsoft がすでに AutoGen と Semantic Kernel を統合したように、2026 年後半には 3〜5 の主要 FW に収束するでしょう。コミュニティの勢い的に LangGraph、CrewAI、Claude Agent SDK が残る可能性が高いです。

予測 ②: Oversight の Platform 化(Layer 7)

現在はセキュリティ、評価、Observability がバラバラのツールですが、「AI Ops」として統合されたプラットフォームが登場するでしょう。Datadog が LLM Observability を出しているように、既存のインフラ監視ベンダーがこの層を飲み込む可能性があります。

予測 ③: プロトコル層が API エコノミーを再定義する(Layer 3)

MCP が本当に「AI の HTTP」になれば、現在の REST API ベースの SaaS 連携は根本から変わります。エージェントがツールの仕様を自動的に理解し、人間がドキュメントを読んで API を叩く必要がなくなる世界が見えてきます。

まとめ — このマップの使い方

AI 技術スタックは巨大で、日々変化しています。でも、8 層のフレームワークで整理すれば、自分が今どこにいて、次に何を学ぶべきかが見えてきます。

具体的な使い方の提案:

- 自分のプロジェクトに必要な層を特定する — 全 8 層を一度に攻める必要はありません

- 各層で 1 つずつ選定すれば最小構成が作れる — 例: Claude 4.5 (L1) + Claude Agent SDK (L2) + MCP (L3) + Composio (L4) + pgvector (L5) + Temporal (L6) + Langfuse (L7) + Vercel AI SDK (L8)

- Layer 3(プロトコル)と Layer 7(Oversight)を軽視しない — 地味ですが、スケールするかどうかはここで決まります

2026 年の AI 支出は 世界全体で 2.52 兆ドル(前年比 44% 増)に達すると予測されています。この巨大な波の中で迷子にならないために、まずは地図を手に入れてください。

- Gartner: Worldwide AI Spending Will Total $2.5 Trillion in 2026

- Menlo Ventures: 2025 The State of Generative AI in the Enterprise

- MCP Adoption Statistics - MCP Manager

- The New Stack: Why the Model Context Protocol Won

- Faros AI: Best AI Coding Agents for 2026

- AlphaMatch: Top 7 Agentic AI Frameworks in 2026

- DeepSeek AI Statistics - SQ Magazine

- Open Source vs Proprietary AI Models - Simplenight

- ISG: State of Enterprise AI Adoption Report 2025

- Intel Capital: Demystifying the AI Infrastructure Stack