「ハッシュ値の衝突」(コリジョン)や「データの改ざん」などの対策で、ベストなハッシュ・アルゴリムを判断するために、ハッシュ値の「長さ」や「速度の目安」一覧が欲しい。

ハ ... ... ハッシュ?

... ってか、ハッシュって、そんなにおいしいの?圧縮された暗号とちゃうん?

TL; DR (今北産業)

-

この記事はハッシュ関数の出力結果を桁数ごとに、まとめたものです。

- ハッシュ関数の各々の「アルゴリズムが最大何文字の 16 進数で返してくるか」の事前確認に利用ください。

-

マスター、一番強いヤツをくれ。

-

バランス優先

-

👉

sha3-512(64 Byte, 128桁, 2020/12/22 現在) -

OS やプログラム言語間の互換性・強度・速度の一番バランスが取れているハッシュ・アルゴリズムで「強い」ヤツ。使いやすさなら、

SHA3-256。 -

互換性?

ここでいう互換性とは「大抵どの言語でも標準で実装しているアルゴリズム」のことです。NIST が制定している Secure Hash Algorithm(略して SHA)のうち、SHA-3 シリーズは最新版のアルゴリズムであるため、汎用性がとても高いです。

最強は SHA3-512 なのですが、現実的で使いやすいのは SHA3-256 でしょうか。

1 世代前の SHA-2 シリーズであっても、SHA256 や SHA512 であれば目くじらたてる必要はありません。しかし、SHA-2 は 20 年前のアルゴリズムであり、クラウドの演算力やブロックチェーンのマイニング・ファームのハッシング演算力が 10 年で激増していることに留意します。というのも 2 世代前の SHA-1 で「SHA-1 の効率的な衝突方法の論文」が発表されてから Google がそのクラウド演算力を使い実際に衝突例を見つけたこともあり、SHA-1 は廃止されただけでなく、同系統のアルゴリズムである SHA-2 も両手を広げて安全とは言えなくなったからです。

つまり、SHA-3 は、将来 SHA256 や SHA512 が破られた場合に備えての別系統によるバックアップです。例えば、NIST が長らく実施していた量子コンピューター演算にも耐性のある暗号アルゴリズム合戦 "PQC"(Post-Quantum Cryptography) でも、勝者は内部処理の一部でハッシュ関数に SHA3 も備えています。そのため、SHA256(SHA2-256)や SHA512(SHA2-512)だけでなく SHA3-256/SHA3-512 にも対応しておけよ、というだけです。 -

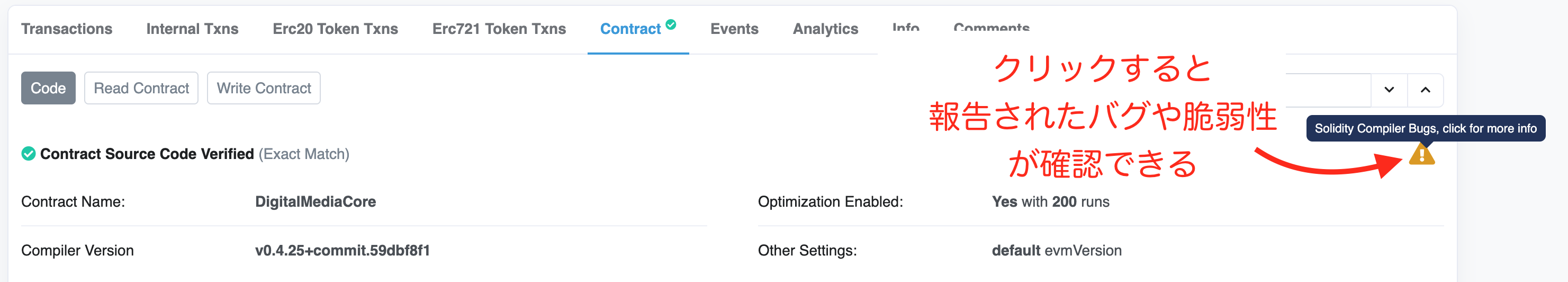

注意: SHA-3 のライブラリに本家 libXKCP を使っている場合、脆弱性が発見されているので、修正パッチの当たった最新のものを使ってください。OpenSSL 版をベースにしたライブラリなら大丈夫ですが、やはり最新版を使うのをオススメします。

-

SHA-3 ライブラリの脆弱性について

2022/10/20 に、SHA-3 のオリジナルを作った Keccak チームが提供している libXKCP ライブラリで、バッファオーバーフローの脆弱性が発見されています。(CVE-2022-37454、CWE-680)

libXKCPの fdc6fef0 のコミットで修正パッチが当たっているので、ライブラリを最新のものにしてください。- PHP

- 7.4.33 以降で対応

- 8.0.25 以降で対応

- 8.1.12 以降で対応

- Python (cPython)

- 3.11 以降で対応(libXKCP の SHA-3 から OpenSSL の SHA-3 に変更)

- Debian のパッケージ対応状況

- CVE-2022-37454 Tracker | Secrurity Tracker @ debian.org

なお、OpenSSL をベースとしたライブラリには今回の

CVE-2022-37454は問題ありませんが、OpenSSL にもバージョンによって異なる脆弱性があります(CVE-2022-3602、CVE-2022-3786)。また、この脆弱性を「SHA-3 に脆弱性があった」と記載しているクリックベイトな記事もありますが、実装方法に問題があっただけで、SHA-3 のアルゴリズム自体に脆弱性が見つかったわけではありません。いずれのライブラリを使うにしても最新のライブラリを使うようにしてください。

参考文献

- SHA-3 Buffer Overflow @ Nicky Mouha

- CVE-2022-37454 @ CVE Report

- Buffer overflow in sponge queue functions | Security Advisories | XKCP @ GitHub

- #105 Incorrect integer comparisons and buffer overflows | Issue | XKCP @ GitHub

- #98517 [CVE-2022-37454] Buffer overflow in the _sha3 module in python versions <= 3.10 | cPython @ GitHub

- 「XKCP SHA-3」に脆弱性 - 「Python」「PHP」などにも影響 @ Security NEXT

- PHPにアップデート、複数脆弱性を修正 @ Secrurity NEXT

- PHP

-

-

-

速度優先

- 👉

BLAKE3(64 Byte, 128桁, 2021/09/02 現在) - OS やプログラム言語間の互換性より「速度優先」の新参ハッシュ・アルゴリズム。

-

速度優先?

速度だけを求めると他にもあるのですが、本当に速度だけを求めると沼にハマるので注意しましょう。

と言うのも、「ハッシュ化しています」「爆速です」と言った途端、常にセキュリティや他の OS・アプリ・プログラム言語とのコラボレーションで比較されるため、選択のバランスが難しいからです。

例えば、爆速だけどニッチなアルゴリズムを使うと、他のプログラム言語では実装されていなかったりして検証しずらかったりすると、悲しいかな、下手すると「爆速だけど信用できない」といったレッテルを貼られたりします。

有志による速度や強度の測定に SMhasher などもあり、論文や多言語での実装なども考慮しながら、自分の環境での実測値をベースに総合的に判断する必要があります。

さて、BLAKE3 は、上記 SHA-3 になり損ねた BLAKE2 の後継です。2021/07/25 に v1.0 をリリースしたばかりの新参であるため、大半の OS やライブラリで査読中などにより標準で実装されていないものが多くあります。そのため、本記事の一覧に含めていません。とは言え、BLAKE2 の知名度・認知度から言っても BLAKE3 はメジャーな(公的機関にも採用されうる)アルゴリズムの 1 つと言っていいでしょう。

強度は SHA3-256 と同程度とアナウンスされていますが、爆速です。Go 版だと実測で FNV1 より 6 倍以上速かったです ... まじか。

ちなみに、セキュリティ目的ではない(暗号学的ハッシュを求めない)のであれば、xxHash の xxHash3 (XXH3) が BLAKE3 以上に圧倒的な速度を誇っているので、そこそこ互換性があり CRC より速くて代替となるハッシュを求めている人にはオススメです。[実装言語]

もし、OS 間やプログラム言語間の互換性をまったく無視するのであれば rapidhash(wyhash の後継)といった C++ に特化したアルゴリズムもあり、沼にハマること受け合いです。

- 👉

-

パスワード目的

-

👉 Argon2 @ Wikipedia(2015 年 PHC 勝者, 可変長, 2021/03/01 現在)

-

パスワード・ハッシュ[?]の強度で一番強いアルゴリズム

(速いとは言ってない) -

NIST で推奨されている PBKDF2 は強くないの?

NIST の 800-132「パスワードに基づく鍵の導出に関する推奨」 で PBKDF2 が推奨されていることからか、「パスワードの保存に PBKDF2 を使う」ケースが見られます。

特に OWASP( Web アプリケーションのセキュリティに関する情報をとりまとめるコミュニテイのプロジェクト)が作成しているチートシート「Password Storage Cheat Sheet」に「FIPS-140 への準拠が必要な場合は、最低でもワークファクター(イテレーション数)が 600,000 以上、内部ハッシュ関数に HMAC-SHA-256 以上を設定した PBKDF2 を使用すること」と書いてあることから、「この設定なら、パスワードの保存に使っていい」と勘違いしちゃうパターンです。確かに、これだけ強く設定すればパスワード保存にも大丈夫な気もしてきますし、そうとも読み取れます。

しかし、SP 800-132 で言っているのは「あなたのモジュールが、パスワードから鍵を導出する必要があるなら、最低限この設定の PBKDF2 を使わないと FIPS-140 に準拠しているとみなさない」であり、「パスワードの保存に使え」とは、どこにも書いてないのです。言い換えると、たとえパスワード保存に「さいきょうの Argon2id」を利用していても、内部の鍵導出に(上記の最低限設定で)PBKDF2 を使用していない場合は、FIPS-140 に準拠しないと言うことです。

つまり、鍵の導出に使うことが推奨されているだけで、PBKDF2 は「パスワードの保存」には推奨されていないのです。

では

PBKDF2とArgon2idの何が違うのかと言うと「ハッシュ値」の利用目的です。PBKDF2はKDF(Key Derivation Function、鍵導出関数、鍵派生関数)に属し、Argon2idはPHF(Password Hash Functions、パスワードハッシュ関数)に属します。「KDF」「PHF」は、どちらもハッシュ値を返します。しかし、いくつかの意味合いの違いがあります。

KDFは引数から派生するキーを生成するために使用される関数ですが、PBKDF はその一例で、主にパスワードから安全な鍵(キー)を導出するために使用される関数です。

例えば、パスワードに紐づいたデータの保存や、認証などの紐付け目的で鍵(キー)を派生させるために広く採用されている関数です。しかし、PBKDF は主に鍵を導出することが目的であるため、パスワードを安全に保存するためには追加の手順が必要になります。一方、「パスワードハッシュ関数」は、パスワードをハッシュ値に変換するために使用されます。パスワードハッシュ関数は通常、パスワードの安全な保存に使用され、パスワードの平文を保存することなく、ハッシュ値を比較することで認証を行います。

パスワードハッシュ関数のうち、Argon2id は、PHC 勝者であるパスワードハッシュ関数です。Argon2id は、パスワードをハッシュ化する際にメモリベースの関数として設計され、高いセキュリティレベルと耐性を持っています。

総括すると、PBKDF2 は鍵派生のための関数であり、パスワードの保存には適していません。一方、Argon2id は PHC で優勝した安全なパスワードハッシュ関数であり、パスワードの安全な保存に使用することができます。

-

有名な bcrypt じゃダメ?

PBKDFはパスワード保存に適していないのはわかったものの、ではパスワード保存の老舗であるbcryptはと言うと、非推奨にはなっていません(2025 年 08 月現在)。bcrypt は 1999 年に登場し、20 年以上にわたり実運用されてきた実績があります。また、たくさんのフレームワークやライブラリに標準で組み込まれており、OWASP のチートシートでも Argon2 が使えない旧環境での代替アルゴリズムとして指定されており、「まだ安全に使える」と見なされています。SHA-2 シリーズの SHA256 や SHA512 と同じ扱いと考えて良いでしょう。

とはいえ、20 年以上前の古い設計であり、CPU のみを使った遅延調整、GPU や ASIC による並列攻撃に弱いとされます。つまり、バイバインがごとく増えていく演算力に対して、異なるアルゴリズムで今のうちから併用して備えるという意味です。

特に近年、「Harvest now, decrypt later」というステルス遅延型の攻撃が増えています。これは「Collect now, decrypt later」と言い換えるとわかりやすいのですが、いまのうちに暗号やハッシュデータを収集しておき、あとで(時代がきたら)復号するというものです。いまの時点では収集されるだけなので、実害に気づきづらい攻撃です。

-

-

- ハッシュ関数とは: ハッシュ関数の基本・特徴

- なんで長さなの?: ハッシュ関数の応用

-

nバイトって HEX 文字列で最大何文字だっけ?:- 単純に

nを2倍してください。

1バイト=

1バイト=0xFF、例:4バイト=HEXで8桁=FF FF FF FF

- 単純に

- なに?

4DrlXのような短いハッシュ値を作りたい?:- ハッシュ値を n 進数に変換して頭の数文字を使うのがいいかも。

- この記事は、「❤︎」(旧 LGTM)が付くたびに、何かしら見直したり、手を加えてスパイラル・アップさせています。そのため適宜内容が変わります。変更通知も送りませんので、ストックくださった方はお暇な時に、また覗きに来てください。

ハッシュ・アルゴリズムとビット長の一覧

(ハッシュ値の長さ一覧)

ハッシュ・アルゴリズム一覧

- このセクションは WIP です

たくさん「❤︎」を頂いたので "List of hash functions" @ Wikipedia の和訳+自分なりに調べた備考を載せていきたいと思います。が、途中でバテたので「❤︎」がつくたびに少しずつ充実していきたいと思います。

チェックサム系(Check Sum, 誤り検出符号)

| アルゴリズム名 (関数名含む) |

データ長 | 算出タイプ (系統) |

備考 |

|---|---|---|---|

| sum8 | 8 bits | sum |

sum8 は、いわゆる「単純なチェックサム」の代表的なアルゴリズムの 1 つ。検証したいデータを 8 ビットの左シフト、つまり頭から 1 バイト(8 ビット)単位で取り出して得られた数値を加算していき、その合計値に SUM8 のハッシュ値をさらに加算すると、最終合計の末尾 8 ビットが 0 になるアルゴリズム。SUM8 の値の作り方は、同じように検証データを頭から 8 ビットごとにシフトしながら得た値を加算していき、合計の下位 8 ビットを取り出す。取り出した値をビット反転させてから 1 を加えた値の下位 8 ビット(2 の補数)を SUM8 の値(ハッシュ値)として使う。ハッシュ値と言いながら、ただの足し算である。そのため、速い。ポイントは、SUM 値は合計の下位 8 ビットの補数(それを足すと 1 桁上がる値)になるため、確認側は、すべて加算していき末尾 n 桁が 0 であるか確認するだけなので、実装も楽で処理も速い。(オンラインで計算を見てみる, Go)このように、単純な足し算であるため、データの並び順は関係なくなり( 1+2+3 = 2+1+3)、0 の並んだデータの違い(1+0+0+0+1 = 1+1)も検知できない。つまり sum 系は 0 の多いデータや 1 バイト文字の並びに弱いアルゴリズムである。そのため衝突し(異なる引数で同じ値を返し)やすく、意図的な改竄には極めて弱い。しかし、データ破損の検出率自体は単純計算で 99.6% 以上あり、計算しやすく高速であるため、簡易な誤り検出で速度が必要な場合に使われる。TCP/IP の IP パケットを転送(ルーティング)する際の確認などで使われる。 |

| sum16 | 16 bits | sum | 上記の 16 ビット版 |

| sum24 | 24 bits | sum | 上記の 24 ビット版 |

| sum32 | 32 bits | sum | 上記の 32 ビット版 |

| BSD checksum (Unix) | 16 bits | sum |

BSD checksum は、巡回シフトによる巡回符号のチェックサム・アルゴリズムである。巡回シフトとは、ビット並びを 1 ビットずらし、押し出されたビットを反対側の頭もしくは末尾に持ってくるビット操作である(右巡回のシフト例: 1011 → 1101 → 1110 → 0111 → 1011 → ... 以下同文)。古くから BSD に実装されており sum コマンド などで使われている。BSD checksum (16 ビット版) の値の作り方は、検証したいデータを上位から 16 ビットずつ読み込み加算していくが、加算する前に合計値を右巡回シフトする。その右巡回シフトした合計値に、読み込み値を加算したら合計値を 16 ビットにトリミングする。つまり、合計値の末尾 16 ビットを抜き出したもの(16 bit なら 1111111111111111 のマスクを AND 演算したもの)を現在の合計値とする。データの読み込みが終わったら、それをチェックサム型のハッシュ値とする。ゆうて、やっていることは、やはり足し算なのである。BSD checksum は sum32 よりは強いものの、後述する CRC-32 型の cksum コマンドよりもエラー検知が弱く、sum32 CRC 同様に改竄耐性はない。つまり、データ(ワード)の順序の変更や、すべてのビットがゼロに設定されたワードの挿入または削除など、一度に多くのビットに影響するいくつかの一般的なエラーを検出できないため「単純なチェックサム」の部類に入る。 |

| SYSV checksum (Unix) | 16 bits | sum |

巡回シフトによる巡回符号のチェックサム・アルゴリズム。System V の初期から実装されており sum コマンド などで使われている。CRC-32 型の cksum コマンドよりもエラー検知が弱く、CRC 同様に改竄耐性はない。「単純なチェックサム」の部類に入る。 |

| fletcher-4 | 4 bits | sum |

Adler-32 の原型ともなったチェックサム・アルゴリズム。単純なチェックサムよりも計算コストは高くなるものの信頼性が高い。fletcher の値の具体的な作り方(実装サンプル)は fletcher-16 を参照するとして、ここでは概要を説明する。まず n ビットごとに読み込んだ入力データを、2 組の変数に各々異なる組み合わせで加算を行い、定数で剰余(mod, %)演算したものを繰り返し行う。最終的にその 2 組みを上位ビットと下位ビットに割り当てたものがハッシュ値である。また、fletcher のハッシュ値を使ったデータの破損の確認は、ハッシュ値からさらに得られる値を、オリジナルのデータに付け加えて同じ fletcher の関数に通すと値がゼロになることで、データ破損を検証できる。fletcher-8 や fletcher-16 は TCP のチェックサムのオプションの 1 つにも採用されている1。Solaris 系のファイルシステムのチェックサムとしても採用されている。使われる定数には、素数の積(合成数)を利用したバリエーションがある。 |

| fletcher-8 | 8 bits | sum | |

| fletcher-16 | 16 bits | sum | Go 言語による実装サンプルを見る |

| fletcher-32 | 32 bits | sum | |

| Adler-32 | 32 bits | sum | zlib の圧縮ライブラリの圧縮や展開/解凍のチェックのために fletcher-16 を改善して開発された。信頼性と引き換えに高速性を追求しているタイプ。同じ長さの CRC よりも速い。信頼性は fletcher-16 と fletcher-32 の中間くらい。IETF の RFC1950 で定義されており、素数の剰余(mod)を利用している。 |

| xor8 | 8 bits | sum |

LRC(Longitudinal Redundancy Check、水平冗長検査)とも呼ばれ、計算方法は ISO 1155 で定義されている。sum8 に似ているものの、加算時に 8 ビット(0xFF)のマスクを合計値にかけることで合計値がオーバーフローしないことと、チェックサムを算出する際の 2 の補数の算出時に XOR を使っているのが特徴。具体的には合計にマスク値(0xFF)を XOR 後 +1 し、下位 8 ビットをチェックサムとする。XOR8 も sum8 同様に 8 ビットごとの加算値に、さらにチェックサム値を加えると末尾 8 ビットが 0 になる。(オンラインで計算を見てみる, Go)ISO 7816 に準拠した IC カードの読み取りや、インターネットの PPP 接続時のシリアル信号(RFC1134)のチェックに使われている。 |

| Luhn algorithm | 1 decimal digit | sum | |

| Verhoeff algorithm | 1 decimal digit | sum | |

| Damm algorithm | 1 decimal digit | Quasigroup operation |

CRC 系(Cyclic Redundancy Check, 巡回冗長検査)

| アルゴリズム名 (関数名含む) |

データ長 | 算出タイプ (系統) |

備考 |

|---|---|---|---|

| cksum (Unix) | 4 Byte (32 bit) | CRC | 名残で checksum と付いているが、POSIX:2008 (IEEE Std 1003.1-2008) に準拠した CRC-32 アルゴリズムを使ったコマンドであるため CRC に分類される。改竄耐性はなく、簡単に衝突(ことなる値で同じ出力に)させることができる。 |

| CRC-8 | 1 Byte (8 bit) | CRC | いわゆる CRC(Cyclic Redundancy Check、巡回冗長検査)系の典型的なアルゴリズムの 1 つ。CRC の Cyclic(巡回)は、CRC-n の場合、データを上位から n ビットぶんを 1 ビットずつズラしながら参照して演算していくため「巡回」と呼ばれる。前述のチェックサム系アルゴリズムが足し算(加算)をベースにしているのに対し、割り算(除算)をベースにしているアルゴリズムで、余りをハッシュ値とする特殊な剰余算である。CRC の演算のポイントは 2 つあり、その「割る方の値」(以下「除数」、 divisor)の算出方法と、実際の CRC の計算方法である。除数の値は定数が使われるが、複数のバリエーション(タイプ)があり、いずれも多項式を用いて算出された定数である。いずれのタイプの除数でも、長さは n ビット + 1 の長さである。(CRC-8 の場合は 9 ビット) CRC の計算方法は「割り算の筆算」(乗除法)に近い方法を使う。つまり、対象の値の左から除数と同じ桁数ぶんを割り、その結果を反映させて 1 桁ずらしてを繰り返す方法に近く、割る代わりに XOR する。 具体的には CRC-8 の場合、まずデータの上位 8 ビットを参照し、その値の左端の 1 ビットが 1 の場合は除数と XOR した値と入れ替える。0 の場合は何もしない(次に進む)。次に参照先を右に 1 ビットずらして同様に 8 ビットぶんを参照することを一番右に辿り付くまで繰り返す。つまり、進めるごとに値の左端がどんどん 0 になっていく(具体例)。そして、最終結果の下位 8 ビットが CRC-8 の値として使われる。 CRC 系は隣り合わせのデータを参照していくため、 sum 系に比べるとデータの並び順に強いものの、離れた位置の違いは検知しにくい(同じ答えになることがある)。そのため、改竄耐性はないが、バースト(突発的な強いノイズ)などによる一部のビット並びが変わった場合の検知には強いため、シリアル通信のチェックサム値としても使われる。 |

| CRC-16 | 2 Byte (16 bit) | CRC | CRC の 16 ビット版。シリアル通信系プロトコルのデータチェックによく使われる。除数として使う定数の算出に使われる多項式には、やはりバリエーションがあり、CRC-16 は 22 個が知られている。有名なバリエーションとして、CRC-16-IBM の X16+X15+X2+1 は USB や PLCのチェックに使われ、CRC-16-CCITT の X16+X12+X5+1 は Bluetooth や SD カードなどのチェックで使われる。(オンラインでCRC-16-IBMの計算を見てみる, Go)

|

| CRC-32 | 4 Byte (32 bit) | CRC | |

| CRC-32 MPEG-2 | 4 Byte (32 bit) | CRC | |

| CRC-64 | 8 Byte (64 bits) | CRC |

- Adler-32 は CRC であると思われていますが、実質的にはチェックサムの部類に分類されます。

Universal hash function families

| アルゴリズム名 (関数名含む) |

データ長 | 算出タイプ (系統) |

備考 |

|---|---|---|---|

| Rabin fingerprint | variable | multiply | |

| tabulation hashing | variable | XOR | |

| universal one-way hash function | |||

| Zobrist hashing | variable | XOR |

Non-cryptographic hash functions

| アルゴリズム名 (関数名含む) |

データ長 | 算出タイプ (系統) |

備考 |

|---|---|---|---|

| Pearson hashing | 8 bits (or more) | XOR/table | |

| Paul Hsieh's SuperFastHash[1] | 32 bits | ||

| Buzhash | variable | XOR/table | |

| Fowler–Noll–Vo hash function (FNV Hash) | 32, 64, 128, 256, 512, or 1024 bits | xor/product or product/XOR | |

| Jenkins hash function | 32 or 64 bits | XOR/addition | |

| Bernstein's hash djb2 | 32 or 64 bits | shift/add or mult/add or shift/add/xor or mult/xor | |

| PJW hash / Elf Hash | 32 or 64 bits | add,shift,xor | |

| MurmurHash | 32, 64, or 128 bits | product/rotation | |

| Fast-Hash | 32, 64 bits | xorshift operations | |

| SpookyHash | 32, 64, or 128 bits | see Jenkins hash function | |

| CityHash | 32, 64, 128, or 256 bits | ||

| FarmHash | 32, 64 or 128 bits | ||

| MetroHash | 64 or 128 bits | ||

| numeric hash (nhash) | variable | division/modulo | |

| xxHash | 32, 64, 128 bits | product/rotation | |

| t1ha (Fast Positive Hash) | 64 and 128 bits | product/rotation/XOR/add | |

| pHash | fixed or variable | see Perceptual hashing | |

| dhash | 128 bits | see Perceptual hashing | |

| SDBM | 32 or 64 bits | mult/add or shift/add | also used in GNU AWK |

Keyed Cryptographic Hash Functions

| アルゴリズム名 (関数名含む) |

データ長 | 算出タイプ (系統) |

備考 |

|---|---|---|---|

| BLAKE2 | arbitrary | keyed hash function (prefix-MAC) | |

| BLAKE3 | arbitrary | keyed hash function (supplied IV) | |

| HMAC | |||

| KMAC | arbitrary | based on Keccak | |

| MD6 | 512 bits | Merkle tree NLFSR | |

| One-key MAC (OMAC; CMAC) | |||

| PMAC (cryptography) | |||

| Poly1305-AES | 128 bits | nonce-based | |

| SipHash | 32, 64 or 128 bits | non-collision-resistant PRF | |

| HighwayHash | 64, 128 or 256 bits | non-collision-resistant PRF | |

| UMAC | |||

| VMAC |

Unkeyed cryptographic hash functions

| アルゴリズム名 (関数名含む) |

データ長 | 算出タイプ (系統) |

備考 |

|---|---|---|---|

| BLAKE-256 | 256 bits | HAIFA structure[14] | |

| BLAKE-512 | 512 bits | HAIFA structure[14] | |

| BLAKE2s | up to 256 bits | HAIFA structure[14] | |

| BLAKE2b | up to 512 bits | HAIFA structure[14] | |

| BLAKE2X | arbitrary | HAIFA structure,[14] extensible-output functions (XOFs) design[15] | |

| BLAKE3 | arbitrary | Merkle tree | |

| ECOH | 224 to 512 bits | hash | |

| FSB | 160 to 512 bits | hash | |

| GOST | 256 bits | hash | |

| Grøstl | up to 512 bits | hash | |

| HAS-160 | 160 bits | hash | |

| HAVAL | 128 to 256 bits | hash | |

| JH | 224 to 512 bits | hash | |

| LSH | 256 to 512 bits | wide-pipe Merkle–Damgård construction | |

| MD2 | 128 bits | hash | |

| MD4 | 128 bits | hash | |

| MD5 | 128 bits | Merkle–Damgård construction | |

| MD6 | up to 512 bits | Merkle tree NLFSR (it is also a keyed hash function) | |

| RadioGatún | arbitrary | ideal mangling function | |

| RIPEMD | 128 bits | hash | |

| RIPEMD-128 | 128 bits | hash | |

| RIPEMD-160 | 160 bits | hash | |

| RIPEMD-320 | 320 bits | hash | |

| SHA-1 | 160 bits | Merkle–Damgård construction | |

| SHA-224 | 224 bits | Merkle–Damgård construction | |

| SHA-256 | 256 bits | Merkle–Damgård construction | |

| SHA-384 | 384 bits | Merkle–Damgård construction | |

| SHA-512 | 512 bits | Merkle–Damgård construction | |

| SHA-3 (subset of Keccak) | arbitrary | sponge function | |

| Skein | arbitrary | Unique Block Iteration | |

| Snefru | 128 or 256 bits | hash | |

| Spectral Hash | 512 bits | wide-pipe Merkle–Damgård construction | |

| Streebog | 256 or 512 bits | Merkle–Damgård construction | |

| SWIFFT | 512 bits | hash | |

| Tiger | 192 bits | Merkle–Damgård construction | |

| Whirlpool | 512 bits | hash |

ハッシュ値の長さ一覧と速度の目安

すべて同じメッセージをハッシュ化したもの(「Hello Qiita!」のハッシュ値)なのに、ハッシュ値の長さ、つまりビット長が同じでも値がまったく異なることに注目ください。

🐒 各アルゴリズムの PHP 7.2.6 での計算速度も記載していますが、環境だけでなく PHP のバージョンによってかなり速度が異なります。速度は目安程度にご利用ください。まずは強いアルゴリズムで組んでから、「推測するな、測定せよ」の精神でご自分の環境に最適化することをお勧めします。

なお、SHA-3に含まれるSHAKE256などの可変長のアルゴリズム、および SHA-3 の最終選考まで残ったBLAKE2や、その後続で爆速と噂のBLAKE3は、まだライブラリが枯れて(OS やプログラム言語で浸透)していないため含めていません。

仕様

- 検証環境:macOS HighSierra(OSX 10.13.6), PHP 7.2.6(cli), MacBookPro Early 2015, 2.7GHz Corei5, Mem 8GB 1867MHz DDR3

- ハッシュするメッセージ:「Hello Qiita!」

- ループ回数:1,000,000 回(100 万回)

- 速度:上記ループの 10 回ぶんの平均値

- 並び順:桁数の少ない順 → 速い順

- メッセージダイジェストは横スクロールをさけるため 8 桁(4バイト)ごとのブロックに分けています。

- 測定のソースコード @ Paiza.IO

8 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

fnv132 |

4 Byte |

0.157887 sec |

b04649f6 |

fnv1a32 |

4 Byte |

0.157962 sec |

129b42dc |

adler32 |

4 Byte |

0.165301 sec |

1bf5042e |

crc32 |

4 Byte |

0.169681 sec |

dd54ff69 |

crc32b(IEEE)

|

4 Byte |

0.172050 sec |

ad6adc0d |

joaat |

4 Byte |

0.173369 sec |

2cbbf315 |

16 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

fnv164 |

8 Byte |

0.168120 sec |

97bfaffd 885daad6

|

fnv1a64 |

8 Byte |

0.176964 sec |

07c72cc2 7b5f8b5c

|

32 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

md4 |

16 Byte |

0.284748 sec |

e2500f3f 1eb028a4 563ca3d4 35028996

|

md5 |

16 Byte |

0.337097 sec |

7c414ef7 535afff2 1e05a36b 1cfc9000

|

tiger128,3 |

16 Byte |

0.341727 sec |

60bd4df9 e039716f 07c9ecd4 4c203d34

|

tiger128,4 |

16 Byte |

0.397596 sec |

7c20d9b5 d9e79da7 b5241a08 a353018a

|

ripemd128 |

16 Byte |

0.553369 sec |

0ff7eaf1 38540680 8e92e642 28a79243

|

haval128,3 |

16 Byte |

0.954699 sec |

a8fe5c62 4c856077 d07db6bc 9a7f1275

|

haval128,4 |

16 Byte |

1.027350 sec |

b5ee64c0 6a003d55 65108356 08c6a34c

|

haval128,5 |

16 Byte |

1.197690 sec |

ad189ff3 183c9cfe cf5a39e3 45ba95f8

|

md2 |

16 Byte |

4.762099 sec |

8cd3c9c1 f1079b15 639ddab1 2227d400

|

40 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

sha1 |

20 Byte |

0.348829 sec |

5d8793ae d96d808a b6af8e47 5ce244e8 a604e478

|

tiger160,3 |

20 Byte |

0.367638 sec |

60bd4df9 e039716f 07c9ecd4 4c203d34 6f07e46a

|

tiger160,4 |

20 Byte |

0.399170 sec |

7c20d9b5 d9e79da7 b5241a08 a353018a bf178a02

|

ripemd160 |

20 Byte |

0.694799 sec |

99a6c172 52ae4e64 e8d22853 c54ee2ad 44089160

|

haval160,3 |

20 Byte |

0.900242 sec |

aba140dc e20ac7a2 615053de 4336e343 37a49b46

|

haval160,4 |

20 Byte |

1.033398 sec |

6bc4fecd c33d5d21 14c695ff f449d333 58f3030d

|

haval160,5 |

20 Byte |

1.197252 sec |

d87a41cb 73469426 42faf2ae 7d62e81a eba5dcc6

|

48 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

tiger192,3 |

24 Byte |

0.394713 sec |

60bd4df9 e039716f 07c9ecd4 4c203d34 6f07e46a 9c308ef7

|

tiger192,4 |

24 Byte |

0.410200 sec |

7c20d9b5 d9e79da7 b5241a08 a353018a bf178a02 0a74f3fb

|

haval192,3 |

24 Byte |

0.874294 sec |

e2b0c018 6b1cc119 0eebe1be 9d61953d 2dd78ba4 8136086c

|

haval192,4 |

24 Byte |

1.031765 sec |

7540fa22 a5714124 cf942e1b 31a890b9 bb59d58c e5a61157

|

haval192,5 |

24 Byte |

1.211350 sec |

e4a6b10a d8286eaf 8cb3f225 950c2f93 b6fdab8c 601626c8

|

56 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

sha224 |

28 Byte |

0.713225 sec |

d72d6ef7 0a788b3e 7f720b5d 88f20a13 bf161c31 b260fd34 6573094d

|

sha3-224 |

28 Byte |

0.817025 sec |

e833eab3 4fbefbe8 9e44dcf1 d4ea9990 10981761 22f51708 df9cd9d0

|

sha512/224 |

28 Byte |

0.825188 sec |

e205b15d 16eda0ce e195d210 73edca14 a69198e9 0070b9b0 09f7cb16

|

haval224,3 |

28 Byte |

0.842655 sec |

a69049ca 88565098 a6f5e2bc adb22980 e59da983 9a779b63 c214e019

|

haval224,4 |

28 Byte |

1.045480 sec |

090b25d0 e8a0f5ef ecf6b683 5be72fe5 6913b34e 2d086922 3b1ac5d1

|

haval224,5 |

28 Byte |

1.209415 sec |

5343b4b1 a16119c5 dcd7726e 53128841 fecb7607 88e9008f 6c6f2cb6

|

64 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

ripemd256 |

32 Byte |

0.574046 sec |

e0fe9c49 b1a59fae 47096909 83e62829 4887b161 5722a62c 2c4187be 816b058d

|

sha256 |

32 Byte |

0.668654 sec |

e863d36c 24ada694 fa77454b 33e8f9b9 545d372a ae251e87 79fc25df 16943fed

|

sha3-256 |

32 Byte |

0.824698 sec |

cedaea23 33478d77 bc9ed3e3 3303f455 85af1917 4a451ce9 3029fedc dd4d1ecb

|

sha512/256 |

32 Byte |

0.833001 sec |

aaa2e875 112de9b6 1744d4a0 ae757e40 cd12008a 0f3948fb 7c42a8cd 48c361b8

|

haval256,3 |

32 Byte |

0.845439 sec |

5f788c8a 5359387b acf7bf60 ff4dd08d e7176205 a0aae1ce 4f485b40 126c0d2f

|

haval256,4 |

32 Byte |

1.048196 sec |

4ebb9e6f a6c045b0 cbba419e f06ac973 b2fd4914 f746e142 bb6b840f bd836158

|

haval256,5 |

32 Byte |

1.218753 sec |

c99614ae a2985f43 f480d029 bcb7974b f5aface5 8730c9d6 f3141a67 58270431

|

gost |

32 Byte |

1.828385 sec |

667f4328 0ff9e0a5 9c15de57 022becf3 cd1a48f8 d37a165c 87576b6f 814fa482

|

gost-crypto |

32 Byte |

1.849877 sec |

7ebf0f97 0f1246b6 aea110d7 32cbcdfd b0169cf1 7336bae7 814e99f1 8abfbd21

|

snefru |

32 Byte |

2.841073 sec |

ad081810 0ab15234 b13b8d09 ad0c519a 35469221 adbf8c5f a71594ca f7dfddc2

|

snefru256 |

32 Byte |

2.850217 sec |

ad081810 0ab15234 b13b8d09 ad0c519a 35469221 adbf8c5f a71594ca f7dfddc2

|

80 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

ripemd320 |

40 Byte |

0.725499 sec |

6d152e32 fee2b979 024b8cff e416c898 16032680 779f7c3a 93c9aa26 35441245 8d4a9010 ad8fdfa5

|

96 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

sha384 |

48 Byte |

0.831855 sec |

b10497cf 49601678 4d8413a4 662983a8 dc4ac470 039ea755 d5ec985f 1aab04ee 26dc3d67 71bbe404 75ea7d13 5a97ba58

|

sha3-384 |

48 Byte |

0.835068 sec |

e83e54ee 323dafb5 ca2d800f d479e1cc 94502362 93d5ad74 36228519 aa657ea3 d1da8bb6 2d07035d ec1ece2f 428ec8dc

|

128 桁のハッシュ値

| アルゴリズム | バイト長 | 速度 | ハッシュ値 |

|---|---|---|---|

sha3-512 |

64 Byte |

0.851400 sec |

9d1aaed0 79bac194 6a5fbafb 4285ec5b dcf0053a 9e005590 46884a14 8f28fcb9 02441b49 cb3a8277 5834a244 4dd183ed a36cee90 0f5662f8 2353fae7 e7111740

|

sha512 |

64 Byte |

0.860255 sec |

cac9036c 1dd3652f c550e99a 4ec2b066 d69d6a40 a369bc85 e3078960 e6f26012 4138f5d0 f4e9a6e0 47dfb833 c9dd9b33 76d02d49 be37de26 dd6234d4 e79cc09e

|

whirlpool |

64 Byte |

1.041927 sec |

488c6cd6 eccb5348 8a7c7617 8c89d514 16b8eb2b 88a30b79 71f1f176 70e27659 fc477cd9 6ade86e4 b6176c5e f2f67068 89606786 4ce15443 eff90733 fd4fcf4c

|

TS; DR 最速のDBキー検索を求めて with SQLite3

ハッシュ値の衝突は別のアルゴリズムでは衝突しない (限りなく)

// 値が微妙に異なる $a と $b

$a = 'xxxxxxxxx..1..xxxxxxxxx'; // 長ったらしい文字列 a

$b = 'xxxxxxxxx..0..xxxxxxxxx'; // 長ったらしい文字列 b

$result_sha1 = ( hash('sha1', $a) === hash('sha1', $b) );

$result_md5 = ( hash('md5', $a) === hash('md5', $b) );

// $result_sha1 --> true, 偶然にも衝突が発生!

// $result_md5 --> false, アルゴリズムが異なると衝突しない(可能性が高い)

古くからダウンロード・ページなどでファイルの改ざんや破損がないかを比べるのに使われている「ハッシュ関数」。

身近なところでは、いつもお世話になっているパッケージマネージャーのパッケージ管理、アクセス・トークンの作成や、みんな大好き Git のコミットID が有名ですが、データベース(以下 DB)のクラスタリングや負荷分散などにも使われています。

Linux のニッチで老舗のパッケージマネージャーである Nix では、ハッシュ値を全面的に使うことで依存関係を徹底的に管理しています。最近、頭角を現している Linux の異端児 NixOS は、その仕組みを OS レベルで使う(カーネル含む全てのシステム・ファイルをハッシュ値ベースで管理し、シンボリック・リンクを貼り替える)ことで、異なるバージョンのテストやトライ&エラーをしやすくしています。

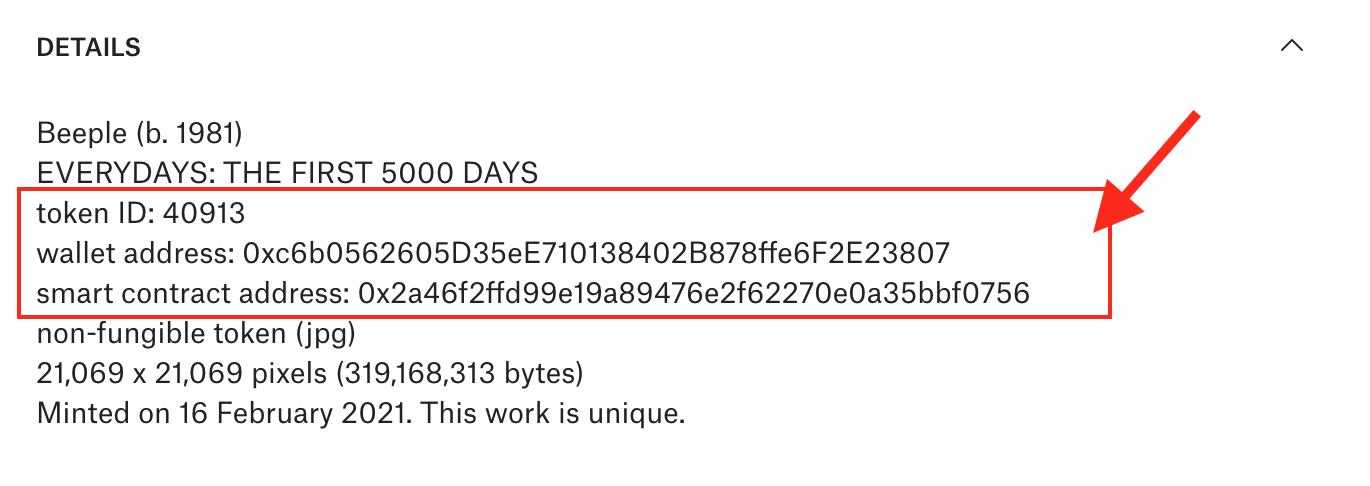

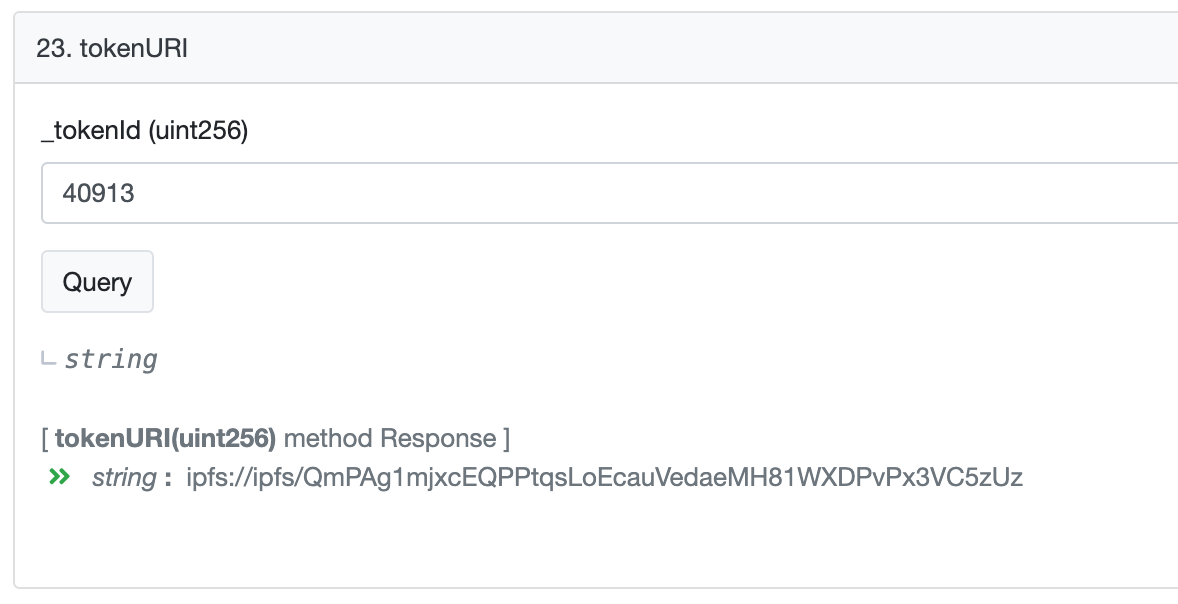

また、後述する IPFS、ブロックチェーンや、そのマッシュアップで新型コロナの頃に話題になった NFT などでは要の関数とも言えるなど、ハッシュ関数は、今後もさまざまな場面で活躍が期待される関数です。

この記事では、「ハッシュ関数の基本と基礎知識」、そして「ハッシュ関数を活用した SQLite3 の 1 つのアイデア」をシェアしたいと思います。

🐒 2021/02/19 追記: Qiita の Markdown の仕様変更により、今まで <details> タグで「必要な人だけみれる」ように隠していた基本的な情報も表に表示されています。そのため、やたら長い記事になっています。

🐒 2021/03/05 追記: Qiita の Markdown で、<details> タグの仕様変更は β 版の一時的なものだったらしいのですが、また再々編成するのも面倒なので、そのまま表示した状態にします。

と言うのも、Qiita は編集時に数文字打つたびにプレビューを更新するので、これだけ長文の記事になると秒単位で動作が重くなります。そのため、重複する説明も多く、やたら長い記事のままになっています(近々 git でオープンソースにしようか考えています)。

目次を見て、ハッシュ関数の基本や活用方法は「完全に理解した」と感じた方は、本題の「長さを知ったところで何?」まで、スキップしてください。答えを先に言っちゃうと「データのハッシュ値 n 桁を SQLite3 の rowid に使う」って模索した時の話しです。それでも読んでみようという方は、ゴロ寝でもしながら読んでください。よく寝れると思います。私も書いていて寝ちゃいます。

ハッシュ関数を完全に理解した気になるコマケーこと

ハッシュ関数の基本と特徴

先に、一言で恐れずに言うなら「ハッシュ値はデータの指紋」です。

つまり「データのハッシュ化」と言うのは「データから情報の指紋を採取すること」みたいなもので、「データのハッシュ」とはデータから採取した指紋情報を指し、データの暗号化でも圧縮でもないのです。

もちろん、データなので指を持ちません。そのため「指紋」よりは、ハッシュ値はデータの「情報紋」と言ってもいいかもしれません。

人間の指紋が特定の個人を識別するために使われるように、データの指紋(ハッシュ値)も特定のデータを識別するのに使われます。

符号化された情報、つまりコンピューターが認識できるデータ(0 と 1 のビットで表現できる情報)であればテキストであろうが、画像であろうが、プログラムであろうが、そのデータからハッシュ値を得ることができます。

人間の指紋は、それ自体からは直接本人を特定できませんし、個人情報を持ちません。しかし、本人の指紋と「比較」したり「対応表」さえあれば、誰の指紋であるか特定できます。そして、そこから DB で個人情報と紐づけることができます。とは言え、本人を特定できたとしても指紋からは本人を復元(クローンを作成)できません。

ハッシュ値も似ています。ハッシュ値だけでは元の値はわかりませんが、ハッシュ値を比較したり、対応表さえあれば元の値を特定できます。また、それをもとに(キーとして)DB に紐づけることもできます。さらに、ハッシュ値を知っていても、ハッシュ値そのものからは元の値を復元できません。

「復元できない」というのは、逆算できない・計算で割り出せないということです。例えば「割り算の余り」(剰余)からは、元の値がわからないのと似ています。

$max = 100; // IDの長さ(最大値は99。∴ 2桁表示で 00 〜 99 の固定長)

$message = 123; // メッセージを数値化したもの(文字コードなど)

$hash = $message % $max; // 123 を 100 で割った余り(必ず 0 〜 99 の範囲)

printf("%02s", $hash); // 23 <-- 余りが 23 になる組み合わせは無限にあるため

// message を見つけるには行動学的なアプローチ

// が必要になる

- message が、どんな値でも2桁のIDになる例をオンラインで見る @ paiza.io

そして、同じ指紋を持つ 2 人は必ず 1 ペア以上いる(0 %ではない)ように、異なるデータなのに同じ指紋(ハッシュ値)を持つデータは必ず作れます。(簡単とは言ってない)

先の例で言うと、メッセージが異なっても同じ余りになるようなイメージです。

$secret = 100;

$message = 123;

print_r($message % $secret); // 123 mod 100 = 23

$message = 323;

print_r($message % $secret); // 323 mod 100 = 23

もちろん、実際には、こんな簡単な式は使われません。

しかし、とてつもなく弱いながらも関数化すれば立派な「ハッシュ関数」です。ただ、実用には耐えない「アルゴリズム」と「ハッシュ値の長さ」の、なんちゃってハッシュ関数である、というだけです。

つまり、同じ「データの指紋」を持つ確率や識別の精度が内部のアルゴリズムやハッシュ値の長さに依存する、この「謎の箱」がハッシュ関数です。

では、ハッシュ関数の基本を「正しく」知ろうと Wikipedia を開くも、何を言っているのかわかりません。

- ハッシュ関数 @ Wikipedia

これは法律や音楽理論や機械学習などのドキュメントと同じように、「同じプロトコルの人(言っていることがわかる人)向けのドキュメント」だからです。

例えば、「変数」や「配列」と言う用語がわからないのにソート・アルゴリズムの説明を覗きに行ったり、メモリアドレスやポインタが理解できていないのに高速化ドキュメントを読んだり、ビットや XOR がわからないのに TCP や JPEG の仕様書を覗くようなものです。

もしくは「デスクトップを右クリックしてプロパティを開いてください」と説明したら、「日本語でおk」と相手がブチキレたことはないでしょうか。同じようなものです。

つまり、ハッシュ関数を正しく知ろうとするとプログラミングの基礎だけでなく「数学」や「暗号学」の基礎知識も必要なのです。そして端的に伝えようとすると、ある程度の基礎知識を相手に求めることになるものなのです。

この記事は、ゴロ寝読みでもいいので、一通り読んでから、再度 Wikipedia の記事を読み直してみてると「(読める ... 読めるぞ)」となることを期待しています。

学問こわい(暗号学・数学こわい)

さて「数学や暗号学の基礎知識も必要」とは言ったものの、暗号学の世界は調べれば調べるほど「暗号化・復号」といった世間一般が思うことを超え、いまや「暗号=セキュリティ」と同義なんだなと痛感します。

そして(数学含む)基礎知識がない人からの「本当に安全なのか」「なぜ安全と言えるのだ」と言った質問には、数式で証明して見せるしかありません。言葉で説明すると、今度は言葉が独り歩きするといった機械学習のエンジニアの方と話している時と似たジレンマを垣間見ます。

言葉の独り歩きと言えば、機械学習のディープラーニング系の話題で「研究者も、なぜそうなるのかわからない」と報道されるのを目にしたことがあると思います。そのため「作ってる本人たちすら理解できない謎の技術」的に思われがちです。

しかし、「わからない」というのは「仕組みはわかっているが、キチガイじみたと言うより、天文学的な組み合わせのパターンを機械にさせているため、なぜその組み合わせにたどり着いたのかがわからない」という略なのです。理解していないわけではないのです。

組み合わせの怖さを知らないという方は、「フカシギおねえさん」「組み合わせ爆発」「巡回セールスマン問題」「三体問題と二重振り子」と言ったキーワードで調べてみてください。

そして「では、仕組みを素人にもわかるように説明せよ。三行で。」みたいな、仕組み(理論や理屈)を理解する気もない、結果だけが欲しいせっかちさんが言うものだから、「なんかわからんけど、すごい」という認知と、AI という言葉が一人歩きして、世間との用語の乖離に悩んでいるそうです。

「AI が〜 AI が〜」と騒ぐのは、機械学習の学者からすると「『なんか知らんけど、時代らしい』というだけで付けた、電気ブランやデジタル・パーマみたいなもんが溢れかえっている」らしいです。

まぁ、確かに時代ではあるのですが、ぶっちゃけ 👌 がないと、まともな研究やモデル作成はできません。そのため流行ってくれないと予算も出ないし、説明した(正した)ところで「動くものだけで、仕組みに興味がない相手」に誤解を解くための時間を割くのも無駄と言うのが現状らしいです。

我々プログラマーの世界で言えば、「デジタル化」は「符号化であって、電子化のことではない」と思いつつも「デジタル化=電子化」という世間の認知に流されないといけない歯痒さに似ています。もしくは「(えぇぇ。それはクラウドとチャうヤろ)」といった感じでしょうか。

上記 「デジタル化」は「符号化であって、電子化のことではない」 について、思いのほかカチンときた人が多いみたいで、SNS で「トランジスタも電子制御なんだから電子化と言っても間違いじゃない」という感じのツッコミを数件いただきました。

補足しますが、ここで言う「デジタル化」とはディジット、つまり数えられるくらいまで情報量を落とすことを言います。

アナログ・データの内容が「0b1011」と表現できるなら、囲碁の石やオセロのコマを「●◯●●」と並べて置いたり、「/-//」と壁に傷をつけても、その数(情報)は過不足なく相手に正確に伝え、残すことができるという意味です。同様に、波の幅を「広い・狭い・広い・広い」と送信すれば、アナログ信号であってもデジタル情報を伝えられます(いわゆる地デジ)。

アナログを「坂」だとすると、デジタルは「階段」のようなもので、「なんとか山の●合目で待ってる」より「なんとか山の●段目で待ってる」の方が正確に伝わるイメージでしょうか。

つまり、必ずしも電気もしくは電子機器でないとデジタル化できないというわけではないのです。それらを使った方が、何かと楽だし、速いというだけなのです。

また、「数えられる」という点で「デジタル化」を「量子化」とも言ったりします。アナログ(無限に連続した)データの測定値を丸めたものを量子化と言い、符号化したものがビットなのですが、ハッシュ関数における説明においては「量子化」という言葉を使うのは好きではありません。後述しますが、ある種のハッシュ関数(特に暗号がらみ)では天敵とも言える量子コンピューターの話で、わけわかめになるからです。同じ「量子」ですが、「佐野量子」くらい違いがあるのに、勝手に紐づける人が多いからです。

この記事では、例えば画像をスキャンしただけのものは「電子化」、画像からデータを抜き出し解釈できるもの(例えば OCR データ)を「デジタル化」と呼びます。これは後述する「電子署名」と「デジタル署名」の違いで重要だからです。

さて、暗号学の世界も我々のようなパンピーが解釈した内容が微妙に間違ったまま広まっているため、動くものだけで仕組みには興味がない相手に、基礎から教えたり間違いを正す時間を割くのも無駄と感じるようです。

偉そうにゆうて、筆者も数学や暗号学に強いわけではありません。

しかも、エンジニアと言うよりは猿人に近いので、1 つの公式より 500 文字のソースコードを見せてもらった方が理解できるのです。

そこで、bash などを触ったり、自分で何かしらのプログラム言語で俺様関数を作ったことがあればわかるプログラマー的な表現方法で「知っておいた方が良いハッシュの基礎知識」を説明したいと思います。

なお、この記事にはサンプル・プログラムはあるものの、計算式やアルゴリズムの詳細はありません。また、セキュリティーの記事でもありません。むしろ暗号学やセキュリティー以前の基礎知識レベルです。「割り算の余り」や「変数」が理解できていれば十分です。

あくまでも筆者が考える、実動作するものを通して理解する「ハッシュ関数の基礎概論」的なものです。そのため、丁寧に説明しているつもりですが、いささかくどい部分があります。

ジャンクフード的な記事ですが、自分なりに「ハッシュ関数が好きになる話題や実例」を、てんこ盛りにしていますので、ゴロ寝でもしながらスマホでお読みください。

この記事では、さまざまな用語と、その概要を説明しています。そして、それらの用語がつながって(点と点が線になって)行くさまを楽しんでいただければと思います。

また、興味のあるキーワードが出て来たら自分なりに掘り下げて、より正確なものに堀り下げて欲しいと思います。キーワードの概要を理解した上で各種文献をご覧になると、より理解度が高まった、そんな記事になるといいなと思います。

そして間違いを見つけたら、戻ってきて、こっそりコメント欄に書いていただけると嬉しいです。

また、この記事は「❤︎(旧 LGTM)」が付くたび、その時折で得ている知識や間違いを整理するつもりで更新・修正しています。書き出さないと理解できないサガなので、1 つの情報として気軽にお読みください。

「ハッシュ」の意味と「ハッシュ関数」の定義

さて、ハッシュ関数の説明の前に「ハッシュ」の意味と、この記事における「ハッシュ関数」の定義をしないといけません。

というのも、後述しますが一般的に「ハッシュ関数」という言葉は「暗号学的ハッシュ関数」を暗に指していることが多いからです。

そのため「ハッシュ関数のアルゴリズムとして CRC を含めるのは違うんジャマイカ🔈」と言う方もいると思います。

鋭い。

確かに、CRC はチェック・サムの親戚みたいなものだし、正しくは「ジャメイカ🔈」です。

しかし、それに固執しすぎるとセキュリティにばかり目が行ってしまい、「ハッシュ」の用語の理解だけでなく、「ハッシュ関数」の利用方法を狭めてしまいます。

特に、「データの類似性」をハッシュ値にする「知覚ハッシュ」(Perceptual Hash)の理解の妨げや、機械学習において「ハッシュ化してトークンを作成する」と言われ「機械学習に暗号が使われている」といった誤解にも繋がりかねません。

「ハッシュ」とは何か

myArray["foo"] = "bar"; などの連想配列の「ハッシュ・テーブル」や、JSON オブジェクトなどの「ハッシュ」(添字配列)と聞いて、「(ハッシュって何だろう)」と調べたら、やたら暗号や数学の話しが出てきて、そっ閉じされた方も多いと思います。

それでは「ハッシュ」とは何でしょう。

ハッシュ関数の「ハッシュ」は「hash」と書き、単純に日本語に訳すと「ごた混ぜ」「細切れ」「台無しにする」などの意味があります。

しかし、その語源を辿ると面白いルーツがわかります。

美術の古典技法で「hatch」という平行線で描画する技法があり、フランス語の「hach🔈」から来ています。日本の漫画などでもペン画の基本となっている技法ですね。

|

|---|

| ハッチング技法の例(Wikipedia 「ハッチング」より) |

そこから英国英語では平行線で構成された「井の字」や「二の字」のような状態のものを hatch もしくは hash と呼ぶようになりました。潜水艦や宇宙船の「ハッチを開ける」などのハッチも「井の字型の出入り口」であったことから来ています。

他にも、肉やジャガイモなどを、縦横に井の字カットしていき、細切れになったものを「hashed 〜(ハッシュドなんとか)」と呼ぶのも同様の語源です。

そして英国では電話の「#」キーを「ハッシュ・キー」と呼ぶようになりました。これが現在の「ハッシュ・タグ」(ハッシュ記号 # によるタグ付け)の語源です。

ちなみに、"#" の記号自体はラテン語の "libra"(平等やバランスを象徴する天秤。転じて「重さ」)の略字が崩れたものです。

ローマの商人などが、libra pondo(「重さの量」)を手書きする際に "lb" に横線を入れて略した "℔" が崩れたものが "#" です。のちにこれが量や数を示す記号となります。

"#" を米国英語ではポンド(pound)と呼んだり、ポンドの略が "lb" や “£”(libra の L)だったりするのも libra がルーツです。

言語学的には「平等」(libra)と「自由」(liber)は関係がないのですが、ラテン語圏では「独裁政治・封建制・奴隷制などからの解放」系で、よくセットで使われるため、「不平等からの解放と自己責任 = 自立」とし、不平等からの解放を "libre" なんとか(自由な、なんとか)と好んで表現されます。

Libre Office などの libre が「無料という意味ではなく、自由(不平等からの解放と自己責任)である」と言われるゆえんでもあります。

ハッシュ・タグ("#")の記号にも、こんな深い意味があったんですね。知らんけど

さて、閑話休題。

転じて データをコマ切れにして、それ単体では全体がわからないものをコンピュータの世界では「ハッシュ」と呼びます。

先に、「ハッシュ化してトークンを作成する」という機械学習の表現があることに触れました。具体的には、データ(例えばテキスト文)をコマ切れにして、各々をトークンと呼び、トークンには ID が振られます(トークンとは、そこでしか利用できない発行物を指し、ここでは、このデータでしか意味をなさない ID です)。

このコマ切れにすることを機械学習でハッシュ化と言います。

| 元データ | This is a data to be hashed and tokenized. |

|---|---|

| トークンと ID (6文字ごとにハッシュ) |

This i, s a da, ta to , be has, hed an, d toke, nized.

|

他にも、Javascript などの Hash map や、Redis などの hash といった、どうみても連想配列か JSON のオブジェクトにしか見えないものを「ハッシュ」と呼んでいるのも、データ全体を細分化したものだからです。

| ID | Name | Age |

|---|---|---|

| 001 | Alice | 32 |

| 002 | Bob | 33 |

| 003 | Charlie | 16 |

上記データの Redis におけるハッシュ(1 件のデータ。行のこと)。

| Key | Value |

|---|---|

| ID | 001 |

| Name | Alice |

| Age | 32 |

しかし、この程度の細分化では個々のデータを寄せ集めれば元の形に戻ってしまいます。角切りステーキのようなイメージです。ハンバーグのミンチ肉のように、復元ができないレベルまで分割して都合のいいサイズで使いたい場合に使われるのが「ハッシュ関数」です。

【まとめ】

コンピューター業界における「ハッシュ化」とは、情報を処理しやすいように断片化すること。断片化された情報(ハッシュ値)単体では全体が見えないのが特徴。

🐒 ちなみに「ミンチ肉」などの「ミンチ」は、ラテン語の「小ささ」の意である「minutia」が、フランスで「mincier」になり、英国の「mince」になったものです。「分」の minute や「小さい」の mini がミンチ肉と同じ語源なのも面白いですね。

「ハッシュ関数」の定義

データをコマ切れにするなど、「それ単体では全体がわからないデータにすることをハッシュと呼ぶ」ことはわかりました。

そして、ハッシュ・マップなどは寄せ集めれば全体が見えてしまうので、そもそも元の形に復元ができないレベルまで細分化(ミンチ状態に)して、都合のいいサイズにしたい時に使うのがハッシュ関数ということもわかりました。

以上を踏まえて、この記事における「ハッシュ関数」の用語の定義をしたいと思います。

A hash function is any function that can be used to map data of arbitrary size to fixed-size values.

(Hash Function @ Wikipedia より)

【筆者訳】

ハッシュ関数とは、任意のサイズのデータを固定サイズの値にマッピングするために使用できる関数全般のことを言います。

つまり、どのような内部処理の考え方の関数であっても「その関数を通すと固定長のデータで返ってくる関数」を、この記事ではハッシュ関数と呼びます。広義(広い意味)でのハッシュ関数ですね。

「ハッシュ関数」とは何か

何はともあれハッシュ関数は「任意のデータを渡すと『ハッシュ値』と呼ばれる値が返ってくる関数のこと」です。

... ... ... まぁ、そうですよね。

でも「ただの関数である」という認識は意外に重要なのです。

機械学習などで「ニューラル・ネットワーク」とか見聞きする際、「○」がたくさんの線でつながっている図を見て、怖いと感じた方もいると思います。

実は、あの「○」って関数やメソッド(クラス関数)のことなんです。

そして関数の出力を、別の関数の引数に「配列で渡している」のが「線」なんです。

しかも「○」の関数は「引数に重みを付けて足し算してフィルターにかけるだけ」といった「単細胞かよっ!」と言いたくなるような単純な処理をするだけだったりします。

そう考えながら見ると単純です(簡単とは言ってない)。

「ハッシュ関数」も、なんだかんだ言っても結局のところ「ただの関数」なのです。

「函数」つまり「引数が同じなら期待する値が出てくる謎の函」です。そして「ハッシュ値なる謎の値」が戻り値であると言うだけです。(「ハッシュ値」については後述します)

ほとんどのプログラム言語で「ハッシュ関数」は実装されていますが、使用できるアルゴリズムは環境によって異なります。標準ライブラリ(最初から同梱されているモジュールなど)に含まれているかに依存するからです。

「ハッシュ値」とは何か

さて、ハッシュ関数の戻り値である「ハッシュ値とは何か」の前に、以下の "beef" および "beef1" という文字列をハッシュ値にした例をご覧ください(一見、ランダム関数のようにも思えますが違いは後述します)。

本記事で使用する言語は、bash と PHP です。コマンドが 1 行でおさまると言うだけで選びました。どちらの言語も知らなくても、やっていることは同じなので気楽に構えてください。文字列を関数に渡して出力しているだけです。プログラムの文法などは深く考えずに「単純に何をしているか」に気付けば十分です。

bash は openssl コマンド、PHP では hash() 関数を使ってハッシュ化しています。また、利用するアルゴリズムは md5 と sha512 です。

ポイントは、bash php に限らず、どのプログラム言語を使っても以下の 3 つは同じことに注目です。

- 数値(16 進数)の文字列で返ってくる。

- アルゴリズムと引数が同じ場合は結果も変わらない。

- 塩を 1 足すだけで結果が大きく変わる。

ハッシュド・ビーフの例

$ # 粗挽き牛ミンチ

$ echo -n 'beef' | openssl md5

34902903de8d4fee8e6afe868982f0dd

$ # 粗挽き牛ミンチ

$ echo -n 'beef' | openssl md5

34902903de8d4fee8e6afe868982f0dd

$ # 粗挽き牛ミンチ(Bash)

$ echo -n 'beef' | openssl md5

34902903de8d4fee8e6afe868982f0dd

$ # 粗挽き牛ミンチ(PHP)

$ php --run 'echo hash("md5", "beef");'

34902903de8d4fee8e6afe868982f0dd

$ # ハッシュド・ポテト

$ echo -n 'poteto' | openssl md5

147f31c730caa77f8a3440e549264a2e

$ # 角切りトマト

$ echo -n 'tomato' | openssl md5

006f87892f47ef9aa60fa5ed01a440fb

$ # 粗挽き牛ミンチ + 1g の塩入り(beef1)

$ salt=1; echo -n 'beef'$salt | openssl md5

30017279d6a5bac241e764eeed261dd8

$ # 粗挽き牛ミンチ + 1g の塩入り(コックが違っても同じレシピなら同じ味)

$ php -r '$salt=1; echo hash("md5", "beef" . $salt);'

30017279d6a5bac241e764eeed261dd8

$ # 絹ごし牛ミンチ

$ echo -n 'beef' | openssl sha512

8cd8bb0cef938ef9cd054c2c2cb965e83310ab5c197cb5fc8f35892a44c1a028bac9e1bcd6248580fa2739cc96074885ea3ee116ef35c2d8f6124270aeff50b7

$ # 絹ごし牛ミンチ(コマンドの言語が違っても同じアルゴリズムと引数なら同じミンチ肉)

$ php -r 'echo hash("sha512", "beef");'

8cd8bb0cef938ef9cd054c2c2cb965e83310ab5c197cb5fc8f35892a44c1a028bac9e1bcd6248580fa2739cc96074885ea3ee116ef35c2d8f6124270aeff50b7

$ # 絹ごし牛ミンチ + 1g の塩入り

$ salt=1; echo -n 'beef'$salt | openssl sha512

a528829f370819123ad3fb04d8066b77ec79ce6eddad07e5b2c925bbd9b2e699e73428d23315875c29b45500b8c767262cf5546e33974e4f7a6102abd1bb045e

$ # 絹ごし牛ミンチ + 1g の塩入り(コックが違っても同じレシピなら同じ味)

$ php -r '$salt=1; echo hash("sha512", "beef" . $salt);'

a528829f370819123ad3fb04d8066b77ec79ce6eddad07e5b2c925bbd9b2e699e73428d23315875c29b45500b8c767262cf5546e33974e4f7a6102abd1bb045e

- オンラインで動作をみる (PHP, Bash, Go, Python3) @ paiza.IO

Windows の PowerShell でも試してみる

Windows 11 の標準コマンドでハッシュ値を確認するには certutil と Get-FileHash コマンドがあります。

certutil は多機能である(証明書の無効化操作といったクリティカルな機能も含む)ため、単純にファイルのハッシュ値を確認するだけなら Get-FileHash を使うことが推奨されています。

Get-FileHash [オプション] <ファイルのパス>

# 使用例

Get-FileHash -Algorithm SHA512 foo.pdf

問題は Get-FileHash は「ファイル」のハッシュ値に特化していることです。そのため、「文字列」のハッシュ値を知りたい場合は直接使えないので、工夫が必要になります。

PS C:\Users\KEINOS\OneDrive\Desktop> # 改行なしで "beef" のテキストを作成

PS C:\Users\KEINOS\OneDrive\Desktop> "beef" | Out-File beef.txt

PS C:\Users\KEINOS\OneDrive\Desktop> Get-FileHash -Algorithm MD5 ./beef.txt

Algorithm Hash Path

--------- ---- ----

MD5 34902903DE8D4FEE8E6AFE868982F0DD C:\Users\KEINOS\OneDrive\Desktop

スクリプト内で文字列をハッシュ化したい場合は、一旦ストリームに文字列を書き込み、ストリーム経由で読み込ませる必要があります。

PS C:\Users\KEINOS\OneDrive\Desktop> # スクリプトの中身

PS C:\Users\KEINOS\OneDrive\Desktop> get-content ./beef.ps1

$stringAsStream = [System.IO.MemoryStream]::new()

$writer = [System.IO.StreamWriter]::new($stringAsStream)

$writer.write("beef")

$writer.Flush()

$stringAsStream.Position = 0

Get-FileHash -InputStream $stringAsStream -Algorithm MD5 | Select-Object Hash

PS C:\Users\KEINOS\OneDrive\Desktop> # スクリプトの実行

PS C:\Users\KEINOS\OneDrive\Desktop> . ./beef.ps1

Hash

----

34902903DE8D4FEE8E6AFE868982F0DD

- 参考文献:「例 4: 文字列のハッシュを計算する」 | Get-FileHash | リファレンス | PowerShell @ learn.microsoft.com

PS C:\Users\KEINOS\OneDrive\Desktop> $PSVersion::PSVersion

Major Minor Patch PreReleaseLavel BuildLabel

----- ----- ----- --------------- ----------

7 4 1

さて、上記を見ると beef の原型はありませんが、ハッシュ値の対応表があれば、元は beef もしくは beef1 であることは確認できそうです。

ハッシュしたてのビーフはミミズにしか見えませんが、成分表(?)上は同じでも「原型を留めていない状態を数値の文字列にした値」がハッシュ値です。

非可逆な感じは、「覆水盆に返らず」でも「水である」ことはわかるようなイメージでしょうか。

とは言え、ハッシュ値は「値」とあるように数値です。しかし、10 進数の値のままだと人間(エンジニア)が扱いづらいので短くするため、一般的に 16 進数の「数値の文字列」で返してきます。ハッシュ関数のオプションによっては文字列型でなく、バイナリ(バイトデータ型)のまま取得できるものもありますが、いずれにしても「数値として認識できる値」で返ってきます。

そして、どのようにミンチ(ハッシュ)にするかが「アルゴリズム」になります。

カードをシャッフルするかのように何度も XOR をする物もあれば、データを 1 バイトずつ読み込みながらゴニョゴニョしたりと、どのアルゴリズムも使用目的や思想によって設計が異なります。

暗号学的ハッシュ関数とチェックサム的ハッシュ関数

ハッシュ関数の戻り値である「ハッシュ値」を生成するには、本記事の一覧で紹介しているように、色々なアルゴリズムがあります。

各々異なった思想や目的で設計されていますが、いずれのアルゴリズムでも「引数が同じであれば戻り値も同じ」「どんな長さのデータでも固定長のデータにする関数」という点は変わりません(例え演算結果が 1 と短くても、最大値は決まっているため「パディング」と言って、頭をゼロで埋めて固定長にします。それに輪を掛けて、SHA-3 の SHAKE256 のように任意の長さで取得できるアルゴリズム、つまり可変長のアルゴリズムもありますが、引数が同じであれば同じ値が返ってきます)。

「ハッシュ関数」の種類

ハッシュ関数には大きく 2 つの種類があります。

暗号学的ハッシュ関数と、それ以外です。

ハッシュ関数によっては、暗号化にも使われている考え方を利用したものがあります。これを「暗号学的ハッシュ関数」と呼びます。恐れずに言うと「セキュリティー目的で使われるハッシュ関数のこと」です。

先述しましたが、ハッシュ関数には以下の 2 つの特徴があります。

- 同じ結果になる

- アルゴリズムと引数が同じ場合は、同じハッシュ値が返ってくる。

- 同じ長さの値になる

- ハッシュ値は固定長の数値で返ってくる(一般的に n 桁の HEX 文字列)※1

そして「暗号学的ハッシュ関数」の場合は、これに輪をかけてさらに大きな 3 つの特徴が加わります。

- 同じハッシュ値にならない

- 異なる引数を、同じハッシュ値にするのは限りなく難しい。

- 逆算ができない

- ハッシュ値から元の値(引数の値)は計算式による算出ができない。※2

- 予測が困難である

- 入力の規則性に対して出力に規則性があってはならず、ハッシュ値から元の値の予測は難しい。※2

異なる値なのに、ハッシュ化すると同じ値になることを「衝突」(コリジョン)と言います。

しかし、同じ衝突でも「あるハッシュ値と同じハッシュ値になる値を探す」のと「同じハッシュ値になる異なる 2 つの値を探す」のでは種類が違います。

「自分と同じ指紋の人を探す」のと「同じ指紋を持つ 2 人を探す」のでは確認する数が違うのと同じです。研究する上で、これらの違いは重要なため、専門家同士が迅速に疎通できるように各々に専門用語が付いているので Wikipedia や専門記事を読んでも難しく感じるのです。

暗号学的ハッシュ関数について、セキュリティ(暗号学)専門の方の説明を聞いても、わかるようでわからない説明に感じます。「... ... 美学」と説明されるような小難しさです。

「なぜ小難しい言い方をするのだろう」と思い、備忘録として、この記事を書き始めたわけですが、単純に「(その業界の)勉強不足」という語彙力のなさなのでした。とほほ。

【まとめ】

ユーザー目線だと「暗号学的ハッシュ関数」は、データの改竄検知に強い「データの同一性」が重視されたハッシュ関数であるのが特徴です。

つまり、異なるデータが同じハッシュ値になりづらいアルゴリズムと言えます。暗号学的ハッシュ関数以外のハッシュ関数に関しては後述します。

ランダム関数とハッシュ関数

さて、ハッシュ関数に触れ始めるとランダム関数との違いが気になってきます。

ハッシュ関数とランダム関数は、どちらも戻り値の予測が難しいゴタ混ぜな数値を返します。しかも、ランダム関数(擬似乱数)も、シード値が同じ場合は「毎回同じ結果になる」のです。

ランダム関数は、同じ値になる戻り値を「均等にランダムに返そうとする」ことが目的です。つまり、出力結果に偏りがないようにランダムに値を出力しようとします。そのため、ランダム性の性能は、OS やライブラリやハードウェアに依存するため、シード値が同じでも、すべての環境で同じ値が返ってくる保証がないのです。

反面、ハッシュ関数の場合は「アルゴリズムと引数が同じなら、どの環境でも毎回同じ結果になる」という点がランダム関数と異なります。

さらに、ハッシュ関数の場合(特に暗号学的ハッシュ関数)は、「入力値が異なるなら、なるべく同じ値の戻り値にならないように返そうとする」点も異なります。

暗号化とハッシュ化

さて、「暗号学的ハッシュ関数」と言われて「暗号学的?暗号的でなく?」と思った方も多いと思います。

これは、暗号学の考え方を取り入れた、セキュリティ用途に使われるハッシュ関数だからです。

「暗号学的ハッシュ関数」は後から出てきたのですが、現在は他を凌駕し、ハッシュ関数と言えば暗号学的ハッシュ関数を暗黙的に指すことも多くあります。

ハッシュ関数は「暗号の世界」でも、とてもよく使われる関数で、暗号化する際にも内部でよく使われます。

そのためか、ハッシュ関数を「データを暗号化する関数のひとつ」のように説明しているブログもありますが、違います。厳密には「データの暗号化に関係する関数のひとつ」です。ハッシュ関数自体は暗号化をするものではありません(後述しますが、関連はあります)。

確かに、元データとハッシュ値の対応表を別途用意していれば、対応表を暗号の解読コード表としても使えるため「暗号用途」には使えます。

しかし、暗号は「可逆」、つまり元に戻せる(復号できる)とわかっているから暗号と呼ばれます。

反対にハッシュ関数は「非可逆」、つまり「元には戻せないことが特徴」であるため、ハッシュ化は暗号化ではありません。

くどいのですが、この違いは意外に重要なのです。

と言うのも、ハッシュ関数を知らないし興味もない相手に説明するのが面倒なため「暗号の一種です」と言ってしまうものだから「ハッシュ値を復号したい」という人が後を断ちません。「ハッシュ化」=「暗号化 + 圧縮」と勘違いさせてしまうパターンです。

これは、「アーカイブ」を「圧縮」と説明されるものだから「tar でアーカイブしたのに、サイズが小さくならない」と勘違いするような、小さなことかもしれません。しかし、そのようなクレームを入れる人は「ハッシュ値から復号して欲しい」と要望するのです。

また、「暗号学的ハッシュ関数」を説明する時に「暗号学的な特性をもたなければいけない」という言葉からも誤解が生まれているようです。

「(暗号の特性ということは復号できるんだな)」と。

できません。

おそらく、大半のハッシュ関数初心者が勘違いすることではないでしょうか。かく言う私もそうでした。

ここで重要な用語の認識があります。「暗号」です。

と言うのも、先に「暗号は復号できる(元に戻せる)とわかっているから暗号と呼ばれます」と言いました。実は、これは「パソコン」を「計算機」と言ってしまうくらいの語弊があります。

現在「暗号」と付くものは「セキュリティ」と同義です。どちらも「何かを他者から守るもの」と考えれば、しっくりくると思います。

つまり、暗号化・復号だけを暗号と呼ぶのではなく、暗号学を駆使したセキュリティ技術も「暗号」と呼ばれます。

例えば、後述するビットコインなどのハッシュ値の塊みたいなものでも「暗号資産」と呼ぶのも最たる例です。

「暗号資産」と言うのは「暗号化された資産」という意味ではなく「暗号学でセキュリティが強化・保護された資産」という意味なのです。ゼロ知識証明などの最先端の暗号技術が駆使されているのです。

「ゼロ知識証明」を恐れずに一言で説明すると「自分が持っている数値(情報)を相手に知らせることなく、相手はその値が正しいと確信(確率が高いと認識)できる技術」です。

言い換えると「相手が持っている情報を知ることができない(情報がゼロだ)が、その情報が正しいと確信するための技術」です。

技術と大袈裟に言っていますが、人間も日常的に似たテクニックを利用しています。

「本当に足し算を理解したのか?丸覚えしているだけではないのか?」という、相手の頭の中を知ることができない場合は、理解していないと解けないテストを繰り返すことで確信度を上げて総合的に判断します。

また、コタツ記事と思われる情報に対して、図書館、一次文献や出典元などから裏取りをすることで確信率を高めるユーザーの行動と同じだったりします。

「ゼロ知識証明」における情報は数値なのですが、「本当に本人であるか」を証明するためなどに活用できます。

例えば、後述する公開鍵・秘密鍵暗号を利用したものです。秘密鍵を「本人しか作成できない値」として紐づけることで、相手が秘密鍵を知らなくても「当人である」と確信(確率)を高められたりします。

具体的には、秘密鍵から作成される検証可能な値(例えば公開鍵、デジタル署名や紐づいたハッシュ値など)を、本人しかアクセスできない箇所(キーサーバー、DNS 設定、ブログや SNS のプロフィール欄など)に複数箇所に設置します。

「複数箇所」がポイントで、これにより相手は秘密鍵を知らなくても(秘密鍵の情報がゼロでも)本人である確率を高め、複合的・総合的に判断できるようにすることも「ゼロ知識証明」の一種です。Keyoxide などがこの仕組みを利用しています。

そもそも公開鍵暗号自体が「自分が持っている数値(秘密鍵)を相手に知らせることなく、相手は(公開鍵により)その数値が正しいことを知ることができる技術」だったりします。

他にも、後述する Bitcoin や Ethereum などの暗号資産では何かしらの真偽に対する証明に活用されます。

これらの暗号資産は公開ブロックチェーンをベースにしているため、誰でも相手の残高がチェックできます。そして振り込み(口座間の残高移動)をする際に、本当に正しい相手先(秘密鍵を持っている相手)に振り込んでいるか、ちゃんと振り込まれたかなどに利用されます。

詳しくは後述しますが、公開ブロックチェーンにより、取り引きの透明性と堅牢性(改竄への耐性など)が本人証明に加わるため、暗号資産の技術は注目を浴びているのです。マスメディアが言うような法定通貨の代替となるからではありません。

何よりも、日本において法定通貨の代わりとなるデジタル通貨は、すでに日常で使われています。V ポイント(旧 T ポイント)、楽天ポイント、d ポイント、Suica といったポイント・システムです。ビットコインと違い、直接現金化(換金)できませんが、既存のポイントシステムの方が(自社システムのため)決済処理も速く、日常の利便性は高いのです。

日本国内でビットコインが日常に浸透しないのは、ドルを普段使いしないのと同じ理由です。すでに信用に足る、高速決済可能なポイントシステムやクレジットなどの独自決済システムが浸透しているためです。沖縄で米ドルが使えるのは、円と同じくらい信用があり利用価値があるからです。

逆に言えば、自国の法廷通貨が信用できないため、金(Gold)や安定した外貨に頼るケースでは、ビットコインなどの暗号資産は普段使いされます。ロシア、中国やエルサルバドルが良い例でしょう。暗号資産が日常の決済手段ではなく、ドルのように為替寄りの印象があるのはそのためです。

このように、セキュリティに関係したハッシュ関数の使い方も広義の意味で「暗号」の一部だったりします。

そのため、この「現在の暗号の常識」を認識している人が言う「ハッシュ化は暗号の一種です」というのは、実は間違っていないのです。問題は、その常識を認識していない人にも同じように説明してしまうためなのです。

英語であれば cipher、encryption、cryptography は違うものなのですが、日本語に翻訳されるものはすべて「暗号」や「暗号化」と翻訳されるのが問題かもしれません。日本語難しい。

日本語が難しいと言えば、翻訳の問題も「ハッシュ関数が暗号の一種という誤解」に関係があると思います。

暗号の論文をわからないながらも読むと "〜 by one-way encryption using hash ..." という言い方が多く出てきます。

丁寧に訳すと「... の、逆算による復号が難しい暗号化を行うためにハッシュ値で〜する」という意味です。

しかし、基本がわかっている人には長ったらしい説明であるため「一方向暗号をハッシュで行う」みたいに訳してしまうのだと思います。

後述する「一方向性関数」を理解して、じっくりと咀嚼すれば訳は間違ってはいないとわかるのですが、パッと「一方向暗号をハッシュで行う」と言われると「ハッシュ関数で一方向に暗号化する」と捉えてしまいそうです(ました)。

また、暗号学の世界では、2 つの固定長のデータを 1 つの非可逆な固定長データとして出力する関数を「One-way compression function」(一方向性圧縮関数)と呼びます。

「非可逆な固定長データにする」という点から、これらの関数を「hash function」とも呼ぶことがあるため、「暗号化+圧縮=ハッシュ値」と誤解のある説明になりがちなのだと思います。

さて、以上を踏まえると「暗号学的ハッシュ関数」が意味することは「セキュリティ目的で使われるハッシュ関数」と言えます。

とは言っても、以下の条件に「暗号でも使われる考え方」(アルゴリズム)を利用しているハッシュ関数というだけのことです(重要なのですが)。

- 「

A→ (処理) →B」としたとき- 「

BからAがバレてはいけない」 - 「

CからBが作成できてはいけない」

- 「

このような「片方向の処理は簡単だが、逆方向は難しい」系の関数(A → B は簡単だが B → A は難しい値を返すもの)を One-Way Function と言います。

「一方向性関数」自体は概念的なもので、具体的にこれというものは存在しません。

例えば「大きな素数を掛け算して自然数を返す」関数などが近いものです。なぜなら、逆の「(大きな値の)自然数から素数を算出する処理」は大変だからです。

他にも「割り算の余り」、つまり剰余(MOD や %)などもよく使われます。なぜなら逆の「余りだけから考えられる元の値の組み合わせ」は無限にあるからです。(A * B) % C = D の場合、D のループするパターンを見れば C は予測できても A B の組み合わせは無限にあります。

hash(){

str="$1" OPTIND=1 # 入力を取得

prime=257 # 秘密の定数

sum=0 # 割られる数

# 入力文字ごとにループ

while getopts : na -"$str"

do

ascii="$(printf '%d\n' "'$OPTARG")" # ASCII コードを 10 進数で取得

sum=$(( sum + ascii )) # 割られる数に加算

done

h="$(( $(( $sum * $prime )) % 100 ))" # 加算値に秘密の定数を掛けて割った余り

printf "%s:\t%02d\n" "$str" "$h" # 2 桁で出力 (00〜99)

}

- オンラインで動作をみる @ paiza.IO

このように「一方向性関数」の考え方は暗号化の処理には重要です。そしてハッシュ関数も一方向性的な性質を持っているため、暗号処理やセキュリティ関連でも、よく使われるのです。

【まとめ】

- ハッシュ関数自体は、復号可能な暗号関数ではないものの、暗号業界では鉄砲玉の使いとして便利にコキ使われる関数である

- この、呼び戻すのが難しい「鉄砲玉の使い」を暗号業界の隠語で「一方向性関数」と呼ぶ

- そもそも、呼び戻せないことが前提のハッシュ関数を「暗号学的ハッシュ関数」と呼ぶ

- 「暗号学的ハッシュ関数」は、守ってくれるための(セキュリティ向けの)関数であるが、知識という身カジメ料を求める闇が深い業界向けの関数である

暗号学的ではないアルゴリズム(破損と類似の検知)

これまでの話しをまとめると、「暗号学的ハッシュ」は他のアルゴリズムと比べて「非可逆性」と「同一性」を重視したアルゴリズムです。つまり、「異なるデータが同じハッシュ値にならないこと」を目的としたタイプと言えます。

逆に「暗号学的ではないハッシュ関数」も数多くあります。

主に、暗号(セキュリティ)目的ではなく「データの状態」を確認するためのものです。例えば、非可逆性や同一性よりも「データが壊れていないかの確認」を目的としたタイプです。

つまり、異なるデータが同じハッシュ値になる可能性が高いことを承知の上で、あくまでも手元のデータが壊れていないかを確認するためのものです。有名なものでは CRC などがあります。

ハッシュ値を「データの指紋」だとすると、暗号学的ハッシュ関数に比べ CRC などは「指紋の種類(渦巻き状、ひづめ状、弓形状、変形状など)の確認しかできない程度のもの」と言えるかもしれません。「渦巻き状であるか」は確実に識別できるも、渦巻き状の指紋の人は多い、みたいなイメージです。

ここで「壊れてない = 改ざんされていない」とした場合、「セキュリティ目的で使用しとるやないかーい」と感じた方もいると思います。鋭い。

シャーペンの芯をドアに挟んでおき、割れていたら部屋に入られたと検知できる話しを聞いたことはないでしょうか。「データが壊れていないかの確認」とは、シャーペンの芯が割れていないかと同じです。つまり、それ自体はセキュリティではなく、応用がセキュリティなのです。そのため、セキュリティ(暗号)の世界は奥が深いのです。

他にも「暗号学的ハッシュ関数ではない

これらは Perceptual Hash(知覚ハッシュ)と呼ばれ、「感覚的に似たようなデータかの確認」を目的としたタイプです。

つまり、データの破損や完全な同一性の確認よりも、データの特徴・パターンをハッシュ値にすることで似たようなデータは近い数値、もしくは似たビットの並びになるのが「知覚ハッシュ」です。

知覚ハッシュは、主に画像や音楽といったマルチメディア関連の類似コンテンツの検知に使われます。他にも、最近では「類似論文の検出」や、機械学習において「類似データの生成や推論にも使えないか」といった研究も盛んです。

例えば LLM などでは、単語や語句の関連性を空間軸として、単語や語句を多次元空間に配置します。

|

|---|

| "Word embeddings and how they vary" @ ミシガン大学 AI ラボより |

すると、類似した文は類似した位置関係値を持つことになります。

その関係値をマッピングしたもの(座標をベースとした位置関係の配列。ハッシュ値とは言わず、Embeddings と呼ばれる配列データ)を、DB の検索キーとしてコンテンツの自然文検索に活用したりしています(これを Semantic Search と言います)。

知覚ハッシュの具体例として、類似画像の検知で有名な pHash を実際に見てみるとピンとくるかもしれません。

以下の 3 つの画像は人間が見ると「似たようなデータ」です。しかし、暗号学的ハッシュやチェックサム的ハッシュの場合は、1 ビットでも異なるとまったく異なるハッシュ値になります。

|

|

|

|---|---|---|

| MD5: 1776fb44ba995fff55ef3498f289b3ba | MD5: abd3a65a92022c0b1cb37b1d5bafb53e | MD5: 060eeab60cc578367f8cd22731a5774e |

対して、Perceptual Hash(知覚ハッシュ)はデータの類似性をハッシュ値にする(数値化する)試みです。例えば、先の画像を 64bit長(16桁)の pHash に通した場合、以下のように同じハッシュ値になります。

|

|

|

|---|---|---|

| pHash-64: ab85f430d0c3d35e | pHash-64: ab85f430d0c3d35e | pHash-64: ab85f430d0c3d35e |

また、解像度(出力ビット長)を高めると、違いは出てくるものの、ほぼ似た値になります。

Go言語で実装を見る

package main

import (

"fmt"

"image"

"image/jpeg"

"os"

"github.com/corona10/goimagehash"

)

const (

file1 = "qiitan_color1.jpg"

file2 = "qiitan_color2.jpg"

file3 = "qiitan_mono.jpg"

imgShrinkSize = 8 // 8 -> 64bit pHash, 16 -> 256bit pHash, must be 2^N

)

func main() {

img1, err := getImg(file1)

panicOnError(err)

img2, err := getImg(file2)

panicOnError(err)

img3, err := getImg(file3)

panicOnError(err)

hash1, err := goimagehash.ExtPerceptionHash(img1, imgShrinkSize, imgShrinkSize)

panicOnError(err)

hash2, err := goimagehash.ExtPerceptionHash(img2, imgShrinkSize, imgShrinkSize)

panicOnError(err)

hash3, err := goimagehash.ExtPerceptionHash(img3, imgShrinkSize, imgShrinkSize)

panicOnError(err)

fmt.Printf("hash1: %x\n", hash1.GetHash())

fmt.Printf("hash2: %x\n", hash2.GetHash())

fmt.Printf("hash3: %x\n", hash3.GetHash())

}

func getImg(imgPath string) (image.Image, error) {

file1, err := os.Open(imgPath)

if err != nil {

return nil, err

}

defer file1.Close()

return jpeg.Decode(file1)

}

func panicOnError(err error) {

if err != nil {

panic(err)

}

}

さて、この pHash の仕組みをザクっと説明すると「画像をモノクロ(グレースケール)に変換して、中央値からの濃淡の変化をパターンにし、固定長の配列にマッピングしたもの」です。

とは言え、単純に低解像度のモノクロ・モザイク画像を配列にしたものではありません。JPEG や MP3 の圧縮などでも使われる、差分の違いをパターン化するアルゴリズムを使っています。

ここで言う「パターン化」とは、数値の変化を波と見なし「複数の波が組み合わさったもの」として、単純な波(サイン波)に分解することを言います。そして各々の波の成分をマッピングしたものをハッシュ値とします。

伝わるかわかりませんが、電子音楽で言うシンセ音源と逆のことをするイメージです。各々のオシレーターの設定値(パラメーター)をマッピングしたようなもの、みたいな。もしくはフーリエ変換ってやつです。

そして、どれだけ類似しているかをハミング距離で計測します。

ハミング距離というのは、同じ長さの 2 つのデータを比較した時、違いが少ないほど距離が近い(類似している)とする考え方です。

具体的には、並びの違う箇所の数を距離とします。例えば、2 つのハッシュ値を xor した値(2 つが異なる場合は 1 にする処理)のビットの数を数え、1 の出現数が少ないほど距離が近いと考えます。

func HammingDistance(a, b []uint64) (int, error) {

if len(a) != len(b) {

return -1, errors.New("different length of input")

}

dist := 0

for i := range a {

// (a xor b) した結果のビットが 1 の数を加える

dist += bits.OnesCount64(a[i] ^ b[i])

}

return dist, nil

}

Go のソースコードをみる

package main

import (

"errors"

"fmt"

"image"

"image/jpeg"

"math/bits"

"os"

"github.com/corona10/goimagehash"

)

const (

file1 = "qiitan_color1.jpg"

file2 = "qiitan_color2.jpg"

file3 = "qiitan_mono.jpg"

file4 = "keinos_logo.jpg"

imgShrinkSize = 16 // 8 -> 64bit pHash, 16 -> 256bit pHash, must be 2^N

)

func main() {

images := []string{file1, file2, file3, file4}

lenImages := len(images)

hashes := make([][]uint64, lenImages)

for index, imgPath := range images {

img, err := getImg(imgPath)

panicOnError(err)

pHashed, err := goimagehash.ExtPerceptionHash(img, imgShrinkSize, imgShrinkSize)

panicOnError(err)

hashes[index] = pHashed.GetHash()

fmt.Printf("hash #%d: %x\n", index, hashes[index])

}

for i := range lenImages {

for j := range lenImages {

if i == j {

continue

}

dist, err := HammingDistance(hashes[i], hashes[j])

panicOnError(err)

fmt.Printf("Distance between #%d and #%d: %d\n", i, j, dist)

}

}

}

func HammingDistance(a, b []uint64) (int, error) {

if len(a) != len(b) {

return -1, errors.New("different length of hashes")

}

dist := 0

for i := range a {

dist += bits.OnesCount64(a[i] ^ b[i])

}

return dist, nil

}

func getImg(imgPath string) (image.Image, error) {

file1, err := os.Open(imgPath)

if err != nil {

return nil, err

}

defer file1.Close()

return jpeg.Decode(file1)

}

func panicOnError(err error) {

if err != nil {

panic(err)

}

}

ちなみに、類似画像のハッシュについて、英語ですが以下の動画が参考になります。

- SPED Talk Image Hashing @ Youtube

- 論文: AN IMAGE SIGNATURE FOR ANY KIND OF IMAGE | PDF by パロアルト研究所 @ ペンシルベニア州立大学

何はともあれ、いずれのハッシュ・アルゴリズムであっても「データを特定する指紋のようなもの」であることがポイントです。

破損チェック

先に述べた CRC や fnv などの「データが壊れていないかの確認」に使われる値は「チェックサム」とも呼ばれます。

しかし、学術的には「CRC」と「チェックサム」は別物です。各々のアルゴリズムが存在するからです。面倒臭いのが、実用面でチェックディジット的に使われる値全般を「チェックサム」と呼ぶことがあることです。

チェックディジットというのは、例えば、バーコードの最後の 1 桁の数値(ディジット)などです。

|

|---|

| データは“123”、チェックディジットは“6”のバーコード (「チェックディジットとは」 バーコードのしくみ @ キーエンスより) |

上の例では、バーコード・リーダーは値 "1236" を読み取ると「最後の 1 桁を除く値(ここでは "123")をゴニョゴニョと計算したら最後の 1 桁(ここでは "6")と同じになるか」と確認することで正常に読み取れたか確認します。

他にも、身近なところではクレジット・カードの番号にもチェックデジットが付いています。カード自体が有効であるかを確認する前に、そもそも入力された(読み取った)番号が正常に読み取れたか確認する必要があるからです。カード会社によってチェックに使われるアルゴリズムは異なりますが、有名なところでは Luhn アルゴリズムがあります。

- Go で Luhn アルゴリズムの動作を見てみる @ Go Playground

このように、最後の数値、つまり読み取りエラーを検知するのに使われる数値がチェックディジットです。

そして、ハッシュ値を似たような目的のために使われる場合に「チェックサム」と呼ばれることがあります(「SHA-256 なのにチェックサム

そのため、アルゴリズムとしての「チェックサム」と、用途としての「チェックサム」があることに注意します。この記事では CRC およびチェックサムの両アルゴリズムを「チェックサム的

なお、暗号学的アルゴリズムに比べ、チェックサム的アルゴリズムは速いものの、改竄

特に改竄に対しては、とてつもなく弱いです。

異なる値なのに簡単に衝突させる(同じハッシュ値にさせる)ことができてしまいます。これは、意図しないコードを差し込むことができるということでもあります。

例えば「foo」というコードに「this is a bad code」というコードを差し込みつつ、「0x1ff172ec」という調整を加えることで、同じハッシュ値にすることができてしまいます。

package main

import (

"fmt"

"hash/crc32"

)

func main() {

// Expected code

goodCode := "foo"

hashGolden := crc32.ChecksumIEEE([]byte(goodCode))

fmt.Printf("Good: %x\n", hashGolden)

// Inject malicious code "this is a bad code" with adjustment value

badCode := goodCode + "\nthis is a bad code\n\x1f\xf1r\xec"

hashHacked := crc32.ChecksumIEEE([]byte(badCode))

fmt.Printf("Bad : %x\n", hashHacked)

//

// Output:

// Good: 8c736521

// Bad : 8c736521

}

- オンラインで動作を見る @ GoPlayground

これは、チェックサム的アルゴリズムが「たとえ演算結果から元のデータは逆算できなかったとしても、データの改竄がしやすい」と言うことです。

つまり、ハッシュ値のやりとりを傍受された場合に、内容は分からずとも「はは〜ん」と流れを読まれ、いじられてしまう可能性がある、と言うことでもあります。

そのため「流れてきたデータに問題はないか」の確認に、「破損チェック」にはチェックサム的アルゴリズムを使い、「改竄チェック」には暗号学的アルゴリズムを使う、といった特徴に合わせた適材適所の判断が必要になります。

とは言え「数マイクロ秒の差が売り上げに大きく影響する」など、よほどシビアな条件でない限り、暗号学的アルゴリズムを使うのがいいでしょう。暗号学的アルゴリズムはチェックサムとしても使えるからです。(逆はできない)

使うなら SHA-2 系の SHA-512 や SHA-3 系の SHA3-256 などの強めのアルゴリズムなら、なおベストです。処理時間などのコストが許す限りベターなものを選びましょう。組み上がってからベストなものに調整して行った方がいいと思います。便利で丁度いいサイズの MD5 アルゴリズムを大事な局面で使っていると暗号警察がやってきますよ。

CRC をハッシュ関数のアルゴリズムに含める理由

この記事で CRC などのチェック・サム的アルゴリズムを、ハッシュ関数のアルゴリズムに含めた理由ですが、単純に List of Hash Functions に含まれており、たいていのプログラミング言語のハッシュ関数が使うモジュールに含まれているからです。

- List of Hash Functions @ Wikipedia

ここで先の「チェックサム的ハッシュ関数はハッシュと呼んでいいのか問題」が出てきます。つまり「CRC やチェックサムはハッシュではない」と言う話しです。

CRC が「ハッシュではない」と言われる主な理由に 2 つあります。

- CRC は多項式で足したり

XORしただけの値だから「予測困難」とは言えない。 - CRC は「誤り検出訂正」にも使えるので、元に戻せるから「逆算不可」とは言えない。

暗号学的ハッシュと比べパターンが現れやすいことから、最初の「予測困難とは言えない」はわかります。次に 2 の「誤り検出訂正に使える」ですが、「ん?訂正」と思われるかも知れません。

CRC は Cyclic Redundancy Check(巡回冗長検査)の略です。つまり Check(検査)とあるため、誤りを「検出」するためのもので「訂正」には使えないと重いコンダラ状態だったのですが、なんと訂正にも使えるそうです。

- Bitfilters | Mathematics of Cyclic Redundancy Checks @ Wikipedia

🐒 ちなみに「誤り検出訂正」ですが、コンピュータでは データが壊れていた場合に自動修復する機能が、そこかしこで使われています。例えば CD や HDD の読み込みや通信のパケットなどです。英語なのですが、以下の動画が基本的な考え方をわかりやすく説明しています。

-

Hamming codes and error correction | 3Blue1Brown @ YouToube(英語)

- ハミング符号 @ Wikipedia(日本語)

しかし、これはデータを修復する時に CRC のアルゴリズム(考え方)が使えることがあるだけで、「CRC のアルゴリズムでハッシュ化する」のとは根本的に目的が違います。

そうすると、次に「いや、そもそもチェックサムなんだからハッシュとは言えない」と言う、最初の議論が出てきます。

これは「学術寄りの正しい目線」と「一般定義されたユーザ目線」の違いのようなものです。なぜなら、確かに厳密な意味では CRC の値はハッシュ値ではないからです。この議論は、海外の掲示板や SNS でもしばし見受けられます。

しかし、これはプログラムで言う「文字列データ」と「バイナリ・データ」の違いを「文字列だってバイナリだから」と言う議論や、「ランダムと言ってもランダムではない」と言った議論と似た性質を持っています。ユーザーと、内部(の仕組み)を知るものの間での食い違いです。

「ドローンの研究をしています」と言っているのに「ラジコンの研究をしてるんですって」とか言われたり、「モニタと睨

いまどき CRC なんて使い所あるの?

SHA-2 や SHA-3 などのツヨツヨなハッシュ・アルゴリズムを知ってしまうと、CRC などのチェックサム的アルゴリズムなんかオワコンと思われがちです。

ところが、意外なところで使われるのがデーターベース(以下 DB)の負荷分散処理です。

例えば、リクエストされたキー(key)に対してバリュー(value)を返すだけの連想配列のような、キー・バリュー型の DB では、負荷を分散するために使われます。

と言うのも、リクエスト数やデータ量が多くなった場合、複数のノードにデータを分ける必要が出てきます(ここで言うノードとは、複数台で 1 つのサービスを提供している場合の 1 台のことです)。

この時、どの DB ノードにデータを保存するか・リクエストするかを決めるのに、リクエストされたキーをハッシュ関数に通し、その値をノードの台数で割った余り(余剰、mod)を使います。

nodeCount = 3 // 3台の DB ノードでクラスタリングする

nodeID = crc16(key) % nodeCount // 0〜2 の ID に分けられる

リクエスト毎に接続先を順番に切り替えるラウンドロビン方式を発展させた考え方で、リクエスト・キーが同じなら決まったノードに転送できます。メリットとしては、ラウンドロビンのように全てのノードが同じデータを持つ必要がありません。また、ハッシュ値が衝突したとしても同じノードに送られるだけなので、速度を優先できます。

しかし、このままだとノードの増減にフレキシブルに対応できません。そこで、あらかじめノードに複数の ID をマッピングしておきます。そして、ノードが増えたらマッピングしたデータの一部を移動させます。この考え方を利用した、有名なところでは Redis などがあります。

- Overview of Redis Cluster main components | docs @ redis.io

「ハッシュ値」と「暗号」の関係

さて「ハッシュ化は暗号化ではない」とは言ったもののハッシュ値は暗号と密に関係しています。

これは、ハッシュ値は暗号データの担保情報としても使われるためです。

特に暗号通信においては「切っても切れない関係」にあります。公開鍵・秘密鍵暗号では、公開鍵を担保する情報としても使われるからです。他にも、後述しますが、お互いの秘密鍵を共有せずに相手の公開鍵から共通の鍵を作成する際にも、ハッシュ関数が活用されたりします。

【コラム】「公開鍵・秘密鍵暗号」とは

🐒 【余談】「公開鍵・秘密鍵暗号」とは

「公開鍵・秘密鍵暗号」(通称「公開鍵暗号」)とは、ペアとなる A と B の2つの鍵があり、片方の鍵で処理したものは、もう片方の鍵でしか逆処理できないタイプの暗号です。

つまり「片方の鍵で暗号化し、もう片方の鍵で復号する」、もしくは「片方の鍵で署名し、もう片方の鍵で検証する」タイプということです。

例えば、A 鍵 で暗号化したものは同じ A 鍵 では復号できません。ペアとなる B 鍵 でしか復号できません。また、その逆もしかりA 鍵 で署名したものは同じ A 鍵 では検証できません。ペアとなる B 鍵 でしか検証できません。

この特徴により、片方の鍵を公開しておき、その公開している鍵で相手に暗号化してもらえれば、もう片方の鍵を持つものでなければ復号できないデータが作れます。同様に、片方の鍵で署名しておけば、もう片方の公開している鍵で誰もが検証できます。

鍵を公開してるのに、安全に暗号通信やファイルのやりとりが行える魔法が使えます。鍵を公開してるのに、です。

ちなみに「鍵」とは、実質的に、いわゆるパスワードと同じ役割をするものです。ワード(単語)ではなく、覚えられないくらいの長い不規則な文字列、もしくはそれをファイルにしたものを「鍵」と呼びます。

そして一般的なパスワードとの違いは自分で決められるものではないことです。伝わるかわかりませんが、「復活の呪文」をファイルに落としたようなものです。(具体的な鍵の例 @ GitHub)

しかし、本質的には「〜のカギとなる」や「キーポイント」のように「重要な部分を引き出すもの」を「鍵key」(鍵)なども、「value」(価値)を引き出す同様の意味です。

そのため「鍵」という単語が出てきたら「暗号関連」と言う思い込みを捨てて「キー

さて、公開鍵・秘密鍵暗号で重要なのが A 鍵 と B 鍵 は「親」と「子」の関係になっていることです。「親の鍵」からは同じ「子の鍵」は何度でも作成できますが、その逆(子から親の鍵)は作成できません。

そのため「親」の鍵で暗号化したデータは同じ「親」の鍵では復号できませんが、復号に必要な「子」は作れてしまうということです。つまり、ユーザーは「親の鍵」さえ大切に保管しておけばよく、必要な時に「子の鍵」を作成し、外部に「子の鍵」を公開するのが一般的です。

このことから親の鍵を「秘密鍵」、子となる鍵を「公開鍵」と呼びます。秘密鍵は「シークレット・キー

注意点として、「秘密鍵」「公開鍵」は必ずしも暗号化・復号に使うための鍵を指すわけではありません。

「value」(価値)を引き出すのに必要な「key」(鍵)のうち、公開するものを「公開鍵」、公開してはいけないものを「秘密鍵」と言います。暗号化に使わないものでも、秘密鍵や公開鍵が存在します。例えば署名鍵などです。たまたま、暗号化に使う鍵も署名に使えるというだけです。

そのため、公開鍵暗号と「暗号」と言いながらも、片方の鍵で署名したものは、もう片方の鍵でしか検証ができないタイプの暗号(セキュリティ)技術も「公開鍵暗号」の 1 つです。

さて、俗に言う「データの暗号化」ですが、「公開鍵で暗号化」し「秘密鍵で復号する」といった説明の記事が多いのですが、暗号化自体はどちらの鍵でもできますし、反対の鍵で復号できます。アプリから見れば、鍵が違うだけで、やっていることは復号というだけです。

とは言え、自分の秘密鍵でデータを暗号化しても公開鍵が一般に公開されている以上、誰でも公開鍵で復号できてしまう時点で、セキュリティとしては「何の対策にもなっていない」と同義です。つまり、データサイズが無駄に大きい、素人にはオススメできないファイルができるだけです。そういった意味で「公開鍵で暗号化」し「秘密鍵で復号する」といった説明がされているのです。

それでは「公開鍵を一般公開せずに、安全な方法で相手に渡せば」という場合は、やっていることは共通鍵暗号と変わりません。つまり、共通鍵暗号を使った方が復号も速く、データも軽く済みます。

「この世の全てを、そこにおいてきた」と、秘密鍵で暗号化したお宝の公開鍵をどこかに隠しておき、ネットの海を航海させるような場合にしか効果はないでしょう。その場合であれば、共通鍵のように、お宝を入れ替えて同じ共通鍵で再暗号化されることはないからです。

不特定多数ではなく特定の相手であれば、もうひと工夫することでセキュリティ的な対策に変貌します。

それは、「二重に暗号化すること」です。つまり、自分の秘密鍵で暗号化したデータを、さらに相手の公開鍵で暗号化するのです。

これの何が「セキュリティ的な対策」になるかと言うと、相手は自身の秘密鍵で復号したのち、送信者の公開鍵でさらに復号することで、確実に 2 者間に限定した暗号データをやりとりできます。逆に、単純に「自分が保証したデータである」ことを公言(証明)したいのであれば、秘密鍵で署名する方が効果的でしょう。

さて、この2つの鍵(公開鍵と秘密鍵)ですが、一般的(?)な方法として素数の概念が活用されています。

例えば、自然数 15 を素因数分解すると 3 と 5 です。しかし、3 という数からは 15 はわかりません。3 の素数を持つ自然数(正確には合成数)は無限にあるからです。また、同様に 5 からも 15 はわかりませんが、3 と 5 からは 15 が簡単にわかったり、15 と 3 からは 5 が作成できるような考え方から、さらに工夫されています。もちろん他のアルゴリズムもあり、どれも難しすぎてわかりません。

しかし「公開鍵・秘密鍵暗号」は欠点も持っています。「大きなデータの暗号化が苦手」なのと「遅い」ことです。特に大きなデータを暗号化する場合は、データをチャンク(ぶつ切り)にしてから各々を個別に暗号化して 1 つにくっ付ける必要があり、復号も逆の手順が必要であるため結構なコストが発生します。サイズも必要以上に大きくなります。

逆に従来の1つのパスワード(鍵)で暗号化および復号できる暗号方式を「共通鍵暗号」と呼びます。決して「共通鍵暗号」がオワコンと言うわけではありません。

「共通鍵暗号」は強いアルゴリズムでも処理速度が速く、「公開鍵・秘密鍵暗号」と比べデータサイズが小さいという特徴があります。現在では、大きなファイルの復号や、復号に速度が求められる場合は「共通鍵暗号」で暗号化し、その共通鍵を「公開鍵・秘密鍵暗号でやりとりしておく」もしくは「お互いが相手の公開鍵と自身の秘密鍵から生成する」というハイブリッドな手法が多くとられます。

暗号の話し自体は、この記事のスコープ(範囲)から外れるため、興味を持たれた方は以下の記事が勉強になります。

- 2つの公開鍵暗号(公開鍵暗号の基礎知識) @ Qiita

さて、このハッシュ関数の「非可逆」な特徴は、一般的に「パスワードの保存」などに使われます。

「パスワードの管理」で、皆が通る道に「パスワードをどうやって保存するか」の葛藤があります。

ユーザーのパスワードを生で保存する(そのまま保存する)のはもってのほか。暗号化するにしても秘密鍵が漏洩したら全てのパスワードがわかってしまうため元も子もありません。また、各々のパスワードに対して秘密鍵を作成しても、秘密鍵の DB が漏洩したら同じことです。

しかし、管理側で求められるのは「ユーザーが事前に決めたパスワード」と「ログインで入力されたパスワード」が同じであるかの確認だけです。

「パスワードはサーバーに保存しておきたくない」、でも「パスワードが登録したものと同じか確認したい」という、覚えたくないけど答えられるようになりたい暗記パンみたいなワガママをハッシュ関数は実現します。

具体的には「パスワードをハッシュ化して保存する」ことで可能です。

パスワードが正しいかの確認はハッシュ値を比較すれば良く、「ハッシュ値が流出したとしても元のパスワードはわからない」だけでなく「管理者すら元のパスワードはわからない」といったメリットがあるからです。パスワード流出事件があると「自分たちでもわからない状態で保存されているから云々

このようなエンコード(特定のルールに従って変換)した値でやりとりする仕組み、つまりオリジナルを隠蔽したままの(デコードする必要のない)状態で、確認のやりとりをする仕組みを「一方向暗号」と呼んだりします。しかし、あくまでもハッシュ値を「暗号

しかし、単純にハッシュ化したからといって安心はできません。

まず、ハッシュ関数のアルゴリズムに CRC のようなチェックサム的アルゴリズムを使ってしまうと、簡単に衝突する(異なるパスワードなのに同じハッシュ値になりやすい)だけでなく、わざと衝突させて改竄する攻撃にまったく耐性がありません。

そのため、後述する salt(塩)を使ったテクニックも役に立ちません。しかし、CRC や checksum は改竄耐性がない以前に、そもそも用途が違います。

次に、「鳩の巣原理」という「鳩の巣箱が鳩の数より少ない場合は、必ず 1 つ以上の巣箱で衝突する鳩がいる」という原理があります。椅子取りゲーム的なものです。

つまり、ハッシュ値のビット長が短かいほど、同じ原理で衝突しやすくなります。

では「暗号学的ハッシュ関数など、ハッシュ値のビット長が長ければ安心か」と言うと、安心できません。

- 「誕生日のパラドックス」と呼ばれる、「意外に衝突する」というジレンマの問題。

- 暗号学的アルゴリズムであっても

MD5やSHA-1のように「合理的に衝突させる方法が見つかっているアルゴリズム」がある。

実は、上記以上の問題があります。

「引数が同じ場合は戻り値も同じ」という、もう1つのハッシュ関数の特徴により流出したデータがハッシュ化されていても意味をなさないことがあるからです。

具体的には、別途パスワード・リストなどがあった場合です。

なぜならパスワード・リストからパスワードをハッシュ化して同じ値を探せばいいからです。つまり「辞書攻撃が使える」ということにもなります。

例えば Folding@home で有名な、バークレー大学の BOINC を使った分散コンピューティングのプロジェクトの 1 つに "Free Rainbow Tables" というものがあります。

これは、注意喚起のために作成された、ハッシュ関数の逆引きを可能とする、数テラバイト規模の巨大な辞書(レインボーテーブル)です。

他にも、過去に流出したメールアドレスとパスワード、32 億件をアーカイブした COMB データなども存在し、その後の流出したものを含めると 150 億件以上のデータが検索可能となっています。つまり、全世界の人口(80億)の約 2 倍近くのパスワードが「表の世界」であっても確認できることになります。

例えば、この記事のサンプルに出てくる 34902903de8d4fee8e6afe868982f0dd(beef を MD5 でハッシュ化したもの)でも、筆者のショボいマシンでも 10 秒以内で総当たり解析できてしまいます。

HashCat を使って34902903de8d4fee8e6afe868982f0ddを解析する

HashCat はオープンソースのパスワード・リカバリー・ツールです。辞書ファイルを使った解析だけでなく、総当たりによる解析機能を持っています。

下部で 34902903de8d4fee8e6afe868982f0dd:beef と解析できていることに注目ください。

$ # 総当たり(-a 3)で MD5(-m 0)を解析する

$ time hashcat -a 3 -m 0 "34902903de8d4fee8e6afe868982f0dd"

hashcat (v6.2.6) starting

METAL API (Metal 263.9)

=======================

* Device #1: Intel(R) Iris(TM) Graphics 6100, skipped

OpenCL API (OpenCL 1.2 (Aug 17 2023 05:46:30)) - Platform #1 [Apple]

====================================================================

* Device #2: Intel(R) Core(TM) i5-5257U CPU @ 2.70GHz, 4064/8192 MB (1024 MB allocatable), 4MCU

* Device #3: Intel(R) Iris(TM) Graphics 6100, skipped

Minimum password length supported by kernel: 0

Maximum password length supported by kernel: 256

Hashes: 1 digests; 1 unique digests, 1 unique salts

Bitmaps: 16 bits, 65536 entries, 0x0000ffff mask, 262144 bytes, 5/13 rotates

Optimizers applied:

* Zero-Byte

* Early-Skip

* Not-Salted

* Not-Iterated

* Single-Hash

* Single-Salt

* Brute-Force

* Raw-Hash

ATTENTION! Pure (unoptimized) backend kernels selected.

Pure kernels can crack longer passwords, but drastically reduce performance.

If you want to switch to optimized kernels, append -O to your commandline.

See the above message to find out about the exact limits.

Watchdog: Temperature abort trigger set to 100c

Host memory required for this attack: 1 MB

The wordlist or mask that you are using is too small.

This means that hashcat cannot use the full parallel power of your device(s).

Unless you supply more work, your cracking speed will drop.

For tips on supplying more work, see: https://hashcat.net/faq/morework

Approaching final keyspace - workload adjusted.

Session..........: hashcat

Status...........: Exhausted

Hash.Mode........: 0 (MD5)

Hash.Target......: 34902903de8d4fee8e6afe868982f0dd

Time.Started.....: Sun Mar 24 15:29:11 2024 (0 secs)

Time.Estimated...: Sun Mar 24 15:29:11 2024 (0 secs)

Kernel.Feature...: Pure Kernel

Guess.Mask.......: ?1 [1]

Guess.Charset....: -1 ?l?d?u, -2 ?l?d, -3 ?l?d*!$@_, -4 Undefined

Guess.Queue......: 1/15 (6.67%)

Speed.#2.........: 313.1 kH/s (0.01ms) @ Accel:512 Loops:62 Thr:1 Vec:4

Recovered........: 0/1 (0.00%) Digests (total), 0/1 (0.00%) Digests (new)

Progress.........: 62/62 (100.00%)

Rejected.........: 0/62 (0.00%)

Restore.Point....: 1/1 (100.00%)

Restore.Sub.#2...: Salt:0 Amplifier:0-62 Iteration:0-62

Candidate.Engine.: Device Generator

Candidates.#2....: s -> X

Hardware.Mon.SMC.: Fan0: 42%

Hardware.Mon.#2..: Temp: 46c

**snip**

34902903de8d4fee8e6afe868982f0dd:beef

**snip**

Started: Sun Mar 24 15:29:04 2024

Stopped: Sun Mar 24 15:29:13 2024

real 0m9.168s

user 0m1.211s

sys 0m0.576s

それくらい、単純に「ハッシュ化しただけ」では安心できないものなのです。

ハッシュしただけでは味気ないので塩を足そう

さて、ハッシュ関数や暗号関数を触っていくと「salt」(ソルト、サルト🔈)という言葉が出てきます。日本語で「塩」のことですが、一般的に「ソルト」と記載されます。

コンピューターの世界で salt は、各々のデータに加えるランダムな数値や文字列のことを指します。先の例で言えば beef に加えた salt=1 です。

料理でいう「塩加減」のように「同じ具材でも塩の加減1つで味が変わるため、毎回調整が必要で加減も秘伝

これまでの例のように、salt の値は「データの前」もしくは「データの後ろ」につなげてハッシュ化する方法によく使われます。

$a = hash( 'md5', $data . $salt); // 後から塩を足す

$b = hash( 'md5', $salt . $data); // 先に塩を足す

data='beef'

salt='1'

# 先に塩を足す("1beef")

hash_prepend_salt=$(echo -n "${salt}${data}" | openssl md5)

echo $hash_prepend_salt; # b14ab03be97e0b8deb2fa930cfdd4f4a

# 後から塩を足す("beef1")

hash_append_salt=$(echo -n "${data}${salt}" | openssl md5)

echo $hash_append_salt; # 30017279d6a5bac241e764eeed261dd8

上記のように、salt を加えるとハッシュ値が変わるのは当然として、前後の salt を入れ替えるだけでもハッシュ結果が大きく異なります。

では、前に足すか、後ろに足すか、どちらのパターンが良いのでしょう。

塩は後から足そう

料理の場合、味を見て後から塩を足すのが基本であるように、単純に salt をデータに足す場合も、後から足すようにしましょう。

$a = hash( 'md5', $data . $salt); // 👍 ベター

$b = hash( 'md5', $salt . $data); // 👎 問題あり

これは、Length extension attack(「伸長攻撃」)と呼ばれるハッシュ値の衝突攻撃に弱いからです。

特に、MD5, SHA-1 や SHA-2 などの Merkle–Damgård と呼ばれる構造を使うハッシュ関数の場合についてまわります。発音は「マークル・ダンガード」のようです。ヒーロー・ロボットのような名前ですが、ブロック・チェーンに興味のある方は、この名前と salt を覚えておいてください。後から出てきます。

さて、この「伸長攻撃」攻撃を恐れずに短く説明すると以下の通りになると思います。

Y = hash( salt . X )のXとYがわかっている場合、saltの長さがわかればsaltが逆算できなくてもY = hash( salt . X . Z)の計算ができる。(.は文字列の結合子)そのため

Zに良しからぬ文字列を入れてYの値を同じにすることができる可能性がある。

- ソルトとハッシュ関数だけでパスワードをハッシュ化するのが微妙な理由 @ Qiita

- Length Extension Attack ツール "Hash Extender" @ GitHub

-

saltをsecret、Xをdata、Yをsignature、Zをappendに置き換えて README をご覧ください。 - このツールの作者のブログに詳しい計算方法が載っています。

Everything you need to know about hash length extension attacks @ SkullSecurity

-

逆に Y = hash( X . salt) と後に付け加える場合は、この攻撃を回避できます。「味付けは後から行う」(salt を加えるのは後)と覚えておきましょう。

塩だけでなく胡椒も足そう

この「salt」(塩)は基本的に個々のデータに加えるのですが、DB の場合、全体に加える「pepper」(胡椒)と呼ばれる値もあります。

例えば、下記はプレーンな(加工や手を加えていない素user1 と user2 のパスワードが同じです。

| ユーザ名 | パスワード |

|---|---|

| user1 | passw0rdA |

| user2 | passw0rdA |

上記だと流出時にバレバレなので、次のようにパスワードに塩・胡椒して味付けします。

$passwd_hashed = md5($passwd . $salt . $pepper);

ここでは可読性のために脆弱な MD5 を使いますが、パスワード保存に MD5 が使われることはありません。

DB の保存で考えると、定数に pepper='pepperA' と設定しておき、テーブルは以下のようなイメージになります。

| ユーザ名 | パスワード |

|---|---|

| user1 | 7915e17989dcbb1d2132c1d207ef9e1d |

| user2 | 5ee508cb664f91000826933e626cd5df |

| ユーザ名 | ソルト |

|---|---|

| user1 | saltA |

| user2 | saltB |

DB ファイル自体が流出したらテーブルをわけても同じことであるため、パスワードとソルトを同じテーブルに格納する場合もあります。どこに格納するかは運用の考え方しだいだと思います。

「ならば、ソルト値を別 DB に保存してリスク分散しなきゃ」と言った、沼にハマったのであれば、以下の記事を一読することをオススメします。

- ソルト付きハッシュのソルトはどこに保存するのが一般的か @ Qiita

さて、全体に胡椒を加える

pepper の定数が流出していなければ、流出した DB の salt 値からだけでは保存されたハッシュ値を算出するのは大変なので、2 つ目のブロックsalt 値はわかることになるので、pepper 値の算出は時間の問題となります。

このような事態の場合、まずは「ユーザー全員にパスワードを再設定をしてもらうこと」が最優先です。そこで、pepper 値を変えれば、すべての保存値と計算が合わなくなるので全体をロックできます。

この胡椒を効かせる方法は、アイデア次第で色々と使えます

ログイン時の cookie の ID などでも使われるテクニックで、不審なログインを複数ユーザーで検知した場合に、pepper 値を変えることで、全員を強制的に再ログインさせることができます。

他にも、定期的に pepper 値を変えて、その後「更新した・しない」でアクティブ・ユーザーを確認したり、アプリに興味のないユーザーをふるい

もちろん、スマホの OS のアップデートやセッションの期限切れによるものもありますが、「更新」という名において、いささかダークなパターンにも利用される可能性があるということです。

また、実際に salt や pepper 値を使う場合は以下のように、より複雑にシェイクします。

- "

saltA" などの単純な文字列でなくランダムな数値や文字列を使う - アルゴリズムを

sha256やsha512などのより複雑なアルゴリズムを使う -

hash('sha256', hash('sha256', $value))と二重・三重にハッシュ化させたりする(時に数万回)

🐒 3 番目のループですが「Key stretching」(ストレッチング)と呼ばれる「総当たり攻撃対策」の 1 つです。

一言で説明すると「1 回の処理に手間をかけさせる対策」です。

主にローカル(流出先)での「総当たり攻撃」の対策で、1 回ハッシュ値を算出するのに手間をかけさせることで、最終値を見つけるまでの時間を伸ばす(ストレッチする)と言う手法です。

例えば、平均して 1 秒かかるくらいに何度も(時に数万回も)ハッシュ関数に通した最終的なハッシュ値を保存して使います。

ログインなどの場合、これにより 1 回のログインに 1 秒かかるものの、総当たり攻撃時には 1 秒に 1 つしか確認できないということでもあります。これにより、攻撃の回数を劇的に減らせます。

他にも、サーバ側で行うストレッチングに「遅延」があります。

例えば、リクエストを受けてハッシュ値を確認する際のタイミングに、わざと sleep を入れて遅延させ、「リトライ回数の制限」と組み合わせることで 1 回の攻撃に手間をかけさせることで総当たり攻撃をし辛くさせます。

ログインなどで、成功するとサクッと入れるのに、間違えると「DB を総なめしてるのかな?」的に反応が遅くなるのを感じたことがあると思いますが、アレがストレッチングです。

この「ストレッチング」は、後述するブロック・チェーンにも「nonce 探索」として活用されています。

パスワード・ハッシュとは

さて、ここまではパスワードの保存に関する話がメインでした。

しかし、本記事はセキュリティのための記事ではありません。あくまでもハッシュ関数の基礎知識と「活用」に関する記事です(「結構、セキュリティ(暗号)の話しをしとるやないかい」と思うかもしれませんが、我々の世界でいう「HDD と SSD の説明と違い」を説明している程度の内容らしいです)。

「安全なパスワード保存」にハッシュ値を使いたいのであれば、パスワード管理専用の関数やフレームワークが各々のプログラム言語には数多くあります。一般的にハッシュ値をパスワード管理に特化したものを「パスワード・ハッシュ」と呼びます。

自分で実装するよりは、それらを利用した方が楽password_hash() という、まんま

先の「ストレッチング」のように「パスワード・ハッシュ」は計算のしづらさ(面倒くささ)に重点をおいているので、速度の速さと強度が重視される「ハッシュ関数」とは目的が違います。

2021/03/01 現在、最強のパスワード・ハッシュは Argon2 と思われます。2013 年から 2015 年にかけて行われた PCH というパスワード・ハッシュの競技会で優勝したのが Argon2 だからです。

Argon2 には、Argon2i と Argon2d の大きく 2 つあります。

Argon2i は、処理時間やハードの電圧など物理的に観察して情報を盗むサイドチャンネル攻撃に耐性があり、Argon2d は、GPU 攻撃(単純な計算の並列処理)に強い耐性があるアルゴリズムです。そして、両方を備えたアルゴリズムが Argon2id です。

例えば PHP 7.3 以降では両方に対応した PASSWORD_ARGON2ID が使えます。(オンラインで動作をみる @ paiza.IO)

また、Go の場合は golang.org/x/crypto/argon2 の公式パッケージが使えます。いささか使いづらいので、手前味噌ですが、使いやすくしたパッケージ "go-argonize" も用意しました。どのように使うのかの参考にしてみてください。

セキュリティの記事ではないとは言え、セキュリティが心配でハッシュ関数を勉強に来たという方は、かの Web セキュリティのバイブルとも言える「徳丸本」で有名な徳丸先生の Youtube 動画チャンネルを入り口とする(フォローする)ことをお勧めいたします。その上でバイブルの1冊くらいは持っておくと良いと思います。

ぶっちゃけ、こんなジャンクで基本的な内容の記事を読むより、先生の本や e ラーニングのコースを受講された方が実装の役に立ちます。

- 徳丸浩のウェブセキュリティ講座 @ Youtube

- 先生の e-ラーニングサービス @ Security Campus [説明動画]

- 徳丸本 「体系的に学ぶ 安全なWebアプリケーションの作り方 第2版」

〜脆弱性が生まれる原理と対策の実践〜- ISBN-10: 4797393165

- https://amazon.co.jp/dp/4797393165/ @ Amazon

- ここ 1 年の「徳丸本」に関する Qiita 記事 @ Google

これから使うなら SHA-3

パスワード以外のデータのハッシュ化に強いアルゴリズムが欲しいと悩んだら、とりあえずは「SHA3-512」を選ぶといいでしょう。次点で、SHA3-256 でしょう。OS やプログラム言語間で互換性が高い(汎用度が高い)中では、一番強いハッシュ・アルゴリズムだからです。(2020/10 現在)

ぶっちゃけ SHA-2 の SHA-256 や SHA-512 でも実用としては現状十分です。

しかし、SHA-2 は 20 年以上前のアルゴリズムであること、脆弱性(合理的な衝突方法)が発見されている SHA-1 の親戚であること、今後の演算力の向上により SHA-2 も時間の問題であることから、移行が推奨されていることを知る必要があります。

これから実装するのであれば SHA-1 や SHA-2 とはまったく違う概念のアルゴリズムで SHA-2 の後継と正式に制定された SHA-3 の利用を検討する価値はあると思います。

ここまでに SHA-1、SHA-2、SHA-3 といった「SHA なんとか」が、ちょいちょい出てきました。SHA(シャー)は "Secure Hash Algorithm" の略で NIST が作成・制定・推奨するハッシュ・アルゴリズム全般を指します。

例えば SHA-2 は SHA-224、SHA-256、SHA-384、SHA-512 の総称で、各々ハッシュ値の長さ(ビット長)のバリエーションを表しており、Merkle–Damgård 構造をベースに作成されたものです。

同様に SHA-3 も、ビット長ごとにバリエーション(SHA3-256 など)があり、 Keccak アルゴリズムをベースに作成されたものの総称です。SHA-3 には、任意の長さのハッシュ値を得られる SHAKE128 と SHAKE256 があり、128 や 256 はハッシュ値の長さではなく、その内部強度を表しています。

ちなみに NIST は、米国の国内標準規格の制定団体のことです。世界標準規格の ISO(そのうち日本語に訳され適用したものが JIS)が「製品やサービスの品質や安全性の向上を図るための規格」であるのに対し、NIST の規格は(冷戦時代に重要視された)「セキュリティと国土安全保障」が、より強く意識されています。

そのため、以前までは米国政府の安全保障局(NSA)が作成したアルゴリズムを制定していました。しかし、近年は「世界中の暗号学の研究者から安全性を高く評価された暗号技術」が選定されるようになったため、NIST 制定の暗号アルゴリズムやハッシュ・アルゴリズムは、インターネットの事実上の標準(デファクト・スタンダード)として使われています。つまり、RSA、AES、SHA といった NIST 制定のアルゴリズムは誰でも知ってるし、使えるという状況であるということです。

とは言え、強いアルゴリズムほど複雑さが増すため処理速度やレスポンスの問題も出て来ます。

どの程度複雑化させるのかも運用の考え方しだいになると思います。一旦強いもので組んでから、予算・運用コスト(計算コスト)・UX と相談しながら、測定しながら低い方へ検討してください。(「憶測するな、測定せよ」です)

いずれにしても、引数に $salt や $pepper およびハッシュ化のループ回数という、絶対公開しない要素加えることで予測を難しくさせているのです。

もちろん salt 値や pepper 値が流出してしまうと意味がありません。シオシオのパーです。つまり、秘密鍵と同じくらい扱いには気をつけないといけないので、「ハッシュ化しても安心できない」とわかると思います。

塩に工夫をして秘密の共通レシピを作ろう(簡易共通鍵の作り方)

さて、元のデータに秘伝salt 値を加えてハッシュ化することで、元のデータのハッシュ値を隠蔽

ここで、salt 値を「外部に公開してはいけない値」なおかつ「元の値を引き出す・特定するために使われる値」とすると、salt は秘密鍵

この salt 値を使った仕組みをさらに工夫すると、2 者間でお互いの秘伝salt 値から共通の salt 値を作成することができます。

つまり、俗に言う「共通鍵」のようなものが、お互いの秘密鍵

注意点として、このような使い方の値を salt とは呼びません。ここでのポイントは「お互いの秘伝

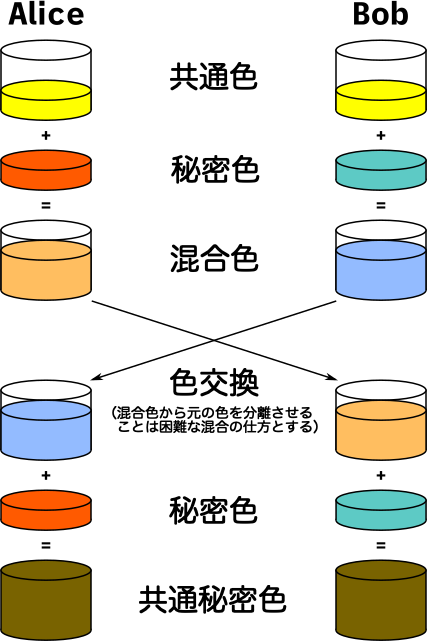

さて、基本的な仕組みですが、数式を使うと頭がチャンポンしちゃうので「色をチャンポンする」と例えると理解しやすかったです。

と言うのも、データに salt 値を加えてハッシュ関数でゴチャ混ぜにするというのは、別の見方をすると「とある色」に「俺様カラー」の絵具を混ぜるようなものとも言えます。

そこで「共通鍵の作り方の流れ」を、まずは色を使った概念図で全体を把握したいと思います。

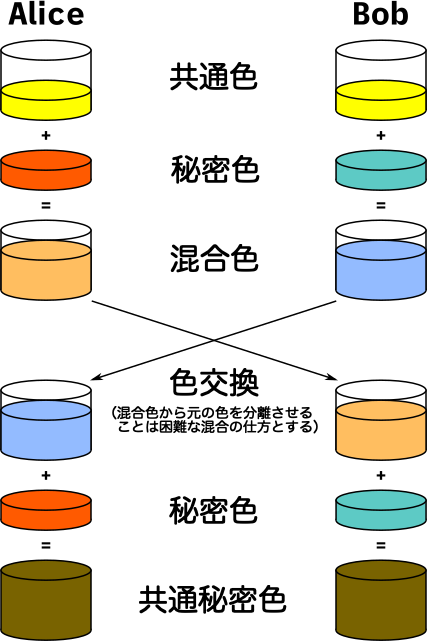

下図における「共通色」は Alice と Bob が事前に合意している色、「秘密色」は各々がランダムに選んだ色、と考えながら下の図を見てください。

ここでのポイントは「秘密色の交換をしていない」ことと、「色を混ぜているだけ」です。

|

|---|

| "Diffie–Hellman key exchange" @ 「ディフィー・ヘルマン鍵共有」の英語版 Wikipedia より筆者による日本語訳 |

色で概念を捉えたとは言え、コードで書かないと理解できないタイプなので、上記を Bash で再現してみました。

いささか分かりづらいですが、"yellow" "red" "green" の文字列を MD5 で数値化し、上記の図の通り足し算しているだけです。Alice.sh と Bob.sh がお互いの秘密色(xxxSecretColor)を参照(受け取って)いないことに注目してみてください。

- オンラインで動作を見る @ paiza.IO

鋭い人は「えー。でもお互いに同じ『共通色』を持っているんだから、『相手から受け取った混合色 - 共通色』と引き算すれば相手の秘密色がわかっちゃうじゃん」と気づくでしょう。

かく言う私は、自分で bash で実装してみて初めて気づきました。足し算でなく掛け算であっても同じです。割っちゃえばいいので。

上記図にある色交換のコメントで「混合色から元の色を分離させることは困難な混合の仕方とする」とあります。

つまり、2 つの値をゴニョゴニョと混ぜて 1 つの値を出すことを「色を混ぜる」と表現しているのですが、単純な足し算や足し算の連続(掛け算)は「分離させることが簡単な混合の仕方」ということになります。

では、色交換した値を自分の秘密色で hash(<色交換した相手の色> + <自分の秘密色>) のようにハッシュすれば良いかというとダメで、塩を前に足すか・後に足すかで大きく変わってしまうからです。

そこで再登場するのが割り算の余り。そう、mod(剰余、%)です。

X := (A * B) % Y // X から見ると、Y は予測できても、A と B の組み合わせは謎

つまり「割り算の余りからは、元の組み合わせを得ることは困難」という性質を使って「元の色(値)の組み合わせに分離させることは困難」という状況を作ります。そして B を秘密色、A と Y の 2 つを共通色とするのです。

ここで、アホみたいな話しですが「a * b は b * a と同じ結果になる」という算数を思い出してください。

そして、同様に下記の 2 つは同じ結果になります。

(a3)2 = (a * a * a) * (a * a * a) = a3*2 = a6(a2)3 = (a * a) * (a * a) * (a * a) = a2*3 = a6

これは数学的に表現すると (ax)y = (ay)x = axy, x = 3, y = 2 と表せます。落ち着いて見比べれば何てことないことを、短く表現しているだけです。

さて、この ax と ay を上記の色の概念図で交換される混合色とした場合、a が共通色、x と y が各々の秘密色とできそうです。

すると、各々算出する「共通秘密色」(共通の値 axy) は (ax)y と (ay)x と計算できそうです。

しかし、これでは(ただの掛け算なので)余りよろしくありません。

そこで両辺を同じ値 p で割った余りを出してみます。以下の 4つは同じ値になるのがおわかりでしょうか。

(ax)y % p(ay)x % paxy % payx % p

これで「共通秘密色」が流出しても、ax もしくは ay の算出は難しくなります。

つまり、a とペアになる値 p を用意し、この 2 つの値をセットで「共通色」(事前に合意している色)とできそうです。

この考え方、つまり「掛け算の順番を変えても同じ値になる」「掛け算の結果が同じなら、それをさらに同じ値で割っても余りは同じになる」が、共通の秘密鍵を作成する際の基本となります。

とは言え、上記で問題なのが「お互いが a と p を知っていること」です。

交換しあった混合色(ax もしくは ay)から相手の秘密色の値(x と y)は算出できてしまいます。受け取った混合色を、結果が 1 になるまで a で割った回数が相手の秘密色だからです。

なんか、振り出しに戻ってきてしまいました。

そこで、相手に渡す混合色を p で割った余りにしたらどうでしょう。

- 旧混合色 %

p= 新混合色ax % p = Xay % p = Y

これであれば、お互いが a と p を知っていても X や Y からは、秘密にしている x と y の色(値)の算出は劇的に難しくなります。

つまり、受け取った新しい混合色を各々は以下のように計算して、共通秘密色を算出することになります。

- 色交換後の共通秘密色の算出(新バージョン)

-

(Y)x % p = (ay % p)x % p= 共通秘密色 -

(X)y % p = (ax % p)y % p= 共通秘密色

-

果たして「割った余りを、さらに割った余り」が同じ値になるのでしょうか。

それでは、以上を踏まえて Alice と Bob の公開鍵を改めて作ってみましょう。今度は、足し算ではなく割り算の余り、つまり mod(剰余)を使ってみます。

まずは、Alice と Bob は秘密鍵として、各々ランダムな値を決めます。ここでは、わかりやすいように Alice の秘密鍵を a、Bob の秘密鍵を b とします。

a = 4 // Alice の秘密鍵(ランダムな値)

b = 3 // Bob の秘密鍵(ランダムな値)

次に、事前に合意している 2 つの値(共通色)として、g と p の値を決めます。変数なので、x と y にしてもいいのですが、気分です。なんか、みんなこの変数名を使いたがるので。

// 事前に合意した値(セットで共通色とする)

g = 5

p = 23

g と p の値ですが、本来はバカでかい素数を元に作られるのですが、わかりやすくするために 5 と 23 にします。

ちなみに、g は generator の略で乱数関数で言うところの seed 値的な役割をする値で素数です。p は prime(素数)の略です。ここでは「事前に合意している 2 つの定数 g と p がある。どうやら素数らしい」程度に考えておいてください。

それでは、まずは Alice の公開鍵(混合色、pubA)を作ってみましょう。

事前に合意している g と p を元に、自身の秘密鍵(a)を使って計算するのですが、計算方法は以下の通りです。g を a 回掛けて、p で割った余りを公開鍵としているだけです。

pubA = (g)a % p

同様に、Bob も公開鍵(混合色、pubB)を秘密鍵(b)を使って計算します。

pubB = (g)b % p

次に、各々が公開鍵を交換(相手の公開鍵を参照)して、秘密の共通鍵の計算をします(commonA と commonB)。計算式は以下の通り。

- Alice の計算

commonA = (pubB)a % p

- Bob の計算

commonB = (pubA)b % p

共通鍵の計算といっても、秘密鍵を作った際の g を相手の公開鍵と入れ替えただけです。見比べてみてください。

それでは、実際に代入して(a = 4, b = 3, g = 5, p = 23 で)計算してみましょう。すると、共通の秘密鍵は同じ値になります。

- 公開鍵(混合色)の計算

-

pubA=(g)a % p=54 mod 23=4... Alice の公開鍵 -

pubB=(g)b % p=53 mod 23=10... Bob の公開鍵

-

- 共通秘密鍵の計算

-

commonA=(pubB)a % p=104 mod 23=18... Alice の共通秘密鍵 -

commonB=(pubA)b % p=43 mod 23=18... Bob の共通秘密鍵

-

なんと、割り算の余り(公開鍵)を、さらに割り算すると、余り(共通鍵)が同じになりました。(オンラインで動作を見る @ paiza.IO)

なぜ同じになるのかというと、剰余(modulo)には面白い性質があって、g と p が素数の場合、ある条件下において (ga % p)b % p は gab % p と同じになる性質があります。

-

(ga mod p)b mod p=gab mod p

試しに (54 mod 23)3 mod 23 と 5(4*3) mod 23 が同じ答えになるか試してみてください。

これは y = x mod p の場合、つまり x を p で割った余りの y は 0〜(p-1) の間を循環するという剰余の性質と、1 と自分自身以外では割り切れない素数の性質を利用していて、ぐるりと巡りに巡って同じになるような感じです。

ここで注目して欲しいのは、上記の証明や条件の詳細ではなく、以下の点です。

- 公開鍵は

ga mod pと、余りを使っているためaを特定することは難しい。 -

pとgが素数の場合、ある条件下において以下が成り立つ。-

(ga mod p)b mod pという計算は、gab mod pの計算と同じ結果になる。 -

(gb mod p)a mod pという計算は、gba mod pの計算と同じ結果になる。 -

gab mod pは、gba mod pと同じこと。

-

条件が気になっちゃう人に説明すると、(ga)b = gabという「べき乗の法則」と、p が素数、g が p 以下の整数で p の原始根の場合に上記が成り立ちます。

以上を踏まえて、改めて図を見てください。混合色を「割り算の余り」を使うことで、色を分離できない状態にしているのが面白いと感じませんか?

|

|---|

| "Diffie–Hellman key exchange" @ 「ディフィー・ヘルマン鍵共有」の英語版 Wikipedia より筆者による日本語訳 |

この、混合色を交換して共通の秘密色を生成する概念を「ディフィー・ヘルマン鍵共有」(DH)と言います。

色交換に使われる混合色の作成は、今回のような mod を使ったもの以外にも、方程式(曲線)を使ったもの(ECDH)などがあります。

ECDH の基本概念をザクっと説明すると、事前に共通色となる方程式を決めておき、秘密鍵と公開鍵を方程式に掛け算した座標を交換しあうことで、お互いの線が交差する点を共通秘密鍵の値とするものです。

先の MOD(余剰、%)を使った方法のポイントは、割り算の余りを使い「組み合わせを無限にした」ことで、色交換する際の混合色、つまり「元の組み合わせに分解できない状態」にしたことです。

そこで、2 つの点があれば直線が引けることを思い出してください。そこから、導き出された方程式(y=ax+b)を相手に渡しても、最初の 2 つの点は相手にはわかりません。

また、2 つの点のうち 1 つを共有しても、その方程式(もしくは傾き)からは 2 つ目の点はわからないため、受け取った相手は元の組み合わせはわからない(混合色から共通色と秘密色には分解できない)という状況が作れます。

そして、お互いが交換した方程式(or 傾き)が交差する点を共通点(共通秘密色)とすることができます。

このような考え方を、直線ではなく楕円曲線(EC、Elliptic Curve)を使ったものが ECDH です。

以下は Go 言語ですが、オンラインで動作が見れます。

-

オンラインで Go の ECDH による秘密鍵共有の動作を見る @ GoPlayground

- 参考文献:【Golang】ECDH 公開鍵から DH 鍵交換で共通鍵を作成する(ディフィー・ヘルマン鍵共有) @ Wiita