「データ分析の工数を削減したいが、スクリプト作成や前処理に時間が取られすぎている」

「ChatGPTやClaudeをどう実務に組み込めば、最も効率的にインサイトを導き出せるのか?」

データ利活用の現場において、生成AIは単なる補助を越え、分析の「実行エンジン」としての地位を確立しています。

今回は弊社ブログで公開した**「生成AIによるデータ分析の徹底解説」**から、技術・実務の視点で再構成した要点をシェアします。

1. 結論:生成AIによってデータ分析ワークフローはどう進化するか?

従来の手法ではコードの記述やツールの習熟に多大な時間を要していましたが、生成AIの台頭により分析のパラダイムは以下のようにシフトしています。

- 実装から論理構築へのシフト: Pythonや統計知識を補完することで、シンタックスの記述ではなく「どのような問いを立てるか」というロジックの構築に集中できるようになります。

- データクレンジングの自律化: 欠損値処理や正規化といった煩雑な前処理をAIが自動実行し、分析可能な状態へ数分で移行させることが可能です。

- 非連続なパターンの抽出: 人間のバイアスに依存しない客観的な視点でデータを多角的にスキャンし、隠れた相関関係や異常値を迅速に特定します。

2. 実務で使い分けるべき「主要ツール」の技術的アドバンテージ

本編記事では、データ分析に特化した3つの主要LLMについて、その技術的特性とユースケースを詳しく掘り下げています。

- ChatGPT (Advanced Data Analysis): 内部でPythonを動的に生成・実行するサンドボックス環境(ADA)が強力で、複雑な数値計算やライブラリを用いた可視化において高い信頼性を持ちます。

- Claude 3シリーズ: 大規模なコンテキストウィンドウと論理推論能力に優れ、複雑なドキュメントからのデータ抽出や、構造化されていない情報からの深い考察を得意とします。

- Google Gemini: GoogleスプレッドシートやBigQueryといったGoogleエコシステムとのシームレスな統合が可能で、チーム開発におけるデータ共有と連携のハブとして機能します。

3. 実践者の視点:成果を最大化する「指示の解像度」

AIを高度な「データアナリスト」として機能させるためには、精度の高いプロンプトエンジニアリングが不可欠です。

単に「分析して」と指示するのではなく、**「特定の役割の定義」と「コンテキストの明示」がアウトプットの質を左右します。

例えば、「専門的なマーケティングアナリスト」としてのペルソナを与え、分析の最終目的を明確に設定することで、単なる計算結果ではない「次に打つべき施策」に繋がる示唆が得られます。本編記事では、この記事の「精度を劇的に向上させるプロンプトのテクニック」**についても具体的に紹介しています。

4. まとめ・さらに詳しく知りたい方へ

元記事では、実売データを用いた売上分析やアンケートのテキストマイニングなど、実務に即した具体的な活用事例やステップバイステップのガイドを網羅しています。

よりテクニカルな詳細や、実装に役立つプロンプト例を確認したい方は、ぜひ本編をご覧ください。

最後に:データの整備からAI活用まで丸投げできる「DATA VOX」

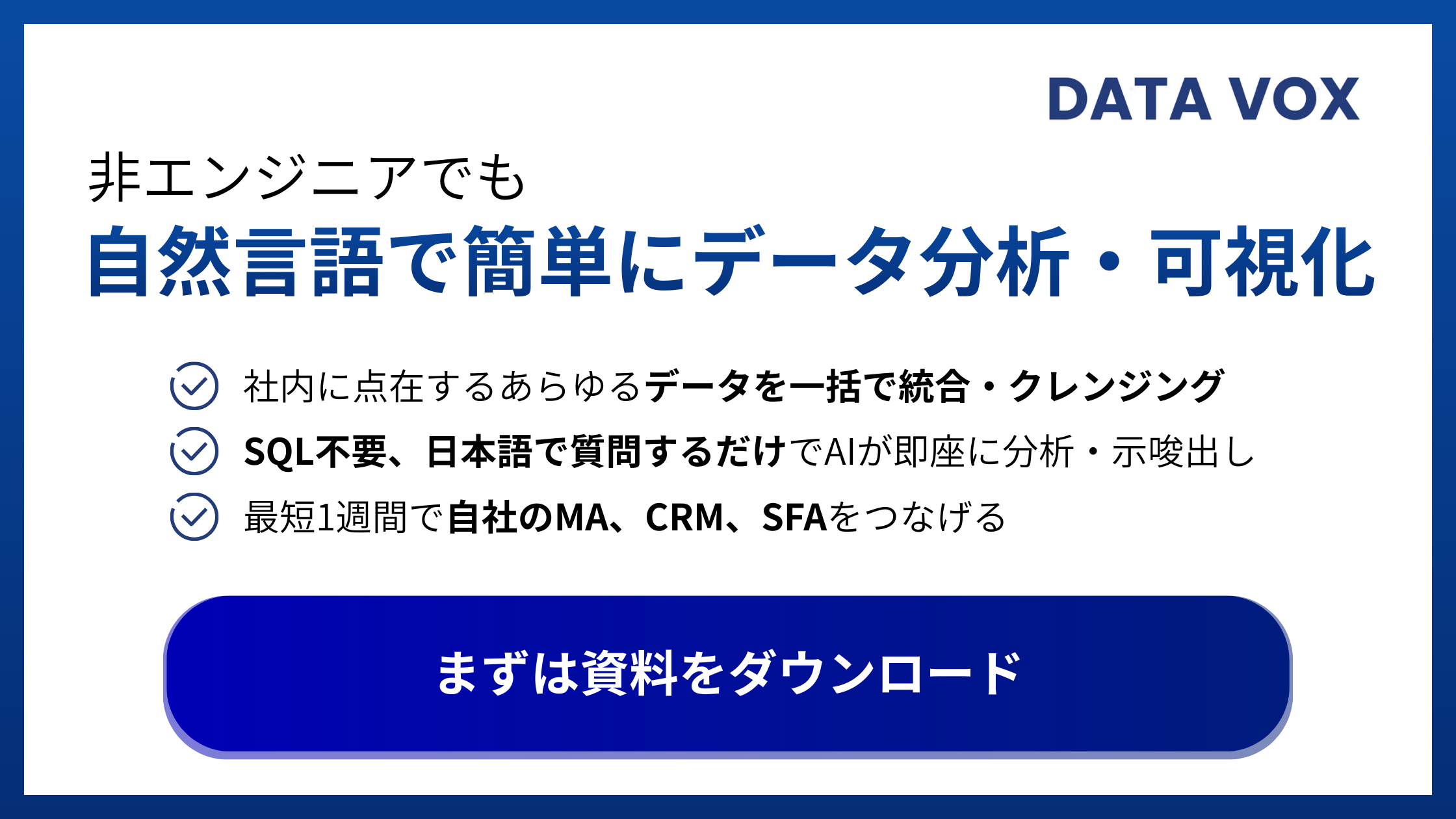

AI活用の基盤が整っていない、あるいは社内データの散在によりAIのポテンシャルを引き出せていない企業様には、AIデータ分析基盤**「DATA VOX(データボックス)」**が力になります。

「社内にデータが散らばっていて整理がつかない」「何から手を付けるべきか見当もつかない」という段階でも、全く問題ありません。煩雑なデータクレンジングや基盤構築から私たちが一括して代行し、貴社のデータドリブンな意思決定を最短距離で支えます。