続編更新しました:機械学習モデルとScratchを連携! TM拡張機能使ってみた

LEGOMindsotrms × Scratch:ScratchでLEGO Mindstormsを動かしてみる

以前とある子供向けScratchのワークショップが面白そうだったので、見学させて頂いたことがある。お題目は「機械学習×スクラッチで、どこにもないアプリを作ろう」で、画像認識ができる拡張機能を使ったワークショップだった。それがなかなかおもしろかったので、備忘録として「使ってみた」を以下に書いていきたいと思う。

ML2Scratch

Scratchについては今回は説明を省略する。

今回利用する拡張機能であるML2ScratchはPCに接続されたカメラから画像を取得してラベル付け、学習を行い、画像認識を行う。そこにScratch特有のGUIプログラミングを織り交ぜることができるものになっている。

準備

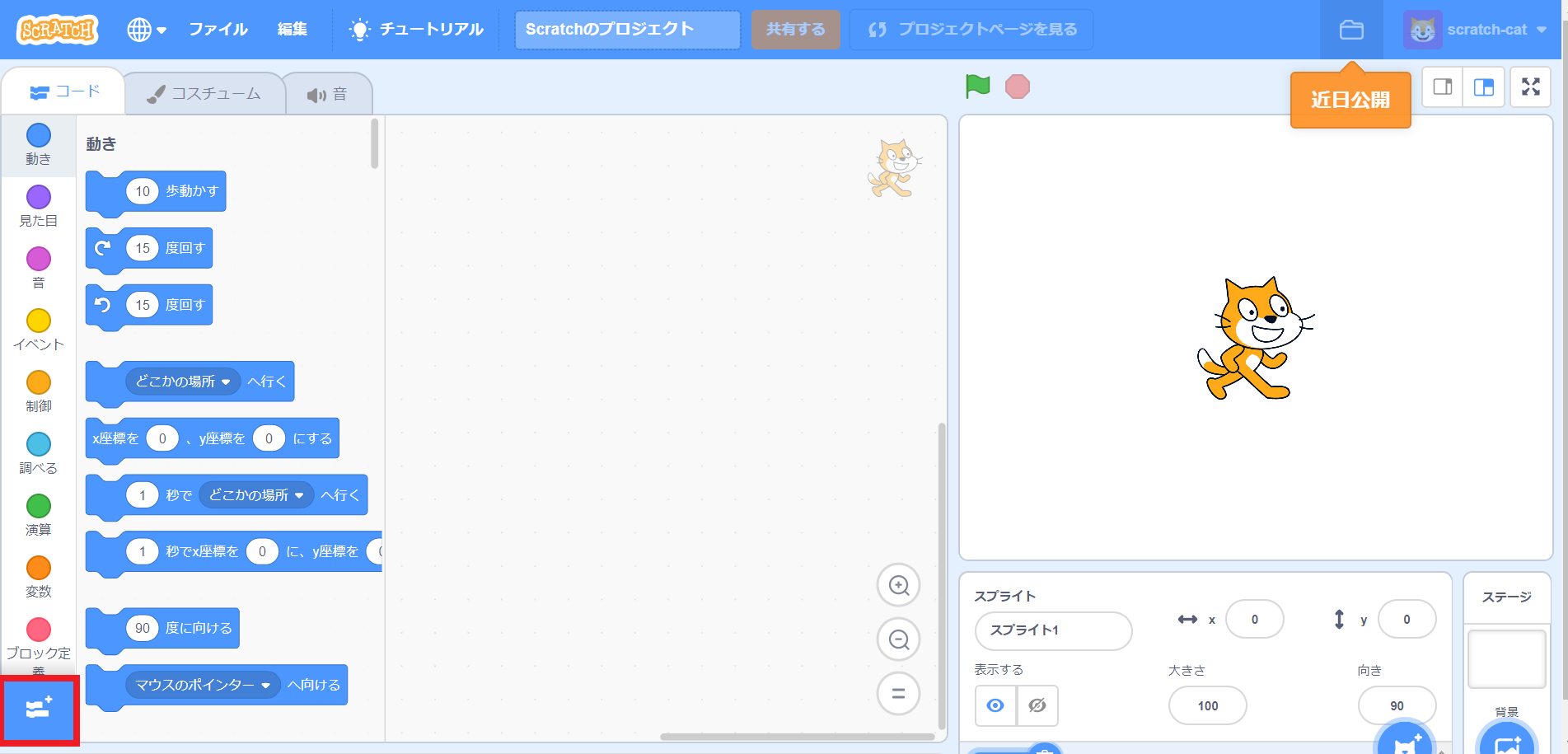

Chromeブラウザで、ML2Scratchを使えるようにカスタマイズされたScratchにアクセスする

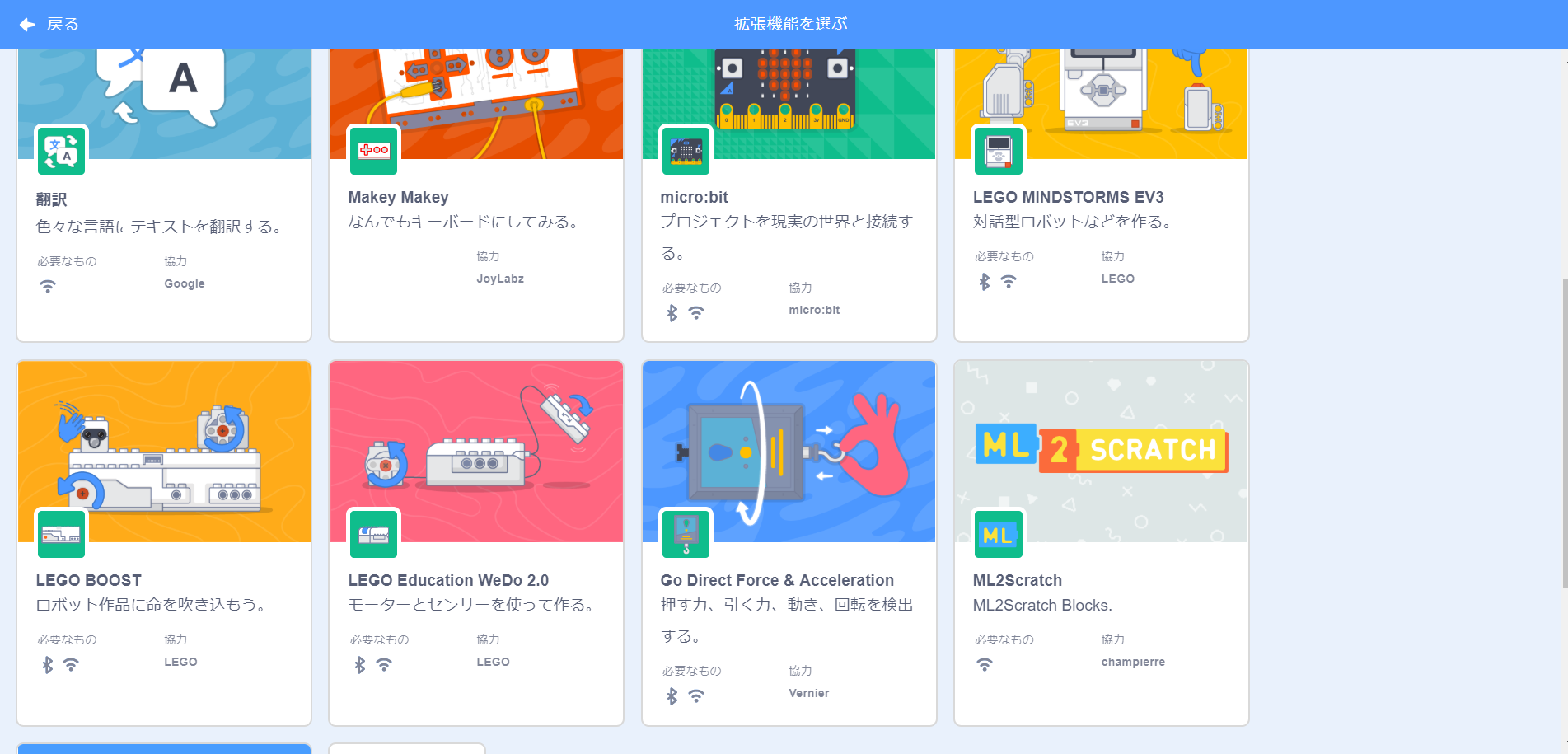

ML2Scratchを選択する(EV3を動かす拡張機能もあるよ!ステマ)

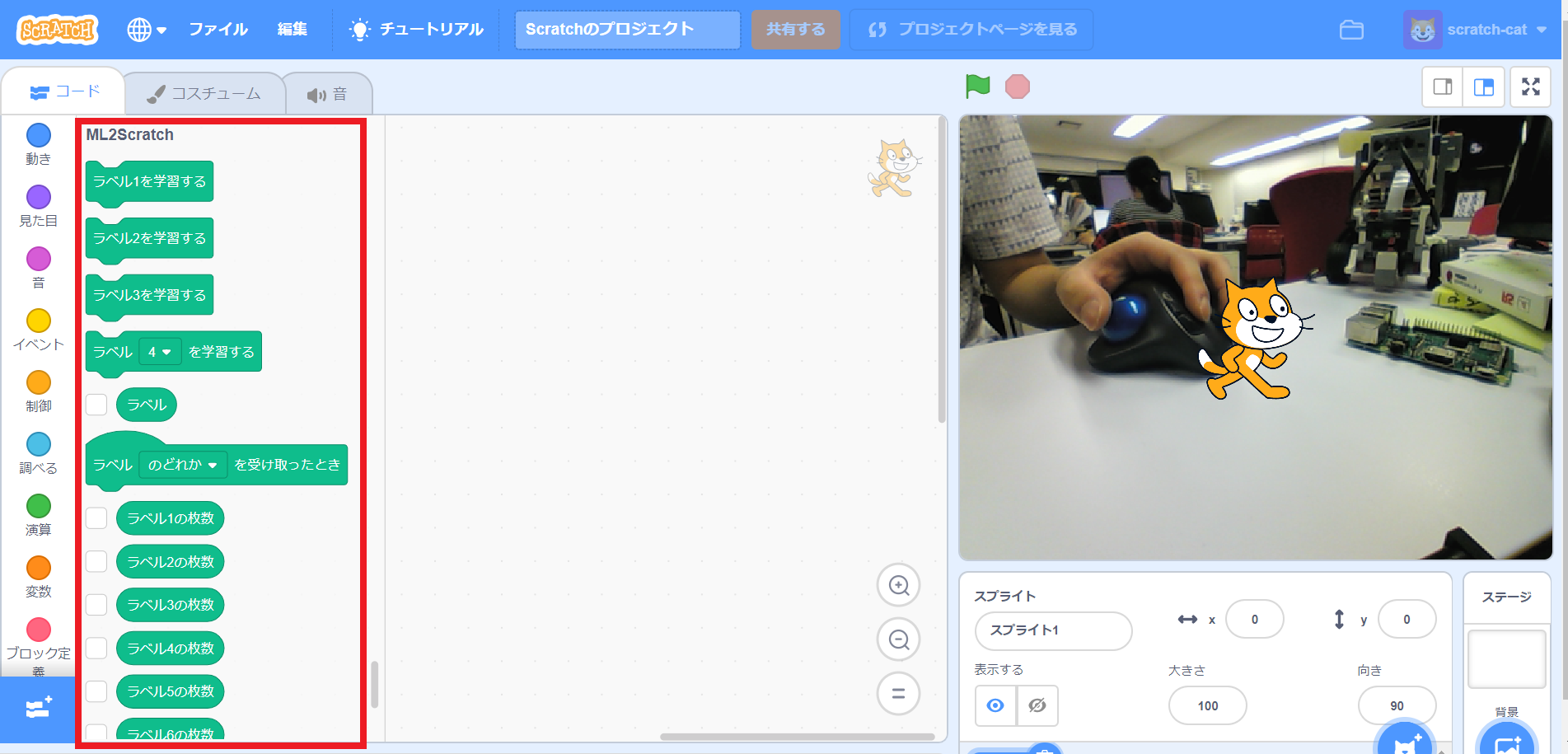

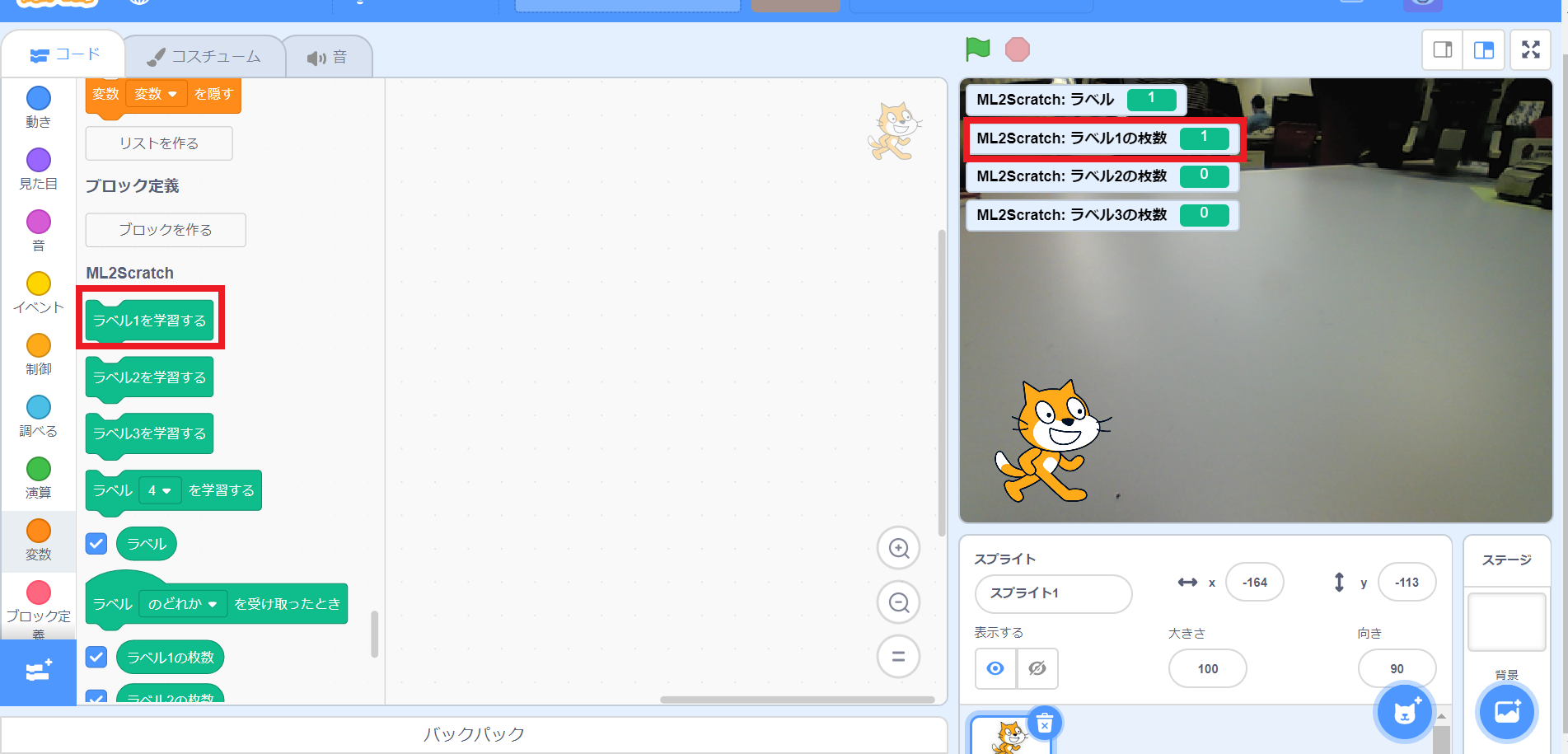

以下のように拡張ブロックが追加され、PCに接続されているカメラ画像が右側の実行画面に映される

ラベル 、ラベル1の枚数、ラベル2の枚数、ラベル3の枚数ブロックの横のチェックボックスにチェックを入れて実行画面に表示する

これで学習前の準備は整った!

カメラ画像の学習

ここからカメラ画像を収集して学習させていくわけだが、やり方はとっても簡単だった。小学生でも1回教えてもらえば扱えるレベルまで落とし込まれている。

以下が今回作るモノについてだ。

- なにも写っていない時、ラズパイが写っている時、SDカードが写っている時を認識させる

- 上記の3パターン時にそれぞれネコが吹き出しでコメントする

では、さっそく画像の学習を行なっていく。

まずは、なにも写っていない状態を学習させるので、カメラ前方はそのままにして、ラベル1を学習するブロックをクリックする。この操作で「何もない風景」をラベル1として撮影し学習させる。

目安としては20回程度学習させるのが良いらしい。撮影回数は実行画面のラベル1の枚数として表示されている。(このためのチェックボックスだったのだ)

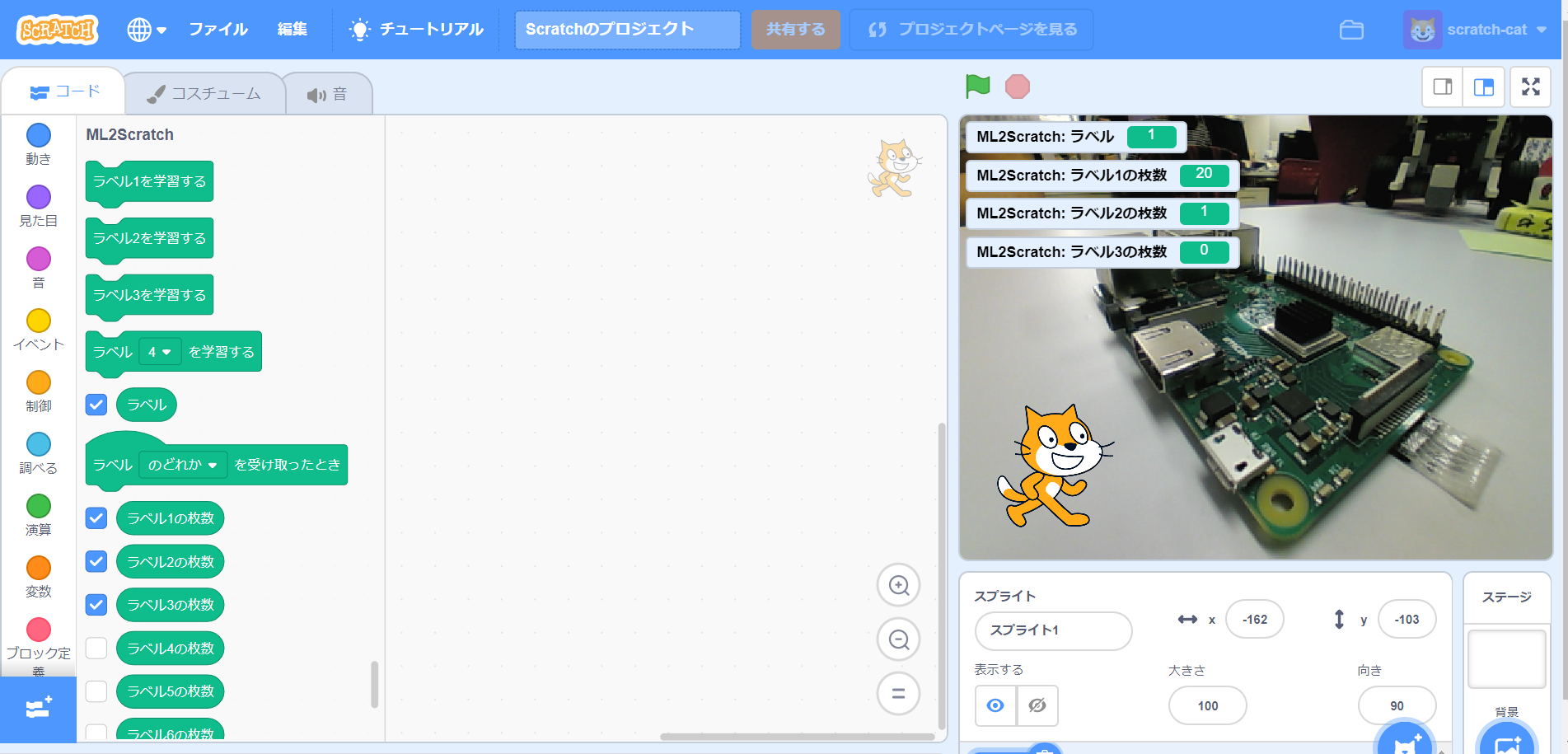

次に「ラズパイ(RaspberyPi)」をカメラに映し、同様にラベル2の枚数が20になるまでラベル2を学習するブロックをクリックする。この際、ラズパイなどモノはいろいろな位置に動かして撮影すると認識率が向上する。

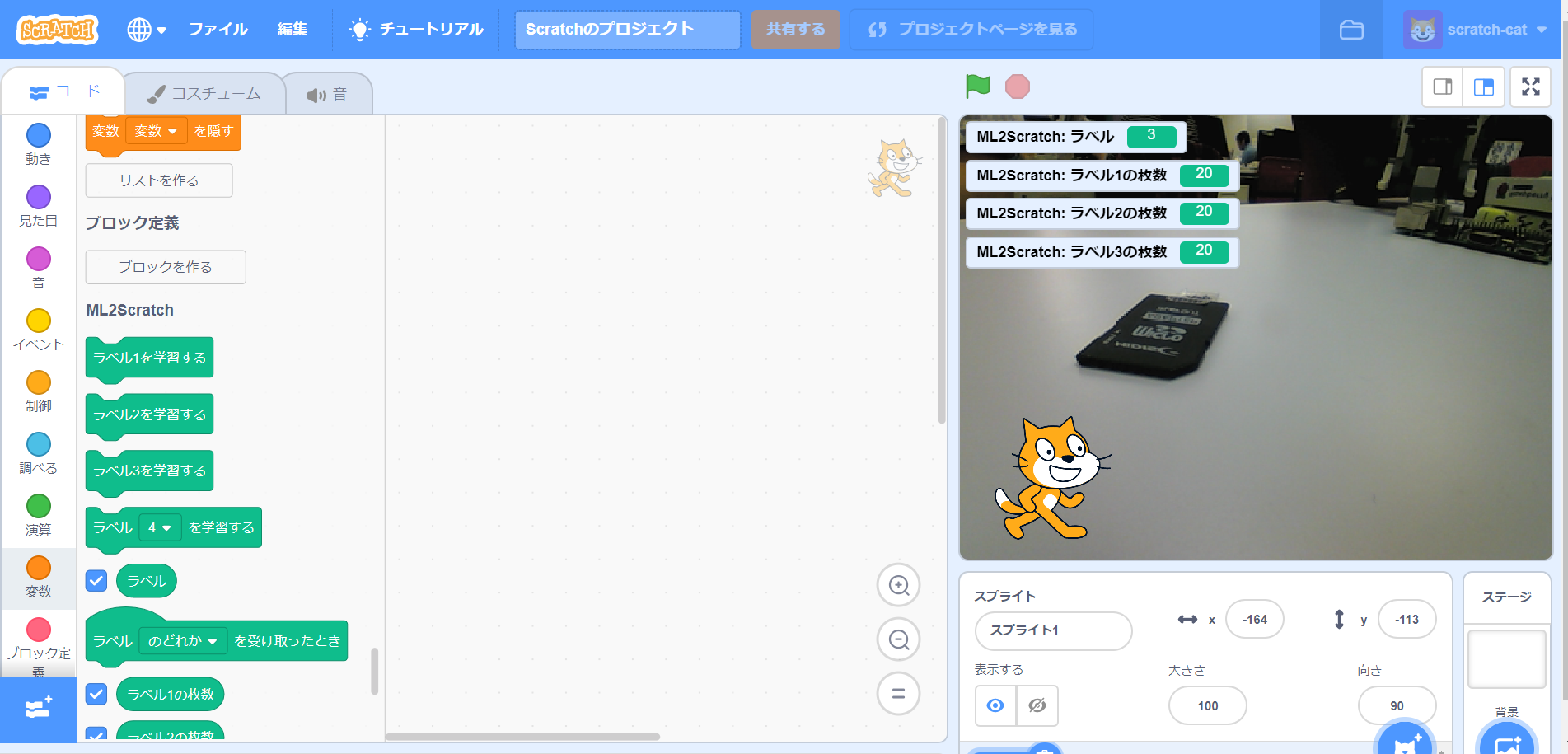

上記と同様に「SDカード」をカメラに映して、ラベル3の枚数が20になるまでラベル3を学習するをクリックしていく。

たったこれだけで学習が完了する。

カメラ映像からの認識

学習を行うと実行画面のラベルの数字が各状況に合わせて変動するのがわかる。何も映していない時は「1」、ラズパイを映している時は「2」、SDカードを映しているときは「3」と表示して各状況を識別しているのがわかる。

各状況に合わせてネコにコメントさせるためにラベルのどれかを受け取ったときを配置し、どれかを1~3に変更し、ネコがコメントするブロックをそれぞれ配置する。プログラムをみるとわかるが、それぞれ

- なにも映していないときは「なにもねえ・・・」

- ラズパイを映しているときは「ラズパイがあるぞぉ」

- SDカードを映しているときは「こいつぁSDカードって言うんだぜ」

と言うように設定。

まとめ

いい感じに学習部分をブラックボックス化できていて、かなり小学生でも使いやすい感じになっている。見学させて頂いたワークショップでも画像認識でキャラクターを動かしたり、音楽を流したり様々な工夫が見られた。

拡張ブロックの中身としてはTensorFlow.jsを用いて実装されている。開発者の石原氏がGitHubにソースコードを公開しているので、興味があれば確認してほしい。

次回:ScratchでLEGO® MINDSTORMS EV3を動かしてみる

追記

(2020/08/03)

ML2Scratch開発者の石原さん著書の「Scratchではじめる機械学習」が発売されました。

本拡張機能を使った作例はもちろん、Scratchの標準機能単体での機械学習実装まで掲載されていますので気になった方はぜひチェックしてみてください。