前回:ScratchでLEGO Mindstormsを動かしてみる

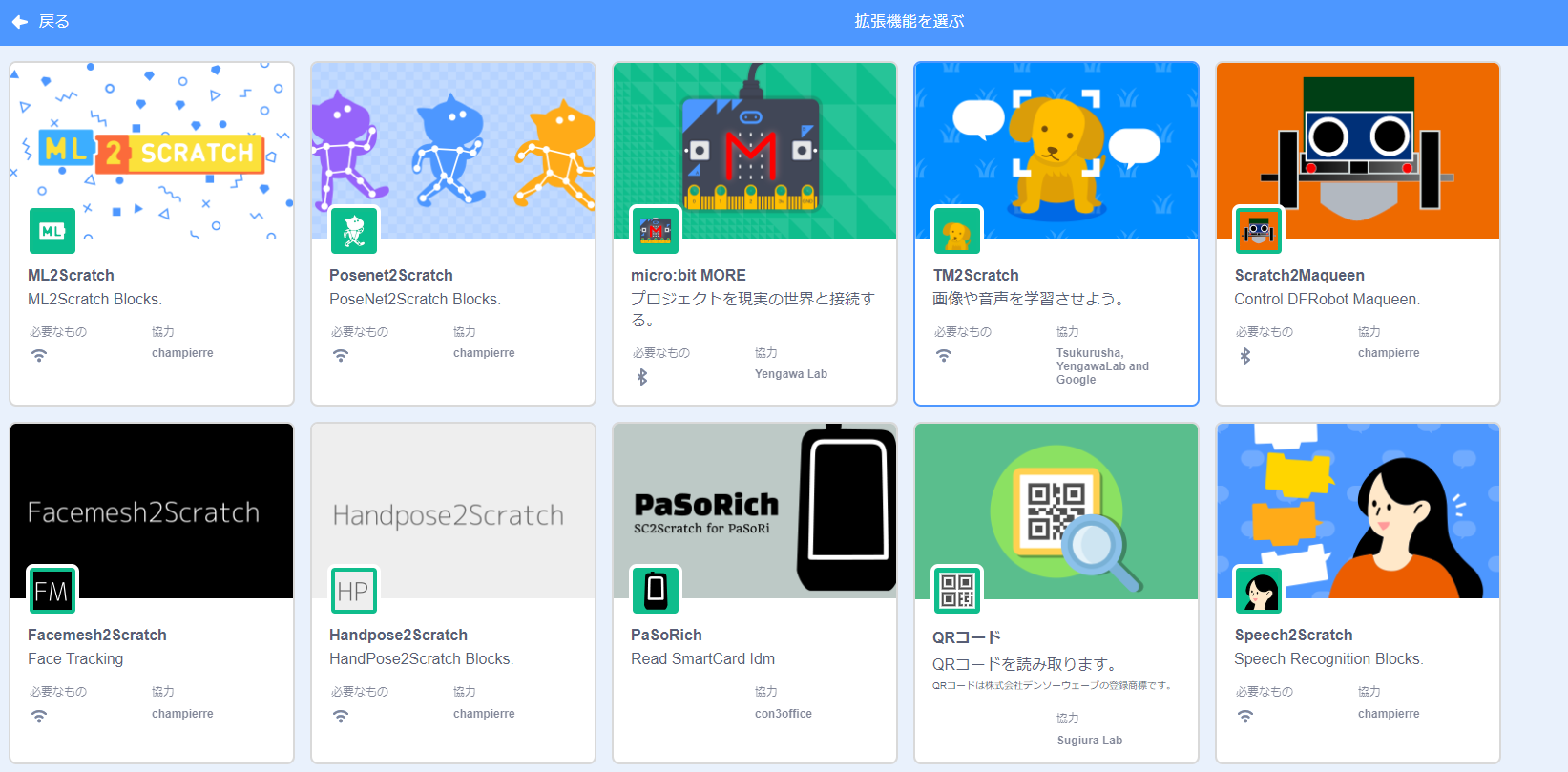

前回に引き続いて今回もScratch上でできる機械学習を試してみる。ビジュアルプログラミング(Scratch)の拡張機能として、TM2Scratchというものを使ってみた。

以前投稿した記事で紹介したML2Scratchの開発者と同じ方が作成された拡張機能で簡単かつ様々なものを認識・識別できるような学習を施すことができる。

TM2Scratch

今回利用する拡張機能であるTM2ScratchはTeachableMachine2.0を利用して、簡単に画像認識や音声認識のモデルを生成し、その生成したモデルをScratch上に反映してプログラム内で利用できるといういうものだ。今回は以下のことをしていく。

- TeachableMachine2.0上で機械学習モデルを作成する

- カスタマイズされたScratch3.0を使って、上記の機械学習モデルを読み込んでプログラミングをする

言葉で並べても伝わりづらいと思うので、一つずつ説明していく。

TeachableMachine2.0

- PCのカメラやマイク、画像データなどを使用して、WEB上のGUI操作で機械学習モデルを作ることができる

(プログラミング不要) - 作成したモデルの出来具合をすぐ確認することができる

- 作成したモデルをエクスポートしプログラムに利用することができる

- 現時点では画像分類・音声識別・ポーズ認識のモデルを作成することが可能

モデル作成

- TeachableMachine2.0上で機械学習モデルを作成する

ではさっそくTeachableMachineでモデルを作成していく。

ML2Scratchでは画像分類を行ったので今回は音声識別のモデルを作成していくことにする。

TeachableMachine2.0のサイトにアクセスする。

アクセスしたら「使ってみる」をクリックする。

画像、音声、ポーズからどの学習モデルを作るか選択する。

今回は音声を選択する。

今回は以下のような音を識別させる。

- 手のひらをパーで叩いた音

- 手のひらをグーで叩いた音

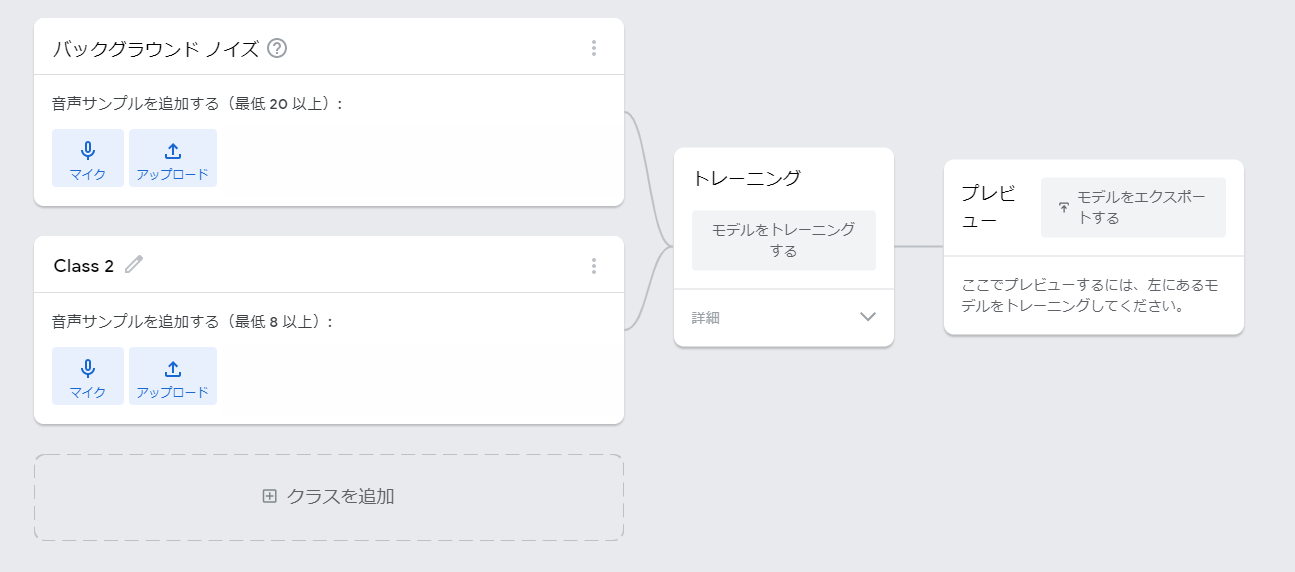

以下のように、いくつかの音声サンプルを追加する画面が表示されるので、

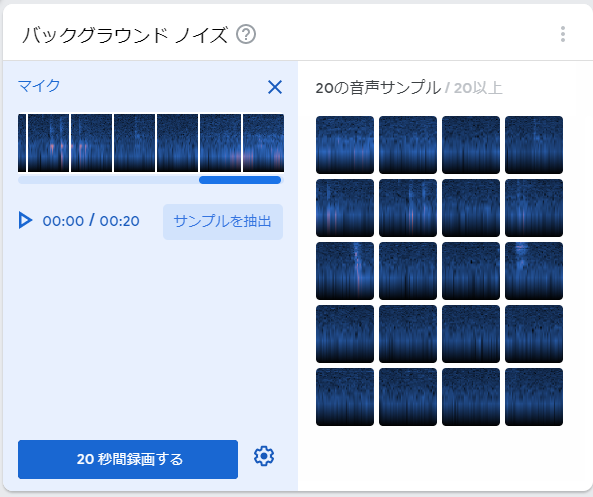

まずはバックグラウンドノイズのデータを採取する。

「マイク」を選択するとPCのマイクを利用して音声を集めることが出来る。

バックグラウンドノイズなので特に音を発したりはせず自然な音のみを収録する。

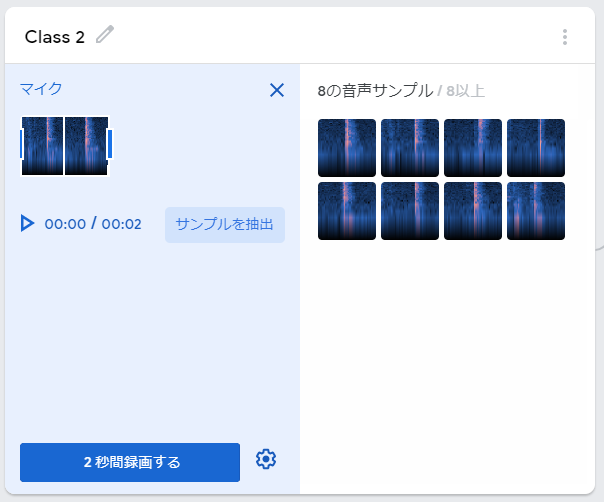

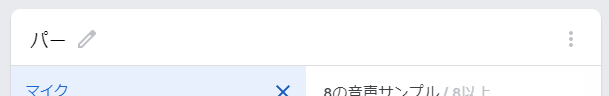

続いて「Class2」に「手のひらをパーで叩いた音」のデータを収録する。

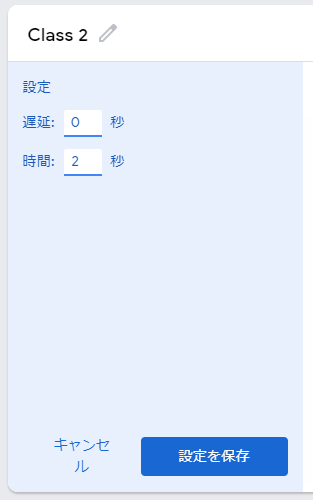

歯車マークから採取するデータに合わせて収録開始のタイミングや、全体の収録時間を設定することができる。

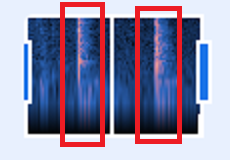

TeachableMachineでの音声の収録では毎秒ごとに区切って学習データとするので、収録時間は2秒とし、1回の収録で1秒毎に1回手を叩いて収録し合計8サンプルになるよう4回繰り返し収録した。

右の画像から2秒間で2回叩いて音を出しているのがわかる。

音声データの収録が完了した「Classe2」の名前をパーに変更しておく。

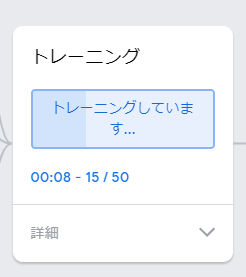

集めたデータを利用して学習モデルを生成していく。「モデルをトレーニングする」を選択して訓練を開始する。

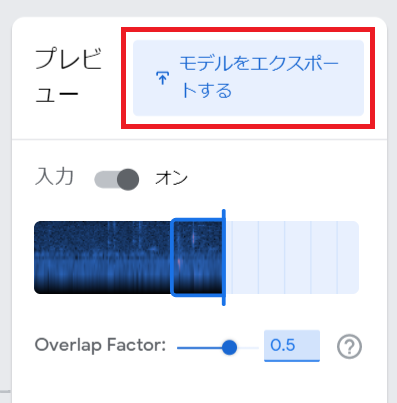

しばらく待ち、訓練が完了するとTeachableMachine上でモデルの動作を確認することができる。まずはここで収録した音声を認識できているか確認する。以下では収録時と同じようにパーで叩くかグーで叩いているがスライダーが認識度合いを表現しているのがわかる。

イメージとしてはペチンという音と、ゴチッという音で認識させるには少し微妙な題材かとも思っていたが思ったよりも認識できている。

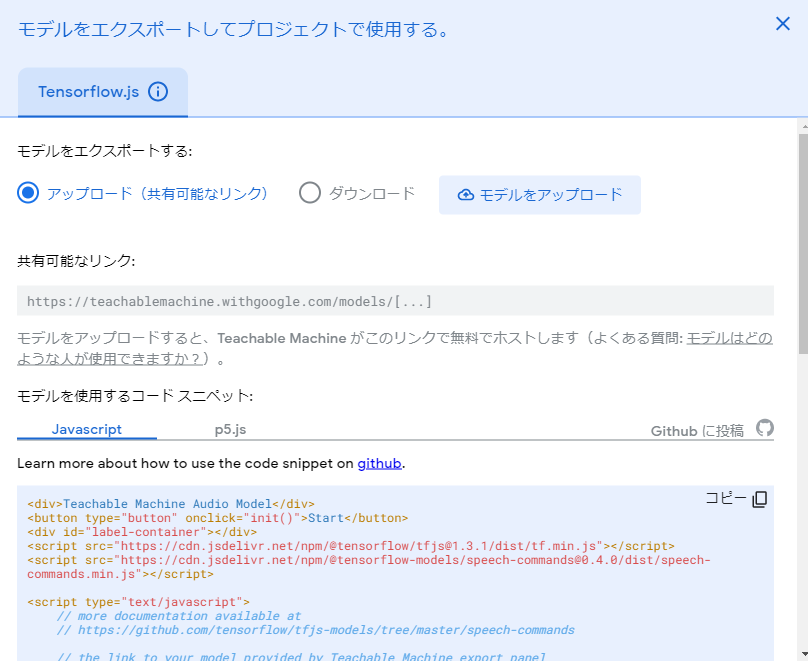

以下のような画面が表示されるので、今回はURL(リンク)を利用する。メモ帳などにコピーしておくと良いだろう。

これでモデルの作成は完了したので、続いてScratchで作業をしていく。

TM2Scratchを使って音声認識プログラムを作る

2.カスタマイズされたScratch3.0を使って、上記の機械学習モデルを読み込んでプログラミングをする

まずは、カスタマイズされたScratchをChrome上で開く。この際カメラやマイクの使用を許可するか選択できるので、必要に応じて許可をする必要がある。

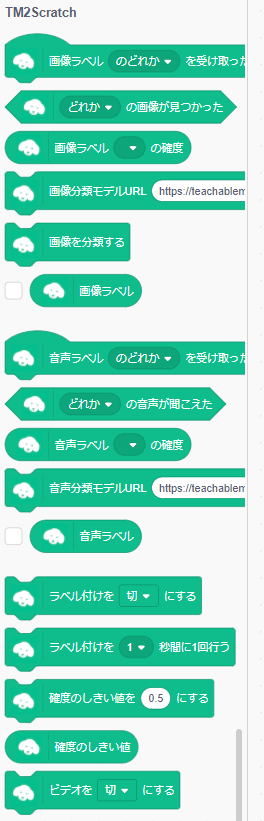

拡張機能追加から「TM2Scratch」を選択してブロックを追加する。

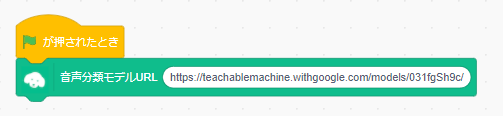

追加されたブロックを利用してまずは以下のようなプログラムを作る。

「音声分類モデルURL」ブロックの空白部分には先程メモしておいたURLを貼り付ける。

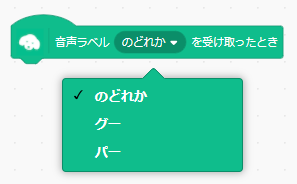

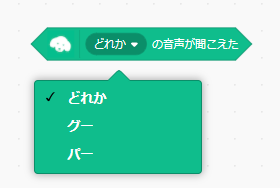

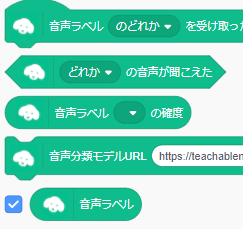

旗マークをクリックすることで以下のブロックに先程収録する際に作成したclasse名が選択できるようになる。

(今回ではパーやグー)

Scratch上で現在どの音を認識しているのか表示させるために「音声ラベル」の横のチェックボックスにチェックを入れておく。

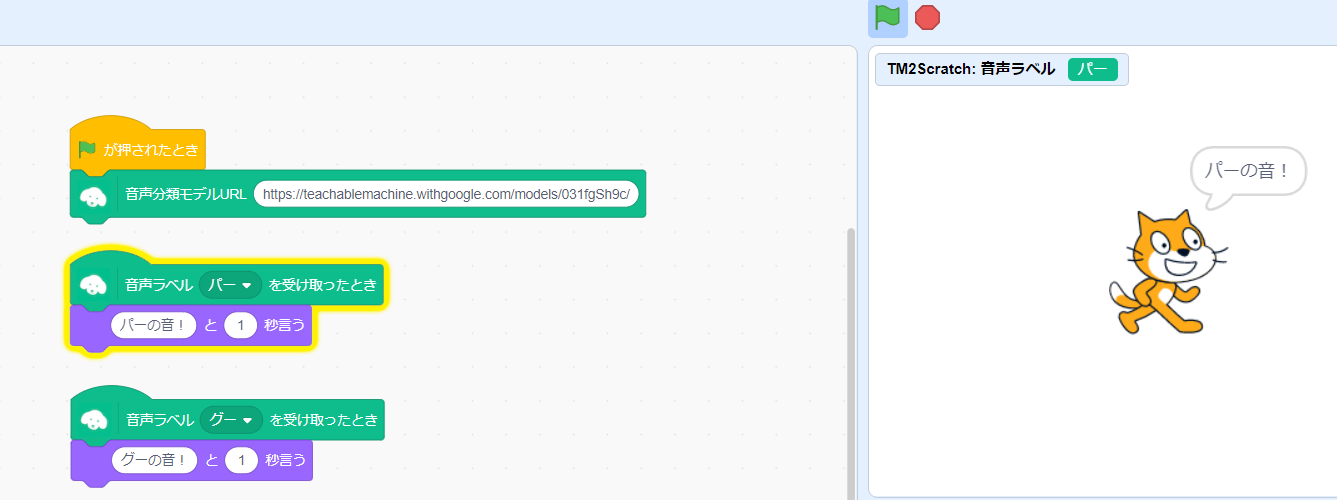

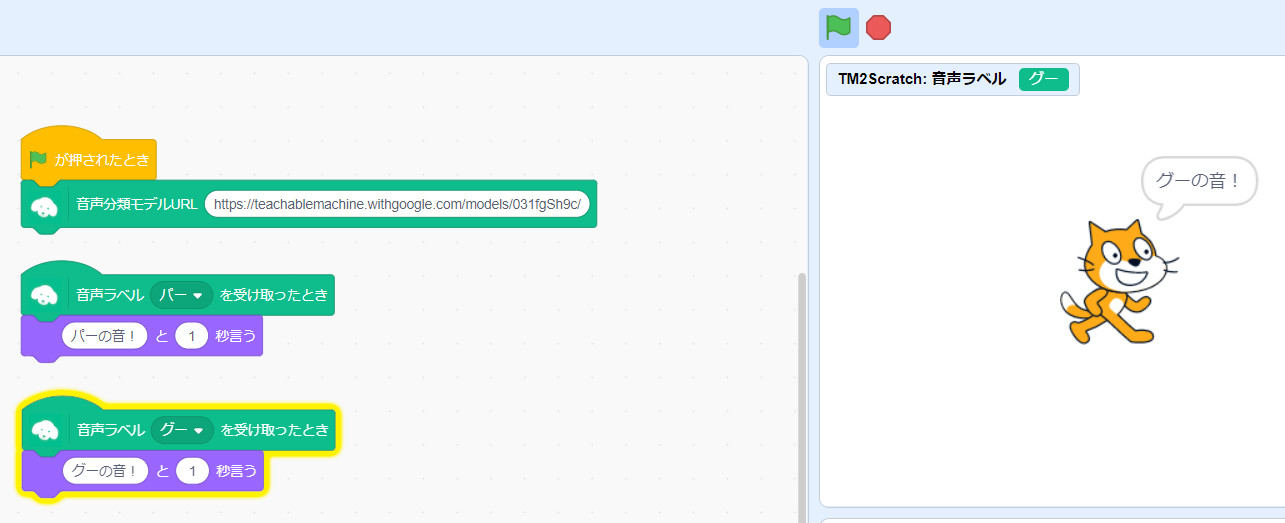

モデルをブロックに反映できたので簡単なプログラムを作ってみる。

音声ラベルとしてパー、グーをそれぞれ認識した際にステージ上のネコがそれに応じてしゃべるという内容。

ラベルを受け取った際にネコがそれに応じて喋っているのがわかる。

TeachableMachineとTM2Scratchを使ってみて

まずTeachableMachineについてだが、画像認識・音声認識・姿勢認識の3分野においてかなり簡単に学習モデルを生成できるのは驚いた。実際にファイルとして出力しJavascriptなどで実装する際に利用できるようだ。

テキストデータやCSVなどは利用することが出来ないので、用途に応じて使い分けるのが妥当だろうか。

またScratchへの連携だが、URLを転用するだけで反映できる点がお手軽で、Scratch利用者にもマッチしている。Scratch上でのプログラムへの応用も簡単にできるため非常にお手軽に体験することができた。

Scratchでも機械学習分野でできることがどんどん広がっていっている。今回の音声認識をLEGO® MINDSTORMS EV3に応用してみるのも面白そうなので実践してみたいと思う。