About

Unity Manualに記載がある'Feature samples'について、各項目が何を行っているのかをまとめました。

まとめ

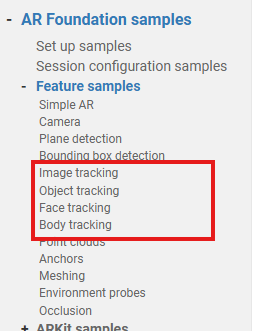

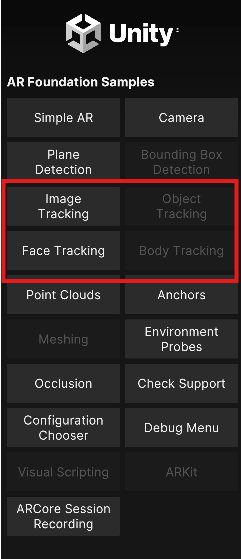

- 'Feature samples'のうち、下図の赤枠にある4つの機能について確認しました。

- アプリにおいては最初の4ボタンが該当します。

本編

Image tracking

サンプルのコードを変更する必要があったため、別記事に詳細を記載しました。 https://qiita.com/Baum9-edge/items/0e47db5cbf0bf15312f5

Object tracking

事前に追跡用のオブジェクトがTemplateディレクトリ内に存在しています。Unityロゴの展開図などがあるため印刷して組み立てておきます。

起動後に組み立てた展開図を確認すると、オブジェクトが表示されます。ただ大分認識に時間がかかりました。オブジェクトの特徴点が少なすぎるような気も…。

Face tracking

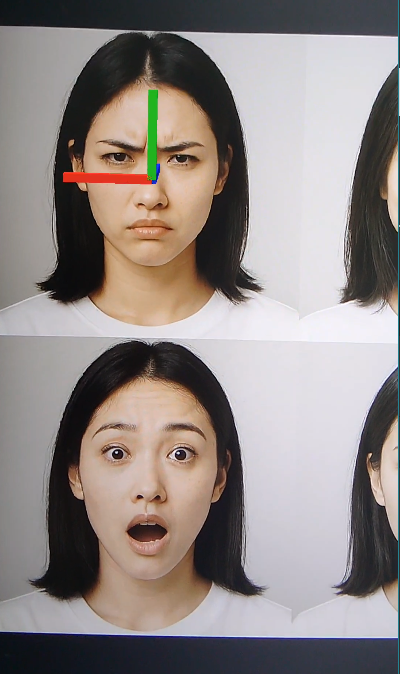

私の顔を映してもしゃーないので、モニタ上の顔に対して検出をかけました。画像認識で有名な例であるLennaの画像を使おうとしましたが、適切でない可能性があったため、Copilotが生成した画像を使用しています。

Face pose

検出した顔の中央付近から、左方向、上方向、奥方向にそれぞれ赤、緑、青のオブジェクトを表示するサンプルです。

Face Mesh

検出した顔にマスクをつけるサンプルです。同時に追跡可能な顔の数など、デバイスの対応状況も表示されます。

Face regions

ARCore専用機能で、顔の特定部位の座標を検出するサンプルです。サンプルでは鼻と両眉の位置を検出しています。

Blend Shapes

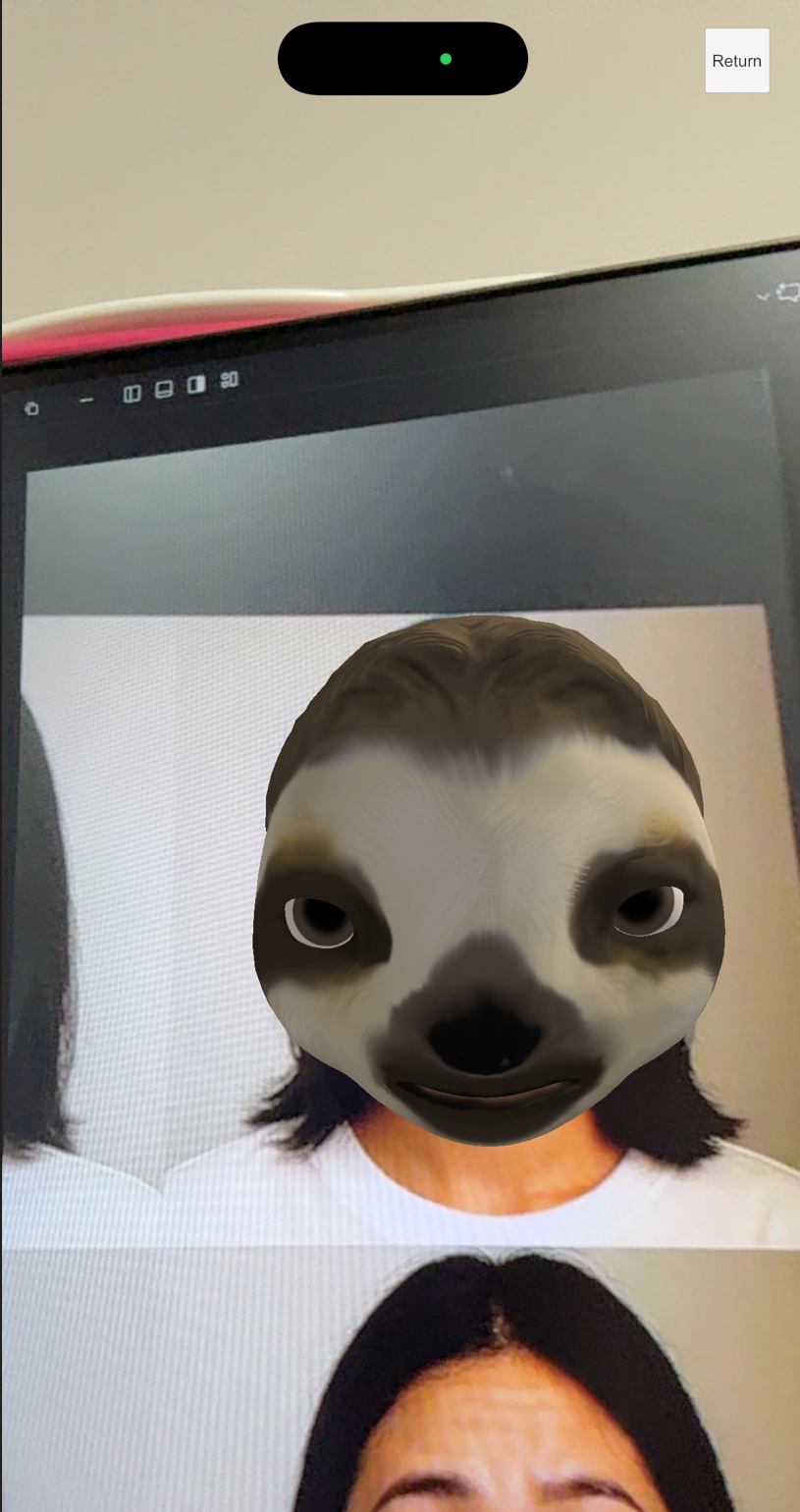

ARKit専用機能です。ウィンクや眉を顰めるといった表情(Blend Shapes)をブレンドするサンプルです。何かの哺乳類の顔で人の顔を上書きします。

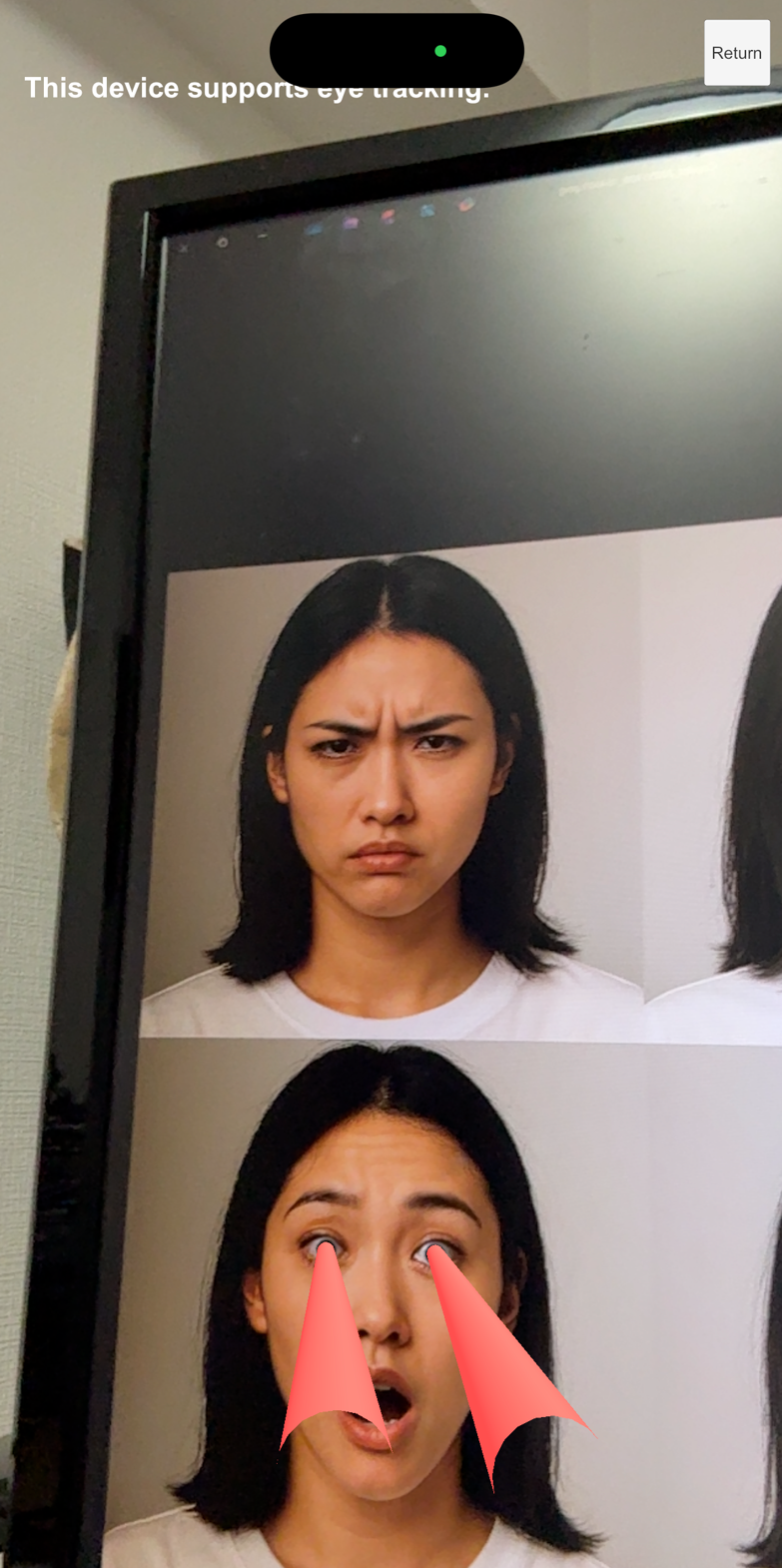

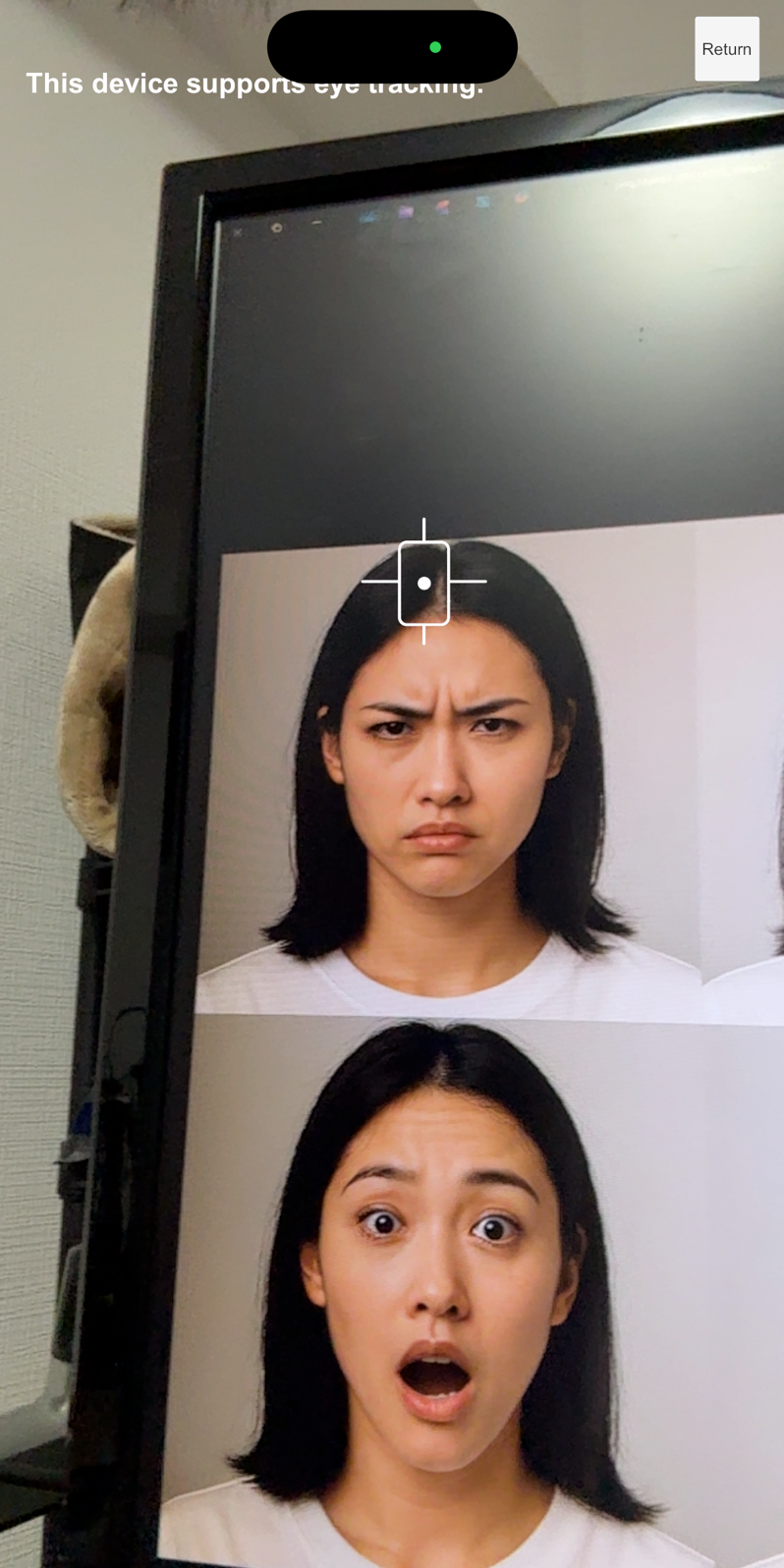

Eye Lasers・Eye Fixation Point

ARKit専用機能で、目線、目の位置、注視点をそれぞれ検出した結果を描画します。

| Eye Lasers | Eye Poses | Fixation Point |

|---|---|---|

|

|

|

Fixation Pointはほかの機能と比べ、実際に試した範囲ではあまり精度が高いとは思えませんでした。

おおまかにスクリーンを上下左右6領域に分けて、どの領域を見ているかが分かる程度なら使えそうでした。

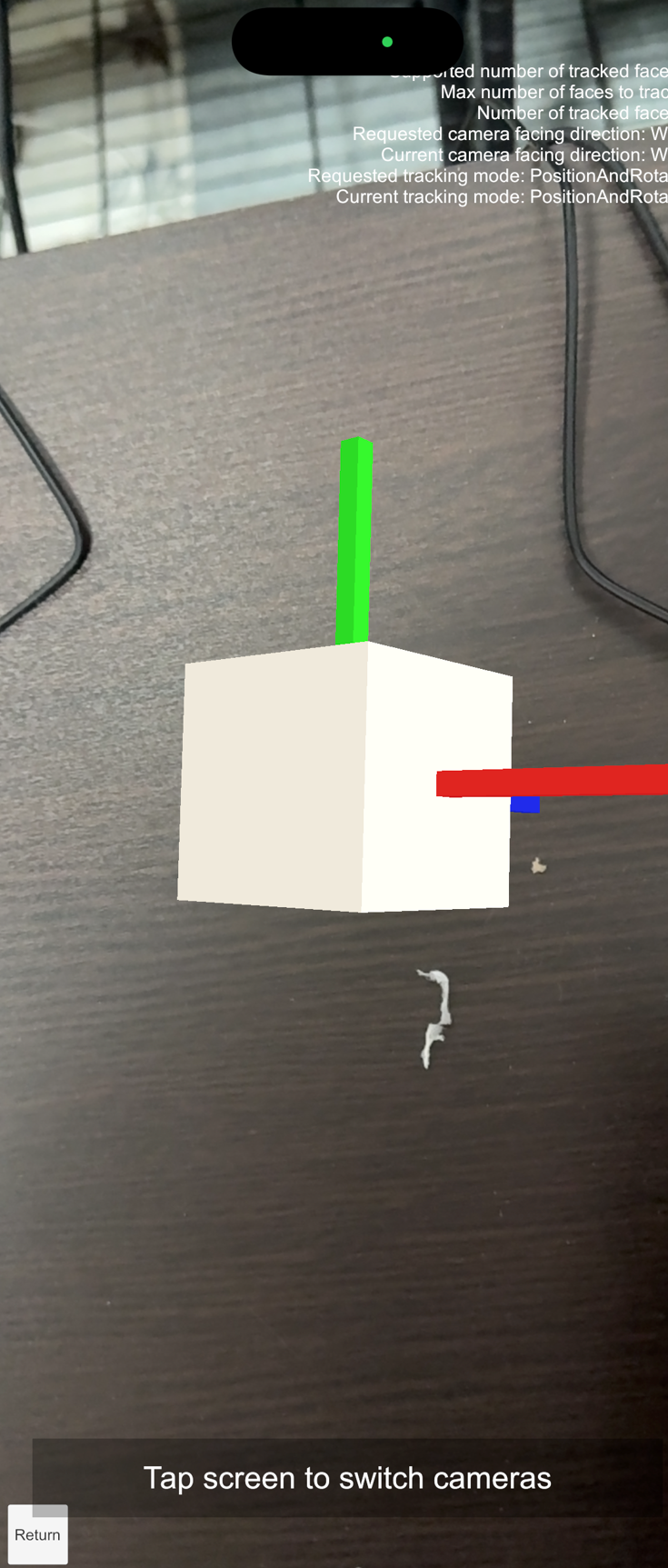

Rear Camera

ARKit専用機能です。背面カメラでビデオシースルーARを行うと同時に、前面カメラでユーザの顔を認識した結果をオブジェクトとして表示するサンプルです。

画像は机を背面カメラが映しつつ、前面カメラが私の顔をとらえオブジェクトに反映しています。

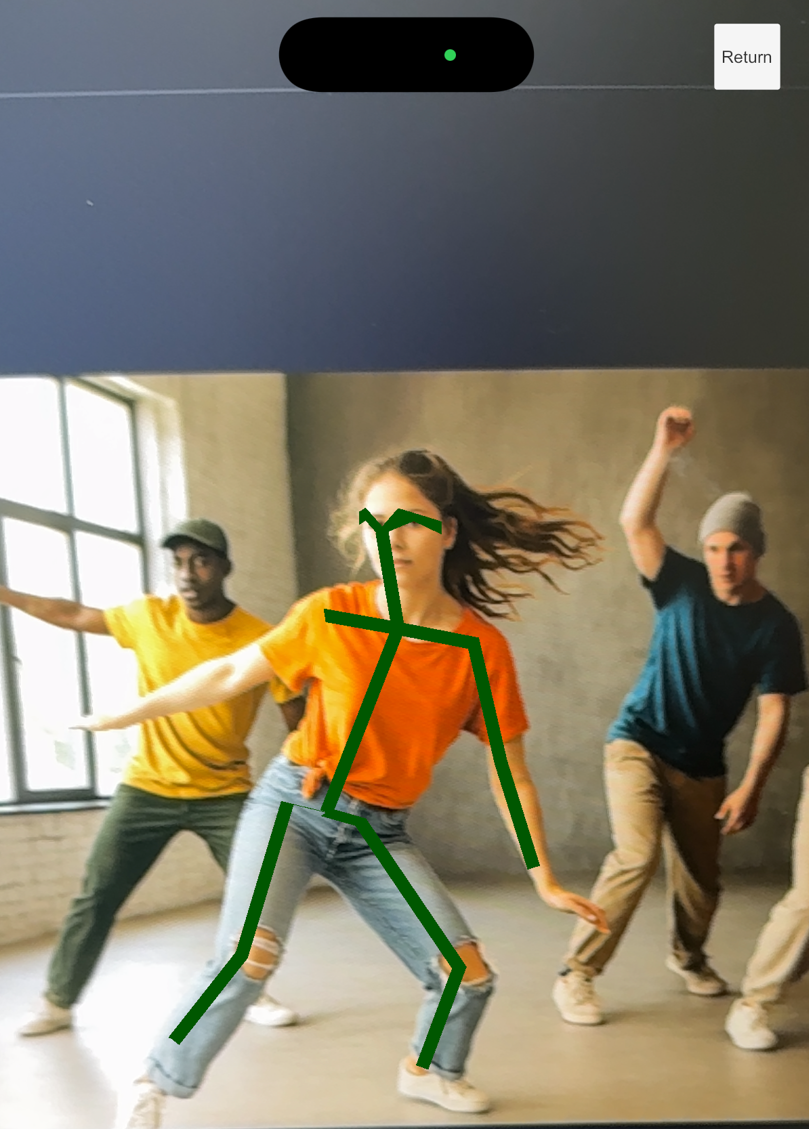

Body tracking

2Dと3Dのサンプルがあります。2Dの場合はスクリーンベース、3Dの場合はワールドベースで人体がトラッキングされます。今回の検証では最大検出人数は1人でした。

| 2D | 3D |

|---|---|

|

|