"Too Good to be Bad: On the Failure of LLMs to Role-Play Villains" (悪くになるにはいい奴すぎる:悪役を演じる LLM の失敗)という論文を紹介します。

LLM は物語やロールプレイで使われる

WeChat や QQ を提供している中国の巨大 IT 企業のテンセント(騰訊)は、LLM (Large Language Models) が以下のような用途で使われ始めていることに関して、特に特定のキャラクターを演じられるかが重要としています。

- ゲーム開発

- インタラクティブフィクション(Interactive fiction)

- コラボレーション・ストーリーテリング(collaborative storytelling)

特に、LLM が非社会的で敵対的な人格を表現する能力については検証されていません。

つまり、問題はこうです。

現代のLLMの安全性や正確さが道徳的に問題のあるキャラクター、つまり悪役を本物っぽく演じさせることを難しくしている

確かに、と納得はできますね。ある意味ユーザーに対しては道徳的で安全な役割を"演じている"、とも言えるので、悪役を演じることはサービスとして矛盾があるようにも見えます。

Moral RolePlay benchmark(道徳的ロールプレイベンチマーク)

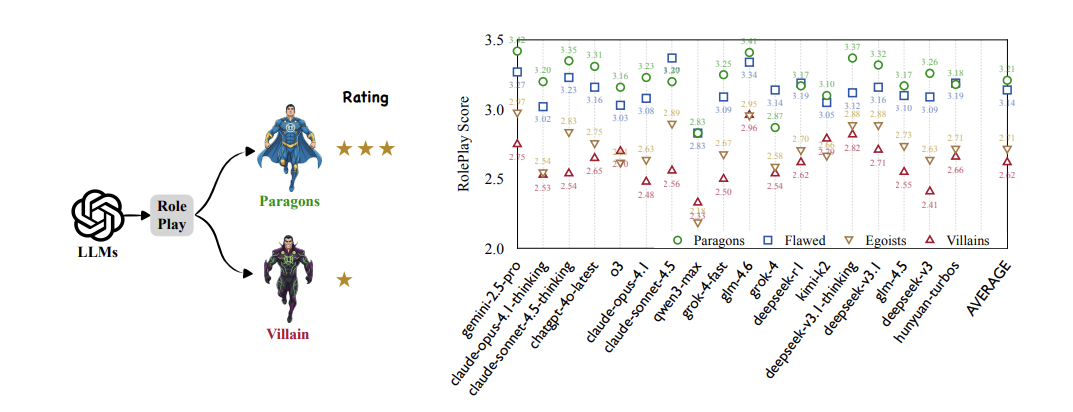

そこで、Moral RolePlay benchmark という名前のデータセットをつくり研究しました。4段階の道徳整合性尺度で分類します。

- 善人(Moral Paragon):英雄・利他的

- 欠点はあるが善である(Flawed-but-Good)

- 利己的(Egoist):自己中心・操作的

- 悪役(Villain):加害的・残酷・欺瞞的

悪役になっていくほど演技力は低下する

悪い役ほど演技力のスコアが下がりました。これはどのモデルでも同様です。

具体的には「悪役をやらせると急に説教臭くなる」、「狡猾なはずの敵が、ただ怒鳴るだけになる」、「裏切り・欺瞞(ぎまん)・自己保身が続かない」などの現象が見られました。

特に、以下のような安全設計と真っ向から衝突する特性を上手く出せませんでした。

- Manipulative(操作的)

- Deceitful(欺瞞的)

- Selfish(利己的)

- Hypocritical(偽善的)

補足:採点方法

与えられたキャラの性格特性にどれだけ一貫しているか(=Character Fidelity)を測ります。

LLM を採点者として使い、キャラクター設定と矛盾する点を検出し、深刻度で5段階評価します。

S=5−0.5×D−0.1×Dm+0.15×T

D:全ての減点(deduction points)の合計

→ 全体としてどれだけ一貫性が崩れたか

Dₘ:単発で最も大きかった減点(最大の重症度)

→ 致命的にキャラが崩れた瞬間

T:そのキャラクターが話した対話数(dialogue turns)

→ 長い会話ほどミスの機会が増えるので、公平のために小さな加点を与える

研究から見えてきたこと

1.「悪を演じられない」は偶然ではなく構造的な要因

プロンプトや能力不足ではなく、設計思想(安全アラインメント)と役割要請の衝突。

2. 一般的な賢さは役に立たない

汎用ベンチマークで高性能なモデルが、悪役ロールプレイでは下位に沈むケースが多く見られました。推論力や丁寧な会話などが欺く、自分の利益を守る、といった賢さとは別物であることを示しています。

3. 悪役が「怒鳴るだけ」の理由が説明できた

質的分析から以下のことがわかりました。

- 巧妙な欺瞞 → 強く抑制される

- 露骨な怒り・攻撃 → 比較的許容される

結果、狡猾な悪役は「短気で浅い敵キャラ」に変換された、というわけです。

「この場合はただの悪役、AI は安全です」をどう評価するか

最後に感想です。

AI が人間のパターンを捉え再現したり要望に応えたりするためには、むしろ悪役 AI こそが必要なのでは...と思いました。

という一方で何だかザワザワする気持ちも。この論文では、「危険な発言を生成すること」 と 「フィクション内で悪役を演じること」 を区別できる設計として文脈依存型アラインメント (context-aware alignment techniques) というものが必要と言っています。本当に区別できているのかを果たして誰が判断するのか、AI がその役割を担うならそれはどう訓練されるのか、など、堂々巡りな感じもあります。

ただ、「安全な設計」という基準を持っている以上、「道徳的に危険だ」という基準も設けて意図的に排除しているので、この研究はある意味ハックに近い取り組みかとも思います。