BluemixのBigInsights for Apache HadoopがOpenBetaになったので、Cloud上でサクッと(タダで)Hadoop使ってみます。

Sparkも入れられるので、Sparkの実行とか使い方的な紹介

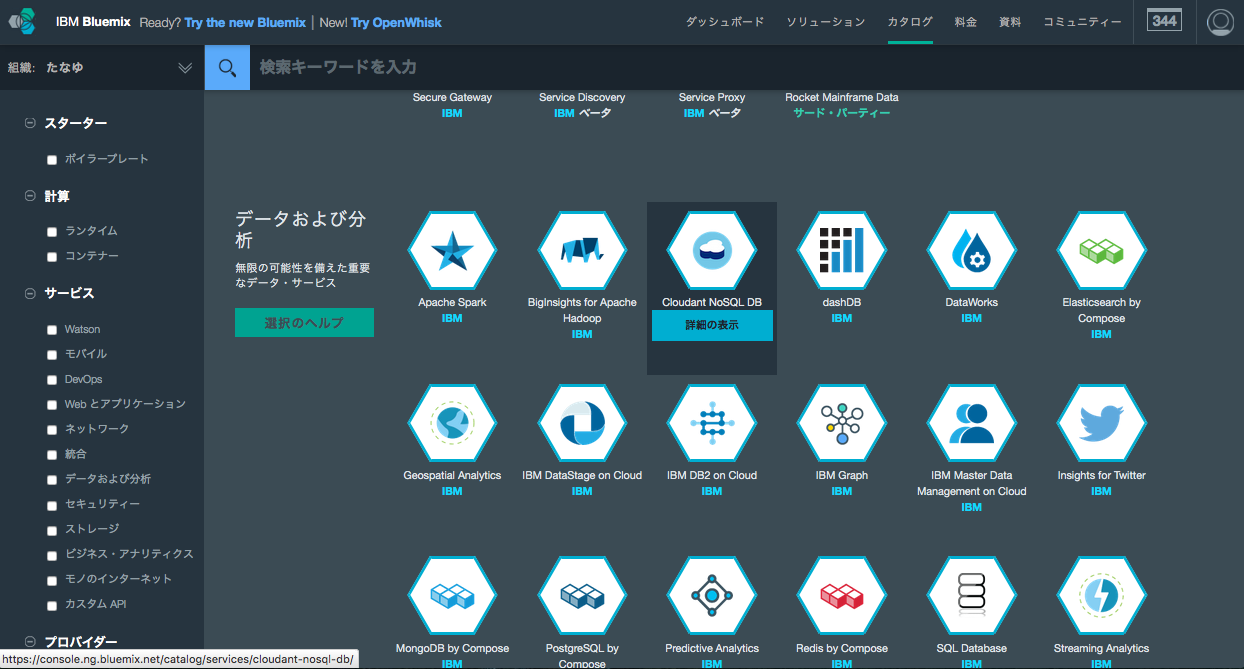

Bluemixのカタログから払い出し

-

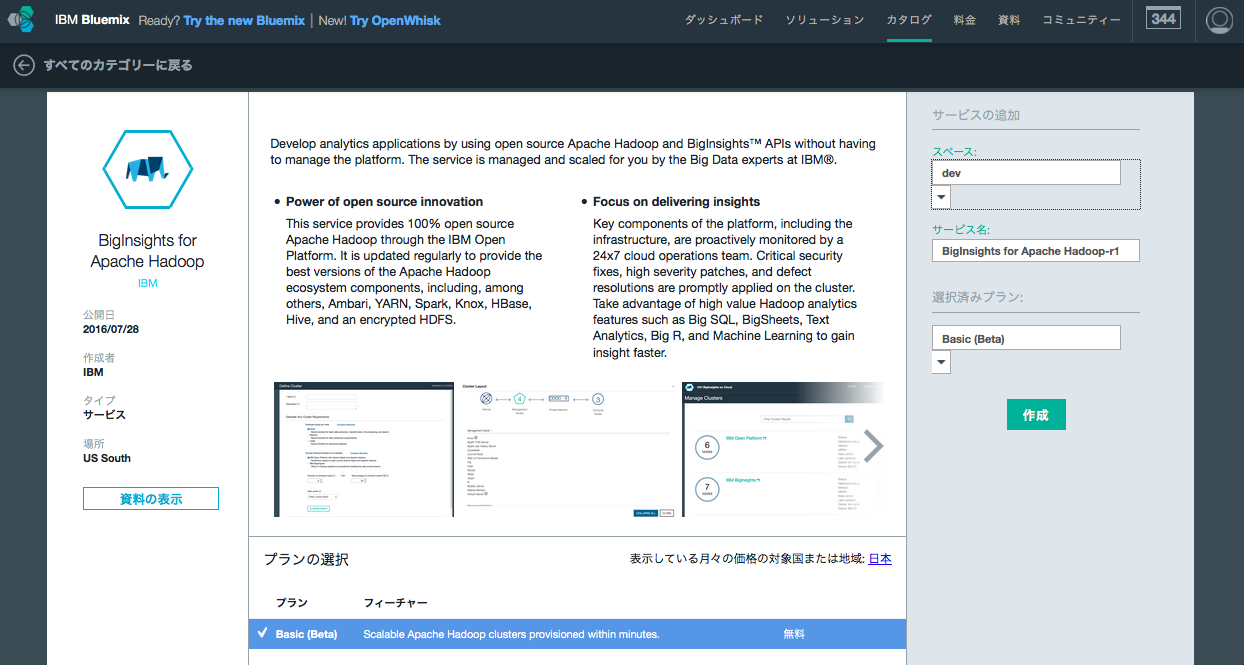

サービス名, 価格プランを選んで作成

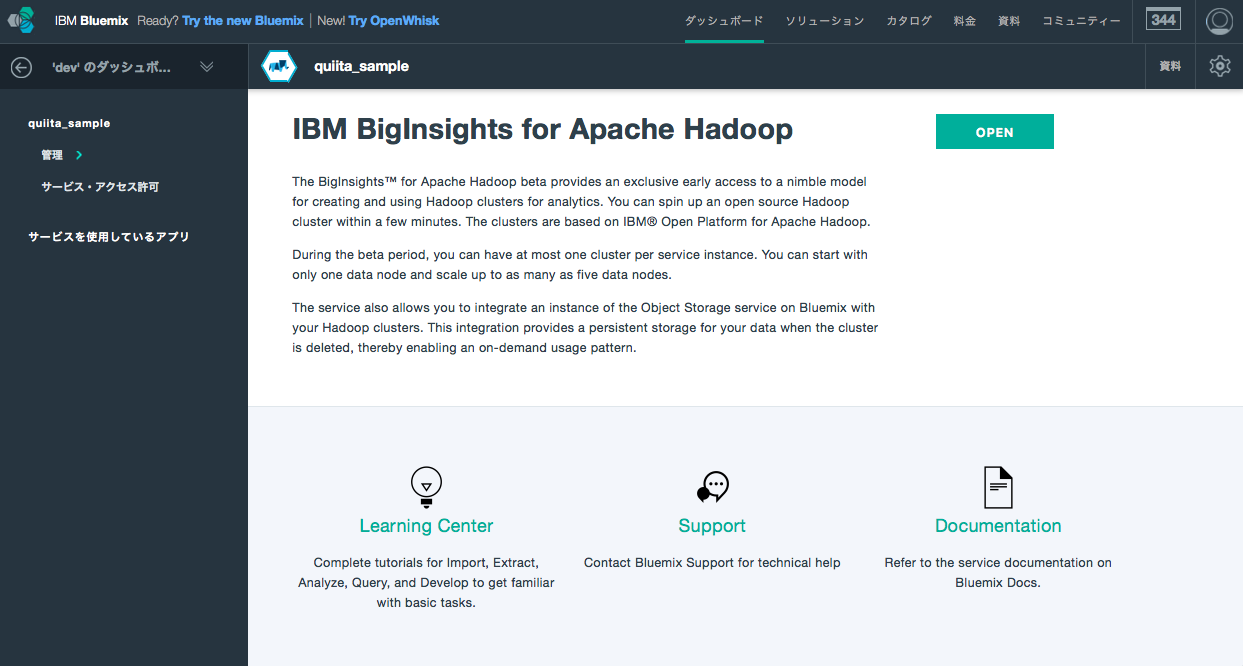

払い出した直後に下記のエラーページとか飛ばされる事がある。ちょっと待ってから再度Open選べばちゃんとcluster管理に飛べる・・・・ほら、betaだし・・・

プロビジョニング

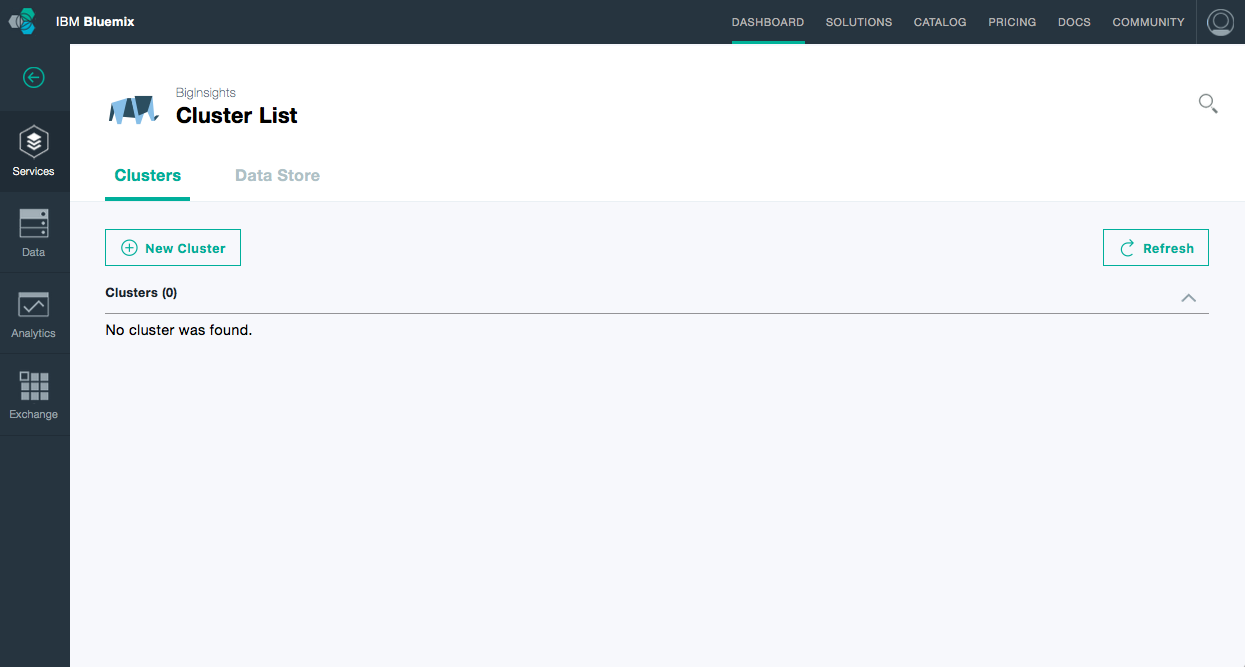

cluster管理画面まで辿りつけたら最初にclusterを作成していきます。

ここのUser NameとPasswordは後のAmbariのログインとSSHで使うので忘れないように・・・

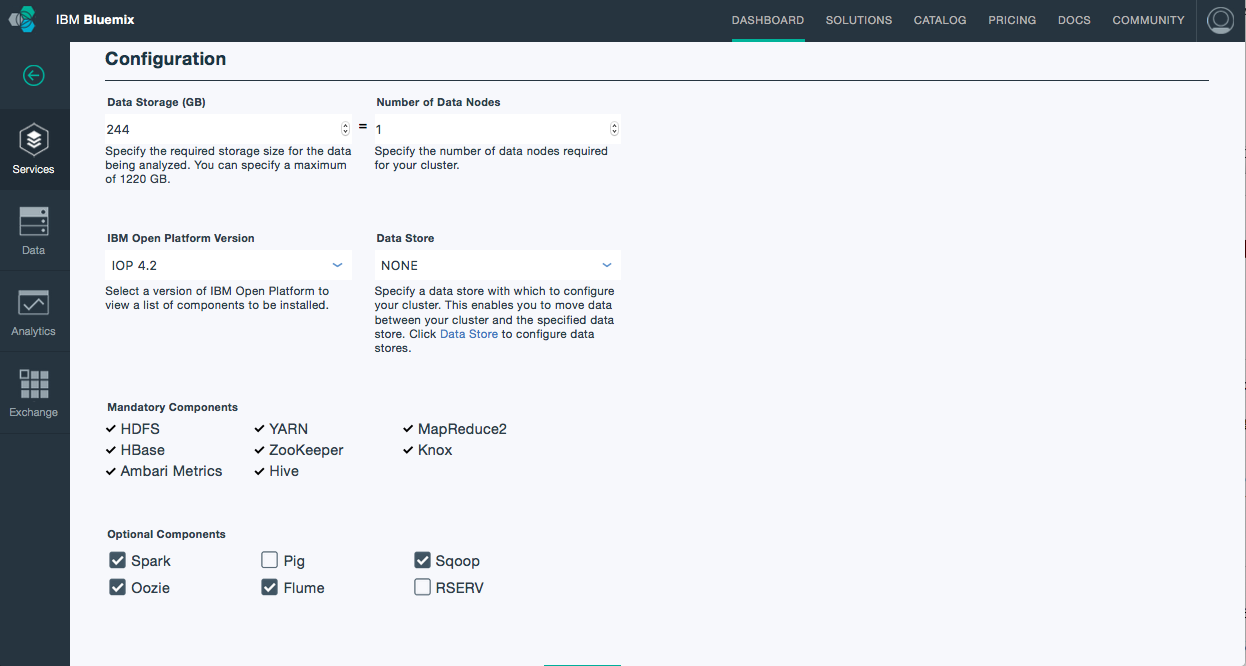

configurationについて

- 仮想の数はDataNode数かGB単位で指定。Beta中は5node/1220GB上限の模様

- IBM Open Platform VersionはIOP 4.2以外選べないのでそれで。

- Data StoreはBluemixのObject StorageかSoftLayerが選べれるみたい。

やってないからわかんないけど、ObjectStorageをS3見たくアーカイブ用途で使用できるんかしら?

- HDFS,YARN,MR2,HBase,ZK,Knox,Ambari,Hiveが必須で入る

- オプションで、Spark,Pig,Sqoop,Oozie,Fluem,RSERVが選択可能

- 今回はSpark,Sqoop,Oozie,Flumeあたり入れとく

configuration終わったら作成

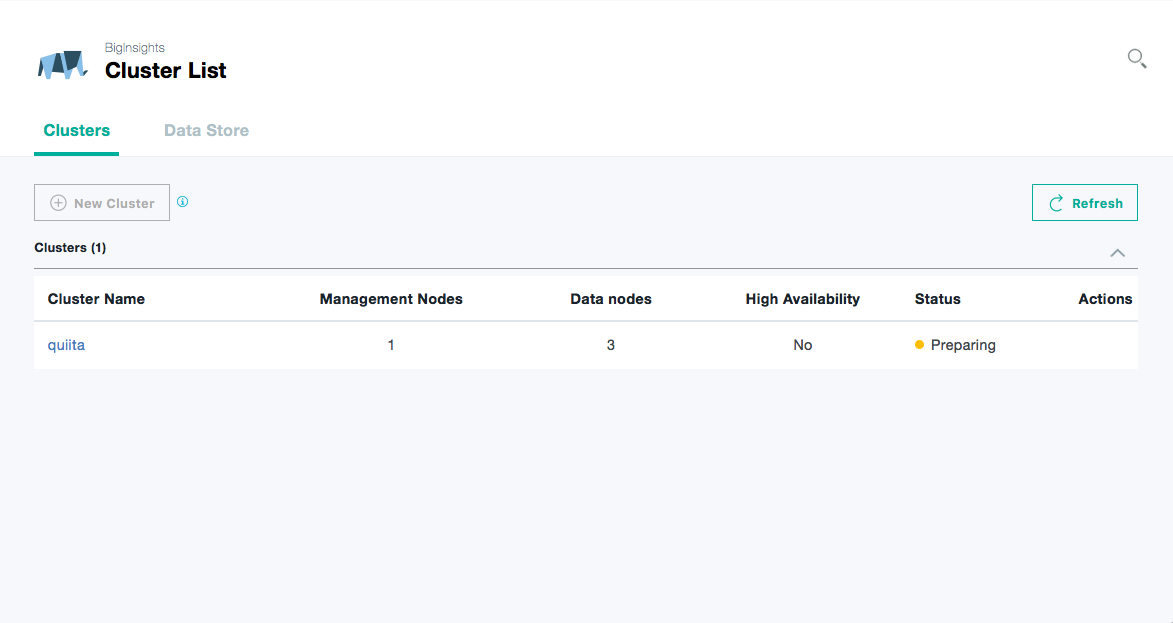

Status画面

プロビジョニング終わると下記のようなClusterのStatusが見れる

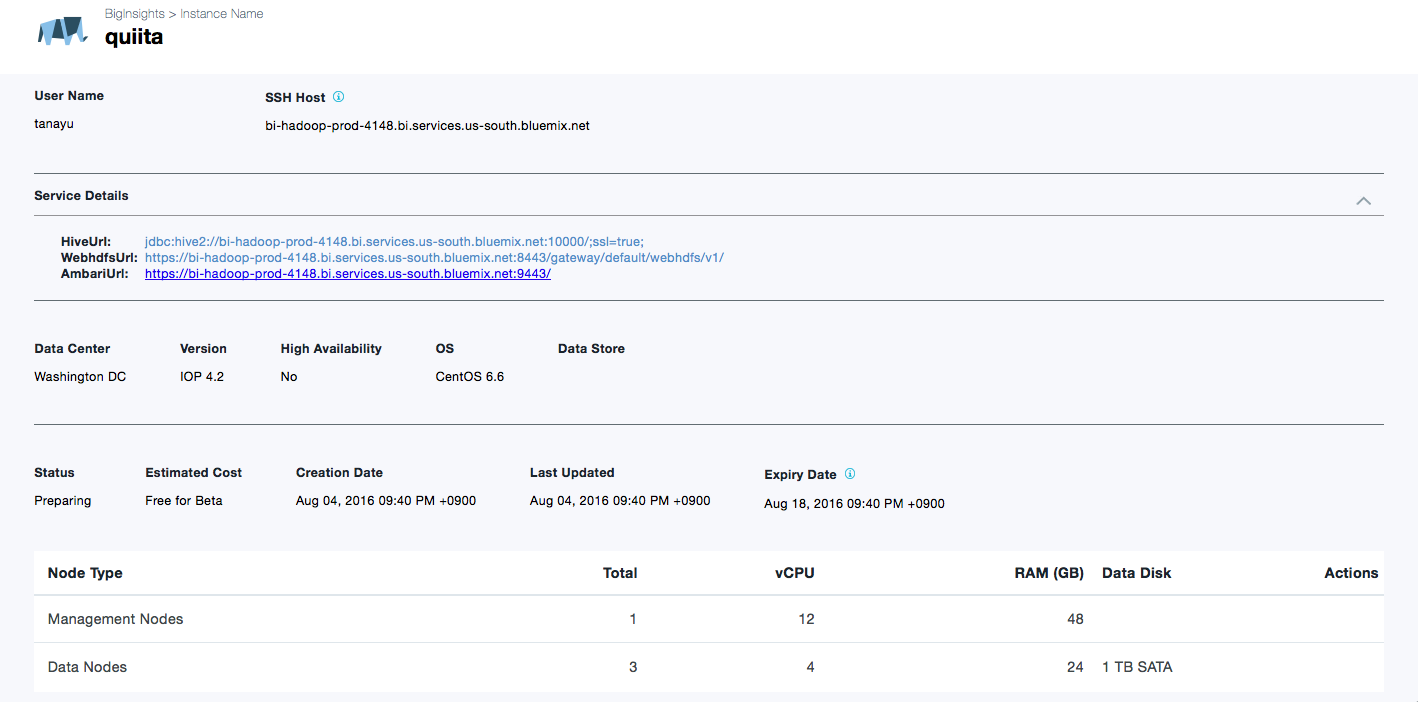

- 重要なのはSSH HostとService Detailsくらい

- SSH先のドメイン

- Hive接続用のURL

- WebHDFS用のURL

- AmbariのURL

ちなみにBluemix上で現在選べるDataCenterはUS South,Sydney,United Kingdomの3つからなのに、BigInsights for Apache Hadoop だけなぜかWashingtonDCに払い出されてるとか、BigInsights(製品)は CentOSサポートしてないけど、これはなぜかCentOSで作成されるとか、そんな細かい事気にしてはいけません・・・betaだし・・・

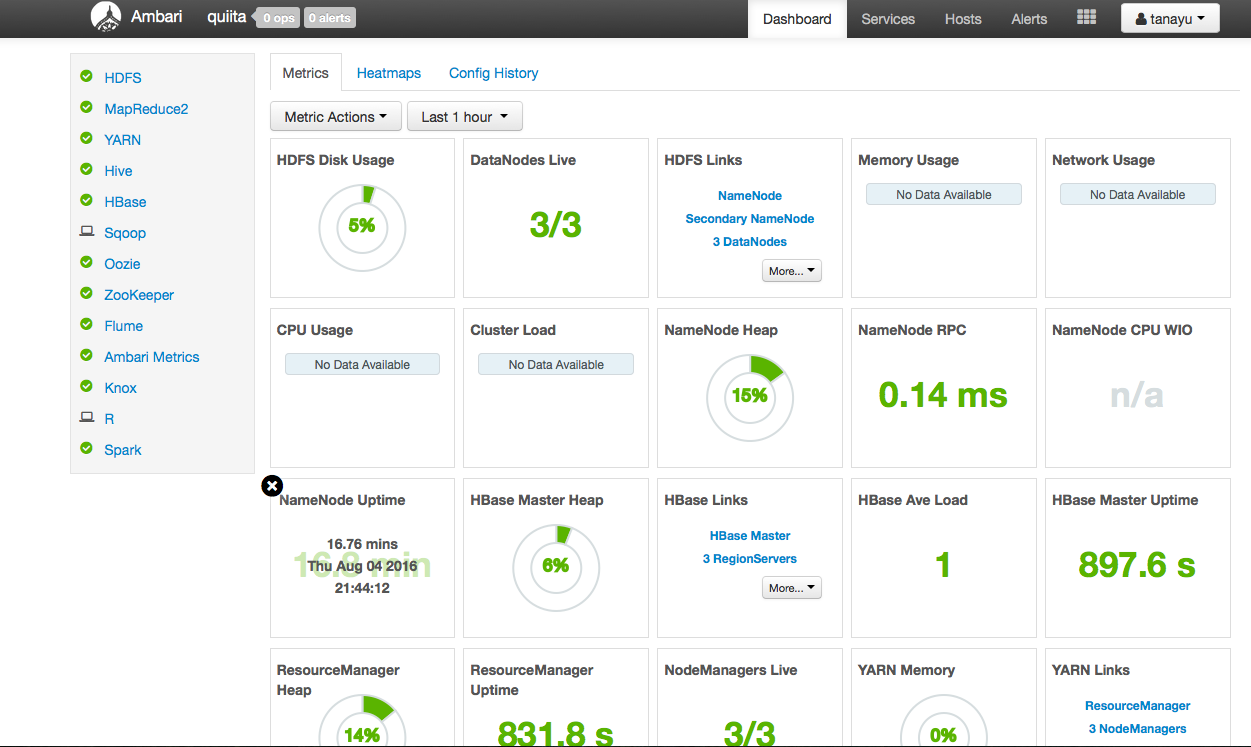

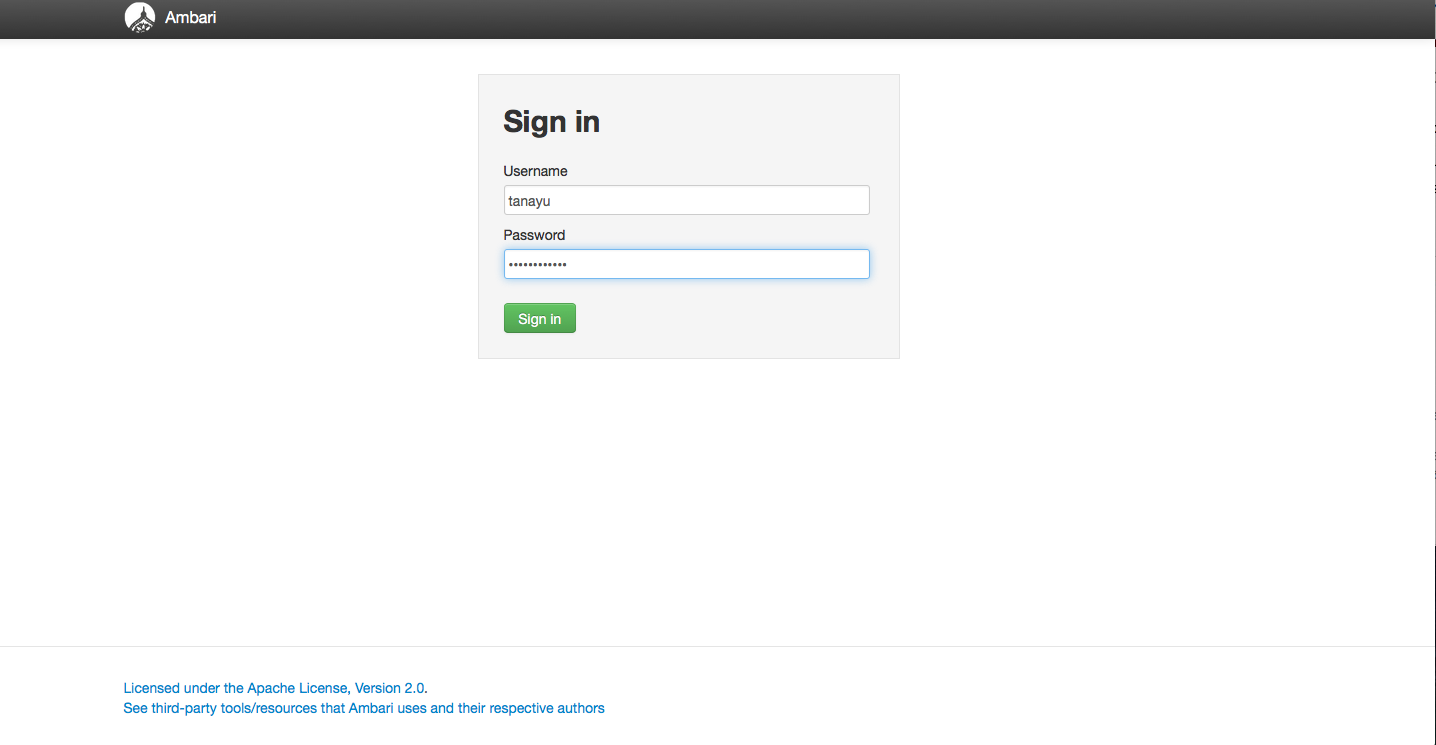

Ambari

おなじみのAmbari画面

プロビジョニング時のUser Name, Passowrdでログイン可能

- ステータス管理

- configuration管理(閲覧のみ)

- メトリクス

などがこちらから可能

素のAmbariのようにClusterへのNodeの追加や、ServiceのStart,Stopなどはできないみたい。HBase使わない人とかも上がりっぱなしになるのでこの辺りは注意

当然、configの変更はできないのでほぼメトリクスとステータス管理用・・・・Ambari入る意味ってなんだろう・・・

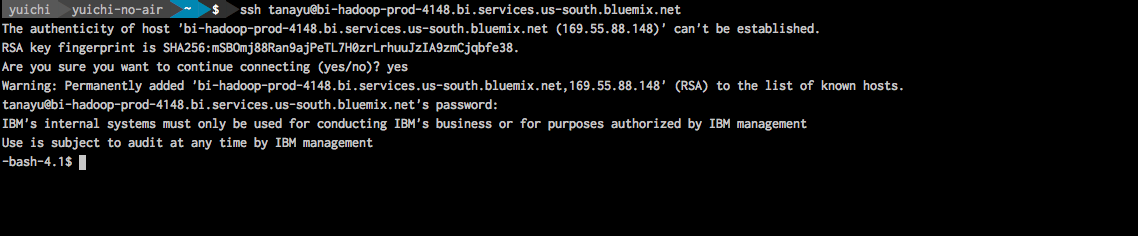

SSH

下図のようにコンソールから、プロビジョニング時のUser Name, Passwordでログイン可能

ssh <User Name>@<SSH Host>

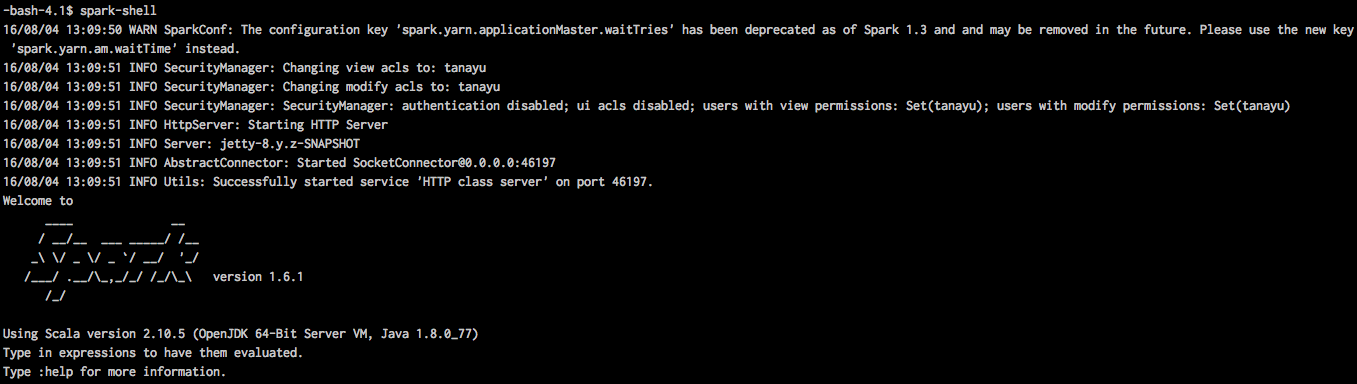

ログイン後、spark-shell叩く事でsparkの実行が可能

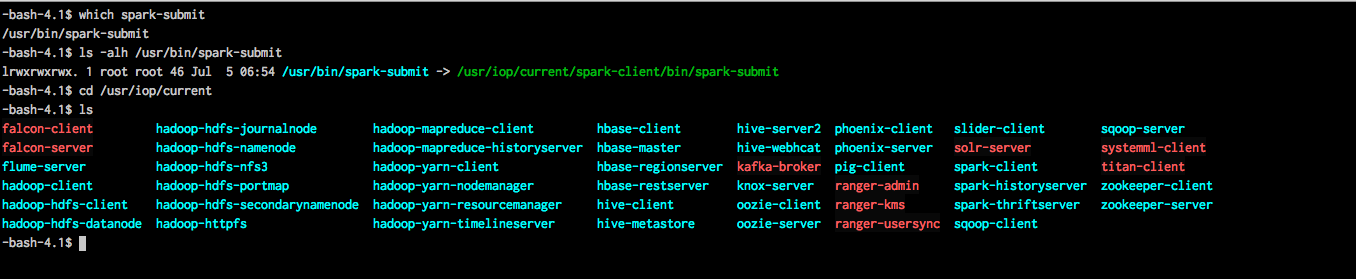

普段よく使う奴らは下図のように

/usr/iop/current/

この辺りにいる

ログインユーザーにsudoはほとんど付いてないみたい。yumが叩けなかったのでvim入れられず。開発環境とかには絶対向かない・・・・

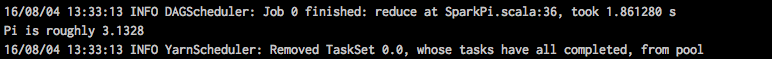

SparkPiの実行

spark-examples.jarは置いてくれてるようなので、spark-submitしてみる

spark-submit --class org.apache.spark.examples.SparkPi --master yarn-client /usr/iop/current/spark-client/lib/spark-examples.jar

実行後、下図の結果が出る。

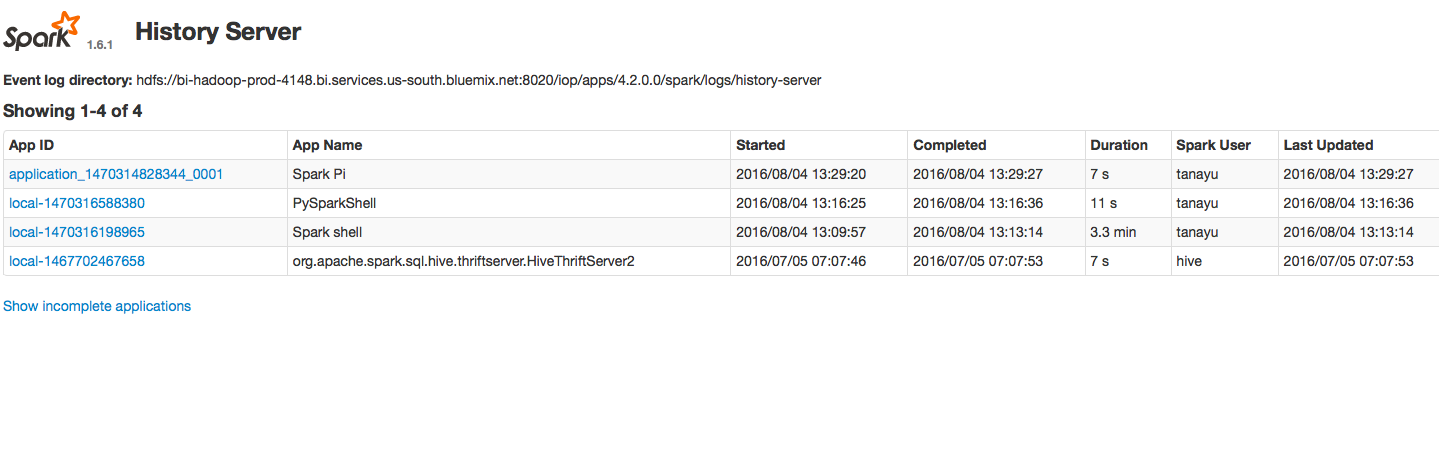

HistoryUIを見るとSparkPiが実行されているのがわかる

開発後、jarを作ってsshで持って行って実行するのはできそう。

HistoryUIを開く際にBasic認証を求められる場合はプロビジョニング時のUser Name, Passwordで入る事が可能です。

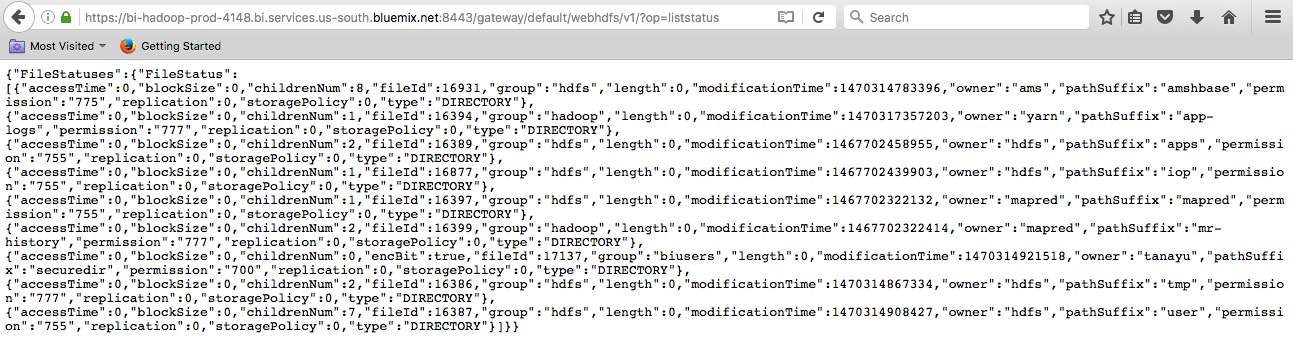

WebHDFS

WebHDFSはRESTになってるので、例えばファイルを一覧でみたい場合はブラウザとかcurlとかで

とりあえず今日はここまで。