■目的

・PCのローカル環境でLLMを設定すること

・ローカルLLMを設定して、無料で利用できることを体験する。

■設定方法

Ollamaのインストール方法

OllamaのHPへ行き、Downloadボタンをクリックする。

https://ollama.com/

OllamaSetp.exeファイルが取得できるので、

クリックします。

※ファイルをデスクトップに移動させた場合、

可愛いアイコンが表示されます。

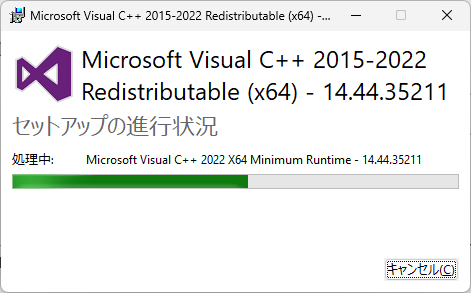

もし、Microsoft Visual C++が求められたら、 指示に従いそのままインストールします。

以下の画面が表示される場合、今回は利用しませんので、画面を閉じます。

インストールの確認

コマンドプロンプトを使って、インストールの確認します。

コマンドが正常に動作すれば、Ollamaのバージョンが表示されます。

ollama --version

モデルの設定方法

利用するモデルを選びます。

OllamaのHP

https://ollama.com/

の左上にある、「Models」をクリックする。

または、

https://ollama.com/search

をクリックします。

使ってみたい、モデルを選択してください。

今回は、llamaモデルを利用します。

プルダウンメニューを見みると、最新順(Newwest)、人気順(Popular)と表示を変えることができます。

最終的に利用するのは、4.7GBのある、llma3にしました。

モデルをインストールします。

ollama pull llama3

インストールされたモデルの確認

oolama list

■動作確認

shell(コマンドプロンプト)でそのまま実行してみる

実行コマンドを行ってから、プロンプトを実行していきます。

実行コマンド:

ollama run llama3

「Send a message」 と表示されるので、生成AIにしてほしいプロンプトを書いてください。

絵を書くように指示すると、アイコンが出てくるようです。

さすがにShellのウインドウで絵を描く要求はできないですね。。

→無茶な要求ですね。

■参照

■venv: Python 仮想環境管理

https://qiita.com/fiftystorm36/items/b2fd47cf32c7694adc2e

■【初心者向け】ローカルLLMを使ってRAGを導入したチャットアプリを作ろう!いくら使っても無料のAI環境を手に入れよう!

■Gemini

https://gemini.google.com/