はじめに

私が待ち侘びていた、Gemini3.0モデルと共にリリースされました。AntigravityはOpenAIだけでなくCursorも潰しにかかったかと思うほどGoogleにいい意味で恐怖を感じる製品となっていると思います。今回は、Antigravityのドキュメントを読んで自分なりにまとめたのと、hands-onもやってみました。是非、お役に立てればと思っています。

Google Antigravity とは何か?

Antigravity は Google が公開した、次世代型のエージェントファースト開発プラットフォームです。従来のIDEを単なるエディタではなく、AIエージェントと協働しながら開発を進めるための総合開発環境として進化させた点が特徴です。VSCodeをフォークして作成されているので、開発者にとっては親しみやすいツールになっていると思われます。

Antigravityの主な特徴

- Agent ‥ エディタ、ターミナル、ブラウザを横方して自律的に動作する新機能。

- Artifacts ‥ エージェントが進捗を伝えるための成果物。

- Editor ‥ AI搭載のIDEで、タブ表示やコマンド実行、エージェントなどを使える残高な機能を提供。

- Agent Manager ‥ 複数のエージェントをパラレルに管理するミッションコントロール。

- User Feedback ‥ 任意のArtifactにコメントやフィードバックを残して、エージェントの行動をガイドできる新機能。

- Task Groups ‥ 個々のツールの呼び出しではなく、高レベルのタスク単位でエージェントを管理する。

- Knowledge ‥ チャット内容を学習し、再利用可能なナレッジベースを構築する機能。

料金プラン

Antigravityはリリース当初、すぐに制限が来てしまい、

現在の利用範囲(2025/12/7時点)

- Public Preview 中

- 個人アカウントのみ対象(GoogleアカウントがあればOK)

全ユーザーが利用可能な機能

- 無制限のタブ補完

- 無制限のコマンドリクエスト

- Agent / Agent Manager

- Browser Subagent

- MCP / Workspaces

無料ユーザー

- 週ごとに制限リセット

Google AI Pro

- レート高め

- 5時間ごとに制限リセット

Google AI Ultra

- レート最も高い

- 5時間ごとに制限リセット

Agent

Antigravity における Agent は、高度な推論モデルを基盤に、ユーザーのコードや作業内容を読み取り、タスクを分解しながら、必要に応じてツール・ターミナル・ブラウザなどを操作し、実際の開発作業を段階的に進めてくれる開発特化型 AI アシスタントです。単なる対話機能に留まらず、IDE 全体を横断して作業を実行できる点が大きな特徴です。

Terminal Command Auto Execution

エージェントがターミナルでコマンドを自動実行する際の挙動を制御する設定です。

- Off:基本的に自動実行しない

- Auto:エージェントが必要に応じて判断

- Turbo:拒否リスト以外のコマンドをすべて自動実行

Allow/Deny リストは Agent 設定で自由にカスタマイズ可能です。

設定変更は 次のメッセージから反映されます。

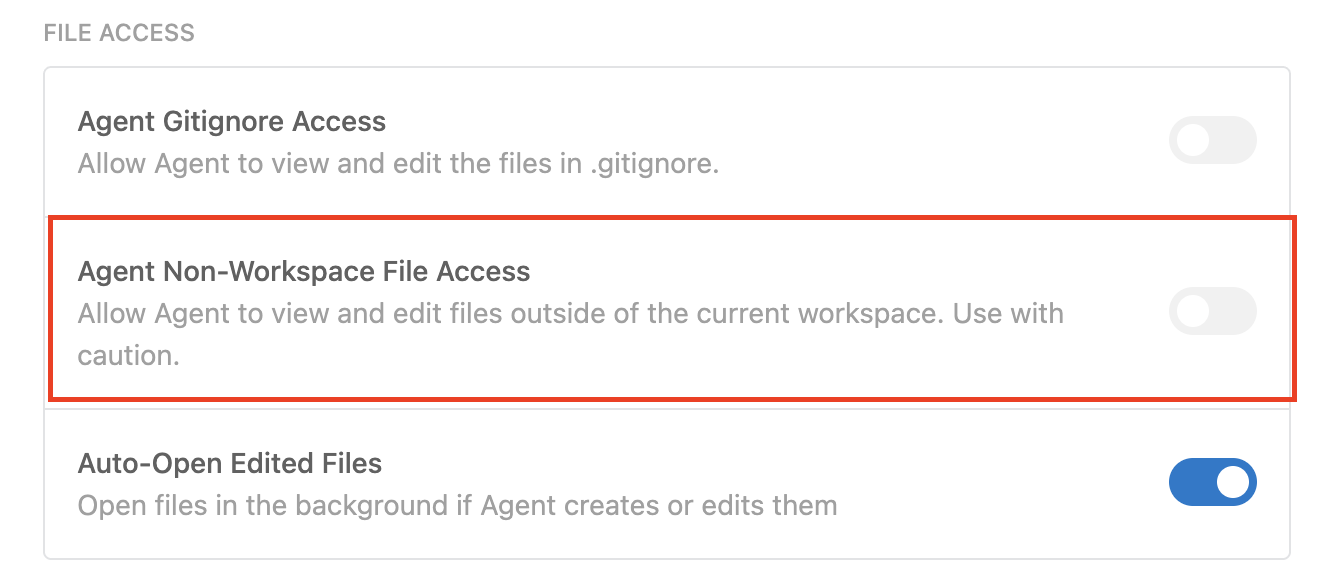

Non-Workspace File Access

エージェントが作業ディレクトリ外のファイルへアクセスできるかどうかを制御する設定です。

Task Groups

エージェントが Planning モード に入った際、複雑な作業は自動的に Task Groups として構造化されます。これにより、大きな作業を小さく分割し、レビューしやすく、進捗管理もしやすい形で提示されます。

Browser Subagent

エージェントがブラウザ操作を行う必要がある場合、その作業を担当するために ブラウザサブエージェント が起動されます。このサブエージェントは、Antigravity が管理するブラウザ上で開いているページ操作に特化したモデルで、メインエージェントとは別に動作します。

ページ操作中は画面に青い枠線とアクション説明パネルを含むオーバーレイが表示され、誤操作を防ぐためユーザーはページを触れません。また、バックグラウンドタブにも対応しているため、他のタブで作業していても問題なく処理が進行します。

Tools

AntigravitymではMCPプロトコルをサポートしています。

コンテキストリリースの取得

AIにログの内容とか設定ファイルとかをコピーして渡すところMCPを使用するとAIが勝手に取得してくれます。

カスタムツールの実行

GitHubリポジトリ内のサンプルコードやNotionドキュメントなどから横断検索をすることができたりします。

TODO コメントから Issue を自動作成することができます。コードに

// TODO: ここ認証ロジック改善

と書いておくだけで、

- この TODO を Linear に Issue として登録して

- タイトルや内容も自動で整形

といった動作がワンクリックで可能になります。

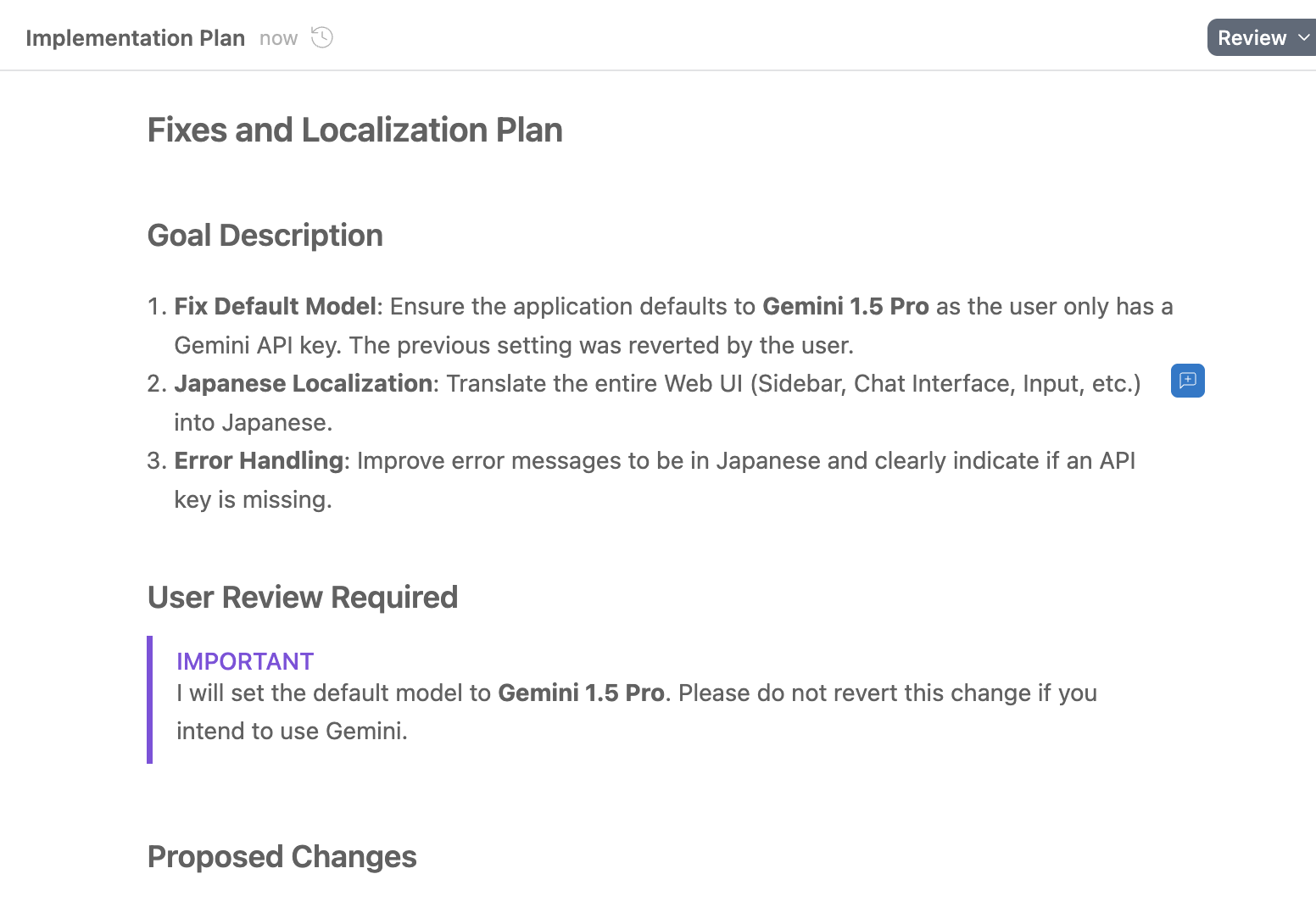

Artifacts

AIは作業を進める上で今、これをやっています。どういう考えをもとにやっていますとか、つらつら文字が表示されます。それがArtifactsです。具体的には下記のようなものです。

- Markdown ドキュメント

- Diff(差分)ビュー

- アーキテクチャ図

- 画像

- ブラウザの録画

- コード差分

Artifactsが生成されるのはPlanning Modeの時です。途中でFeedbackも求められることがあるのでエージェントとユーザーで認識齟齬がないかのやり取りをする必要があります。

Task List

Task Listは、エージェントが複雑なタスクに取り組む際に、作業内容を整理し、進捗を管理するために使われるアーティファクトです。

Implementation Plan

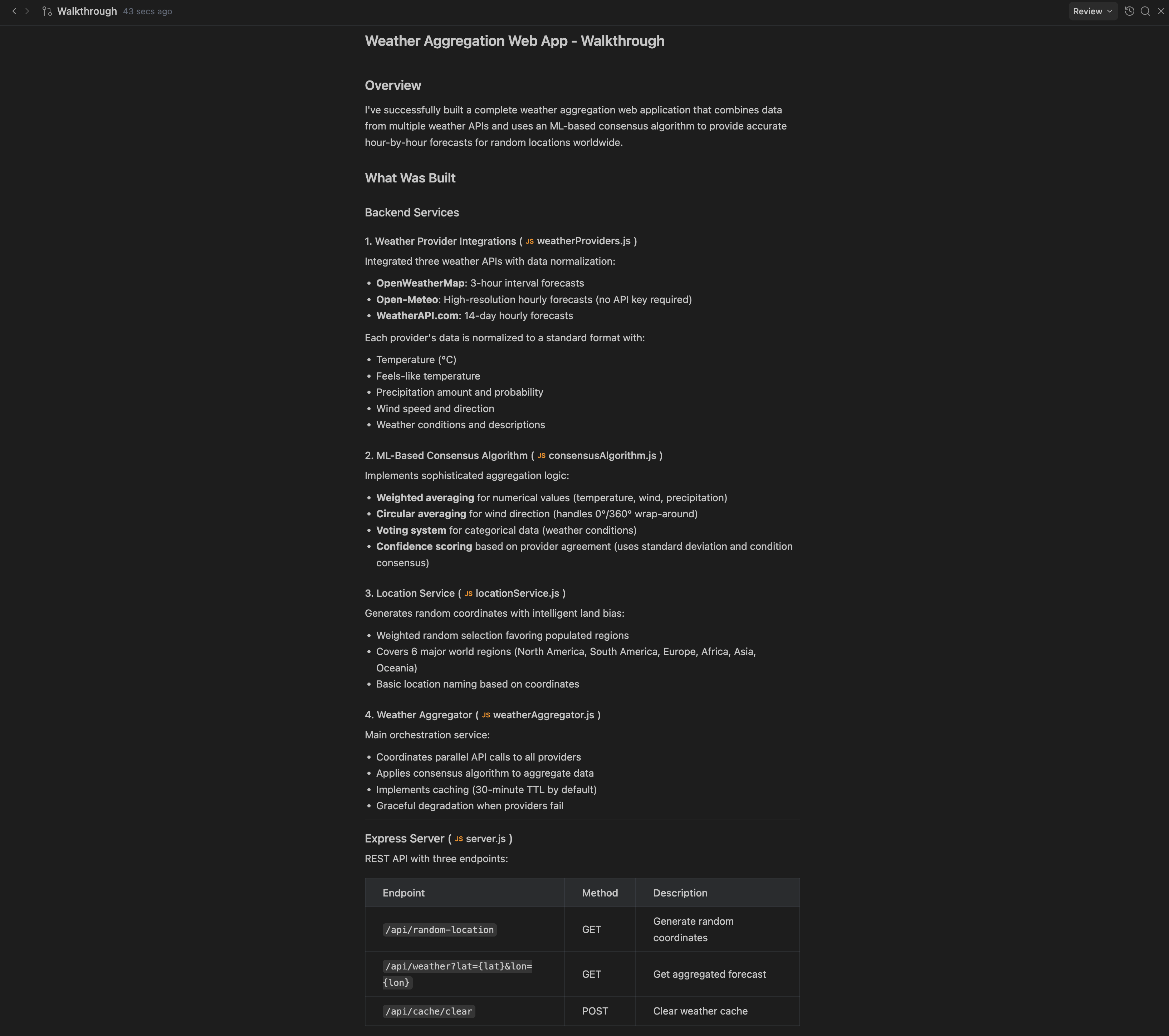

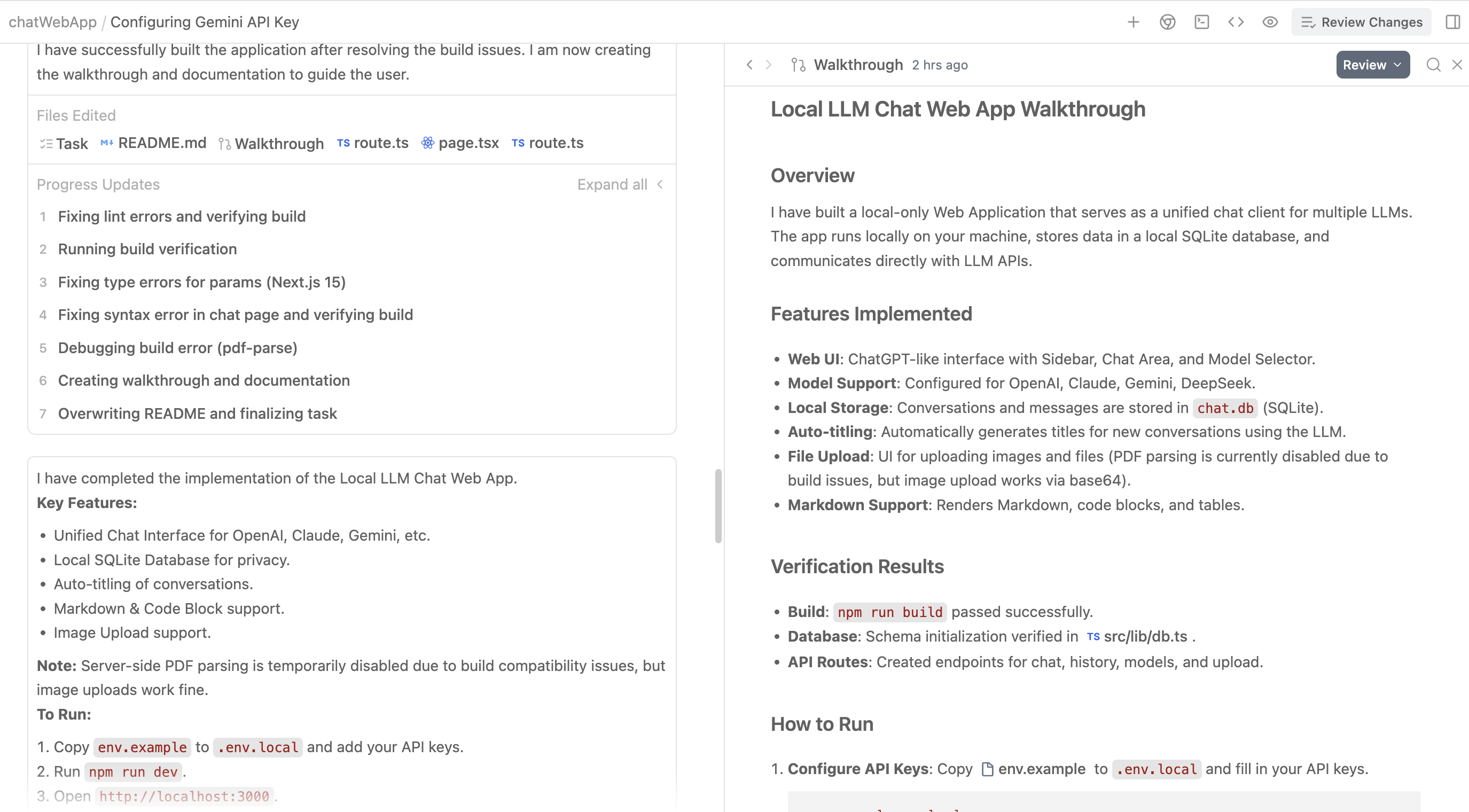

Walkthrough

実際にAgentが行った変更についての要約が記載されている。ブラウザタスクの場合、Walkthroughには、Agentがブラウザで構築または作成したもののスクリーンショットや画面録画が含まれることがよくあります。

Screenshots

Browser Subagentは開いているページやページ上の要素のスクリーンショットを撮影してくれます。また、Agentに対してページのスクショを撮るようにも支持することができます。

- 自動スクリーンショット撮影: ブラウザサブエージェントがページの状態確認が必要な時に自動的にスクリーンショットを撮影

- 手動指示: ユーザーがエージェントに対してスクリーンショット撮影を指示可能

- 画像アーティファクト: 撮影されたスクリーンショットは画像アーティファクトとして保存

- フィードバック機能: 保存された画像にコメントを付けてエージェントにフィードバックを提供可能

Browser Recordings

Browser Subagent実行した操作を自動的に記録・再生してくれる機能です。

- 自動記録: ブラウザサブエージェントの操作が自動的に記録される

- 複数の表示場所: ブラウザステップUI内とアーティファクトの両方で確認可能

- ループ再生: エージェントのアクション履歴を繰り返し確認できる

- レビュー機能: 操作履歴を後から振り返って検証可能

Knowledge

コーディングセッションからの洞察をキャプチャして整理してくれます。ナレッジアイテムはエージェントとのやり取りによって自動でナレッジアイテムを作成したり、既存のナレッジアイテムを更新したりします。すべてのナレッジアイテムの要約がエージェントで利用可能となっており、エージェントはそれらを使用して応答を生成します。エージェントが会話に関連するナレッジアイテムを特定すると、そのナレッジアイテム内のアーティファクトを自動的に学習し、適用可能な情報を使用します。

Editor

VSCodeをベースにしています。Open VSX Marketplaceの拡張機能に対応しているため、VSCodeと同様に追加の拡張機能をインストールすることができます。

エージェントが会話の中でコードを書き始めるとAgentパネルの下記ツールバーに「Review Changes」セクションが表示されます。

Command

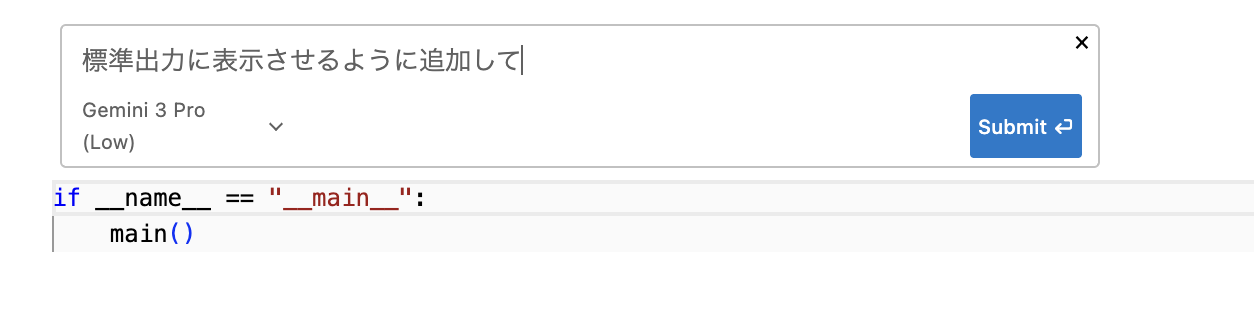

Command 機能は、エディタ内で自然言語を使って“その場で”コード補完やターミナルコマンド生成を依頼できる仕組みです。

Mac: Cmd + I

Windows: Ctrl + I

ちなみにこれはコードでの提案だけではなくてターミナルでも実行することができるらしい。

Tab-to-Jump

Tab-to-Jump は、ドキュメント内の「次に編集すべき箇所」にスムーズに移動するための機能です。エディタが「次に編集すると良い場所」を判断し、

小さな「Tab to jump」アイコンが表示されます。Tab キーを押すと、その位置へカーソルが瞬時に移動します。

Tab-to-Import

未インポートのクラスや関数を使用した際に、必要な import を自動で挿入する機能です。

- 検出:入力した識別子が未インポートの場合、自動で検知

- 動作:Tab を押すと補完が確定され、ファイル先頭に import 文が自動追加される

Editor Window

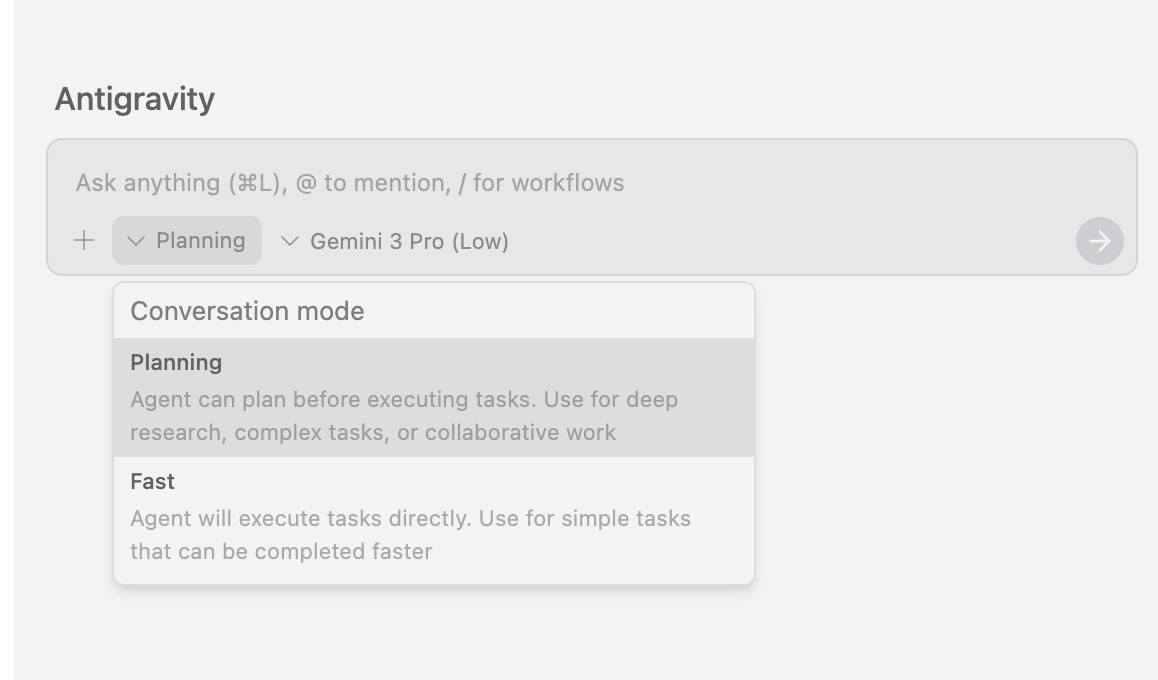

実際にエディタでコードを書いたり修正したりしながらAIを使いたい時はこちら!

そうすると、右にチャットができる画面が出てくる。そこではConversation modeとmodelの選択を行うことができる。

Conversation mode

● Planning モード

エージェントがタスクに受けかかる前に 計画を立てるモード です。

- 実行前にタスクを分解し、作業方針を整理する

- 深い調査、複雑な作業、大きめの変更に向いている

- 共同作業で手順を共有したい場合にも有効

じっくり考えてから進めてほしい時に選ぶモードです。

● Fast モード

エージェントが 即実行に移るモード です。

- 計画ステップを省略し、そのまま作業を開始する

- 単純で短時間で終わる作業に向いている

- スピード重視で結果を早く得たいときに便利

「とにかくすぐやってほしい」場合はこちら。

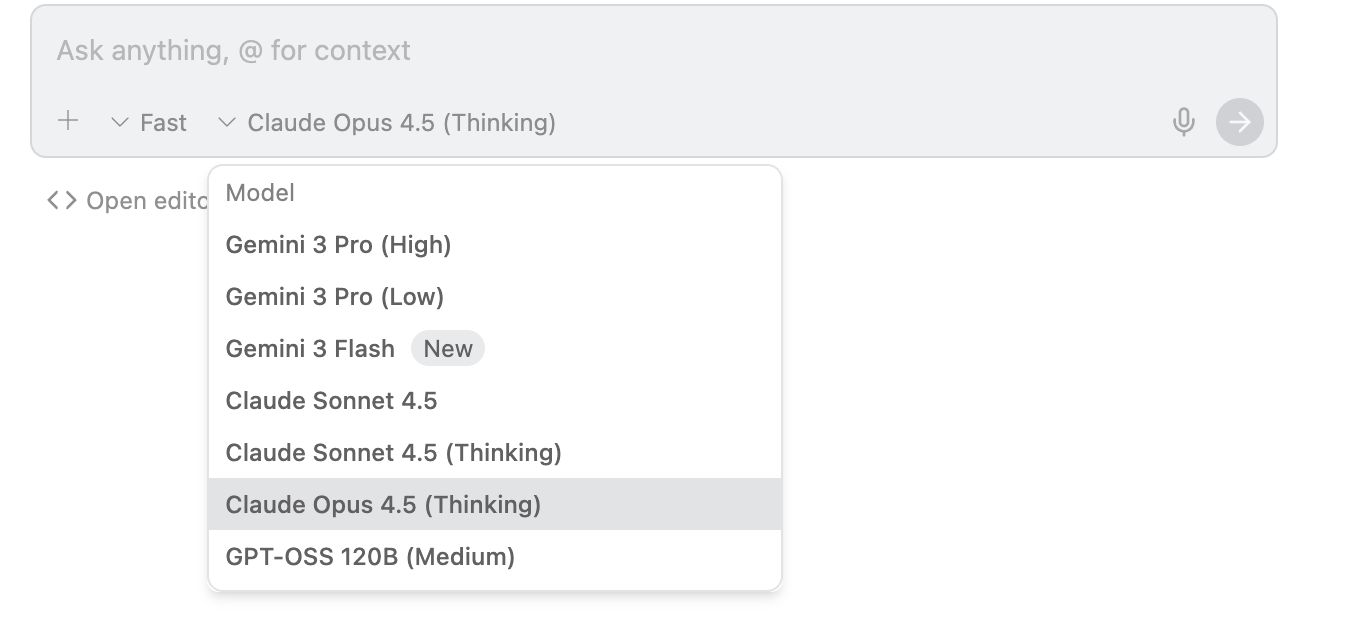

モデル一覧

Gemini 3 Pro (High)

- Googleのモデル

- 高精度で深い推論が可能

- 複雑なタスク、コード生成、高度な分析に向く

Gemini 3 Pro (Low)

- Googleのモデル

- 軽量でレスポンスが速い

- 日常的な開発作業や短めのタスクに向く

- コストと速度のバランスが良い

Gemini 3 Flash

- Googleのモデル

- レスポンスが早い

- コスト効率が高い

- なぜかGemini 3 ProよりSWE-benchのスコアが高い

- コーディング能力が高いので普段使いはこれで良い

Claude Sonnet 4.5

- Anthoropicのモデル

- 文章生成・要約が得意

- 落ち着いた応答で読みやすい結果を出す

- ドキュメント作成や説明用途にも向いている

Claude Sonnet 4.5 (Thinking)

- Anthoropicのモデル

- より深い推論に特化したモード

- 時間はかかるが、複雑な問題や設計タスクに強い

- 精密に考えてほしいケースで便利

Claude Opus 4.5 (Thinking)

- Anthoropicのモデル

- Antoropicの再高性能モデル。金額も一番高い。

- 長大なコンテキストや複数ファイル・複数サービスにまたがる設計検討に強い

- 最終兵器として使用すべし!!

GPT-OSS 120B (Medium)

- OpenAIのモデル。スペックがあれば無料でこのLLMをダウンロードできる。

- オープンソース系の大規模モデル

- 汎用性が高く、コード・文章の両方を幅広く扱える

- モデルの自由度が高く実験用途にも使いやすい

- GPT5よりは性能は落ちるがコスパは良い。

最初に要件を詰めるときはGemini3 Pro(High)を使用するのが良いと思う。コーディングしていて、何か改修をしたいと思ったときは、Gemini3 Pro(High) or Claude Sonnet 4.5 (Thinking)を使用すると精度高く改修することができる。それでもうまく動かないときは最後の砦として、Claude Opus 4.5 (Thinking)を使用するのが良い。Calude Opus 4.5はレートリミットにすぐに到達してしまう可能性があるので多用すべきではないです。コーディングをしていていてコードの解説をして欲しい時や単純な調べ物に関してはスピードとコスパの良いGemini 3 Flashを使用すべきだと思う。

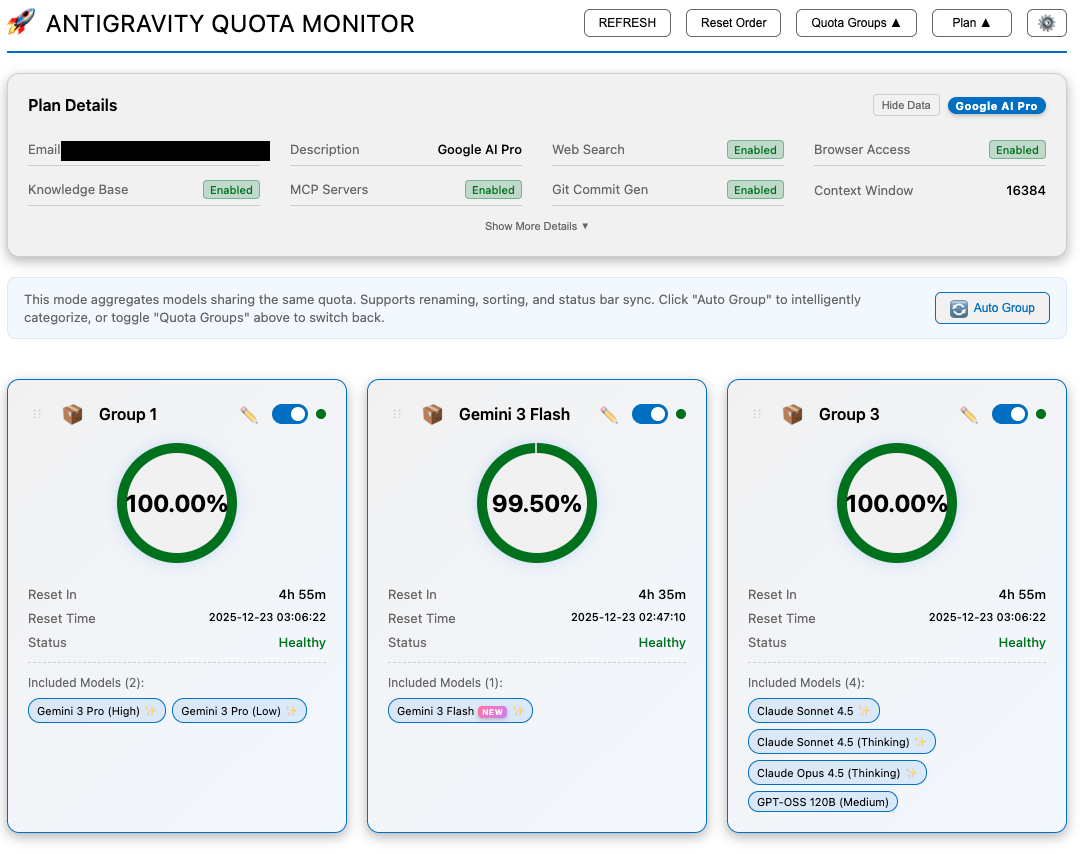

Group 分類一覧

Antigravity では、モデルの使用制限が「Group」単位で管理されています。

そのため、ある Group の制限に達しても、別 Group に属するモデルは引き続き使用可能です。

例えば、Gemini 3 Pro 系モデルを集中的に使用して Group1 の制限に達した場合でも、

Claude 系モデルや Gemini 3 Flash など、別 Group のモデルには影響しません。

逆に、Claude Opus 4.5 (Thinking) を使いすぎて Group3 の制限に達すると、

同じ Group3 に属するモデル(Claude シリーズや GPT-OSS 120B)は使用できなくなります。

- Group1:Gemini 3 Pro シリーズ

- Group2:Gemini 3 Flash

- Group3:Claude シリーズ / GPT-OSS 120B

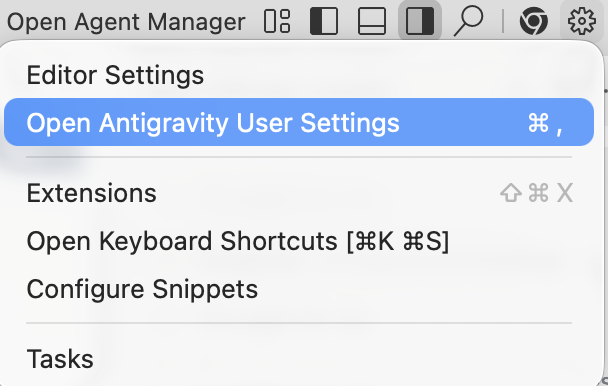

Agent Manager

Agent Managerは、ユーザーの指示のもとで動くAntigravityのエージェントたちが、どんな作業をしているかを俯瞰できる “上位レイヤーのビュー” を提供するために作られています。この画面では、複数のワークスペースをまたぎ、同時に数十のエージェントを監視したり操作したりできます。また、開発作業の多くをエージェント経由で行えるため、コードを直接書くのではなく エージェント中心の開発を実現します。

-

Inbox

AI からの提案や通知、レビュー待ちの項目を一覧で確認できる場所です。複数のタスクを同時に管理する際に便利で、承認が必要なアクションを見落とさずに確認できます。 -

Start Conversation

新しい指示やタスクを AI に送って、会話形式で開発を進めるための入口です。ここからエージェントとのセッションが始まります。 -

Workspace

プロジェクト内のタスクや進行状況をまとめて管理するメイン画面です。ファイルやフォルダ構造を確認しながら、プロジェクト全体を把握できます。 -

Playground

AI の動作を試したり、小さな実験的タスクを安全に実行できるテストエリアです。本番環境に影響を与えずに、気軽に試せるのが特徴です。 -

Browser

AI が Web ページを閲覧して調査や情報取得を行うための専用ブラウザです。リアルタイムで情報を収集し、開発に必要なデータを自動的に取得できます。

EditorとAgent Managerの切り替え

Antigravity を使ううえで、まず覚えておきたい基本操作が Editor ⇄ Agent Manager の切り替え です。

Mac: Cmd + E

Windows: Ctrl + E

Browser

Chromeブラウザを使用して、ブラウザでの動作確認テストやネット上の情報を読み込むなどしてくれる機能です。Agentが操作するブラウザにはどのアカウントにもログインしていない状態で操作されます。Antigravityが動作する環境にChromeがインストールされている必要があります。

Antigravity ブラウザーエージェントを初めて利用する場合、自動的に Chrome ウェブストアに移動して拡張機能のインストール案内が表示されます。

許可リスト/拒否リスト

- Denylist(拒否リスト) — 危険な/悪意のあるURLを拒否

- Allowlist(許可リスト) — 信頼できるURLのみ明示的に許可

拒否リストにあるURLは許可リストURLには追加することができません。拒否リストが優先されます。ブラウザが許可リストにないURLへアクセスしようとすると、「常に許可」ボタン付きのプロンプトが表示されます。「常に許可」をクリックすると、そのURLが許可リストに追加され、対象のWebページへのアクセスや操作が可能となります。

おすすめ拡張機能

Antigravity Cockpit(by jlcodes)

Antigravity Cockpit は、GUIでアカウントのプランやモデルの残容量などを確認することができます。どうしても、残りどれくらい使用できるの?と気になることが多いと思いますので直感的に確認することができるAntigravity Cockpitはおすすめです。

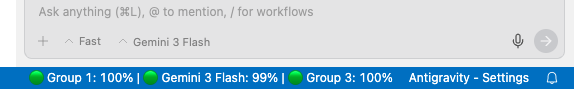

ちなみに、エディタの右下にもモデル残容量が表示されます。

FAQ

Antigravityにデータ収集されたくないときはユーザー設定からオプトアウトする必要があります。デフォルトではONになっているのデータ収集されることに注意!!

Antigrabvityを実際に試してみた!

実際にAgent Managerを使用してチャットウェブアプリを開発してみた。下記のプロンプトを使用しました。

①要件整理(ローカルで動くWebアプリ版)

1.サービス概要

ChatGPT風のUIを持つローカル専用Webアプリを作成する。ブラウザで動作、サーバーはすべてローカルPC上で完結(クラウド不使用)。各社LLMをAPI経由で呼び分け、ChatGPT風画面で統一して使えるチャットクライアント。

2.実装対象モデル

モデル名:呼び出し方式:備考

OpenAI GPT:REST API:files/vision可

Claude(Anthropic):REST API:長文対応

Gemini:REST API:画像/ファイル強い

DeepSeek:REST API:高速・大規模

XGlog:REST API:任意

※すべてAPIキーはローカル環境変数またはローカル設定ファイルに保持

3.必須機能(MVP)

3.1 Web UI(ChatGPTクローン仕様):左にチャット一覧/右にメッセージ履歴/モデル選択ドロップダウン/Markdownレンダリング/コードブロック・表対応/画像プレビュー

3.2 モデル切り替え:チャットごとにモデルを保持/UIから簡単に切り替え可能

3.3 会話管理:新規チャット/タイトル自動生成(AI要約)/履歴はローカルDB(SQLite or IndexedDB)保存

3.4 ファイル・画像アップロード:PDF、画像、テキストアップロード/LLM APIに送れる形式へ自動変換(base64等)

3.5 ローカル実行要件:ローカルサーバー(Node.js)起動/ブラウザから http://localhost:3000 などでアクセス/APIキーは.envまたはローカル設定画面に保存(絶対に外部送信しない)

4.推奨技術スタック

フロント(Web):Next.js/React/Tailwind CSS/Markdownレンダラー(react-markdown)

バックエンド(ローカルサーバー):Node.js/Express/SQLite(better-sqlite3)/API呼び出し:axios

しばらくすると完了してWalkthroughが出てきました

これに従って、セットアップしていくと・・・

素晴らしい!それっぽい画面が作成されています。

LLMのAPI Keyを入力して試してみたところ、残念ながら失敗しました。

画面を日本語にするようAgentにお願いしたり、Agentにプログラムを修正させたりしたら無事作成することができました。素晴らしい!!

参考

最後に

Antigravityの完成度の高さに驚きました。さすがGoogleさん!!AIを制するのはGoogleだと私は思っています。AI時代において戦略的にスピーディーに学習する大切さを日々感じています。圧倒的な資金と知能を持つGoogle製品の学習をすることは将来への大きな投資になると思っています。Googleさん、次はAIブラウザを期待していますよ!!本記事を読んでくださった方に少しでも役に立っていれば嬉しく思います。ありがとうございました。