本記事は古いIBM CloudのVCS環境(vSphere 6.5ベース)を順次最新化してますにおける作業の一環である。

1. サーバーを注文する

既存環境と同一Primary Sunbetを指定する。こことは違って、今回はVMware Solutions DedicatedのvSphere(VSS)を利用して注文する。

- クラスター名は適当で良い(この名前が実際のESXi環境に反映される訳ではなく、注文時のテンプレート名称に過ぎないので)。

- ESXi 7.0u3を選択。

- 既存ノードと同一DC/Podを選択し、CPU/Memoryを選択。

- 既存ノードと同一VLAN/subnetを選択。

これにより、esx7host000.vcs65.ibm.localというサーバーがプロビジョニングされる。

2. Secondary Private VLANのトランク

こことは違って、注文時に指定したSecondary VLANがトランクされてプロビジョニングされてくるので対応不要。

3. ESXiへのパッチ適用

最新化されているので実施せず。

[ibmvmadmin@esx7host000:~] vmware -v

VMware ESXi 7.0.3 build-19898904

4. ESXiでのパラメーター変更

以下docsを参考。IBM CloudのVCSでは以下のパラメーターが変更されている。

https://kb.vmware.com/s/article/1038578?lang=en_us

https://cloud.ibm.com/docs/vmwaresolutions?topic=vmwaresolutions-vc_bom

VSSであってもデフォルトでは設定されていないようなので、以下の設定を行う。

esxcli system settings advanced set -o "/NFS/MaxVolumes" -i 256

esxcli system settings advanced set -o "/NFS41/MaxVolumes" -i 256

esxcli system settings advanced set -o "/NFS/HeartbeatMaxFailures" -i 10

esxcli system settings advanced set -o "/NFS/HeartbeatFrequency" -i 12

esxcli system settings advanced set -o "/NFS/HeartbeatTimeout" -i 5

esxcli system settings advanced set -o "/NFS/MaxQueueDepth" -i 64

esxcli system settings advanced set -o "/Disk/QFullSampleSize" -i 32

esxcli system settings advanced set -o "/Disk/QFullThreshold" -i 8

esxcli system settings advanced set -o "/Net/TcpipHeapSize" -i 32

esxcli system settings advanced set -o "/Net/TcpipHeapMax" -i 1536

esxcli system settings advanced set -o "/Net/BlockGuestBPDU" -i 1

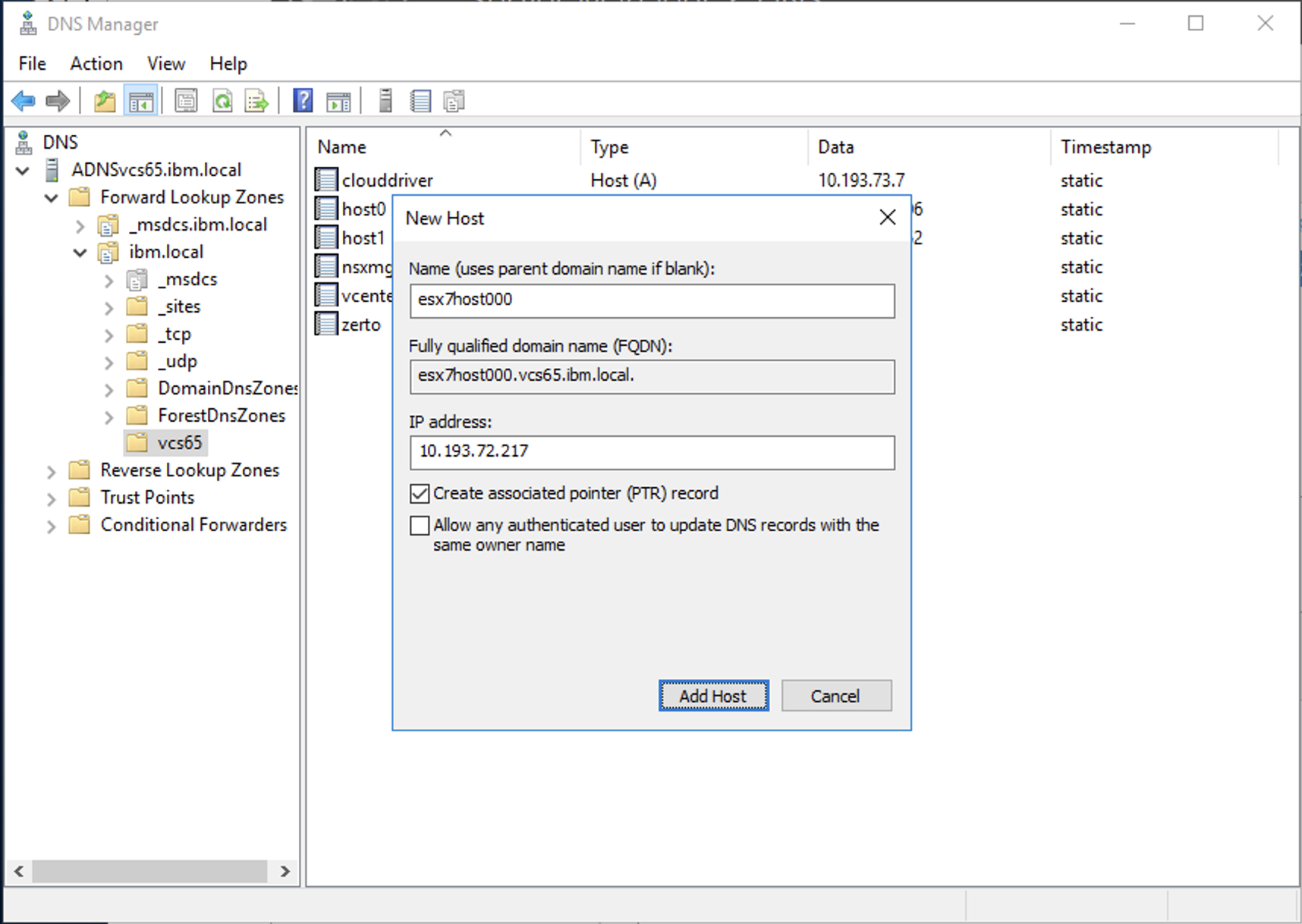

5. DNSレコードの追加

VCSのAD/DNSサーバーで、追加するホストのAレコード/PTRレコードを追加する。

C:\Users\Administrator>nslookup esx7host000.vcs65.ibm.local

Server: localhost

Address: 127.0.0.1

Name: esx7host000.vcs65.ibm.local

Address: 10.193.72.217

C:\Users\Administrator>nslookup 10.193.72.217

Server: localhost

Address: 127.0.0.1

Name: esx7host000.vcs65.ibm.local

Address: 10.193.72.217

6. クラスターへのノード追加

- DRSは止めておく。稼働中にVMが移動されては困るので。VMware DRS (Distributed Resource Scheduler)を停止/再開する方法

- Add Host

- 追加するサーバーのFQDN, ID, Passwordを指定。

- Accept

- NEXT

- FINISH

- VSSで購入したライセンスも、適用された状態のままクラスターに追加される。

7. 分散スイッチにvmnicを追加

SDDC-Dswitch-Privateにvmnic0/vmnic2を割り当てる。

- Maintenance Modeにする

-

SDDC-Dswitch-Privateを右クリックして、Add and Manage Hostsを選択

- Add hosts

-

New hostsから新規ノードを追加。

- 1台目のESXiと併せて、vmnic2をuplink1に、vmnic0をuplink2に割り当てる。

- ASSIGN PORT GROUP

- NEXT

-

SDDC-DPortGroup-Mgmtを選択してASSIGN

- NEXT

- NEXT

- FINISH

- 結果

同様に、SDDC-Dswitch-Publicにvmnic1/vmnic3を割り当てる。

-

SDDC-Dswitch-Publicを右クリックして、Add and Manage Hostsを選択

- Add hosts

-

New hostsから新規ノードを追加。

- vmnic1をuplink1に、vmnic3をuplink2に割り当てる。

- このままNEXT

- NEXT

- FINISH

- 結果

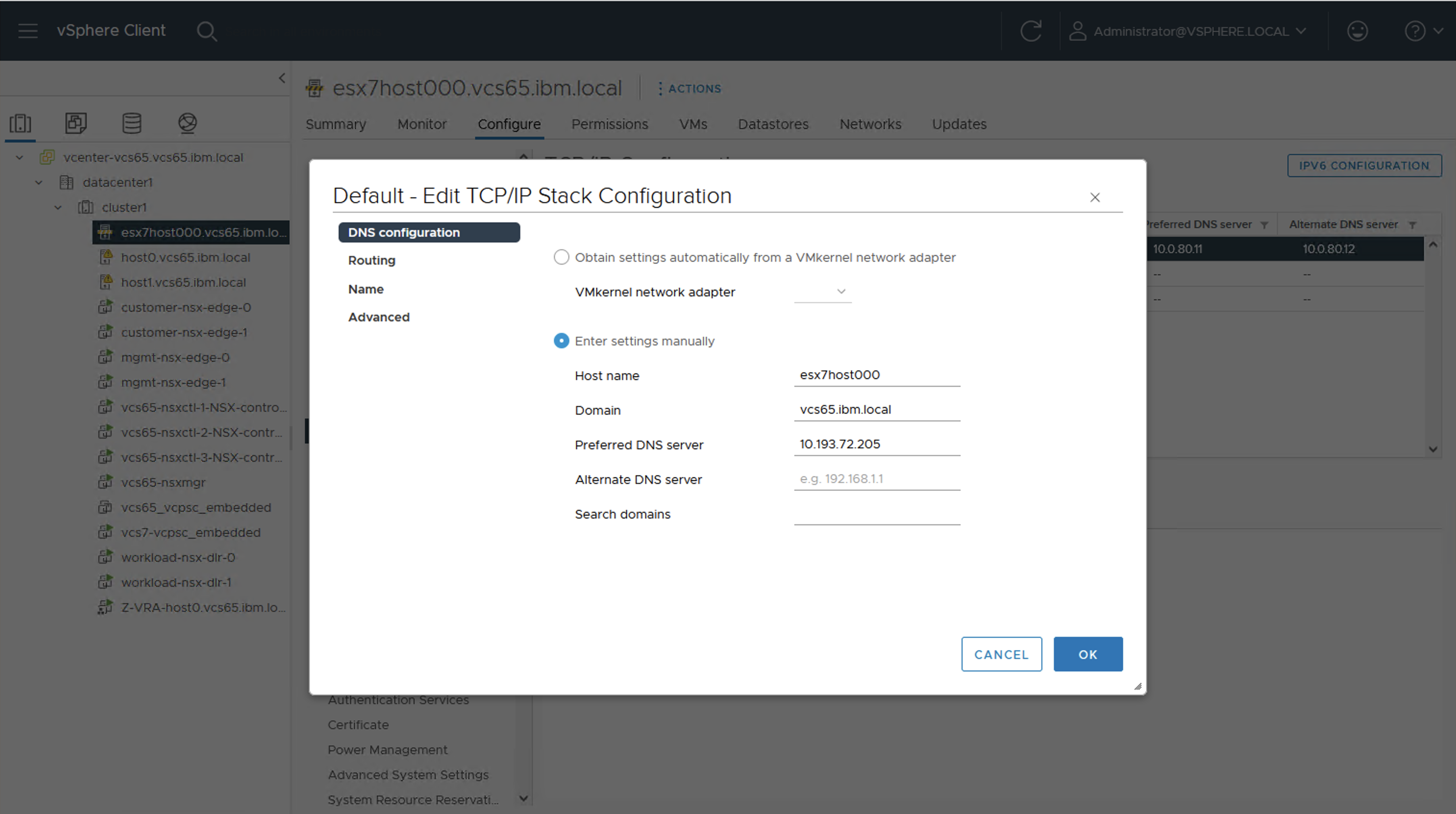

8. DNSの変更

デフォルトでは、IBM Cloud提供の10.0.80.11/10.0.80.12を利用しているので、AD/DNSサーバーを利用するように変更する。

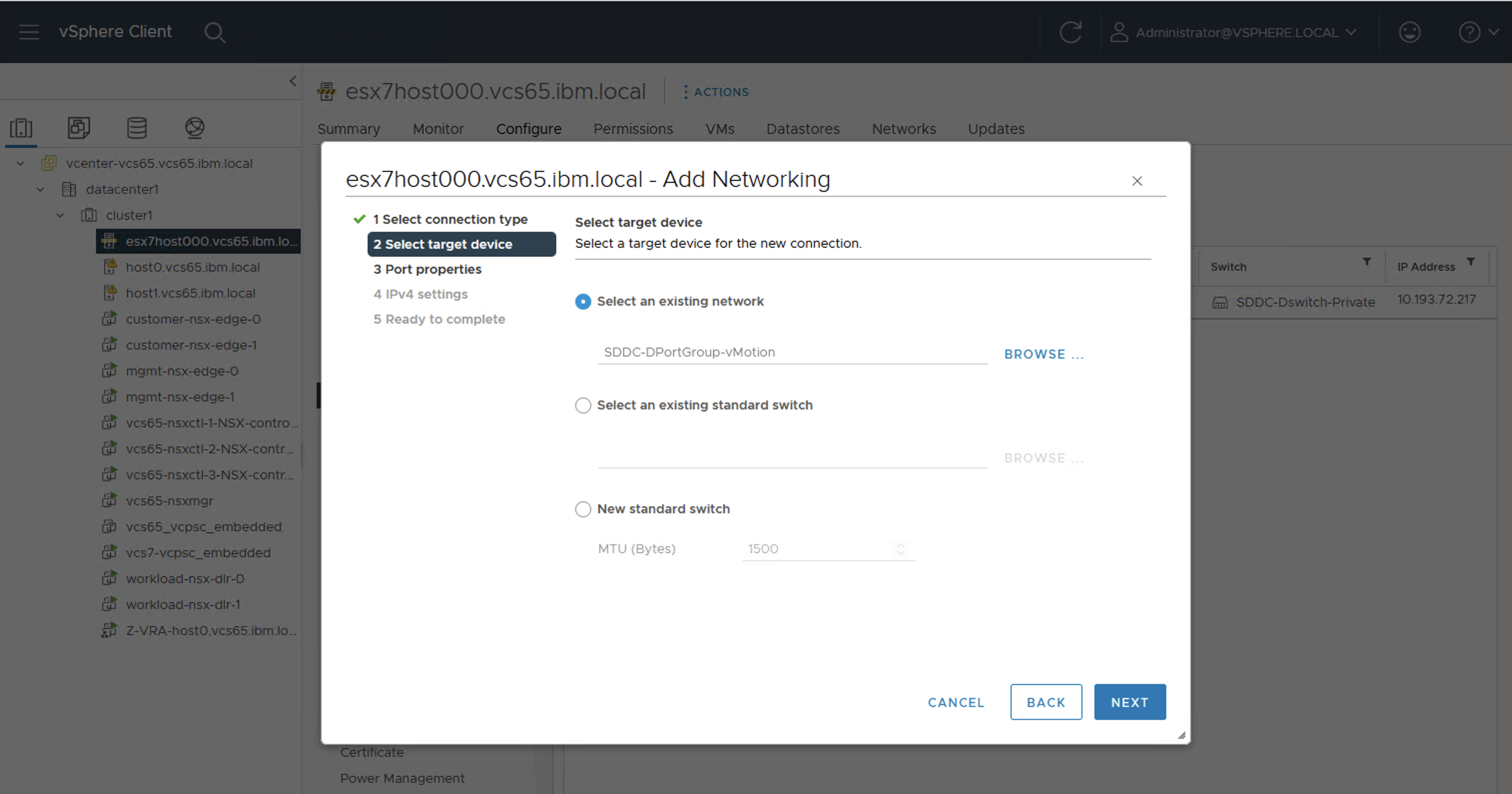

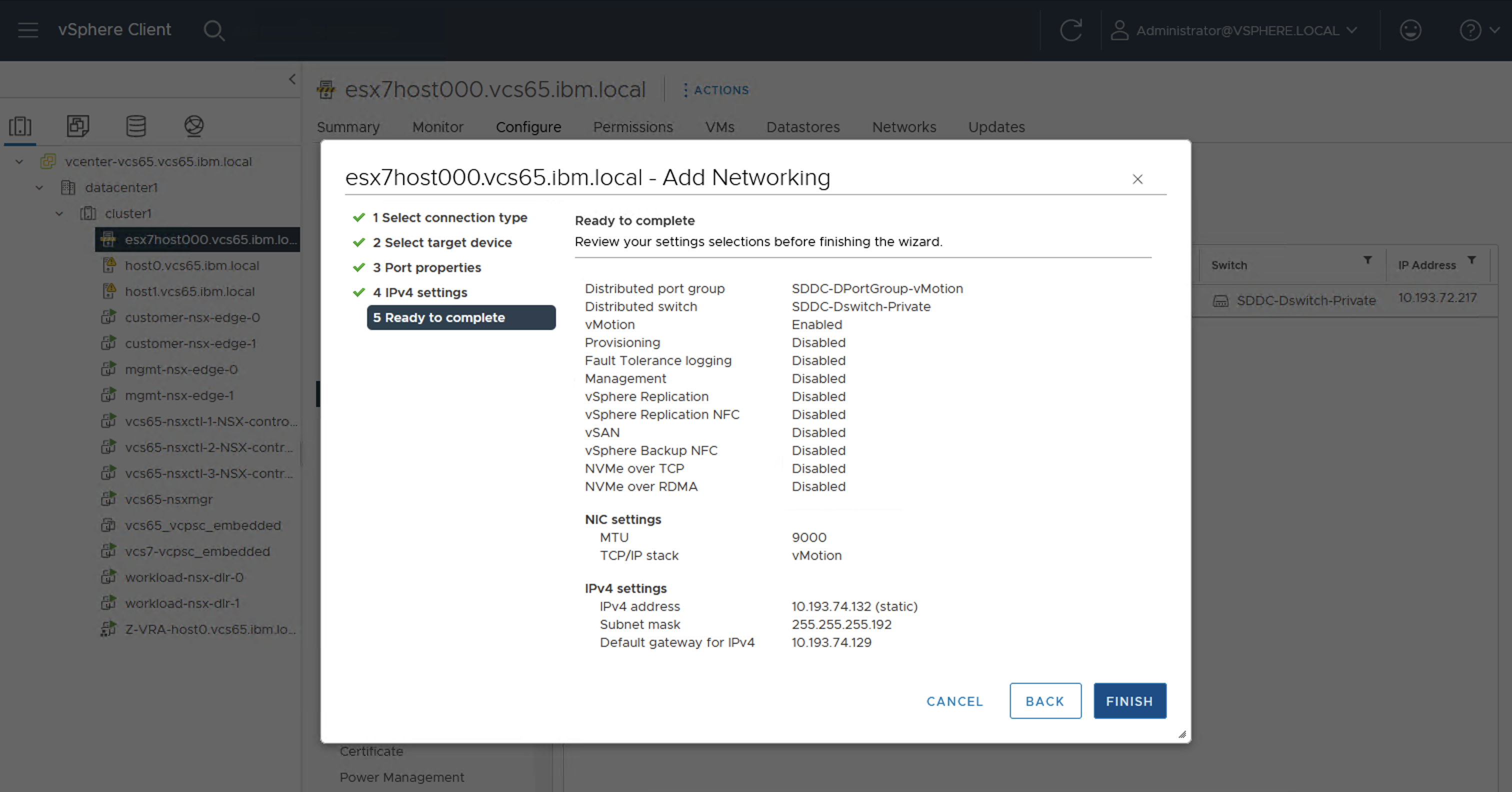

9. VMKernelの作成

既存の1台しか存在しないESXiホストのIPアドレス構成は以下のようであった。

[root@host0:~] esxcfg-vmknic -l |grep -e Interface -e IPv4

Interface Port Group/DVPort/Opaque Network IP Family IP Address Netmask Broadcast MAC Address MTU TSO MSS Enabled Type NetStack

vmk0 1 IPv4 10.193.72.206 255.255.255.192 10.193.72.255 00:50:56:6a:25:55 9000 65535 true STATIC defaultTcpipStack

vmk2 48 IPv4 10.193.74.2 255.255.255.192 10.193.74.63 00:50:56:6e:ff:ad 9000 65535 true STATIC defaultTcpipStack

vmk3 32 IPv4 10.193.74.66 255.255.255.192 10.193.74.127 00:50:56:6b:2f:da 9000 65535 true STATIC defaultTcpipStack

vmk6 115 IPv4 10.193.75.66 255.255.255.224 10.193.75.95 00:50:56:69:47:e7 9000 65535 true STATIC defaultTcpipStack

vmk7 128 IPv4 10.193.75.67 255.255.255.224 10.193.75.95 00:50:56:64:d7:67 9000 65535 true STATIC defaultTcpipStack

vmk4 66 IPv4 10.193.73.130 255.255.255.128 10.193.73.255 00:50:56:61:26:2f 9000 65535 true STATIC vxlan

vmk5 67 IPv4 10.193.73.131 255.255.255.128 10.193.73.255 00:50:56:6b:1e:a4 9000 65535 true STATIC vxlan

vmk1 16 IPv4 10.193.74.130 255.255.255.192 10.193.74.191 00:50:56:62:e9:38 9000 65535 true STATIC vmotion

[root@host0:~] esxcli network ip route ipv4 list

Network Netmask Gateway Interface Source

------------- --------------- ------------- --------- ------

default 0.0.0.0 10.193.72.193 vmk0 MANUAL

10.193.72.192 255.255.255.192 0.0.0.0 vmk0 MANUAL

10.193.74.0 255.255.255.192 0.0.0.0 vmk2 MANUAL

10.193.74.64 255.255.255.192 0.0.0.0 vmk3 MANUAL

10.193.75.64 255.255.255.224 0.0.0.0 vmk6 MANUAL

10.201.206.0 255.255.255.0 10.193.74.65 vmk3 MANUAL

10.201.206.37 255.255.255.255 10.193.75.65 vmk6 MANUAL

10.201.206.47 255.255.255.255 10.193.75.65 vmk6 MANUAL

この環境はvSphere6.5ベースのVCSであり、すでにautomationはサポートされていないため、IBM Cloudによってこれらのsubnet上のIPが割り当てられる心配はない。よって、vMotion/vSAN/NFSは既存環境と同一portable subnet内から連番でIPアドレスを割り当てた。その結果、以下のようなIPアドレス体系になった(多分こういう表を作業前に作っておいた方が良いのでまとめた)。

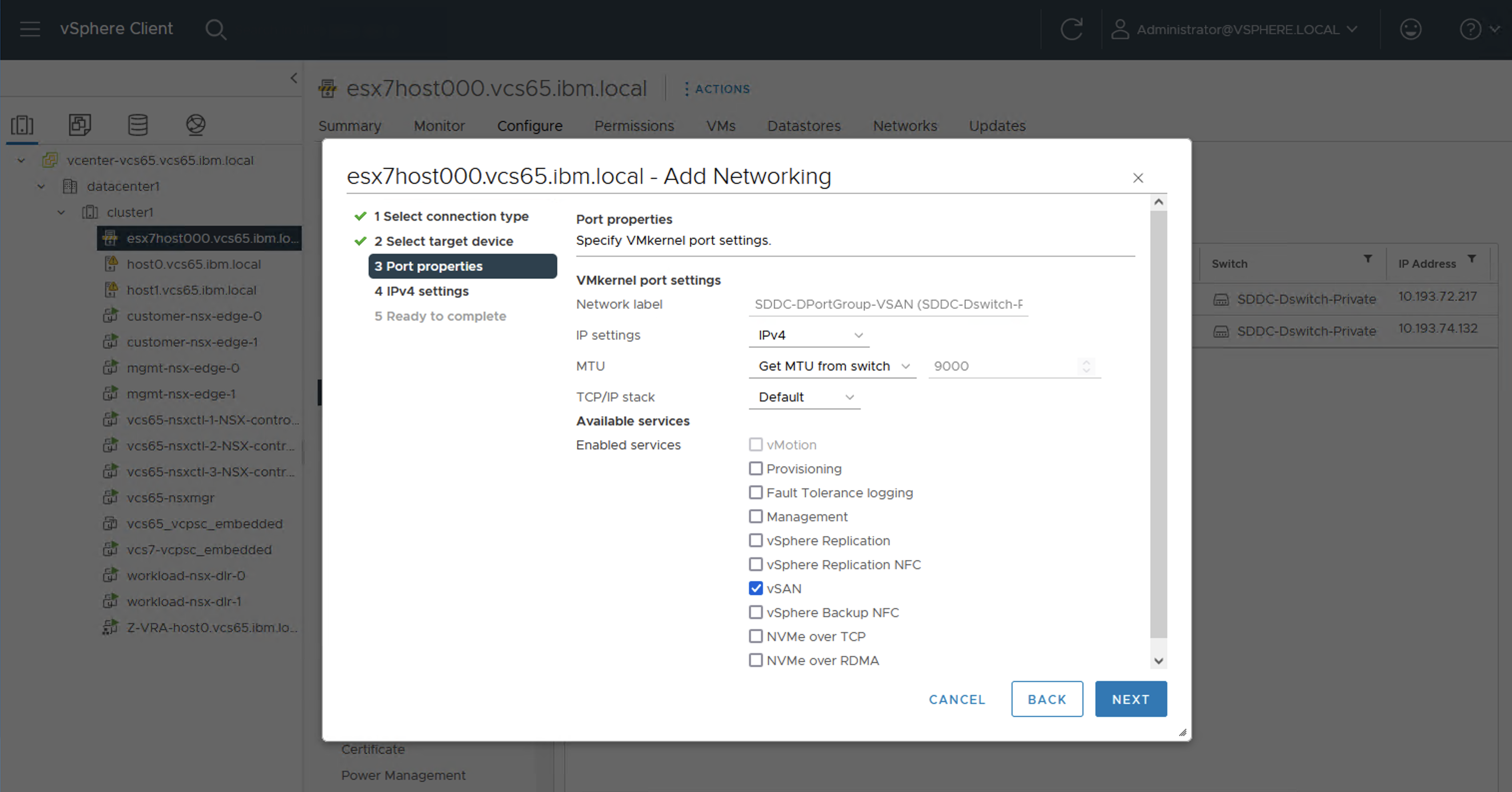

vSANは利用していないのでvmk2は削除しても良いのだが、今回は手順を確認する意味も兼ねて追加しておいた。

| vmkernel | Enabled Service | PortGroup | IP Address(1台目) | IP Address(2台目) | IP Address(追加分) | subnnt mask | default gateway |

|---|---|---|---|---|---|---|---|

| vmk0 | Management | SDDC-DPortGroup-Mgmt | 10.193.72.206 | 10.193.72.252 (ESXiをプロビジョニングする時にprimary subnetから自動割り当て) |

10.193.72.217 (ESXiをプロビジョニングする時にprimary subnetから自動割り当て) |

255.255.255.192 | 10.193.72.193 |

| vmk1 | vMotion | SDDC-DPortGroup-vMotion | 10.193.74.130 | 10.193.74.131 | 10.193.74.132 | 255.255.255.192 | 10.193.74.129 |

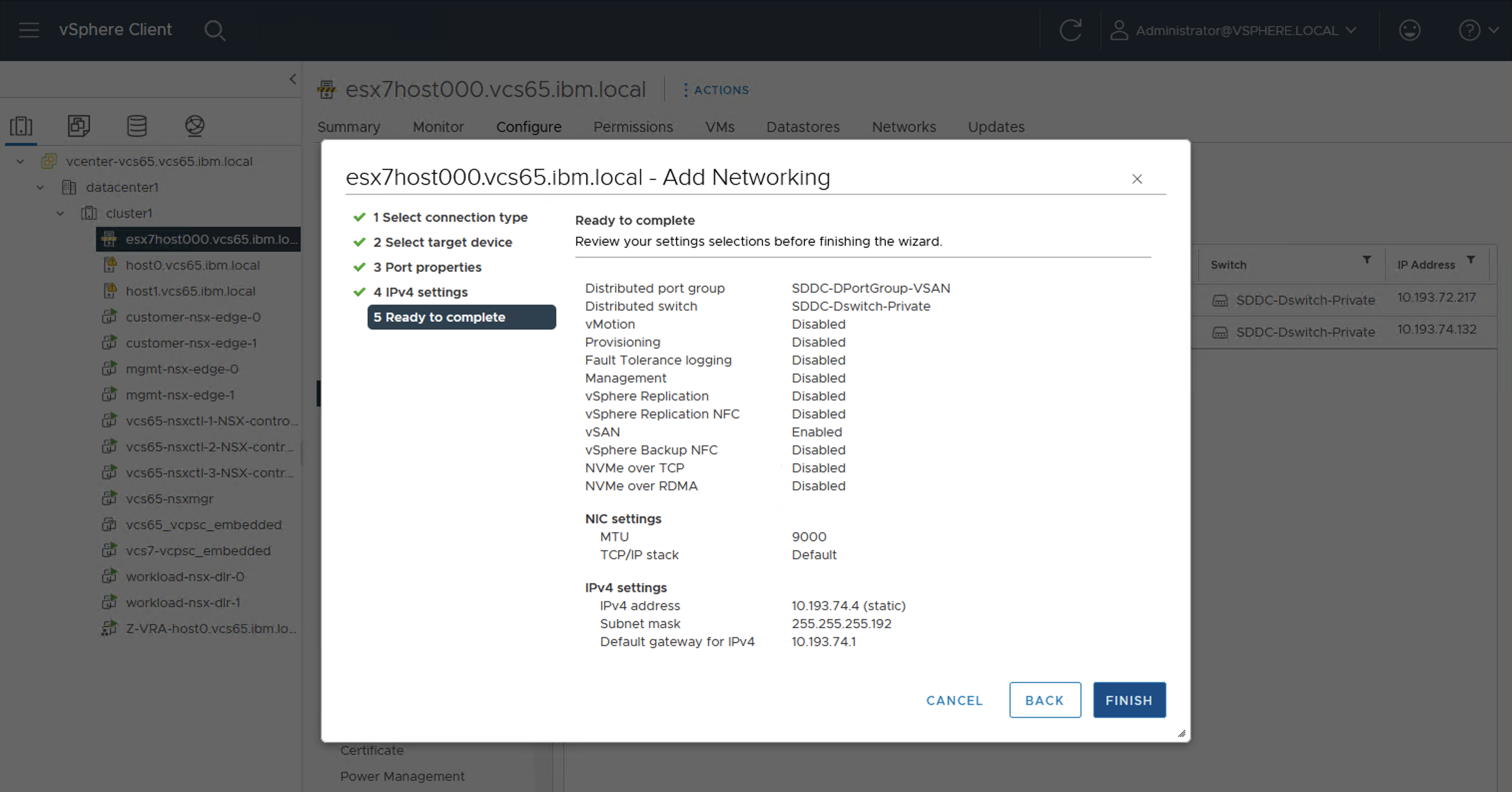

| vmk2 | vSAN | SDDC-DPortGroup-VSAN | 10.193.74.2 | 10.193.74.3 | 10.193.74.4 | 255.255.255.192 | 10.193.74.1 |

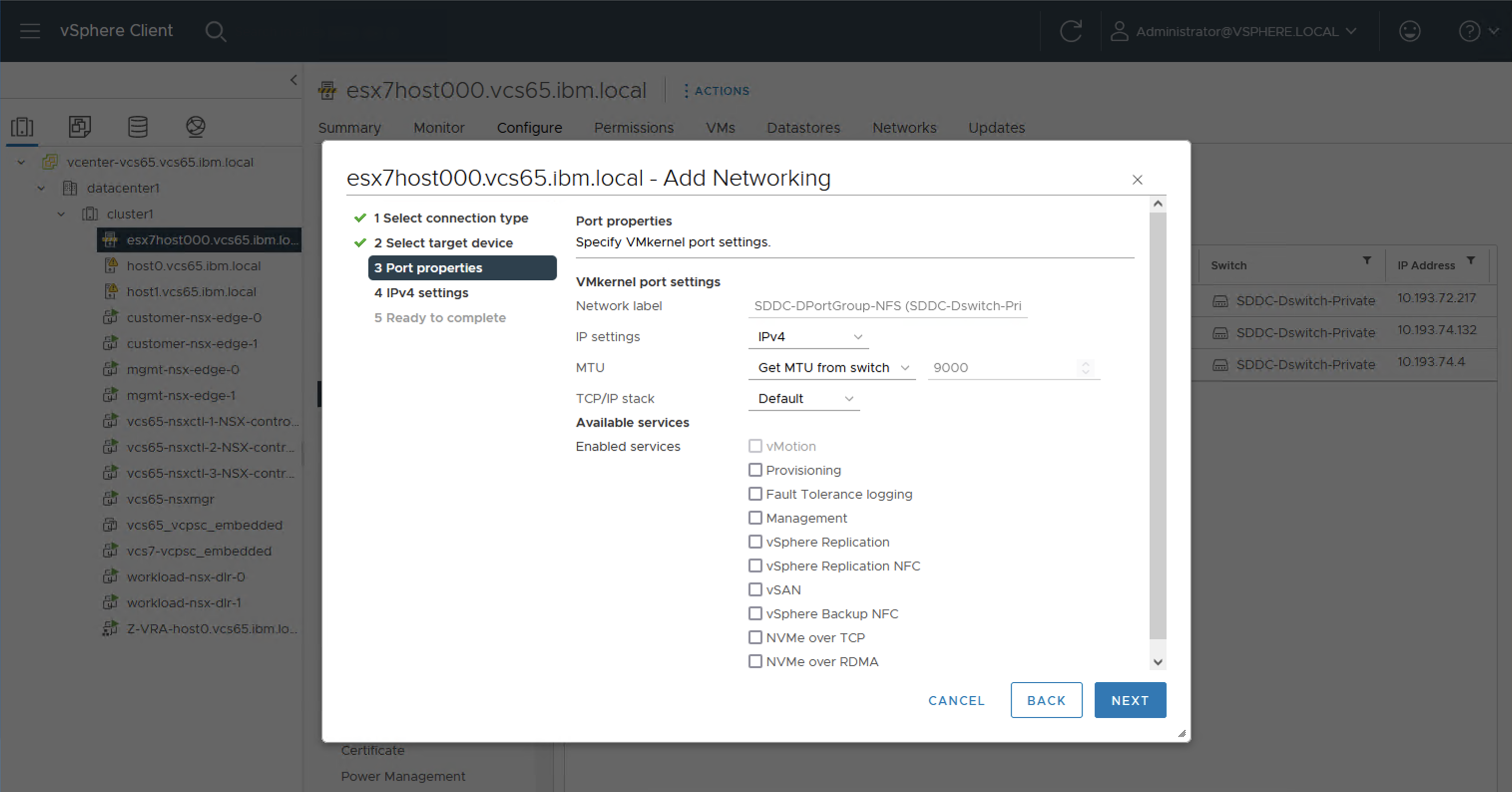

| vmk3 | -- | SDDC-DPortGroup-NFS | 10.193.74.66 | 10.193.74.67 | 10.193.74.68 | 255.255.255.192 | 10.193.74.64 |

| vmk4 | vxlan | vxw-vmknicPg-dvs-xx | 10.193.73.130 (NSX構成時にIP Poolから自動的に割り当てられる) |

10.193.73.132 (NSX構成時にIP Poolから自動的に割り当てられる) |

10.193.73.134 (NSX構成時にIP Poolから自動的に割り当てられる) |

255.255.255.128 | 10.193.73.129 |

| vmk5 | vxlan | vxw-vmknicPg-dvs-xx | 10.193.73.131 (NSX構成時にIP Poolから自動的に割り当てられる) |

10.193.73.133 (NSX構成時にIP Poolから自動的に割り当てられる) |

10.193.73.135 (NSX構成時にIP Poolから自動的に割り当てられる) |

255.255.255.128 | 10.193.73.129 |

| vmk6 | -- | SDDC-DPortGroup-iSCSI-A(過去に手動で作成したもの。今回は移行対象外) | 10.193.75.66 | N/A | N/A | 255.255.255.224 | 10.193.75.65 |

| vmk7 | -- | SDDC-DPortGroup-iSCSI-B(過去に手動で作成したもの。今回は移行対象外) | 10.193.75.67 | N/A | N/A | 255.255.255.224 | 10.193.75.65 |

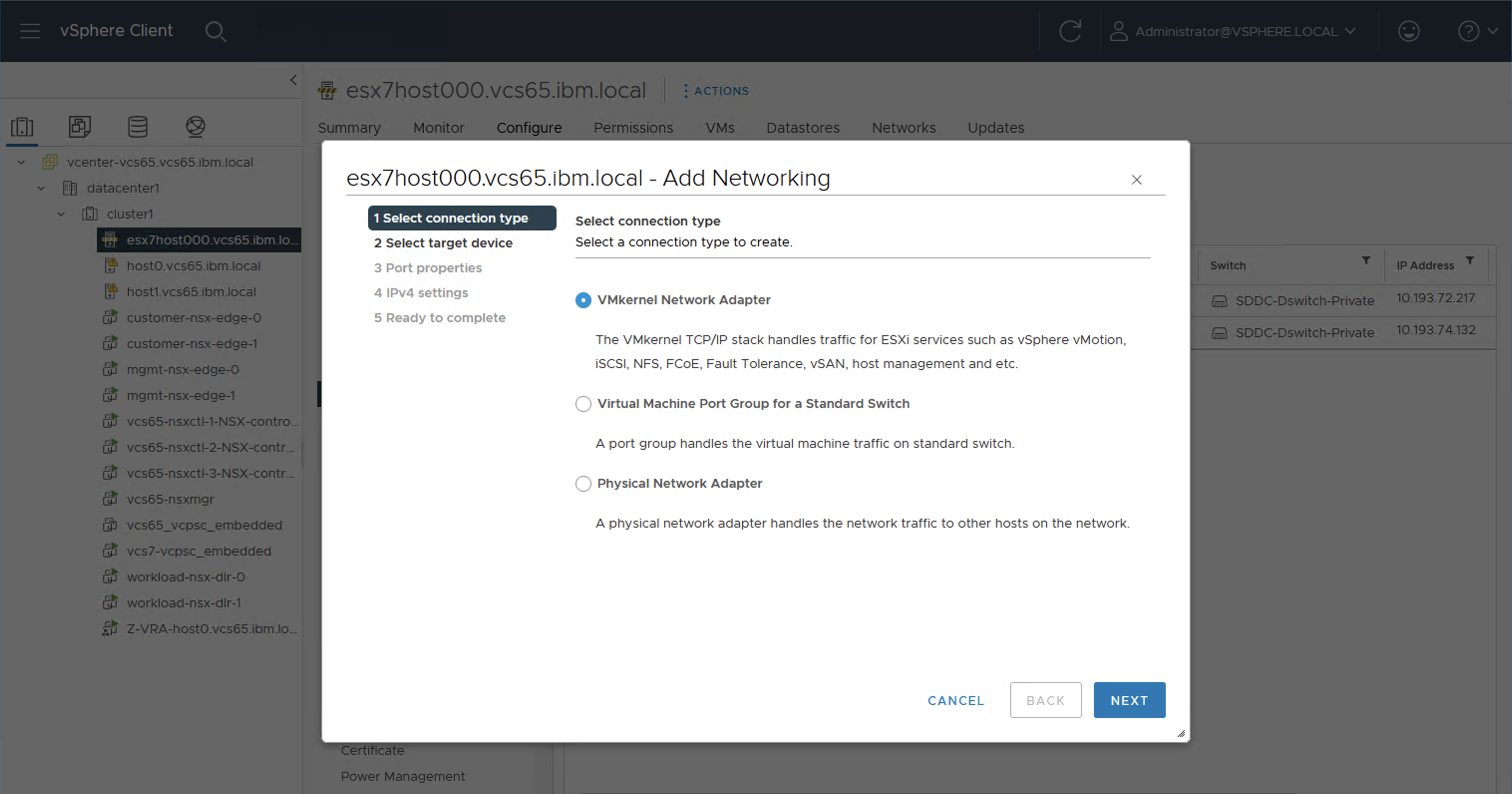

9-1. vMotion用vmkernel(vmk1)の作成

9-2. vSAN用vmkernel(vmk2)の作成

9-3. NFS用vmkernel(vmk3)の作成

9-4. VXLAN用vmkernel(vmk4, vmk5)の作成

NSX構成時に自動作成されるので、ここでは何もしない。

10. File Storage(NFS)のマウント

10-1. NFS用vmkernelを利用するように経路情報を追加

現状のままでは、外部ネットワークへの通信はdefault gatewayを経由するため、Primary VLAN/vmk0が利用される。File Storage(NFS)へのアクセス時には、Secondary VLAN/vmk3を利用するように、static routeを追加する。

[root@esx7host000:~] esxcli network ip route ipv4 add --gateway 10.193.74.65 --network 10.201.206.0/24

[root@esx7host000:~] esxcli network ip route ipv4 list

Network Netmask Gateway Interface Source

------------- --------------- ------------- --------- ------

default 0.0.0.0 10.193.72.193 vmk0 MANUAL

10.193.72.192 255.255.255.192 0.0.0.0 vmk0 MANUAL

10.193.74.0 255.255.255.192 0.0.0.0 vmk2 MANUAL

10.193.74.64 255.255.255.192 0.0.0.0 vmk3 MANUAL

10.201.206.0 255.255.255.0 10.193.74.65 vmk3 MANUAL

既存のFile Storageにpingできることを確認。

[root@esx7host000:~] ping fsf-tok0501b-fz.service.softlayer.com

PING fsf-tok0501b-fz.service.softlayer.com (10.201.206.40): 56 data bytes

64 bytes from 10.201.206.40: icmp_seq=0 ttl=61 time=4.313 ms

64 bytes from 10.201.206.40: icmp_seq=1 ttl=61 time=0.324 ms

64 bytes from 10.201.206.40: icmp_seq=2 ttl=61 time=0.296 ms

--- fsf-tok0501b-fz.service.softlayer.com ping statistics ---

3 packets transmitted, 3 packets received, 0% packet loss

round-trip min/avg/max = 0.296/1.644/4.313 ms

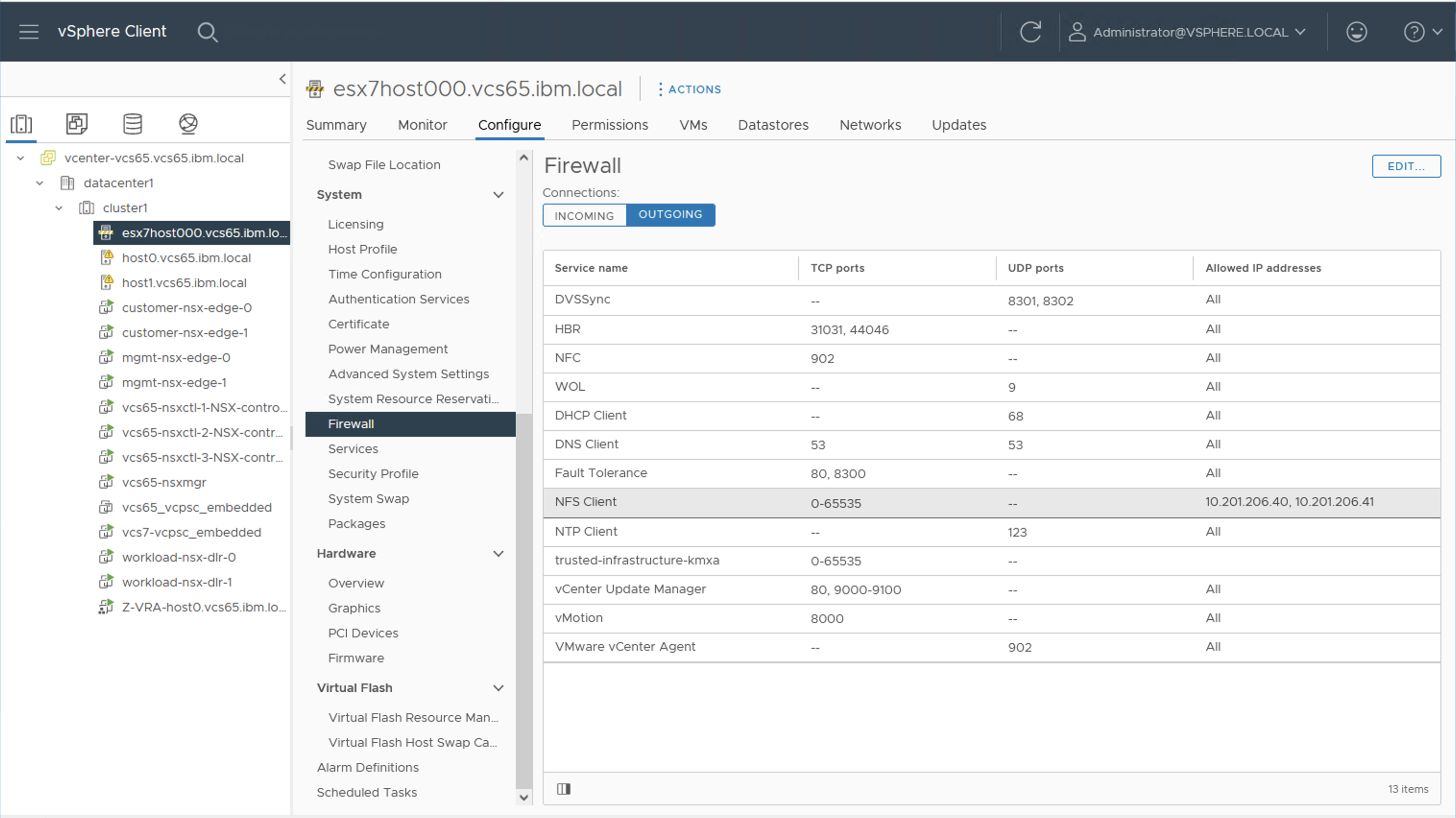

10-2. Allowed Hostsの確認。

VCSで使われているFile StorageおよびそのFile Storageは、vCenterの以下から確認できる。

また、このストレージのAuthorized Hostsでvmk3で構成したネットワークからのアクセスが許可されている。

10-3. 共有ストレージのマウント

management-shareやworkload_share_xxxxなどの共有ディスクをマウントする。

- 現行のESXiだけがHosts一覧に載っている。Actionsから、

Mount Datastore to Addtional Hosts...を選択。

- 今回追加するホストを選択。

- 追加された

- 同様に他のFile Storage(NFS)も構成する。ホストを追加した結果。追加した結果。

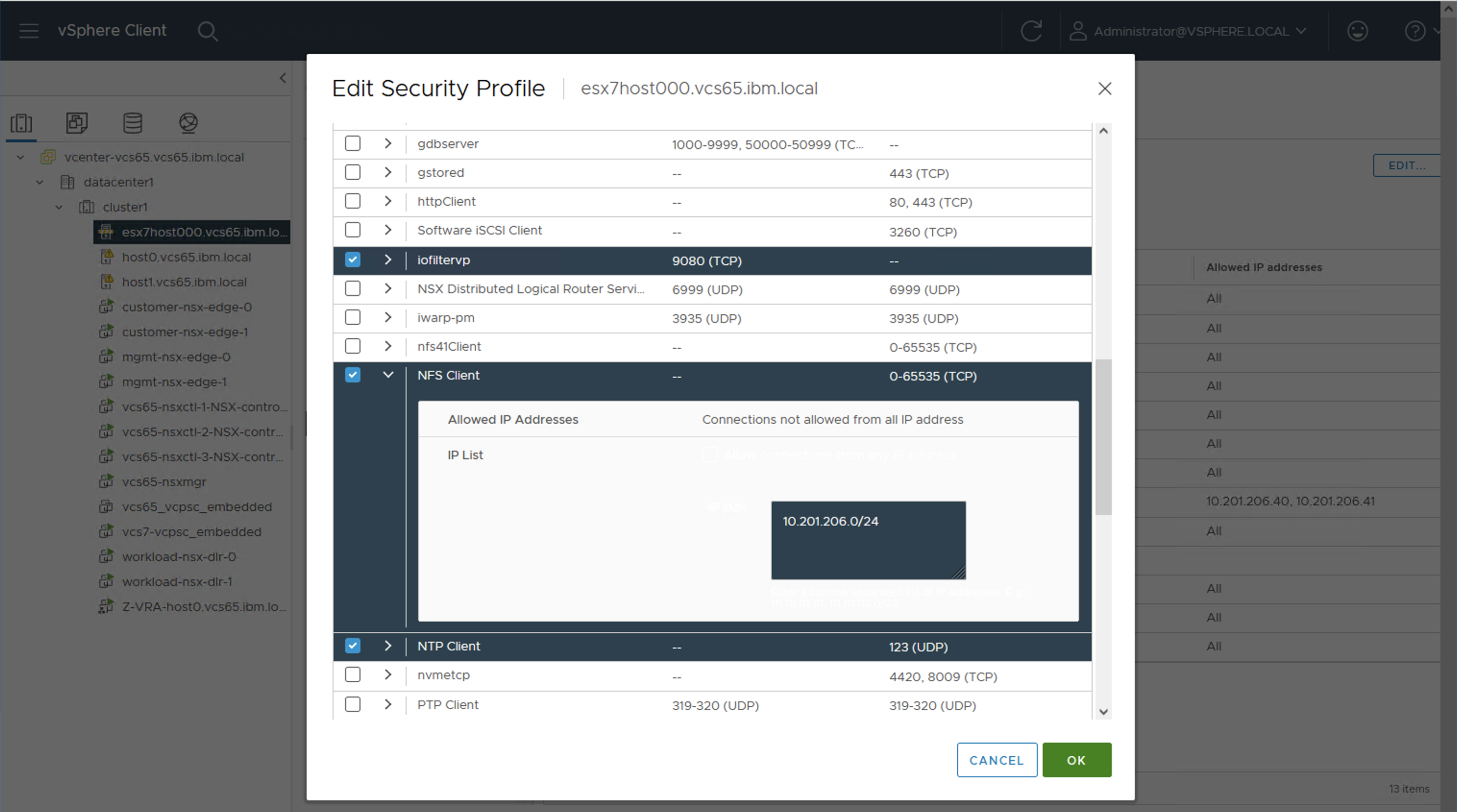

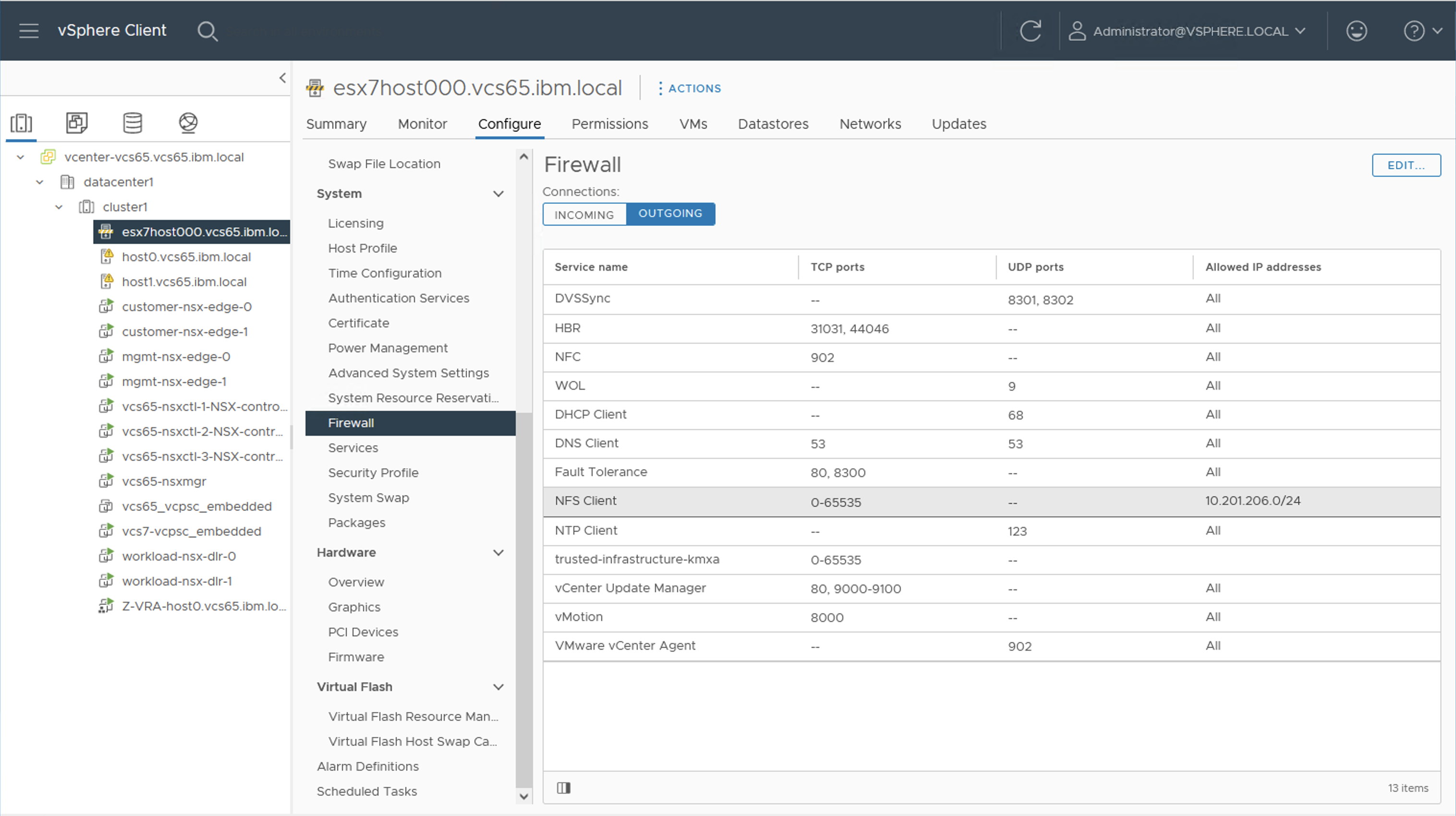

10-4. NFS Client用にESXi Firewallを修正

NFS Clientの許可IPアドレスが単独のアドレス(今回のFile Storageの名前解決時に利用されたIP)で構成されているので、将来的にFile StorageのIPアドレスが変更した際にも対応できるようにsubnet指定に変更。こちらの記事も参照。

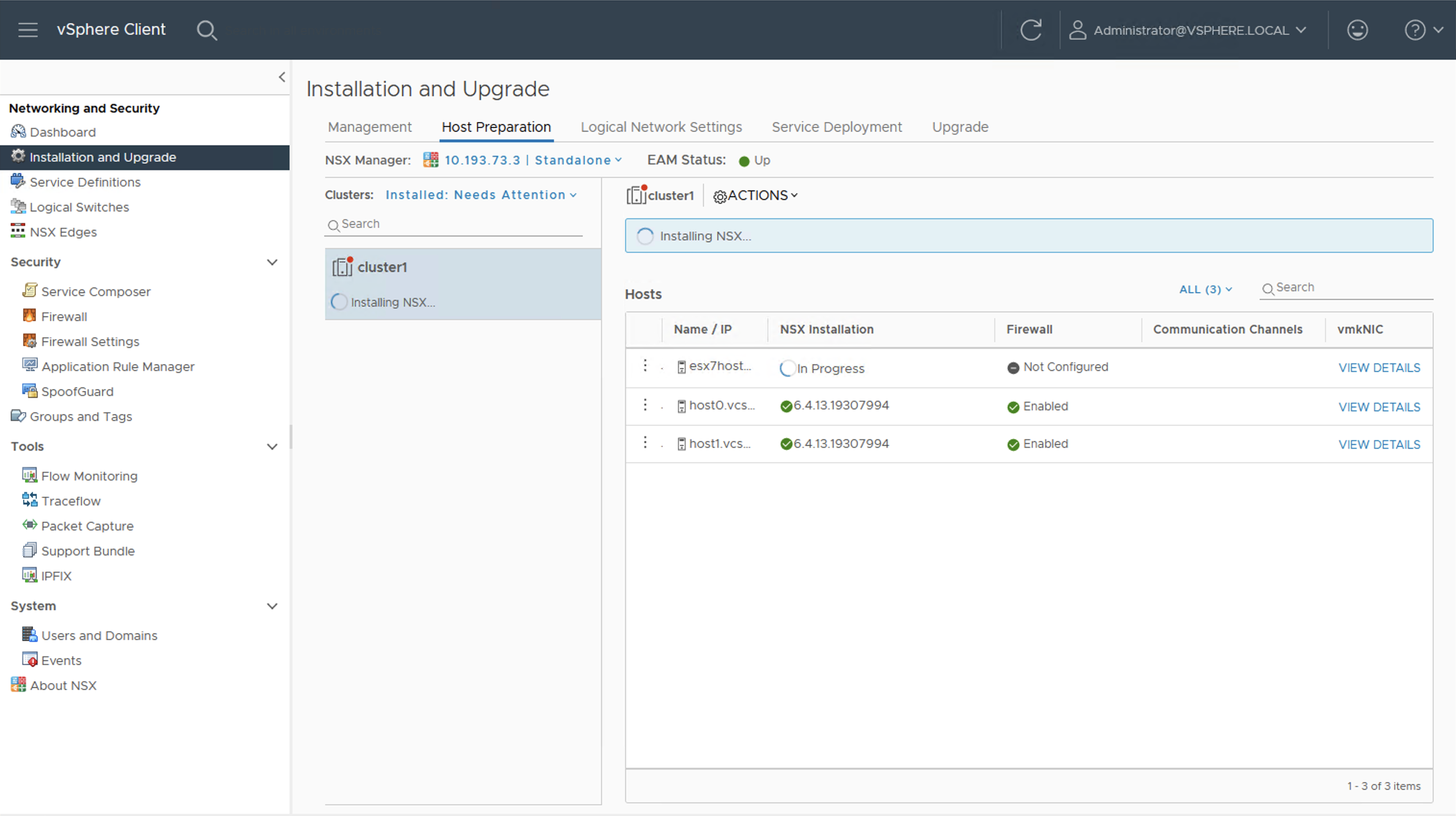

11. NSX for vSphereの構成

-

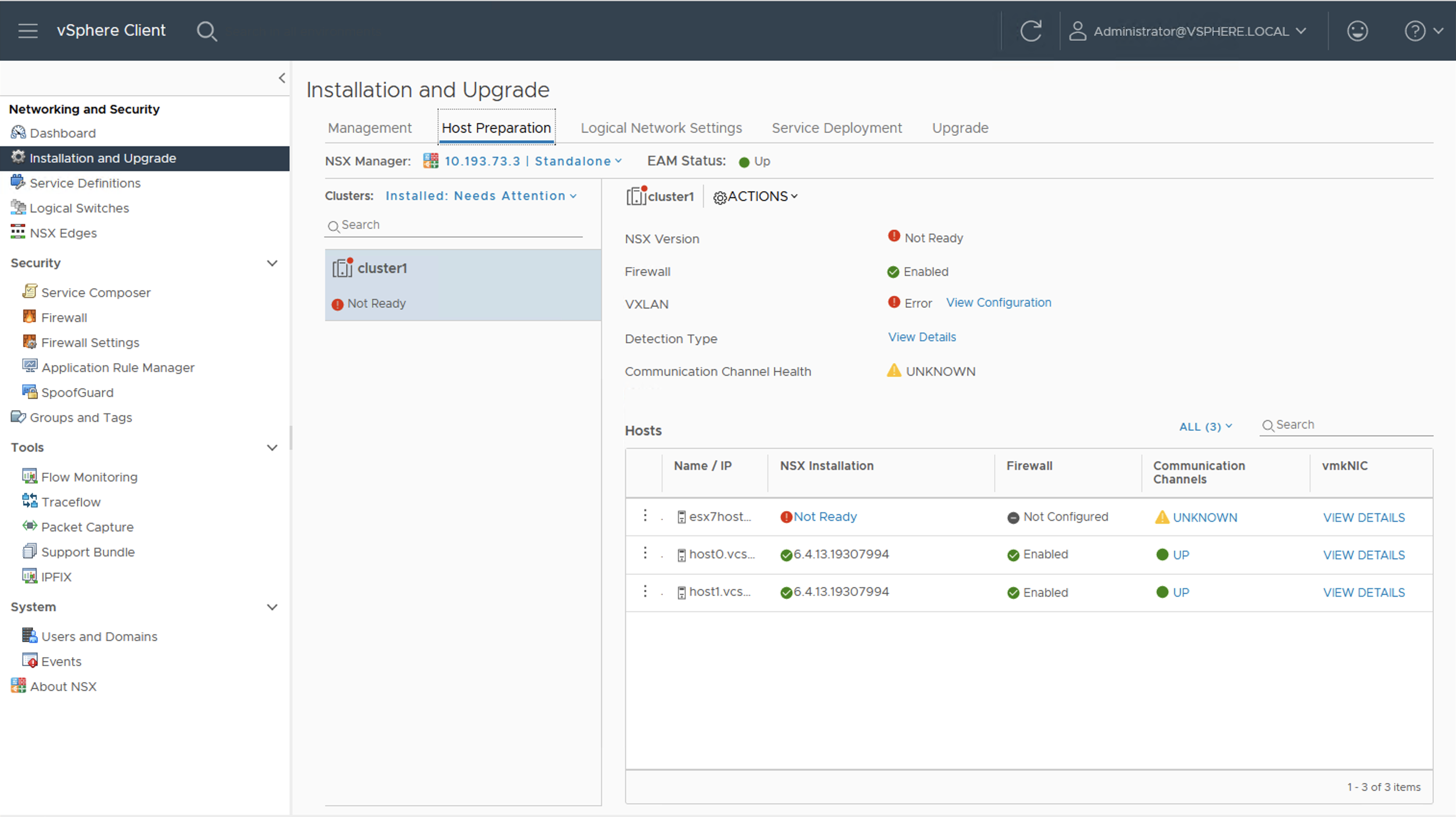

Host Preparationを確認。追加したESXiホストではNSX for vSphereの構成が完了していないため、Cluster全体としてはNot readyとなっている。

-

View Configurationを確認。VTEPとして先述のIP Poolを利用していて、2つのVTEPをSRCIDでロードバランシングするポリシーであることが以下から確認できる。

-

Not Readyを押下し、そこで現れる

RESOLVE ALLを押下。これによりNSX for vSphereがESXiに導入開始される。

12. テスト

以上にて作業は完了したので、

- メンテナンスモードを抜ける。(手順省略)

- 新ホストにvMotionができることを確認。(手順省略)