LLMの進化がすごいです。

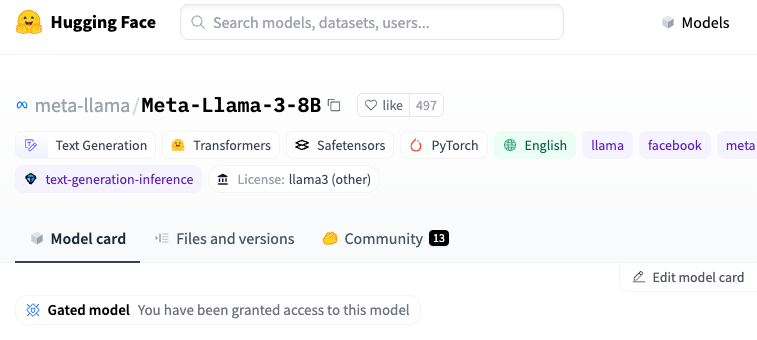

こちらからモデルへのアクセスを申請します。氏名、誕生日、国、所属などを入力します。

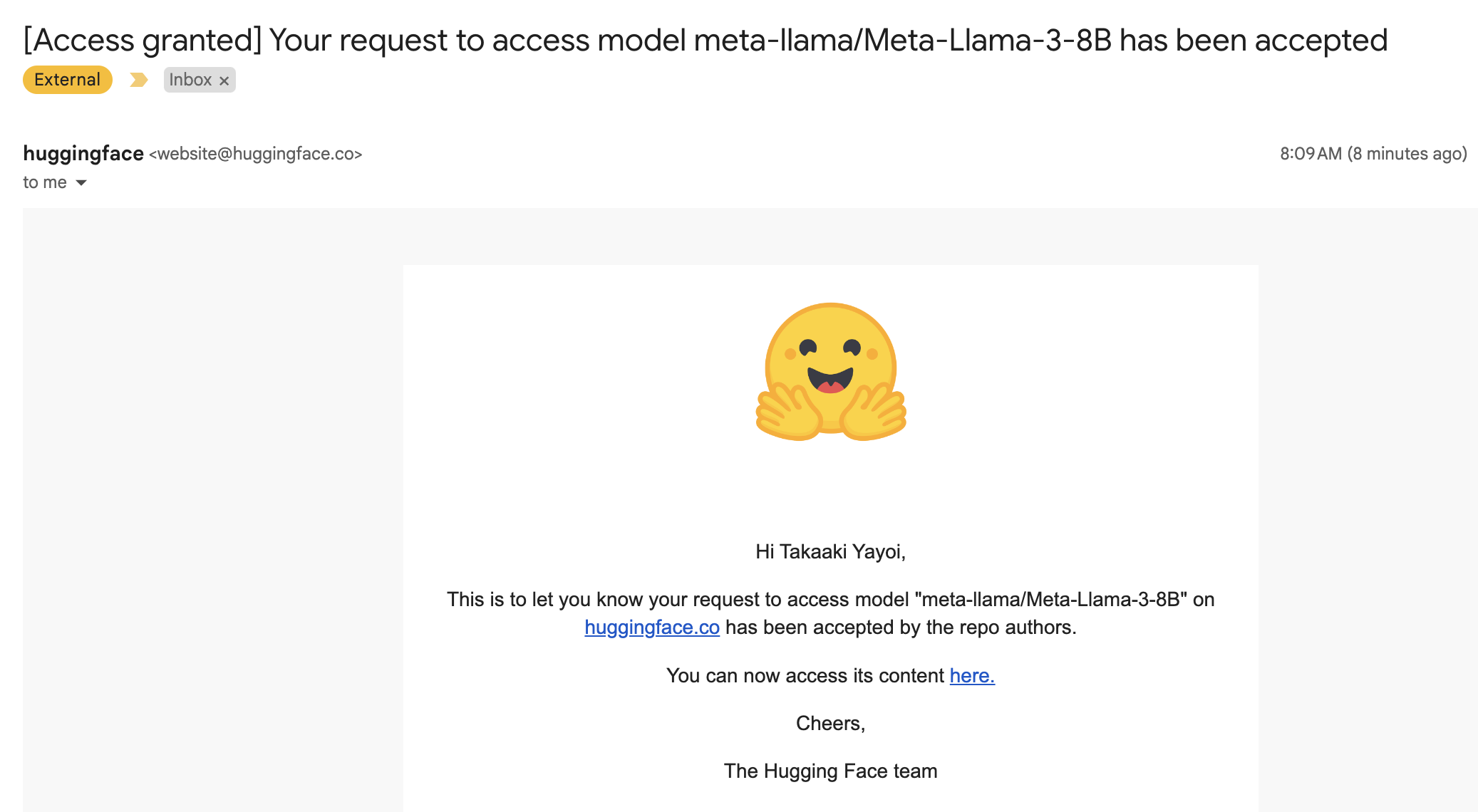

審査が通ると以下のようなメールが届きます。数分でメールが届きました。

アクセストークンを用いてHugging Face Hubにログインします。

from huggingface_hub import login

login()

サンプルコードを実行します。

import transformers

import torch

model_id = "meta-llama/Meta-Llama-3-8B"

pipeline = transformers.pipeline( "text-generation", model=model_id, model_kwargs={"torch_dtype": torch.bfloat16}, device_map="auto")

pipeline("Hey how are you doing today?")

動きました!

[{'generated_text': 'Hey how are you doing today? I am doing well. I am a little bit tired because I'}]

あとで、日本語やMeta-Llama-3-8B-Instructも試します。色々工夫が必要らしいです。

そして、こちらのブログにあるように、DatabricksはMetaとのパートナーシップを結び、Databricksの基盤モデルAPIを通じてLlama3を提供する予定です!

こちらの機能も利用できるようになったら試してみます。