はじめに

- RESTで取得してSplunk or Splunk Cloudに取り込みたいデータがある

- Add-onがあればいいんだけど、ないものはない

- Add-on作るのめんどい

- ローカルでREST叩くスクリプト動かすとしても24時間稼働するマシン用意するのもコストがかかる

- うーん、、、AWS Lambda試してみるか → 何これすごい! というお話です

追記:本記事ではNode.jsを使用します。Pythonでの方法をまとめました。

AWS LambdaでRESTでデータ取得してSplunkに送信してみる (Python編))

環境

- Lambdaからアクセス可能するためEC2などでグローバルIPを持つSplunk Enterprise、もしくはSplunk Cloud

- AWS Lambda

設定手順の概要

- SplunkでHEC設定

- AWS Lambdaで関数作成

- CloudWatchでLambdaを定期実行化

設定手順

1. SplunkでHEC設定

まずはAWS Lambdaからデータを受け取るためのHECを設定します。

ここは通常通りです。

- 設定 > データ入力

- HTTPイベントコレクターの [+ 新規追加] をクリック

- 名前を適当に入力して [次へ] をクリック

- 取り込み先のインデックスを選択 ※今回はaws_lambdaを作成しました。

- 生成されたトークンをメモ

以上です。

念のため、SSLの有効/無効状況やHTTPポート番号をグローバル設定から確認しておきましょう。

2. AWS Lambdaで関数作成

さて、AWS Lambda初心者にとって何をどうしたらいいか全然分からず途方に暮れていたのですが、splunk-logging blueprintという有難いものを見つけました。

本当にSplunkには何でもあるなぁ。

これはAWS Lambdaの関数の設計図(Blueprint)で、Splunk HECへのデータ送信が可能なもののようです。言語はNode.jsです。

まずは上記のページの通り設定してきます。

- AWS ConsoleからLambdaを探す

- [関数を作成] をクリック

- [設計図の使用] を選択し、設計図で「splunk-logging」を検索、選択して [設定] をクリック

(またはこちらから直接行けます)

- 諸々入力します。

- 関数名:任意

- 実行ロール:「基本的なLambdaアクセス権限で新しいロールを作成」のまま

- Lambda関数のコード:今はいじる必要なし

- 環境変数:HECの情報を入力

- SPLUNK_HEC_URL:https://splunkのhost名:8088/services/collector

※プロトコル、ポート番号はHEC設定に合わせる。/services/collectorを忘れずに(これがないと404エラーになります。しばらく悩みました)。 - SPLUNK_HEC_TOKEN:HECのトークン値

- SPLUNK_HEC_URL:https://splunkのhost名:8088/services/collector

- [関数の作成] をクリック

- これでSplunkへデータ送信するための関数が作成されました。早速テストしてみましょう。

「テスト」タブでテンプレートは「hello-world」のまま [呼び出し] をクリックします。するとサンプルのJSONがSplunkに送られます。

Splunk側を見てみましょう。あっさり取り込めていますね。すごい!

7.さて、Hello Worldできたところで今回の本題である「好きなRESTを叩いてそのデータを送る」に取り掛かりたいと思います。

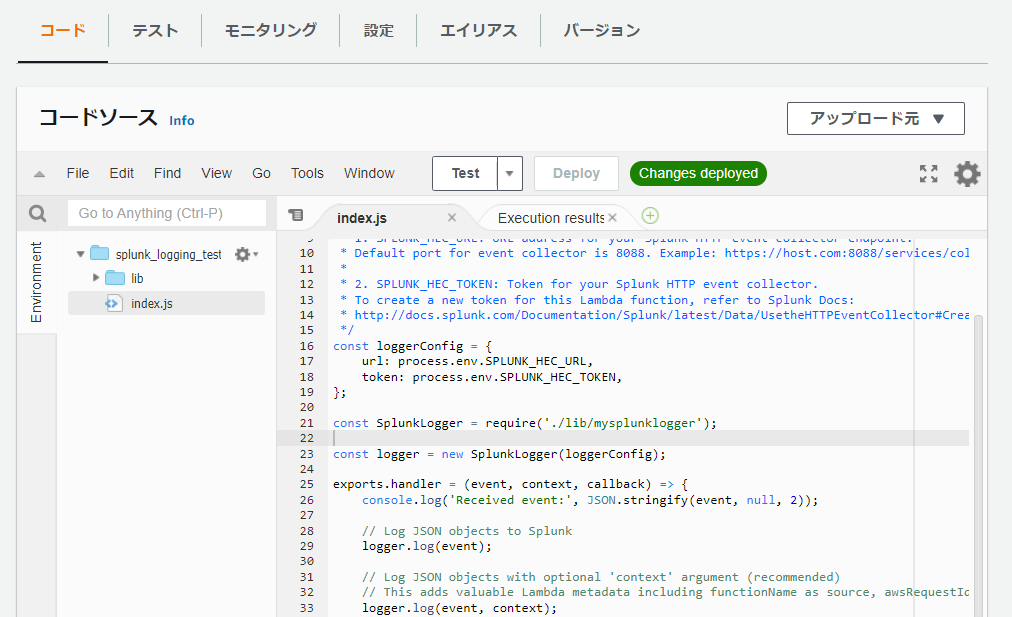

先ほどスルーしたスクリプト部分を見てみましょう。

「コード」タブのindex.jsをダブルクリックで開きます。

重要なところはexports.handler内です。コメントで使用方法が書かれています。

exports.handler = (event, context, callback) => {

console.log('Received event:', JSON.stringify(event, null, 2));

// Log JSON objects to Splunk

logger.log(event);

// Log JSON objects with optional 'context' argument (recommended)

// This adds valuable Lambda metadata including functionName as source, awsRequestId as field

logger.log(event, context);

// Log strings

logger.log(`value1 = ${event.key1}`, context);

// Log with user-specified timestamp - useful for forwarding events with embedded

// timestamps, such as from AWS IoT, AWS Kinesis, AWS CloudWatch Logs

// Change "Date.now()" below to event timestamp if specified in event payload

logger.logWithTime(Date.now(), event, context);

// Advanced:

// Log event with user-specified request parameters - useful to set input settings per event vs token-level

// Full list of request parameters available here:

// http://docs.splunk.com/Documentation/Splunk/latest/RESTREF/RESTinput#services.2Fcollector

logger.logEvent({

time: Date.now(),

host: 'serverless',

source: `lambda:${context.functionName}`,

sourcetype: 'httpevent',

event: event,

});

// Send all the events in a single batch to Splunk

logger.flushAsync((error, response) => {

if (error) {

callback(error);

} else {

console.log(`Response from Splunk:\n${response}`);

callback(null, event.key1); // Echo back the first key value

}

});

};

要はlogger.log()、logger.logWithTime()もしくはlogger.logEvent()で送信データを整え、logger.flushAsync()で送信するようです。

また、サンプルではeventを引数として渡していますが、これはLambdaをAPI GatewayやKinesisなどで起動するときに渡せるデータのようです。

つまりAWS内で発生したデータもKinesisがLambdaに渡し、Lambdaで処理を加えてからSplunkに送信できるということですが、今回は自力でデータを取ってもらうので無視します。

それでは適当なREST APIでデータを取ってみましょう。

ところで国際宇宙ステーション(ISS)が今どこを飛んでいるか気になっていませんか?

ちょうど良かったです。そんなあなたのためにREST APIが用意されています!

International Space Station Current Location

これを使ってデータ取得と送信のスクリプトを作ってみましょう。

できたものがこちらです。

exports.handler = (event, context, callback) => {

let http = require('http');

const url = 'http://api.open-notify.org/iss-now.json';

// REST APIでデータ取得

http.get(url, (res) => {

let body = '';

res.setEncoding('utf8');

// データをbodyに蓄積していく

res.on('data', (chunk) => {

body += chunk;

});

// 蓄積完了したら処理

res.on('end', (res) => {

// bodyをJSON Objectに変換

res = JSON.parse(body);

console.log('Received event:', res);

// 送信データを組み立て

logger.logEvent({

time: res.timestamp, // イベントの時刻。もしデータ内に時刻がなければDate.now()で現在時刻を渡す。

host: 'serverless', // お好みのhost

source: `lambda:${context.functionName}`, // お好みのsource

sourcetype: 'iss', // お好みのsourcetype

event: res, // 取得したデータをObject化したresを渡す。

index: aws_lambda, // お好みのindex。HEC側で指定されていれば不要。

});

// HECにデータ送信

logger.flushAsync((error, response) => {

if (error) {

callback(error);

} else {

console.log(`Response from Splunk:\n${response}`);

callback(null, event.key1); // Echo back the first key value

}

});

});

}).on('error', (e) => {

console.log(e.message);

});

};

注意する点としてはlogger.logEvent()でしょうか。

お手軽にlogger.log()でもいいのですが、今回はタイムスタンプやsourcetypeを指定するためこちらを使用してみました。

// 送信データを組み立て。

logger.logEvent({

time: res.timestamp, // イベントの時刻。もしデータ内に時刻がなければDate.now()で現在時刻を渡す。

host: 'serverless', // お好みのhost

source: `lambda:${context.functionName}`, // お好みのsource

sourcetype: 'iss', // お好みのsourcetype

event: res, // 取得したデータをObject化したresを渡す。

index: aws_lambda, // お好みのindex。HEC側で指定されていれば不要。

});

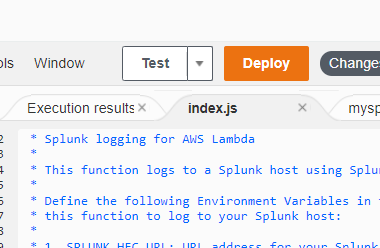

さて、これを実行してみます。[Test] ボタンからテストできます。 [Deploy] で更新内容を反映してからテストしてみましょう。

Splunkで見てみましょう。無事取り込めました。すごい!

いい感じに動いたので、次はこのスクリプトを定期実行したいと思います。

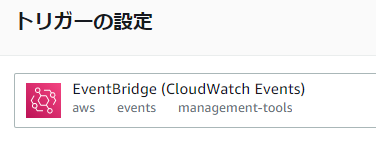

3. CloudWatchでLambdaを定期実行化

Lambdaの定期実行ってどうするんだろと思って調べたところ、CloudWatchでcron実行できるみたいです。

早速設定してみましょう。

- 設定 > トリガーから [トリガーを追加] をクリック

- EventBridge (CloudWatch Events) を選択

- ルールタイプで「スケジュール式」を選択。cronでもいいですが、rate式というのがすごく分かりやすい。とりあえず5分ごとに実行するように設定。※ISSのRESTは最短5秒ごとの制限。

- [追加] をクリックすれば定期実行化が完了

これで5分ごとにISSの位置情報を取得してSplunkに送ってくれるようになりました。

ちょっと待って、Splunkを見てみましょう・・・きっちり5分ごとに取れていますね。

せっかくなのでRealtime Location Trackerを使って移動履歴をトラッキングしてみましょう。

index="aws_lambda"

| eval id = 1

| table _time, iss_position.latitude, iss_position.longitude, id

と思ったら多分正しそうです。

地上から約400kmの上空を秒速約7.7km(時速約27,700km)で飛行していて、地球を約90分で1周、1日で約16周します。

まとめ

- ロジックだけ気にすればいいのでサーバーレスは便利。Lambdaの実行状況はCloudTrailのログ取り込みで可視化できるようです(今回は割愛)。

- RESTでデータを取りたいけどAdd-onが無い場合、AWS Lambdaも有力な選択肢になりますね。