はじめに

この記事は株式会社ナレッジコミュニケーションが運営するチャットボット と AIエージェント Advent Calendar 2025 の9日目にあたる記事になります!

今回は、re:Invent Black Belt などでアナウンスされた、

「Amazon Bedrock に 18 のオープンウェイトモデルが追加」

というアップデートを、ざっくり整理してみます。

- どんなベンダーのモデルが増えたのか

- それぞれどんな特徴がありそうか

- Bedrock 上でどうやって呼び出すのか

あたり、ライトに把握する用の記事です。

※ほぼ自分用にまとめたものです。

注意:

- 本記事は 2025年12月時点の情報です

- 18のモデルはアナウンス済みですが、リージョンによって利用可能なモデルが異なります

- 最新の対応状況は公式ドキュメントで必ずご確認ください

1. Amazon Bedrock とオープンウェイトモデル

Amazon Bedrock は、AWS が提供する マネージドな基盤モデル(FM)プラットフォーム です。

- 複数ベンダーの LLM / 画像 / マルチモーダルモデルを共通 API 呼び出せる

- セキュリティやネットワーク周りは AWS のマネージド

- CloudWatch, IAM, VPC, KMS などと素直に統合できる

そして今回テーマとなっているのが 「オープンウェイトモデル」 です。

- AIモデルの重み(weight)を公開することで、研究者や開発者がそのモデルを自由に利用、改変、商用利用できる

- ローカル実行やオンプレ・他クラウドでの実行も可能

- ただし Bedrock 上で使う場合は、AWS がホスティングをマネージドでやってくれる

つまり、

OSS 系モデルを自前でホストするのはしんどいけど、

とりあえず安全に、楽に使いたい

というニーズにうまくハマるのが「Bedrock 上のオープンウェイトモデル」です。

2. 今回追加された 18 モデルの一覧

公開されたスライドでは、以下のベンダーのモデルが新しく使えるようになったと紹介されています。

2025年10月に公開されたOpenAIが提供するオープンソースの安全推論モデルも含まれています。

※リージョン対応状況は公式ドキュメントを参照:

https://docs.aws.amazon.com/ja_jp/bedrock/latest/userguide/models-supported.html

Google:

- Gemma 3 (4B, 12B, 27B)

MiniMax AI:

- MiniMax M2

Mistral AI:

- Mistral Large 3

- Ministral 3(3B, 8B, 14B)

- Magistral Small 1.2

- Voxtral Mini 1.0

- Voxtral Small 1.0

Moonshot AI:

- Kimi K2 Thinking

NVIDIA:

- NVIDIA Nemotron Nano 2 9B

- NVIDIA Nemotron Nano VL 12B

OpenAI:

- gpt-oss-safeguard-20b

- gpt-oss-safeguard-120b

Qwen:

- Qwen3-Next-80B-A3B

- Qwen3-VL-235-A22B

3. 実際何ができるの?

用途別にかなりざっくり分類すると、次のようなイメージになります。

| # | シナリオ | 候補モデルの例 |

|---|---|---|

| 1 | 汎用チャット / FAQ | Gemma 3 (12B, 27B), MiniMax M2, Ministral 3 (8B, 14B) |

| 2 | コストを抑えたリアルタイム推論 | Gemma 3 4B, Ministral 3 3B, Nemotron Nano 2 9B |

| 3 | 高度な推論・エージェント | Mistral Large 3, Qwen3-Next-80B-A3B, Kimi K2 Thinking |

| 4 | 長文ドキュメント要約・分析 | Kimi K2 Thinking, Qwen3-Next-80B-A3B |

| 5 | 画像+テキスト(マルチモーダル) | Qwen3-VL-235-A22B, Nemotron Nano VL 12B, Voxtral 系 |

| 6 | 安全性チェック / モデレーション | gpt-oss-safeguard-20b / 120b |

実際には

- 対応リージョン

- 料金

- レイテンシ

- 日本語品質

あたりで最終決定することになるので、

まずは複数モデルを A/B テスト してみるのが現実的です。

4. Bedrock からオープンウェイトモデルを呼び出してみる(実践編)

ここからは、Amazon Bedrock 上のオープンウェイトモデルを実際に叩いてみる手順を、コンソール操作 → コード実行まで順番にまとめます。

例として「Gemma 3 (4B)」(仮のモデル ID)を使いますが、

他のオープンウェイトモデルでも手順はほぼ同じです。

※リージョン/モデル ID は公式ドキュメントから最新を必ず確認してください:

https://docs.aws.amazon.com/ja_jp/bedrock/latest/userguide/models-supported.html

前提

- すでに AWS アカウントを持っている

- Bedrock がサポートされているリージョンを使う(例: us-east-1 など)

- ローカルに Python 3.x が入っている

Step 0: リージョンとモデルの確認

公式ドキュメントを開く:

https://docs.aws.amazon.com/ja_jp/bedrock/latest/userguide/models-supported.html

使いたいオープンウェイトモデル(例: Mistral Large 3, Gemma 3, Qwen など)が

- どのリージョンで使えるか

- モデル ID が何か

を確認します。

例(※あくまでイメージです。実際の ID はドキュメント or コンソールで確認してください)

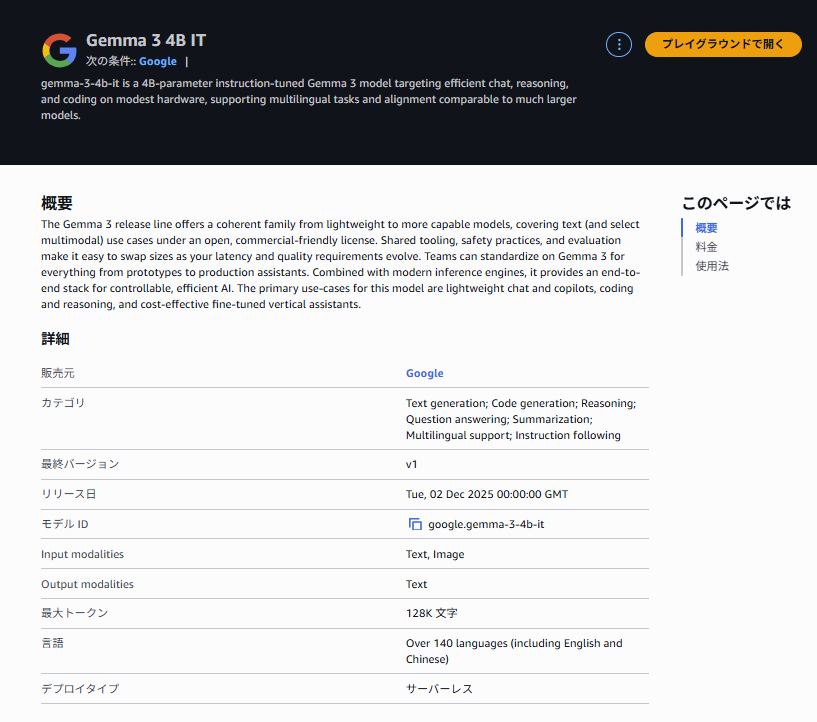

- モデル名:Gemma 3 (4B)

- リージョン:us-west-2

- モデル ID:google.gemma-3-4b-it

以降の例では、リージョンを us-west-2、モデル ID を google.gemma-3-4b-it として進めます。

Step 1: Bedrock コンソールでモデルを有効化する

1. AWS マネジメントコンソールにログイン

右上のリージョン選択で、Bedrock と対象モデルがサポートされているリージョンを選択

(例:オレゴン (us-west-2))

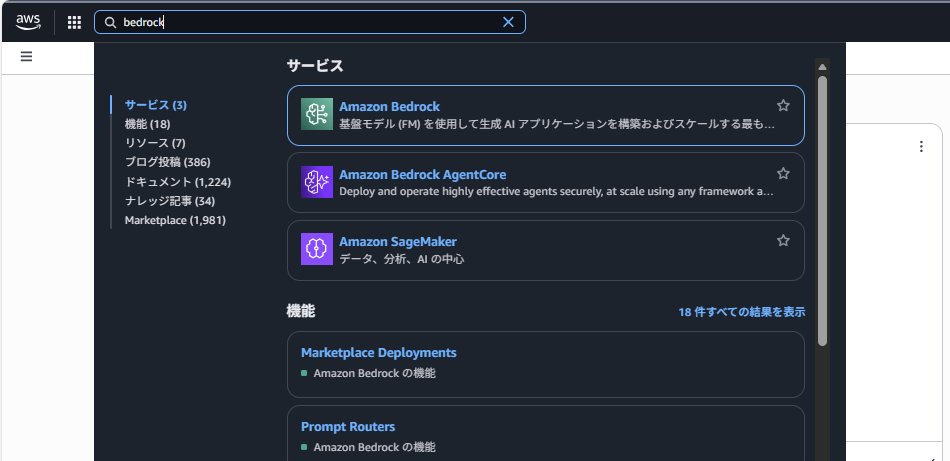

2. サービス一覧から 「Amazon Bedrock」 を開く

左メニューの 「モデルカタログ(Model catalog)」 をクリック

※モデルアクセスページは廃止されたので注意

3. 一覧から使いたいオープンウェイトモデル(例: Google Gemma 3 4B)を探して選択

画面上部にある 「プレイグラウンドで開く」 ボタンを押す

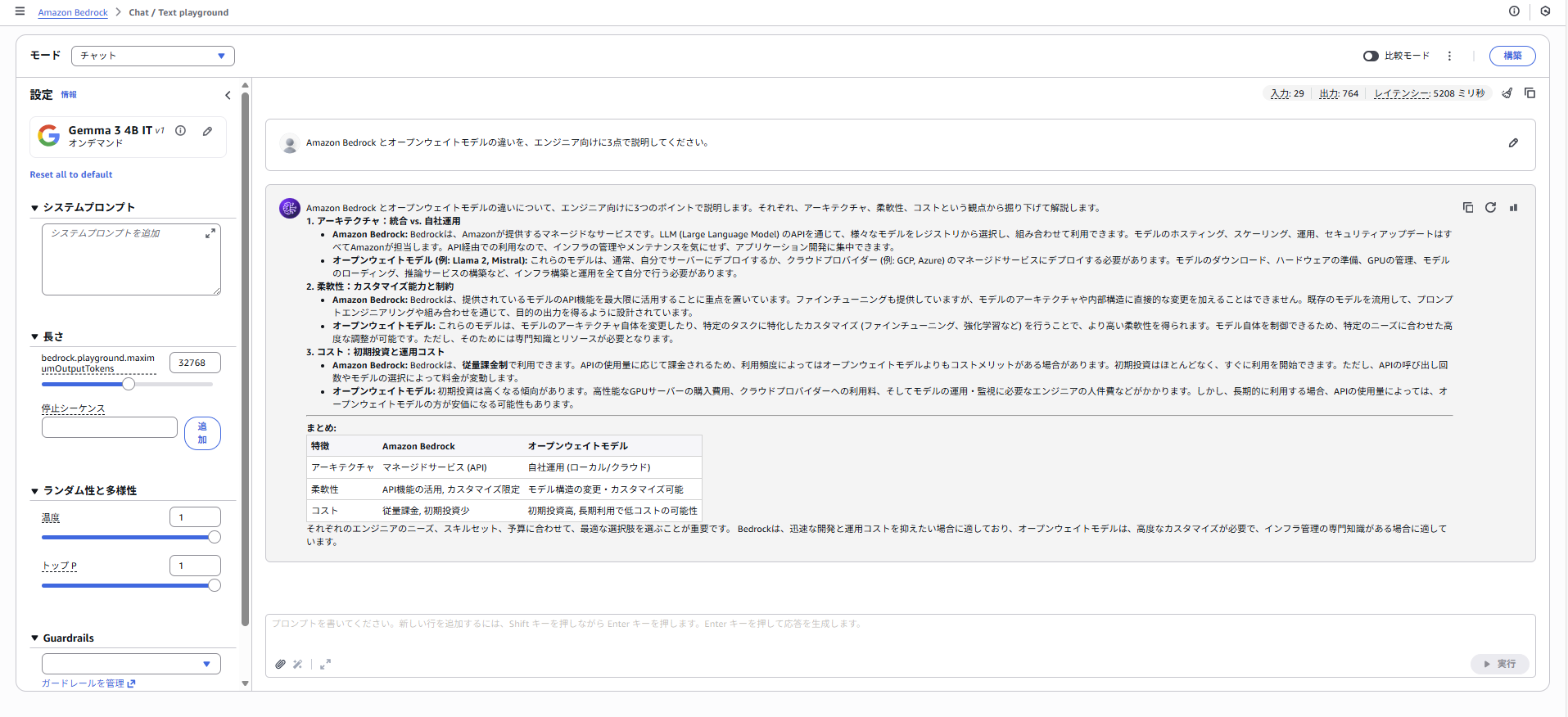

Step 2: Playground で動作確認する(推奨)

コードを書く前に、コンソール上の Playground で動かしてみます。

1. 先ほど開いたプレイグラウンド上で入力欄に適当なプロンプトを入れる

例:

Amazon Bedrock とオープンウェイトモデルの違いを、エンジニア向けに3点で説明してください。

2. 「実行」ボタンを押す

ここで期待通りのレスポンスが返ってくれば、

「モデルアクセス」「リージョン選択」までは問題なし、と判断できます。

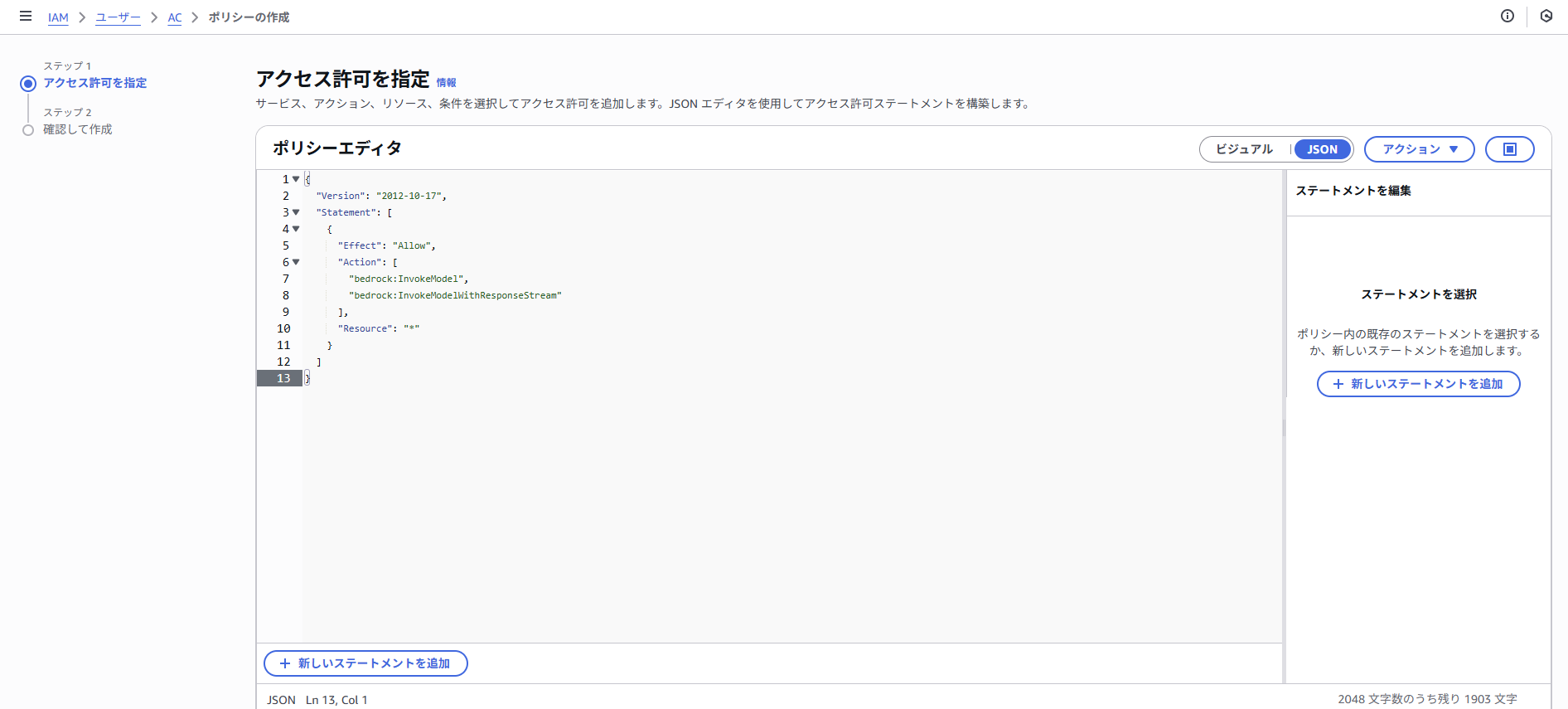

Step 3: IAM 権限(bedrock:InvokeModel)を付与する

プログラムから Bedrock を呼ぶために、bedrock:InvokeModel の権限を持つ IAM ユーザー or ロールを用意します。

1. 最小限の IAM ポリシー例

IAM ポリシー JSON の例です(検証用にかなり緩めています)。

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"bedrock:InvokeModel",

"bedrock:InvokeModelWithResponseStream"

],

"Resource": "*"

}

]

}

- 本番では Resource を特定モデルの ARN に絞るなどの制限を推奨です。

- 必要に応じて CloudWatch Logs や Secrets Manager などの権限も追加します。

このポリシーを

- 開発用 IAM ユーザー

- あるいは EC2 / Lambda にアタッチする IAM ロール

に付与しておきます。

Step 4: ローカル環境の準備(AWS CLI & 認証情報)

1. AWS CLIのインストール

ここはOSで異なるので割愛します。

2. 認証情報の設定

- IAM ユーザーのアクセスキー、シークレットアクセスキー:

AWS Access Key ID [None]: AKIA................

AWS Secret Access Key [None]: xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx

- Bedrockのリージョン:

Default region name [None]: us-west-2

- デフォルトのアウトプットフォートマット:

Default output format [None]: json

3. 確認

aws sts get-caller-identity

次のようなJSONが返ってくれば、認証成功です。

{

"UserId": "AIDA...",

"Account": "123456789012",

"Arn": "arn:aws:iam::123456789012:user/your-user"

}

※ ここで設定した内容は ~/.aws/credentials / ~/.aws/config に保存されます。

Step 5: Python から Bedrock Runtime クライアントを作る

1. boto3 をインストール

pip install boto3

python -c "import boto3; print(boto3.__version__)"

バージョンが表示されれば成功です。

2. 最小コード(Converse API で呼び出す例)

最近のBedrockでは、Converse APIという共通インターフェイスで多くのモデルを扱えるようになっています。

(対応状況はモデルごとに異なるので、ドキュメントで「Converse 対応」か確認してください。)

import boto3

REGION = "us-west-2"

MODEL_ID = "google.gemma-3-4b-it" # 使いたいモデルID

client = boto3.client("bedrock-runtime", region_name=REGION)

prompt = "Amazon Bedrock のメリットを3つ、日本語で箇条書きにしてください。"

response = client.converse(

modelId=MODEL_ID,

messages=[

{

"role": "user",

"content": [{"text": prompt}],

}

],

inferenceConfig={

"maxTokens": 512,

"temperature": 0.7,

},

)

# レスポンスからテキストを取り出す

output_text = response["output"]["message"]["content"][0]["text"]

print(output_text)

- MODEL_ID は必ずコンソール/ドキュメント上の 実際の ID に置き換えてください

- inferenceConfig のパラメータ名・意味はモデルごとに少し違う場合がありますが、 多くのテキストモデルでは maxTokens / temperature / topP あたりが共通で使えます

3. Pythonを実行

以下のように返ってくれば成功です。

* **低コスト:** モデルの利用料金は、使用量に応じて従量課金制のため、必要な分だけ支払えば良い。大規模なモデルを常時運用する必要がない場合、コスト効率が高い。

* **スケーラビリティと信頼性:** Amazonのインフラ上で動作するため、高いスケーラビリティと信頼性を備えており、アプリケーションの成長に合わせて柔軟にリソースを拡張できる。

ご参考になりましたでしょうか?

まとめ

Amazon Bedrock に追加された 18 のオープンウェイトモデルにより、用途やコストに応じた柔軟なモデル選択が可能になりました。

本記事のポイント:

- オープンウェイトモデルをマネージドで使えるのが Bedrock の強み

- リージョンごとに利用可能なモデルが異なるため、事前確認が必須

- Converse API を使えば、モデル間の切り替えが容易

次のステップ:

- 複数モデルで同じタスクを試して、出力品質とコストを比較

- 用途に応じて軽量モデル(1B〜3B)と高性能モデル(70B〜)を使い分け

- セーフティモデル(gpt-oss-safeguard)を組み合わせた安全な構成を検討

まずは Playground で気軽に試してみて、自分のユースケースに合ったモデルを見つけてください!