watsonx.aiのLLMをPythonから呼び出すためには、以下の3つを用意する必要があります。

- APIキー

- watsonx.ai Runtimeが関連付けられた「プロジェクト ID」

- watsonx.ai Runtimeの「サービス・エンドポイント」

APIキーの作成

watsonxのハンバーガーメニューから「アクセス(IAM)」にアクセスします。

プロジェクトの準備

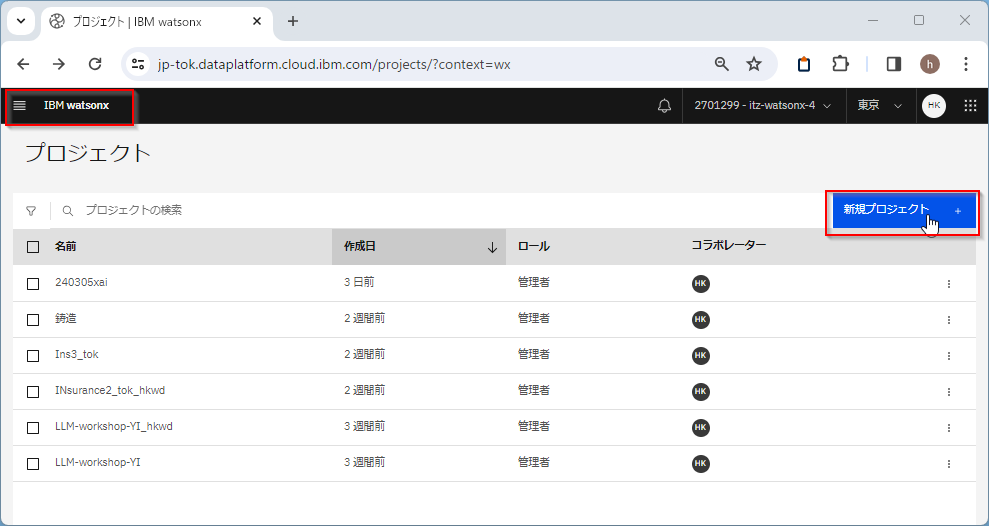

watsonx.ai Studioで「新規プロジェクト」を作成します。

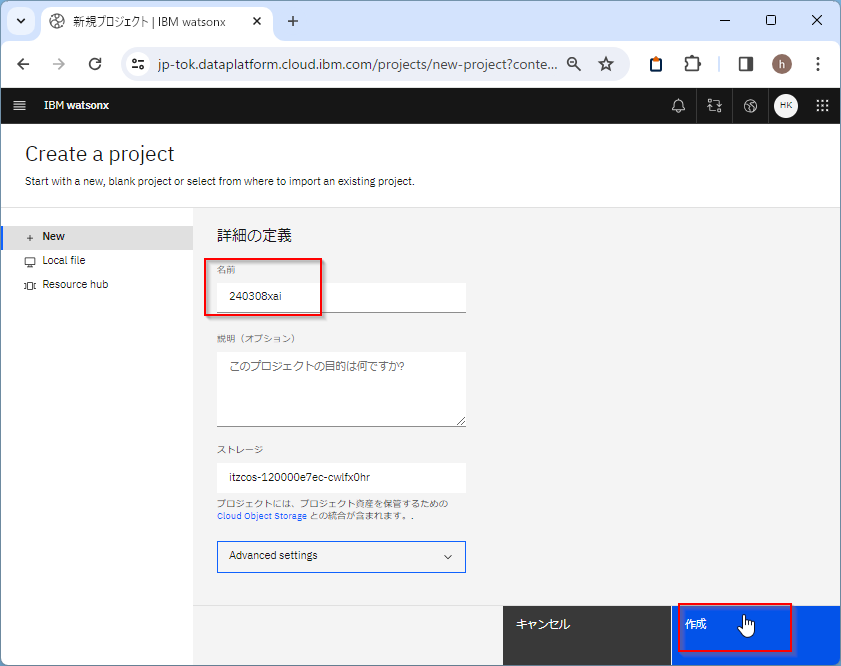

適当に名前をつけて「作成」します。ここでは「240308xai」という名前にしています。

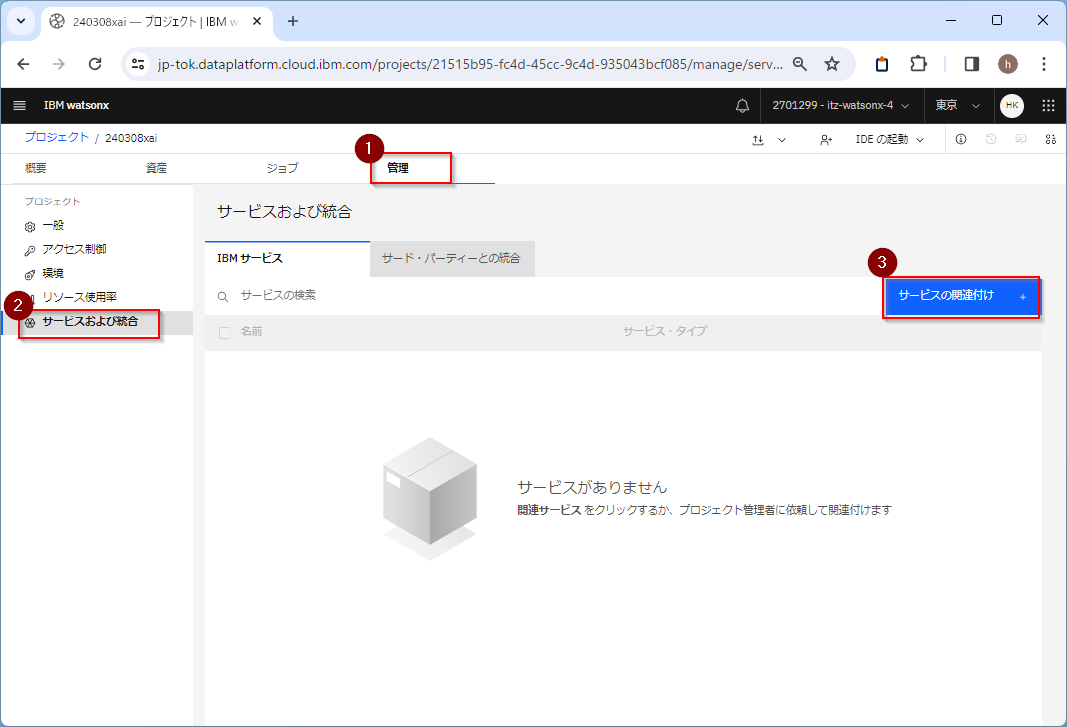

「管理」タブでwatsonx.ai Runtime(旧Watson Machine Learning)というエンジンのサービスを関連付けます。

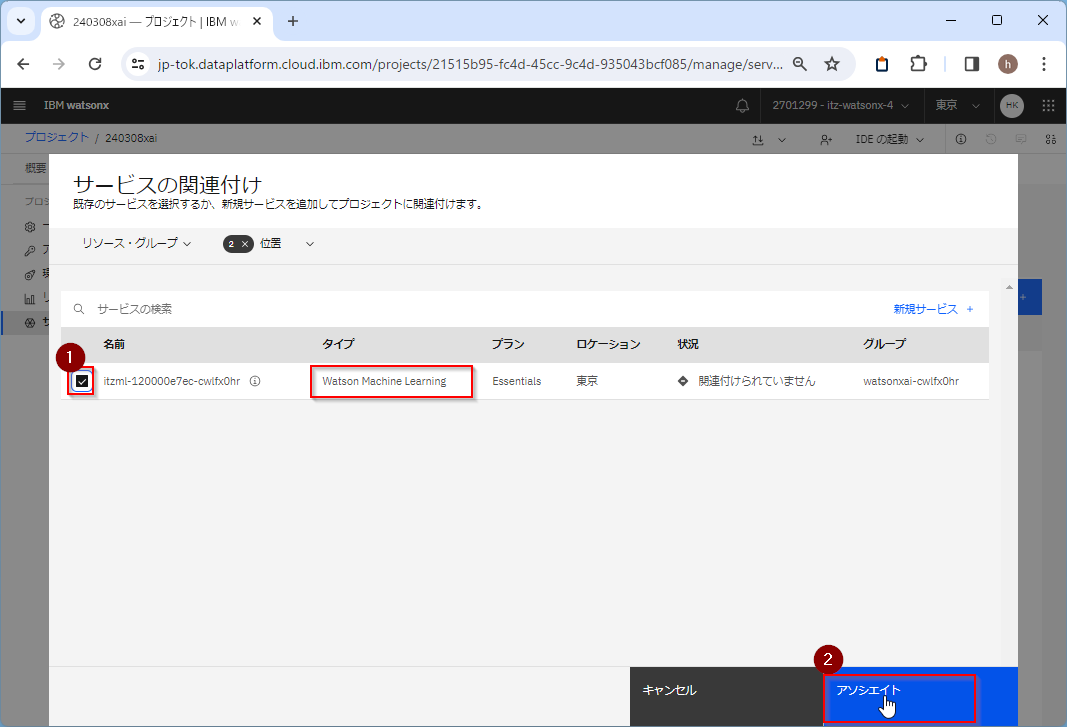

あらかじめ用意しておいたwatsonx.ai Runtime(旧Watson Machine Learning)のサービスを「アソシエイト」します。もし用意していなければ「新規サービス」から追加します。

プロジェクトID取得

プロジェクトに入り、「管理」タブの「一般」を選び、「プロジェクト ID」をコピーして、書き留めておいてください。

watsonx.ai Runtimeのサービス・エンドポイントの確認

サービス・エンドポイントはリージョンごとに異なっています。

以下だと東京リージョンになっています(正確には、この表示はwatsonx.ai Studioのリージョンですが、watsonx.ai Studioとwatsonx.ai Runtimeは同じリージョンであるのでwatsonx.ai Runtimeも東京になります)。

各リージョンのサービス・エンドポイントは以下から探してください。

パブリック・エンドポイントは以下です。

プライベート・エンドポイントは以下です。

東京のパブリックエンドポイントであれば

https://jp-tok.ml.cloud.ibm.com

となります。

まとめ

これで、「APIキー」、watsonx.ai Runtimeが関連付けられた「プロジェクト ID」、「watsonx.ai Runtimeのサービス・エンドポイント」の三つが揃いました。

参考

コンソールでの API キーの作成

プロジェクトの作成 — Docs | IBM watsonx

プロジェクトへの関連サービスの追加 — Docs | IBM watsonx