この記事は、ちゅらデータ Advent Calendar 2025 19日目の記事です。

NotebookLMに作ってもらった本記事のインフォグラフィックです。

スライド資料も作ってくれるのですがなかなかの出来でした、すごい。

なお受賞作品はすべて他チームの功績です、筆者チームはかすりもしませんでした…

1位:GreatAkihabaraさん, 2位:kufushaさん, 3位:Cog Botsさん, すごかったです!おめでとうございます!(ネット上で発見できた受賞作品のみ列挙しています)

運営の皆様もありがとうございました!

はじめに

さて、2025年も残り2週間を切りました。

今年は 「AI Agent / Agentic AI」 という概念が一気に広まった1年だったのではないでしょうか。間違いなく、2025年の技術トレンドのど真ん中にあったテーマだと思います。私もADKを使ってAIハッカソンに参加したりしていました。ADKいいですよね…

最近は、その更に一歩先の概念として 「Physical AI」 という言葉を耳にする機会も増えてきました。2025年1月のCESでは NVIDIA CEO が Physical AI という言葉を用い、続く2025年5月のCOMPUTEX Keynoteでは Agentic AI の先にある「世界を理解するAI」として位置づけています。そして、その次には 汎用ロボティクスの時代が来る とも言及されていました。

こうした流れの中で、世はまさに大フィジカルAI時代を迎えつつあり、日本国内でも

- AIロボティクス検討会の開催

- AIRoAのような団体の設立

- 東京大学 松尾・岩澤研究室でのPhysical AI 講座の開講

- データサイエンティスト協会スキルチェックリストへのロボティクス追加

など、Physical AI 周辺の動きが一気に活発化しています。

そんな Physical AI・ロボティクスに注目が集まる中、去る2025年12月5日〜7日に、AMD × Hugging Face × WOWROBO × TAI × DATA MONSTERS スポンサードの AMD Open Robotics Hackathon が、東京・秋葉原にて開催されました。

本記事では、筆者がこのハッカソンに参加した体験として、

- どんなハッカソンだったのか

- 実機 × LeRobot で何ができたのか

を中心に、当日の様子や成果物、率直な感想をまとめます。

今後、同様のハッカソンに参加を検討している方の参考になれば幸いです。

模倣学習などの技術的詳細には言及しませんので予めご了承ください。

※ 「まだ誰も書いていないネタだ!ヘヘ」と思ってチマチマ書いていたら、松尾研究所さんに先を越されてしまいました。こちらの記事もとても面白いので、ぜひあわせてどうぞ(自社アドカレ記事で他社アドカレ記事を紹介するストロングスタイルでお送りしています)。

AMD Open Robotics Hackathonとは

一言で言うと、実機ロボットソリューションを短期間で実装する激アツハッカソン です。

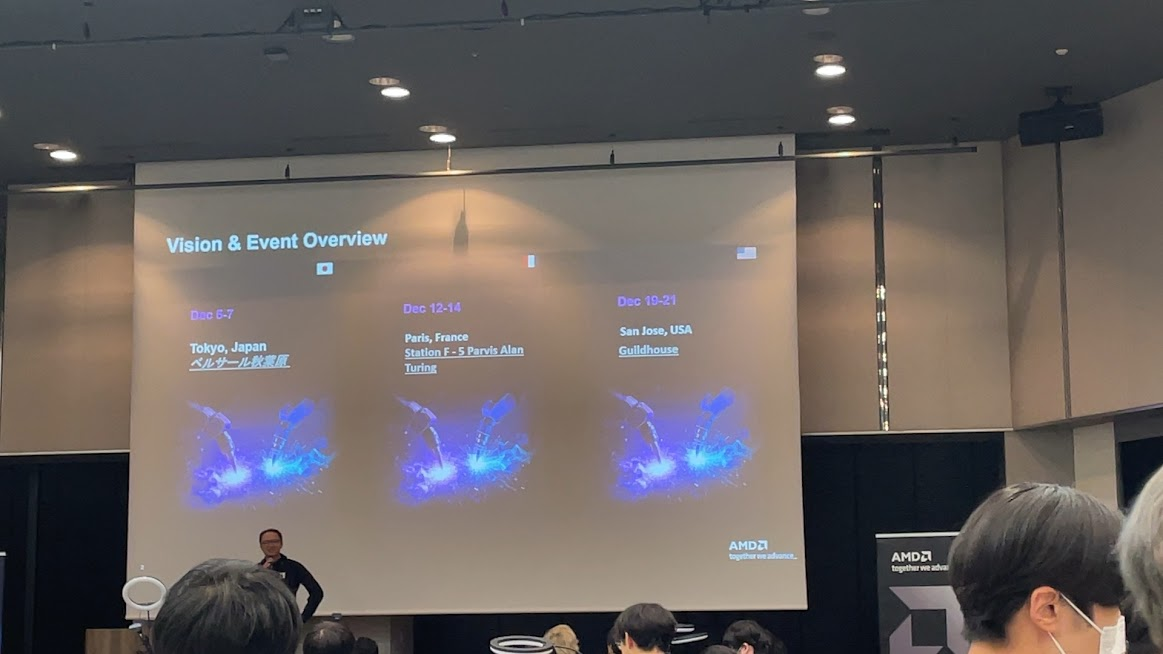

AMD Open Robotics Hackathon は、AMD 社が主催するロボティクス分野の実践型ハッカソンです。Hugging Face の LeRobot を用いて、実機ロボットを使った開発・検証に取り組むことができます。賞金は10,000ドル(1位)、5,000ドル(2位)、2,000ドル(3位)。日本(東京)・フランス(パリ)・アメリカ(サンノゼ)で、時期をずらして開催されました。

詳細は公式サイトをご確認ください。

特徴

本ハッカソンの特徴をまとめると、以下の通りです。

- 実機ロボットを使った開発が前提

- 短期間で「環境構築 → 検証 → 実装」まで一通り体験可能

- 会場泊まり込み可という、なかなか珍しいハードコアでクレイジーなスタイル

- 必要なハードウェア・ソフトウェア・計算リソースはすべて提供

- 追加で必要なハードウェアがあれば 最大300ドルまで払い戻しあり

※ LeRobotを使った世界的なハッカソンとしては2回目と認識しています。1回目はLeRobot Worldwide Hackathon。

ハッカソンの構成

本ハッカソンは、以下の2つのミッションで構成されていました。

Mission 1: ハンズオン

- LeRobotを使った「Hello, World」的位置づけ

- 講師によるハンズオンワークショップからスタート

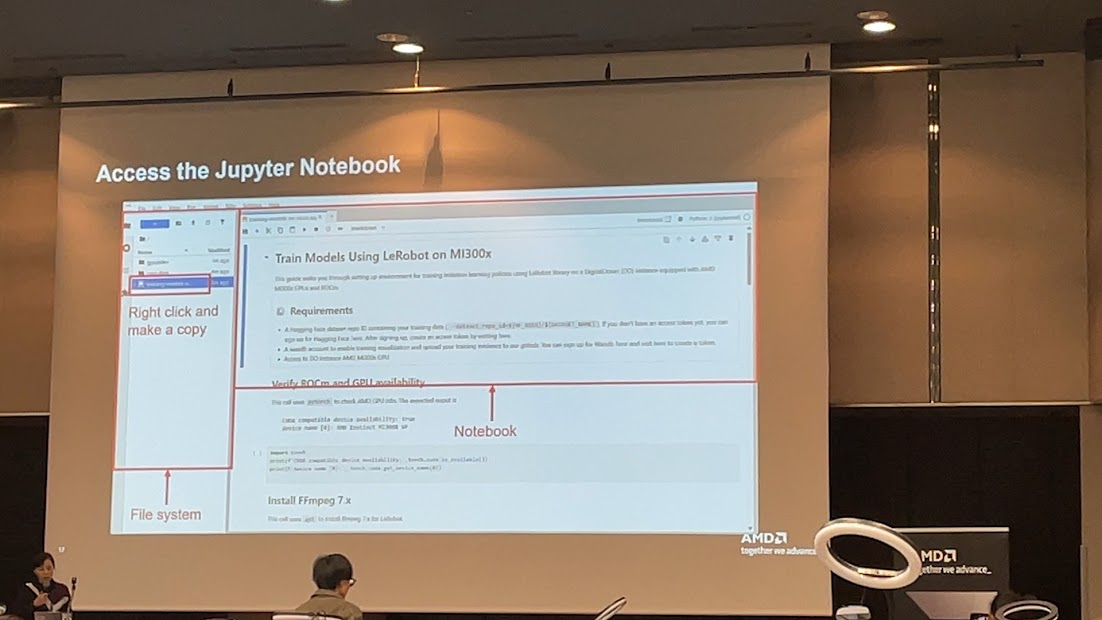

- AMD AIソリューションを使用してLeRobotの開発環境をエッジからクラウドまでエンドツーエンドでセットアップ

- 指定課題: 小さな物を拾い上げて、ゴミ箱に入れる (例:プラスチック製のおもちゃのレンガを拾ってカップに入れる、ペンを手に取ってペンホルダーに入れるなど)

初心者でも 「とりあえずロボットを動かすところまで」 を体験できる内容でした。

Mission 2: フリースタイル

- 自由課題として取り組むメインミッション

- 現実世界の課題を想定したロボティクスアプリケーションの開発

- 最終的な審査対象

Mission 1 で得た知識や環境をベースに、各チームが独自のアイデアを実装していくフェーズです。

提供される開発環境

本ハッカソンでは、データ収集 → 学習 → 推論・評価 まで、開発に必要なものがほぼすべて提供されていました。

具体的な構成は以下の通りです。

- Wowrobot SO-101 Fully Assembled Kit: 1 set

- Cameras: 2 units

- Overhead camera bracket with LED light: 1 set

- Laptop ASUS Vivobook S 14, Ryzen AI 9 HX 370 (Ubuntu 24.04): 1 set

- USB hub: 2 pieces

- Interface: 1 piece

- AMD Developer Cloud (MI300X GPU): 2 virtual machines

「GPUどうするんだろう…」という不安は一切不要で、手元PC + クラウドGPU x2 の構成をぱっと使えるのはかなり良い体験でした。

※ 必要に応じて 自前の機材やロボットの持ち込みも可能でした。筆者は RealSense や OAK-D を持ち込みましたが、結果的に 今回は出番なしでした(悲しい)。

ドキュメント・リポジトリ周り

QuickStart や FAQ、各種ガイドは以下の GitHub リポジトリにまとまっていました。

「とりあえずこれを見れば始められる」状態にはなっており、事前に一度目を通しておくとかなり楽だと思います。

LeRobot について

ハッカソンのメインで使用する LeRobot も OSS として公開されています。

本記事では LeRobot 自体の詳細な解説は行いませんが、Qiita や Zenn 等にすでに分かりやすい解説記事が多数ありますので探してみてください。

当日の様子

3日間のタイムライン(配布資料より一部引用)と、実際に参加して感じたことを雑多にまとめます。

Day 1: 環境構築

| Time | Session |

|---|---|

| 17:30–18:00 | 開場 & チェックイン |

| 18:00–19:00 | 夕食(提供) |

| 19:00–19:20 | ウェルカムスピーチ |

| 19:20–19:30 | 全体スケジュール共有 |

| 19:30–20:00 | ハードウェアピックアップ |

| 20:00–20:30 | LeRobot セットアップワークショップ |

| 20:30–20:40 | AMD Developer Cloud ワークショップ |

| 20:40–21:00 | Q&A |

| 21:00–24:00 | ハッカソン |

- 会場に入った瞬間、とにかくデカくて驚いた

- 約40チーム参加と聞いて二度ビビる

- 自前のアームキットやロボットを持参しているチームも多く、「あれ、もしかして場違い…?」という気持ちになる

- 提供されるお弁当が美味しい(重要)

-

QuickStartに従って環境構築を開始

- PyTorchのインストールが全然終わらない

- おそらく40チームが一斉にダウンロードしたことで、会場 Wi-Fi の帯域が圧迫されていたのでは、という推測

- conda なんだ、へえ

- この日は ハードウェアセットアップとソフトウェアインストールでほぼ終了

- キャリブレーション周りで少し混乱

- キャリブレーションコマンドの記載ミス

- キャリブレーション動画のリンク切れ

- 「1か月で準備した」と聞いていたので、致し方なしかも

- 模倣学習だけでなくルールベースでもいけるのでは? と思い、ROS 2 もインストール

- ただし、適当に選んだ LeRobot × ROS 2 の OSS が動かず詰む

- 事前準備、大事

- 一部ワークショップや TA(テクニカルアシスタント)とのやり取りは英語

- 英語、ちゃんと勉強しておこう

- ブランケットが配布されていて、「これは本気で泊まらせに来てるな…」と覚悟が決まる

- チヤホヤ系の初心者向けハンズオンではなく、「当たり前にこれくらいできますよね?」というややハードコアな感じだった印象

- 事前準備ゼロ・初心者の筆者は、右も左も分からずちょっと泣きながら作業した

- 隣のチームは秒でアーム動かしていてめっちゃ焦った

- さすがに初日から泊まり込みは無理だったので、終電で一度帰宅

Day 2: Mission 1

| Time | Session |

|---|---|

| 0:00–0:30 | ミッドナイトスナック |

| 0:30–8:00 | 休息 |

| 8:00–9:00 | 朝食(提供) |

| 9:30–10:30 | Mission 2 プランプレゼン |

| 10:30–12:00 | ハッカソン |

| 12:00–13:00 | 昼食(提供) |

| 13:00–16:30 | ハッカソン |

| 16:30–17:00 | LeRobot Technical Sharing |

| 17:30–18:30 | 夕食(提供) |

| 18:30–19:00 | ゲストスピーカートーク |

| 19:00–24:00 | ハッカソン |

- 朝から再合流し、Mission 1 の キャリブレーション → データ収集 → 学習 → 推論・評価 を一通り実施

- ポリシーはいくつか選択肢があったが、今回は Action Chunking with Transformers を選択

- Learningベースなので、とにかくデータの量と質が重要だった

- Data-Centric AI とはこのことか、という気持ちになる

- テレオペ(人間側オペレーター)の操作精度がそのまま性能に直結?

- データ収集中、音声ガイダンスが延々と流れる仕様

- だんだんノイローゼ気味になる

- これ参加者の方、共感いただけますよね?!

- 学習時間は データ量・ステップ数によるが、30分〜数時間

-

--save_freqや--resumeなど便利なオプションが盛りだくさん

-

- 初めてロボットが「それっぽく」動いた瞬間は感動した

- Weights & Biases や Hugging Face Hub と連携できるのは、開発体験としてかなり良かった

- Hugging Face の 権限設定をミスって少しハマった

- お弁当が引き続き美味しい

- 別件があったため、早期離脱

- 出入りは自由だった

- ROS Japan UG #60に参加、こちらも楽しかった

Day 3: Mission 2

| Time | Session |

|---|---|

| 0:00–0:30 | ミッドナイトスナック |

| 0:30–8:00 | 休息 |

| 8:00–9:00 | 朝食(提供) |

| 9:00–12:00 | ハッカソン |

| 12:00–13:00 | 昼食(提供) |

| 13:00–16:00 | ハッカソン終了 & 提出期限 |

| 16:00–17:30 | 審査 |

| 17:00–18:00 | 夕食(提供) |

| 18:00–18:40 | Top 8 チームのデモ |

| 18:40–19:00 | 結果発表 |

| 19:00–19:30 | ハードウェアキット返却 |

| 19:30–20:00 | 撤収 |

- 諸事情により 筆者はこの日ほぼ戦線離脱

- 実質、チームメンバーに丸投げ状態

- 本当に感謝

- Mission 2 では、だるま落としを積んでもらうという比較的イージーなタスクを設定

- 色も違うし、認識しやすそう

- 難易度的にも初心者向けで妥当かも

- 沖縄らしいタスクだとなお良かったかも

- なお、チームメンバーがなぜかだるま落としを欲しがっていた

- 結果としてテーマ選定はスムーズだった

- お弁当は最後まで美味しかったようです

成果物

今回のハッカソンで取り組んだ成果物をまとめます。

どちらも Hugging Face Spaces 上で学習データセットを可視化できるWeb VisualizerのURLをつけていますので興味のある方はぜひご覧ください(Visualizerも用意されているなんて…LeRobotは便利ですね)。

前置き: Calibration & Teleoperation

ロボットに動作を覚えさせるために、本ハッカソンでは「模倣学習(Imitation Learning)」を用います。

模倣学習では、タスクを実行している際の人間の操作データが必要になります。このデータ収集に用いられるのが Teleoperation です。Teleoperation では、人が操作する リーダーアーム の動きに同期して、フォロワーアーム(実機ロボット) が動作します。人がタスクを遂行する様子をそのまま記録することで、学習用データを収集していきます。

なお、Teleoperation を行う前に、Calibration を実行します。これはリーダーアームとフォロワーアームの対応関係を正しく揃えるための初期設定です。公式ドキュメントおよびキャリブレーション手順は以下が参考になります。

Mission 1

※ 👆推論・評価の様子です、テレオペではなくロボットが自律動作していますMission 1 では、LeRobot を用いた基本タスクとして、「物体を把持し、指定された目標位置に配置する」という一連の動作を実装しました。

- キャリブレーション

- テレオペレーションによるデータ収集

- 学習

- 推論・評価

という開発の基本フローを、実機を使って一通り体験できたのが大きな収穫でした。

収集したデータセットは以下で可視化できます。

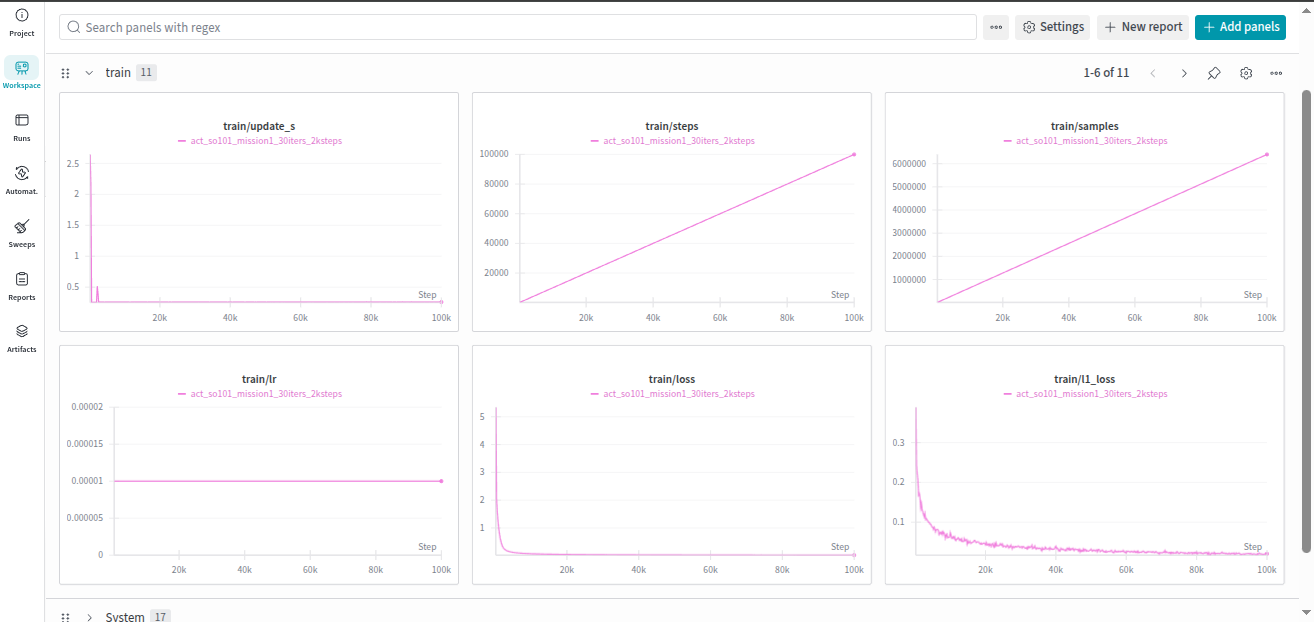

今回は、

- ポリシー:Action Chunking with Transformers

- データ数:30エピソード

- 学習回数:100kステップ

という設定で学習を行い、学習時間は 約8時間 でした。

Mission 2

※ 👆推論・評価の様子です、テレオペではなくロボットが自律動作していますMission 2 では、自由課題として「だるま落としを積み上げる」 タスクに挑戦しました。

このタスクを選んだ理由は、

- 色の違いが明確で、視覚的な認識がしやすい

- 動作自体の難易度が比較的低く、制御や学習に集中できる

といった点です。

結果として、時間の都合で十分なデータ収集ができず、タスク完遂には至りませんでした。ただし、Mission 1 で得た知見を応用しながら取り組めたため、自由課題としてはちょうど良い題材だったと感じています。

データセットはこちらです。

- ポリシー:Action Chunking with Transformers

- データ数:5エピソード

- 学習回数:5kステップ

- 学習時間:約30分

受賞作品

ネット上で発見できた受賞作品たちをまとめます。

🥇 1位:ドーナツロボ(GreatAkihabara)

ドーナツを梱包してくれます、2つのアームが連携して動いている…すごい。

ポリシーはSmolVLAを採用し、箱詰めと箱閉めで別のモデルを使用しているとのこと。

https://x.com/yuji_fujima/status/1998008069897519446

🥈 2位:パスタ調理ロボ(kufusha)

調理器具を使用して一連のパスタ調理を自動化していました、すごい。

https://www.kufusha.com/information/p007198/

https://www.kufusha.com/works/robotics/w007148/

🥉 3位:寿司大将(Cog Bots)

回転寿司ピックアップロボです、サーモン・マグロ・玉子からネタを選択すると対象のお皿をピックアップしてくれます。

Diffusion Transformer(DiT)アーキテクチャとFlow MatchingフレームワークをつかったStreaming Flow(自作ポリシー!)を採用し、258kパラメータと比較的軽量なモデルで高精度を達成しているとのことです。

コードを見ると音声認識もしている?学生さんとのことですが、すごすぎます…!

https://x.com/keio_crl/status/1997970569774674255

https://github.com/Mamo1031/AMD_Robotics_Hackathon_2025_Sushi_Taisho

こちらのチームは詳細記事を書いていただいているようでした、参考になります…!

おわりに

とにかく、楽しいハッカソンでした。

参加者の皆様、お疲れ様でした。そして運営の皆様、このような貴重な機会をいただき、本当にありがとうございました。

会場に泊まり込み、実機ロボットに触れ、世界規模の OSS・プラットフォームを前提に開発する。こうした体験は、なかなか日常では得られないものだと思います。

ただ、筆者は体調を崩しました。ハッカソンは、技術力だけでなく体力配分も重要です。無理はせず、ほどほどにしましょう。

今後も Physical AI・ロボティクスの動向には注目していきたいところです。某猫型ロボットは 2112年9月3日生まれ らしいですが、あと100年弱あれば実現も夢じゃないかもな── そんなことを考えてしまう年末となりました。

なお、今回使ったロボットアーム SO-101 は個人でも手が届く価格帯ですし、Google Colab等でも学習可能らしいので、興味を持っていただけた方は、年末年始の自由研究として検討してみるのもアリかもしれません。書き初めや凧揚げなどお正月らしいことをやらせてみたら楽しそうですね。

それでは、良いお年を。

この記事は、AI文章校正ツール「ちゅらいと」で校正されています。