はじめまして、sonesuke( https://twitter.com/sonesuke ) です。 LLMのニュースを追っかけ続けたので、これからキャッチアップする人用にまとめておきます。

単発のプロンプトテクニックについてはこちらご覧ください。

これだけは知っとけ用語

各手法の説明を読む前に、これらの用語を読んでおくと各手法がわかります。知っている人は飛ばしてください。

プロンプトエンジニアリング

入力(プロンプト)を工夫して性能をあげようというアプローチ。

機械学習系で精度アップといえば、追加学習させたりモデルを拡張するのですが、LLMではモデルが大き過ぎてコストが洒落になりません。

そのような事情からプロンプト側を工夫することで、回答に直接影響を与えるという手法が発達しています。

ファインチューニング

モデルを新たな学習データで追加学習させ、モデルのパラメータを更新し、精度を高めようというもの。いわゆる普通の機械学習。

Zero-Shot / Few-Shot

ここでいうShotは、例示の意味。Zero-shotだと、例示なし。Few-shotだと、2, 3個の例示をという意味。

Hallucination

いわゆるGPT嘘つき問題。

LLMは、あくまでも次のワードとして確率が高いものを出しているだけで、別に事実確認はしていないし、論理的に考えているわけでもありません。まったく学習していないものに対して、それっぽいけど間違っているものを出力してしまいます。

これは実用上の問題になることが多く、さまざまな対応策が提案されています。主アプローチは以下の2つです。

- 飛躍が起きないように段階的に考えさせる。

- 知らないものは調べさせる

各手法

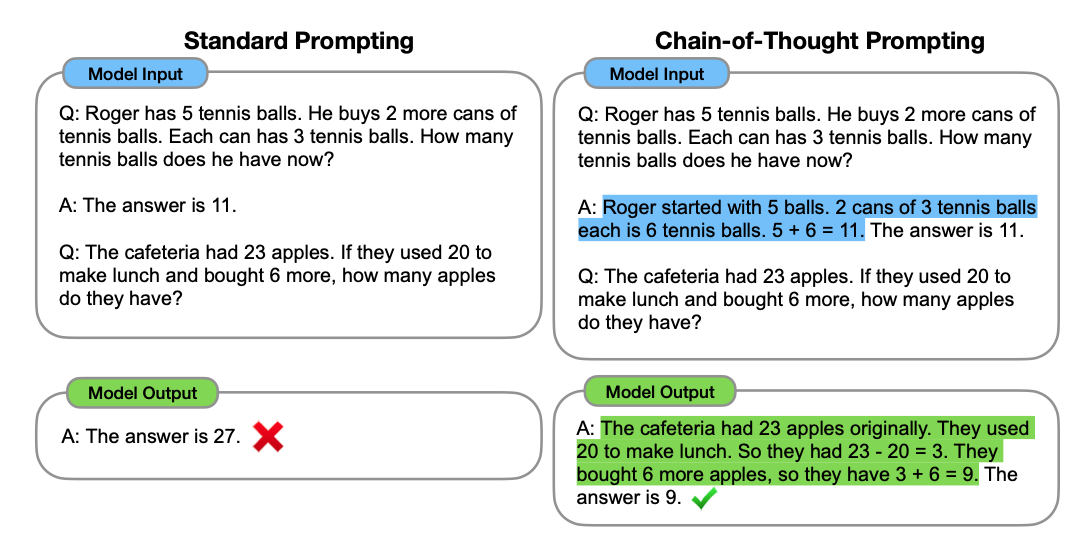

Chain of Thought

あらかじめ関連するQuestionとAnswerを例示し、推論の道筋を方向づけします。

ポイントは

- 同じ構造の問題を選んで例示する

- 例示の解答部分で問題の構造を分解して答えを示す

Zero-shot-CoT

「段階的、論理的に考えて」をつけておけば、とりあえず性能があがると一時流行っていたやつです。英語だと、”Let’s think step by step”

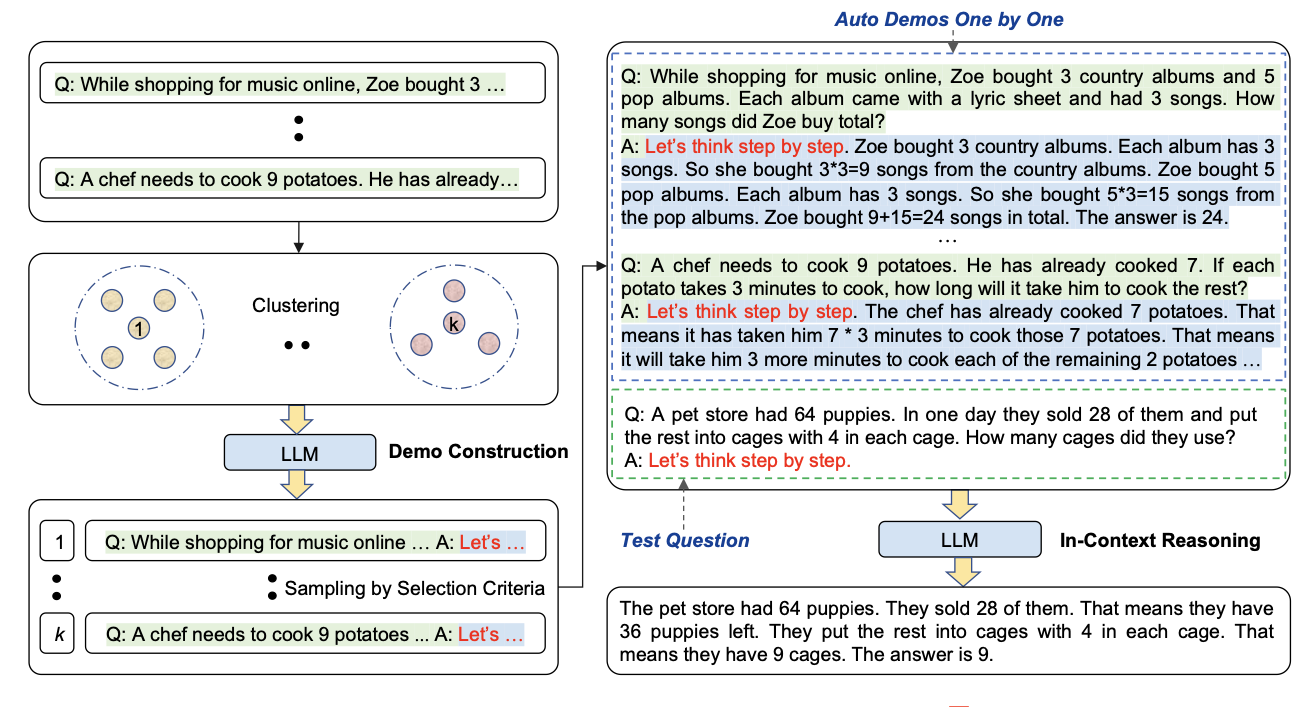

Automatic Chain of Thought

Zero-shot-CoT + Manual CoT + Retriever。(Retrieverとは、検索エンジンだと思ってください。)

これで、最適なQAを選択し、例示することで性能を上げます。

ステップ

- 前準備として”Let’s think step by step”でのQA集をクラスタリングしてもっておく

- ユーザーから入力が来た際に、クラスタからQAを持ってきて、入力にCoTとして入れる

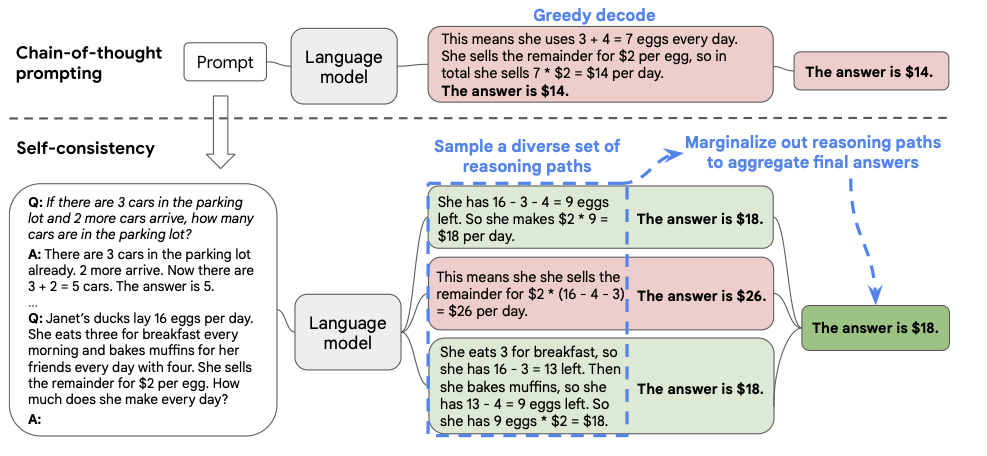

Self-consistency

多数決 CoT。

たくさんのCoTの結果をマージすることで解答の精度を高めます。

ステップ

- 入力(プロンプト)に対応するCoTの答えの部分をサンプリングし、複数個持つ

- 複数の解答をマージして、最終の答えとする

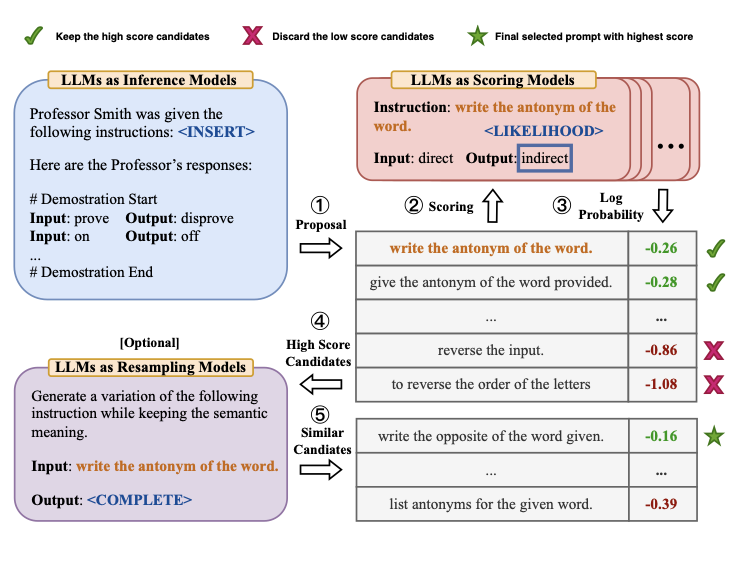

APE (Automatic Prompt Engineer)

プロンプトエンジニアリング自体を自動化してよい入力を作ります。

ステップ

- 出力から、入力を予測 (Reverse Generation)

- 入力に対しスコアを計算

- スコアに基づいて、入力を決める。 (スコアが収束するまで反復してもよい)

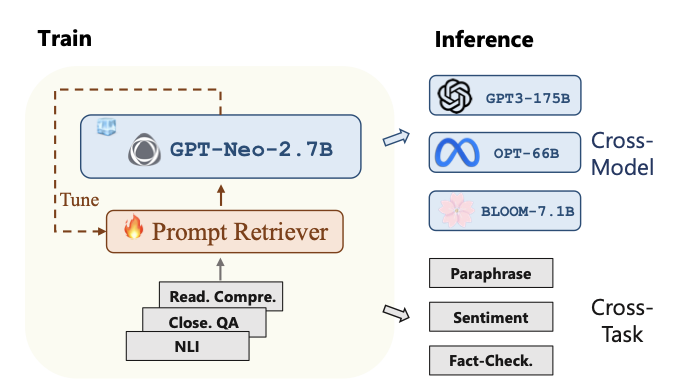

UPRISE (Universal Prompt Retrieval for Improving Zero-Shot Evaluation)

Prompt Retrieverという最適なプロンプトを検索するLLMを使って、タスク(用のプロンプト)やモデルを選択します。

Prompt Retrieverとして、GPT-Neo-2.7Bという小さめのLLMを使っているところも特徴。

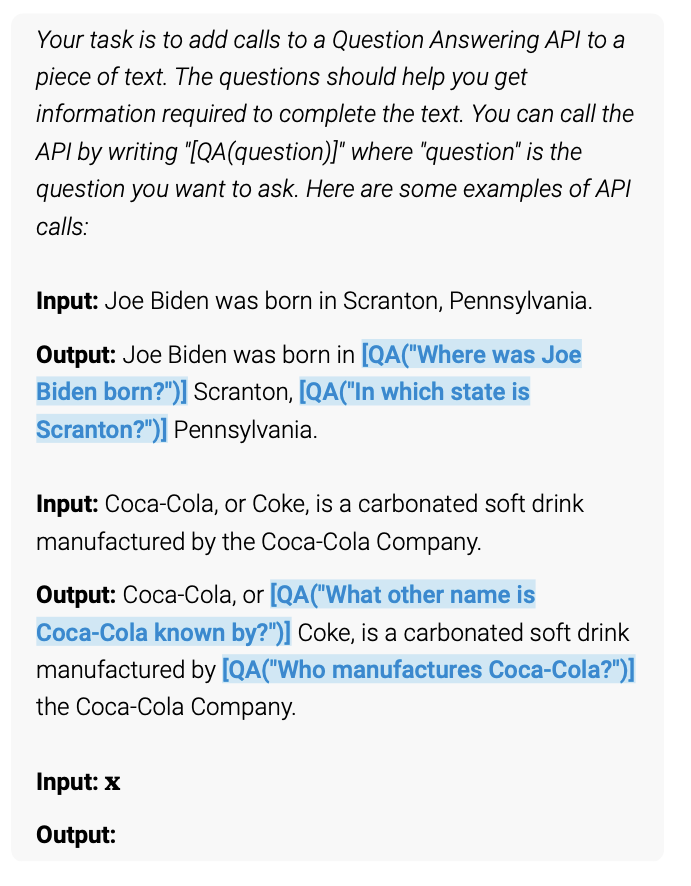

Toolformer

APIを使ってサーチエンジンや計算などの知識を取り込み、LLMが苦手なところを補います。

下記は、QA(質問)というAPIを使用する方法。

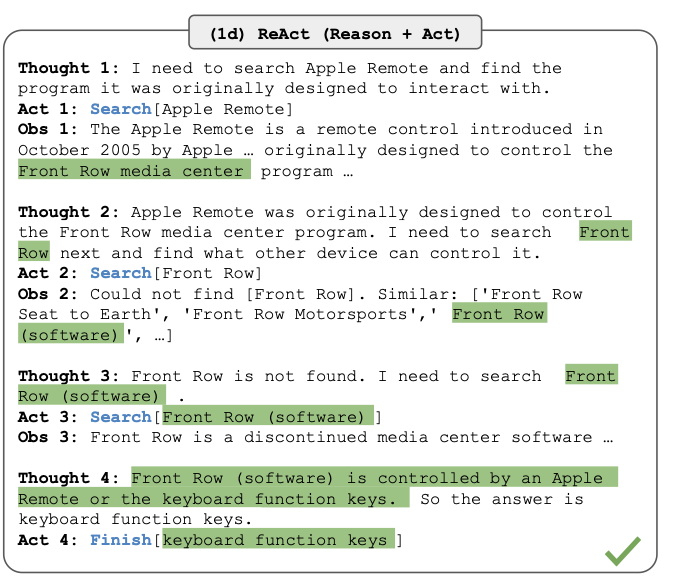

ReAct

推論(Thought)と行動(Act)をReActフォーマットで入力を作り、実際にツールと連携して、解を導きます。

行動(Act)として、Searchなどのツールを自然に取り込むことができ、Obsとしてコンテキストに組み込まれます。

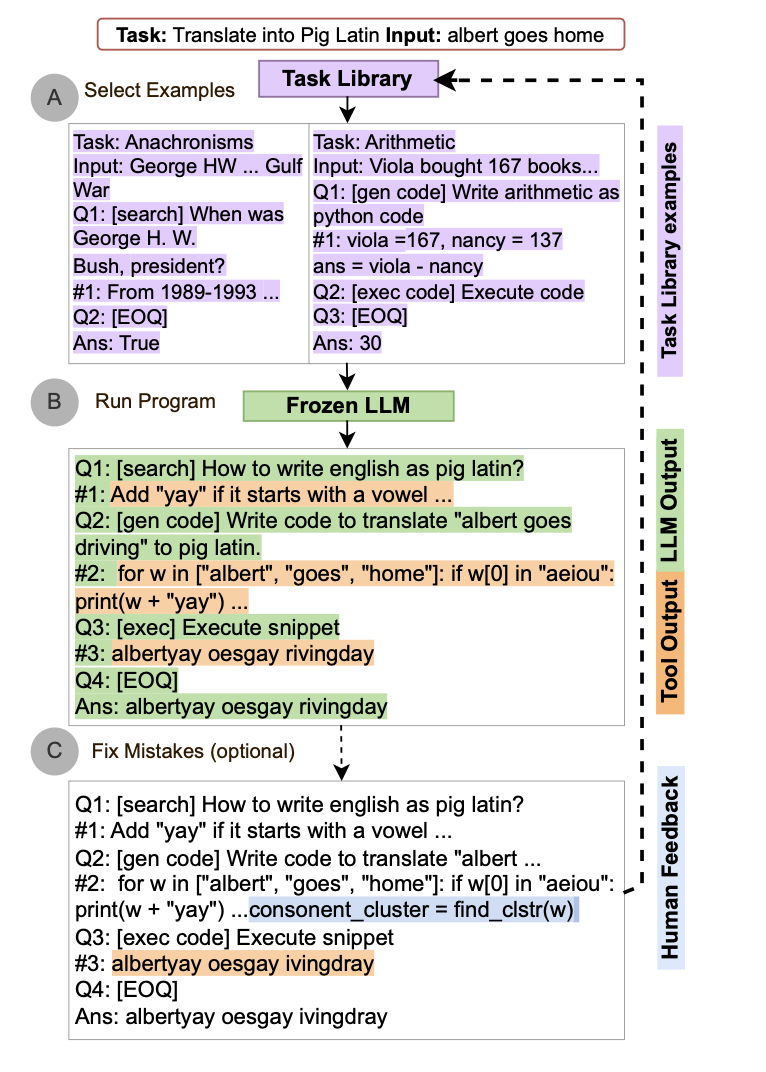

ART(Automatic Reasoning and Tool-use)

タスクライブラリとツールライブラリから、LLMを使って入力を作って、推論させます。

LLMを使って、推論ステップを生成しているところが特徴です。

まとめ

プロンプトエンジニアリングの分野はタケノコのように新手法が出てきています。

とはいうものの、基本的には、「複数回のステップに分ける」「外部の知識を取り入れる」というものが多数で、

- どういうステップに分解させるか

- 外部知識の取得をどうやって計画させるか

- これらをどうやってコンテキストに盛り込むか

というところで工夫していく方向かと思われます。

なかなかまとめ上げるのに骨が折れました。皆様の参考になれば幸いです。

こういうをChatGPT君がやってくれるんじゃなかったっけ?