はじめまして

GMOコネクトで執行役員CTOしている菅野 哲(かんの さとる)です。

Limitless AIを装備して24時間生きているワケですが、気になる投稿があったのでアレコレ考えた結果をまとめてみました。

暗号おじさんとしては、高機能暗号の出番がそろそろ出てくるんじゃない?とワクテカしています。

はじめに

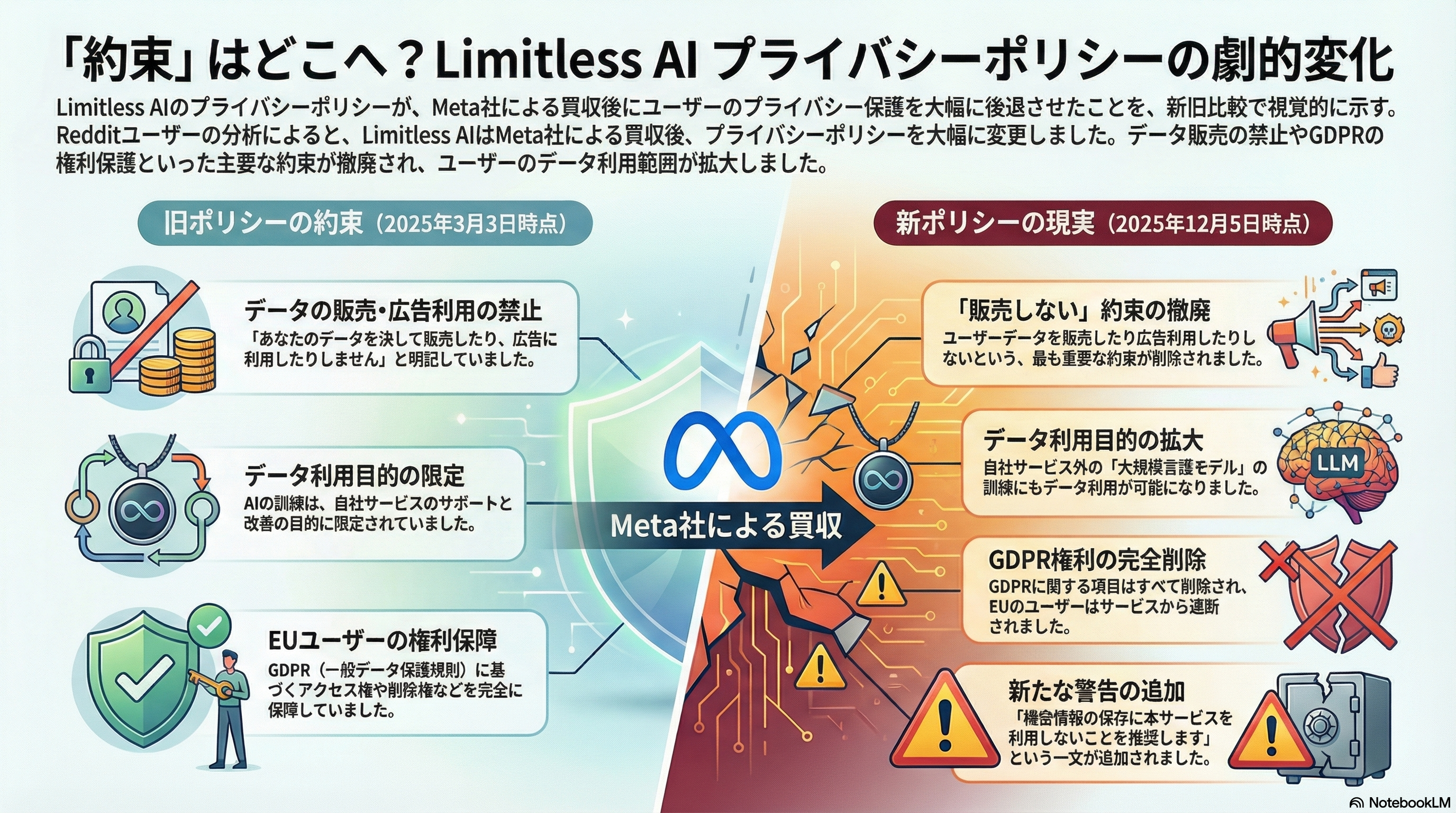

2025年12月5日、AIペンダント「Limitless」を開発するLimitless AI社がMetaに買収されたことが発表された。同日、同社のプライバシーポリシーが改定され、わずか9ヶ月前の2025年3月版と比較して大幅にプライバシー保護が後退する内容となった。この事例は、身の回りの情報をAIサービスに蓄積させることの本質的なリスクを浮き彫りにしている。

Limitlessプライバシーポリシー変更の衝撃

Meta買収の経緯

Limitless AI社は、会話を録音・文字起こしするAIペンダントを開発していたスタートアップ企業である。同社は2020年に「Rewind」として創業し、2024年にLimitless AIへと社名変更、99ドルのAIペンダントの販売を開始していた。同社は、a16z、First Round Capital、NEAなどから累計3,300万ドル以上の資金調達を行っていた。

2025年12月5日、MetaによるLimitless買収が公式に発表された。買収金額は非公開だが、Metaは「AI対応ウェアラブルの開発を加速するためにLimitlessチームが参加することに興奮している」と述べている。LimitlessチームはMetaのReality Labs部門のウェアラブル組織に統合される予定である。

買収に伴い、Limitlessペンダントの新規販売は終了し、既存顧客には最低1年間のサポートが提供されるが、ブラジル、中国、EU、イスラエル、韓国、トルコ、英国では2025年12月5日をもってサービス提供が終了した。また、デスクトップ活動を記録する「Rewind」アプリは12月19日にすべての画面・音声キャプチャ機能が停止される。

プライバシーポリシーの主要な変更点

Redditユーザーによる詳細な比較分析によれば、2025年3月3日版と12月5日版のプライバシーポリシーには以下の重大な変更が含まれている。以下は、Reddit投稿(r/limitlessaipendant)から引用した差分表である:

| Section | March 3 2025 policy | December 5 2025 policy | Key change |

|---|---|---|---|

| Intro/No‑sell promise | "We will never sell your data or use your data for advertising." | This promise is removed. | Removes explicit pledge not to sell data or use it for advertising. |

| Data uses – AI training | "To train, develop, and improve the artificial intelligence, machine learning, and models that we use to support our services." | "To train, develop, and improve artificial intelligence, machine learning, and other large language models" (standalone statement). | The purpose is broadened, allowing data to train large language models beyond the company's services. |

| Data uses – additional purposes | Not applicable (no explicit clause). | Adds purposes such as "test and enhance our services" and using de‑identified, anonymized or aggregate data for any legal purpose. | Introduces broad testing and de‑identified data use for unspecified purposes. |

| Third‑party AI providers | Data sent to third‑party AI providers is not used for training and is deleted after 30 days. | Assurance that data is not used for training and is deleted after 30 days is removed; the policy simply discloses that data is shared with third‑party providers for transcription and summarization. | Removes time‑limited deletion and no‑training guarantee for third‑party AI services. |

| Disclosures | Lists vendors, limited AI providers, analytics services (Amplitude, Sentry, Fathom, Segment), advertising partners and law‑enforcement/mergers. | Adds affiliates and professional advisors, removes advertising partners, and broadens law‑enforcement disclosures. | Expands who data may be shared with. |

| EEA/GDPR rights | Includes a full section explaining grounds for processing (consent, contract necessity, legal obligation, legitimate interests) and user rights (access, deletion, portability, objection). | Completely removed. | Eliminates explicit GDPR rights for EU/EEA users. |

| Security warning | Advises that the company uses "reasonable safeguards" and that no method is completely foolproof. | Adds: "We recommend that you do not use the Services to store sensitive or confidential information.". | Emphasises that users should not store sensitive or confidential data using the service. |

| Retention | States that data is deleted when it is no longer necessary and considers relationship length and legal requirements. | Allows pendant users to choose "indefinitely"; no auto‑delete for user‑selected retention. | Enables indefinite retention for users who opt to keep data. |

| Children | Service not intended for users under 18. | Changes threshold to users under 13. | Lowers the age restriction. |

| Do not Track | States "We do not respond to Do Not Track signals". | The statement is removed. | Eliminates explicit handling of Do Not Track signals. |

| International mentions | Mentions standard contractual clauses for EEA/UK‑US transfers and "safeguards to afford adequate protection". | Simplifies to say data is hosted in the US and users consent to transfers by using the service. | Simplifies cross‑border transfer language; places burden on user consent. |

(出典:Reddit r/limitlessaipendant "New Privacy Policy as of December 5th, 2025 - IMPORTANT CHANGES")

主要な変更点の詳細は以下の通りである:

1. データ販売・広告利用禁止の約束の削除

旧ポリシー(3月版)には「私たちはあなたのデータを販売したり、広告のために使用したりすることは決してありません」という明示的な約束があったが、新ポリシー(12月版)ではこの記述が完全に削除された。

2. AIトレーニング目的の拡大

- 旧:「当社のサービスをサポートするために使用する人工知能、機械学習、モデルのトレーニング、開発、改善のため」

- 新:「人工知能、機械学習、その他の大規模言語モデルのトレーニング、開発、改善のため」(独立した記述)

この変更により、データが同社のサービスの枠を超えて、より広範な大規模言語モデルのトレーニングに使用される可能性が示唆されている。

3. サードパーティAIプロバイダーに関する保証の削除

旧ポリシーでは、サードパーティのAIプロバイダーに送信されたデータは「トレーニングには使用されず」、「30日後に削除される」と明記されていたが、新ポリシーではこれらの保証が削除され、単に文字起こしと要約のためにサードパーティプロバイダーとデータを共有することのみが開示されている。

4. EEA/GDPR関連セクションの完全削除

旧ポリシーには、処理の根拠(同意、契約上の必要性、法的義務、正当な利益)とユーザーの権利(アクセス、削除、移植性、異議申し立て)を説明する完全なセクションが含まれていたが、新ポリシーではこのセクションが完全に削除された。

5. セキュリティに関する新たな警告

新ポリシーでは「サービスを使用して機密情報や秘密情報を保存しないことをお勧めします」という記述が追加され、サービスが機密データに対して強固なセキュリティを提供しないことが示唆されている。

6. その他の変更

- データ開示先の拡大:「関連会社」と「専門アドバイザー」が追加され、法執行機関への開示が拡大

- データ保持期間:ペンダントユーザーは「無期限」の保持を選択可能に

- 児童の年齢制限:18歳未満から13歳未満に引き下げ

- Do Not Track信号への対応に関する記述の削除

- 国際データ転送:標準契約条項(SCC)の説明が簡略化され、「サービスを使用することでユーザーは転送に同意する」という記述に変更

これらの変更は、より広範なデータ使用と明示的なプライバシー保護の削減への移行を示しており、2025年12月5日版のポリシーは3月3日版よりも大幅に保護が弱くなっている。

AIグラス時代の到来:音声から映像データへの質的転換

Meta Ray-Banスマートグラスの進化

Metaは2023年にRay-Banと共同でスマートグラスを発売し、2025年9月には次世代の「Meta Ray-Ban Display」を発表した。この新型は、以下の特徴を持つ:

- レンズ内蔵のフルカラー高解像度ディスプレイ(600×600ピクセル、視野角20度)

- 12MPカメラと3倍ズーム

- リアルタイム翻訳とライブキャプション機能

- Meta AIとの統合による視覚的応答

- 歩行者ナビゲーション機能

- Meta Neural Band(筋電図(sEMG)リストバンド)によるジェスチャー制御

価格は799ドルで、2025年9月30日に米国で発売され、2026年初頭にカナダ、フランス、イタリア、英国への展開が予定されている。

蓄積されるデータの質的・量的変化

AIグラスは、従来の音声のみのデバイスと比較して、以下のような質的に異なるデータを収集する:

- 映像データ:ユーザーが見ているものすべて

- 位置情報:ナビゲーション機能による継続的な位置追跡

- 視線データ:ユーザーが何に注目しているか

- 周囲の人物:意図せず他者の顔や行動が記録される

- 環境情報:訪問した場所、閲覧した文書、会話の相手など

これらのデータは、24時間365日記録される可能性があり、その総量と機密性は従来のスマートフォンやペンダント型デバイスを大きく上回る。

ビッグテックによるM&Aがもたらす「理念の喪失」リスク

WhatsAppとInstagramの前例

Metaによる買収後のプライバシーポリシー変更は、Limitlessが初めてではない。過去にも以下の事例がある:

WhatsApp(2014年買収)

2021年1月、WhatsAppは新しいプライバシーポリシーを発表し、親会社Facebookとのデータ共有を拡大することを明らかにした。この変更は大きな反発を呼び、多くのユーザーがSignalやTelegramなどの代替アプリに移行した。特に、WhatsApp Businessチャットは転送中のみ暗号化されており、企業と協力する第三者がデータをどう扱うかは企業の裁量に委ねられている。

Instagram(2012年買収)

2020年、Instagramは未成年者のデータを標的広告のために収集しているとして告発された。18歳未満のInstagramユーザー10万人以上の生体認証データを収集したとして、Facebook(現Meta)に対して訴訟が提起された。

これらの事例は、買収後に当初のプライバシー重視の姿勢が失われ、親会社のデータ収集・活用戦略に統合されていくパターンを示している。

規約変更の法的正当性と倫理的問題の乖離

多くの場合、企業は利用規約を一方的に変更する権利を持っており、ユーザーは変更を受け入れるか、サービスから離脱するかの二択しかない。Limitlessの場合、既存ユーザーはデータのエクスポートか削除を選択できるが、サービス継続を望む場合は新しいポリシーを受け入れざるを得ない。

この構造的な非対称性が、企業買収時のプライバシーリスクの本質である。ユーザーがスタートアップの理念を信頼してデータを預けたとしても、買収によってその理念は簡単に覆される可能性がある。

技術的解決策:利用者主権を担保する暗号技術

エンドツーエンド暗号化(E2EE):通信経路の保護

エンドツーエンド暗号化は、送信者と受信者の間でのみデータを復号できる仕組みである。通信経路上の第三者(攻撃者、ISP、政府機関など)からデータを保護できるが、重要な点として、データの受信者(事業者)自身はデータを復号できる。

例えば、メッセージングアプリのWhatsAppでは、ユーザーA ←→ ユーザーB の通信がE2EEで保護され、WhatsApp(事業者)も復号できない。しかし、AIサービスの場合、通信は「ユーザー ←→ AIサービス提供者(事業者)」となるため、E2EEを使用しても事業者はデータを復号して処理できる。

したがって、E2EEは以下には有効だが、事業者によるデータ利用やポリシー変更のリスクは防げない:

- 有効な保護対象:通信経路上の盗聴者、ハッカー、ISP、政府機関

- 保護できない対象:サービス提供者自身によるデータアクセス

WhatsAppとFacebook Messengerは2023年12月からデフォルトでE2EEを導入しているが、グループチャット、企業とのチャット、Marketplaceチャットは暗号化されていない。また、ユーザーが通報した暗号化メッセージは、その会話の最近のメッセージとともにMetaに転送され、レビューされる。

AIサービスで事業者からもデータを保護するには、E2EEだけでは不十分であり、次に述べる準同型暗号やクライアントサイド処理が必要となる。

AIサービスと暗号化の両立:準同型暗号(FHE)

従来、暗号化されたデータでAI処理を行うことは不可能だった。しかし、準同型暗号(Fully Homomorphic Encryption: FHE)により、データを復号することなく暗号化されたまま計算を実行できるようになった。

準同型暗号の仕組み

- クライアントが秘密鍵でデータを暗号化

- 暗号化されたデータをサーバーに送信

- サーバーが暗号化されたデータのまま計算を実行

- 暗号化された結果をクライアントに返送

- クライアントが秘密鍵で結果を復号

この仕組みにより、サービス提供者は一切平文データにアクセスすることなく、LLMの推論やデータ分析を実行できる。

2025年の実用化状況

2025年現在、準同型暗号は実用段階に入りつつある:

- Zamaなどの企業が、FHE専用のSDKとライブラリを提供

- SEAL-Python、TenSEAL、HElibなどのライブラリがCKKSスキームを使用した暗号化されたベクトル・行列演算をサポート

- クラウドプロバイダー(AWS、Azure)がFHE-as-a-Serviceを提供開始

- ハードウェアアクセラレーション(GPU、FPGA、専用ASIC)により、FHEの性能が大幅に向上

- Zamaは第一世代のFHEアクセラレーターで1,000倍の高速化、第二世代で10,000倍の高速化を目指している

実装例

2025年2月に発表された研究では、準同型暗号を使用したエンドツーエンドのニューラルネットワークが、平文のニューラルネットワークと同等の精度を達成できることが示された。また、Nature Machine Intelligence誌(2025年12月)では、準同型暗号を用いた深層強化学習フレームワークが発表され、状態、行動、報酬を暗号化したままDRLプロセスを実行できることが実証された。

課題

- 計算オーバーヘッド:CPUで実行する場合、暗号化されていないプログラムより少なくとも100万倍遅い

- ノイズ管理:計算を重ねるとノイズが蓄積し、復号できなくなるため、ブートストラッピング(ノイズの更新)が必要

- 複雑性:高度な数学的概念とセキュアプログラミングの習得が必要

しかし、ハードウェアアクセラレーションとアルゴリズムの改善により、これらの課題は急速に解消されつつある。

連合学習(Federated Learning):分散型AIトレーニング

連合学習は、データを中央サーバーに集約することなく、各デバイスでローカルにAIモデルをトレーニングし、モデルの更新のみを共有する手法である。

仕組み

- 中央サーバーがグローバルモデルを各デバイスに配布

- 各デバイスがローカルデータでモデルをトレーニング

- デバイスがモデルの更新(勾配やパラメータ)のみを中央サーバーに送信

- 中央サーバーがこれらの更新を集約して新しいグローバルモデルを作成

- 更新されたグローバルモデルを再び各デバイスに配布

プライバシー保護技術との組み合わせ

- 差分プライバシー:モデル更新にノイズを追加し、個々のデータポイントを特定できないようにする

- セキュアアグリゲーション:複数のデバイスからの更新を暗号化されたまま集約

- 準同型暗号:連合学習と組み合わせることで、さらに強固なプライバシー保護を実現

実用例

- Googleは「Gboard」キーボードで連合学習を使用し、ユーザーのタイピングパターンから学習しながら、実際のキーストロークを中央サーバーに送信しない

- 医療分野では、複数の病院が患者データを共有することなく、協調してAIモデルをトレーニング(2025年の研究では、8カ国12病院が連携し、肺がんのGTVセグメンテーションモデルをトレーニング)

- IoT環境でのリアルタイム侵入検知システム

その他の高度な暗号技術

ゼロ知識証明(Zero-Knowledge Proofs)

ある情報が真実であることを、その情報自体を明かすことなく証明する技術。ブロックチェーンと連合学習を組み合わせたフレームワークで、モデル更新の検証に使用されている。

属性ベース暗号(Attribute-Based Encryption)

ユーザーの属性(役職、部署など)に基づいてアクセス制御を行う暗号方式。細粒度のアクセス制御が可能。

閾値暗号(Threshold Encryption)

秘密鍵を複数の断片に分割し、一定数以上の断片が揃わないと復号できないようにする技術。鍵の紛失リスクを分散できる。

実装上の課題とトレードオフ

ユーザビリティとセキュリティのバランス

プライバシー保護技術を実装する際、技術的な完全性とユーザー体験のバランスが最も困難な課題となる。完全な暗号化を実装すると、以下のような実用上の問題が生じる。

鍵管理の複雑性

暗号化システムの根幹は秘密鍵の管理にある。ユーザーが秘密鍵を紛失すると、データが永久に失われるという問題は、一般ユーザーにとって大きな心理的負担となる。パスワードは「忘れたらリセット」できるが、暗号化鍵の紛失は取り返しがつかない。この問題に対処するため、様々なアプローチが提案されている。

閾値暗号(Threshold Encryption)を用いた鍵の分散管理では、秘密鍵を複数の断片に分割し、信頼できる複数の当事者(家族、友人、専門サービス)に分散して保管する。一定数以上の断片が揃わないと復号できないため、一つの断片が失われても問題ない。しかし、このアプローチは複数の信頼できる当事者を見つける必要があり、すべてのユーザーにとって現実的とは言えない。

複数デバイス間での鍵の同期も重要な課題である。ユーザーは通常、スマートフォン、タブレット、PCなど複数のデバイスを使用するため、すべてのデバイスで同じデータにアクセスできる必要がある。Signal Protocolのような「セッション管理」プロトコルでは、デバイスごとに異なる鍵ペアを持ちながら、セキュアに鍵交換を行う仕組みを提供している。ただし、この仕組みの実装は複雑であり、開発コストが増大する。

機能制限とのトレードオフ

暗号化されたデータに対しては、特定の操作が困難または不可能になる。全文検索、並べ替え、フィルタリングなど、平文データでは当たり前に実行できる操作が、暗号化されたデータでは大幅に制限される。検索可能暗号(Searchable Encryption)やOrder-Preserving Encryption(順序保存暗号)などの技術が研究されているが、これらは完全な準同型暗号と比較してセキュリティが弱く、特定の攻撃に対して脆弱である。

AI機能についても、暗号化により一部が制限される可能性がある。例えば、リアルタイムの音声認識や画像認識は、準同型暗号の計算オーバーヘッドにより、レスポンスタイムが大幅に遅延する可能性がある。ユーザーがAIアシスタントに質問してから回答が返ってくるまで数秒から数十秒かかるようでは、実用的とは言えない。

パフォーマンスとバッテリー消費

準同型暗号は依然として計算コストが高い。2025年時点のハードウェアアクセラレーターにより大幅な改善が見られるものの、平文処理と比較すると依然として桁違いに遅い。特にウェアラブルデバイスのような小型デバイスでは、計算能力とバッテリー容量が限られているため、準同型暗号の実装はより困難である。

AIグラスのようなデバイスでは、カメラ、ディスプレイ、通信モジュールがすでに多くの電力を消費しているため、さらに準同型暗号の計算を追加すると、バッテリー寿命が実用レベル以下に低下する可能性がある。Meta Ray-Ban Displayは混合使用で6時間のバッテリー寿命を持つが、準同型暗号を追加すると、これが2〜3時間に短縮される可能性がある。

この問題に対する現実的なアプローチは、ハイブリッド方式である。センシティブなデータ(会話内容、個人情報)のみを準同型暗号で保護し、一般的なデータ(公開情報、匿名化された統計データ)は通常の暗号化または平文で処理する。このアプローチにより、セキュリティとパフォーマンスのバランスを取ることができる。

AI処理との両立:現実的なアプローチ

AIサービスと暗号化を両立させるため、複数のアプローチが並行して研究・実装されている。

1. ハイブリッドアプローチ:FHEとTEEの組み合わせ

2025年に発表された「Secure Bridge」フレームワークは、準同型暗号(FHE)とTrusted Execution Environment(TEE、信頼できる実行環境)を組み合わせたハイブリッドアプローチを提案している。FHEでサポートされる操作はFHEで実行し、複雑な計算やレイテンシに敏感なタスクはTEE内で実行する。

TEEは、IntelのSGX(Software Guard Extensions)やAMDのSEV(Secure Encrypted Virtualization)のような技術で、メインプロセッサ内に隔離された安全な実行領域を作成する。この領域内では、OS管理者やハイパーバイザーでさえアクセスできない。ただし、TEEはハードウェアベンダーを信頼する必要があり、過去にはSGXに対する攻撃も報告されている。

このハイブリッドアプローチにより、デフォルトで平文を公開せず、柔軟なツール統合をサポートできる。Model Context Protocol(MCP)ゲートウェイがツール統合を制御し、型付きスキーマ、最小権限アクセス、機密データの編集、改ざん防止ログを適用する。

2. クライアントサイド処理:デバイス上でのAI実行

可能な限りデバイス上でAI処理を実行することで、データを外部に送信する必要がなくなる。AppleはiPhoneやiPadでオンデバイスのSiri処理を推進しており、GoogleもPixelシリーズでオンデバイスAI機能を強化している。

2025年時点で、スマートフォンやAIグラスに搭載されるプロセッサ(Qualcomm Snapdragon、Apple Silicon、Google Tensorなど)は、専用のNPU(Neural Processing Unit)を搭載し、デバイス上で高度なAI推論を実行できる。Meta Ray-Ban DisplayもQualcomm Snapdragon AR1 Gen1プロセッサを搭載しており、オンデバイスAI処理の基盤を持っている。

ただし、大規模言語モデル(LLM)のような巨大なモデルは、依然としてクラウド処理が必要である。700億パラメータのLLMをスマートフォンで実行するには、メモリとストレージが不足している。この問題に対する解決策として、モデルの量子化(パラメータのビット数を削減)や、小型の蒸留モデル(大規模モデルの知識を小型モデルに転移)が研究されている。

3. 連合学習:分散型トレーニングの実践

連合学習は、モデルトレーニングの段階でプライバシーを保護する。各デバイスがローカルデータでモデルをトレーニングし、モデルの更新のみを中央サーバーに送信する。中央サーバーはこれらの更新を集約するが、元のデータにはアクセスできない。

連合学習は、差分プライバシー、セキュアアグリゲーション、準同型暗号などの技術と組み合わせることで、さらに強固なプライバシー保護を実現できる。差分プライバシーでは、モデル更新にノイズを追加し、個々のデータポイントを特定できないようにする。セキュアアグリゲーションでは、複数のデバイスからの更新を暗号化されたまま集約し、中央サーバーでさえ個々のデバイスの更新を見ることができない。

2025年の医療分野の研究では、8カ国12病院が連合学習フレームワーク「Personal Health Train(PHT)」を使用し、肺がんのGTVセグメンテーションモデルをトレーニングした。このプロジェクトでは、患者データが病院外に共有されることなく、高精度なAIモデルが開発された。Secure Aggregation Server(SAS)により、モデルの平均化が安全な環境で行われ、潜在的なデータ漏洩の問題が軽減された。

規制の現状と課題:GDPRとAIの交差点

欧州のジレンマ:プライバシー保護か経済競争力か

2025年11月19日、欧州委員会は「Digital Omnibus」パッケージを発表し、GDPR、AI Act、ePrivacy規則の大幅な改定を提案した。この提案は、過去10年間EUが構築してきたプライバシー保護の枠組みを根本的に見直そうとする動きであり、国際的に大きな注目を集めている。

欧州委員会の公式説明によれば、この改定の目的は「コンプライアンスの負担を軽減し、法的確実性を向上させ、特に中小企業にとって規制の複雑性を低減すること」である。背景には、2024年に元イタリア首相マリオ・ドラギが発表した報告書があり、欧州の複雑な法律がイノベーションを阻害し、米国や中国との競争で遅れをとっているという警告が含まれていた。

しかし、この「簡素化」の名の下に提案されている変更は、実質的にプライバシー保護の後退を意味するとの批判が強い。オーストリアのプライバシーNGO「noyb」と欧州デジタル権利団体(EDRi)は、この提案を「EUデジタル保護の大幅な後退」と強く批判している。

Digital Omnibusの主要な変更点とその影響

AI開発のための正当な利益の明確化

最も重要な変更の一つは、個人データをAIシステムやモデルの開発・トレーニングに使用することを「正当な利益」として明示的に認める新条項の追加である。現行GDPRでは、AI開発のためのデータ処理が正当な利益に該当するかどうかが不明確であり、多くの企業は「同意」を取得するか、処理を控えるかの二択を迫られていた。

新しい条項により、企業は同意なしにAIトレーニング用のデータを処理できる可能性が高まる。ただし、管理者は依然として必要性と比例性のバランステストを実施し、適切な保護措置を講じる必要がある。これには、AIトレーニングに使用するデータの最小化、データ主体がデータ処理に無条件に異議を唱える権利の付与が含まれる。この変更は、欧州のAI企業にとっては朗報であるが、プライバシー擁護団体は「オプトアウト」方式の限界を指摘している。

個人データの定義の見直し

最も論争を呼んでいる変更の一つは、個人データの定義の狭小化である。noybの分析によれば、リークされた草案では、直接的に個人を特定できない情報は、他のデータとリンク可能であっても個人データとして扱われなくなる可能性がある。この変更により、広告ID、Cookie、IPアドレスなどの仮名識別子がGDPR保護の対象外となる恐れがある。これらの識別子は、単独では個人を特定できないが、複数のデータソースを組み合わせることで個人を特定できる。現行GDPRでは、このような「リンク可能性」も個人データの判断基準に含まれているが、新しい定義ではこの保護が失われる可能性がある。

2025年11月19日に正式発表されたDigital Omnibusでは、健康データの定義を制限する条項(直接的に健康状態を明らかにするデータのみを健康データとする)は含まれなかったが、プライバシー擁護団体は依然として警戒を続けている。

データ主体の権利行使の制限

新しい提案では、データへのアクセス、修正、削除の権利が「データ保護目的」に制限される可能性がある。実務上、これは労働者が雇用紛争でデータ要求を使用したり、ジャーナリストが調査報道のためにデータを要求したり、消費者が企業の不正行為を立証するためにデータを要求することがブロックされる可能性を意味する。さらに、管理者がデータ主体のアクセス要求に対して手数料を請求できる範囲が拡大される可能性がある。

批判と支持

オーストリアのプライバシーNGO「noyb」の分析によれば、この提案はGDPR保護を大幅に弱める可能性がある。欧州デジタル権利団体(EDRi)は、これを「EUデジタル保護の大幅な後退」と批判している。100人以上の法律専門家が、Digital Omnibusの提案がEU法に違反していると指摘している。

一方で、産業界は概ねDigital Omnibusを歓迎している。特に中小企業は、現行GDPRのコンプライアンスコストが事業の大きな負担になっていると訴えている。GDPRの現在の制約がAIイノベーションを妨げ、特に中小企業にとってコンプライアンスが不釣り合いに困難になっていると主張している。

国際的な影響:「ブリュッセル効果」の逆転か

GDPRは、2018年の施行以来、「ブリュッセル効果」として知られる現象を引き起こした。世界中の国々が、EUの厳格なプライバシー基準を模範としてデータ保護法を制定した。ブラジルのLGPD(一般データ保護法)、カリフォルニア州のCCPA(カリフォルニア州消費者プライバシー法)、インドの個人データ保護法、日本の個人情報保護法の改正など、多くがGDPRの影響を受けている。

しかし、EUがプライバシー保護を緩和する方向に舵を切れば、この「ブリュッセル効果」が逆転する可能性がある。他国も「競争力」を理由にプライバシー保護を弱めるかもしれない。これは、世界的なプライバシー保護のレベルを引き下げるレースになりかねない。英国情報コミッショナー(ICO)は、リスクベースでプラグマティックなデータ保護アプローチを採用しており、Digital Omnibusの簡素化の方向性を歓迎する可能性がある。

標準化の進展:技術的基盤の整備

規制の議論と並行して、プライバシー保護技術の標準化も進展している。

NIST(米国国立標準技術研究所)

NISTは準同型暗号を「暗号化されたデータで評価を可能にする特殊なタイプの暗号化スキーム」として認識し、プライバシー強化暗号(Privacy-Enhancing Cryptography: PEC)に関するワークショップシリーズを開催している。2024年のWPEC(Workshop on Privacy-Enhancing Cryptography)では、医療、金融分野でのFHEのユースケース、パフォーマンスガイドライン、FHEハードウェアパフォーマンスに関するセッションが含まれていた。

ISO/IEC標準

ISO/IEC 18033-6:2019は、準同型暗号のメカニズム(Exponential ElGamal、Paillierスキームなど)を規定している。この標準は、異なる実装間の相互運用性を確保し、セキュリティパラメータの選択に関するガイダンスを提供している。

HomomorphicEncryption.org

産業界と学術界の協力組織であるHomomorphicEncryption.orgは、2018年に準同型暗号セキュリティ標準を公開し、API/SDK標準の策定を継続している。この組織には、Microsoft、IBM、Intel、Google、Inpher、Dualityなどの主要企業が参加しており、実用的な標準の開発に取り組んでいる。これらの標準化活動により、準同型暗号の実装が標準化され、異なるベンダー間の相互運用性が向上し、セキュリティパラメータの選択が明確になることが期待されている。

まとめ:プライバシー・バイ・デザインの必要性

規約への「信頼」から技術的「保証」へ

Limitlessの事例が示すように、企業のプライバシーポリシーは買収や経営判断により容易に変更される。「データを販売しない」という約束は、法的拘束力が弱く、ユーザーは企業の善意に依存するしかない。9ヶ月という短期間で、明示的なプライバシー保護の約束が削除され、データ使用の範囲が大幅に拡大された。これは、プライバシーポリシーという「紙の約束」の脆弱性を端的に示している。

真の解決策は、技術的な保証である。暗号化により、企業がデータにアクセスできない、またはアクセスしても意味のあるデータとして読み取れない状態を技術的に保証することで、ポリシー変更のリスクを無効化できる。具体的には、以下の技術的保証が必要である:

-

準同型暗号(FHE) により、事業者がデータを復号せずにAI処理が可能。2025年時点で、ハードウェアアクセラレーターにより実用的な性能が達成されつつある。

-

クライアントサイド処理により、デバイス上でAI処理を完結し、データを外部に送信しない。スマートフォンやAIグラスのNPUの進化により、オンデバイスでの高度なAI推論が可能になっている。

-

連合学習により、データを中央サーバーに集約しない。Google、Apple、医療機関などで実運用が始まっており、プライバシーを保護しながらAIモデルを改善できる。

-

エンドツーエンド暗号化(E2EE) により、通信経路上の第三者からデータを保護(ただし、事業者自身は復号可能)。メッセージングアプリでは標準となっているが、AIサービスでは事業者からの保護には不十分。

-

オープンソース実装により、暗号化の実装が検証可能。独立した第三者による監査により、バックドアや脆弱性がないことを確認できる。

これらの技術を組み合わせることで、「ゼロ知識AIサービス」が実現可能になる。サービス提供者は暗号化されたデータのみを処理し、ユーザーの実際の情報にはアクセスできない。このアーキテクチャにより、買収やポリシー変更があっても、データのプライバシーは技術的に保証される。

AIグラス時代に求められる設計原則

今後、AIグラスなどのウェアラブルデバイスが普及するにつれ、以下の設計原則が重要になる。これらの原則は、単なる理想ではなく、実装可能で検証可能な技術的要件として定義される必要がある。

1. プライバシー・バイ・デザイン

サービス設計の初期段階からプライバシー保護を組み込む。後からの対応では不十分である。具体的には、データフローの各段階で「このデータは暗号化されているか」「誰が復号できるか」「どのような保護措置があるか」を明確に定義する。アーキテクチャ設計レビュー、セキュリティ監査、プライバシー影響評価(PIA)を開発プロセスに組み込む。

Meta Ray-Ban Displayのようなデバイスでは、カメラが常時起動しており、周囲のすべてを記録できる。このようなデバイスでは、「何を記録するか」「どのように保存するか」「誰がアクセスできるか」を明確に定義し、技術的に制限する必要がある。例えば、他者の顔を自動的にぼかす、音声は一時的にのみ保持し永続的には保存しない、などの設計決定が重要になる。

2. データ最小化

サービス提供に必要最小限のデータのみを収集・処理する。「将来役立つかもしれない」という理由でデータを収集することは避けるべきである。AIグラスの場合、24時間365日の記録は技術的に可能だが、実際に必要なのは特定のトリガー(音声コマンド、ジェスチャー)に応答した瞬間のデータのみである。

また、収集したデータの保持期間も最小化する必要がある。Limitlessの新ポリシーでは「無期限」の保持が可能になったが、これは明らかにデータ最小化の原則に反する。適切な保持期間(例:30日、90日)を設定し、それを超えたデータは自動的に削除されるべきである。

3. 利用者主権

ユーザーが自分のデータを完全にコントロールできる仕組み(暗号化鍵の管理、データの削除、エクスポート)を提供する。これは、GDPRのデータポータビリティの権利とも整合する。ユーザーは、いつでも自分のすべてのデータをエクスポートし、別のサービスに移行できるべきである。

さらに、ユーザーは「誰が自分のデータにアクセスしたか」を確認できるべきである。アクセスログ、処理履歴、共有先などを透明に開示することで、ユーザーは自分のデータがどのように使われているかを監視できる。

4. 透明性と検証可能性

暗号化の実装をオープンソース化し、独立した第三者による監査を受ける。「私たちは暗号化しています」という主張だけでは不十分である。実装がオープンであることで、セキュリティ研究者、規制当局、一般ユーザーがコードを検証し、バックドアや脆弱性がないことを確認できる。

Signalのプロトコルが信頼されているのは、完全にオープンソースであり、世界中のセキュリティ専門家によって検証されているからである。AIサービスも同様のアプローチを採用すべきである。

5. 規制への対応と超越

GDPR、CCPA、日本の個人情報保護法など、各国の規制に準拠する。ただし、規制の最低基準を満たすだけでなく、技術的にそれ以上の保護を提供する。規制は常に技術の進化より遅れるため、「規制に準拠しているから安全」とは限らない。

前述のDigital Omnibus提案が示すように、規制は政治的・経済的圧力により弱体化する可能性がある。技術的保証は、このような規制の変化に対して堅牢である。準同型暗号で保護されたデータは、規制が変わっても、企業のポリシーが変わっても、依然として保護される。

技術的実現可能性と課題

2025年現在、これらの技術は理論的な段階を脱し、実用化に向けて急速に進展している。FHEハードウェアアクセラレーターにより、実用的な性能が達成されつつあり、Zamaなどの企業は第一世代で1,000倍、第二世代で10,000倍の高速化を目指している。連合学習は、Google、Apple、医療機関などで実運用されており、プライバシーを保護しながらモデルを改善できることが実証されている。エンドツーエンド暗号化は、メッセージングアプリで標準となっており、数十億人のユーザーが日常的に使用している。

課題は技術的実現可能性ではなく、むしろビジネスモデルとの整合性である。多くのAI企業は、ユーザーデータへのアクセスを前提としたビジネスモデル(広告、データ販売、AIトレーニング)に依存している。プライバシー保護技術の採用は、このビジネスモデルの根本的な見直しを要求する。

しかし、この見直しは必ずしも悪いことではない。プライバシー保護を競争力の源泉として捉えることで、新しいビジネスモデルが生まれる可能性がある。Appleは「プライバシーは人権」というメッセージングにより、ブランド価値を高めている。Signalは、完全な暗号化を提供することで、プライバシー重視のユーザーから支持を得ている。

今後の展望:「データを見ないサービス」の時代へ

AIウェアラブルデバイスの普及により、プライバシーリスクは質的・量的に拡大する。音声だけでなく映像、位置情報、生体情報など、極めて機密性の高いデータが24時間365日収集される可能性がある。Limitlessの事例は、企業の「約束」に依存することの脆弱性を明確に示した。買収、経営陣の交代、財務的圧力など、様々な要因によりプライバシーポリシーは簡単に変更される。

真の解決策は、技術的な保証機能を持つ暗号技術の採用である。準同型暗号、連合学習、クライアントサイド処理などの技術は、もはや研究段階ではなく、実装可能な段階に達している。これらの技術を組み合わせることで、「データを見ないサービス」が実現可能になる。

今後、プライバシー保護がビジネス競争力の源泉となり、「データを見ないサービス」が新たな標準となる可能性がある。規制当局は、技術的保証を法的要件として組み込むべきである。技術者は、プライバシー保護技術の実装とオープンソース化を推進すべきである。そしてユーザー自身が、プライバシー保護を重視し、技術的保証のないサービスを拒否することで、市場にシグナルを送る必要がある。

Limitlessの事例は、警鐘である。しかし同時に、より良い未来への道筋も示している。技術は問題の原因でもあり、解決策でもある。私たちが選択すべきは、データへの無制限なアクセスを前提とした「信頼ベース」のモデルではなく、技術的保証に基づく「ゼロ知識」のモデルである。AIの恩恵を享受しながら、プライバシーを保護する――これは技術的に可能であり、倫理的に必要であり、そして経済的にも実現可能である。

参考文献

-

TechCrunch (2025). "Meta acquires AI device startup Limitless". https://techcrunch.com/2025/12/05/meta-acquires-ai-device-startup-limitless/

-

Reddit (2025). "New Privacy Policy as of December 5th, 2025 - IMPORTANT CHANGES". r/limitlessaipendant

-

Meta (2025). "Meta Ray-Ban Display: AI Glasses With an EMG Wristband". https://about.fb.com/news/2025/09/meta-ray-ban-display-ai-glasses-emg-wristband/

-

Fast Company (2021). "WhatsApp and Facebook's ultimatum to users reveals a privacy disaster". https://www.fastcompany.com/90593066/whatsapp-facebook-privacy-ultimatum

-

Zama (2024). "Homomorphic Encryption and LLM: Is ChatGPT end to end encrypted?". https://www.zama.org/post/chatgpt-privacy-with-homomorphic-encryption

-

arXiv (2025). "An End-to-End Homomorphically Encrypted Neural Network". https://arxiv.org/html/2502.16176

-

Nature Machine Intelligence (2025). "Empowering artificial intelligence with homomorphic encryption for secure deep reinforcement learning". https://www.nature.com/articles/s42256-025-01135-2

-

JMIR AI (2025). "Advancing Privacy-Preserving Health Care Analytics and Implementation of the Personal Health Train: Federated Deep Learning Study". https://ai.jmir.org/2025/1/e60847/

-

Scientific Reports (2025). "Privacy-preserving federated learning for collaborative medical data mining in multi-institutional settings". https://www.nature.com/articles/s41598-025-97565-4

-

TechPolicy.Press (2025). "EU Set the Global Standard on Privacy and AI. Now It's Pulling Back". https://www.techpolicy.press/eu-set-the-global-standard-on-privacy-and-ai-now-its-pulling-back/

-

White & Case (2025). "EU Digital Omnibus: What changes lie ahead for the Data Act, GDPR and AI Act". https://www.whitecase.com/insight-alert/eu-digital-omnibus-what-changes-lie-ahead-data-act-gdpr-and-ai-act

-

Inside Privacy (2025). "European Commission Proposes Revisions to GDPR and Other Digital Rules Under Digital Omnibus Package". https://www.insideprivacy.com/eu-data-protection/european-commission-proposes-revisions-to-gdpr-and-other-digital-rules-under-digital-omnibus-package/

最後に、GMOコネクトでは研究開発や国際標準化に関する支援や技術検証をはじめ、幅広い支援を行っておりますので、何かありましたらお気軽にお問合せください。