はじめに

Word Representations via Gaussian Embeddingという論文を読んだのでまとめていきます。

1. 対象とするトピック

1.1 キーワード

Gaussian Embedding 論文

1.2 経緯

近年、入力を低次元の空間に埋め込むことで空間における類似度を測る研究が増加しています。

例: collaborative filtering, word semantics and language modeling

これらの研究では入力を一点で表現し空間内に埋め込んでいます。しかしこの方法では、入力同士の包含関係や意味の広がりを表現できません。一方で、点ではなく確率分布によって表すことで、下図のような関係性を捉えることができます。

この論文では単語を空間上にガウス分布として埋め込むことで上図のような関係を捉えることが目的となっています。

2. 理論

2.1 モデル

モデルについて説明します。まず、各単語を空間上でガウス分布として埋め込みます。

$$

w_i = N(x;\mu_i,\sum_i)

$$

平均が単語分散表現での意味ベクトルに相当し、分散共分散行列が空間上での意味の広がりを表します。似たような意味をもつ単語同士でこれらのパラメータが近づくようにします。そのために、類似度を表すエネルギー関数E(x,y)を導入します。エネルギー関数では、類似度の高い入力から得る値が類似度の低い入力から得る値よりも大きくなります。そして、この関数を用いて以下のように損失関数を定義します。

この損失関数はRank-SVM等で用いられているmax-margin ranking lossと言います。以降ではこの損失関数を計算するために必要なエネルギー関数等について考察します。

2.2 WARMUP: EMPIRICAL COVARIANCES

2.3 ENERGY-BASED LEARNING OF GAUSSIANS

エネルギー関数を用いてガウス分布へ埋め込む関数を学習します。

2.3.1 SYMMETRIC SIMILARITY: EXPECTED LIKELIHOOD OR PROBABILITY PRODUCT KERNEL

ガウス分布間での類似度の測り方を考察していきます。先に対象な類似度について考えます。この時、まず思いつくのは平均同士での内積計算です。これは一応計算可能である程度分布同士の類似度を表現できます。しかし、分散の情報を無視しているため実質的には点で埋め込む場合の類似度計算と等価になってしまいます。これではわざわざ分布の空間に埋め込んだ意味がなくなってしまいます。そこで別の方法を考えます。

次の方法は分布同士での内積計算です。一般には二つの連続関数

に対し以下のように定義されます。

二つの独立したガウス分布の場合は、内積が以下の式で計算されます。

実際の学習では

-

ranking lossにとって都合の良いように「差」ではなく「比」を計算する必要があること - 計算結果のオーダーを下げて扱いやすくすること

を目的に上記の対数を利用していました。d次元の場合は対数が以下の式で表されます。

2.3.2 ASYMMETRIC SIMILARITY: KL DIVERGENCE

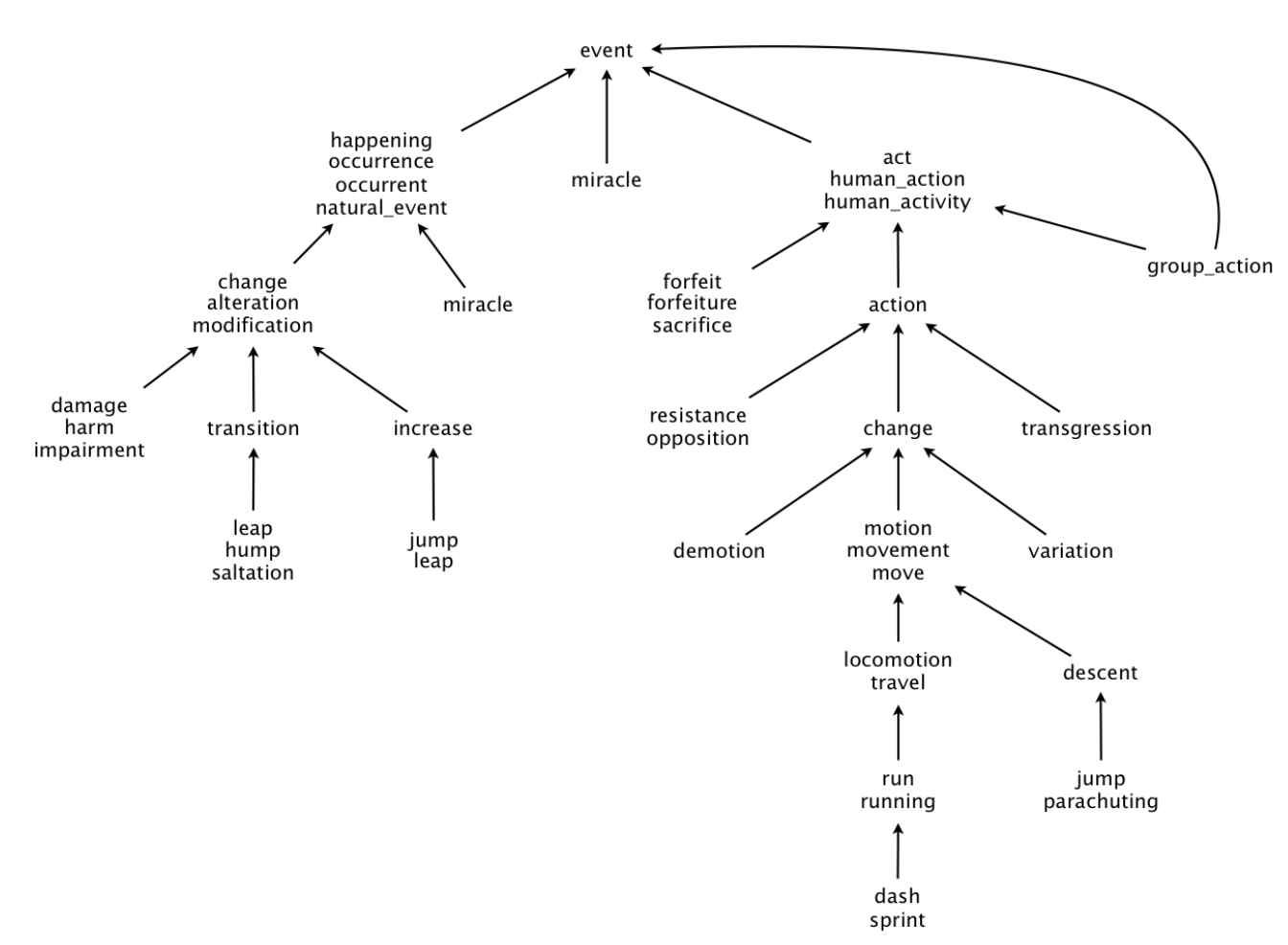

前節で、分布同士の対象な類似度を計算する手法について考察しました。本節では、非対称な類似度を計算する手法について考察します。非対称な類似度とは、特定の構造が保持されるような類似度です。特定の構造の例としては、下図のWordNetに示されるような含意関係が挙げられます。

論文ではKL-divergenceを用いて階層構造を保持しています。エネルギー関数は以下のように定義されています。

2.3.3 UNCERTAINTY OF INNER PRODUCTS

入力をガウス分布で埋め込んでいるため、内積計算をガウス分布から得た二つのベクトル間の内積計算として扱うことができます。そして、二つのベクトル間での内積から得たベクトルもまたガウス分布から得たものとして扱えます。つまり、内積計算から得たベクトルに対し平均と分散を定めることが可能です。例えば、

P\ (z = x^\top y)

という分布に対し、以下のように平均と分散を計算することができます。

3. 実験

以下の観点から実験と定性的・定量的評価を行っていました。

SPECIFICITY AND UNCERTAINTY OF EMBEDDINGSENTAILMENTDIRECTLY LEARNING ASYMMETRIC RELATIONSHIPSWORD SIMILARITY BENCHMARKS

以下にいくつか結果を紹介します。

3.1 SPECIFICITY AND UNCERTAINTY OF EMBEDDINGS

各単語が埋め込まれたガウス分布の分散共分散行列を用いてquery word近傍に位置する単語のspecificityとuncertaintyを求めています。具体的には、近傍の単語を分散共分散行列の行列式の値が大きい順にソートしています。結果は下図の通りです。

似ている単語同士で比較した際に、抽象的な単語ほど分散共分散行列の行列式の値が大きいことがわかります。

3.2 DIRECTLY LEARNING ASYMMETRIC RELATIONSHIPS

KL-divergenceを用いて学習した階層構造を確認しています。特に統計量や明確な評価基準は記載されていません。点での埋め込みでは原理的に階層構造を表現できないのでベースラインとの比較が不可能だったのかもしれません。実際に学習したガウス分布が捉えている階層構造が下図に示されています。

終わりに

点ではなく分布で行うことで効果が現れる定量的評価方法があまり見つからず苦戦している印象を受けました。WordNetを用いた比較ができるorder-embeddingのような新規手法は稀有な例かもしれません。

参考文献

- Luke Vilnis, Andrew McCallum (2015). Word Representations via Gaussian Embedding, https://arxiv.org/pdf/1412.6623.pdf

- stfate (2018). ガウス埋め込みによる「意味の広がり」を捉える単語埋め込み, https://qiita.com/stfate/items/d44a8e5c7109e37ab0cd