この記事は、ロドニー・ブルックス氏のブログ記事 "[FoR&AI] Steps Toward Super Intelligence IV, Things to Work on Now" の翻訳です。訳者によるまとめはこちら。

我々は、汎用人工知能エージェントの構築について、あるいは超知能エージェントについても語ってきた。いかにしてそこへ至るのだろうか? どのようにECWやSLPを作ればよいのか? 現在研究者が取り組むべきことは何だろう?

少し後で、子供の能力とコンピタンスに基いて、4つの短期的な目標を導入したいと思う。これが私の4部構成のエッセイの4番目の大きなリストとなるだろう。あまり混乱を招かぬように、単に数字とリストだけを要約してみよう。これが、私が4部のエッセイで説明し提案してきたことである。

|||

|---|---|---|

|パート1| 4つのAIに対する過去のアプローチ|

|パート2| 2つのチューリングテスト代替案|

|パート3| 7つの (代表的な) 現在のAIには困難なこと|

|パート4| 4つの即座の進歩を起こす方法|

しかし、AI研究者は今実際に何を研究するべきだろうか?

我々は、知的な存在のアーキテクチャについて研究するべきだと思う。その知的存在が住んでいるのが現実世界であれサイバー空間であれ。また、構造化されたモジュール、つまり複合的な能力の基礎を成し、現実世界における知覚と行動のすべてをグラウンディングし、有用な空間表現と操作手段を持ち、短いタイムスケールで世界に対してリアクションする能力を与え、あらゆる領域にわたって曖昧さを十分に扱えるようなモジュールについても研究するべきだと思う。

まずは最初に、知的な存在のためのアーキテクチャについて話そう。

現在のすべてのAIシステムも、何らかの構造に基いて動作している。しかし、その構造は継続的な存在 [ongoing existence] を備えていない。それらのAIプログラムの動作は一時的 [transactional] なプログラムであり、人間が何かをさせたいと望んだときに動作させるものである。

2016年3月に、囲碁の世界チャンピョンであるイ・セドルを破ったプログラム、AlphaGoについて考えてみよう。そのプログラムは、自分がゲームをプレイしていることも、人間が存在することも、あるいは囲碁盤の二次元領域が現実世界に存在することもまったく知らないのだ。- 現実の世界が存在していることも知らないだろう。そのため、AlphaGoは、現実世界における自身の存在に気を払う生きた息をする人間であるイ・セドルとは著しく異なっている。

私は、イ・セドルは1杯のコーヒーのみに支えられている、という当時の誰かのコメントを覚えている。一方で、AlphaGoは200人の人間のエンジニアによって支えられていたのだ。エンジニアのチームが、AlphaGoが動作するクラウド上のプロセッサを取得し、ソフトウェアのバージョンを管理し、AlphaGoに指し手を入力し (イ・セドルは、単に自分自身の2つの眼で盤面を見るだけでよい) AlphaGoが望んだ手を盤面上で指し、必要な際にはすべてをリブートし、またAlphaGoがゲームをプレイできるようその他すべての手筈を整えるのだ。

これは超知能ではなく、超ポンコツ [basket case] である。

そこで、一番初めに必要となるのは、プログラムが身体を備えているか否かにかかわらず、自身の要求に対処でき、自身の住む世界 (クラウド内であれ物理的世界であれ) について理解し、自身の継続的な存在を確かなものにすることである。ルンバは、これらのことに多少対処できる。充電が減った場合には充電器を探し、ゴミのタンクを空にする必要がある場合には人間に通知し、移動不可能な場合には助けを求める。これは、ECWに我々が求めるレベルの自己充足性ではまったくない。しかし、私が意図していることを示せるだろう。

次に、構造化されたモジュールについて考えよう。これが2つ目の私の論点となる。

パート3で私が挙げた7つの事例、現在の人工知能には困難なことは、すべて良いスタート地点である。しかし、そこでは単に説明のために7つを選択しただけだ。このテーマについて考察してきた人はたくさんいて、それぞれの人が独自のリストを作成できるだろう。

このように主張する人もいるかもしれない。近年のディープラーニングの巨大なブレイクスルー、たとえば音声処理において、話し言葉それ自体のみならず、音素処理の特徴量検出も学習可能であるという事例に基づけば、あらゆることがデータから学習可能であるのだ、と。私が色一貫性を取り上げたポイントは、単にオンラインの画像を大量に閲覧することだけから、知的な機能が自然に発生するわけではないことを示すためである。色一貫性は、現実世界で自然淘汰のビルディングメカニズムから生じたものであり、物体の本質的な色は、たとえその物体に当たる光の色が変わったとしても、実際には不変であるという事実を補償するものである。この能力は、進化を通して生じた生命体が、自身にとって重要な問題を扱うための生得的な特徴である。このような重要なモジュールを事前に作成しておけば、速いスピードで超知能へと至れる可能性が高くなるのではないだろうか。

そして、ハードコアな機械学習の崇拝者には、ここで1つ質問してみたい。会社の給与部門、住宅ローン企業、あるいは内国歳入庁 (合衆国の徴税機関)は、エクセルのスプレッドシートを使って財務上の問題を計算するべきだろうか、あるいは、彼ら自身の人生におけるお金の問題について、何百万件ものスプレッドシートの事例で訓練された、すべてがネットワーク上の重みにエンコードされたディープラーニングネットワークの出力を信頼するべきだろうか? 読者も彼らが何と答えるか予想できるだろう。このような本当に重要な問題については、ディープラーニング信者でさえ、事例から学ぶことは必ずしも最良のアプローチではないと認めるのである。

パート3の常識に関する話題で、アーネスト・デイヴィスと共に引用したゲイリー・マーカス[^1]は、最も重要な構築するべきモジュールについて語っている。

- 物体の表現

- 構造化された台数表現

- 変数に対する演算

- タイプ-トークンの区別

- 集合、場所、経路、軌道、障害物と永続的な個人を表現する能力

- 物体のアフォーダンスを表現する方法

- 時空間連続性

- 因果関係

- 翻訳不変性

- コスト-パフォーマンス分析の能力

他の人々も異なるリストを作成できるだろう。しかし、継続的な存在と目的とを備えた何らかのエンティティの構造内部において組み合わせ可能な生得的モジュール、世界の中で知覚し行動するシステム内で組み合わせ可能なモジュール、おもちゃのオンラインデモンストレーションではなく何らかのことを本当に行うシステムの内部で組み合わせ可能なモジュール、などのモジュールに対して人々が取り組んでいく限り、本当の進歩をもたらせるだろう。

そして、注意を。我々は意識に関する問題を完全に回避してきた。ECWやSLPのどちらも、何らかの形で意識を持つ必要があるか否かは、私が思うに未解決の問題である。そして、我々が意識を解明できない限りその問題は未解決に留まるであろう。

どのようにして我々がそこへ辿りついたと分かるのか

アラン・チューリングは、1950年の論文「計算する機械と知能 [Computing Machinery and Intelligence]」で模倣ゲームを提唱した。彼の目的は、論文冒頭の文章で述べられている通り、「機械は考えられるのか?」という疑問を検討することだった。このゲームは、機械が「思考」する能力を持てるのか否かという疑問を議論するための修辞的設定として使われている。また、彼は機械がこのゲームをプレイできるようになる時期を予想しているけれども (2000年までには70%の確率で人間のフリをした機械が人間を騙せるようになると予想していた)、チューリングはこのゲームを機械知能に対するベンチマークにするつもりは無かったように私には思える。

しかし、何年か経って、本当の人工知能研究者ではなくメディアがチューリングの模倣ゲームを取り上げ、これがチューリングテストとして知られるようになってしまったのだ。ある者たちにとっては、機械がこのおしゃべりのゲームで人間を負かすことができるかどうかが、人工知能の発展に対する確かなテストとなったのだ。これは決して優れたテストではなく、それゆえにこのゲームに対する巨大な「トーナメント大会」も真剣な研究者からはほとんど無視されている。そして、次第に、まったく知的ではないバカなチャットボットが勝者として表彰されるまでになってしまった。

一方で、本当の研究者たちも、DARPAグランドチャレンジのようなコンペティション、アーバングランドチャレンジ(現在の自動運転車の研究に直接繋がった)、ロボットチャレンジのようなコンペを競っている。

確かに、物理的・非物理的な人工知能システムが、ECWやSLP向けのタスクをどれほど上手に遂行できるかを競うコンペやテストを想像することはできる。けれども、私が恐れていることは、チューリングテストと同様に、これらのテストが劣化させられゲーム化させられることである。最も優れたバージョンのECWやSLPが市場に選択されるであろうと私は確信している。- チューリングテスト大会をゲーム化して勝利する純粋なチャットボットとは違い、それらのシステムは真の経済的価値を持っているだろうから。だから、ECWやSLPに対するテストやコンペは存在しないのだ。

私は、研究領域に対するコンペはそれほど好みではない。それらのコンペは集団浅慮をもたらし、ルールのゲーム化に多くの労力が費されてしまうと常に感じていたからだ。そして、私が思うに、明示的な特定の目的はコンペの開催へと繋がってしまう。チューリングテストの場合のように、誰もそれを意図していない場合であってもそうなのだ。

代わりに、ここで私は4つの特定の目標を設定したいと思う。それぞれは、ある年齢に達した子供の能力のコンピタンスの観点から定められている。

- 2歳児の物体認識の能力

- 4歳児の言語理解の能力

- 6歳児の物体操作の能力

- 8歳児の社会性理解

ほとんどの人はポルノや芸術とは何であるのか、形式的定義なしでも理解できるだろう。私が掲げた目標も同じだ。つまり、一般的な知識のある人々であれば、ある程度の期間インタラクションを行えば、AIシステムのパフォーマンスを計測できるだろう。対象者たちは、適切な年齢の子供たちともある程度の期間のインタラクションした経験があると仮定する。

これらの目的は、子供やAIシステムが受験する「パフォーマンステスト」によって定義されるものではない。これらは、曖昧なコンピタンスの水準を示すものである。パフォーマンスとコンピタンスの混同は、人工知能の実現まで我々がどれほど離れているかを理解することについて、人々がよく犯す誤りのうちの1つである。

もしも、超知能、または単なる日常的なレベルの汎用性に向けて人工知能を本当に進歩させたいのであれば、ご大層なパフォーマンスによって人目を引く疑似餌ではなく、汎用的なコンピタンスの領域に注力することが必須であると思う。

測定指標としてのパフォーマンスに反対する、と言っておこう。そして、もっとあいまいなコンピタンスの観念を、我々が本当の進歩を遂げているのかを測定する指標とすべきである。

では、それぞれのケースについて、どんな種類のコンピタンスを考えるべきだろうか?

2歳児の物体認識の能力

2歳児は既に色の一貫性を理解している。そして、少なくとも2、3個程度の色を表す言葉を使ってそれを説明できる。しかし、それ以上に、2歳児は物体クラスを扱うこともでき、視覚的に見た物体とその機能/役割とをマッピングできるのだ。

2歳児は、何らかのものを意図的に椅子として利用できると理解している。たとえ、それが以前に見た椅子とはまったく似ていないものであったとしても。脚の数が異なるかもしれないし、異なる素材で作られているかもしれない。その椅子の脚は非常に奇妙な形をしているかもしれないし、人形のためのオモチャの椅子であるかもしれない。2歳の子供は、これらすべてに惑わされることはない。以前に目にした椅子といかなる共通点を持っていなかったとしても、子供は椅子を椅子であると宣言できる。これは、ニューラルネットワークが視覚的に物体を分類する方法とは完全に異なっている。

しかし、更には、椅子として使われるようにデザインされていない物体を見たとしても、その物体自体や場所から判断して、椅子として利用可能だと考えることもできる。岩を見てその上に座れると判断できるし、機能的に背もたれとして使える何かが存在するような、より良い他の場所を探すこともできる。

つまり2歳児は、洗練された形で物体クラスを理解しているのだ。(...)

しかし、ちょっと待ってほしい。まだある。2歳児は、複数の異なる情報源からのワンショット視覚学習が可能である。いかなる形であれこれまで1度もキリンを見たことがない2歳の子供を想像してほしい。そこで、手書きのキリンの絵、キリンの写真、オモチャの剥製のキリン、キリンの動画などをたった数秒でも直接目にしたとすれば、2歳児の心には永久にキリンの概念が刻み込まれるだろう。その子は、その先ずっと、どのように表現されていても、キリンをキリンとして認識できるだろう。多くの人は生きたキリンを見たことがないかもしれないし、生きている恐竜を目にした人は誰もいない。それでも、誰もがキリンや恐竜を簡単に認識できる。

やってみたまえ、ディープラーニングよ。1つの事例を、1つの形で!

4歳児の言語理解能力

ほとんどの4歳児は読み書きはできないだろうが、しかし話したり聞いたりはできる。4歳児は、双方向に順番で会話することをとてもよく理解しており、他人の話を遮ったり、あるいは自分の話が誰かに遮られたことも理解できる。4歳児は、韻律 [prosody] を理解して自分でも使うことができ、同時に顔、頭や全身の動きを理解し使うこともできる。同様に、話し相手からもこれらの合図を読み取り、自分の視線と相手の視線検出を上手く用いて多人数の会話をこなし、脇で別の会話が始まったとしてもおそらく理解できる。

4歳児は、誰かとの会話が始まったと理解し、また(普通は)会話が終了したときや、話し相手が変わったときにも理解できる。会話に3人か4人の人が参加していたとしても、誰か特定の人に話しかけるために名前を呼ぶ必要もないし、誰かから話しかけられたと理解するために名前を呼ばれる必要もない。- 4歳児は、コミュニケーション中のあらゆる非言語的な手掛かりを用いて、話し相手を適切に推論できる。

これらすべては、Amazon EchoやGoogle Homeのような今日の音声認識エージェントとは非常に異なっている。また、4歳児は何分間もの会話から生じたコンテキストを保持できるという点においても異なっている。彼らは不完全な文も理解できる。コンテキストをもとに理解可能な、たった1, 2語の短いが意味のある間投詞を発することもでき、全員の相互理解を進めることもできる。

4歳児は、過去5年間の間にディープラーニングによって顕著な進歩が見られた音声認識のように、ノイズの多い環境で言葉を聞き、バックグラウンドノイズを補償し、自分に向けられた言葉に集中することも、あるいは自分に向けられものではない言葉に聞き耳を立てることもできる。過去一度も耳にしたことのない強い訛りを理解して、会話から正確な意味を引き出すこともできる。

他人の発話パターンから性別と年齢を推測でき、誰かが普段と違う喋り方をしていることに気付き、それに慣れることもできる。叫び声、ささやき声や歌声を理解でき、4歳児自身も適切な形で歌ったり、ささやいたり叫ぶこともできる。

そして、複雑な文章であっても扱うこともできる。時制の細かな区別を理解し、仮説について話したり理解することもできる。意味のないお喋りをして理解することもでき、それを通して理解のパターンを織り込む。4歳児は自分が嘘を付いていることも理解でき、その事実を声のパターンから隠そうと試みることもできる。

4歳児の言語能力は、シンボリックであれニューラルであれ、いかなるAIシステムをも超えている。

6歳児の物体操作能力

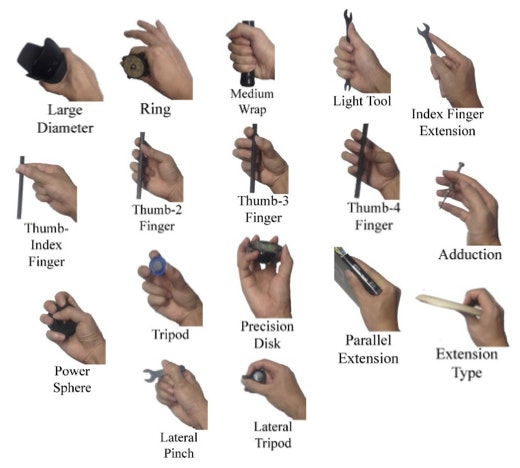

6歳の子供は、超天才児でもない限り、ピアノでショパンの曲を演奏できないだろう。それでも、小さな手を使って、今日のロボットではまったく不可能な目覚しい物体操作の妙義が可能なのだ。まったく初めての物体を見たときでさえ、それが片手で、両手でつかめるのか、両腕と全身 (胸とおなかを追加の支持点として使う)で抱えられるか、あるいはまったく持ち上げられないのか、かなり高い信頼性で推定できる。片手で物をつまむ場合にも、どのような掴み方を使うか事前に定めて、物に手を近づけながら手の形を変えることができる。

6歳児は、以下すべての掴み方ができるだろうと私は確信している。

[私はこの画像の出所を知らない - このドローイングのウェブサイトで画像を発見した]

6歳児は蛇口をひねることができ、靴紐を結び、読みやすい文字を書き、窓を開け、あまり重すぎない場合にはブラインドを上げ下げすることもできる。また、箸を使って固形でない食事でも食べられる。6歳児は本当に器用である。ちょっと教えてあげれば野菜を切ることも、テーブルを拭くことも、食料のケースを開け閉めすることもでき、積み上げられた物を押入から出し入れできる。

6歳児は、やわらかな服を扱い、たたむこともできる。ただし、スキルのある大人ほどには上手ではないかもしれないが (この点においては、私もスキルのある大人とは言えない…)。自分一人で脱ぎ着するために服を扱い、あるいはお人形の服も扱えるかもしれない。

更には、ネコ、あるいは大きめのサイズのイヌでさえも安全に抱きかかえることもできる。非常に幼い弟や妹を上手に確実に抱き上げられるようにもなれる。祖父母とスキンシップすることもできる。

6歳児は、大きな混乱を起こさずにオシリを拭くこともできる (たいていの場合は)

ECWは、これらすべての動作ができなければならない可能性が高いだろう。ただし質量は増加するだろうが (すなわち、完全に成長した大人を持ち上げたり着替えさせたりすることは、6歳児の身体能力を超えている)。

今日のロボットは、一般的な状況では、つまりロボットが新しい環境に置かれ、一度も眼にしたことのない何らかの新しい物体に対しては、このようなタスクのうちのいずれか一つでさえ遂行することはできないのだ。

8歳児の社会性理解能力

8歳になった子供は、自分自身の信念、願望、意図などを、世界の他の具体的なものと同様に表現できる。また8歳児は、他の人々も異なる信念、願望、意図を抱いていることを理解でき、適切な質問をされた場合にはそれらを表現することもできる。

更には、8歳児は自分自身が信じていることに対して、他人が信じているであろうことを推測し、2つの差異を表現することもできる。この能力に対するテストの具体例としては、「誤信念課題 [false-belief task]」が挙げられるだろう。この課題にはさまざまなバリエーションが存在するが、しかし本質的には以下の通りである。実験者が、被験者の子供に対して、ある人が2つの箱の中身を見ていることを観察させるのである。箱Aには、たとえばオモチャのゾウが入っていて、箱Bは空っぽであるとしよう。そして、その人は部屋を立ち去る。その後実験者は、子供が見ている前で、オモチャのゾウを箱Bへと移動させるのである。そして、子供に対してオモチャのゾウが入っているのはどちらの箱かを質問する。当然、子供は箱Bであると回答するだろう。しかし、重要なのは、部屋を出ていった人が戻ってきたときにオモチャのゾウを探す場所はどこでしょうか、という質問である。子供が十分に成長すると (ここでは多くの実験と結果のバリエーションがあるが)、子供たちは、部屋を出ていった人が探すのは箱Aであると答えられるようになるのだ。その人が、現時点では事実と異なった信念を持っていると分かっているからである。

このテーマについては膨大な文献があり、他人を理解することにも多くの側面がある。加えて、このような知識のテストは、極めて幼い子供たちばかりではなく、チンパンジー、犬、鳥その他の動物に対しても実施されており、彼らが何を理解しているのかが研究されている - 言語が使えない状況では、これらの実験設計は非常に難しい場合がある。

また、社会性理解には他にも多数の側面がある。その中には、他者の行動から願望や意図を推測すること、なぜ相手がそのような願望や意図を持っているのかを理解することなどがある。精神的な疾患のなかには、こういった推論能力を損なう症状も存在する。けれども、正常な社会環境では、我々は関わり合う相手にこれらの多くの領域の機能的能力が備わっていると仮定している。我々は、ある種のことがらについての説明は不要であると感じられる。なぜなら、相手が我々を観察して理解してくれるだろうから。そして、我々もまた自分自身の知識のフローを観察しており、世界の中で行動する人々を見たとき有用な提案ができるのだ。我々は、いつもこのようなことをしている。何かを指さして「あっち」と言う。それだけでも誰かの助けになる。完全に見知らぬ人にとってさえである。

社会性理解こそが、我々を一貫した全体たる人間にする潤滑油である。また、我々はペットに対するバージョンの社会性理解を保持しているが、しかし鉢植えには持たないだろう。8歳児は、日常生活において十分な社会性理解を備えている。

コンピタンスの向上が道を導く

これらの2、4、6、8歳児のコンピタンスは、ECWやSLPでも重要な役割を果たすだろう。これらのコンピタンスがなければ、知能システムは自然に見えないだろうし、我々と同等に賢くも見えないだろう。これらのコンピタンスが人間を模倣した方法で実現されるのか否か (鳥 vs. 飛行機) はともかくとして、これらのコンピタンスは、汎用人工知能システムの実現に、あるいは「超知能」と表現される何かを実現したいと考えるのであれば、必要不可欠である。

だから、進歩を起こそう。本当の進歩を。単なるハイプの疑似餌ではなく、これら4つのシステムレベルの目標に向かって。そうすれば、過去60年の間で本当に初めて、我々は人間レベルの知能とコンピタンスを備えた機械へと向かう歩みを進められるだろう。

実際のところ、これはほんの小さな歩みの一部分であり、超知能へと向かう道のりはさらに遠いのだ。

神々の創造は、本当に困難であると分かった。たとえ、我々自身のイメージの中に神々が存在したとしても。

[1^]: 原注1 “Innateness, AlphaZero, and Artificial Intelligence“, Gary Marcus, submitted to arXiv, January 2018.