概要

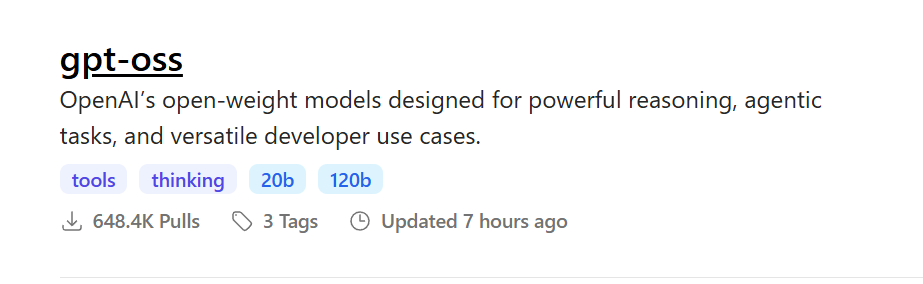

先日、こちらが発表されました。

さすがに上位のgpt-oss120bはVRAMが80GB必要とのことで、まず一般人には動かせる代物ではない...

でも下位のgpt-oss20bであれば、ゲーム用PCくらいで動かせそうな予感...!ちょっくら試してみて、無料でAI使い放題環境を手に入れてみましょう!

PCスペック

こんな感じです。VRAMが8GBなのでちょっと不安でしたが、最終的には動かせる環境まで持っていけました。

- CPU:Core i7-12700K

- GPU:RTX 3060Ti(VRAM 8GB)

- RAM:32GB

ollamaとgpt-ossの導入

ollamaのインストール

ollamaとは、かのOpenAIさんがリリースしている、LLMをローカル環境で実行するためのソフトウェアです。

インストールはこちらから。インストーラをダウンロードして実行するだけです。

gpt-ossの導入

ollamaで導入できるモデル一覧にはすでにgpt-ossがありますので、コマンドから導入していきます。

powershellなどで以下コマンドを実行するだけ。

ollama run gpt-oss:20b

ファイルサイズは13GBほどあるのでお気を付けください。

試してみる

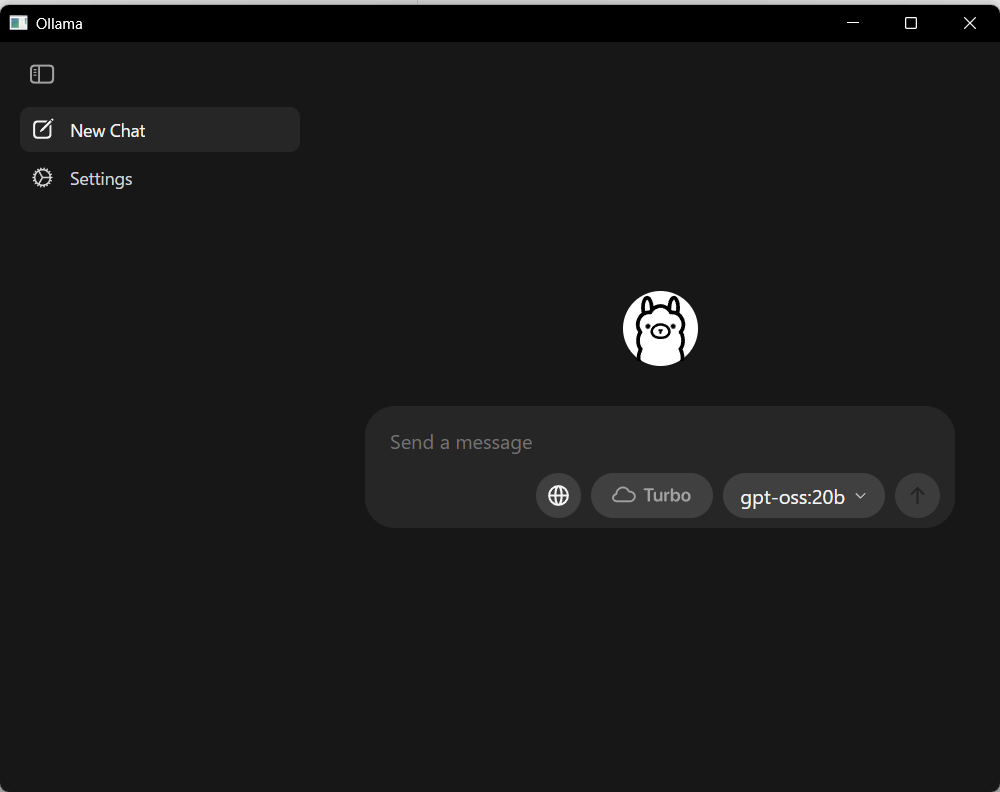

導入した状態でollamaを開くと、さっそく選択できるモデルにgpt-oss:20bの文字が...!

適当な質問でちゃんと動作するか試してみましょう。VRAM足りていないような気がしますが果たして...?

すごい、めちゃくちゃ応答してくれました。返答まで3分くらいかからいましたが、VRAM不足で起動しないなんてことはなく、しっかり応答できてそうです。

ollamaでは、VRAMが足りていない場合、一部をRAMにオフロードしてCPUで動作してくれるみたいです。速度は遅くなりますが、VRAM不足で起動できないみたいなことにはならないそう!

感想

流石に普段使っているCopilotほどとは言いませんが、それでもギリ実用的な速度でそれなりの応答を返してくれるLLMがローカルで構築できるのは感動ですね...!

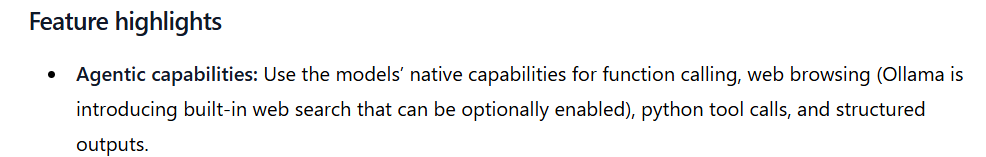

また、公式にはこんな記述もあるみたいなので、もしかしてMCPの呼び出しとかもできそう...?

まだまだ実験のし甲斐がありそうなので、色々試してみようと思います!