OSSのAI開発基盤KAMONOHASHIをAWS EC2に構築してみます。

オンプレ前提のインストーラのため、構築に少し手間がかかります。

手順概要

- EC2インスタンスを用意します

- インスタンス内でデプロイツールを実行します

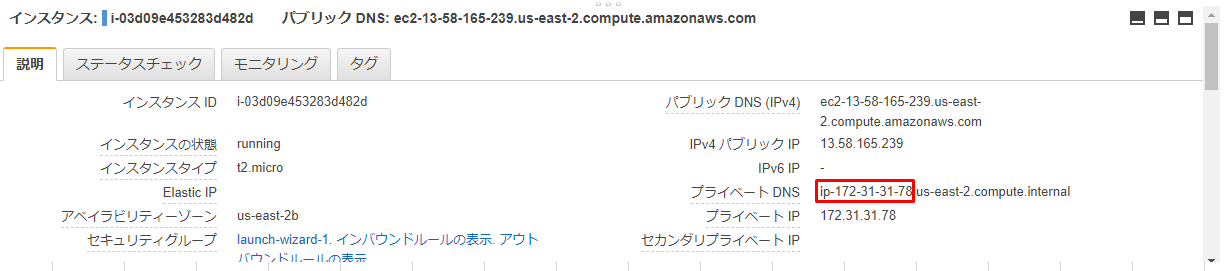

- マシン名にはプライベートDNSのものを使用します

- 設定修正

- 構築完了後にプライベートDNSの設定を書き換えて、外部からアクセス可能にします

お試しで構築する想定なので、セキュリティなどはいろいろ省略します。

KAMONOHASHIはバージョン1.0.0を使います

構築手順

EC2インスタンスを用意

-

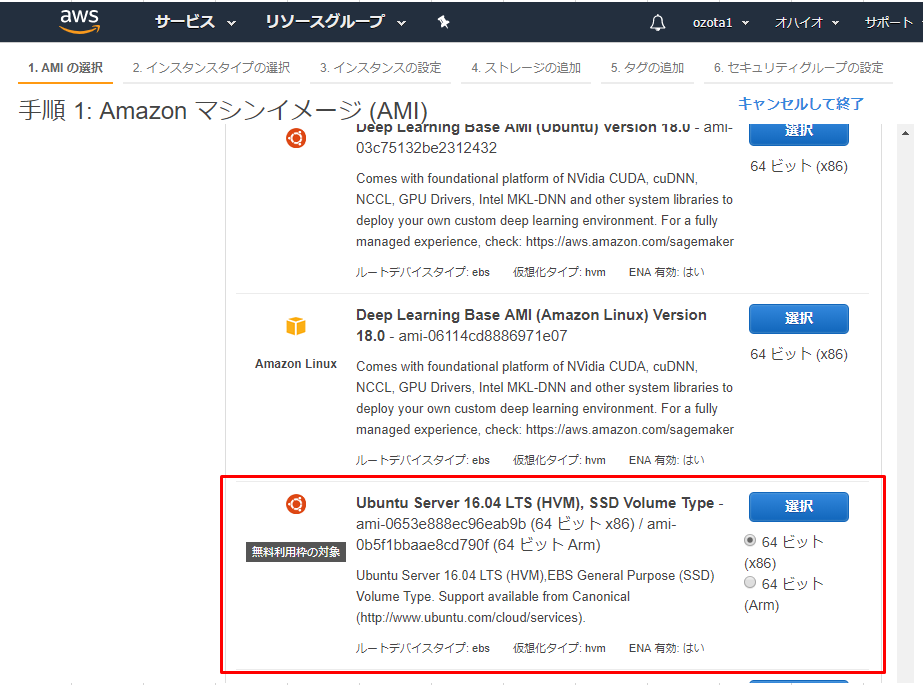

EC2インスタンスを作ります

-

インスタンスタイプはドキュメント の表に従って選択します

- KAMONOHASHIノードはc5.xlarge、k8s,storageはt3a.small、GPUはg3s.xlargeなどになります

-

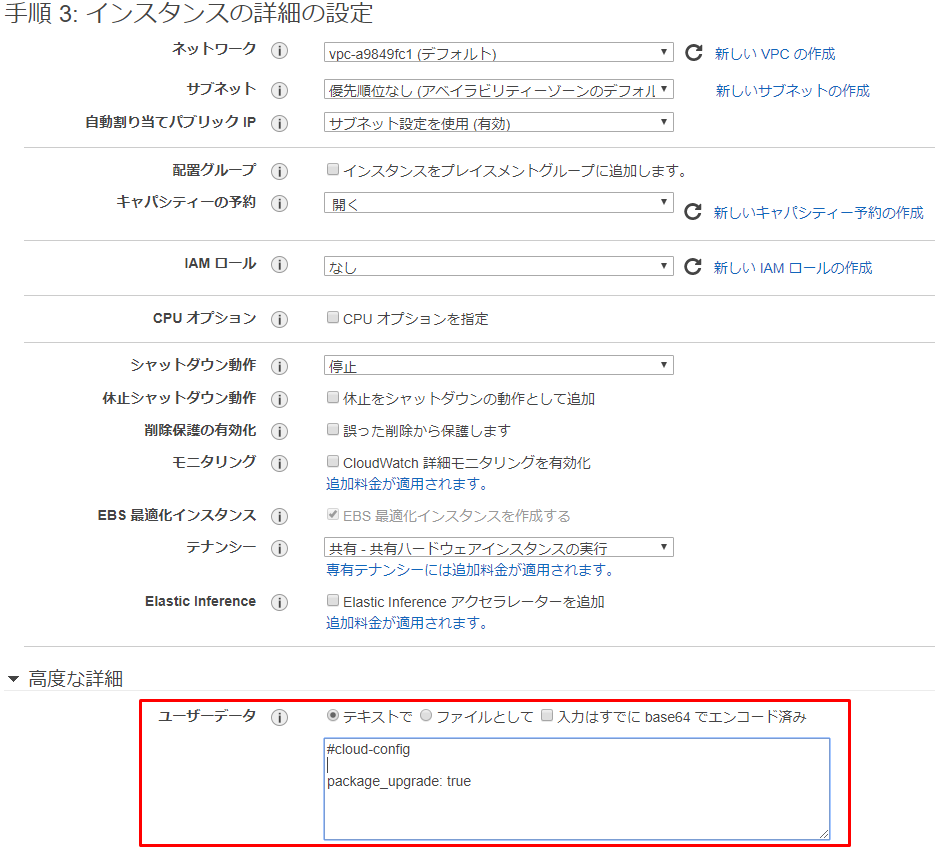

インスタンスの設定タブで、cloud init機能による初回起動時のapt updateを設定しておきます。

-

確認と作成からEC2インスタンスを作成します

- すべて同じキーペアを指定してください

-

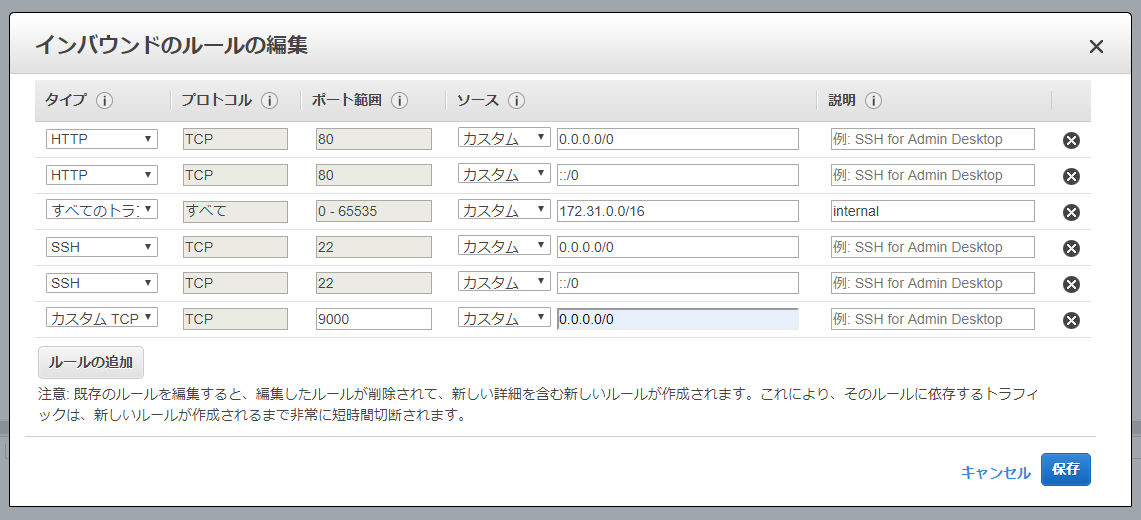

- 内部通信(デフォルトVPCでは172.31.0.0/16)はすべて許可します。このサブネットはVPCに応じて設定してください。

- 外部からssh, 80(webアクセス)、9000(ストレージアクセス)のTCPポートを開けておきます

- 簡単のため、すべてのEC2インスタンスで同じ設定とし、任意のGlobal IP を許可します

-

sshでGPU用インスタンスに入り、NVIDIA DRIVERをインストールします

インスタンス内でデプロイツールを実行

-

k8s用のEC2インスタンスにsshします

- sshに使用したpemファイルをrootユーザーの

~/.ssh/id_rsaファイルとして配置します

- sshに使用したpemファイルをrootユーザーの

-

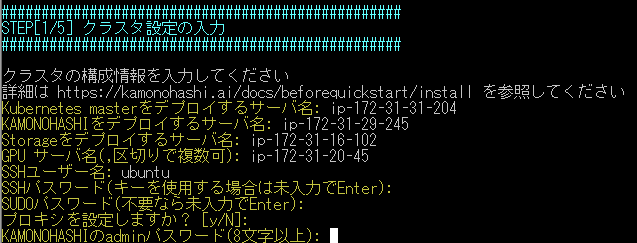

構築マニュアルの作業を行います

-

構築完了まで待ちます。20分ほどかかります

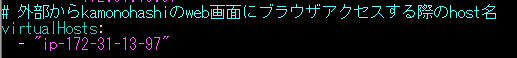

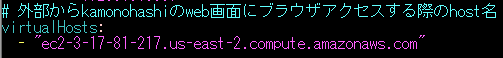

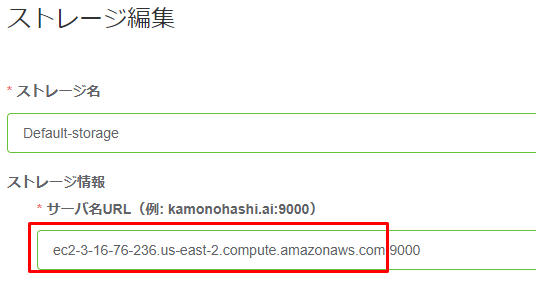

設定修正

-

/var/lib/kamonohashi/deploy-tools/1.0.0/kamonohashi/deploy-kqi.sh cleanを実行してKAMONOHASHIのコンテナを止めます -

vi /var/lib/kamonohashi/deploy-tools/1.0.0/kamonohashi/conf/settings.ymlを実行します -

/var/lib/kamonohashi/deploy-tools/1.0.0/kamonohashi/deploy-kqi.sh deployを実行してKAMONOHASHIのコンテナを起動します -

上記で設定した外部host名でログインします

以上です。あとはチュートリアルを実行して動作確認してみましょう