はじめに

Local Deep ResearchはいわゆるDeep Researchをローカルで実行するソフトです。LLMに Ollama、検索に SearXNG を用いることができるため、比較的プライバシーを重視したDeep Researchが実行できます。

セットアップ

以下の様な docker-compose.yml を作成して立ち上げます。

公式では、cookiecutter を用いて docker-compose.yml を作成していますが、直接作成しました。

services:

local-deep-research:

image: localdeepresearch/local-deep-research:latest

container_name: local-deep-research

network_mode: host # Best option for connecting to locally running Ollama

ports:

- "5000:5000"

environment:

- LDR_LLM__PROVIDER=ollama

- LDR_WEB__PORT=5000

- LDR_WEB__HOST=0.0.0.0

- SEARXNG_INSTANCE=http://localhost:8080

- SEARXNG_DELAY=2.0

volumes:

- ./ldr_data:/install/.venv/lib/python3.13/site-packages/data/

- ./local_collections/personal_notes:/local_collections/personal_notes/

- ./local_collections/project_docs:/local_collections/project_docs/

- ./local_collections/research_papers:/local_collections/research_papers/

restart: unless-stopped

depends_on:

- ollama

- searxng

ollama:

image: ollama/ollama:latest

container_name: ollama

ports:

- "11434:11434"

volumes:

- $HOME/.ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

restart: unless-stopped

searxng:

image: searxng/searxng:latest

container_name: searxng

ports:

- "8080:8080"

environment:

- SEARXNG_BASE_URL=http://localhost:8080/

volumes:

- ./searxng:/etc/searxng

restart: unless-stopped

実行

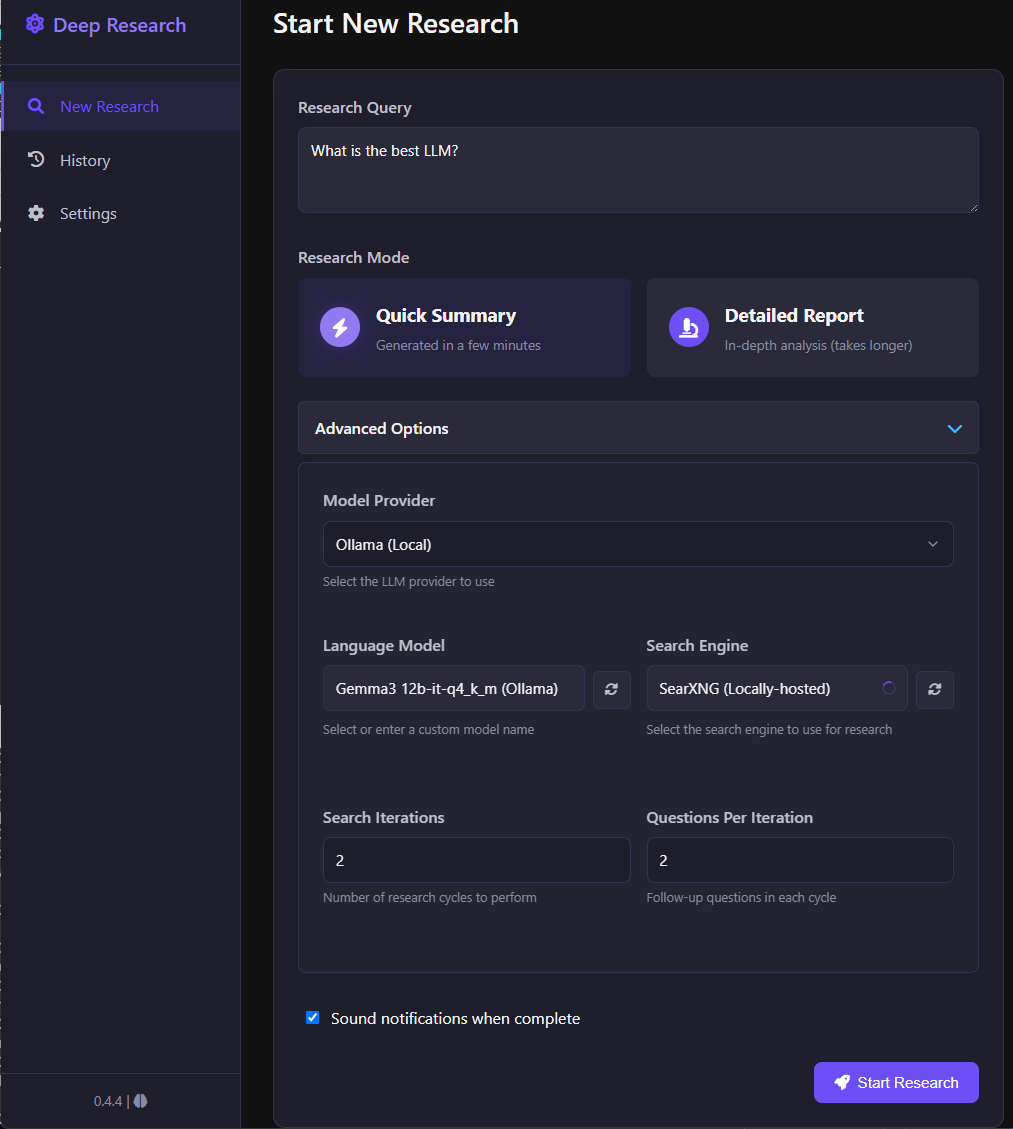

docker compose up -d で立ち上げたら、 http://localhost:5000 にアクセスします。

Research Query に質問を入力し、Language Model でモデルを選択して、Start Research で実行します。

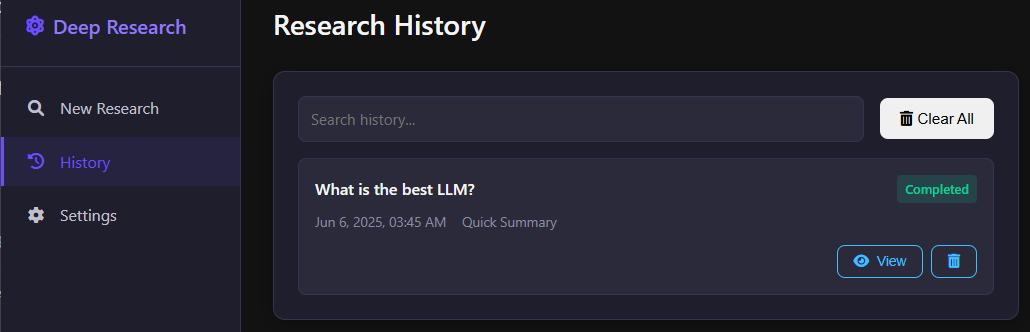

しばらくすると、レポートができあがります。レポートは PDF や Markdown で書きだすこともできます。

History から、過去に作成したレポートの確認ができます。

まとめ

ローカルで Deep Research 実行できる Local Deep Research を試しました。レポートの質は使用するLLMに左右されると思いますが、それなりのものが出力されました。ローカルで、Deep Research を実行できるものは他にもありますが、GUIがあり現在も更新が続いているものとして、有力だと思います。