はじめに

はじめまして。 NTTデータ ソリューション事業本部 デジタルサクセスソリューション事業部 の @nttd-nagano です。

Informatica(インフォマティカ) (※1)のクラウドデータマネージメントプラットフォームとして、「Intelligent Data Management Cloud」(※2。以下IDMCと記載)というものがあります。

今回は、そのIDMCのデータ統合サービス「Cloud Data Integration」(※3。以下CDIと記載)の機能「SQL ELT最適化」機能(※5、SQL ELT Optimization)にて、統合データ分析プラットフォーム Databricks (※6)にELT(※10)してみた ので、ご報告します。

以前Qiitaに投稿した記事(「 Informaticaのデータ統合サービスCloud Data IntegrationでSnowflakeにELTしてみた 」)のDatabricks版です。

※1. Informatica(インフォマティカ)

Informaticaは1993年に米国カリフォルニア州で設立され、2004年に日本法人を設立したデータマネジメント市場のパイオニア。Fortune100のうち86社を含む、100ヶ国以上の5000を超える企業がInformaticaのソリューションを採用しており、同社のクラウドは月間86兆件ものトランザクションを処理している。

※2. Intelligent Data Management Cloud

略称はIDMC。旧称はIICS。クラウドデータマネジメントプラットフォーム。以下IDMCと記載。

※3. Cloud Data Integration

略称はCDI。データ統合サービス。ETL処理(※4)やELT処理(※6)を担う。以下CDIと記載。

※4. ETL処理

データベースなどに蓄積されたデータから必要なものを抽出(Extract)し、目的に応じて変換(Transform)し、データを必要とするシステムに格納(Load)すること。

※5. 「SQL ELT最適化」機能(「プッシュダウン最適化」機能)

少し前まで「プッシュダウン最適化」機能(Pushdown Optimization。略称はPDO)と呼ばれていた。データ変換処理を各DBMS固有の命令を含む最適なSQLクエリに変換して、DBMS側で実行する機能。

※6. Databricks

Databricksは、エンタープライズグレードのデータ分析とAIソリューションを大規模に構築、デプロイ、共有、保守するための、統合されたオープンなデータ分析プラットフォーム。Databricksは、データウェアハウス(※7)とデータレイク(※8)を統合する、次世代のクラウド型統合データ分析基盤「レイクハウス・プラットフォーム」(※9)を提供している。これにより、全てのデータエキスパートが、あらゆるデータを簡単に統合、迅速に分析し、AIを活⽤したインサイトを獲得することが可能になる。

※7. データウェアハウス

Data Warehouse、DWHとも表記される。「Warehouse」とは倉庫を表す単語。複数のデータソースからのデータを、意志決定のため、主題別に編成し(業務主導のデータモデルではなく、データ主導のデータモデルに編成しなおす)、統合し、時系列で格納したデータベースのこと。削除や更新もしない。データは、一定の周期でデータソースからData Warehouseに移される。(1990年にアメリカの計算機科学者William H. Inmonが著作で定義したことにより有名になった概念。)

※8. データレイク

Data Lakeとも表記される。「Lake」とは湖を表す単語。複数のデータソースからのデータを元のままの形式でコピーし、格納する広大なデータ領域のこと。一般的に構造化データのほかに、半構造化データや、非構造化データも格納できる。(ビッグデータ時代が到来した2010年頃に提唱された概念。)

※9. データレイクハウス

Data Lake Houseとも表記される。「データレイクハウス」は、データウェアハウス(※7)とデータレイク(※8)の課題を解決するデータ管理における新たなオープンアーキテクチャを指す。データレイクハウスでは、従来から活用していた構造化データに加え、AIや機械学習の活用に欠かすことのできない非構造化データを柔軟に組み合わせて分析を行うことができる。データレイクとデータウェアハウスを単一のシステムに統合することで、データ部門が複数のシステムにアクセスする必要がなくなり、データ処理が迅速化する。

※10. ELT処理

ETL処理(※4)と対比して使われることが多い言葉。データ統合処理の順序を従来型のE→T→Lの順ではなく、E→L→Tの順でおこなう。近年ではDBMSの性能が爆発的に向上したことから、その性能を有効活用するために使われる手法。

データ統合処理は、データの変換を伴うことが多いですが、 この 「SQL ELT最適化」機能では、ELT処理によりDBMSなどの処理能力を最大限に活用し、高いパフォーマンスを実現します。

具体的には、 データ変換処理を各DBMS固有の命令を含む最適なSQLクエリに変換して、DBMS側で実行します。

今回は、 Databricks を対象に、この「SQL ELT最適化」機能の使い方をご紹介します。

※. 余談ですが、弊社はDatabricksも取り扱っており、日本で最多である9名の「Databricks Champion」(※11)が在籍しているほか、多数の受賞歴がございます。

※11. Databricks Champion

Databricks Championは、Databricksが提供する「データとAIの民主化」を推進するソリューションの特性や概念を理解し、技術的な専門家という側面だけでなく、エバンジェリストとして、その深い知見をマーケットに広く発表していく「 Legendary Heroes of DATA + AI 」。

SQL ELT実行時にSQL warehouseを使うようにSecure Agentを設定する

HOW TO: Configure a mapping task in Cloud Data Integration to use the Databricks SQL engine に従って設定していきます。

- IDMCにログインする。

- アプリケーションピッカー(マイサービス)で「管理者」をクリックする。

- 左ペインで「ランタイム環境」をクリックする。

- 右ペインにてエージェントグループを開いてSecure Agentをクリックする。

- 「編集」ボタンをクリックする。

- 「サービス」欄にて「Data Intgration Server」を選択する。

- 「タイプ」欄にて「DTM」を選択する。

- 「JVMOption」系のキーで値が未設定の行の編集アイコンをクリックする。

-

-DUseDatabricksSqlForPdo=trueと入力する。

- 「保存」ボタンをクリックする。

- 「Data Intgration Server」が再起動するのを待つ。

なお、この「Sql」というのはDatarbricksの「SQL warehouse」を表し、「Pdo」というのは「Pushdown Optimizaion」(現在の表現で言うと「SQL ELT」)を表すと思われます。

S3バケットを作って入力側となるファイルを格納する

CDIは 様々なシチュエーションでデータ統合処理をDatabricksにSQL ELTすることができます が、今回、Databricksにロードするデータは、S3にCSVファイルとして格納しておくことにしました。

なお、 Databricksは自身が持つデータレイクハウス(※9)にAmazon S3からデータを取り込む機能を持っています が、本記事では別のAWSアカウントのS3バケットからデータをロードしてみます。

まず、AWSマネジメントコンソールの「S3」にて、S3バケットを作りました。

次に、入力ファイルとして、次のような3種類のダミーデータを用意し、格納しました。

- order_data.csv (注文情報)

- customer_data.csv (顧客マスタ)

- product_data.csv (商品マスタ)

S3の認証情報をDatabricksのSQL WarehouseのSparkパラメータとして設定する

SQL ELTすると、Databricksが直接ソース側のS3バケットにアクセスすることになります。そのため、アクセスするための認証情報を、DatabricksのSQL WarehouseのSparkパラメータとして設定しておく必要があります。

認証情報(アクセスキーID、シークレットアクセスキー)は、あらかじめAWSマネジメントコンソールの「IAM」にて払い出しておいてください。

Connect to Amazon S3 | Databricks on AWS に従って設定していきます。なお、今回は影響範囲を最小限にするため、バケット毎の設定としています。

- Databricksワークスペースにサインインする。

- Databricksワークスペースの上部のバーでユーザー名をクリックする。

- メニューにて「Settings」をクリックする。

- 左ペインの「Workspace admin」の「Compute」をクリックする。

- 右ペインの「SQL Warehouse」の「Manage」ボタンをクリックする。

- 「Data Security」パートの「Data Access Configuration」に次のように入力する(エンドポイントは東京リージョンの場合)。

spark.hadoop.fs.s3a.bucket.【S3のバケット名】.access.key 【当該バケットにアクセスするためのアクセスキーID】 spark.hadoop.fs.s3a.bucket.【S3のバケット名】.secret.key 【当該バケットにアクセスするためのシークレットアクセスキー】 spark.hadoop.fs.s3a.bucket.【S3のバケット名】.endpoint s3.ap-northeast-1.amazonaws.com

Databricksに出力側となるテーブルを作る

今回、Databricks側にロードする際には、前述の入力を変換しながら結合していくこととします。(詳細は後述)

DatabricksのWebインターフェースにて、次のようなテーブルを作りました。

アドオンコネクタとしてS3とDatabricksを有効にする

CDIでは接続先のリソース毎に、「コネクタ」を使用します。標準のコネクタのほかに、 様々なアドオンコネクタがあります。

CDIの30日間の無料体験 を使用している場合などは、アドオンコネクタを使えるようにする作業が必要です。下記の操作を実施してください。すでに使えるようになっている場合はこの作業は不要です。

- IDMCにログインする。

- アプリケーションピッカー(マイサービス)で「管理者」をクリックする。

- 左ペインで「アドオンコネクタ」をクリックする。

- 右上の検索欄に「s3」と入力する。

- 「Amazon S3 Connector」の「無料トライアルを開始する」ボタンをクリックする。

- ダイアログで「OK」ボタンをクリックする。

- 右上の検索欄に「Databricks」と入力する。

- 「Databricks Delta Connector」の「無料トライアルを開始する」ボタンをクリックする。

- ダイアログで「OK」ボタンをクリックする。

接続オブジェクトを作る

CDIでは接続先の設定を「接続」(あるいは「接続オブジェクト」)という定義体で管理しています。

今回はS3とDatabricksの接続オブジェクトを作ります。

- 左ペインで「接続」をクリックする。

- 「新しい接続」ボタンをクリックする。

-

S3用の接続オブジェクト を作るために、下記のように入力する。

設定項目 設定値 接続名 【任意。以降では「conn_amazons3」と記載)】 説明 タイプ Amazon S3 v2 ランタイム環境 【自分のランタイム環境(Secure Agentをインストールしたマシン)】 Access Key Secret Key IAM Role ARN External Id Use EC2 Role to Assume Role Folder Path 【先ほど作成したS3バケット名】 Master Symmetric Key Customer Master Key ID S3 Account Type Amazon S3 Storage Region Name 【S3バケットが存在するリージョン名】 Federated SSO IdP NONE Other Authentication Type NONE S3 VPC Endpoint Type NONE STS VPC Endpoint Type NONE KMS VPC Endpoint Type NONE - 「保存」ボタンをクリックする。

- 「テスト接続」ボタンをクリックする。

- 「この接続のテストに成功しました。」と表示されることを確認する。

- Databricksワークスペースにサインインする。

- Databricksワークスペースの上部のバーでユーザー名をクリックする。

- メニューにて「Settings」をクリックする。

- 左ペインの「Users」の「Developer」をクリックする。

- 「Access tokens」の右側の「Manage」ボタンをクリックする

- 「Generate new token」ボタンをクリックする。

- 「Comment」欄に使用目的を入力する。

- 「Lifetime」欄に有効日数を入力する。

- 「Generate」ボタンをクリックする。

- トークンをメモしておく。

- 左ペインの「SQL Warehouses」をクリックする。

- 使用するSQL Warehouseをクリックする。

- 「Connection details」タブをクリックする。

- 「JDBC URL」欄の内容をメモしておく。

- IDMCの接続管理画面に戻る。

- 「新しい接続」ボタンをクリックする。

-

Databricks用の接続オブジェクト を作るために、下記のように入力する。

設定項目 設定値 接続名 【任意。以降では「conn_databricks」と記載)】 説明 タイプ Databricks Data Cloud ランタイム環境 【自分のランタイム環境(Secure Agentをインストールしたマシン)】 Authentication Standard SQL Warehouse JDBC URL 【前述の手段で取得したJDBC URL】 Databricks Token 【前述の手順で取得したトークン】 Catalog Name 【カタログ名】 - 「保存」ボタンをクリックする。

- 「テスト接続」ボタンをクリックする。

- 「この接続のテストに成功しました。」と表示されることを確認する。

マッピングを作る

CDIでは、データ統合処理を「マッピング」という定義体で管理しています。

まず、空のマッピングを作ります。

- アプリケーションピッカー(マイサービス)で「データ統合」をクリックする。

- 左ペインにて「新規」をクリックする。

- ダイアログで、「マッピング」>「マッピング」をクリックする。

- 「作成」ボタンをクリックする。

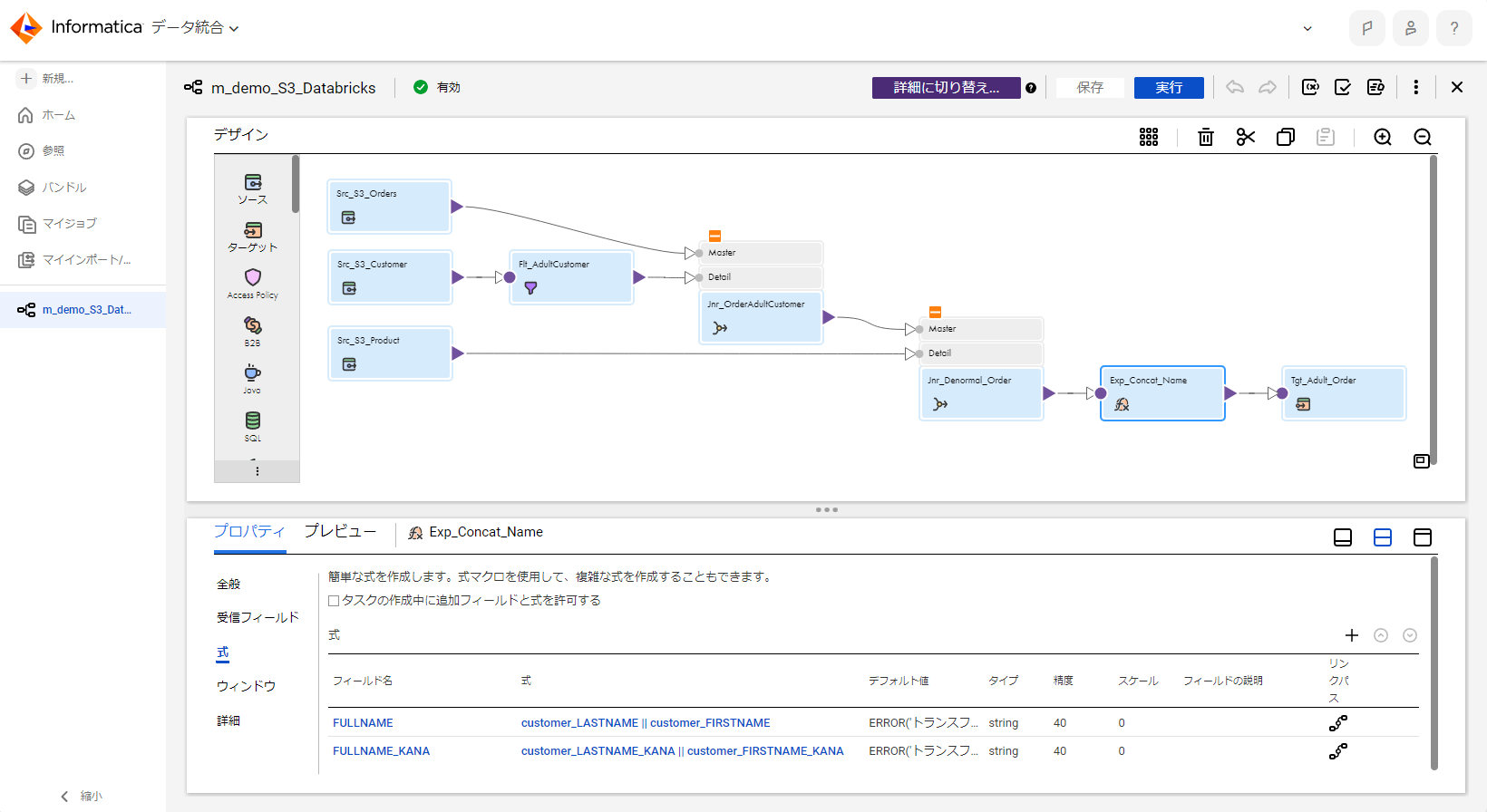

さて、マッピングでのデータ統合処理の内容ですが、今回は、「S3バケット内の複数のCSVファイルのデータを抽出し、一部を変換して、結合し、さらに変換した後に、Databricksのテーブルにロードする」というものにしてみます。

詳細は割愛しますが、おおむね次のような手順で作成しました。

-

ソースオブジェクト が3個になるように配置する。

-

各ソースオブジェクトを選択し、「ソース」パートに以下のように設定する。

設定項目 設定値 接続 【先ほど作成したS3用接続オブジェクト】 ソースタイプ 単一オブジェクト オブジェクト 【各CSVファイル】 形式 Flat -

フィルタトランスフォーメーション を配置し、customerと接続する。18歳以上を通過させるように設定する。

-

ジョイナトランスフォーメーション を配置し、orderとcustomerを接続する。

-

ジョイナトランスフォーメーション を配置し、前項のジョイナトランスフォーメーションとproductを接続する。

-

式トランスフォーメーション を配置し、前項のジョイナトランスフォーメーションを接続する。

-

式トランスフォーメーションにて、「LASTNAME」と「FIRSTNAME」を 文字列結合 するように設定する。

-

ターゲットオブジェクト を選択し、「ターゲット」パートに以下のように設定する。

設定項目 設定値 接続 【先ほど作成したDatabricks用接続オブジェクト】 ターゲットの種類 単一オブジェクト オブジェクト 【先ほど作成したテーブル】 操作 Insert Target Database Name Target Table Name Update Override Query Write Disposition 【デフォルト値のまま】 Update Mode 【デフォルト値のまま】 Update As Update Staging Location Pre-SQL Post-SQL Job Timeout 【デフォルト値のまま】 Job Status Poll Interval 【デフォルト値のまま】 DB REST API Timeout 【デフォルト値のまま】 DB REST API Retry Interval 【デフォルト値のまま】 拒否された行の転送 【デフォルト値のまま】 -

ターゲットオブジェクトに前述の式トランスフォーメーションを接続する。

-

ターゲットオブジェクトの「フィールドマッピング」パートにて、受信フィールドとターゲットフィールドをマッピングする。

SQL ELT最適化結果をプレビューする

SQL ELT最適化機能によってマッピングがどのようにSQLクエリに変換されるかをプレビューしてみましょう。

次のように操作します。

- 画面右上の「SQL ELT Query」アイコンをクリックする。

- 「Generate SQL Query」ボタンをクリックする。

- 「次へ」ボタンをクリックする。

- 「SQL ELTプレビュー」ボタンをクリックする。

- 生成されたSQLクエリが表示されている箇所の右上の「⇔」アイコンをクリックする。

- プレビューを見終わったら、「閉じる」ボタンをクリックする。

下記がSQL ELT最適化機能によって生成されたSQLクエリです。

生成されたSQLクエリ1

/** SQLクエリ1 **/

CREATE TABLE denormal_adult_orders_1713323328600_1713323329339(

`PRODUCT_ID` string ,

`PRODUCT_NAME` string ,

`PRICE` string ,

`MAKER` string) USING DELTA ;

生成されたSQLクエリ2

/** SQLクエリ2 **/

COPY INTO denormal_adult_orders_1713323328600_1713323329339 FROM

(SELECT `PRODUCT_ID` :: string , `PRODUCT_NAME` :: string , `PRICE` :: string , `MAKER` :: string FROM 's3a://********/product_data.csv')

FILEFORMAT = CSV

FORMAT_OPTIONS ('delimiter'=",", 'quote'='"', 'escape'='\\', 'encoding'="UTF-8", 'header'='true');

生成されたSQLクエリ3

/** SQLクエリ3 **/

CREATE TABLE denormal_adult_orders_1713323329075_1713323328899(

`CUSTOMER_ID` string ,

`LASTNAME` string ,

`FIRSTNAME` string ,

`LASTNAME_KANA` string ,

`FIRSTNAME_KANA` string ,

`AGE` string ,

`DATE_OF_BIRTH` string ,

`GENDER` string ,

`MAILADDRESS` string ,

`ZIP_CODE` string) USING DELTA ;

生成されたSQLクエリ4

/** SQLクエリ4 **/

COPY INTO denormal_adult_orders_1713323329075_1713323328899 FROM

(SELECT `CUSTOMER_ID` :: string , `LASTNAME` :: string , `FIRSTNAME` :: string , `LASTNAME_KANA` :: string , `FIRSTNAME_KANA` :: string , `AGE` :: string , `DATE_OF_BIRTH` :: string , `GENDER` :: string , `MAILADDRESS` :: string , `ZIP_CODE` :: string FROM 's3a://********/customer_data.csv')

FILEFORMAT = CSV

FORMAT_OPTIONS ('delimiter'=",", 'quote'='"', 'escape'='\\', 'encoding'="UTF-8", 'header'='true');

生成されたSQLクエリ5

/** SQLクエリ5 **/

CREATE TABLE denormal_adult_orders_1713323328555_1713323329427(

`ORDER_ID` string ,

`ORDER_DATETIME` string ,

`CUSTOMER_ID` string ,

`PRODUCT_ID` string ,

`QUANTITY` string) USING DELTA ;

生成されたSQLクエリ6

/** SQLクエリ6 **/

COPY INTO denormal_adult_orders_1713323328555_1713323329427 FROM

(SELECT `ORDER_ID` :: string , `ORDER_DATETIME` :: string , `CUSTOMER_ID` :: string , `PRODUCT_ID` :: string , `QUANTITY` :: string FROM 's3a://********/order_data.csv')

FILEFORMAT = CSV

FORMAT_OPTIONS ('delimiter'=",", 'quote'='"', 'escape'='\\', 'encoding'="UTF-8", 'header'='true');

生成されたSQLクエリ7

/** SQLクエリ7 **/

INSERT INTO `main`.`test_informatica`.`denormal_adult_orders` (ORDER_ID, ORDER_DATE, QUANTITY, CUSTOMER_ID, FULLNAME, FULLNAME_KANA, AGE, DATE_OF_BIRTH, GENDER, MAILADDRESS, ZIP_CODE, PRODUCT_ID, PRODUCT_NAME, PRICE, MAKER )

SELECT t4c10 AS t6c0,

t4c11 AS t6c1,

cast(t4c13 as int) AS t6c2,

t4c0 AS t6c3,

CONCAT(t4c1, t4c2) AS t6c4,

CONCAT(t4c3, t4c4) AS t6c5,

cast(t4c5 as int) AS t6c6,

t4c6 AS t6c7,

t4c7 AS t6c8,

t4c8 AS t6c9,

t4c9 AS t6c10,

`t0`.`PRODUCT_ID` AS t6c11,

`t0`.`PRODUCT_NAME` AS t6c12,

cast(`t0`.`PRICE` as int) AS t6c13,

`t0`.`MAKER` AS t6c14

FROM (`denormal_adult_orders_1713323328600_1713323329339`)

AS t0

INNER JOIN

(

SELECT t1c0 AS t4c0,

t1c1 AS t4c1,

t1c2 AS t4c2,

t1c3 AS t4c3,

t1c4 AS t4c4,

t1c5 AS t4c5,

t1c6 AS t4c6,

t1c7 AS t4c7,

t1c8 AS t4c8,

t1c9 AS t4c9,

`t3`.`ORDER_ID` AS t4c10,

`t3`.`ORDER_DATETIME` AS t4c11,

`t3`.`PRODUCT_ID` AS t4c12,

`t3`.`QUANTITY` AS t4c13

FROM (

SELECT `t1`.`CUSTOMER_ID` AS t1c0,

`t1`.`LASTNAME` AS t1c1,

`t1`.`FIRSTNAME` AS t1c2,

`t1`.`LASTNAME_KANA` AS t1c3,

`t1`.`FIRSTNAME_KANA` AS t1c4,

`t1`.`AGE` AS t1c5,

`t1`.`DATE_OF_BIRTH` AS t1c6,

`t1`.`GENDER` AS t1c7,

`t1`.`MAILADDRESS` AS t1c8,

`t1`.`ZIP_CODE` AS t1c9

FROM (`denormal_adult_orders_1713323329075_1713323328899`)

AS t1

WHERE '18' <= `t1`.`AGE`)

AS t2

INNER JOIN

(`denormal_adult_orders_1713323328555_1713323329427`)

AS t3

ON `t3`.`CUSTOMER_ID` = t1c0)

AS t5

ON t4c12 = `t0`.`PRODUCT_ID`

生成されたSQLクエリ8

/** SQLクエリ8 **/

DROP TABLE denormal_adult_orders_1713323328600_1713323329339

生成されたSQLクエリ9

/** SQLクエリ9 **/

DROP TABLE denormal_adult_orders_1713323329075_1713323328899

生成されたSQLクエリ10

/** SQLクエリ10 **/

DROP TABLE denormal_adult_orders_1713323328555_1713323329427

マッピングタスクを作って実行する

さてこれで、どんなSQLクエリが生成されるかは分かったので、実際に実行してみます。

実行するには、まず、「マッピングタスク」という定義体を作成し、その後、そのマッピングタスクを実行します。

-

左ペインにて「新規」をクリックする。

-

「作成」ボタンをクリックする。

-

次のように設定する。

設定項目 設定値 タスク名 【任意】 プロジェクト 【デフォルト値のまま】 説明 ランタイム環境 【自分のランタイム環境(Secure Agentをインストールしたマシン)】 マッピング 【先ほど作成したマッピング】 -

「次へ」ボタンをクリックする。

-

「ランタイムオプション」の 「SQL ELTの最適化」パート にて、次のように設定する。

設定項目 設定値 SQL ELTの最適化タイプ 【任意。「全体」など。SQL ELT先を片寄せしたい場合は他の値を選ぶ。】 最適化コンテキストタイプ 【デフォルト値のまま】 フォールバックオプション 【デフォルト値のまま】 一時的なビューの作成 有効にする 一時的なシーケンスの作成 有効にする -

「保存」ボタンをクリックする。

-

「実行」ボタンをクリックする。

マッピングタスクの実行結果を見る

マッピングタスクを実行できたので、結果を見てみましょう。

次のように操作します。

- 左ペインにて「マイジョブ」をクリックする。

- 最上部(最新)のジョブインスタンスをクリックする。

- 「ステータス」に「成功」と表示されていることを確認する。

- 下部の「SQL ELT Optimization」パートにて、SQL ELTされたSQLクエリを確認する。

ここで、本当にSQL ELTされているか、この画面からセッションログをダウンロードして見てみます。

実際にSQL ELTされており、先ほどプレビューで見たSQLクエリが、Databricksに発行されていることを確認できました。

おまけとして、Databricksの Query History でも見てみましょう。

先のSQLクエリが、Databricksに発行されていることを確認できました。

結局、SQL ELTでパフォーマンスは上がったの?

さて、ここまで読んできた皆さんが気になるのは、「結局、SQL ELTの有無によって、データ統合処理のパフォーマンスは向上したの?」という点かと思いますが、それは、次に挙げるような様々な条件によって変わるため、ここで提示するのは控えます。

- SQL ELTなしのデータ統合処理(ETL処理)で使用するEC2インスタンスのインスタンスタイプ

- SQL ELTありのデータ統合処理(ELT処理)で使用するDatabricks SQL Warehouseのサイズ

- 入出力するデータ量 etc...

大量のデータを処理する場合はSQL ELT最適化が効果を発揮する場合が多いでしょう。(SQL ELTできない種類の変換処理もあります)

おわりに

以上、「Informaticaのデータ統合サービスCloud Data IntegrationでDatabricksにELTしてみた」でした。

CDIは30日間の無料体験ができる ので、この機会に試してみてはいかがでしょうか。

DatabricksやDatabricksが提供する「レイクハウス」についてもっと知りたい方は、「2023 Databricks Global Partner Awards」の「APJ Partner Champion of the Year」も受賞している弊社齋藤のインタビュー記事をご覧ください。

仲間募集

NTTデータ ソリューション事業本部 では、以下の職種を募集しています。

1. クラウド技術を活用したデータ分析プラットフォームの開発・構築(ITアーキテクト/クラウドエンジニア)

クラウド/プラットフォーム技術の知見に基づき、DWH、BI、ETL領域におけるソリューション開発を推進します。

https://enterprise-aiiot.nttdata.com/recruitment/career_sp/cloud_engineer

2. データサイエンス領域(データサイエンティスト/データアナリスト)

データ活用/情報処理/AI/BI/統計学などの情報科学を活用し、よりデータサイエンスの観点から、データ分析プロジェクトのリーダーとしてお客様のDX/デジタルサクセスを推進します。

https://enterprise-aiiot.nttdata.com/recruitment/career_sp/datascientist

3.お客様のAI活用の成功を推進するAIサクセスマネージャー

DataRobotをはじめとしたAIソリューションやサービスを使って、

お客様のAIプロジェクトを成功させ、ビジネス価値を創出するための活動を実施し、

お客様内でのAI活用を拡大、NTTデータが提供するAIソリューションの利用継続を推進していただく人材を募集しています。

https://nttdata-career.jposting.net/u/job.phtml?job_code=804

4.DX/デジタルサクセスを推進するデータサイエンティスト《管理職/管理職候補》

データ分析プロジェクトのリーダとして、正確な課題の把握、適切な評価指標の設定、分析計画策定や適切な分析手法や技術の評価・選定といったデータ活用の具現化、高度化を行い分析結果の見える化・お客様の納得感醸成を行うことで、ビジネス成果・価値を出すアクションへとつなげることができるデータサイエンティスト人材を募集しています。https://nttdata-career.jposting.net/u/job.phtml?job_code=898

ソリューション紹介

Trusted Data Foundationについて

~データ資産を分析活用するための環境をオールインワンで提供するソリューション~

https://www.nttdata.com/jp/ja/lineup/tdf/

最新のクラウド技術を採用して弊社が独自に設計したリファレンスアーキテクチャ(Datalake+DWH+AI/BI)を顧客要件に合わせてカスタマイズして提供します。

可視化、機械学習、DeepLearningなどデータ資産を分析活用するための環境がオールインワンで用意されており、これまでとは別次元の量と質のデータを用いてアジリティ高くDX推進を実現できます。

TDFⓇ-AM(Trusted Data Foundation - Analytics Managed Service)について

~データ活用基盤の段階的な拡張支援(Quick Start) と保守運用のマネジメント(Analytics Managed)をご提供することでお客様のDXを成功に導く、データ活用プラットフォームサービス~

https://www.nttdata.com/jp/ja/lineup/tdf_am/

TDFⓇ-AMは、データ活用をQuickに始めることができ、データ活用の成熟度に応じて段階的に環境を拡張します。プラットフォームの保守運用はNTTデータが一括で実施し、お客様は成果創出に専念することが可能です。また、日々最新のテクノロジーをキャッチアップし、常に活用しやすい環境を提供します。なお、ご要望に応じて上流のコンサルティングフェーズからAI/BIなどのデータ活用支援に至るまで、End to Endで課題解決に向けて伴走することも可能です。

NTTデータとInformaticaについて

データ連携や処理方式を専門領域として10年以上取り組んできたプロ集団であるNTTデータは、データマネジメント領域でグローバルでの高い評価を得ているInformatica社とパートナーシップを結び、サービス強化を推進しています。

https://www.nttdata.com/jp/ja/lineup/informatica/

NTTデータとTableauについて

ビジュアル分析プラットフォームのTableauと2014年にパートナー契約を締結し、自社の経営ダッシュボード基盤への採用や独自のコンピテンシーセンターの設置などの取り組みを進めてきました。さらに2019年度にはSalesforceとワンストップでのサービスを提供開始するなど、積極的にビジネスを展開しています。

これまでPartner of the Year, Japanを4年連続で受賞しており、2021年にはアジア太平洋地域で最もビジネスに貢献したパートナーとして表彰されました。

また、2020年度からは、Tableauを活用したデータ活用促進のコンサルティングや導入サービスの他、AI活用やデータマネジメント整備など、お客さまの企業全体のデータ活用民主化を成功させるためのノウハウ・方法論を体系化した「デジタルサクセス」プログラムを提供開始しています。

https://www.nttdata.com/jp/ja/lineup/tableau/

NTTデータとAlteryxについて

Alteryx導入の豊富な実績を持つNTTデータは、最高位にあたるAlteryx Premiumパートナーとしてお客さまをご支援します。

導入時のプロフェッショナル支援など独自メニューを整備し、特定の業種によらない多くのお客さまに、Alteryxを活用したサービスの強化・拡充を提供します。

NTTデータとDataRobotについて

NTTデータはDataRobot社と戦略的資本業務提携を行い、経験豊富なデータサイエンティストがAI・データ活用を起点にお客様のビジネスにおける価値創出をご支援します。

NTTデータとDatabricksについて

NTTデータではこれまでも、独自ノウハウに基づき、ビッグデータ・AIなど領域に係る市場競争力のあるさまざまなソリューションパートナーとともにエコシステムを形成し、お客さまのビジネス変革を導いてきました。

Databricksは、これら先端テクノロジーとのエコシステムの形成に強みがあり、NTTデータはこれらを組み合わせることでお客さまに最適なインテグレーションをご提供いたします。