Microsoft は 5 月 23 日、Build 2023「The era of the AI Copilot」のセッションにおいて、「Copilot Stack」開発フレームワークを発表しました。

「マイクロソフト、AI アプリや Copilot の構築フレームワークを明らかにし、AI プラグインエコシステムを拡充」

Copilot stack の具体的な話はコチラ↑

開発者が独自のコパイロットを構築するための AI 開発フレームワークの概説

Copilot stack のコンポーネントは大きく分けて 3 層に分かれており、

- アプリケーション

- AI オーケストレーション

- 基盤モデル

です。

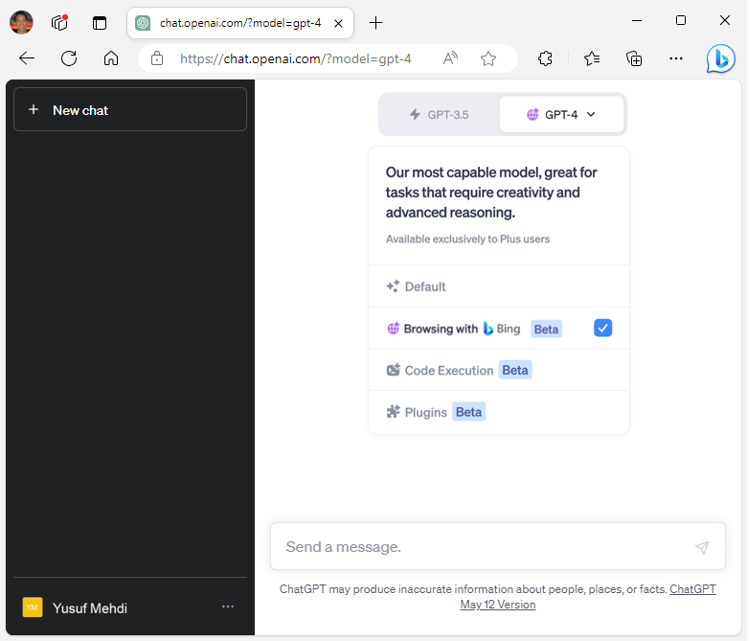

アプリケーション層はフロントエンドで、ChatGPT と連携するプラグインや、企業のアプリケーションに統合する独自の Copilot です。このプラグイン開発に Github Copilot と Visual Studio を利用して簡単にプラグインを開発し、ChatGPT UI に統合するデモが披露されました。

AI オーケストレーション on Azure

先月、Semantic Kernel を用いて GPT モデルを様々なデータソース、アプリのオーケストレーターとして利用するアーキテクチャ例を紹介しましたが、今回 Azure Machine Learning にプロンプトフローという初のプロンプトエンジニアリングツールが搭載され、UI を用いて LLM オーケストレーター開発ができるようになりました。

さらにこのプロンプトフローは、Azure OpenAI Service の Chat playground などと共に、Azure AI Studio に統合されました。

プロンプトとメタプロンプト

"メタプロンプト"は、例えば ChatGPT に対するキャラ付けであったり、ルール、安全性、Responsible AI に関する制限などを記述するプロンプトとして、解決すべきタスクを指示する"プロンプト"と区別しています。

メタプロンプトはモデルを Fine-tuning しなくても簡単にモデルのルールや振る舞いを適用できる手段ですが、本当にルールに従っているかどうかを本番適用前に十分にテストする必要があります。Azure AI Studio には、このメタプロンプトをテストする仕組みが搭載されています。さらに Azure AI Content Safety 機能によってコンテンツ管理基準を満たさないプロンプトや生成からコンテンツを検出し、削除することができます。

Grounding

Grounding によってプロンプトに対してベクトルデータベースに保管した記憶や Web API 経由の外部データ、プラグインの実行結果などを付加して、モデルの知らない内容も答えさせることができます。この Grounding を UI 上で簡単に行えるのが Azure AI Studio です。

プラグイン

Microsoft は、OpenAI 社が ChatGPT に導入したのと同じオープンなプラグイン規格を採用することを発表しており、ChatGPT と Microsoft が提供する幅広い Copilot の相互運用を可能にします。プラグインは単に Grounding 用途で用いるだけでなく、Bing、Dynamics 365 Copilot、Microsoft 365 Copilot、Windows Copilot などの Copilot からも機能します。

注目はやはり Azure AD によるアクセスコントロールが使える点ですね。アクセスコントロールは例えば Chat UI からのドキュメント検索リクエストに対して、表示するべきドキュメントをユーザーごとに出し分ける(フィルタリング)するのに必要不可欠な要素です。

ここに、エンタープライズにおけるプラグイン開発エコシステム、爆誕です。

プラグイン開発

Microsoft 365 Copilot 用プラグイン開発

Microsoft 365 Copilot 用のプラグインは、早期アクセス プレビュー段階であり、参加するには開発者プレビュープログラムへの申請が必要です。Microsoft 365 Copilot では、Teams メッセージ拡張機能や Microsoft Graph コネクタが提供されます。

Azure AI Studio

Chat playground

Azure AI Studio 内の Chat playground に「Add your data」が追加されました。

こちらでは Azure Cognitive Search のインデックスからドキュメントの情報を取得して回答させることが簡単にできるようになります。

Chat playground 上からプラグインを呼び出し、Grounding することもできます。

プロンプトフロー

Azure Machine Learning に統合された、プロンプトエンジニアリングツールです。

プロンプトフローではグラフを用いてプロンプトチェーンを構成できます。

図の上部を見てください、LangChain や Semantic Kernel の LLM 開発ライブラリが統合されています!さらに、様々な LLM、プロンプト、Python コードを統合し、複数のデータソースも統合されています。

上図の retrieve_cart のツール定義にあるように、社内システムの API からのデータ取得結果を Grounding して、ChatGPT から回答させることができます。

そして、プロンプトフロー側にも Azure Cognitive Search のベクトルインデックスが統合されました。BM25 ベースの全文検索エンジンである Azure Cognitive Search は今日、ベクトルデータベースとして利用できるようになったのです。

Azure OpenAI の Embeddings API を利用する場合、ベクトルインデックスへのテキスト(ドキュメントチャンク)の格納時とユーザークエリーの変換時に API を呼ぶ必要がありますが、このアクションを簡単にフローに挿入できると非常に便利になります。

基盤モデル

LLM 中心アプリ開発のベースとなる基盤モデルは、GPT-3/4 だけでなく、様々なオープンソースのモデルも統合することができます。

Azure Machine Learning のモデルカタログでは様々なオープンソースモデルを選択して、利用したりファインチューニングしたりできます。

Build では、様々なモデルや API を接続して、最終的に Linkedin に投稿するデモが披露されました。このデモの時点で、LLM 中心アプリの開発のためには GPT モデルだけにこだわっていないことが分かります。

Azure AI Studio やプラグインと連携すれば、企業内でこのような高度な LLM 中心アプリを開発することができます。

Microsoft Build 2023 Book of News