Archive

次のリンクのチュートリアルを行うと大まかには理解できます。

-

バケット作成※バージョニング・オブジェクトロックは有効

ガバナンスモードを追加設定してみます。

勝手に消すなよ設定です。(既に環境は無いので安心してください。)

-

ファイルをアップロードします。

この際、アップロードの工程においてストレージクラスを選択できますね。

べんり。

OK!

次にAWS CLIでやりくり。

cmd

aws configure list

S3の一覧表示

aws s3 ls

Glacier Deep Archiveを保存先として指定する場合。

aws s3 cp "C:\Users\{ユーザー名}\Desktop\{ファイル名}" s3://{バケット名}/path/{ファイル名} --storage-class DEEP_ARCHIVE --region us-east-1

参考:

フォルダをアップロードしたい場合。

aws s3 cp "C:\Users\{ユーザー名}\Desktop\{フォルダ名}" s3://{バケット名}/path/ --recursive --storage-class DEEP_ARCHIVE --region us-east-1

復元

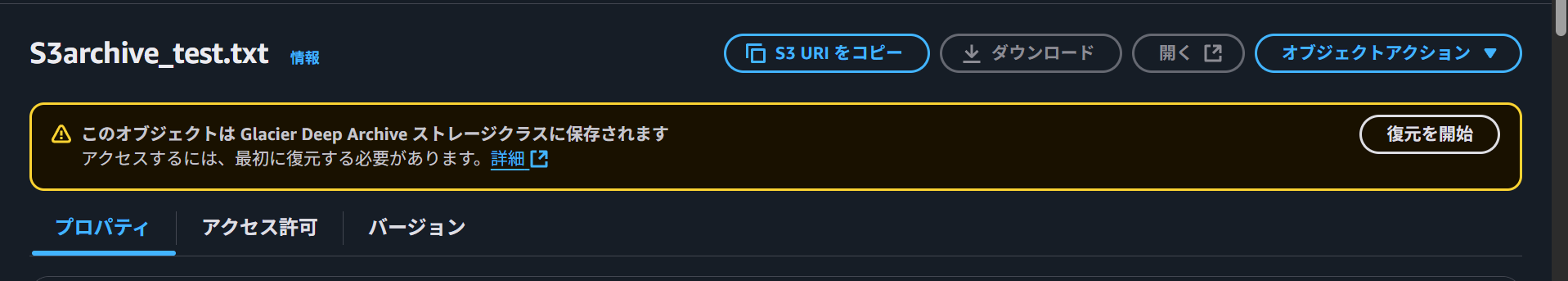

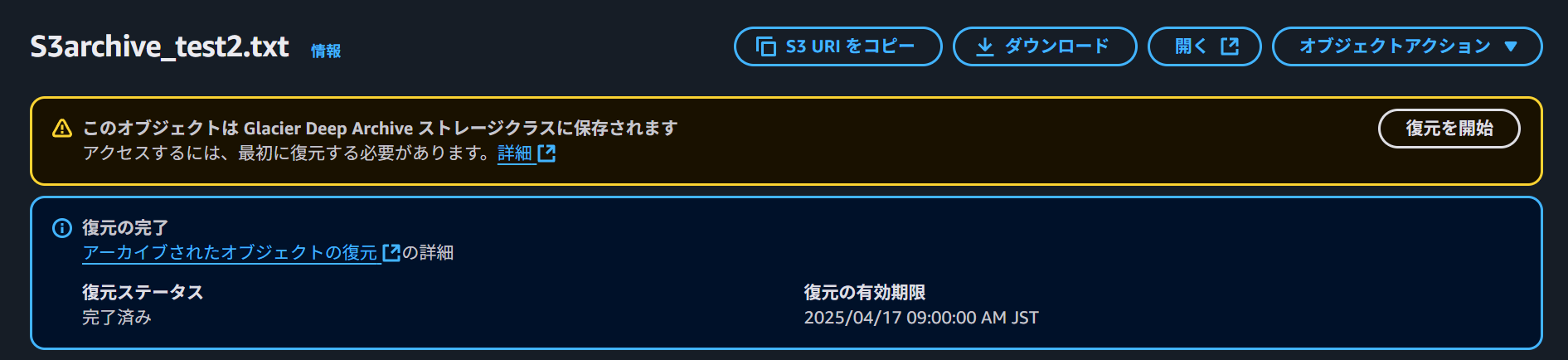

復元後の表示→

実際にファイルをダウンロードすることができました。

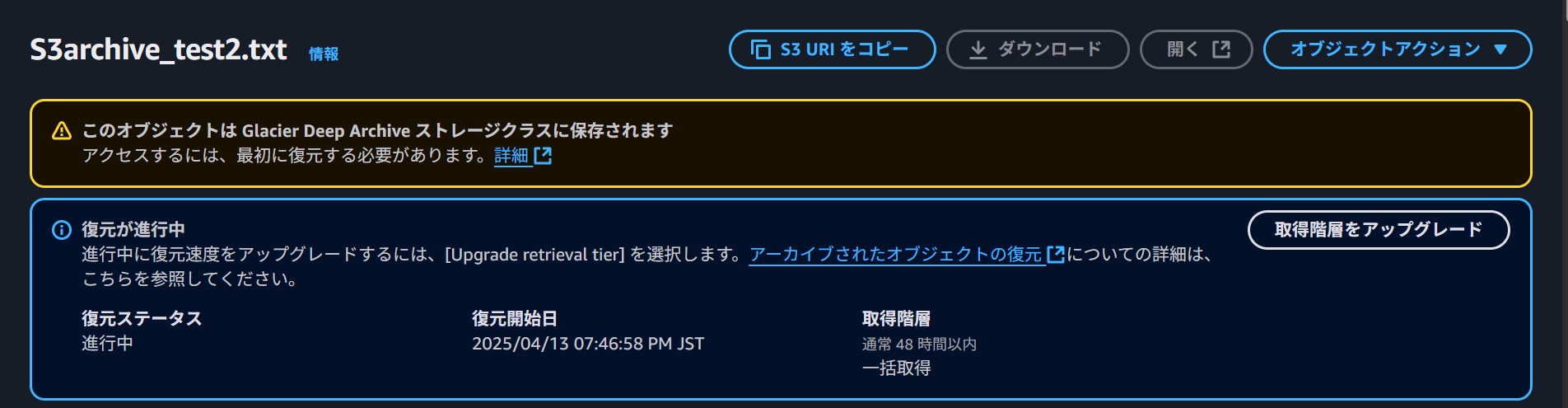

2.コマンドでもやってみます。※これは一括取得なので48時間

aws s3api restore-object --bucket {バケット名} --key "{ファイル名}" --restore-request "{\"Days\":2,\"GlacierJobParameters\":{\"Tier\":\"Bulk\"}}" --region us-east-1

ファイルサイズは関係ないようです。.txtファイルで内容未記載のデータでしたが、復旧時間は平気で24時間を超えてきました。

しかし、表示にあるとおり、時短をすることが可能なようです。「取得時間をアップグレード」というボタンから短縮できるようです。

実際にファイルをダウンロードすることができました。