せっかく精度の高いディープラーニングモデルを作ったのに、実際にサービスで動かすと「重い…遅い…」なんて経験、ありませんか?

今回は、そんな悩みを解決してくれるTensorRTについて、皆さんに分かりやすく紹介していきます。

そもそもTensorRTって何?

TensorRT(テンソルアールティー)は、NVIDIAが開発した「AIモデルを爆速で動かすためのツール」です。 © 2021-2025、NVIDIA Corporation

簡単に言うと:

◎推論速度を劇的に向上させる

◎メモリ使用量を削減する

◎GPU性能を最大限活用する

つまり、あなたの重いモデルを軽量・高速化してくれる魔法のツールです。

TensorRTの主な機能

1. 精度最適化

FP32 → FP16/INT8への量子化

精度をほぼ保ちながら計算量を大幅削減

2. グラフ最適化

例: Conv2D + BatchNorm + ReLU → 最適化された単一レイヤー

3. カーネル最適化

GPU固有の最適化されたカーネルを自動選択

ハードウェアに合わせた最高性能を実現

TensorRTの具体的なメリット

1. 推論速度の高速化

リアルタイム処理が求められるアプリケーションに最適

スループットの向上により、さらに多くのリクエストを同時に処理可能

2. メモリ使用量の削減

GPU メモリ効率の向上により、さらに多くのモデルを同時に実行可能

メモリ効率化により大きなバッチでの処理が可能

3. 精度はそのまま

量子化という技術で軽量化

精度低下は最小限(通常1-2%)

実用上問題なし

4. 簡単導入

主要フレームワークに対応:

TensorFlow

PytTorch

ONNX

その他多数

TensorRTは、特に本番環境での推論処理において威力を発揮し、アプリケーションの実用性を大幅に向上させる技術です。

実際の使い方(簡単!)

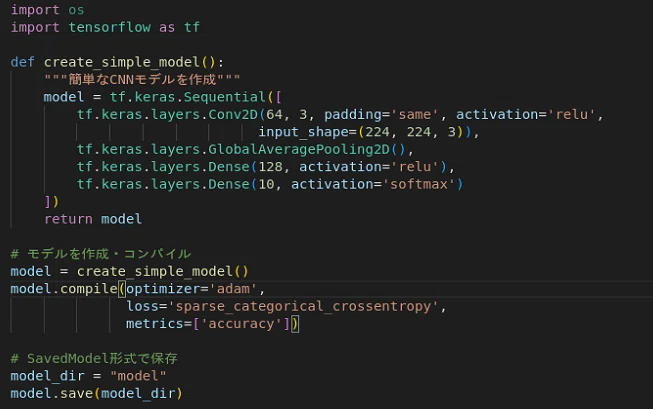

・ モデルの準備

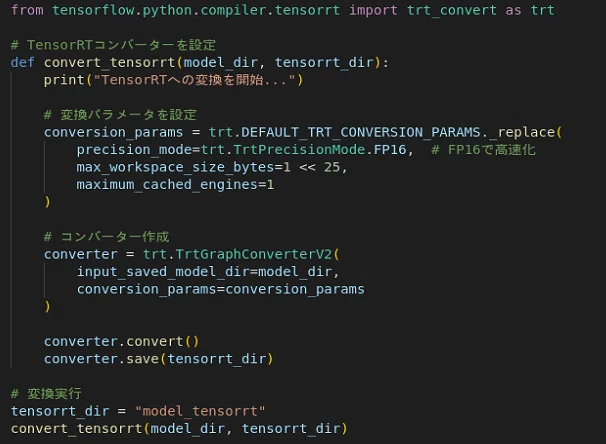

・ TensorRTでモデル変換

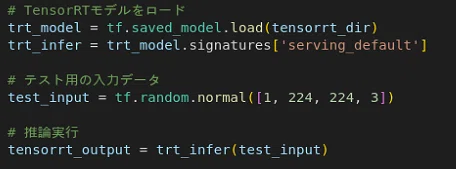

・ TensorRTモデルで推論

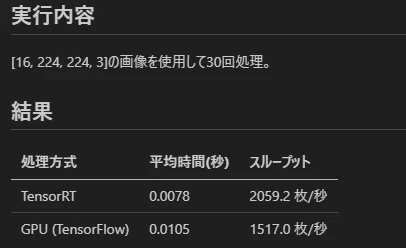

ベンチマークしてみました

・ 使用したモデル

Resnetのような複雑なモデル

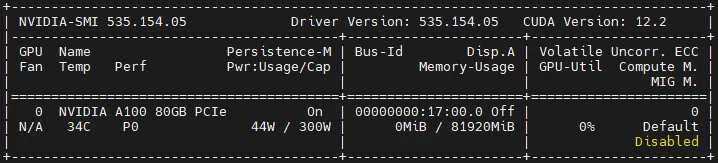

・ 使用したGPU情報

・ 結 果

同じGPUとモデルを使用しても、TensorRTはTensorFlowより1.36倍高速でした。

モデルが大きく複雑化するほど効果は上がるため、最適化などを実施すればさらなる高速化が期待できます。

どんな場面で活躍している?

自動運転

リアルタイム物体検出・認識

車線検出、信号認識

1フレーム遅れが事故に直結する重要な用途

医療診断

CT、MRI画像の高速解析

医師の診断をリアルタイムでサポート

製造業での品質検査

半導体検査装置での欠陥検出

自動車部品の外観検査

製品の品質検査を高速化

セキュリティ・監視

顔認証システム

荷物のX線検査

その他多数

低レイテンシと高スループットが求められる分野

これらの分野では、TensorRTの最適化技術が重要な役割を果たしています。

特にリアルタイム性が要求されるシステムでは、TensorRTなしでは実用化が困難な場合も多くあります。

始めるための環境構築

必要なもの

-

NVIDIA GPU © 2021-2025、NVIDIA Corporation

Support Matrix - NVIDIA TensorRT Documentation -

CUDA(GPU計算用ライブラリ)

-

Python環境

インストール手順

Installing TensorRT - NVIDIA TensorRT Documentation

NGCコンテナを使用する手もあります。

TensorRT | NVIDIA NGC

まとめ

TensorRTは、ディープラーニングモデルを実用化する上で欠かせないツールです。

最初は難しく感じるかもしれませんが、まずは小さなモデルから試してみて、その威力を実感してください。

一度使い方を覚えれば、あなたのプロジェクトが劇的に改善されることでしょう。

いかがでしたでしょうか?

今回の記事を通してエム・ソフトをより深く知っていただくきっかけになれば幸いです!

ぜひ当社公式サイトも見てみてください!

https://www.msoft.co.jp/

https://en-gage.net/msoft_career/

【転機診断チェックシート】

あなたの現状をチェックしてみませんか

https://www.msoft.co.jp/download/Qiita/

最後までお読みいただき、ありがとうございました。