クラウドデータウェアハウスは,ビッグデータ分析の核となる技術として多くの企業に採用されている.本記事では,最も人気のある4つのクラウドデータウェアハウス(Snowflake,Microsoft Fabric,Amazon Redshift,Google BigQuery)について,Pythonからデータを書き込む方法を詳しく解説する.さらに,それぞれのプラットフォームの特徴や違いについても比較していく.

1. 前提条件

各データウェアハウスへの接続にあたっての共通の前提条件は以下の通りである.

- Python 3.6以上の実行環境

- 各クラウドサービスのアカウントとアクセス権限

- 対象となるデータウェアハウスが既に作成済みであること

- ネットワーク接続(一部サービスではIP許可リスト設定が必要)

また,それぞれのサービス特有の前提条件については各セクションで説明する.

2. Snowflakeへのデータ書き込み

2.1 Snowflake接続の前提条件

- Snowflakeアカウント情報(アカウントURL,ユーザー名,パスワード)

- 必要なロールと権限が付与されていること

- 書き込み先のデータベース,スキーマ,テーブルが作成済みであること

2.2 Python用Snowflakeコネクタのインストール

pip install snowflake-connector-python pandas

より高度な機能が必要な場合は,SQLAlchemyとの統合も可能である.

pip install snowflake-sqlalchemy

2.3 基本的なデータ挿入

import snowflake.connector

import pandas as pd

# 接続情報

conn = snowflake.connector.connect(

account='your_account_locator', # アカウント識別子(例: xx12345.east-us-2.azure)

user='your_username',

password='your_password',

warehouse='your_warehouse',

database='your_database',

schema='your_schema'

)

# カーソルを作成

cursor = conn.cursor()

# 挿入用のSQLを実行

try:

insert_sql = """

INSERT INTO sample_table (id, name, value, date_col)

VALUES (%s, %s, %s, %s)

"""

data_to_insert = [

(1, 'Item 1', 100.50, '2023-01-15'),

(2, 'Item 2', 200.75, '2023-01-16'),

(3, 'Item 3', 300.25, '2023-01-17')

]

cursor.executemany(insert_sql, data_to_insert)

conn.commit()

print(f"{len(data_to_insert)}行のデータを挿入しました")

except Exception as e:

print(f"エラーが発生しました: {str(e)}")

finally:

cursor.close()

conn.close()

2.4 Pandasを使用したデータフレームの書き込み

import pandas as pd

from snowflake.connector.pandas_tools import write_pandas

# サンプルデータフレームを作成

df = pd.DataFrame({

'id': [101, 102, 103, 104],

'name': ['Product A', 'Product B', 'Product C', 'Product D'],

'value': [150.25, 275.50, 310.75, 450.00],

'date_col': pd.to_datetime(['2023-02-01', '2023-02-02', '2023-02-03', '2023-02-04'])

})

# Snowflakeへの接続

conn = snowflake.connector.connect(

account='your_account_locator',

user='your_username',

password='your_password',

warehouse='your_warehouse',

database='your_database',

schema='your_schema'

)

# データフレームをテーブルに書き込む

try:

# 書き込み先テーブル

table_name = 'sample_table'

# write_pandas関数を使用してデータを書き込み

success, nchunks, nrows, _ = write_pandas(

conn=conn,

df=df,

table_name=table_name,

quote_identifiers=False

)

print(f"書き込み成功: {success}")

print(f"チャンク数: {nchunks}")

print(f"書き込み行数: {nrows}")

except Exception as e:

print(f"エラーが発生しました: {str(e)}")

finally:

conn.close()

2.5 バルクロードでの書き込み(大量データ向け)

import pandas as pd

import snowflake.connector

from snowflake.connector.pandas_tools import write_pandas

import os

# 大きなデータフレームを生成

large_df = pd.DataFrame({

'id': range(1, 100001),

'name': [f'Item {i}' for i in range(1, 100001)],

'value': [i * 1.5 for i in range(1, 100001)],

'date_col': pd.date_range(start='2023-01-01', periods=100000, freq='D')

})

# Snowflake接続

conn = snowflake.connector.connect(

account='your_account_locator',

user='your_username',

password='your_password',

warehouse='your_warehouse',

database='your_database',

schema='your_schema'

)

# チャンクごとに処理

chunk_size = 10000

total_rows = len(large_df)

try:

# 書き込み前に一時的にワークサイズを大きくする

conn.cursor().execute("ALTER SESSION SET USE_CACHED_RESULT = FALSE")

conn.cursor().execute("ALTER WAREHOUSE your_warehouse SET WAREHOUSE_SIZE = 'LARGE'")

for i in range(0, total_rows, chunk_size):

chunk = large_df.iloc[i:i+chunk_size]

# チャンクを書き込み

success, nchunks, nrows, _ = write_pandas(

conn=conn,

df=chunk,

table_name='large_sample_table',

quote_identifiers=False

)

print(f"チャンク {i//chunk_size + 1}: {nrows}行 処理完了")

# ワークサイズを元に戻す

conn.cursor().execute("ALTER WAREHOUSE your_warehouse SET WAREHOUSE_SIZE = 'MEDIUM'")

except Exception as e:

print(f"エラーが発生しました: {str(e)}")

finally:

conn.close()

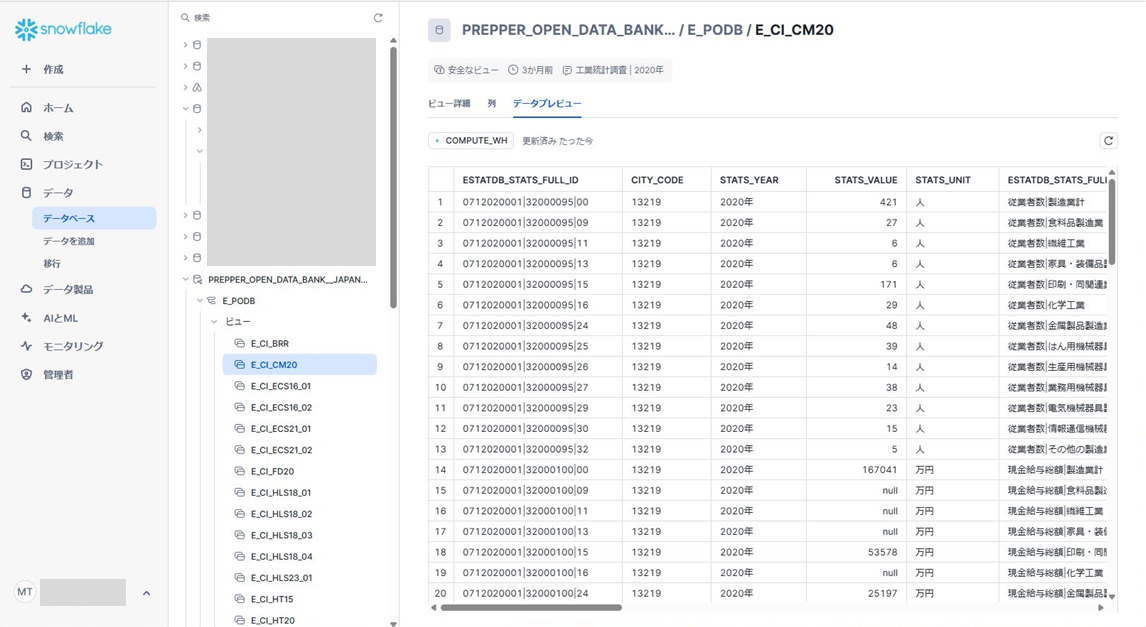

2.6 SnowflakeのGUI

3. Microsoft Fabricへのデータ書き込み

3.1 Microsoft Fabric接続の前提条件

- Microsoft Fabricライセンス(ProまたはPremium)

- Fabricワークスペースとウェアハウスが作成済みであること

- SQL認証またはAzure AD認証の設定

- ファイアウォールで接続元IPが許可されていること

詳細については,Microsoft FabricのウェアハウスにおけるSQL接続とPythonからのデータ書き込み手法で紹介している.

3.2 必要なライブラリのインストール

pip install pyodbc pandas

Azure AD認証を使用する場合は,以下も必要になる.

pip install msal

3.3 SQL認証によるデータ挿入

import pyodbc

import pandas as pd

# 接続文字列の設定

server = "ワークスペース名.sql.fabric.microsoft.com" # Fabricポータルで確認したサーバー名

database = "ウェアハウス名" # ウェアハウス名

username = "SQLユーザー名"

password = "SQLパスワード"

# 接続文字列

conn_str = f"DRIVER={{ODBC Driver 17 for SQL Server}};SERVER={server};DATABASE={database};UID={username};PWD={password}"

# 接続

conn = pyodbc.connect(conn_str)

cursor = conn.cursor()

# データ挿入

try:

insert_query = """

INSERT INTO schema_name.table_name (column1, column2, column3)

VALUES (?, ?, ?)

"""

data_to_insert = [

('Value 1', 100, '2023-01-15'),

('Value 2', 200, '2023-01-16'),

('Value 3', 300, '2023-01-17')

]

cursor.executemany(insert_query, data_to_insert)

conn.commit()

print(f"{len(data_to_insert)}行のデータを正常に挿入しました.")

except Exception as e:

conn.rollback()

print(f"エラーが発生しました: {str(e)}")

finally:

cursor.close()

conn.close()

3.4 Azure AD認証による接続とデータ挿入

import pyodbc

import msal

# AAD認証情報

tenant_id = "テナントID" # Azure ADのテナントID

client_id = "クライアントID" # アプリケーション(クライアント)ID

client_secret = "クライアントシークレット" # クライアントシークレット

server = "ワークスペース名.sql.fabric.microsoft.com"

database = "ウェアハウス名"

# MSALを使用してトークンを取得

authority = f"https://login.microsoftonline.com/{tenant_id}"

scope = ["https://database.windows.net/.default"]

app = msal.ConfidentialClientApplication(

client_id=client_id,

client_credential=client_secret,

authority=authority

)

result = app.acquire_token_for_client(scopes=scope)

if "access_token" in result:

token = result["access_token"]

else:

print(f"トークン取得エラー: {result.get('error')}: {result.get('error_description')}")

exit()

# ODBCドライバーでAzure AD認証を使用して接続

conn_str = f"DRIVER={{ODBC Driver 17 for SQL Server}};SERVER={server};DATABASE={database};Authentication=ActiveDirectoryServicePrincipal;UID={client_id};PWD={client_secret}"

# 接続と処理

conn = pyodbc.connect(conn_str)

cursor = conn.cursor()

# データ挿入処理

try:

insert_query = """

INSERT INTO schema_name.table_name (column1, column2, column3)

VALUES (?, ?, ?)

"""

data_to_insert = [

('AAD Value 1', 110, '2023-01-15'),

('AAD Value 2', 220, '2023-01-16')

]

cursor.executemany(insert_query, data_to_insert)

conn.commit()

print(f"{len(data_to_insert)}行のデータを正常に挿入しました.")

except Exception as e:

conn.rollback()

print(f"エラーが発生しました: {str(e)}")

finally:

cursor.close()

conn.close()

3.5 Pandasを使用したデータフレームの書き込み

import pandas as pd

import urllib

from sqlalchemy import create_engine

# サンプルデータフレームの作成

df = pd.DataFrame({

'column1': ['値A', '値B', '値C', '値D'],

'column2': [150, 250, 350, 450],

'column3': pd.date_range(start='2023-01-01', periods=4)

})

# SQL Server接続用のURLエンコードされた接続文字列

params = urllib.parse.quote_plus(

"DRIVER={ODBC Driver 17 for SQL Server};"

f"SERVER=ワークスペース名.sql.fabric.microsoft.com;"

f"DATABASE=ウェアハウス名;"

f"UID=ユーザー名;"

f"PWD=パスワード"

)

# SQLAlchemyエンジンを作成

engine = create_engine(f"mssql+pyodbc:///?odbc_connect={params}")

# データフレームをSQLテーブルに書き込む

try:

df.to_sql(

'table_name', # テーブル名

engine,

schema='schema_name', # スキーマ名

if_exists='append', # 既存テーブルに追加

index=False,

chunksize=1000 # 一度に処理する行数

)

print(f"{len(df)}行のデータを正常に挿入しました.")

except Exception as e:

print(f"エラーが発生しました: {str(e)}")

finally:

engine.dispose()

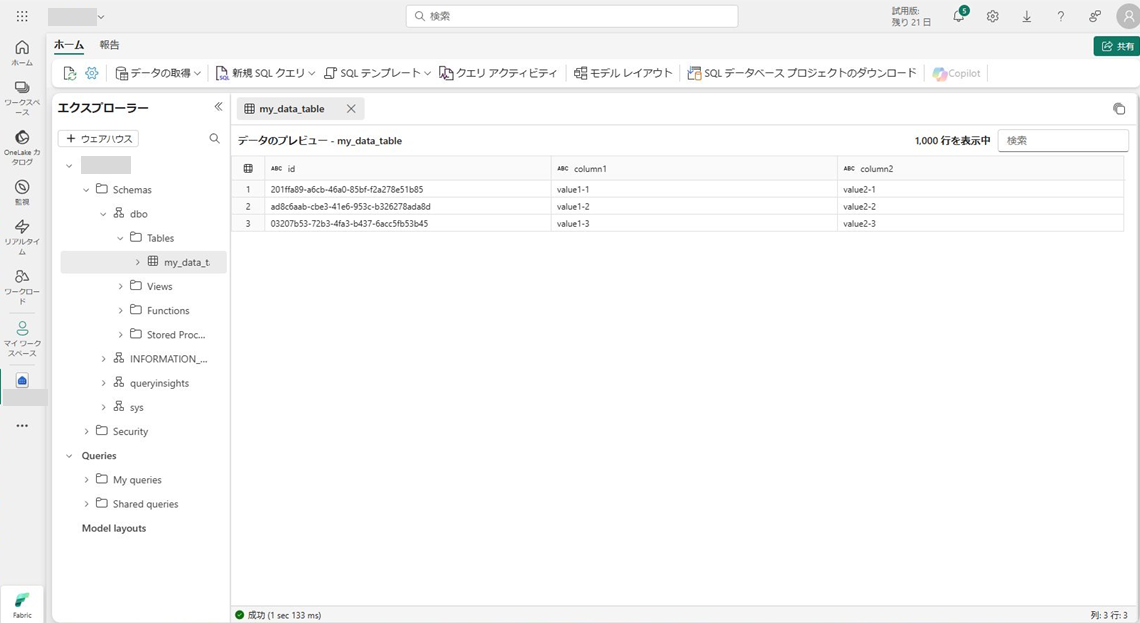

3.6 Microsoft FabricのGUI

4. Amazon Redshiftへのデータ書き込み

4.1 Redshift接続の前提条件

- AWS認証情報(アクセスキーとシークレットキー)またはIAM認証情報

- Redshiftクラスターエンドポイント,ポート,データベース名

- セキュリティグループ設定で接続元IPからのアクセスが許可されていること

4.2 必要なライブラリのインストール

pip install psycopg2-binary pandas boto3

4.3 基本的なデータ挿入

import psycopg2

import pandas as pd

# 接続情報

host = 'your-redshift-cluster.region.redshift.amazonaws.com'

port = '5439'

dbname = 'your-database'

user = 'your-user'

password = 'your-password'

# 接続

conn = psycopg2.connect(

host=host,

port=port,

dbname=dbname,

user=user,

password=password

)

# オートコミットを無効に(トランザクション制御のため)

conn.autocommit = False

cursor = conn.cursor()

# データ挿入

try:

insert_query = """

INSERT INTO schema_name.table_name (id, name, value, date_col)

VALUES (%s, %s, %s, %s)

"""

data_to_insert = [

(1, 'Redshift Item 1', 100.50, '2023-01-15'),

(2, 'Redshift Item 2', 200.75, '2023-01-16'),

(3, 'Redshift Item 3', 300.25, '2023-01-17')

]

cursor.executemany(insert_query, data_to_insert)

conn.commit()

print(f"{len(data_to_insert)}行のデータを正常に挿入しました.")

except Exception as e:

conn.rollback()

print(f"エラーが発生しました: {str(e)}")

finally:

cursor.close()

conn.close()

4.4 IAM認証を使用した接続

import boto3

import psycopg2

# AWS クライアントの設定

boto3.setup_default_session(

aws_access_key_id='YOUR_ACCESS_KEY',

aws_secret_access_key='YOUR_SECRET_KEY',

region_name='YOUR_REGION'

)

# Redshift Data APIクライアントを作成

redshift_client = boto3.client('redshift')

# 一時的な認証情報を取得

credentials = redshift_client.get_cluster_credentials(

DbUser='database_user',

DbName='database_name',

ClusterIdentifier='cluster_identifier',

DurationSeconds=3600 # 1時間有効

)

# 取得した認証情報で接続

conn = psycopg2.connect(

host='your-redshift-cluster.region.redshift.amazonaws.com',

port=5439,

dbname='your_database',

user=credentials['DbUser'],

password=credentials['DbPassword']

)

cursor = conn.cursor()

# データ挿入処理

try:

cursor.execute("""

INSERT INTO schema_name.table_name (id, name, value)

VALUES (10, 'IAM Auth Item', 999.99)

""")

conn.commit()

print("データを挿入しました.")

except Exception as e:

conn.rollback()

print(f"エラーが発生しました: {str(e)}")

finally:

cursor.close()

conn.close()

4.5 S3経由の効率的なデータ読み込み(COPY)

Redshiftでは,大量データの場合はS3を経由したCOPYコマンドを使うのが効率的である.

import boto3

import pandas as pd

import psycopg2

from io import StringIO

import csv

# サンプルデータフレームを作成

df = pd.DataFrame({

'id': range(1, 10001),

'name': [f'Product {i}' for i in range(1, 10001)],

'value': [i * 2.5 for i in range(1, 10001)],

'date_col': pd.date_range(start='2023-01-01', periods=10000)

})

# CSVに変換

csv_buffer = StringIO()

df.to_csv(csv_buffer, index=False, header=False, quoting=csv.QUOTE_MINIMAL)

# S3にアップロード

s3_client = boto3.client(

's3',

aws_access_key_id='YOUR_ACCESS_KEY',

aws_secret_access_key='YOUR_SECRET_KEY',

region_name='YOUR_REGION'

)

bucket_name = 'your-s3-bucket'

file_key = 'redshift_data/batch_import.csv'

s3_client.put_object(

Bucket=bucket_name,

Key=file_key,

Body=csv_buffer.getvalue()

)

# Redshiftへの接続

conn = psycopg2.connect(

host='your-redshift-cluster.region.redshift.amazonaws.com',

port='5439',

dbname='your-database',

user='your-user',

password='your-password'

)

cursor = conn.cursor()

# COPYコマンドでS3からデータをインポート

try:

copy_cmd = f"""

COPY schema_name.table_name (id, name, value, date_col)

FROM 's3://{bucket_name}/{file_key}'

IAM_ROLE 'arn:aws:iam::account-id:role/redshift-s3-role'

DELIMITER ','

TIMEFORMAT 'YYYY-MM-DD'

TRUNCATECOLUMNS

COMPUPDATE OFF;

"""

cursor.execute(copy_cmd)

conn.commit()

print("S3からデータをインポートしました.")

except Exception as e:

conn.rollback()

print(f"エラーが発生しました: {str(e)}")

finally:

cursor.close()

conn.close()

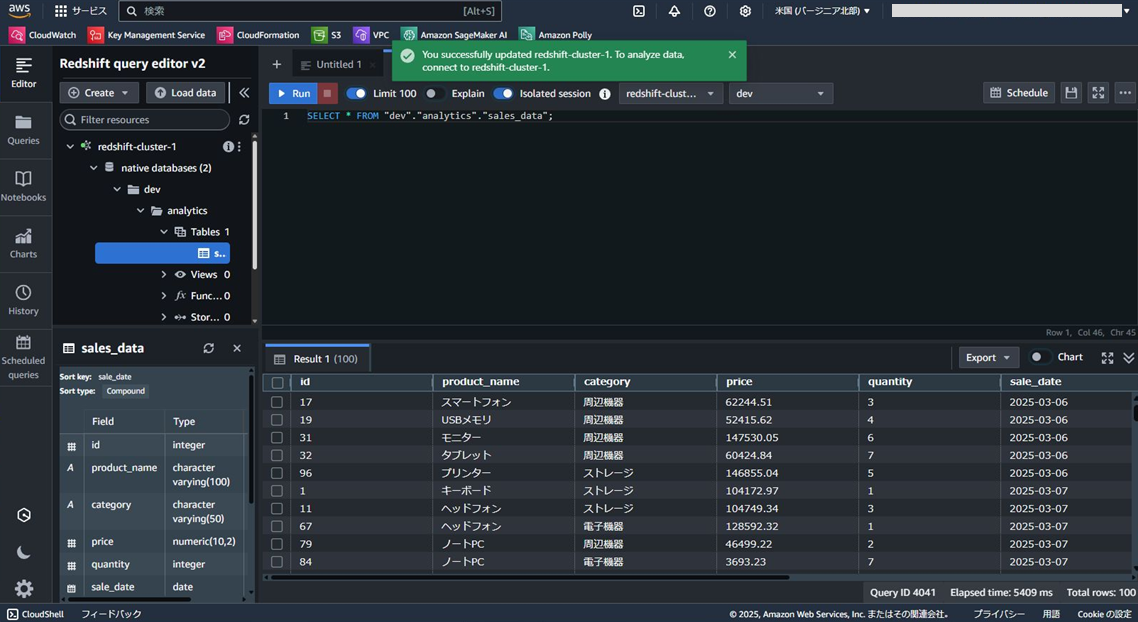

4.6 AWS RedshiftのGUI

5. Google BigQueryへのデータ書き込み

5.1 BigQuery接続の前提条件

- Google Cloudプロジェクトとサービスアカウント

- BigQueryデータセットとテーブルが作成済みであること

- サービスアカウントキーファイル(JSON)へのアクセス

5.2 必要なライブラリのインストール

pip install google-cloud-bigquery pandas pyarrow db-dtypes

5.3 認証と基本的なデータ挿入

from google.cloud import bigquery

from google.oauth2 import service_account

import pandas as pd

# サービスアカウントキーのパス

key_path = "path/to/your-service-account-key.json"

# 認証情報

credentials = service_account.Credentials.from_service_account_file(

key_path,

scopes=["https://www.googleapis.com/auth/bigquery"],

)

# クライアントの作成

client = bigquery.Client(

credentials=credentials,

project=credentials.project_id,

)

# テーブル参照

table_id = "your-project.your_dataset.your_table"

# 行を挿入

rows_to_insert = [

{"id": 1, "name": "BigQuery Item 1", "value": 100.50, "date_col": "2023-01-15"},

{"id": 2, "name": "BigQuery Item 2", "value": 200.75, "date_col": "2023-01-16"},

{"id": 3, "name": "BigQuery Item 3", "value": 300.25, "date_col": "2023-01-17"},

]

# 挿入を実行

errors = client.insert_rows_json(table_id, rows_to_insert)

# エラーチェック

if errors == []:

print(f"{len(rows_to_insert)}行のデータを挿入しました")

else:

print(f"エラーが発生しました: {errors}")

5.4 Pandasを使用したデータフレームの書き込み

from google.cloud import bigquery

from google.oauth2 import service_account

import pandas as pd

# サービスアカウントキーのパス

key_path = "path/to/your-service-account-key.json"

# 認証情報

credentials = service_account.Credentials.from_service_account_file(

key_path,

scopes=["https://www.googleapis.com/auth/bigquery"],

)

# クライアントの作成

client = bigquery.Client(

credentials=credentials,

project=credentials.project_id,

)

# サンプルデータフレームを作成

df = pd.DataFrame({

'id': [101, 102, 103, 104],

'name': ['BQ Product A', 'BQ Product B', 'BQ Product C', 'BQ Product D'],

'value': [150.25, 275.50, 310.75, 450.00],

'date_col': pd.to_datetime(['2023-02-01', '2023-02-02', '2023-02-03', '2023-02-04'])

})

# テーブル参照

table_id = "your-project.your_dataset.your_table"

# 書き込みジョブの設定

job_config = bigquery.LoadJobConfig(

# スキーマを自動検出する場合

autodetect=True,

# 手動でスキーマを定義する場合

# schema=[

# bigquery.SchemaField("id", "INTEGER"),

# bigquery.SchemaField("name", "STRING"),

# bigquery.SchemaField("value", "FLOAT"),

# bigquery.SchemaField("date_col", "DATE"),

# ],

# 既存データに追加

write_disposition="WRITE_APPEND",

)

# データフレームをアップロード

try:

job = client.load_table_from_dataframe(df, table_id, job_config=job_config)

job.result() # ジョブの完了を待機

# 結果を確認

table = client.get_table(table_id)

print(f"テーブルに{table.num_rows}行あります")

except Exception as e:

print(f"エラーが発生しました: {str(e)}")

5.5 大量データのバッチ処理

from google.cloud import bigquery

from google.oauth2 import service_account

import pandas as pd

import numpy as np

from datetime import datetime

import uuid

# 認証情報

credentials = service_account.Credentials.from_service_account_file(

"path/to/your-service-account-key.json",

scopes=["https://www.googleapis.com/auth/bigquery"],

)

client = bigquery.Client(credentials=credentials, project=credentials.project_id)

# 大量のデータを生成

rows = 100000 # 10万行

chunk_size = 10000 # 1万行ずつ処理

# テーブル参照

table_id = "your-project.your_dataset.your_large_table"

# バッチ処理

for i in range(0, rows, chunk_size):

# チャンク用のデータフレームを作成

df_chunk = pd.DataFrame({

'id': range(i, i + chunk_size),

'uuid': [str(uuid.uuid4()) for _ in range(chunk_size)],

'name': [f'Item {j}' for j in range(i, i + chunk_size)],

'value': np.random.rand(chunk_size) * 1000,

'date_col': pd.date_range(start='2023-01-01', periods=chunk_size)

})

print(f"チャンク {i//chunk_size + 1}/{rows//chunk_size} を処理中...")

# ロード設定

job_config = bigquery.LoadJobConfig(

autodetect=True,

write_disposition="WRITE_APPEND",

)

# データをアップロード

try:

job = client.load_table_from_dataframe(df_chunk, table_id, job_config=job_config)

job.result() # ジョブの完了を待機

print(f"チャンク {i//chunk_size + 1}: {chunk_size}行をアップロードしました")

except Exception as e:

print(f"エラーが発生しました: {str(e)}")

break

# 最終行数を確認

table = client.get_table(table_id)

print(f"処理完了.テーブルの最終行数: {table.num_rows}")

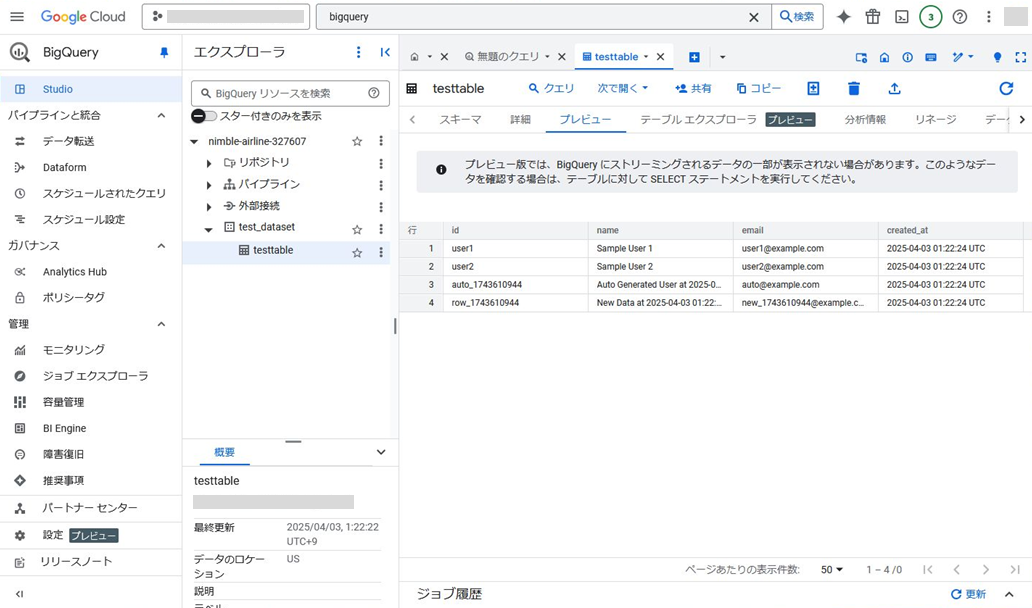

5.6 BigQueryのGUI

6. 各プラットフォームの比較

6.1 接続方式と認証の比較

| プラットフォーム | 接続プロトコル | 主な認証方式 | ドライバ/ライブラリ |

|---|---|---|---|

| Snowflake | JDBC/ODBC, HTTP | ユーザー名/パスワード, OAuth, キーペア | snowflake-connector-python |

| Microsoft Fabric | TDS (SQL) | SQL認証, Azure AD | pyodbc, ODBC Driver |

| Redshift | JDBC/ODBC, PostgreSQL | IAMクレデンシャル, データベース認証 | psycopg2, boto3 |

| BigQuery | REST API | サービスアカウント, OAuth | google-cloud-bigquery |

6.2 データ書き込み方法の比較

| プラットフォーム | 1行ずつの挿入 | バルク挿入 | ファイルからのロード | データフレーム直接ロード |

|---|---|---|---|---|

| Snowflake | ○ (低効率) | ○ (executemany) | ○ (PUT+COPY) | ○ (write_pandas) |

| Microsoft Fabric | ○ (低効率) | ○ (executemany, fast_executemany) | ○ (BULK INSERT) | ○ (to_sql) |

| Redshift | ○ (低効率) | ○ (executemany) | ◎ (S3+COPY推奨) | ○ (to_sql) |

| BigQuery | ○ (insert_rows_json) | ○ (batch insert) | ◎ (GCS経由推奨) | ◎ (load_table_from_dataframe) |

6.3 パフォーマンス面での特徴

| プラットフォーム | 少量データ挿入 | 大量データ挿入 | 最適なロード方法 | スケーリング特性 |

|---|---|---|---|---|

| Snowflake | 良好 | 非常に良い | PUT+COPY | 自動スケーリング (ウェアハウスサイズ調整) |

| Microsoft Fabric | 良好 | 良好 | BulkCopy | 自動スケーリング (予約容量で調整可能) |

| Redshift | 普通 | 良好 | S3+COPY | 手動スケーリング (ノード数調整) |

| BigQuery | 良好 | 非常に良い | GCS+LOAD | 自動スケーリング (スロットで調整可能) |

6.4 料金モデルの比較

| プラットフォーム | 料金モデル | ストレージ課金 | 計算リソース課金 | 停止時の課金 |

|---|---|---|---|---|

| Snowflake | 消費ベース | 圧縮後の使用量 | ウェアハウス使用時間 | ストレージのみ |

| Microsoft Fabric | 容量ベース | 容量単位に含まれる | 容量単位に含まれる | 完全に含まれる |

| Redshift | インスタンスベース+Storage | 使用量ベース | インスタンス時間 | インスタンス料金発生 |

| BigQuery | 消費ベース/定額ベース | 使用量ベース | クエリ処理量またはスロット | ストレージのみ |

6.5 ユーザビリティと開発体験

| プラットフォーム | Python連携の容易さ | エラー処理 | ドキュメンテーション | エコシステム |

|---|---|---|---|---|

| Snowflake | ◎ (専用コネクタ) | ◎ (詳細エラーメッセージ) | 非常に充実 | 豊富なパートナー連携 |

| Microsoft Fabric | ○ (標準ODBC) | ○ (SQLエラー詳細) | まだ発展途上 | Azureエコシステムと統合 |

| Redshift | ○ (PostgreSQL互換) | ○ (エラーコード詳細) | 充実 | AWSエコシステムと統合 |

| BigQuery | ◎ (公式ライブラリ充実) | ◎ (詳細エラー情報) | 非常に充実 | Googleエコシステムと統合 |

6.6 特徴的な機能の比較

| プラットフォーム | 特徴的な書き込み機能 | トランザクション | パーティション管理 | リアルタイム処理 |

|---|---|---|---|---|

| Snowflake | 半構造化データ対応,ゼロコピークローン | ACID準拠 | 自動クラスタリング | Snowpipe (ストリーミング取り込み) |

| Microsoft Fabric | Deltaテーブル,OneLake統合 | ACID準拠 | カスタムパーティション | Azure Stream Analytics連携 |

| Redshift | SUPER型,Spectrum | ACID準拠 | 柔軟なソートキー | Redshift Streaming Ingestion |

| BigQuery | ストリーミング挿入,JSON対応 | 制限付きトランザクション | 自動パーティショニング | BigQuery Storage Write API |

総評と選択ガイド

各クラウドデータウェアハウスは,それぞれに強みと特徴がある.以下に,どのようなケースでどのサービスを選ぶべきかのガイドラインを示す.

Snowflakeが適している場合

- マルチクラウド戦略を採用している組織

- コンピューティングとストレージの分離が必要なケース

- データ共有機能が重要な場合

- 柔軟なスケーリングが必要な場合

Microsoft Fabricが適している場合

- Microsoftのエコシステムに深く統合されている組織

- Power BIとの緊密な連携が必要なケース

- オールインワンのデータ分析プラットフォームを求める場合

- Syntexなど,Microsoft AI機能との統合を活用したい場合

Amazon Redshiftが適している場合

- AWSサービスを広範に利用している組織

- 費用対効果の高いクラウドデータウェアハウスが必要なケース

- S3データレイクと密接に連携する必要がある場合

- 予測可能な料金モデルを好む場合

Google BigQueryが適している場合

- サーバーレスアーキテクチャを求める組織

- 管理オーバーヘッドを最小限に抑えたい場合

- 大規模なデータ分析と機械学習の統合が重要なケース

- GCPエコシステムを活用している場合

まとめ

本記事では,主要なクラウドデータウェアハウス(Snowflake,Microsoft Fabric,Amazon Redshift,Google BigQuery)へPythonからデータを書き込む方法を解説した.各プラットフォームは独自の接続方法と最適化手法を持つが,Pythonのエコシステムはどのサービスにも十分な対応を提供している.また,本記事では,1つのクラウドサービスにロックインすることなく,柔軟にデータウェアハウスが利用できることを確認した.

データウェアハウスの選択においては,単にパフォーマンスや費用だけでなく,既存のクラウドインフラ,チームのスキルセット,長期的なデータ戦略に基づいて判断することが重要である.最適なデータウェアハウスとそのデータ書き込み手法を選択することで,データの価値を最大限に引き出すことができる.

その他ここでは紹介しきれていない,Databricks,Teradataについてもゆくゆく評価していきたいと思う.