検証動画

はじめに

先日OpenAIから公開された多言語音声認識を行うことができるマルチタスクモデルであるWhisperを利用して音声データから音声認識、言語識別、翻訳を検証してみました。

whispaerのインストール

pip install git+https://github.com/openai/whisper.git

whisperを読み込みモデルをダウンロード

import whisper

model = whisper.load_model("large")

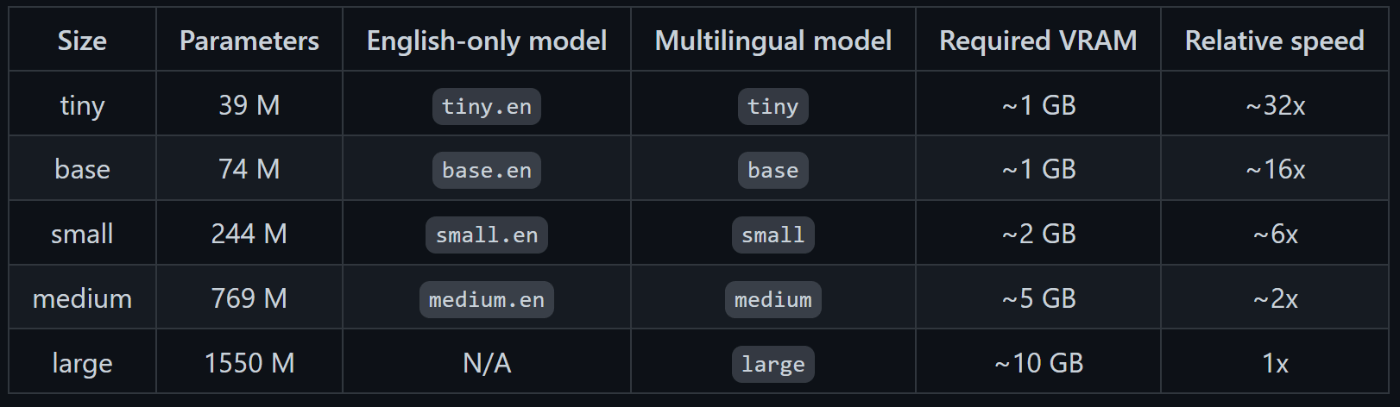

動画内では、「large」モデルを利用しましたが、様々なモデルが存在します。

音声認識

result = model.transcribe("音声データ", verbose=True)

引数で言語を指定しない場合は、自動で言語識別されます。

verboseでログ出力が可能です。

翻訳

result = model.transcribe("音声データ", verbose=True, task=translate)

taskでtranslateを指定することで翻訳することができます。