はじめに

以前 NetworkX を使った可視化で、3D化した Network Topologyグラフをご紹介しました。

このようにグラフによる可視化をするのは非常に分析にとって有益ですが、これらのデータをクラスタリングして、さらに分析を進めるにはどうしたらいいでしょうか? 通常のK-Meansや G-Meansなどではうまく分類できません。

そこでこのようなソーシャルグラフに対して、クラスタリングする手法の一つに Louvainというのがあります。ソーシャルグラフのクラスタリングについてはこちらのスライドが大変わかりやすかったです。

https://www2.slideshare.net/komiyaatsushi/newman-6670300

Splunk DLTK のサンプルにもこの Louvain によるクラスタリングがありましたので、今回 GPU環境を使い cuGraphライブラリにある Louvainを試してみました。

Rapids cuGraphについて

こちらの Readme.mdにありますとおり、Rapids は nVIDIAが作ったGPUを使うためのライブラリー群がセットになったフレームワークであり、その中の一つにcuGraphというグラフ分析を扱うライブラリがあります。Louvainを始めいくつものアルゴリズムがサポートされております。

Louvainとは

ネットワーク内のコミュニティ(密に結合しているノードの集合)を抽出する手法の一つであり、従来の手法に比べ高速で抽出することができます。 参考サイトはこちらです。

準備

利用するには、Splunk DLTK環境になります。

今回は Rapidsを利用するため、GPU環境は必須となります。

1. GPU環境の準備

Splunkサーバーの他に、GPUの搭載されたコンテナ環境を別に用意して接続する必要があります。今回はこちらのブログを参考に環境を準備しました。(かなり詳しく書かれております)

https://www.splunk.com/en_us/blog/tips-and-tricks/splunk-with-the-power-of-deep-learning-analytics-and-gpu-acceleration.html

今回利用した環境は上記Blogにもありますが、AWSの DeepLearning AMIを利用しました。Dockerや必要なライブラリーがすでにインストールされております。

EC2インスタンスタイプは、g4dn.xlarge (4vCPU , 1GPU(T4), 16GB Memory, 0.526USD/時間)を利用しました。(利用しない時はこまめに落としましょう)

また Splunk Server (SH) と通信するため、以下のポートを許可します。(セキュリティグループ)

TCP 22 : Remote access via SSH

TCP 32768: Container SPL application server

TCP 2375: Remote Docker API

TCP 8888: Jupyter Labs DEV image

TCP 6006: Tensorboard DEV image

あとは、コンテナに対してリモートコントロールを許可するため、APIを有効にします。

cat /lib/systemd/system/docker.service |sed 's/containerd.sock/containerd.sock -H=tcp:\/\/0.0.0.0:2375/g' |sudo tee /lib/systemd/system/docker.service sudo systemctl daemon-reload;sleep 2;sudo service docker restart

これでコンテナ側のセットアップは終了です。

セットアップの詳細は、上記のブログを参照ください。

2. DLTK側セットアップ

今度は、Splunk Server (SH) に DLTKをインストールして、セットアップします。

ちょっと古い記事ですが、こちらの記事も参考にしてください。

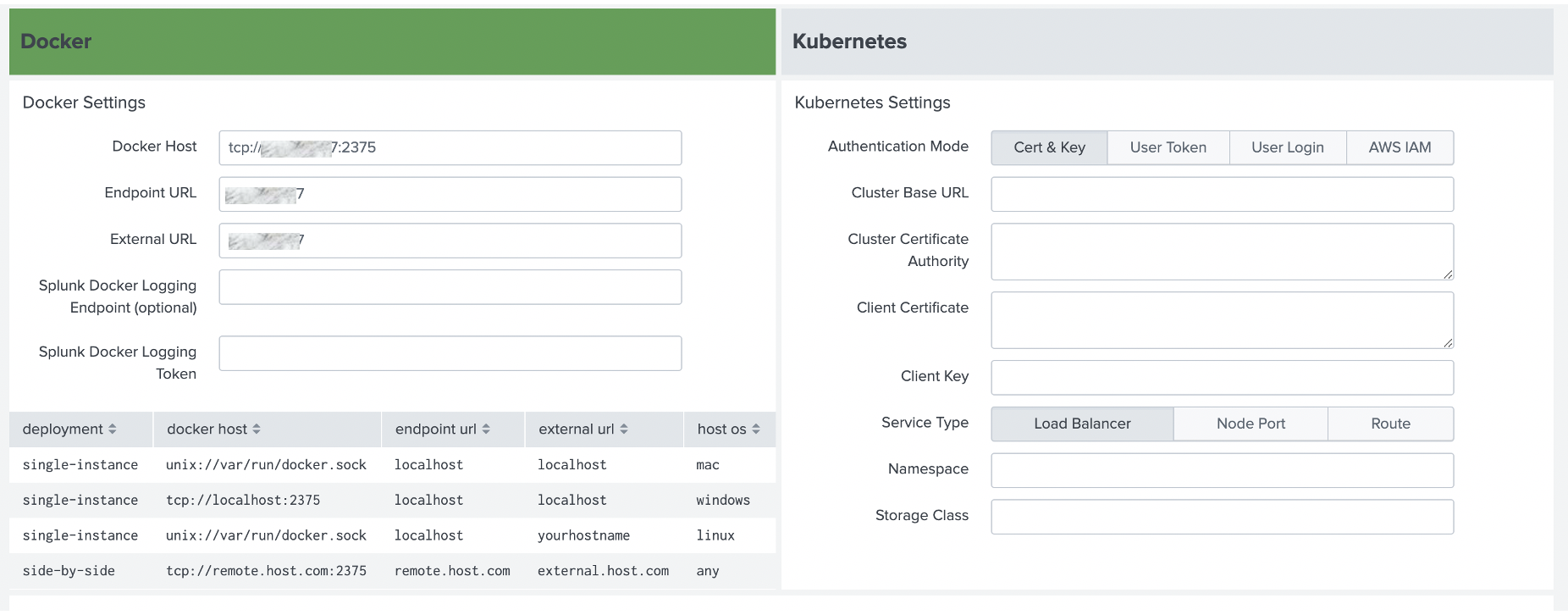

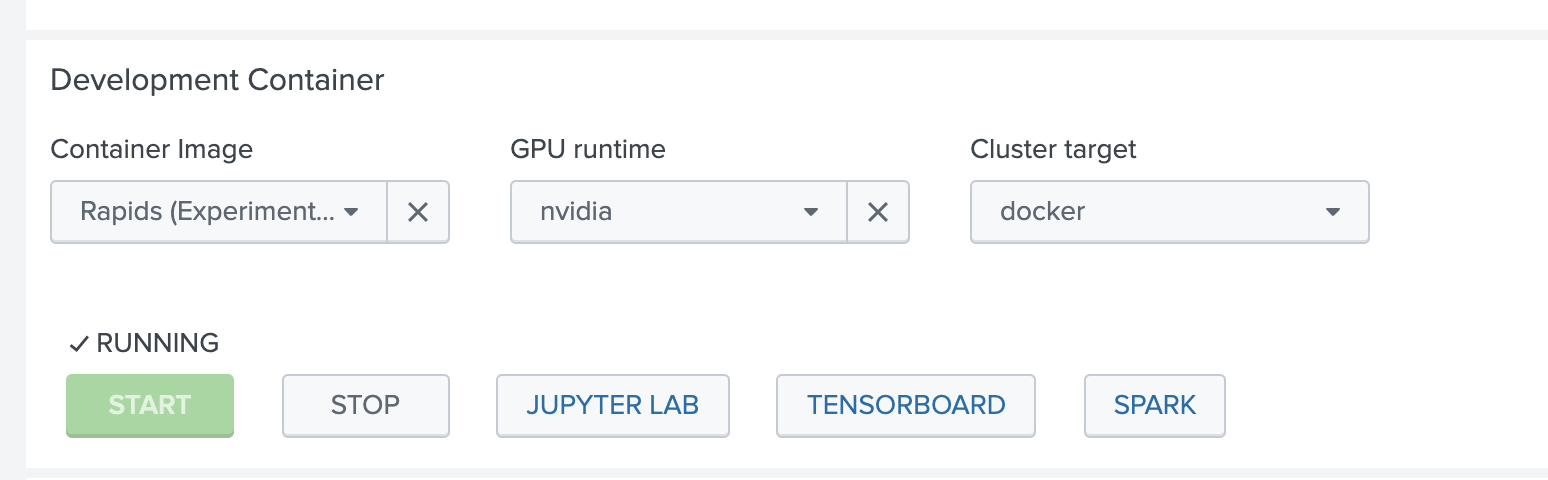

DLTK3.3 では、Dockerと Kubernetesのどちらかが選べますが、今回は Dockerにして、ホストを先ほど作成したリモートホストにします。

実行するコンテナを選択する際に、Rapids + nvidia を選択してください。 (Golden Imageの中には入っておりません)

ノートブックの確認

Jupyter Labに接続すると、graph_algo_louvain.ipynb というノートブックがあります。

中身をみてみましょう。

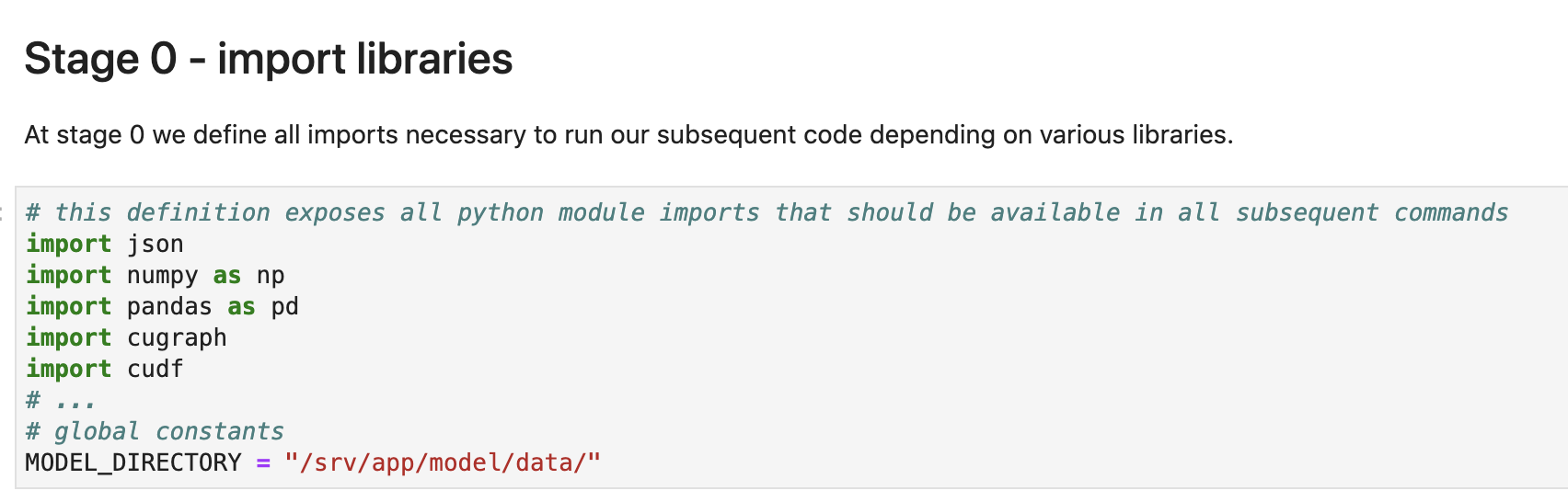

最初はライブラリーのインポートです。 cugraph がありますね。

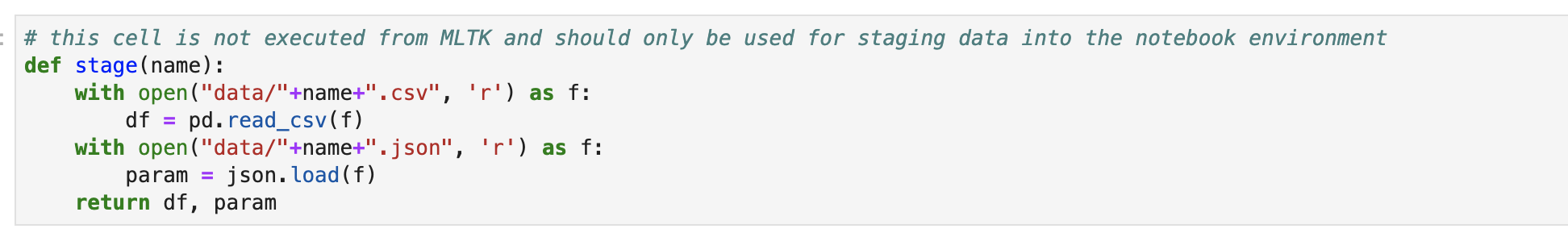

次にノートブック上でコード実行のため、サンプルデータを取り込みます。Splunk側で以下を実行してください。

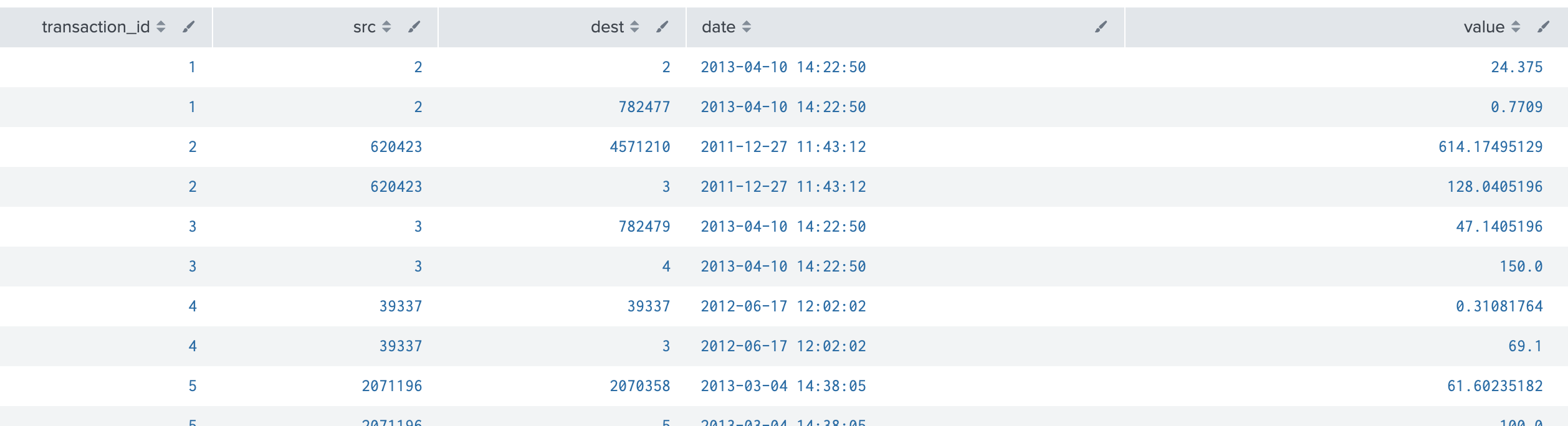

データの中身は、bitcoinのトランザクションログになります。

| inputlookup bitcoin_transactions.csv

| rename user_id_from as src user_id_to as dest

| fit MLTKContainer mode=stage algo=graph_algo_louvain from src dest into app:bitcoin_graph_louvain as graph

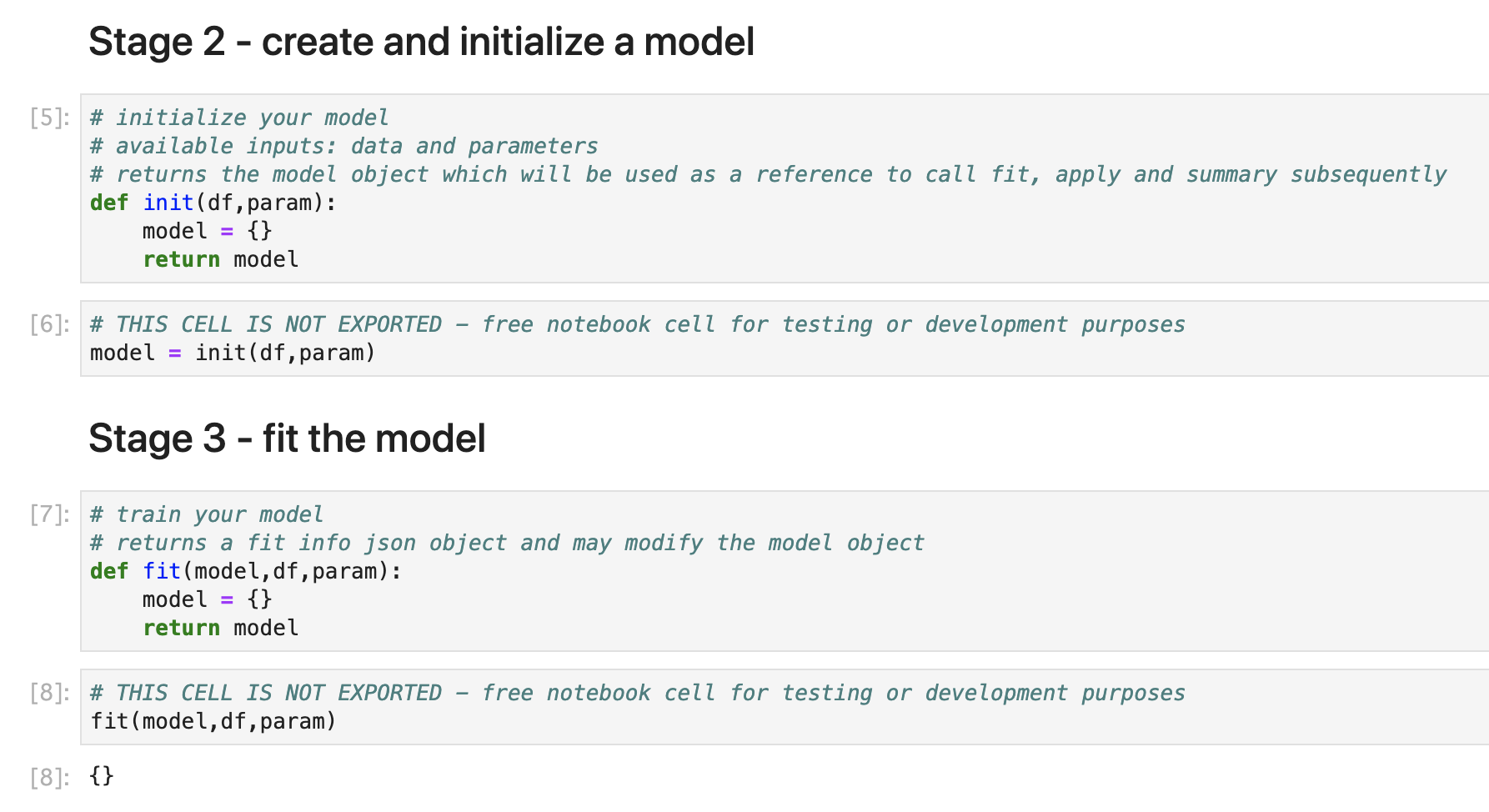

その後、初期化、fitとありますが、こちらは形式上のもので中身はなにもしてません。

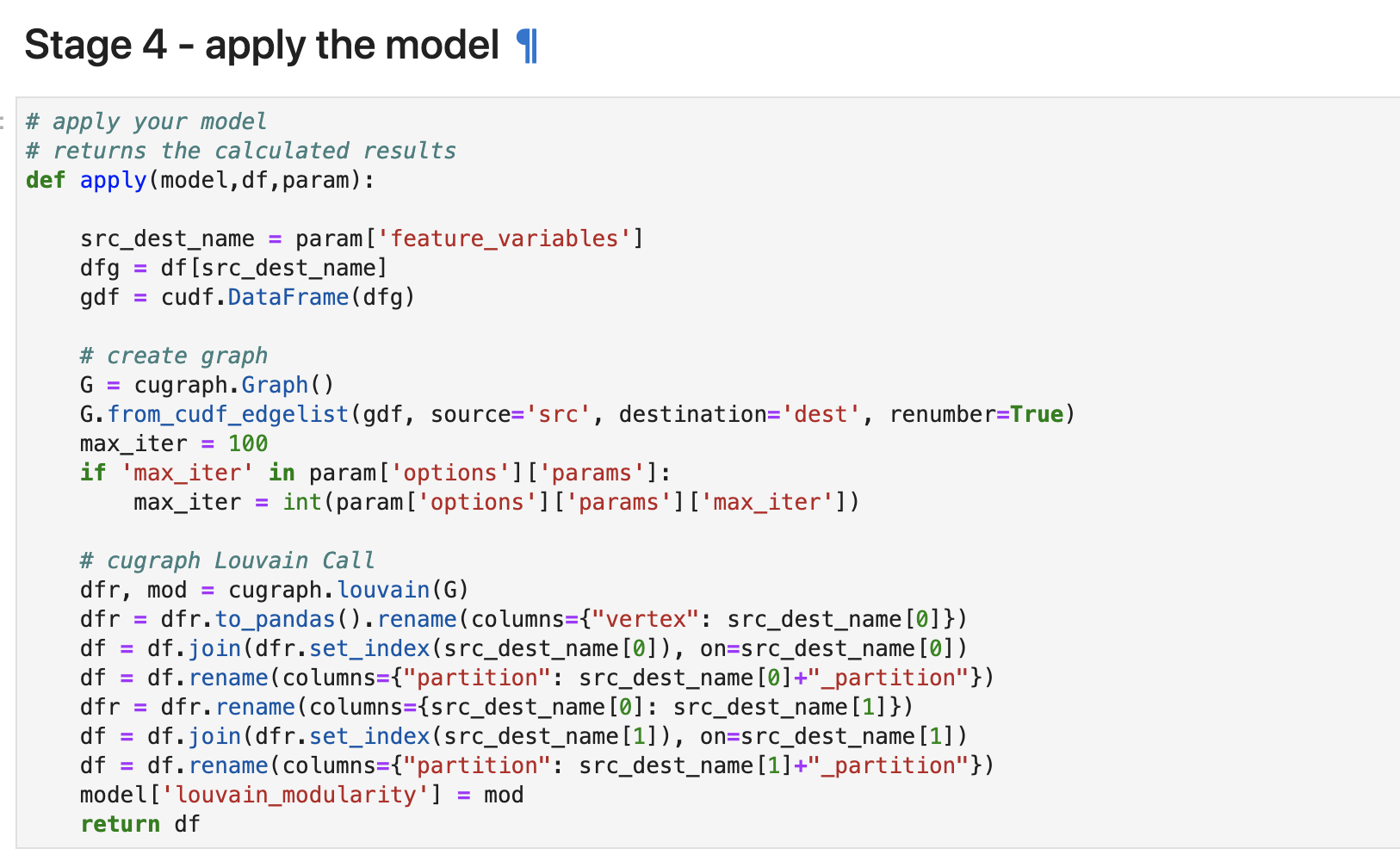

こちらがこのモデルの中身になります。

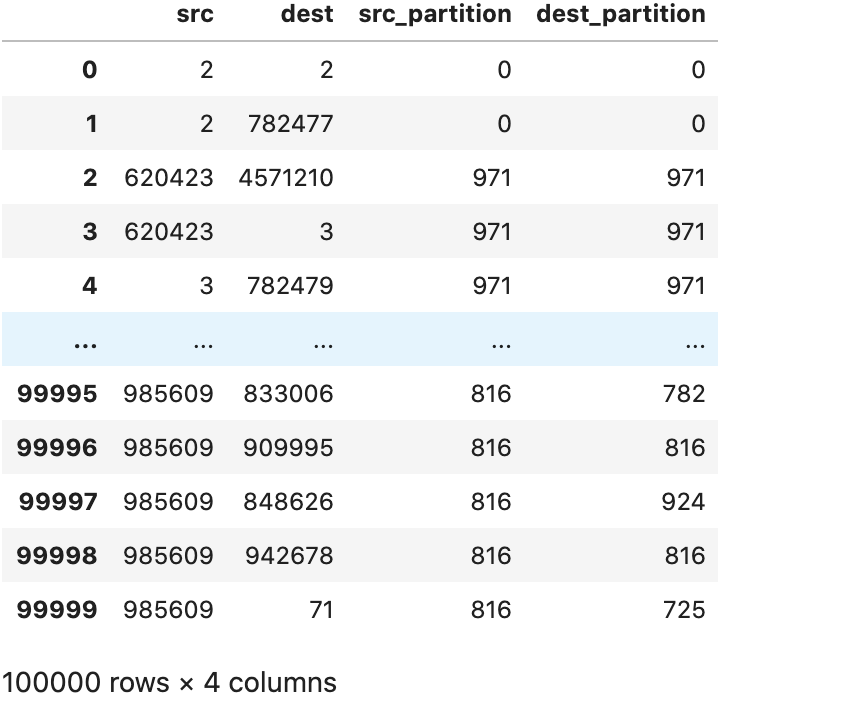

最初にグラフを作成して、その後に Louvainによってクラスタリングがされております。

partitionと書かれている部分が、Louvainによってクラスタリングされた際のラベルになります。

一度、これらの関数定義を実行しておけば完了です。

可視化してみよう。

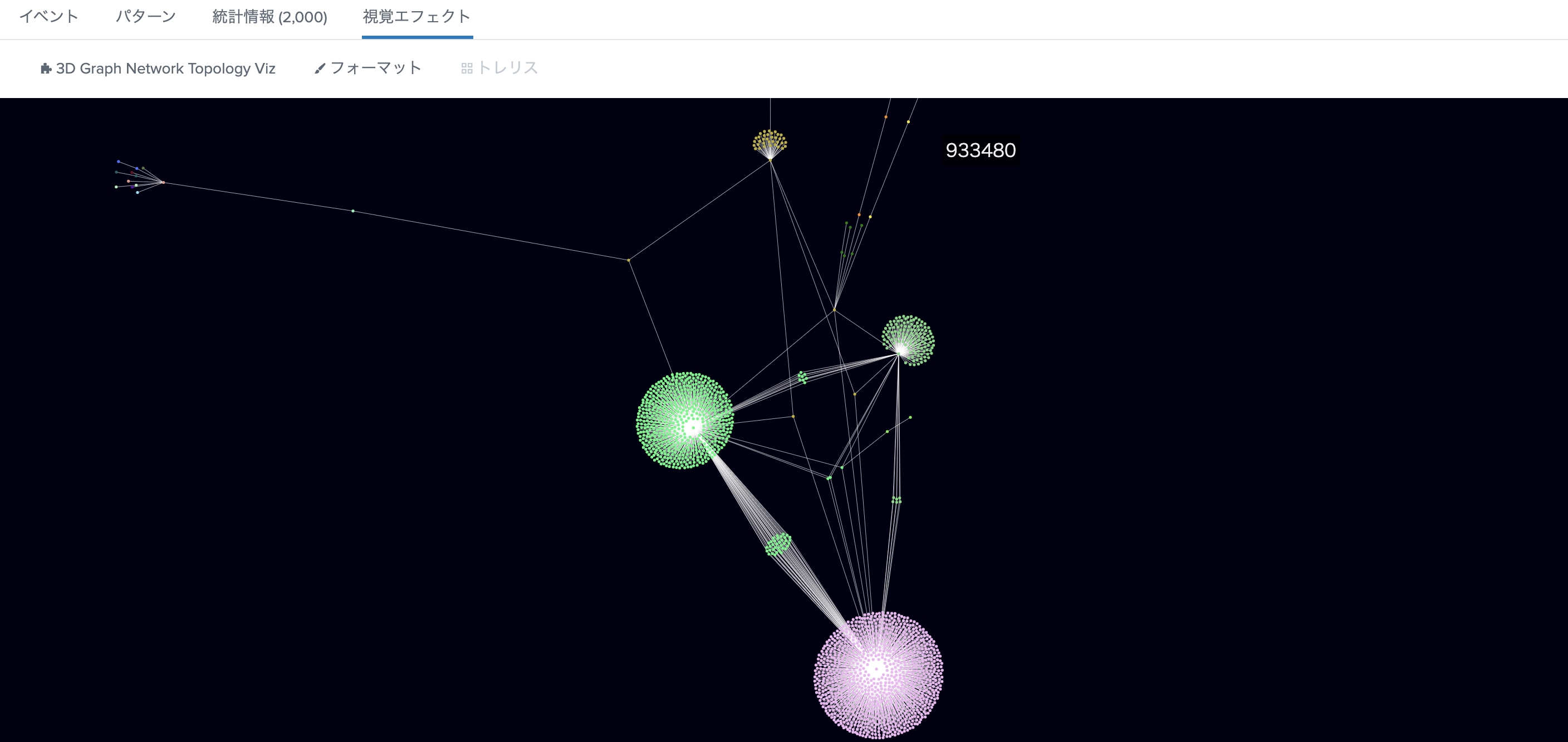

それでは、DLTKにあるサンプルダッシュボードを使って可視化してみます。

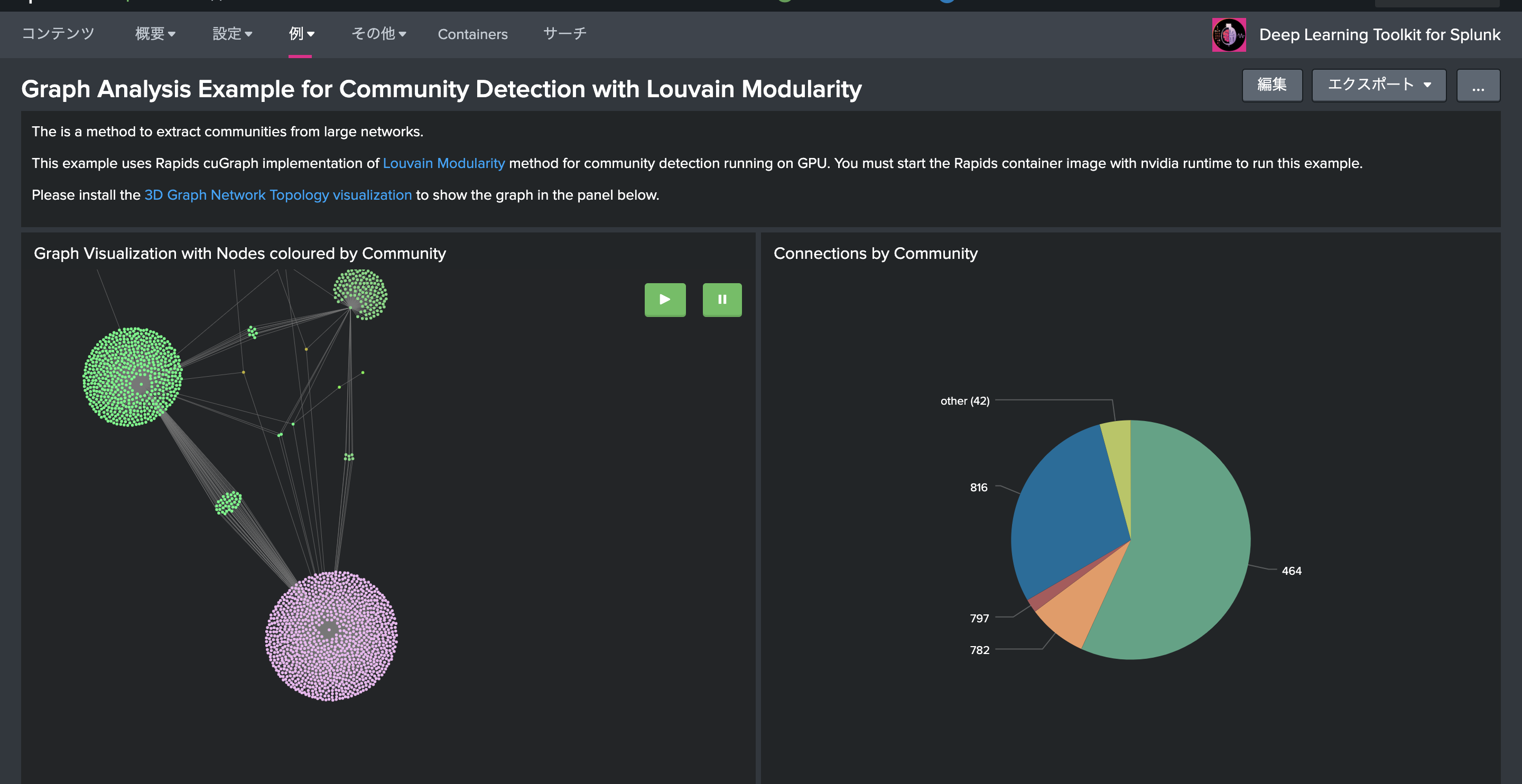

左にある、3D Graph Network Topologyを使った可視化ですが、クラスタリングされたパーティション(ラベル)ごとに色がついているのがわかります。

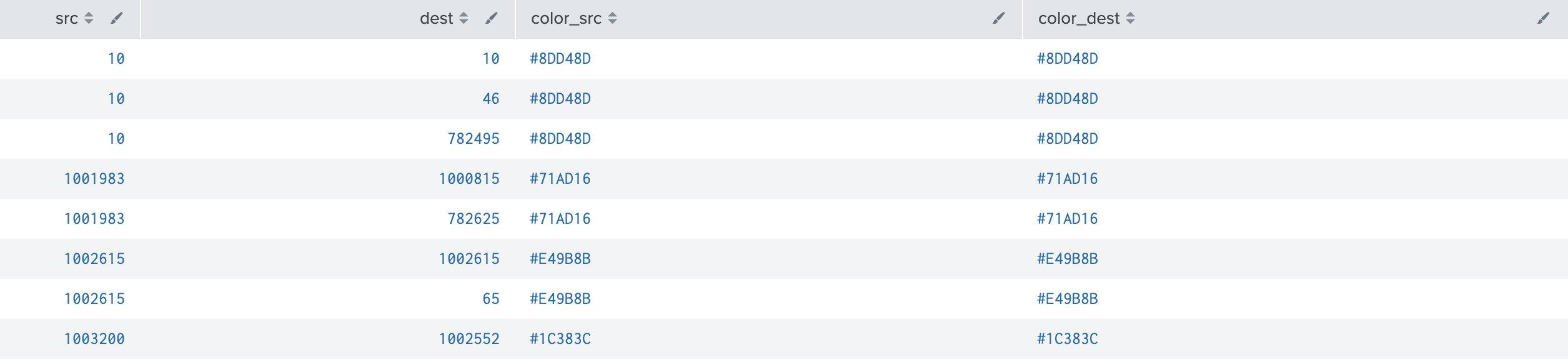

実際に、どのように色をつけているかみてみたいと思います。

| inputlookup bitcoin_transactions.csv

| rename user_id_from as src user_id_to as dest

| stats count by src dest

| fit MLTKContainer algo=graph_algo_louvain from src dest into app:bitcoin_graph_louvain as graph

| rename graph_src_partition as labeled_community

| table src dest count labeled_community

| head 2000 | eval color_src="#".upper(substr(md5(labeled_community),0,6))

| eval color_dest=color_src

| table src dest color_src color_dest

ポイントは2つです。

1つ目は、こちらで、対象のデータ(src,dest)を先ほど作成した graph_algo_louvain アルゴリズムに送りクラスタリング結果を返してもらいます。

fit MLTKContainer algo=graph_algo_louvain from src dest into app:bitcoin_graph_louvain as graph

2つ目はこちらで、3D Graph Network Topologyでは、色を指定しないといけないのですが、md5 のハッシュを使って、その先頭の6文字に"#"をつけて表示することで、以下のようにカラー分けしております。(賢い!)

eval color_src="#".upper(substr(md5(labeled_community),0,6))

視覚エフェクトで 3D Network Topologyを選択するとこのように見事に色分けされてます。

まとめ

これでグラフ図に対してもクラスタリングができ、しかも可視化まで行えるようになりました。

注意点としては、今回GPUを使っているので、クラスタリングまでは大量のデータでも計算はできますが、最後のNetwork Toplogyによる可視化では、Splunk SH側のリソースに依存するため、可視化の時にデータサイズを絞る必要があります。

でも面白いですね。