概要

この記事では、ECCV2022の量子化論文を紹介します。1

その1

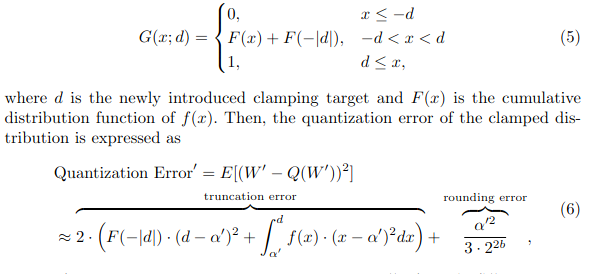

Symmetry Regularization and Saturating Nonlinearity for Robust Quantization

- 概要:量子化後のロバスト性を上げる方法2つ(SymReg, SatNL)の提案

- 新規性:量子化後のロバスト性を上げる方法でSOTA

- キモ:

- 評価:MobileNetV2等で実験した。3bit以下で効果あり。

おまけ:上の論文からの引用論文

Robust Quantization: One Model to Rule Them All

- 概要:KURE. ビット幅・量子化幅等のパラメータにロバストな量子化。2

- 学会:NeurIPS2020

- 研究機関:Intel

- 新規性:量子化では重みの分布は正規分布より一様分布が良いことを初めて理論的に証明した。

- キモ:重みの尖度(Kurt)が一様に近いことを制約に入れたロスを入れる。$\mathcal{K}_T$は一様分布の1.8とする。

- 評価:

ASAM: Adaptive Sharpness-Aware Minimization for Scale-Invariant Learning of Deep Neural Networks

- 概要:ASAM. (SAM)https://arxiv.org/abs/2010.01412の改良

- 学会:ICML2022

- 研究機関:Samsung

- 新規性:SAMの、パラメータのスケーリングに弱い課題を解決する。

- キモ:最適化ステップに正規化を入れる。

- 評価:画像や自然言語処理タスクでSAMと比較した。