概要

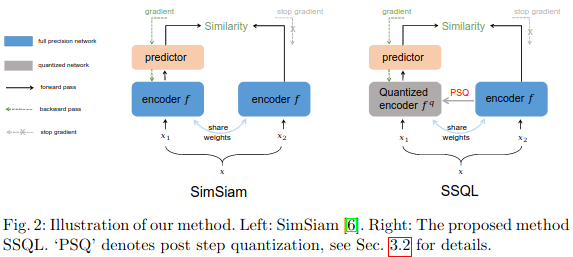

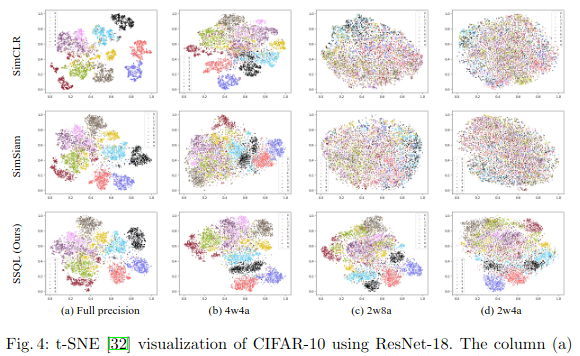

Synergistic Self-supervised and Quantization Learning

概要:SSQL. 量子化学習とSSL(自己教師有り学習)を組合せたもの。

新規性:量子化フレンドリーな特徴を学習し、下流タスクに適用できるようにした。

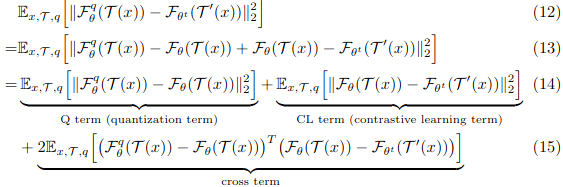

キモ:エンコーダ$f$と量子化したものとでロス計算する。

本ロスを小さくすれば、量子化ロスとSSLのロスを両方小さくできる。

評価:ResNet-18等で実験した。

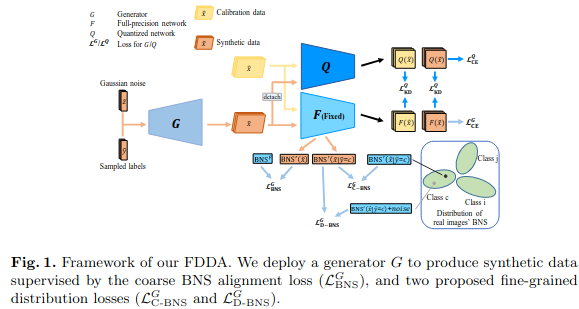

Fine-grained Data Distribution Alignment for Post-Training Quantization

概要:FDDA. ゼロショット(データを使わない)量子化の方法。

新規性:合成データを使うゼロショット量子化で、低ビットでも精度を落とさない。

キモ:BN統計量の近さ、ばらつきに着目したこのようなロスでデータ合成し、クラス間の類似性やクラス内の多様性も表現できるようにする。

- $\mathcal{L}_{BNS}^G $ はBN統計量を合わせるロス。

- $\mathcal{L}_{D-BNS}^G$は、同じクラス内でもばらつきをもたせるロス。

- $\mathcal{L}_{C-BNS}^G$は、同じクラス間で近づけるロス。

評価:ResNet-18, MobileNet等に適用した。

Patch Similarity Aware Data-Free Quantization for Vision Transformers

概要:PSAQ-ViT. Vision Transformerへのデータ無し量子化適用。

新規性:従来のデータ無し量子化は、キャリブレーション用データ生成がBN統計量ベースだったが、BNのないViTでも適用できるようにした。

キモ:TransformerはMulti Head Attentionで前景パッチにattentionが当たりやすい観察から、パッチ間の類似性が入力データの特徴として使えるという仮説を見出し、ロス$\mathcal{L}_{PSE}$を最適化するとうまいキャリブレーション画像が作られるようにした。

評価:ViT, DeiT, Swin-Transformerで実験した。

-

画像や数式は論文から引用しています。 ↩