概要

この記事では、CVPR2022の量子化論文を紹介します。1

その1

It's All In the Teacher: Zero-Shot Quantization Brought Closer to the Teacher

(CVPR2022 Oral)

概要:AIT. Zero-shot Quantization (教師画像不要の量子化)

研究機関:NAVER

新規性:複数のロスの和を考えなくてよく汎化性の高い方法を提案した。

キモ:ロスをKL Divergenceのロスの1つだけで表す。KL Divergenceは汎化性能が高い。

評価:CIFAR, ImageNet, ResNet, MobileNetV2で実験した。

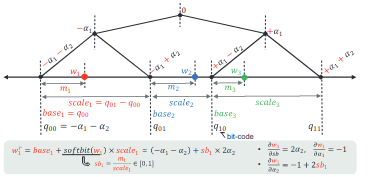

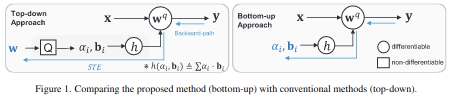

Mr.BiQ: Post-Training Non-Uniform Quantization based on Minimizing the Reconstruction Error

概要:Mr. BiQ. 非一様(マルチレベル量子化)のPTQ

マルチレベル量子化とは、$\alpha_i$を量子化の深さによって変える。

研究機関:Samsung

新規性:マルチレベル量子化で、量子化パラメータを学習可能にした。

キモ:量子化パラメータを学習する。

評価:ResNet等で実験した。

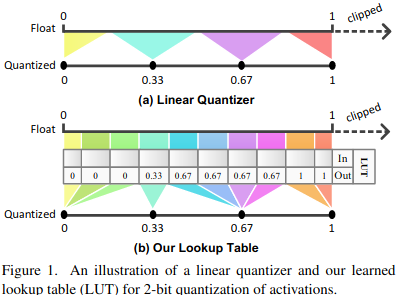

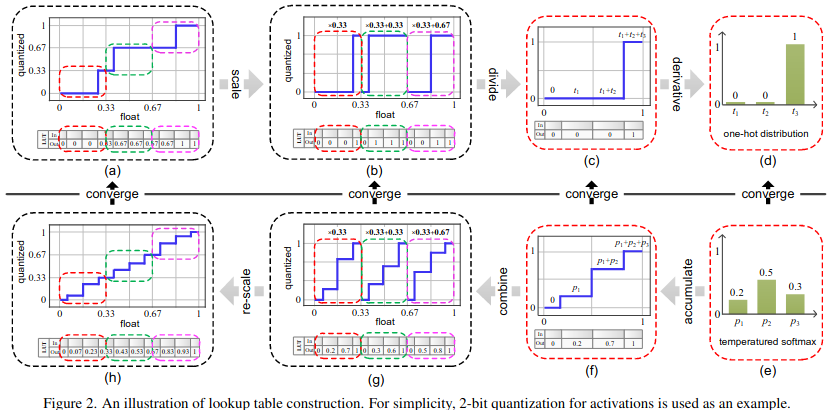

Learnable Lookup Table for Neural Network Quantization

概要:Look Up Table (LUT) による非線形量子化

新規性:LUTを学習可能にした。

キモ:Fig. 2のように量子化をステップ関数の和で表し微分可能にする。

評価:ResNet, VGGで従来の量子化と比較した。

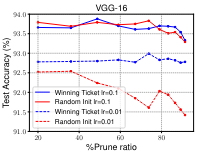

(おまけ・ICLR2019) Rethinking the Value of Network Pruning

概要:枝刈り後のFine tuningの必要性について調査した。

新規性:枝刈り後の学習の初期値は、枝刈り前の重みでも、ランダム重みでも変わらないことを実証した。

キモ:VGG, ResNet, DenseNet, CIFAR, ImageNetで実験した。ランダム重みの方が精度が良いこともある。

評価:宝くじ仮説でも見てみたけど、学習率が大きいと当たりくじでもランダム初期値でも変わらなかった。

-

画像や数式は論文から引用しています。 ↩