この記事について

日本ディープラーニング協会(JDLA)の初学者向けAI講座を個人的にまとめたメモです。

受講は無料のため、このまとめ記事で興味を持ったらぜひ本家の講座を受講してみてください。

・AI For Everyone (すべての人のためのAIリテラシー講座) | Coursera

AIの現実

AIと3匹のくま

『3匹のくま』という童話がある

同様に、AIもできること/できないことに対して楽観的にも悲観的にもなりすぎないことが重要

・楽観的すぎる:AIが意識を持つ/非常に賢いAI殺人ロボットがもうすぐ登場する

・悲観的すぎる:AIはすべてを行うことができず、AIの冬が到来する

・丁度いい:AIはすべてを行うことはできないが、産業と社会を変革する

AIの限界

・性能の限界

・説明可能性の難しさ(うまく機能する場合も含む)

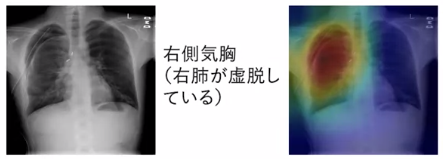

例:AIが画像診断で右側肺気胸と判断したが、その根拠がわからない

→ヒートマップでAIがどの部分を重点的に見ているか等の解決策もある

実は、人間も同様に「どうやって意思決定するか?」を説明するのは得意ではない

例:マグカップを見た時に、どうやってそれが「マグカップ」だとわかるのか?

逆に、人間が解決方法を見つける必要がある場合に、AIの説明能力が役立つことも考えられる

したがって、説明可能性は研究の余地が大きな分野の一つ

説明可能性は難しいが不可能ではない

→AIシステムが自分で説明できる優れたツールが必要

・偏ったデータによるAIの偏見

データの偏りによって差別的なバイアスを学習してしまう恐れがある

・AIの攻撃的手法

AIシステムを故意に騙そうとする誰かがいる場合、一部のAIシステムは敵対的攻撃に対して脆弱

用途によっては脆弱性の確認と対策が重要となる

差別/バイアス(偏見)

AIシステムはどのようにしてバイアスを持ち、それによってどのように一部の人々を差別するのか?

また、AIシステムの偏見をどのように低減/排除するのか?

AIによる有害なステレオタイプの学習

・Microsoftの研究結果の例

AIがインターネット上のテキストから学習すると、有害なステレオタイプを学習してしまう

Microsoftの功績として、こういったバイアスの量をAIシステム上で減らすための技術的な解決策を提案した

-

AIにインターネット上の文字を読み取らせて単語について学習させ、類似性について推論させる

-

AIシステムにクイズを出す

-

「男性」:「女性」なら、「父親」:?

-

すると、AIは「母親」という単語を出力する

これは、これらの単語の"インターネットでの典型的な用法"を反映している

同様に、「王」に対しては「女王」と出力する

ところが、

「コンピュータープログラマー」:「男性」なら、何:「女性」?

との問いに対し同じAIが出力した答えは「家事従事者」だった

男性と女性が等しく家事従事者にもコンピュータープログラマーになれることをAIシステムに理解させたい場合は、↓のように出力させたいことになる

「コンピュータープログラマー」:「男性」、「コンピュータープログラマー」:「女性」

「家事従事者」:「男性」、「家事従事者」:「女性」

AIシステムはどのように学習してこのようなバイアスがかかった状態になるのか?

AIシステムは数字のセットを使用して単語を保存している

例:「男性」という単語が2つの数字(1,1)として格納されている

AIシステムが数値を算出する方法は、インターネット上での「男性」という単語の用法の統計データを介している

これらの数字は言葉の"典型的な用法"を表している

この数値を使ってグラフにプロットする

「男性」という単語を右の図の位置(1,1)にプロット

同様に、「コンピュータープログラマー」は(3,2)、「女性」は(2,3)に格納される

AIシステムに上記の類推を計算させると、平行四辺形を作る

つまり、位置(4,4)に関連付けられている単語は何か考える → それがこの類推の答え

数学的に考えると、「コンピュータープログラマー」に対する「男性」の関係は、「男性」という言葉から右に2目盛、上に1目盛進む、ということ

何に対しての「女性」か?という問いの場合、同様に右に2目盛、上に1目盛進む

残念ながらインターネット上のテキストから導き出された場合、「家事従事者」が(4,4)に配置される

これが、AIシステムがバイアスに基づいた類似性を導き出す理由

なぜバイアスが重要な問題であるのか

女性に対して差別的な雇用AI

例:雇用にAIを使用している企業があり、そのAIが女性に対して差別的であることがわかったためツールを廃止した

肌の色が濃い人よりも肌の色が明るい人の方が正確に動作する顔認識システム

肌の色の濃さによって動作の正確性が変わると思われる顔認識システムがある

AIシステムが主に、明るい色の肌の人々のデータに基づいて訓練されている場合に起こり得る

例:犯罪捜査で肌の色の濃い人々に対し、バイアスのかかった不公平な影響を生む

今日、多くの顔認識チームはAIシステムがこのようなバイアスを示さないように取り組んでいる

統計的ローン承認システム

例:統計的ローン承認システムAIが、一部の少数民族グループに対して差別してしまい、より高い金利を提示してしまった

銀行は、承認システムにおけるこのようなバイアスの減少・解消に取り組んでいる

有害な先入観を強化してしまう毒性作用

AIシステムが悪意のあるステレオタイプを強化してしまうという毒性作用 に寄与しないことが重要

例:8歳の少女が画像検索エンジンで「最高経営責任者」を検索した時に、男性の写真しか表示されなかったり、性別・民族等の点で自分と同じような人がいない場合、大企業の最高経営責任者になるようなキャリアを少女に思いとどまらせてしまうかもしれない

バイアスの対処

技術的な解決策

例:バイアスに対応する数値をゼロに設定する

あるAIシステムが単語を格納するための沢山の数字を学習するとき、バイアスに対応する数字が少ないことを発見した

これらの数値をゼロに設定するだけでバイアスは大幅に減少する

別の解決策としては、よりバイアスが少なくインクルーシヴなデータを使用する

例:顔認識システムの構築時に、複数の民族やすべての性別のデータを必ず含めるようにする

→ システムのバイアスが少なくなり、インクルーシヴさが高まる

システムの透明性や監査プロセス

多くのAIチームはシステムの透明性や監査プロセスを改善しているため、AIシステムにバイアスがある場合、どんなバイアスを示しているか常に確認できる

少なくとも、問題が存在した場合に認識することができるため対処ができる

例:多くの顔認識チームは人口の様々なサブセットでAIシステムの正確性を体系的にチェックしている

→ 濃い色の肌の人と明るい色の肌の人を比べた時に正確さが同じかどうか?

透過的なシステムと体系的な監査プロセスがあると、問題発生時に少なくとも迅速に問題を特定できる可能性が高くなり、修正がしやすくなる

多様な労働力

多様な労働力を持つこともバイアスを減らすのに役立つ

従業員に多様性があると、個々人が様々な問題を発見できる可能性が高くなり、データがより多様でインクルーシヴなものになる

→ バイアスの少ないアプリケーションを作る