この記事の目的

-

こちらの記事で非線形2層パーセプトロンについて書いた

-

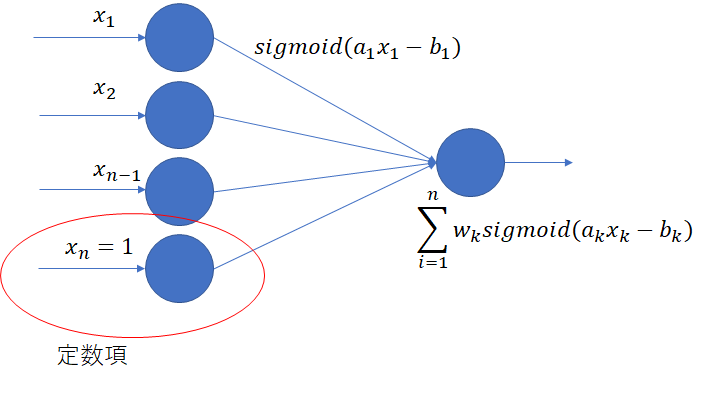

2層パーセプトロンにおいてシグモイド関数のゲインと切片の両方を学習するとどうなるかを実験してみる

- すなわちsigmoid(ax-b)= 1/(1+exp(-ax+b))のaを前回は学習したがbも学習する

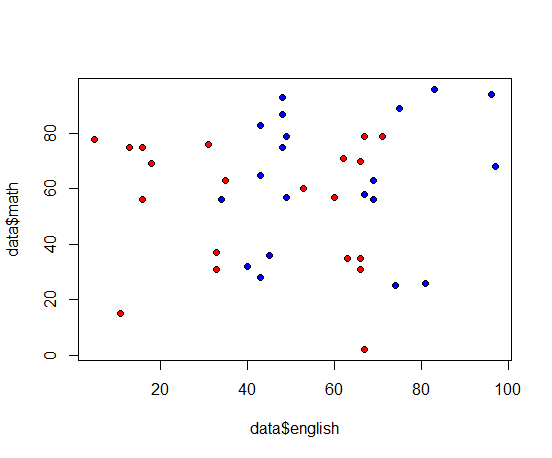

実験データ

学習方法

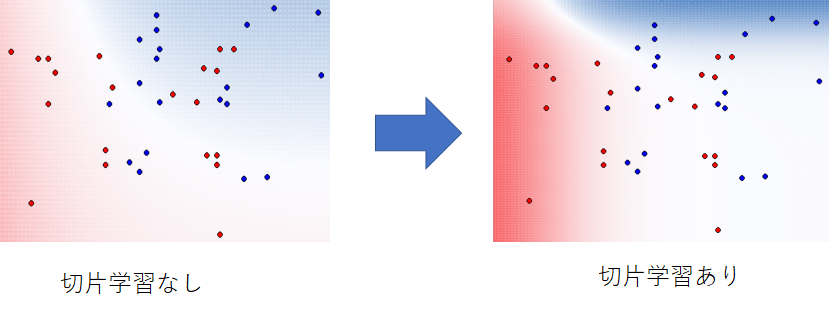

実験結果

-

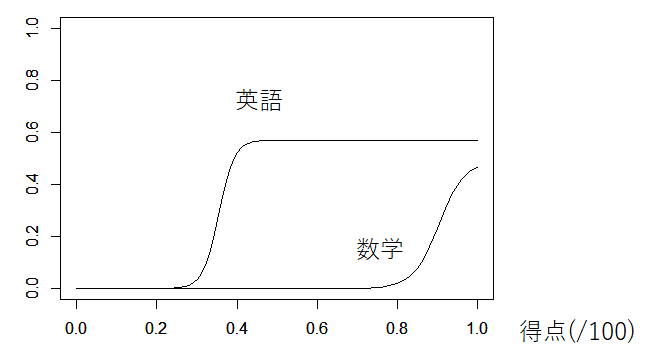

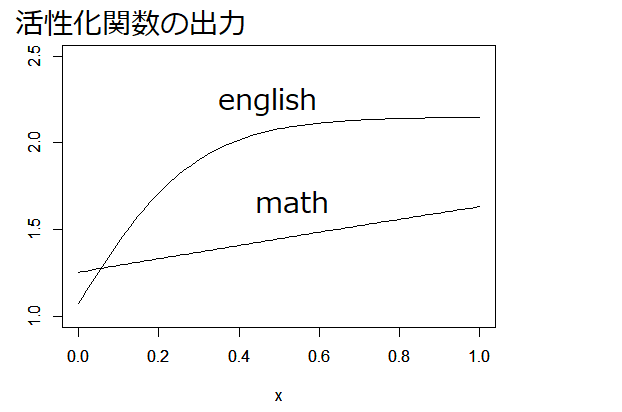

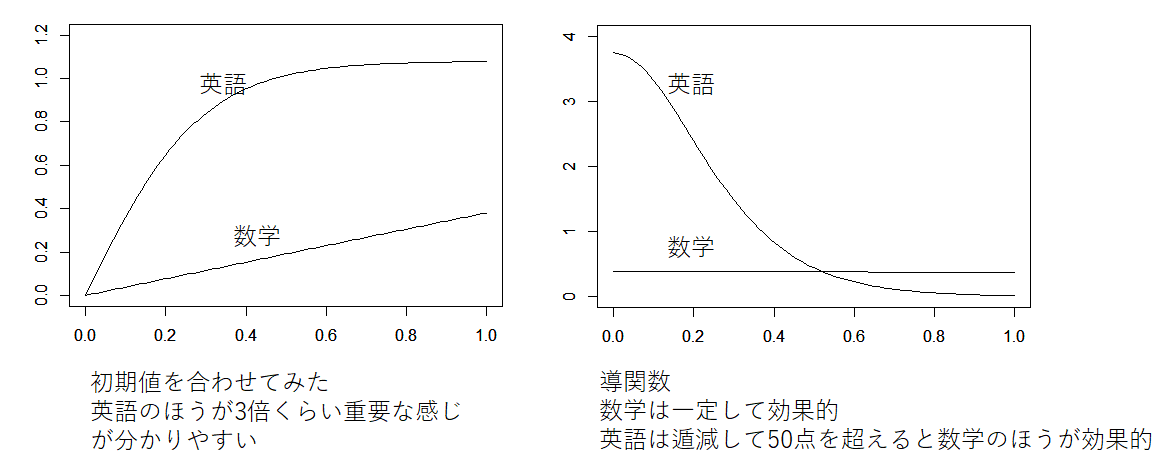

英語と数学のシグモイド関数の出力

-

- 数学は80点ぐらいまでは影響なしで、80点から急激に上昇

-

二乗誤差7.86 -> 7.16

-

二乗誤差は減ったが過学習してしまった感

-

確かにデータの感じはよくとらえているが今回の目的(大学の合格可能性を基に示唆を与えるような目的)にはそぐわないか

- 一番下の不合格のサンプルを無視すれば、確かに数学の点が上がっても合格率はそんなに変わらないので、このデータからはこうなるとは思う

- 一方で、事前知識として数学が20点までで合格はしないということが分かっていれば、bを学習しないほうがより、実態に即している。

結論

- bを学習することで二乗誤差が減り、よりデータにフィットした判別が可能

- 問題(データや目的)によってbは学習すべきときとそうでないときがある