はじめに

日本語文章でBOWをするためにCountvectorizerを試していたのですが、どうもfitした単語とtransformしたあとのカラム(get_feature_names()で獲得が可能)が一致せず、fitに利用した単語が一部消えていることが判明しました。解決策を知らず、検索もなかなか時間がかかったため、まとめたいと思います。

環境

- python3.8

- Docker

- docker_image : Datascience notebook

- Jupyter Lab / jupyter notebook

追記

from sklearn.feature_extraction.text import CountVectorizer

vectorizer = CountVectorizer(tokenizer=lambda txt: txt.split())

こちらが一番良かったです。正規表現は「......」のようなものが消えてしまいました。

問題

import pandas as pd

from sklearn.feature_extraction.text import CountVectorizer

import numpy as np

# ベクトル化する文字列

sample = np.array(['今日 晴れ 明日 曇'])

# CountVectorizer

vec_count = CountVectorizer()

# ベクトル化

vec_count.fit(sample)

X = vec_count.transform(np.array(["今日 雨 明日 雨 会社 電車 晴れ 会社 歩く"]))

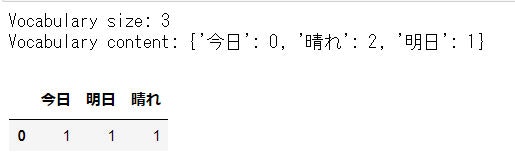

print('Vocabulary size: {}'.format(len(vec_count.vocabulary_)))

print('Vocabulary content: {}'.format(vec_count.vocabulary_))

pd.DataFrame(X.toarray(), columns=vec_count.get_feature_names())

本来であれば「雲」という単語もカラムになってほしいが、なぜか府用語とされてしまう。

調べてみると、すべての単一文字トークンは、デフォルトのトークナイザによって無視されるとのこと

英語が前提でできているため、「a」などは削除されるようにできているらしい。詳しくはこちらの記事を見ていただきたい。

解決策

こちらの記事を参考にしたところ解決した。

やったこととしては、Countvectorizer(token_pattern='(?u)\\b\\w+\\b')としただけ

import pandas as pd

from sklearn.feature_extraction.text import CountVectorizer

import numpy as np

# ベクトル化する文字列

sample = np.array(['今日 晴れ 明日 曇'])

# CountVectorizer

vec_count = CountVectorizer(token_pattern='(?u)\\b\\w+\\b')

# ベクトル化

vec_count.fit(sample)

X = vec_count.transform(np.array(["今日 雨 明日 雨 会社 電車 晴れ 会社 歩く"]))

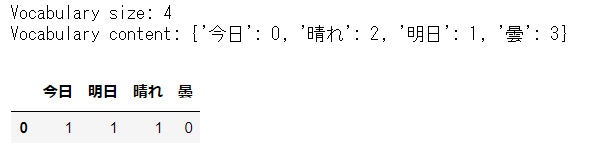

print('Vocabulary size: {}'.format(len(vec_count.vocabulary_)))

print('Vocabulary content: {}'.format(vec_count.vocabulary_))

pd.DataFrame(X.toarray(), columns=vec_count.get_feature_names())

うまくいきました!

余談

1つ目の記事には単一の文字トークンを語彙に含めたい場合は、衣装トークナイザーを使用する必要があります。

vectorizer = CountVectorizer(tokenizer=lambda txt: txt.split())

とあり、こちらで解決したのですが、別の状態(入力が単純なnumpy配列じゃない?)のときにうまくいかず、すべてのカラムに1以上の値が割り当てられているという謎の現象が起きました。こちらについては現在調査中ですので、わかり次第追記したいと思います。

今回のサンプルコードであれば問題なく動いています。

import pandas as pd

from sklearn.feature_extraction.text import CountVectorizer

import numpy as np

# ベクトル化する文字列

sample = np.array(['今日 晴れ 明日 曇'])

# CountVectorizer

vec_count = CountVectorizer(tokenizer= lambda sample: sample.split())

# ベクトル化

vec_count.fit(sample)

X = vec_count.transform(np.array(["今日 雨 明日 雨 会社 電車 晴れ 会社 歩く"]))

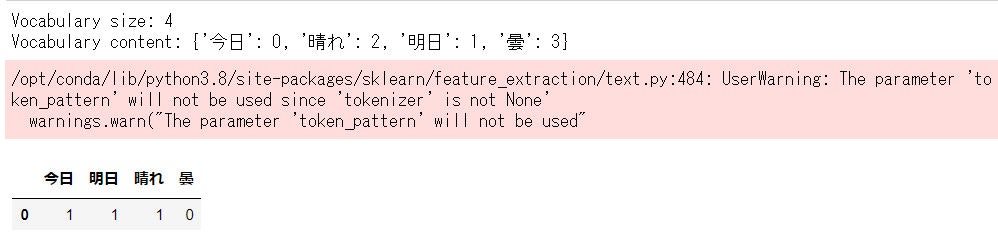

print('Vocabulary size: {}'.format(len(vec_count.vocabulary_)))

print('Vocabulary content: {}'.format(vec_count.vocabulary_))

pd.DataFrame(X.toarray(), columns=vec_count.get_feature_names())

Warningはでていますが、1文字の単語も機能しています。

最後に

日本語文章をCountvectorizerすると疎のベクトルになりやすいので、やはり扱いは難しいなと感じました。1文字が消えてしまう問題に気付かないで行ってしまう人もいそうですね (私も今になって気づきました)