はじめに

Dataikuは"Everyday AI, Extraordinary People"というテーマの元に、従来のデータ分析に加えてAIエージェントの開発と活用にも力を入れております。

そんな中、FDUA主催の「第4回金融データ活用チャレンジ」に、例年同様今年もツール提供させて頂く事となりました。

本記事は、コンペティションにご参加頂くための手順を分かりやすくご案内する目的で記述しております。

この記事でわかる・できること

- コンペ参加の手順

- Dataikuご利用の準備

- コンペ推進・提出までの流れ(例として解法に触れない範囲で)

この記事の対象者

- 本コンペに参加する全ての方(初めての方を含む)

- Dataikuにご興味のある方

- 生成AI・AIエージェントをご活用されたい方

目次

1.コンペ参加の手順

1.1 SIGNATEのコンペページから参加登録

上記ページのリンクから、参加ボタン(SIGNATEに登録済みの場合)を押下する事でコンペの参加が可能です。

- SIGNATEのユーザー登録が必要な方は右上の「ログイン」から、案内に沿って登録・ログインを実施して下さい

- その後コンペの参加登録に再度ユーザー情報の登録が必要となります

1.2 コンペ情報の把握とデータダウンロード

コンペ登録後の画面にて、説明タブからコンペの概要を把握した上で、「データ」タブから各種データをダウンロードします

- slack_invitation_link.txtを開きいずれかのリンクURLを利用してSlackチャネルへ参加

- 今回も参加者向けのコミュニティとしてSlackチャネルが用意されております - securities_report.zipとverification_process_report.zipの解凍と各種CSVファイルの確認

- データの説明はSIGNATE画面の「説明」にて確認できます

1.3 Slackチャネルの参加と内容の確認

今回もDataikuは勿論のこと各社様より分析ツールや生成AIのAPIが提供されております。

それらの利用申請はslack_invitation_link.txt内のリンクから参加できるSlackチャネルから実施頂けますので、こちらのSlackの情報を確認して下さい

是非「22-申請-dataiku」でツール申請頂き、疑問点は「12-qa-dataiku」のチャネルに遠慮なく投稿して下さい!

コミュニティとして皆様と一緒に学び、盛り上げていくチャネルにしたいと思っております。

2.Dataiku利用の準備

2.1 利用申請フォームの記入

Dataikuをご利用頂く事で"コンペの推進がより簡単かつスムーズに"実施頂けます。

ご利用に当たっての情報登録をお願いしておりますので、お手数ですが以下のフォーム登録をお願いします。

2.2 クラウド利用登録 or (製品インストール)

Dataikuでは本コンペ向けにクラウド形式の「無料トライアル版」をご案内しております。14日の期限後もご自身でボタンを押す事で延長可能で、コンペ完了までご利用頂けますので是非ご活用下さいませ。

場合によってはインストール版も用意がございます。

以下のページよりクラウド登録をお願いします。

・dataikuのご利用が初めてでアカウント登録がまだの方は「サインアップ」を押してご登録をお願いします

・過去にdataikuをご利用頂いており、環境期限が切れてしまっている方はSlackの「12-qa-dataiku」チャネルにてお問い合わせ下さいませ

3.dataiku環境の設定

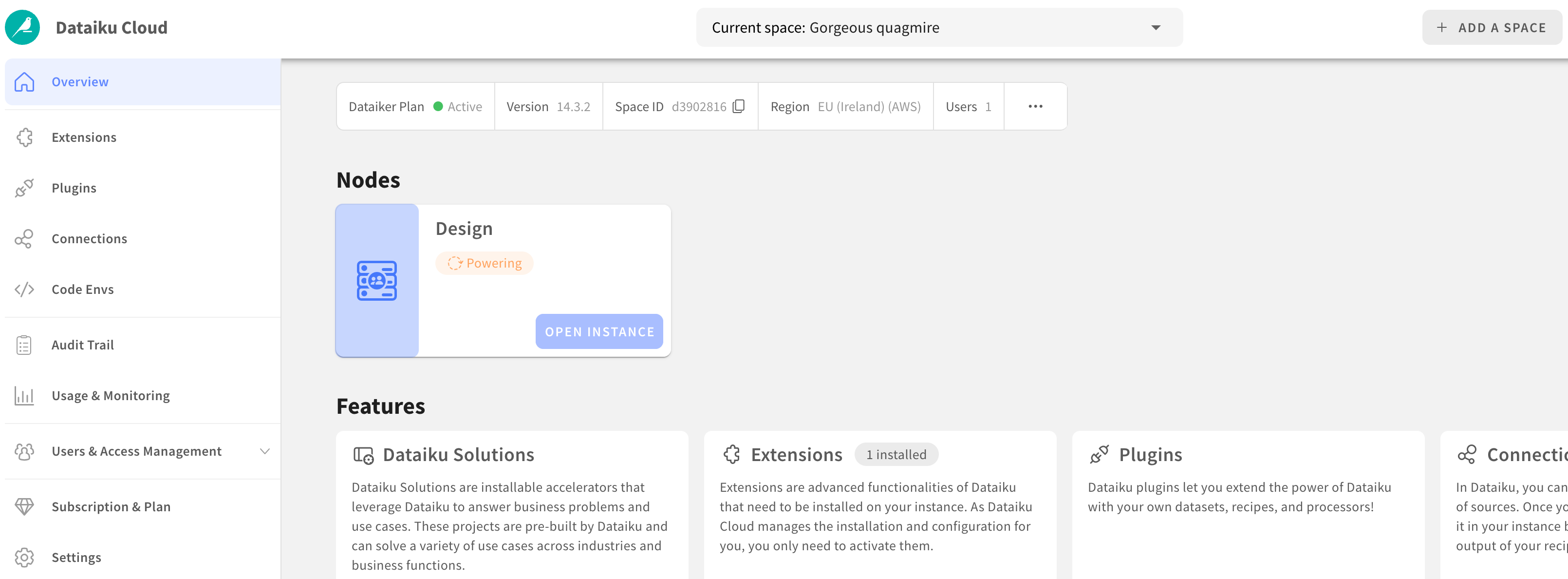

3.1 Dataiku Cloudコンソール

登録を完了の上、案内に沿って進めて頂くと以下のクラウド管理画面が表示されるかと存じます(クラウド版の場合)

-

「Nodes」の中のDesignノードの「OPEN INSTANCE」を押下して頂くとDataiku環境がそのままブラウザで開き準備完了です!

-

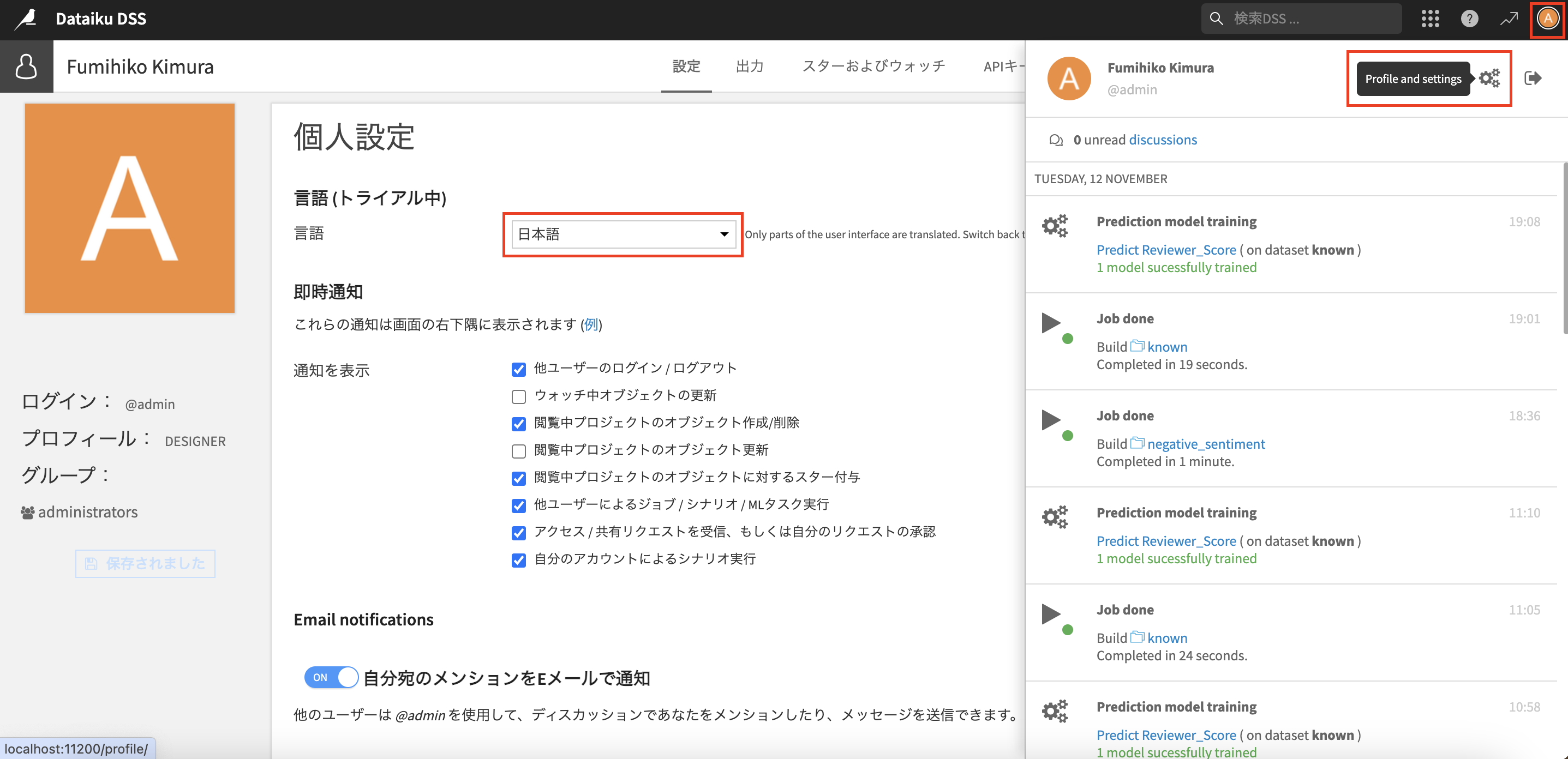

ログイン後に、右上のプロファイルの設定から言語を日本語に変更しておきましょう。

こちらでDataikuの利用が可能になりました!

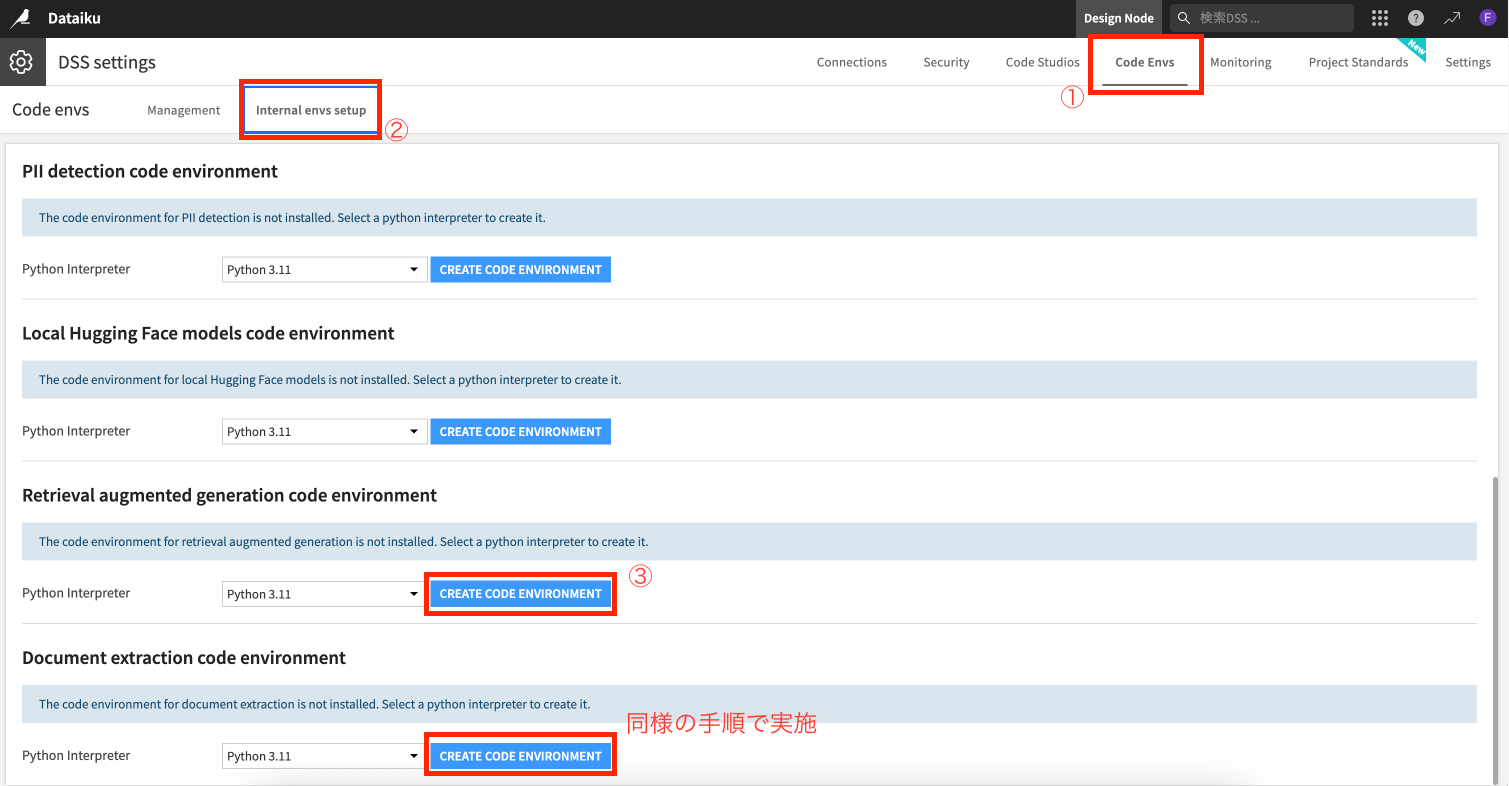

3.2 Pythonパッケージの事前インストール

Dataikuでは分析に必要なパッケージを簡単にGUI上でインストールできる様にしております

今回は、「RAGの作成」や「ドキュメントのテキスト化」に必要なパッケージをインストールしておきましょう。

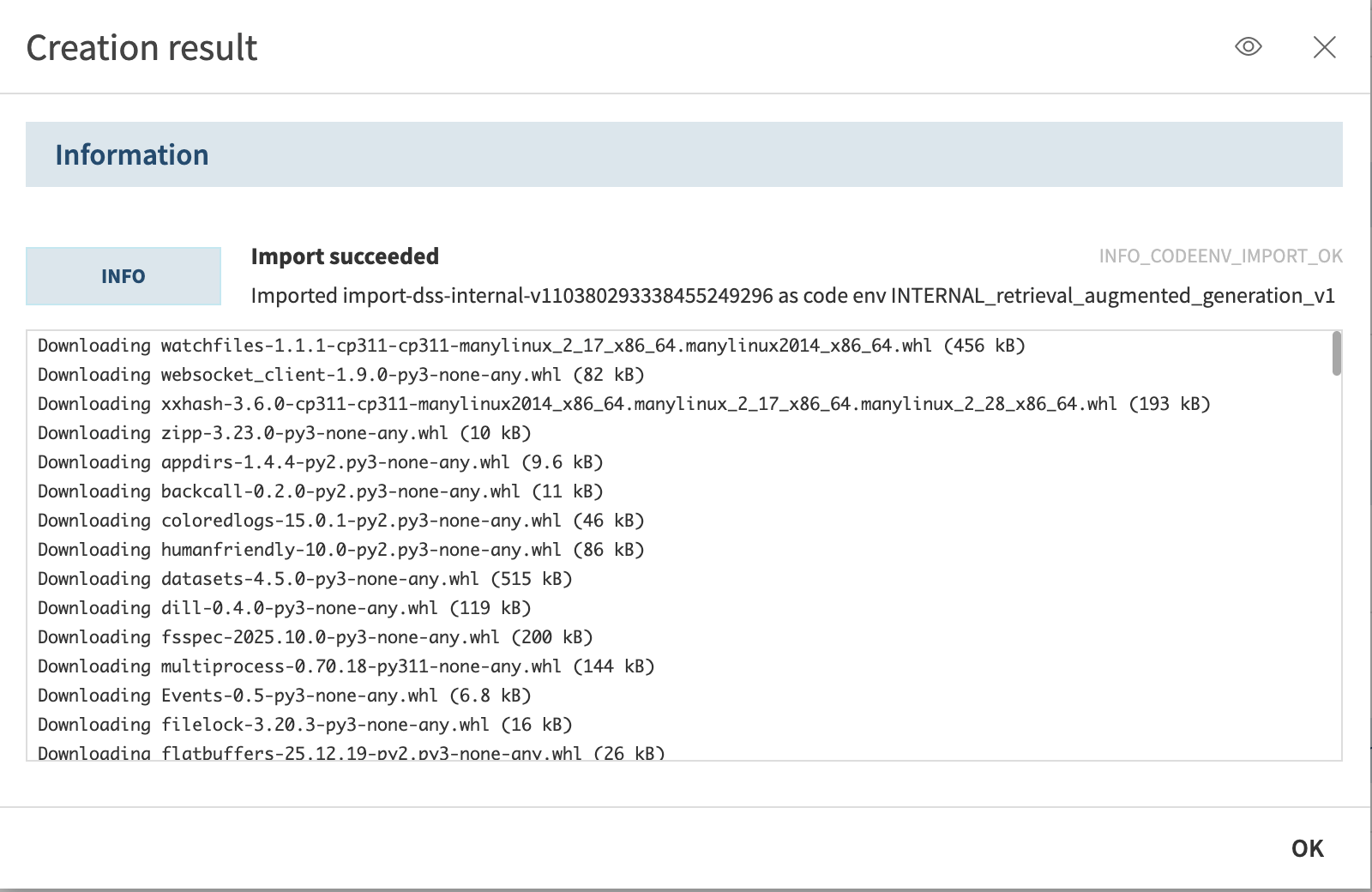

-

「Code Envs」タブをクリックし「Internal envs setup」ボタンを選択し、「Retrieval augmented generation code environment」をクリック

※処理内容で要否は変わりますが、「Document extraction code environment」も同様の手順でインストールして下さい

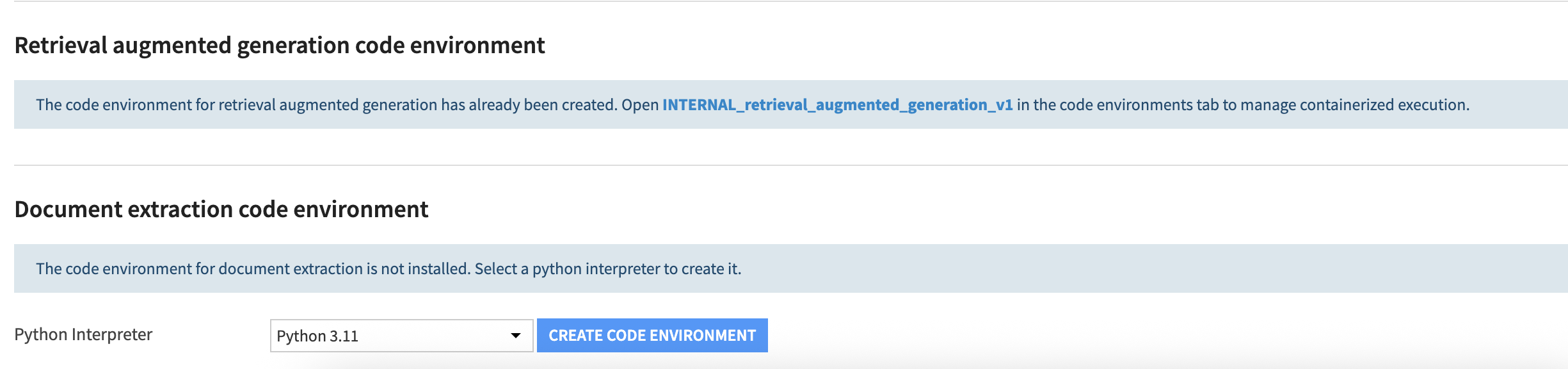

-

以下の表示になると思いますので、「Document extraction code environment」もインストールして下さい

こちらでパッケージのインストールも完了です!

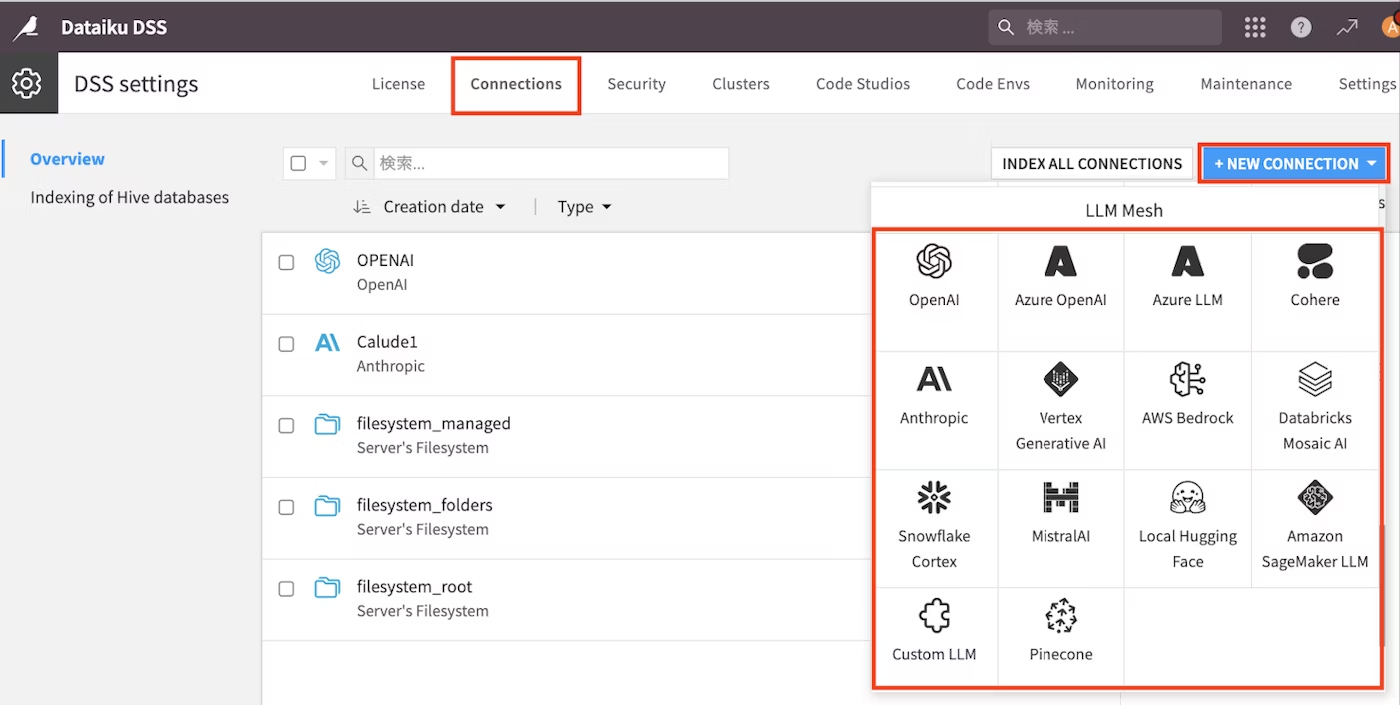

3.3 生成AIのAPI接続設定

生成AIのAPIは今回もMicrosoft様から提供されております。

SIGNATEのコンペページ上のMicrosoft様の申請ページからフォームを記載頂いて数日待つとAPIの情報がメールで送られます。

上記の申請が完了している or 自前でAPIを用意している前提で、Azure OpenAIを例として接続設定の手順を記載します。

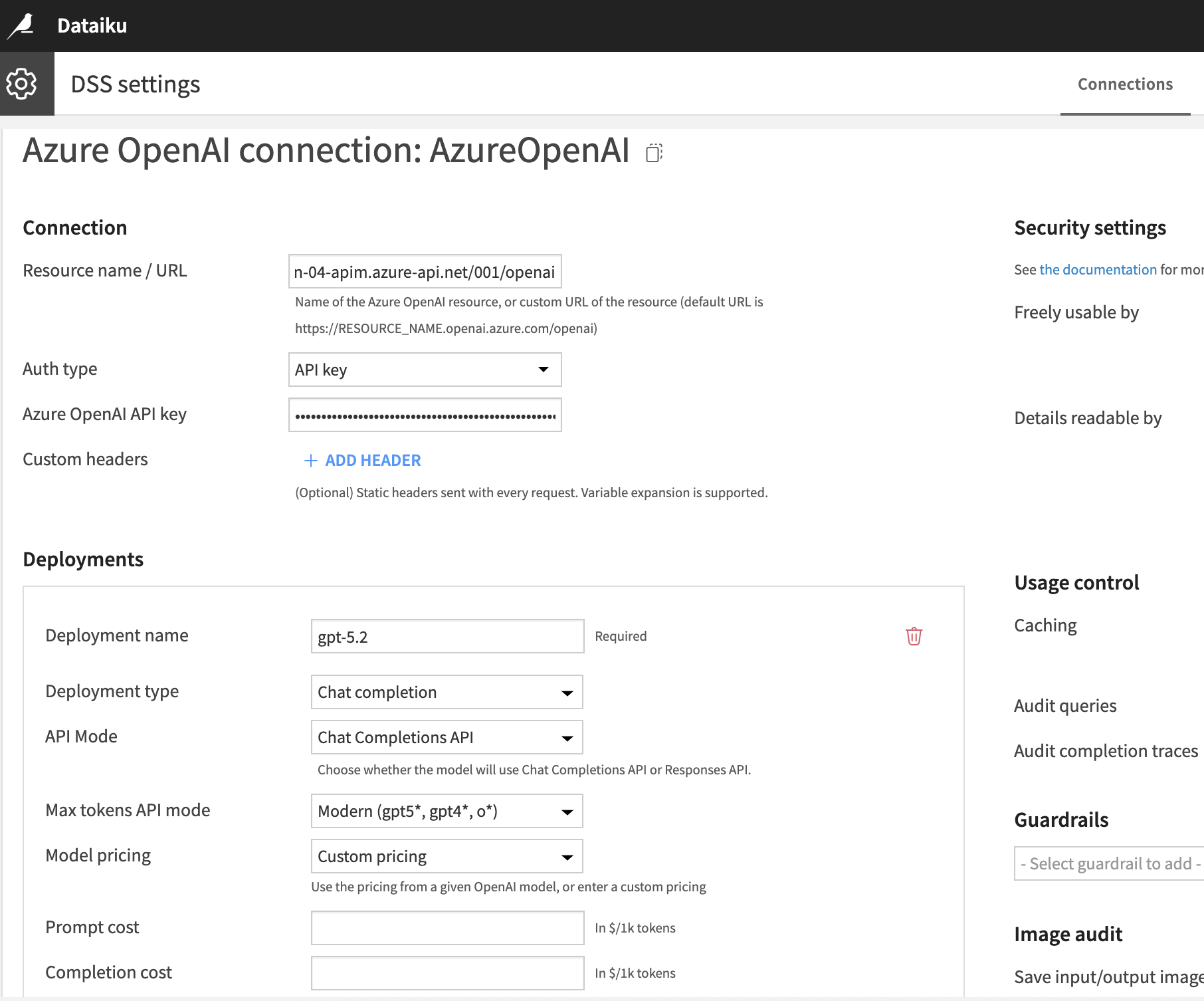

以下、私もKeyを受領したのでアップデートしました

-

右上の「ナインドット」→「アドミニストレーション」をクリック→「Connections」タブを選択し→「NEW CONNECTOIN」→「Azure OpenAI」をクリック

-

入力する情報は、Slackで申請後メールで受領します

- 以下を参考にご自身の情報で入力して下さい

- New connection name:任意の名前

- Resource name / URL:Endpoint URLの末尾に/openaiを加えたURL

例:[https://xxx.net/001/openai] ※こちら躓きやすいので注意して下さい

- Deployment name:gpt-5.2

- Deployment type:chat completion

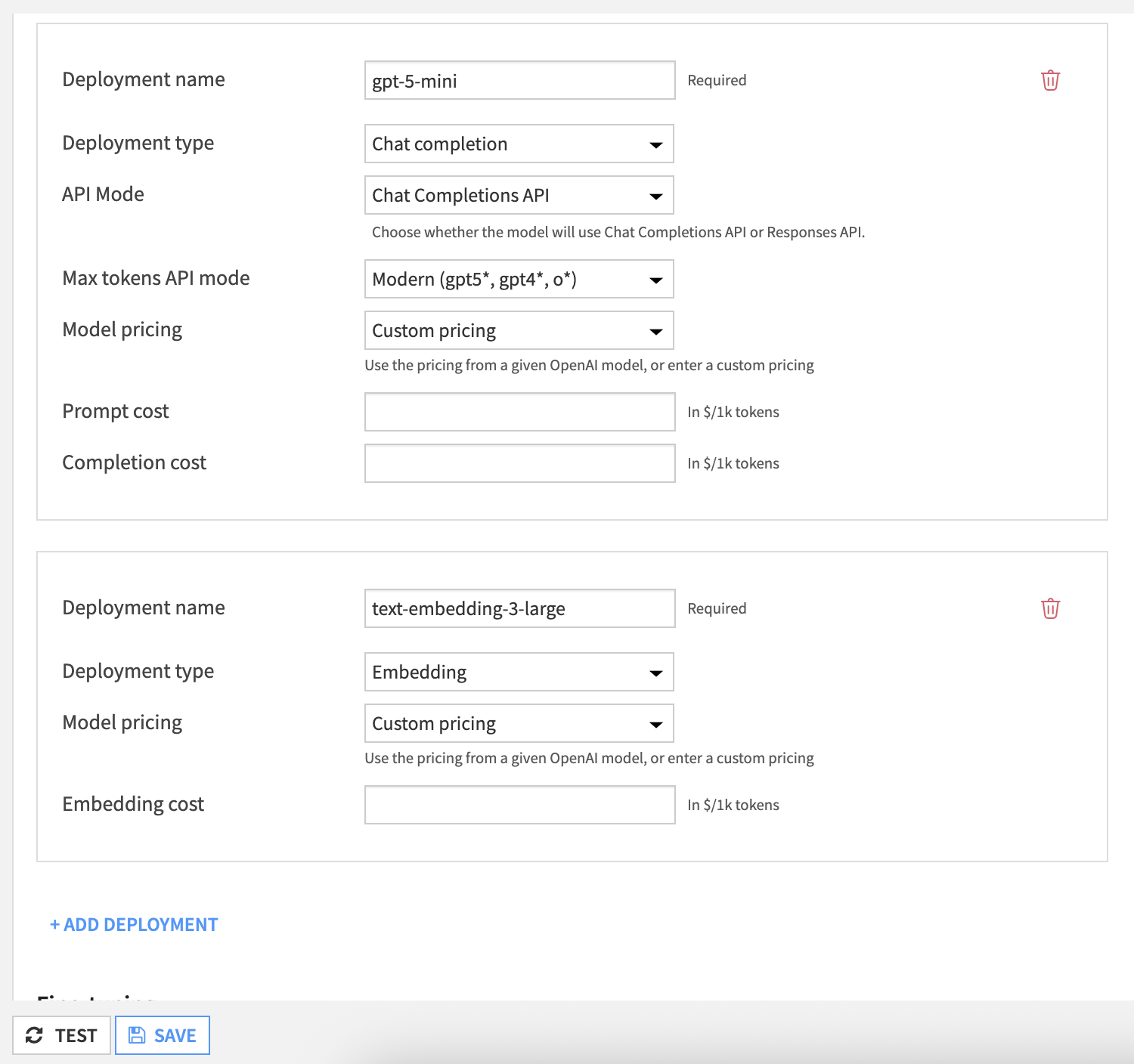

embeddingモデルについても「+ADD DEPLOYMENT」をクリックして頂き以下を入力して下さい

- Deployment name:text-embedding-3-large

- Deployment type:Embedding

※今回はchatモデルでgpt-5-miniも提供されているので、そちらも追加しております

- Deployment name:gpt-5-mini

- Deployment type:chat completion

こちらでページ下部の「TEST」でOKであれば「CREATE」でAPI接続も完了です!

後はDataiku上で自由に生成AIを含めたあらゆる機能を利用できますので、開発を進めるだけです!

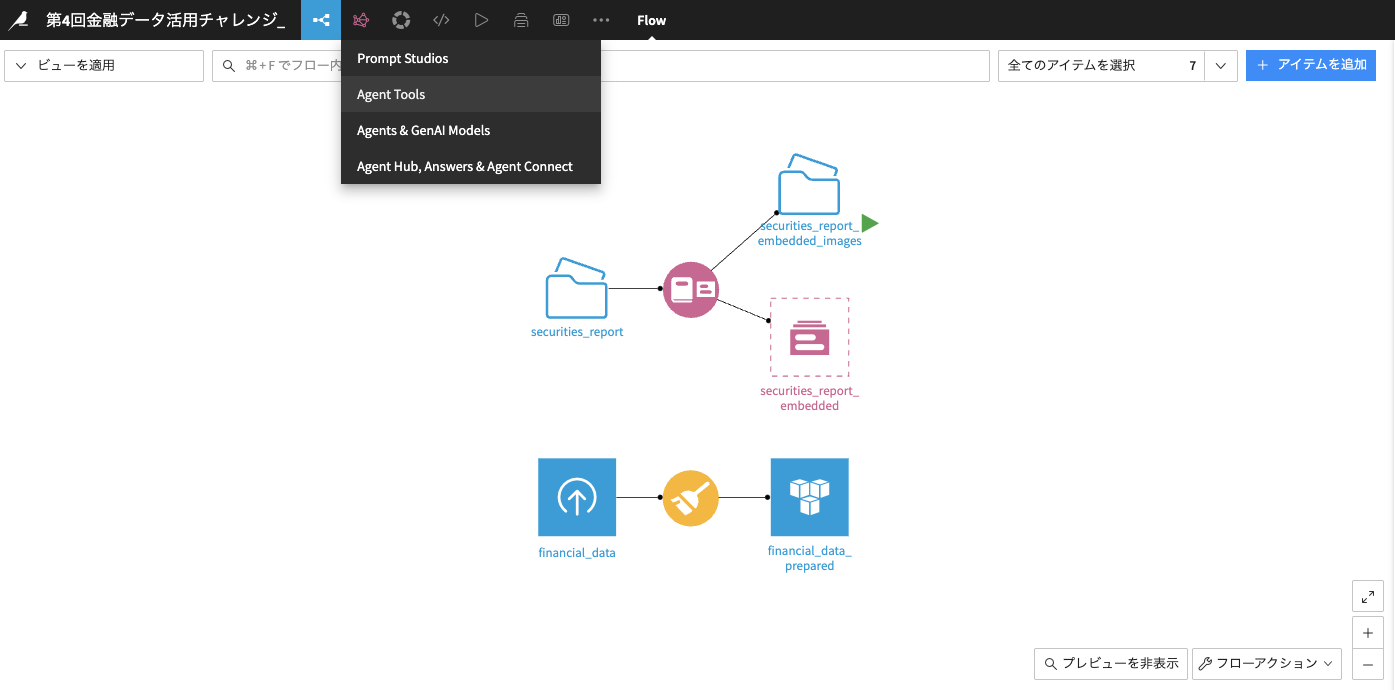

4.提案書エージェント作成

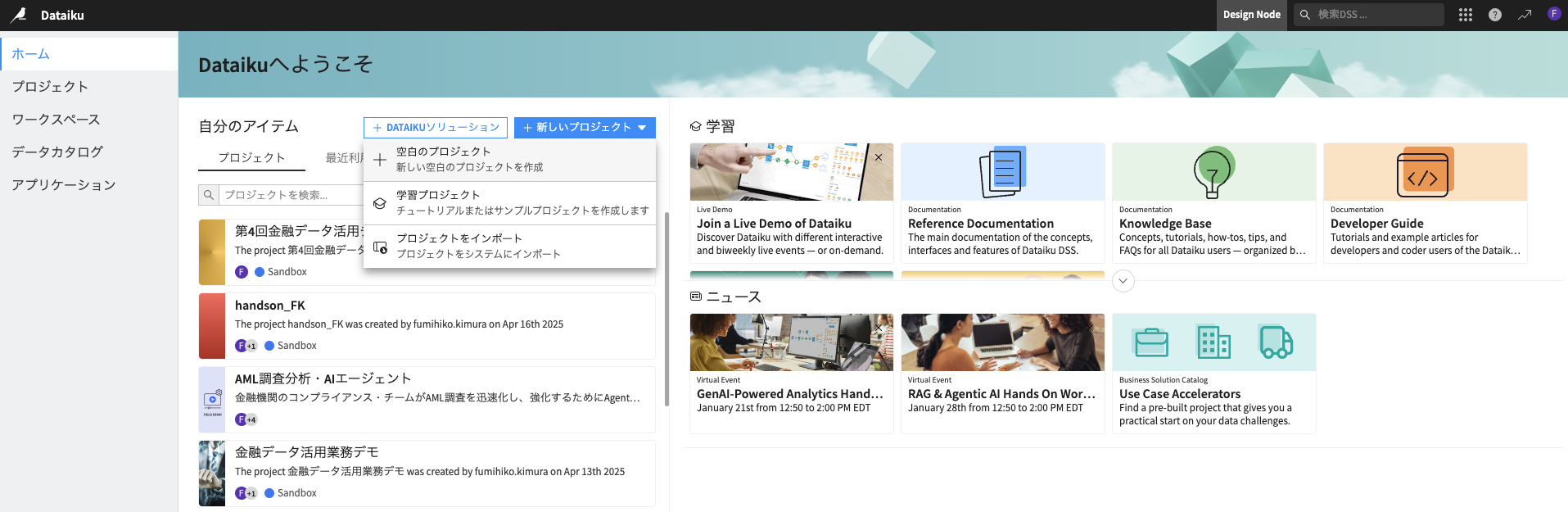

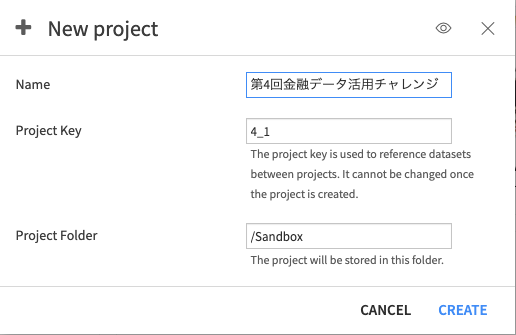

4.1 Dataikuプロジェクトの作成

Dataikuではプロジェクトという単位であらゆる分析を管理します

4.2 利用データの取り込み

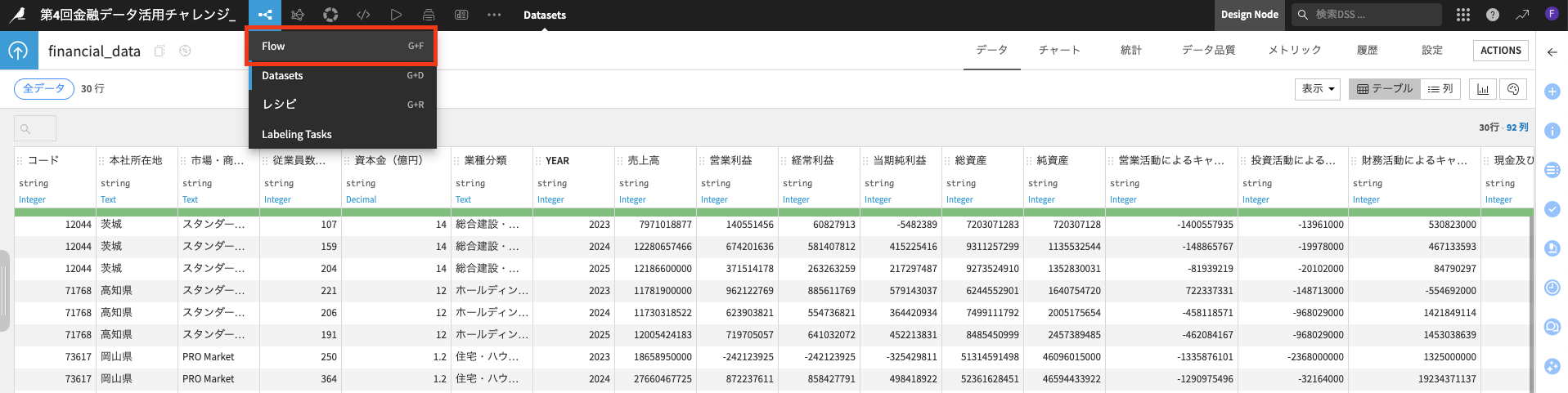

csvデータ(financial_data.csv)とPDFデータ(securities_report)の2種類を取り込みます

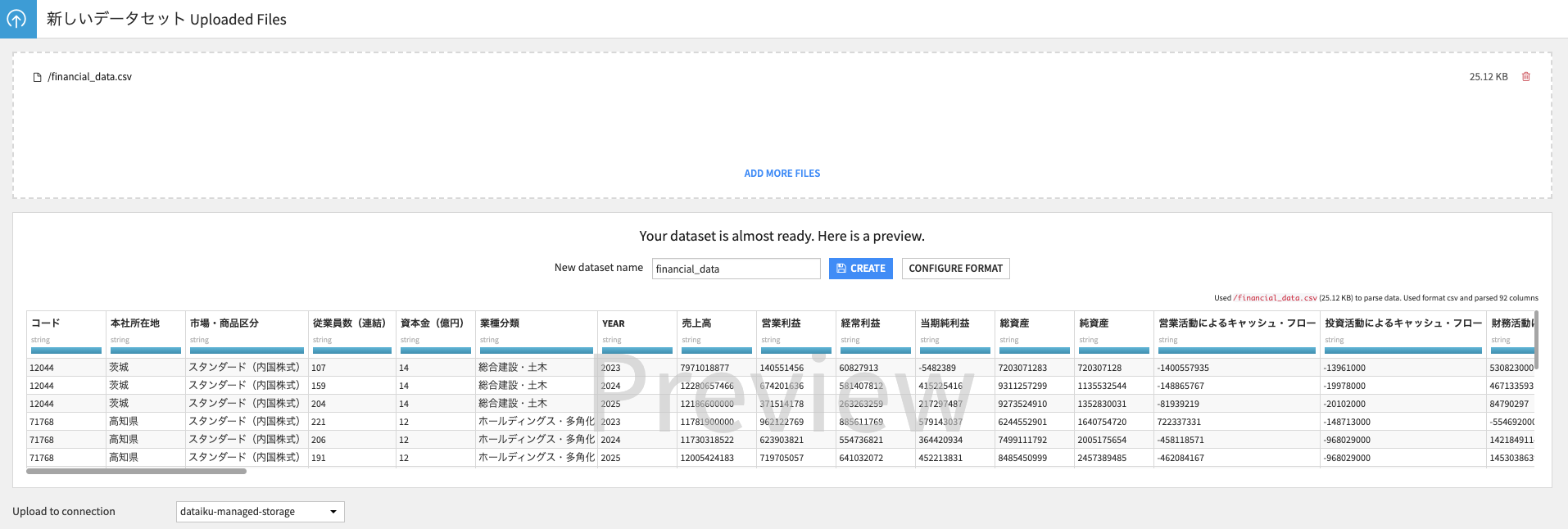

- まずはcsvデータの取り込みとして、画面右上の「+アイテムを追加」をクリックし、「アップロード」を選択

- financial_data.csvのファイルを"Drag and drop files here or"のエリアにドラッグ&ドロップ

- CREATEボタンを押下し、データの取り込みを完了

これでまずは定量データの取り込みが完了です!

-

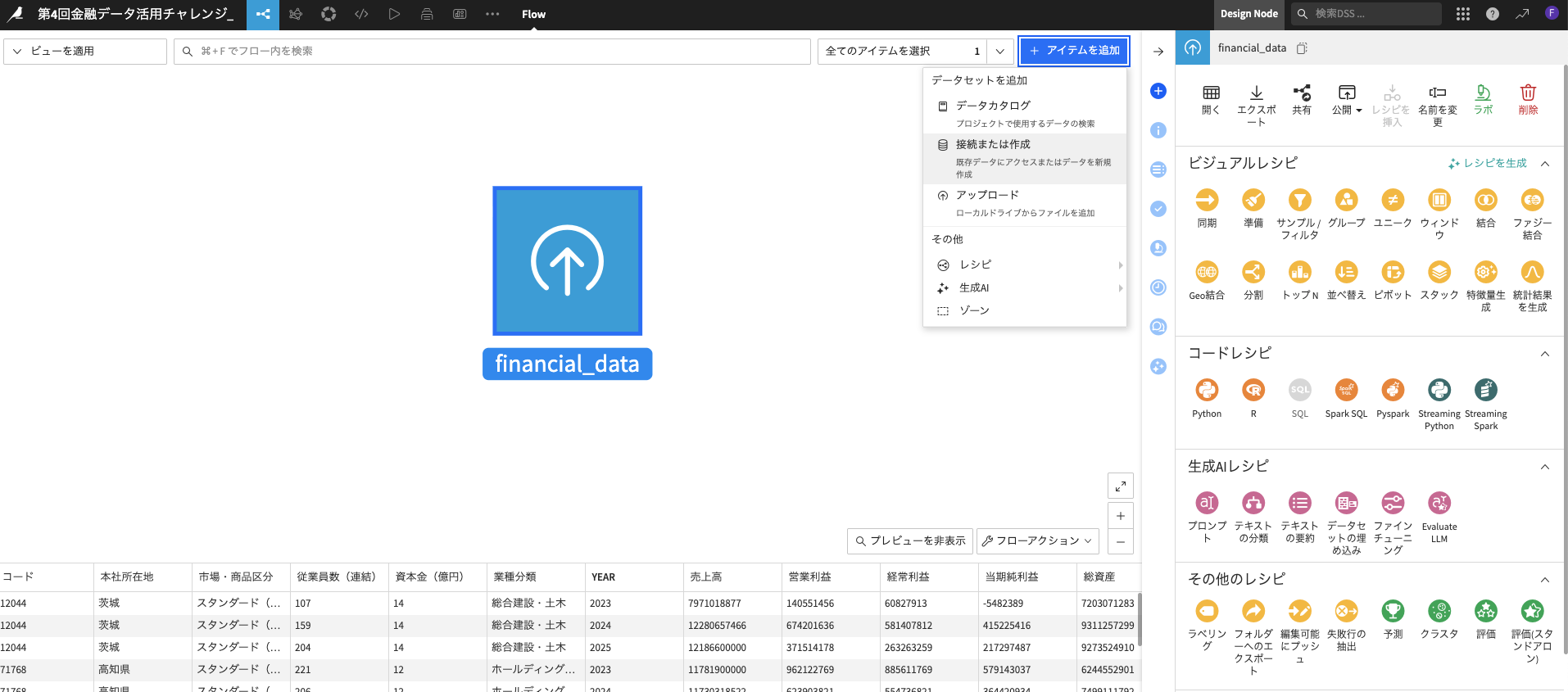

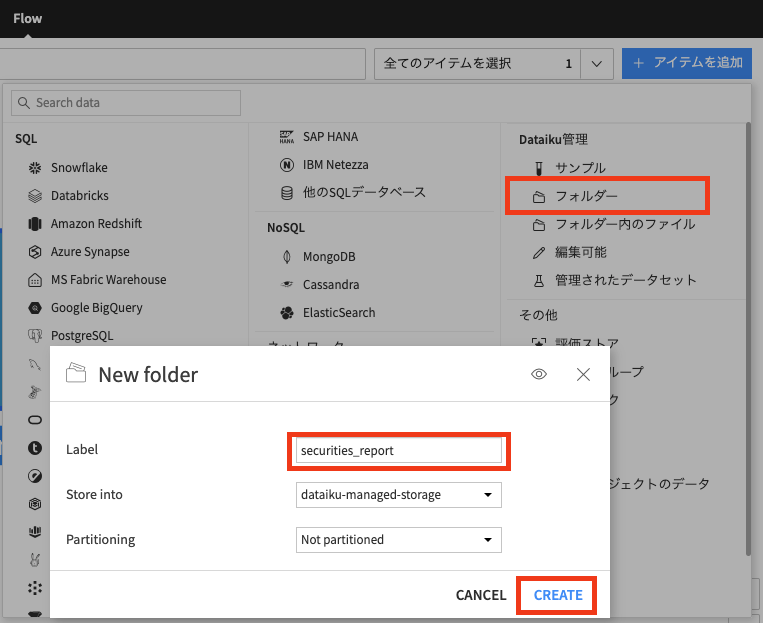

「フォルダー」を押下し、Labelに"securities_report"と名前を記入し、「CREATE」にてドキュメント格納用のフォルダーを作成

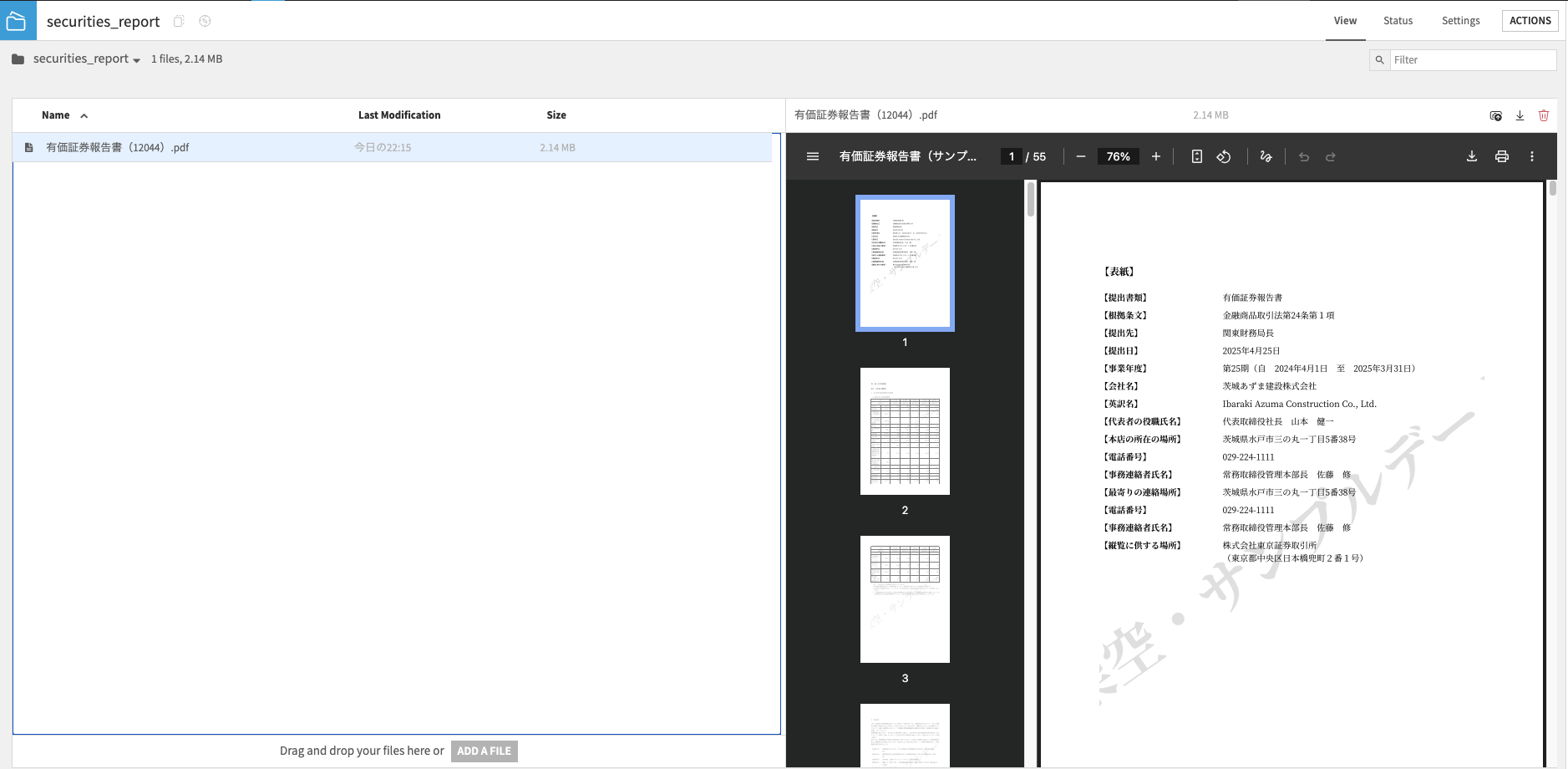

-

アップロードが完了したら選択する事で右側にプレビュー表示可能です

こちらでPDFの取り込みも完了です。

※全ファイルを同時複数選択し、全て一括でアップロードする事も可能です。こちらの手引書ではまずはサンプルとして"コード:12044"のサンプル企業のみを対象としますが、ぜひ全てのPDFのハンドリングや提案書の作成もチャレンジしてみて下さいませ!

4.3 データの前処理

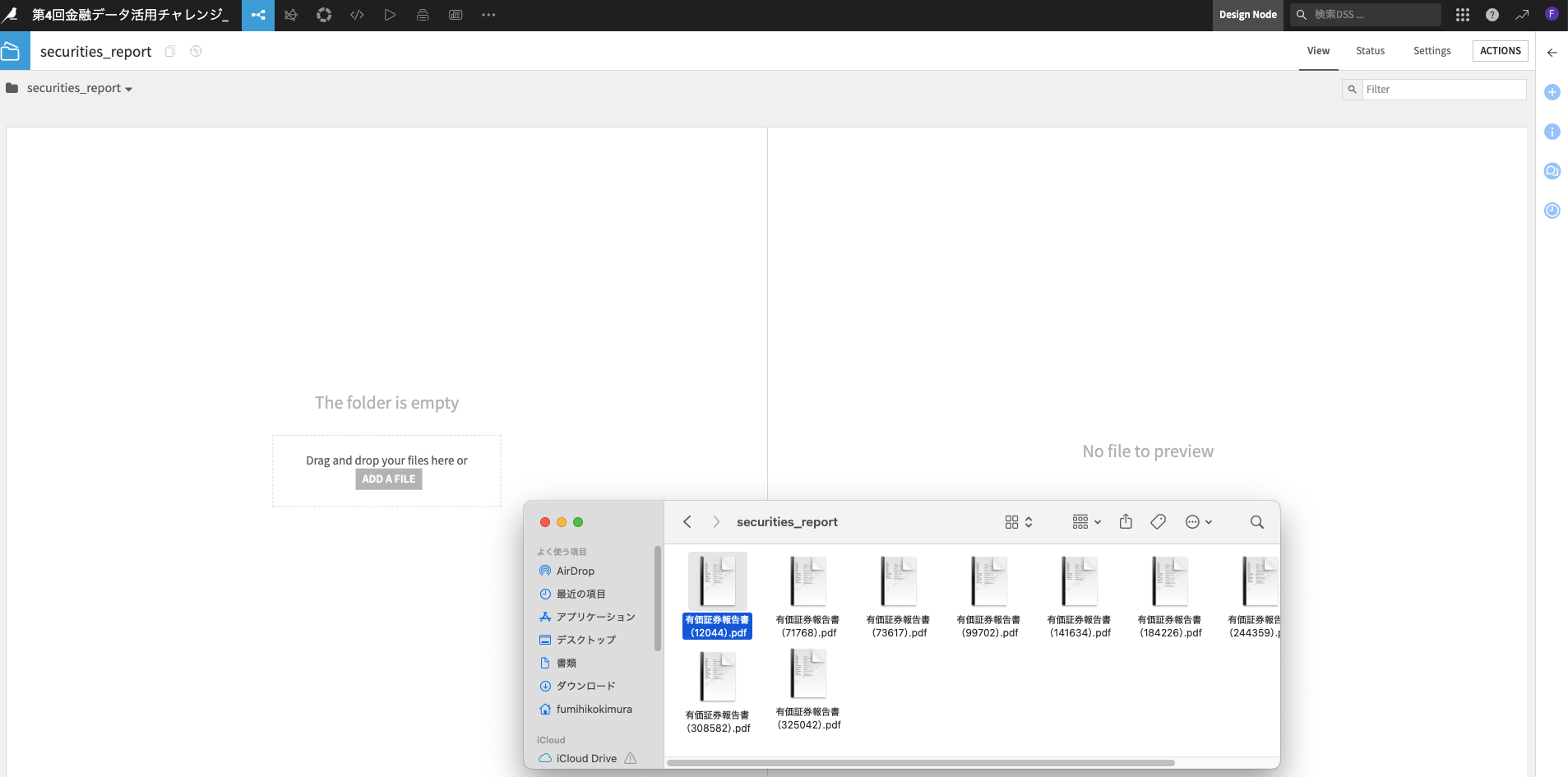

まずはテーブルデータの「financial_data」から加工していきます

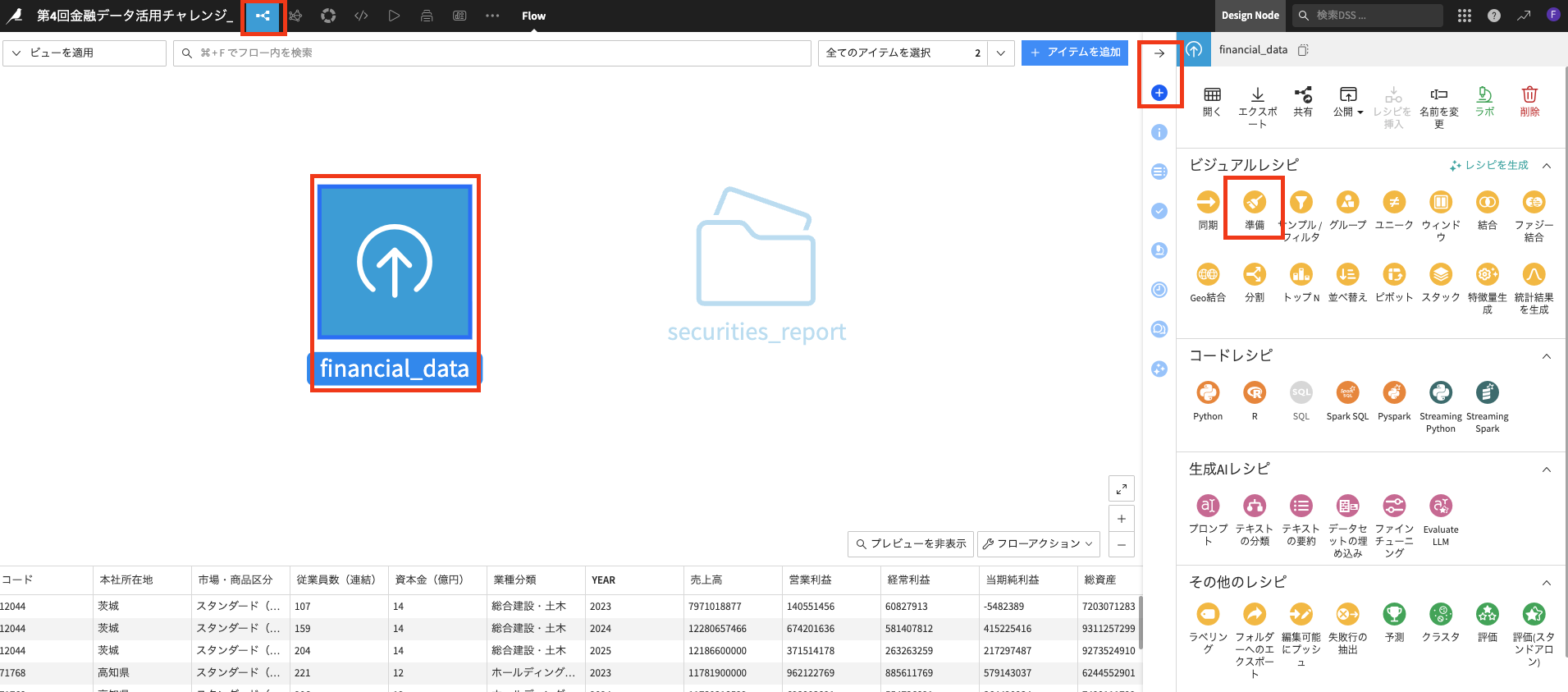

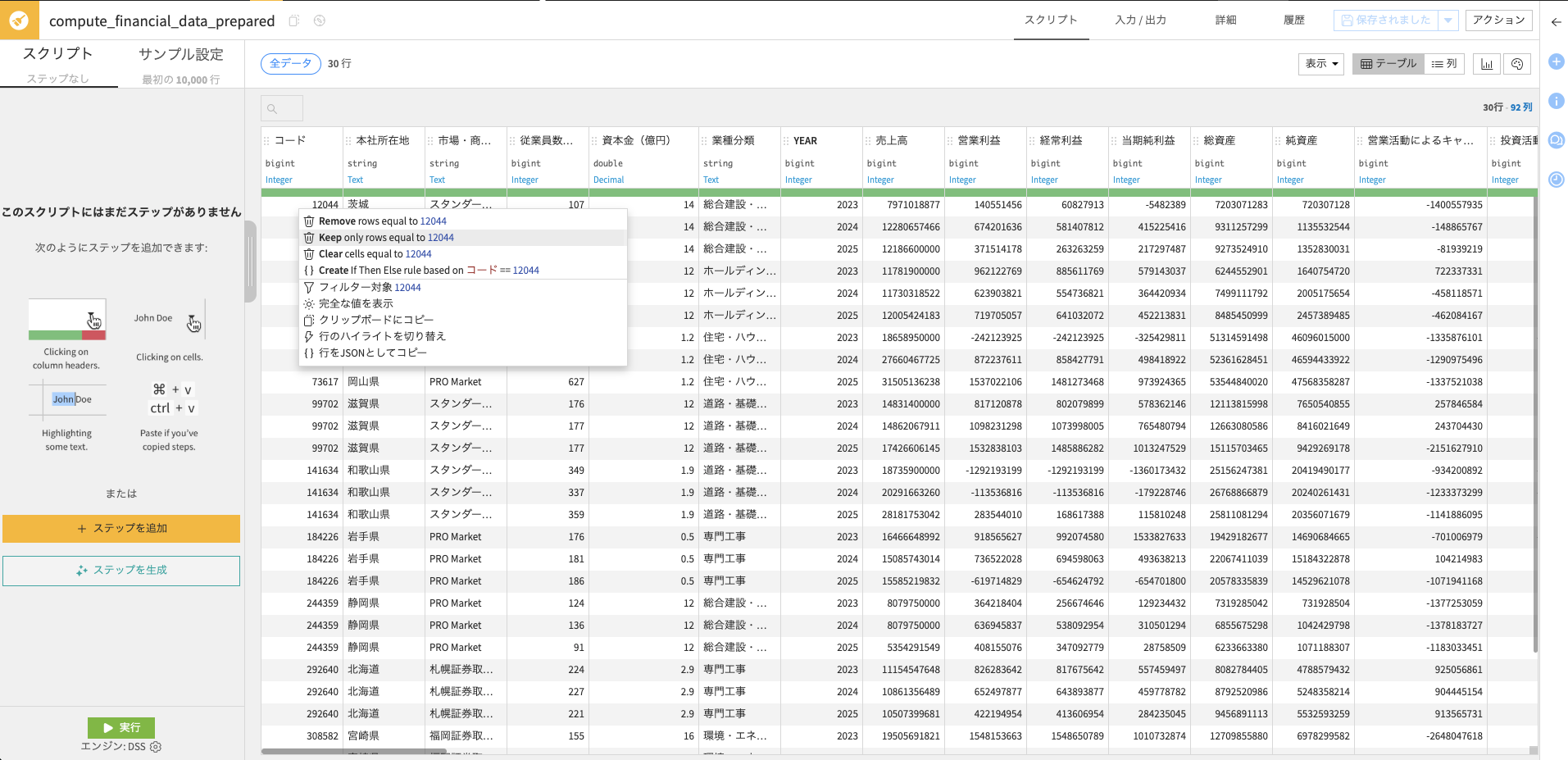

-

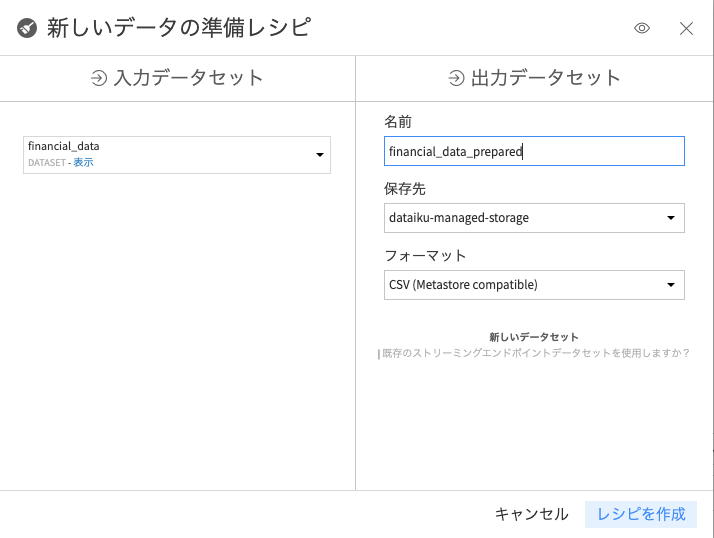

左上の「フロー」タブからビジュアルフローの画面に遷移し、"financail_data"のデータセットをクリックし、右側のパネル内のビジュアルレシピの中から「準備」レシピを選択

※右側のパネルは"→"もしくは"➕"マークで開きます

-

本手引書ではコード12044のみをサンプルで利用するため、コード列の"12044"のセルをクリック→「Keep only rows equal to 12044」を押下(本来残しても構いませんが、手引書上はその他のセルを削除します)

その後左下の緑の「実行」ボタンをクリックして下さい

また、実は列名の下にあるグレーの文字(Stringなど)が数値系のデータは自動でbigintやdoubleになっているかと存じます。これはDataikuが列の中身を解析して型変換してくれている便利機能です!

創意工夫次第ですが、型変換してくれるとデータの扱いとして非常に良い事も沢山ありますので、ぜひ確認してみて下さい。

こちらで定量データを扱いやすい形に変換できました。

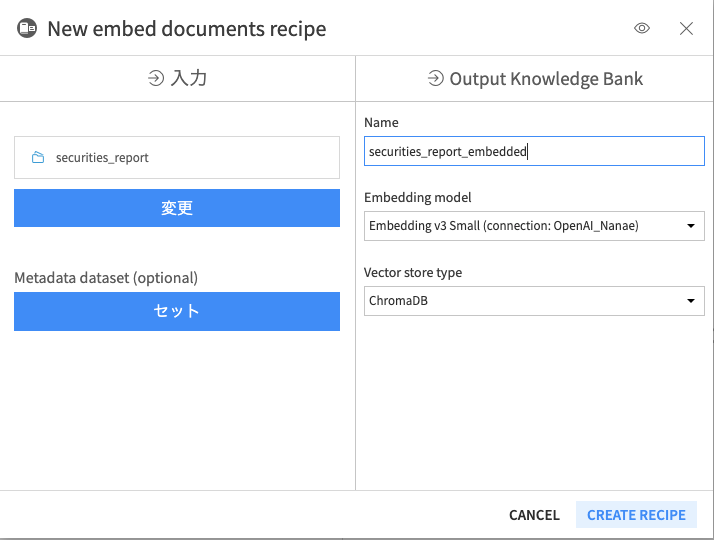

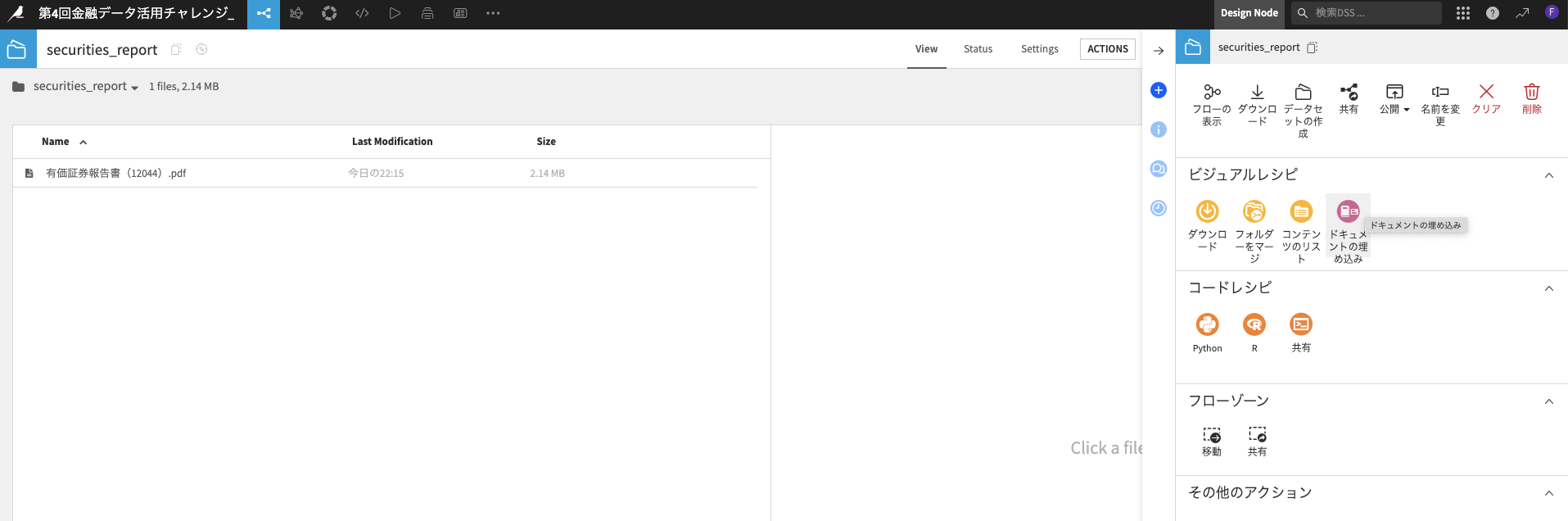

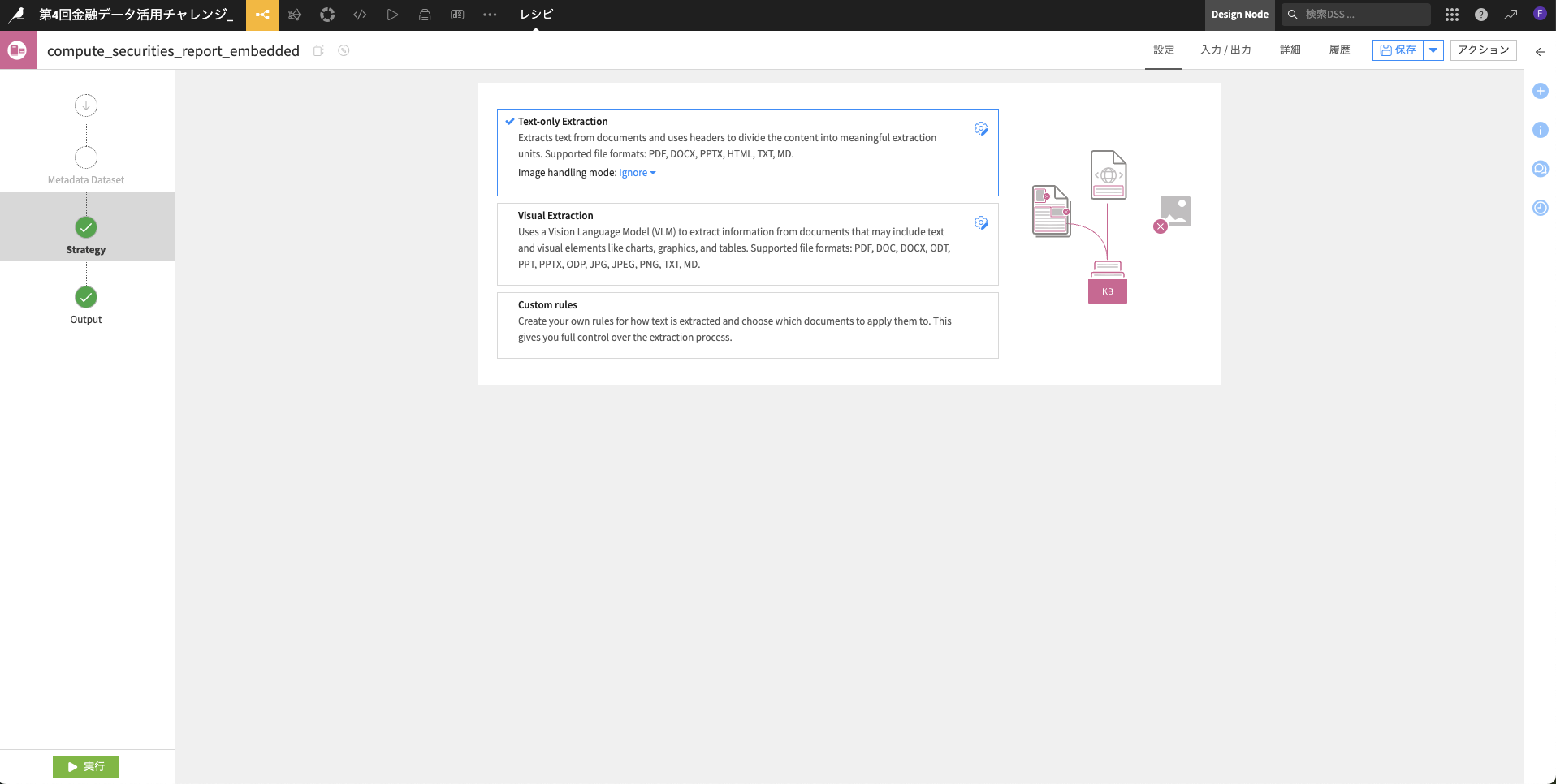

4.4 有価証券報告書のRAG化

次に、securities_reportフォルダの中に格納した「有価証券報告書(12044).pdf」を後程生成AIが内容を読み取れる様に所謂RAG化します

-

フローに戻った上で「securiries_report」フォルダをダブルクリックし、右のパネルから「ドキュメントの埋め込み」をクリックします

-

ドキュメントの解析方法や調整が可能ですが、今回は画像がデータに含まれていないため「Text-only Extraction」で進めます。特に変更せずに左下の「実行」ボタンを押下して下さい。

注)エラーが出る場合は"3.2項の Pythonパッケージの事前インストール"が実施済みか再確認して下さい。

※VLMを含めたRAG化の複数の手法を試したい場合は別の選択肢も是非お試し下さいませ。

また、OCR的にドキュメントの内容をテキスト化した上でRAG化するのも一つの手段かと思います。

※繰り返しですが、今回の手引書では一つのPDFで試しておりますが、複数ファイルを一度にRAG化する事も可能ですので、上記を含めて試行錯誤の一つとして下さい。

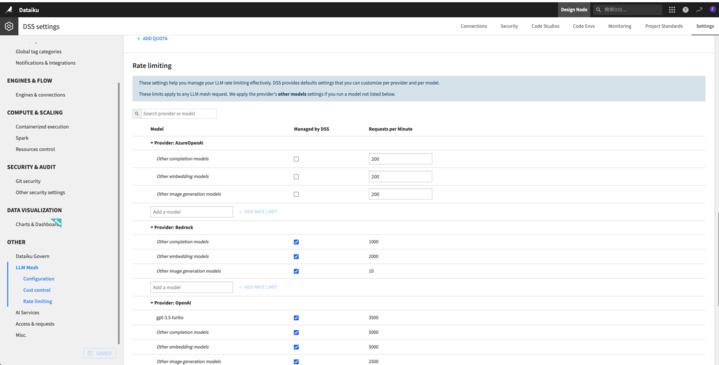

------(補足追記)------

今回10件分のドキュメントを一括でRAG化する時に、提供されているAzure OpenAIのkeyの設定にて、リクエスト数の制約でエラーが発生するケースがあります。

その場合は、以下もご参考に設定値を変更してみて下さいませ。

- 右上のナインドットから「アドミニストレーション」→「Settings」→左下の「LLM Mesh」にて、Rate limitingを設定

- AzureOpenAI内のembedding modelsなどのRequests per Minuteの値を減らす(私は200に減らしてみて成功しております)

------(完)------

4.5 提案書エージェントの作成(ツール作成編)

エージェントの構築には複数の手法がありますが、ベーシックに自然言語を受け付ける「エージェント」の下に、エージェントが呼び出す「ツール(機能)」を紐付けて提案書エージェントを作成してみましょう。

まずはツールから作成します。

今回はcsvの定量データを検索して参考にするツールと、RAGを呼び出すツールの二つを作成します。

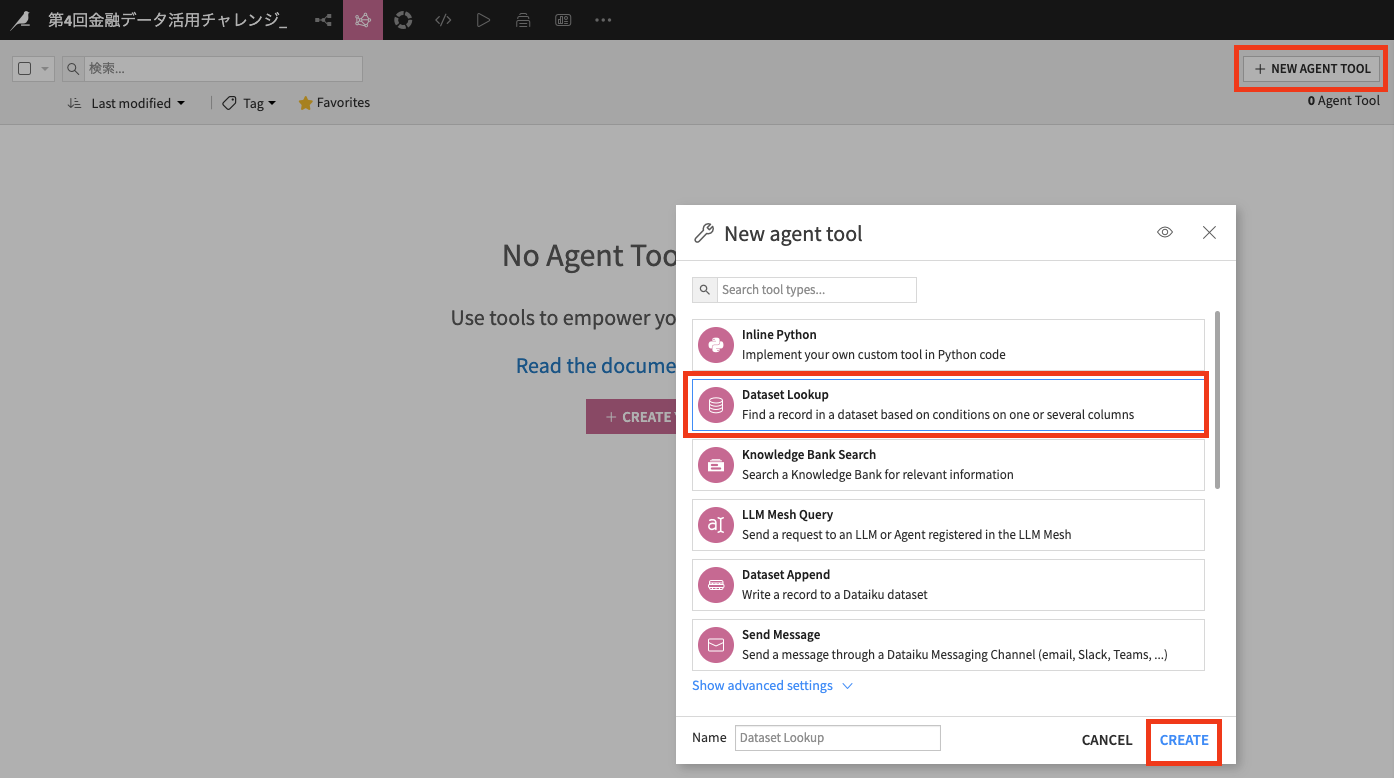

-

まずは前者として「Dataset Lookup」ツールを選択し、「CREATE」を押下して下さい

※Dataikuではエージェント構築に使えるプリセットのツールを多く設けております。プラグインでも追加で様々用意しておりますので是非ご興味あればご確認下さい。

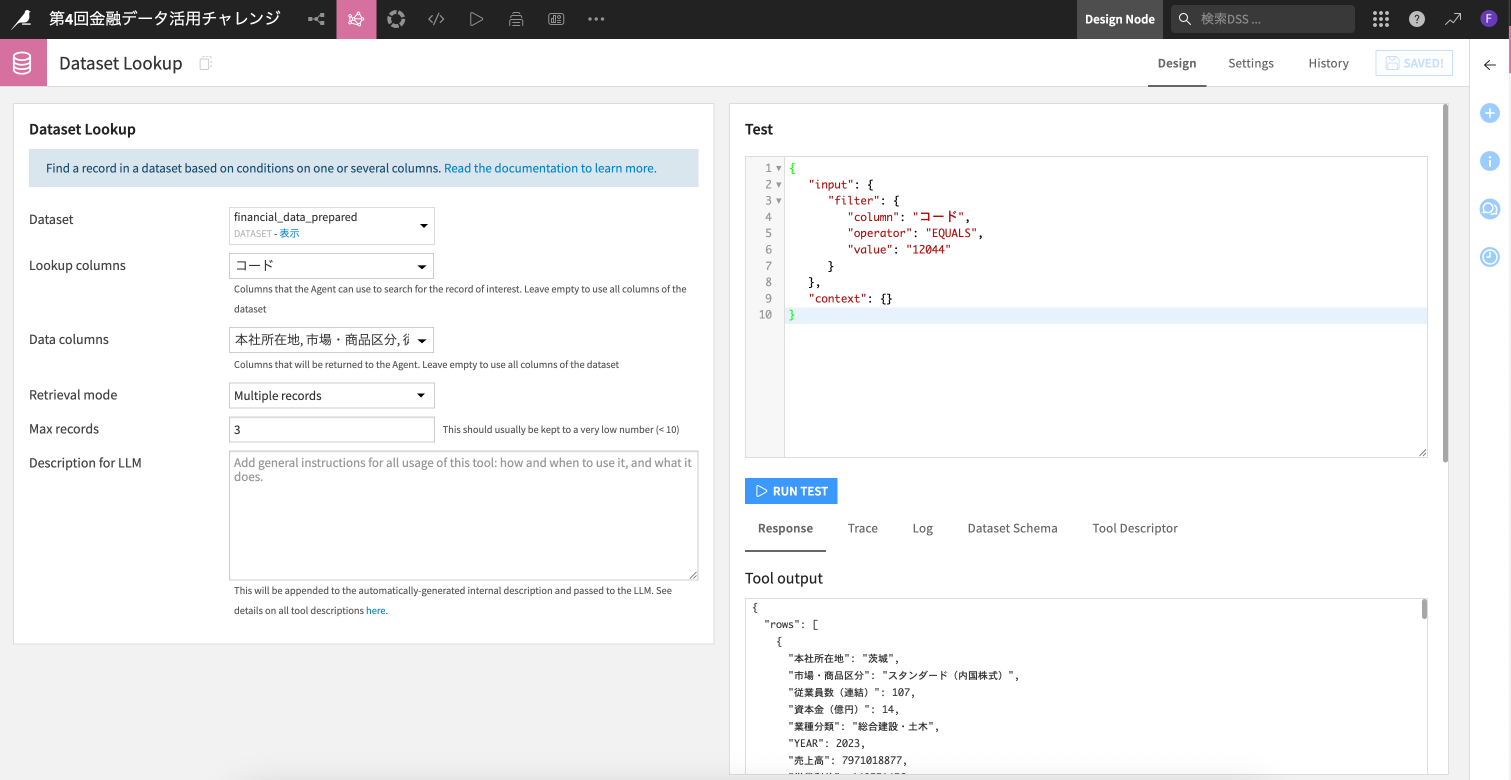

-

下記画像の様な設定項目とします

Dataset:financial_data_prepared

Lookup columns:コード

Data columns:コード以外の全て

Retrieval mode:Multiple records

Max records:3

※今回は各社コード毎に3行しかないため3行の出力と設定

(右側のパネルにてツールの挙動をテストする事も可能です)

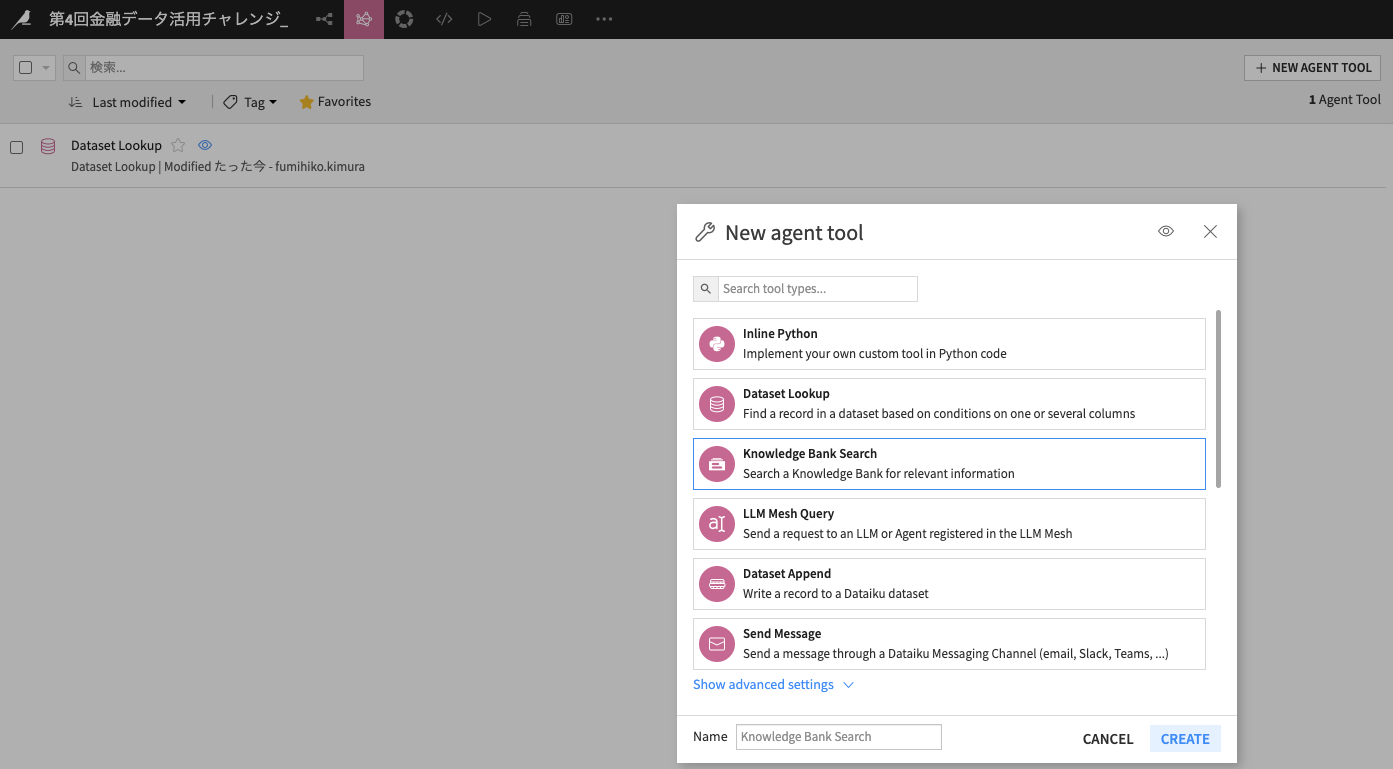

右上の「SAVE」ボタンを押下してツール作成完了です。もう一つRAG検索ツールを同じ手順で作成します -

ツールの画面から「+NEW AGENT TOOL」を押下し、「Knowledge Bank Search」をクリックして「CREATE」を押下

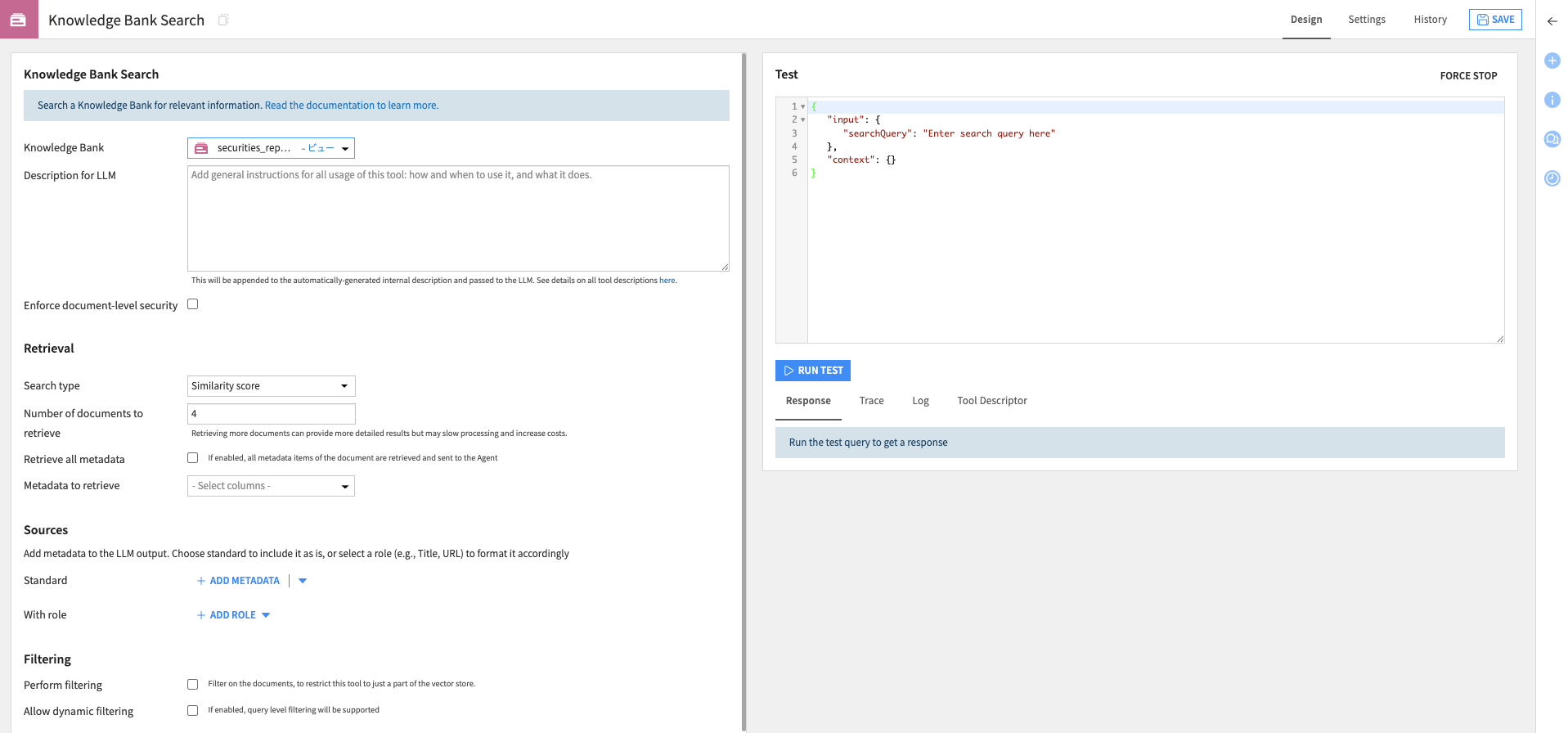

-

各種追加設定も可能ですが、今回はKnowledge Bankにプルダウンから先ほど作成した「securiries_report_embedded」を指定して、右上から「SAVE」を押下

こちらでエージェントが利用する2つのツールの作成が完了です。

この二つのツールにて、エージェントに自然言語で提案書作成を依頼した際に、CSVのデータとPDFドキュメントの情報を参照してくれます。

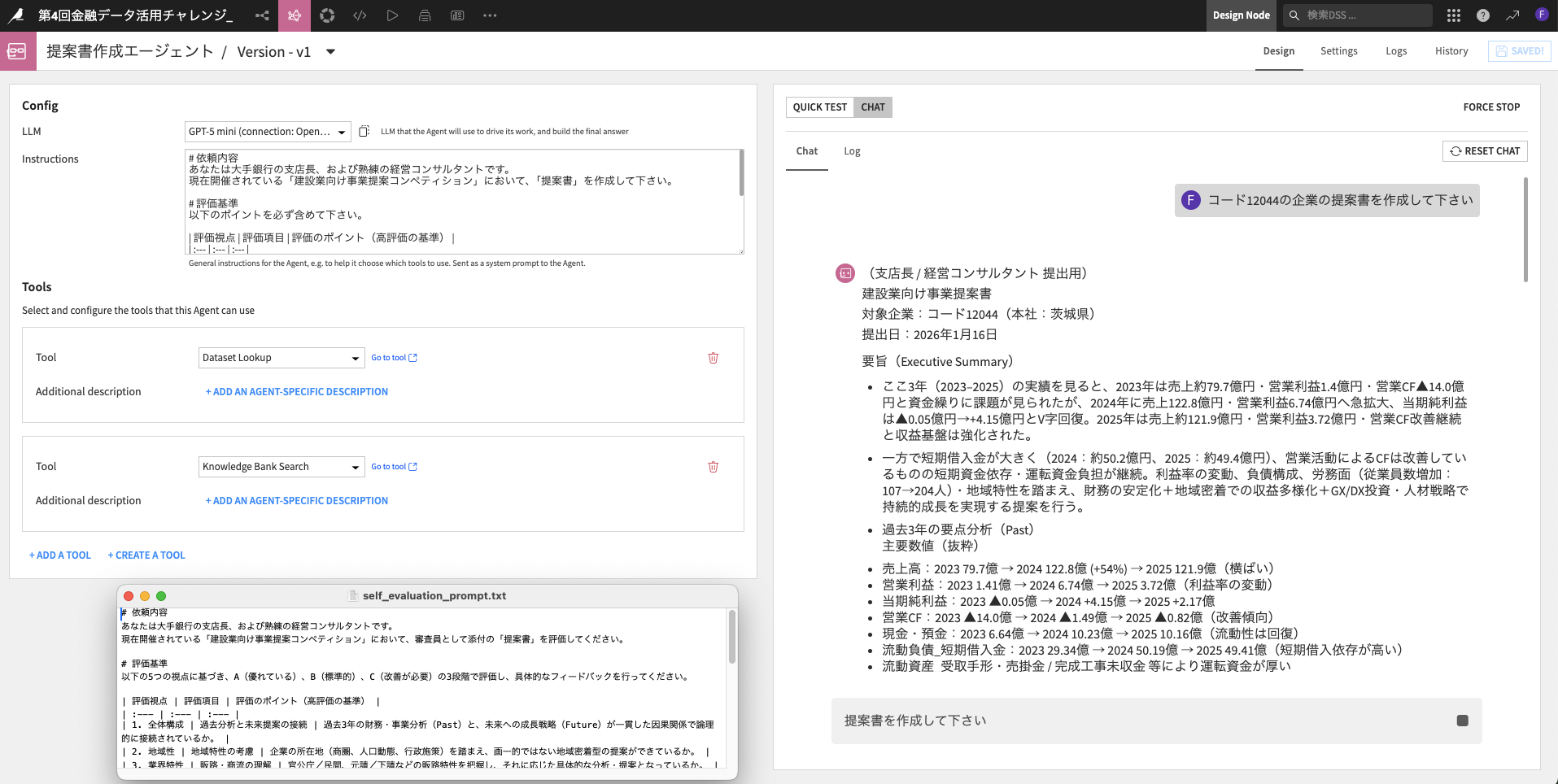

4.6 提案書作成エージェント(エージェント作成編)

最後に先ほど作成した2つのツールを束ねるエージェントを作成します。

- フロー内の右上「+アイテムを追加」から「生成AI」→「Visual Agent」を押下

- 「提案書作成エージェント」などの名前を入力して「OK」ボタンを押下

- エージェントの設定画面にて以下の内容を入力

LLM: GPT-5 mini

※「3.3項の 生成AIのAPI接続設定」で設定した皆様ご利用のLLMモデル

Instructions: 配布資料の「self_evaluation_prompt.txt」の観点を残したまま"提案書を作成する役割"に一部書き換えたプロンプト

Tools: 「+ADD A TOOL」からToolに「DatasetLookup」と「Knowledge Bank Search」の二つを追加

「SAVE」して頂いたら、これで提案書作成エージェントの作成が完了です。

この時点でテストしたい方は、右側のパネルから「CHAT」にて提案書作成を依頼すると結果が返却されます!

とっても簡単にエージェントが作成できました。

5.提案書データ作成・自己評価の確認

5.1 提案書テキスト保存用データの準備

今回取り上げているコード12044を一行のみ保持し、別カラムに生成AIの回答を記載させるデータを準備します。

(言葉で伝えにくく分かり辛いと思いますので、まずは手順を追ってみて下さい)

- 「financial_data_prepared」をクリックし、ビジュアルレシピから「ユニーク」レシピを選択

※添付の選択したデータセットをそのまま利用して提案書の作成指示をエージェント(LLM)に投げた場合、同じコードで3行分生成してしまうため重複削除にて1行に変換します

※今回はサンプルで1社取り上げてますが、本来の10社分=30行ある際により有効です

- 名前は変更せずに、「レシピを作成」を押下

- 添付画像の様に列として残す「コード」のみを右側に残し、左下の「実行」ボタンを押下

5.2 提案書作成のプロンプトによる指示

作成したデータにはコード列と12044の行が1行のデータとなりました。

このデータをインプットにして、12044の企業に対する提案書作成の指示と、そのエージェントのアウトプットを生成します。

- 右のパネルから「プロンプト」レシピを選択

- 名前はデフォルトのままで「レシピを作成」を押下

- プロンプトレシピには以下の内容を入力し、左下の「実行」ボタンを押下します

LLM: Agent - 提案書作成エージェント ※先ほど作成済みのエージェント

Prompt: コード列の企業に対する提案書を作成して下さい ※エージェント側のプロンプトに提案書の観点を記入済みのため、指示のみ

Prompt inputs: Columnにコードを指定

- 出力データを確認すると「llm_output」(エージェントのアウトプット)として、提案書が作成されてます。全文表示はデータをハイライトして右クリックで実施できます。

5.2 提案書の自己評価(self_evaluation)

今回は自己評価用のプロンプトにてA,B,Cの評価とフィードバックを得られます。

今後の改善活動に向けて自己評価もフローに組み込んでみましょう。

- 出力したデータセットをクリックし、「プロンプト」レシピを押下

- 名前はデフォルトのまま「レシピを作成」を押下

- プロンプトに以下の内容を入力し、「実行」ボタンを押下

LLM: GPT-5 mini ※仮で利用しております

Prompt: 配布の「self_evaluation_prompt.txt」

Prompt inputs: Desctiption→提案書、Column→llm_output ※プロンプトに"提案書"と記載されているので、提案書とllm_output列を紐付け

- 実行後のデータは以下の様な形で評価も算出できました

- 最終的なフローは以下の通りです

提案書の内容がデータとして作成できましたので、このままデータセットから「Copy to clipboard」として文章を「12044.docx」に貼り付けて完成です!

今回は1社分をサンプルに作成しましたが、手順の中で12044に絞らない形で推進すれば10社分も同じフローで作成可能です。

あくまで今回の手引書はベーシックな例になりますので、データ、プロセス、プロンプト、などなど各所で試行錯誤して頂ければと存じます。

ぜひ最初のトライアルとして順を追ってお試し下さい。少しでもお役に立ててたら幸いです。

参考情報

- Twitterで日々データ分析やDataikuに関わる内容を発信してます。是非参考としてフォローして頂けると嬉しいです

https://x.com/Fumihiko__K - ハンズオン開催

1月28日(水)18:00-からハンズオンを開催しますので、是非ご参加ください!

※詳細はSlackチャネルにてご案内いたします

おわりに

- Dataikuは「データ接続〜前処理〜RAG構築・プロンプトエンジニアリング〜エージェント作成」までの全てのプロセスを完結できる素晴らしいプラットフォームです

- 各手順のステップがビジュアルフローで見える化され、後からイタレーションが容易ですし、実際は大量データのハンドリングや実ビジネスに沿った一括処理、オペレーション側の機能なども豊富です

- 生成AIやエージェントもご案内の通りDataiku上で活用できますし、改善要素がどんどん出てくると思うので是非ご活用下さい!

ぜひ皆様と一緒に盛り上げていきたいと思いますので、Slackチャネルにも遠慮なく投稿して下さいね!最後までご拝読を有難うございました。