この記事では、MacとiPhoneを使い、フェイスキャプチャしたデータをUnity内のVRMに反映させ、OBSで配信する流れを紹介します。VMagicMirrorやLuppetといった、VTuber配信用の素晴らしいツールは存在しますが、動かすにはWindowsの環境が必要です。本記事を通して、VTuber活動に興味があるMacユーザが、VTuber環境の準備方法の手段が学べられると幸いです。

こちらの記事はUnity #2 Advent Calendar 2021 の9日目の記事です。

前置き

背景

自社のイベントでForksちゃんという自作アバターでVTuber的なことをやってみた際に、Macでの実装が思っていたより大変だなと思ったので、実装の流れについてこの記事で共有したいと思いました。私自身は公に活動してるVTuberではありません。社内で楽しく受肉してただけです。楽しいね。

必要な環境

- Unity

- FaceIDが搭載されてるiOSデバイス(iPhoneX, iPhone11, iPad Pro等)

- iPhone/Ipad用 iFacialMocap (有料)

- Mac用 iFacialMocap (無料)

- OBS

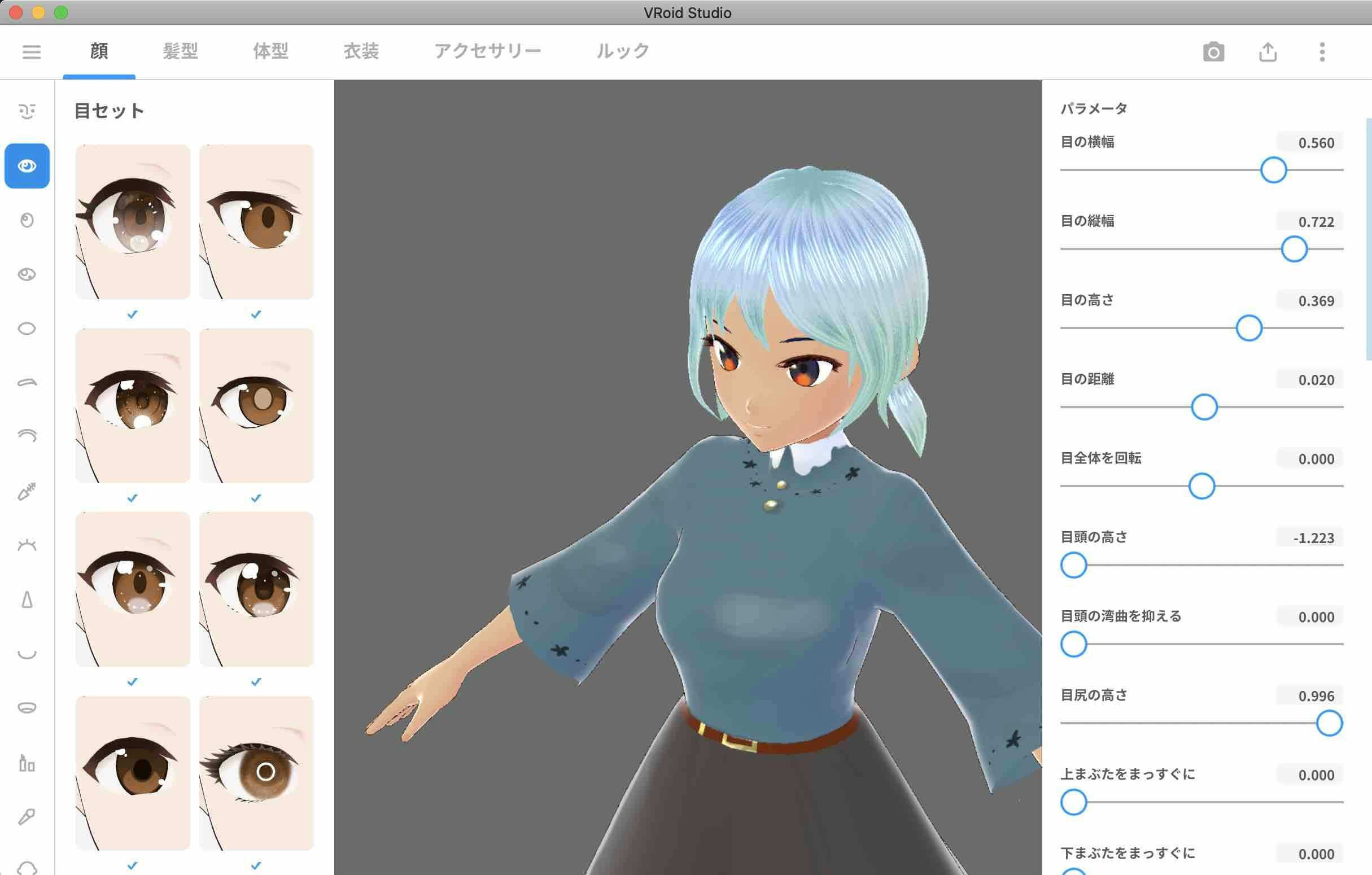

VRモデルの準備

まずはじめに、VTuber用のモデルの準備をします。

VRoid Studio を使用すると、無料で良いクオリティのモデルを作成することが出来ます。Mac対応のソフトも提供しているので、公式サイトからツールをダウンロードしてモデルを作成して見ましょう。

モデルの作成が一通り終わったら「VRMエクスポート」のオプションでファイルを出力します。

エクスポートする際、モデルのポリゴン数、マテリアル数、ボーン数等をいくらか削減することが出来ます。減らした方が後々Unity内で動かす時に、モデルの動きの処理による遅延が少なくなります(多分)。

iPhone用iFacialMocapの準備

iFacialMocapはiPhoneで顔の動きをキャプチャするアプリです。使用するにはiPhoneにFaceIDが搭載されてる必要があります。iPhoneアプリは下記のリンクから入手することが出来ます。

https://apps.apple.com/jp/app/ifacialmocap/id1489470545

上記のアプリは有料ですが、機能制限付きで無料版もお試しすることも出来ます。

アプリを起動すると、自分の顔の動きがキャプチャされ、iPhone上の顔のモデルに反映されます。

顔の動きのキャプチャが出来ていることが確認出来たら、次のステップに移りましょう。

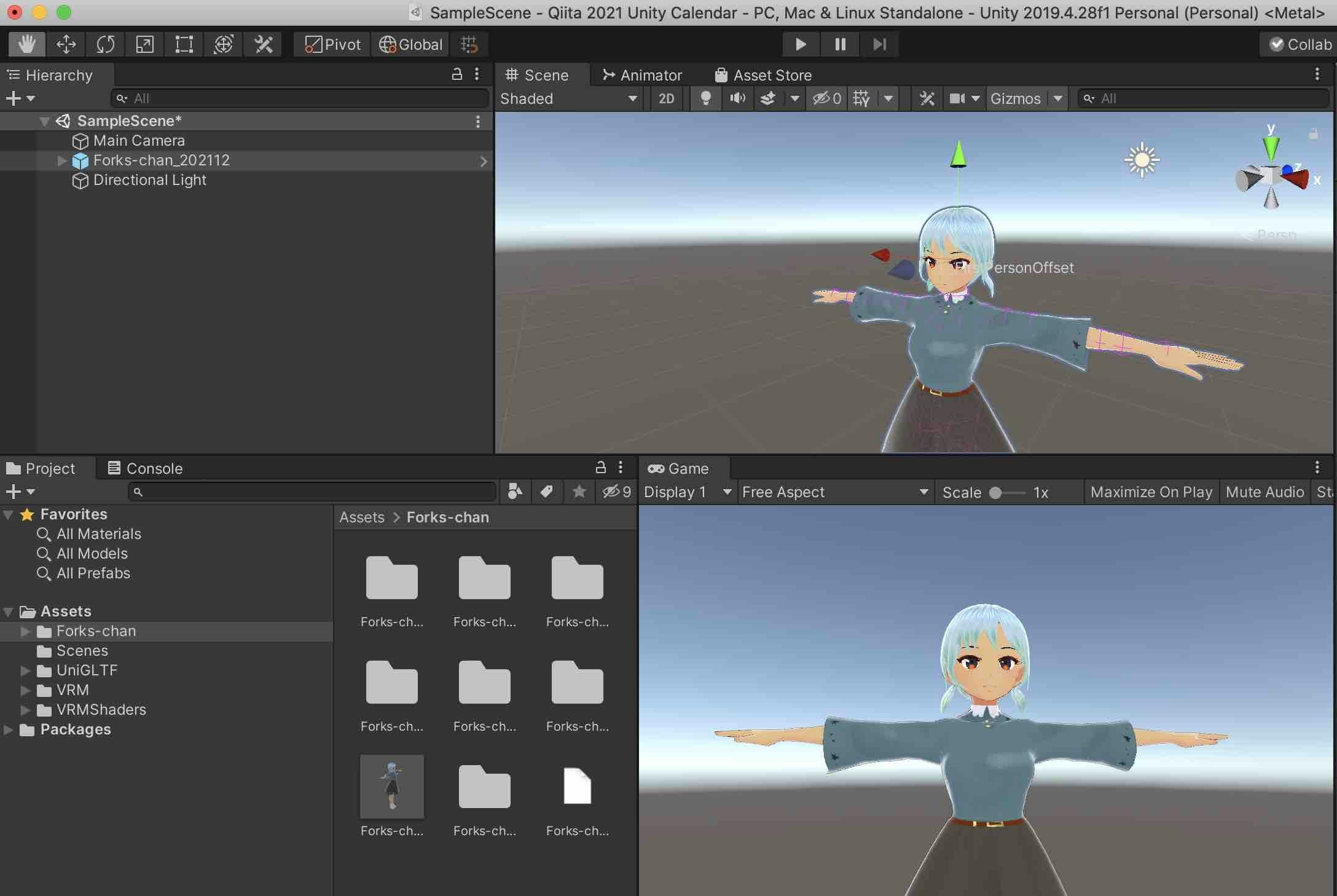

Unityの準備

Unityの設定

Unity Hub を起動し、2019.4.28f1 (LTS) で新しいプロジェクトを作成します。Mac Build Support が出来るように設定しましょう。

UniVRMをインストールする

UniVRMはUnityでVRMファイルが扱えるように出来るツールです。ツールのインストールからVRMモデルをインポートする一通りの流れはこちらの記事がとても参考になりました。

無事にVRMをUnity内に配置が出来たら次のステップに進みましょう。

Mac用iFacialMocapソフトをダウンロードする

Mac用のソフトは、iPhone版のiFacialMocapとUnityの中継機として扱われます。iPhone版のiFacialMocapのトラッキング情報が中継機を通し、Unity内のVRMの顔を動かします。

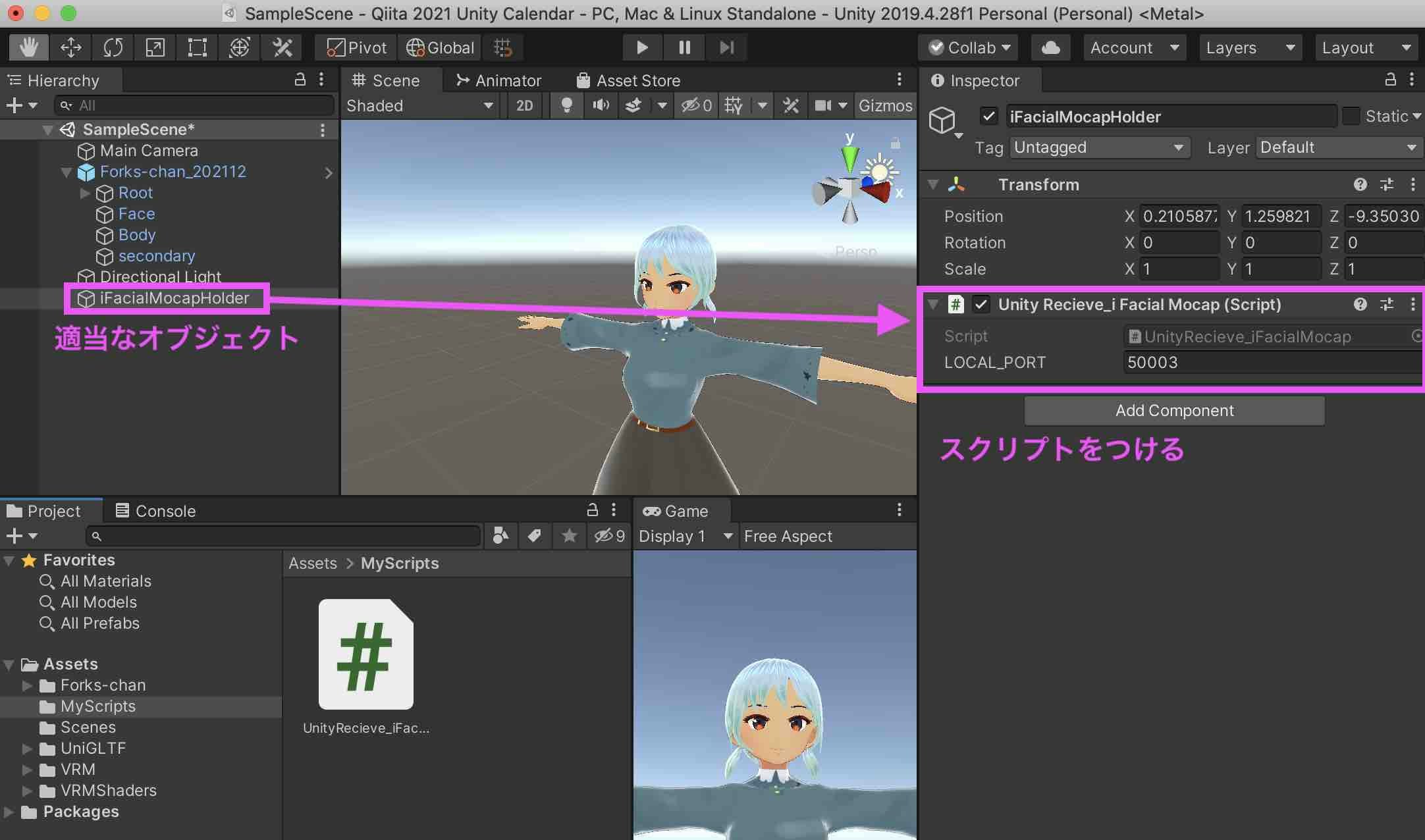

iFacialMocapとUnity内のVRMのシンクの準備

Mac用のiFacialMocapを立ち上げます。【Open Advanced Setting】をクリックすると、多くの設定が出てきますが、基本的に設定する内容は下記の4つです:

1. Unityに対応するようにする

【Software Name】の部分をUnityに選択します。

2. VRMファイルをロードする

下の方にスクロールすると、【Load settings from file】というボタンが出てきます。こちらをクリックし、作成したVRMファイルをアップロードすると、良い感じに他の項目(表情の設定等)がマッピングされます。

3. C#スクリプトをUnityに追加する

一番上の【Script】ボタンをクリックすると、C#スクリプトが入ったFinderウィンドウが開きます。Unity内に適当なオブジェクトを作成し、このスクリプトを付与します。

4. IPアドレスを設定する

【iPhone IP address】の項目をiPhoneのiFacialMocapに表示されてるIPアドレスと合わせます。もしiFacialMocapの方にIPアドレスが表示されていない場合、一度アプリを再起動すると表示されるはずです。

VRMをシンクさせる

この状態で一度iPhoneのiFacialMocapとUnityのモデルをシンクしてみましょう。

順序通りに進めます:

- iPhoneのiFacialMocapを立ち上げる

- Unityの再生ボタンをクリックし、ゲームを実行する

- MacのiFacialMocapで【Connect to Unity】をクリックする

うまくシンクが出来ましたでしょうか。【Connect to Unity】を押してもうまくつながらない場合、もしかしたらC#スクリプトを貼り忘れてるかもしれません。

Mac用にビルドする

シンクが出来ることを確認出来たら、UnityからMac用にビルドをします。【File】→【Build Settings】を開き、【Player Settings】を開きます。【Resolution and Presentation】で【Fullscreen Mode】をWindowedに設定します。後ほどビルドしたファイルの設定内容が微妙でしたら、この【Player Settings】上のオプションを細かに調整してみましょう。

設定が終わったらビルドをします。ビルドしたファイルを実行したら、同じ用にiFacialMocapとシンク出来るかの確認をしましょう。

ビルドしたモデルが反応しない場合、一度先程まで開発をしていたUnityの環境を閉じて、iFacialMocapを接続しなおしてみましょう。

OBSの準備

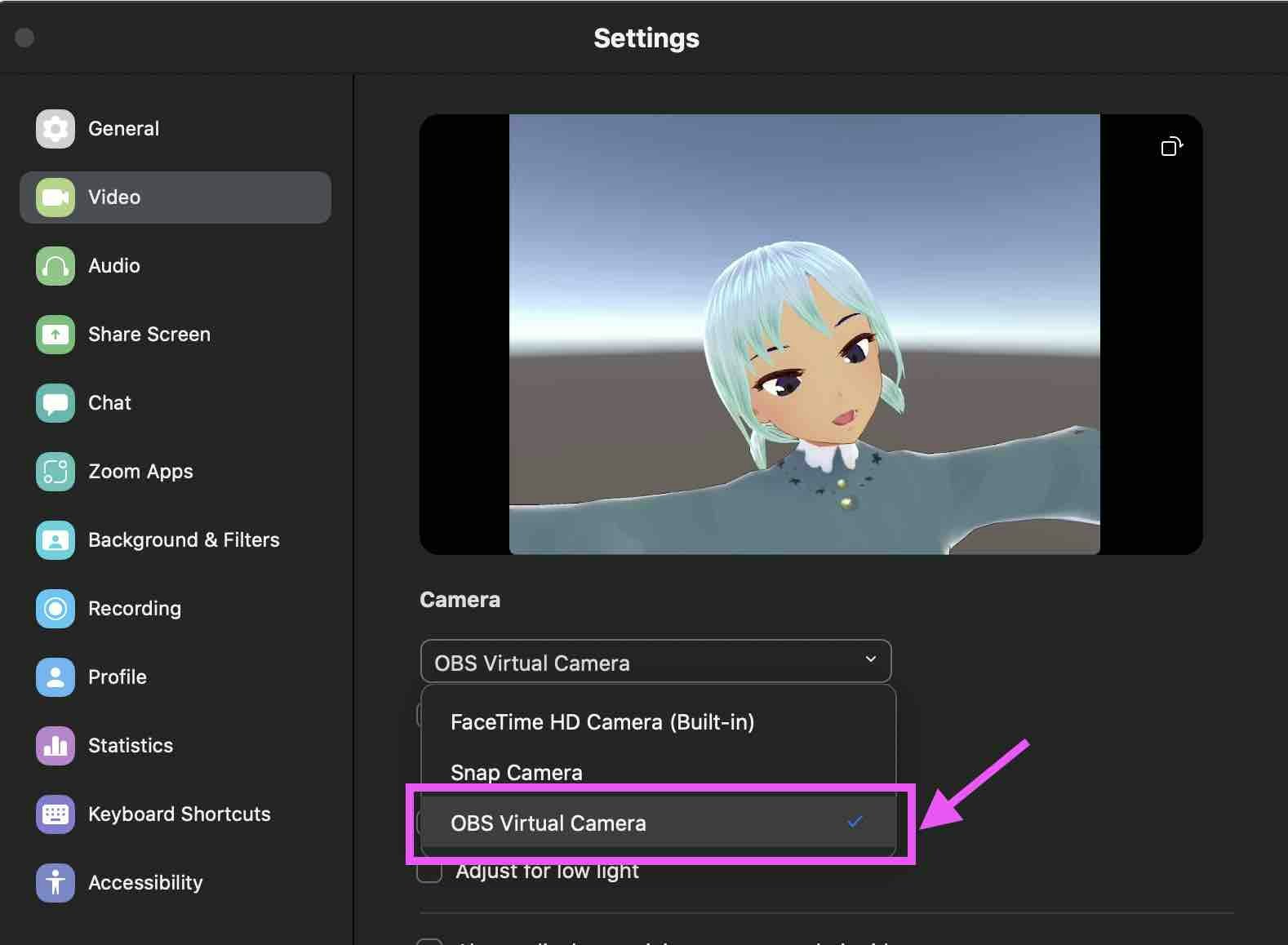

OBSとはライブ配信を支援してくれるソフトです。公式サイトからMac版をダウンロードし、インストールをします。先程ビルドしたUnityのファイルを実行した後に、OBSでウィンドウキャプチャのオプションを選び、Unityの実行中のファイルを選びます。設定後、【Start Virtual Camera】をクリックすると、他のアプリやサービスからこのウィンドウを参照することが出来ます。

例えばZoomのオンラインビデオ会議で使うとします。Zoomを立ち上げ、カメラの設定で「OBS Virtual Camera」を選択すると、先ほどOBSで設定した内容が流れるようになります。

Unityで実装する利点

VTubingの環境をUnityで実装する利点としては、好きに内容をいじれるからです。無料のアセットで自分好みにVR世界をセットアップしたり、VRMがウィンクしたらオブジェクトを生成することもスクリプトで設定が出来ます。自由度が高いです。

個人的にはUnity内からkintoneというデータベースツールのREST APIを叩いてたりしてます。こういうのとか。

出来上がったもの

社内イベントで出来上がったものについてインタビューして頂きました。下記のGIFのように、Zoomを通してVRMを通してコミュニケーションすることが出来ました。

内容としては

- Unityの環境でVRMを動かし、Zoomでコミュニケーションしている

- 配信環境からkintoneのREST APIを叩き、データベース情報を引っ張ってきて表示している

- VRMでニッコリした表情をすることをトリガーにkintoneのREST APIを叩いて出張申請のリクエストを承認している

という感じです。

以上となります!

補足情報

Q. VRMがずっとTポーズのままなのだが?

A. VRMのオブジェクトの階層を掘っていくと、肩や腕のパーツが選択出来ます。これらを良い感じに回転させればTポーズから抜け出せます。

Q. 動かせるのは顔だけ?

A. 表情がシンクされ、頭も角度をいくらか変えられます。腕や手の動きはシンクされません。そこまで追求したい方はLeap Motionで実装すると良いかもしれません。

Q. OBSで配信すると重い・・・!

A. OBSは初期設定だと高画質で配信しようとします。まずこちらの設定を緩めることからはじめましょう。さらに軽くしたい場合はVRMの軽量化とUnity環境の軽量化にチャレンジする必要があります。というかそもそもMacは3Dの処理にそんなに向いてないので、本気でやるんだったらWindowsでやりましょう (えっ