はじめに

OpenCVを使った画像処理の実験。

物体検出の練習として、一部界隈で熱狂的なファンを持つ(?)マルフク看板を写真の画像から探してみます。

といっても物体検出というほど立派なことをしていないので、いくらでも改善の余地がありそうですが、まずは取っ掛かりとして。

マルフク看板?

こんなの。

民家や小屋に貼られているのを見たことのある方もいらっしゃると思います。

最近見なくなったとお思いの方も多いかもしれません。

ここではあまり書いていませんでしたが、ファンサイトやTwitterのBotも作ってたりする筋金入りのマルフク看板ファンなのであります。(宣伝)

検証環境

- Windows 10 Home (1903)

- Python 3.6.8

- opencv-python==4.2.0.34 (pipからインストール)

- imutils==0.5.3 (同上)

問題設定

今回は入力された画像に対して、マルフク看板の写っている領域を検出して四角で囲んでみます。看板自体は長方形ですが、撮影の角度によって多少歪んだ形になっているでしょう。

最初の画像はこんな感じになると良いですね。

自分で作らなくてもいい?

既存の技術やモデルで間に合うならそれでよいので、最初にMask R-CNNの学習済みモデルを試してみたのですが、どうも微妙な結果でした。

matterport/Mask_RCNN: Mask R-CNN for object detection and instance segmentation on Keras and TensorFlow

stop sign、赤と白ですし気持ちは分かりますが…。

他の画像だと何も検出されない場合もありました。

「マルフク看板」なんてクラス、あるわけないもんなあ。

【手動ポスト】最近Botの中の人は深層学習で遊んでいるのですが、マルフク看板のある風景を物体検出させたらどうなるのかやってみました。マルフク看板には残念ながら何の結果もつかず。マルフク看板自動検出への道は遠いか。使ったプログラムはこれです。 https://t.co/aFUoKs05UJ pic.twitter.com/6BiyNyDs44

— 電話の金融マルフクbot (@029bot) March 26, 2020

というわけで、やはり何か考える必要があるっぽいです…。

OpenCVで物体検出(もどき)

四角や円を検出するチュートリアルがあるので、同様の方法でマルフク看板の領域を検出してみたいと思います。

なお「もどき」と書いているのは、いろいろな物体クラスを用意しているわけでもなければ、輪郭抽出以上のことをしているわけでもないからです。。。

以下のチュートリアルの内容をベースに作ってみます。

OpenCV shape detection - PyImageSearch

チュートリアルの内容の他、必要に応じてこちらのページを参考にしました。

機械学習のためのOpenCV入門 - Qiita

まずはモジュールのインポートと、引数解析・画像読み込み部分です。

import argparse

import imutils

import cv2

# 引数解析

ap = argparse.ArgumentParser()

ap.add_argument("-i", "--image", required=True,

help="path to the input image")

args = vars(ap.parse_args())

# 画像読み込み

image = cv2.imread(args["image"])

2値化

まずは画像を2値化して、背景部分が黒、物体部分(マルフク看板の領域)が白になるようにします。

以下のコードを実行すると、2値化された画像がウィンドウに表示され、何かキーを入力するとウィンドウが閉じます。

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

blurred = cv2.bilateralFilter(gray, 25, 15, 15)

thresh = cv2.threshold(blurred, 160, 255, cv2.THRESH_BINARY)[1]

cv2.imshow("Thresh", thresh)

cv2.waitKey(0)

カラー画像をグレースケール化し、画素値がある閾値以上かどうかで白・黒に塗り分けます。

この方法で問題なのは、**「赤で描かれている部分が黒(背景)になってしまう」**という点です。このままだと赤い部分は看板の領域の外になってしまいます。cv2.threshold() のパラメータも関係ないわけではありませんが、赤色がそれなりに濃く描かれているので、赤い部分が白くなるようにパラメータを調整すると、大部分が白になってしまいます。

そこで、前処理として 赤色を消す 方法を試してみたいと思います。

光の赤色に見える部分は、絵の具(インク)の三原色でいえば「マゼンタ」と「イエロー」を混ぜたものになります。1

つまり、マゼンタとイエローを消すことによって、赤い部分を白くすることができそうです。

光の三原色 (RGB) で言えば、マゼンタを消すには緑 (G) を最大にすればよく、イエローを消すには青 (B) を最大にすればよいので、マゼンタとイエローを消すと結局RGBの赤 (R) の成分だけが効いてきます。よって、Rの値だけを残すことによって目的を達成できます。

ということで、グレースケール化する際に cv2.cvtColor() を使わず、RGBの「赤」の成分を取り出す方法を試します。

gray = image[:, :, 2]

blurred = cv2.bilateralFilter(gray, 25, 15, 15)

thresh = cv2.threshold(blurred, 160, 255, cv2.THRESH_BINARY)[1]

cv2.imshow("Thresh", thresh)

cv2.waitKey(0)

結果はこんな感じ。良いですね。

ちなみに、赤の成分を取り出した時点の画像 (gray) はこうなっています。文字が読める程度に色は残っていますが、背景と比べると薄くなっていることが分かります。

こんな感じで色あせて赤色が抜けた看板は普通に見かける気がする…。

輪郭抽出

今度は、先ほど作成した白黒の2値画像から、物体の輪郭を抽出します。

cv2.findContours() を使えば輪郭抽出は簡単にできるので、その結果を画面に描画して確認してみましょう。

output = image.copy()

# 輪郭抽出

cnts = cv2.findContours(thresh.copy(), cv2.RETR_LIST, cv2.CHAIN_APPROX_SIMPLE)

cnts = imutils.grab_contours(cnts)

# 画像に輪郭を描画

for c in cnts:

cv2.drawContours(output, [c], -1, (0, 255, 0), 2)

cv2.imshow("Image", output)

cv2.waitKey(0)

なんか随分ぐちゃぐちゃですね…。

先ほどの2値画像に境界線を素直に引いた結果ではあるのですが、これでは使い勝手が悪いですし、ノイズの影響もあって変なところに線が出ていたりするので、もう少し改良しましょう。

輪郭の多角形近似

輪郭抽出の結果は点の集合になっていますが、最終的には輪郭は四角形(綺麗な長方形とは限りませんが)を想定しているので、多角形で近似した方がノイズの影響を小さくできてよいでしょう。

output = image.copy()

# 輪郭抽出

cnts = cv2.findContours(thresh.copy(), cv2.RETR_LIST, cv2.CHAIN_APPROX_SIMPLE)

cnts = imutils.grab_contours(cnts)

# 画像に輪郭を描画

for c in cnts:

# 輪郭を多角形で近似

epsilon = 0.1*cv2.arcLength(c,True)

c = cv2.approxPolyDP(c,epsilon,True)

cv2.drawContours(output, [c], -1, (0, 255, 0), 2)

cv2.imshow("Image", output)

cv2.waitKey(0)

看板の縁の部分の線がギザギザしていましたが、そのギザギザ感が取れて直線的になりましたね。

一方、背景の関係ないところに線が出る状況はそのままです。

小さい領域を削除

アドホックな方法ではありますが、ノイズから誤検出される領域は小さいことが多いので、面積が一定値未満の領域は表示しないようにします。

output = image.copy()

# 輪郭抽出

cnts = cv2.findContours(thresh.copy(), cv2.RETR_LIST, cv2.CHAIN_APPROX_SIMPLE)

cnts = imutils.grab_contours(cnts)

# 画像に輪郭を描画

for c in cnts:

# 輪郭を多角形で近似

epsilon = 0.1 * cv2.arcLength(c, True)

c = cv2.approxPolyDP(c, epsilon, True)

# 小さい領域を表示しない

area = cv2.contourArea(c)

if area < 400:

continue

cv2.drawContours(output, [c], -1, (0, 255, 0), 2)

cv2.imshow("Image", output)

cv2.waitKey(0)

形状の情報でフィルタリング

先ほどの例ではうまくいくのですが、他の画像を試すと変な輪郭が残ることがあります。

以下のように、画像の縁と屋根で囲まれた三角形の部分を検出してしまっています。

そこで、形状の情報を利用してフィルタリングしてみます。

マルフク看板の実物は「幅900mm × 高さ600mm」の長方形です。このとき、面積 $S$ と周囲の長さ $L$ の関係として

\frac{\sqrt S}{L} = \frac{\sqrt{900 \times 600}}{2 \times (900 + 600)} = \frac{\sqrt 6}{10} \approx 0.245

が成り立ちます。この値は幅と高さを同じ倍率で大きくしても変わりませんので、形状を表す特徴として使えそうです。2

output = image.copy()

# 輪郭抽出

cnts = cv2.findContours(thresh.copy(), cv2.RETR_LIST, cv2.CHAIN_APPROX_SIMPLE)

cnts = imutils.grab_contours(cnts)

# 画像に輪郭を描画

for c in cnts:

# 輪郭を多角形で近似

epsilon = 0.1 * cv2.arcLength(c, True)

c = cv2.approxPolyDP(c, epsilon, True)

# 小さい領域を表示しない

area = cv2.contourArea(c)

if area < 400:

continue

# 周囲の長さを計算

perimeter = cv2.arcLength(c, True)

# 輪郭が3:2の長方形に近い場合のみ表示

if perimeter == 0:

# ゼロ割り防止

continue

if 0.23 < area ** 0.5 / perimeter < 0.26: # approx sqrt(6)/10

cv2.drawContours(output, [c], -1, (0, 255, 0), 2)

cv2.imshow("Image", output)

cv2.waitKey(0)

これで右上の三角形の輪郭は消え、良い感じに看板の部分だけ残ります。

まだ形状しか見ていませんが、実際には枠の中の領域を取り出して物体検出(マルフク看板かどうか?)を実行することになるのでしょう。

2値化の閾値パラメータを与えないようにする

最初の方に出てきた以下のコードです。Rの値が160より大きいか小さいかで白と黒を塗り分けています。

thresh = cv2.threshold(blurred, 160, 255, cv2.THRESH_BINARY)[1]

少し考えれば分かるように、画像の明るさなどの条件によって最適な閾値は変化します。

OpenCVには、閾値を自動で決める方法として「大津の方法(大津の2値化)」3という有名な方法が実装されているので、試してみます。

# 大津の方法

thresh = cv2.threshold(blurred, 0, 255, cv2.THRESH_BINARY+cv2.THRESH_OTSU)[1]

結果はこちら。

自動でパラメータを決めることなしに輪郭を抽出できました。

電気メーターの部分に枠が出てしまっていますが、後で分類すればよいことにして、とりあえず目を瞑ります。。。

課題

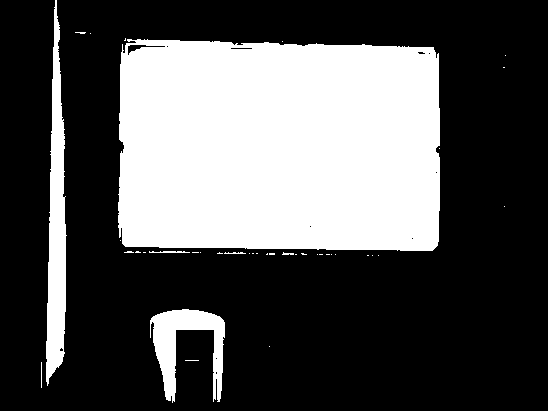

結構うまく動いているように見えますが、実はこんな画像をうまく処理できません。

小屋に貼られている白い板が実はマルフク看板です。皆様ご存知の通り(?)、放置されたマルフク看板はこんな感じで読めなくなってしまいます。しかし真っ白ならばむしろ検出には都合がよいはず。

ではなぜ白い領域に枠が出てこないかというと、2値化の結果

こうなってしまったからです。要するに背景のトタン板の色が明るいことが原因ですね。

この画像の場合、パラメータを適切に決めることができればうまくいきます。

# thresh = cv2.threshold(blurred, 0, 255, cv2.THRESH_BINARY+cv2.THRESH_OTSU)[1]

thresh = cv2.threshold(blurred, 190, 255, cv2.THRESH_BINARY)[1]

推測ですが、「大津の方法」では輝度のヒストグラムに「背景」と「物体」という2つのピークがあることを仮定しているため、明るいトタン板の色が「物体」側に取り込まれてしまったと考えられます。

他の画像を使った場合でも、うまくいったりいかなかったり。改善は今後の課題ですね。

コードまとめ

import argparse

import imutils

import cv2

# 引数解析

ap = argparse.ArgumentParser()

ap.add_argument("-i", "--image", required=True,

help="path to the input image")

args = vars(ap.parse_args())

# 画像読み込み

image = cv2.imread(args["image"])

gray = image[:, :, 2]

blurred = cv2.bilateralFilter(gray, 25, 15, 15)

# 大津の方法

thresh = cv2.threshold(blurred, 0, 255, cv2.THRESH_BINARY+cv2.THRESH_OTSU)[1]

cv2.imshow("Thresh", thresh)

cv2.waitKey(0)

output = image.copy()

# 輪郭抽出

cnts = cv2.findContours(thresh.copy(), cv2.RETR_LIST, cv2.CHAIN_APPROX_SIMPLE)

cnts = imutils.grab_contours(cnts)

# 画像に輪郭を描画

for c in cnts:

# 輪郭を多角形で近似

epsilon = 0.1 * cv2.arcLength(c, True)

c = cv2.approxPolyDP(c, epsilon, True)

# 小さい領域を表示しない

area = cv2.contourArea(c)

if area < 400:

continue

# 周囲の長さを計算

perimeter = cv2.arcLength(c, True)

# 輪郭が3:2の長方形に近い場合のみ表示

if perimeter == 0:

# ゼロ割り防止

continue

if 0.23 < area ** 0.5 / perimeter < 0.26: # approx sqrt(6)/10

cv2.drawContours(output, [c], -1, (0, 255, 0), 2)

cv2.imshow("Image", output)

cv2.waitKey(0)

以下のようにコマンドを実行すると動きます。

python marufuku.py -i image.png

まとめ

物体検出の初歩の初歩ではありますが、マルフク看板を題材に輪郭抽出だけ試してみました。

実際に使えるものにするには、背景色への頑健性も課題ですが、抽出した領域に対するクラス分類器の学習(データを集めて)も必要になってくると思います。

パラメータを全自動で決めることにこだわらず、目視確認しながらパラメータ調整しつつ領域を切り出して、Mask R-CNNなどの学習データを作る方針が良いのかな、などと考えています。

-

実は「円形度」を $4\pi$ で割って正の平方根をとったものと等しくなります。→円形度とは何? Weblio辞書 ↩

-

大津展之: 判別および最小2乗規準に基づく自動しきい値選定法, 電子通信学会論文誌 D, Vol. 63, No. 4, pp.349-356, 1980 ↩