概要

Attentionに関して、調べていて、以下の論文に出会った。

役立つかもしれない![]() ので、記事にする。

ので、記事にする。

Attention in Natural Language Processing

Galassi, Andrea, Marco Lippi, and Paolo Torroni. "Attention in natural language processing." IEEE Transactions on Neural Networks and Learning Systems (2020).

論文の概要

論文( https://arxiv.org/abs/1902.02181 )より引用

Attention is an increasingly popular mechanism used in a wide range of neural architectures. The mechanism itself has been realized in a variety of formats. However, because of the fast-paced advances in this domain, a systematic overview of attention is still missing. In this article, we define a unified model for attention architectures in natural language processing, with a focus on those designed to work with vector representations of the textual data. We propose a taxonomy of attention models according to four dimensions:therepresentation of the input, the compatibility function, the distribution function, and the multiplicity of the input and/or output. We present the examples of how prior information can be exploited in attention models and discuss ongoing research efforts and open challenges in the area, providing the first extensive categorization of the vast body of literature in this exciting domain.

DeepL訳(ママ)

注目は、様々なニューラルアーキテクチャで使用されるメカニズムとして、ますます普及しています。このメカニズム自体も様々な形式で実現されている。しかし、この分野では急速な進歩を遂げているため、注意についての体系的な概要はまだ明らかになっていない。この論文では、テキストデータのベクトル表現を扱うように設計されたものに焦点を当てて、自然言語処理における注意アーキテクチャのための統一モデルを定義する。本論文では、自然言語処理における注意アーキテクチャの統一モデルを提案する。事前情報がどのように注意モデルに利用されるかの例を示し、現在進行中の研究努力と未解決の課題について議論し、このエキサイティングな分野の膨大な文献を初めて広範に分類した。

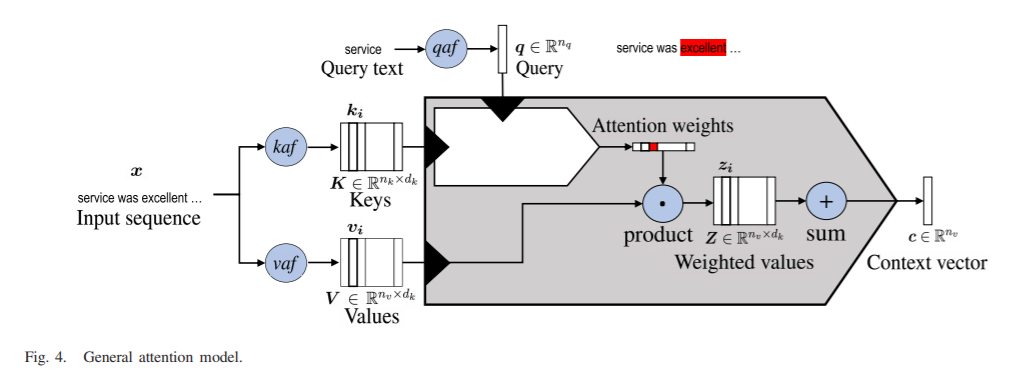

General Attention Model

「General Attention Model」というのが提案されていた。

(似てる、しかし、少し違うような、意味ある違いかなにかわからないような、そんなモデルが沢山あるので、このようなモデルの提示はGoodだと思う。)

まとめ

特にありません。

コメントなどあれば、お願いします。![]()

関連記事(本人)

この論文は、以下の記事の13番目の記事(※記事でなくて論文ですが、、)として、提示しています。