PFNが公開してくれている下記の画風の変換、とても面白いけど、サンプルを試すだけではどこまでチャンピオンデータなのかよくわからないので試してみた。

画風を変換するアルゴリズム | Preferred Research

結論

- 画風をスタイルから抽出して、対象に適用することが本当に出来ていることが実感できた。

- 特定のデータだけで再現しているわけではないことを確認できた。

- 使うモデル、スタイルの元画像によって結果が大きく変わった。チャンピオンな結果となるかどうかはこの辺りの依存度が大きいようだった。

再現は難しくなく、Deep Learningの高い能力を実感できてしまいました…

画風の特徴量抽出をマニュアルで行うのは困難だと思われるので、他のやり方でこのアルゴリズム以上の結果を出すのは相当難しいのでは、と思いました。

確認結果

著作権フリーの画像を入力し、画風が適用されていることを主観評価した。スタイルを適用する画像には、最近のポップな画像が欲しかったが、著作権フリーだと中々見つからない…そこで、Evernote/iPadを使ってあのキャラクターに似せようとした画像を手書きした。orz

※ VGG 16-layerのCNNモデルで生成。

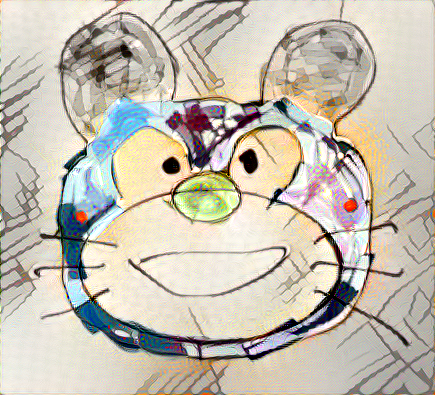

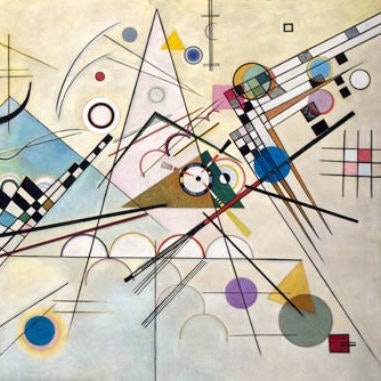

ケース1 〜 カンディンスキーのスタイル適用例

| スタイルの元画像 | 適用対象 |

|---|---|

カンディンスキー ≪ コンポジション Ⅷ ≫ 1923 ※右側を切り出し |

残念な落書きキャラクター orz

|

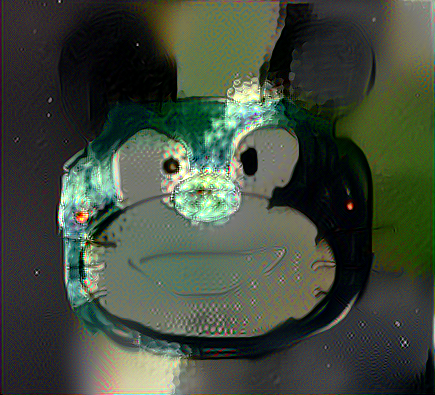

結果

色使いはもちろん、背景の細かいテクスチャや線の太さの使い方がかなり似たように見える。

ケース2 〜 ドガのスタイル適用例

| スタイルの元画像 | 適用対象 |

|---|---|

ドガ 【 スター 】 1878

|

残念な落書きキャラクター orz

|

結果

5,000回の繰り返しの結果、上のケースと違って途中経過のほうがそれらしい結果が出ていた。

画像の上半分、人物背景の特徴が反映されている様子があるような…。

| 2,500回時点 | 4,000回時点 | 最終画像 |

|---|---|---|

|

|

|

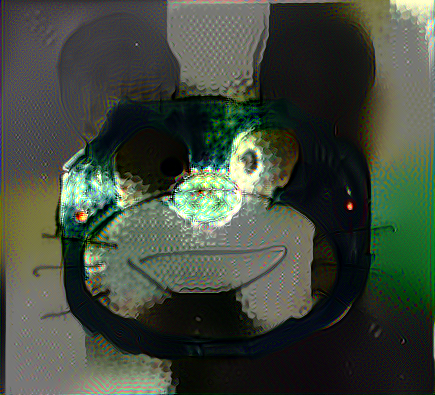

派生実験 〜 モデルにNINを使ったとき

4,000回時点の画像はこの通りで、このように使うモデルで結果がかなり違いました。

最後になりますが、成果を公開していただいたPreferred Research様に感謝致します。