はじめに

この投稿は AI-102: Microsoft Azure AI エンジニア の学習をした内容のメモです。

投稿の一覧は以下のリンク先にあります。

前の投稿

画像を分析する

Azure AI 画像分析には以下のような機能があります。

| 名前 | 説明 |

|---|---|

| タグ付け | 画像のコンテキストを表す場所や物の単語を出力 |

| 物体検出 | 画像に含まれる物体を画像内の座標と共に出力 |

| 画像分類 | 画像の内容に基づいて適切にラベル付けする |

| 人物検出 | 画像に含まれる人物の座標を出力 |

| キャプション生成 | 画像のキャプションを生成 |

カスタム コンピューター ビジョン モデルの作成

カスタム コンピューター ビジョン モデルを作成すると、自分で用意した画像によりモデルを訓練することができます。

例として、Github でサンプルとして公開されている 2 種類の葉っぱの画像を用意して、それらを分類する画像分類モデルを作成してみます。

| 名前 | 画像例 |

|---|---|

| Hemlock |  |

| Cherry |  |

あらかじめ Azure 上で Blob ストレージにコンテナを作成し、公開されているサンプル画像をアップロードしておきます。

以下の手順で行います。

- Azure 上で Azure AI サービスリソース、または Custom Vision リソースを作成

※ 以前の記事で作成したリソースを使用します。 - Vision Studio または Azure AI Foundry データセットを作成し、ラベル付け

- ラベル付けしたデータによって、モデルをトレーニング

以下で、2 の手順を順に見ていきます。

データセットの作成

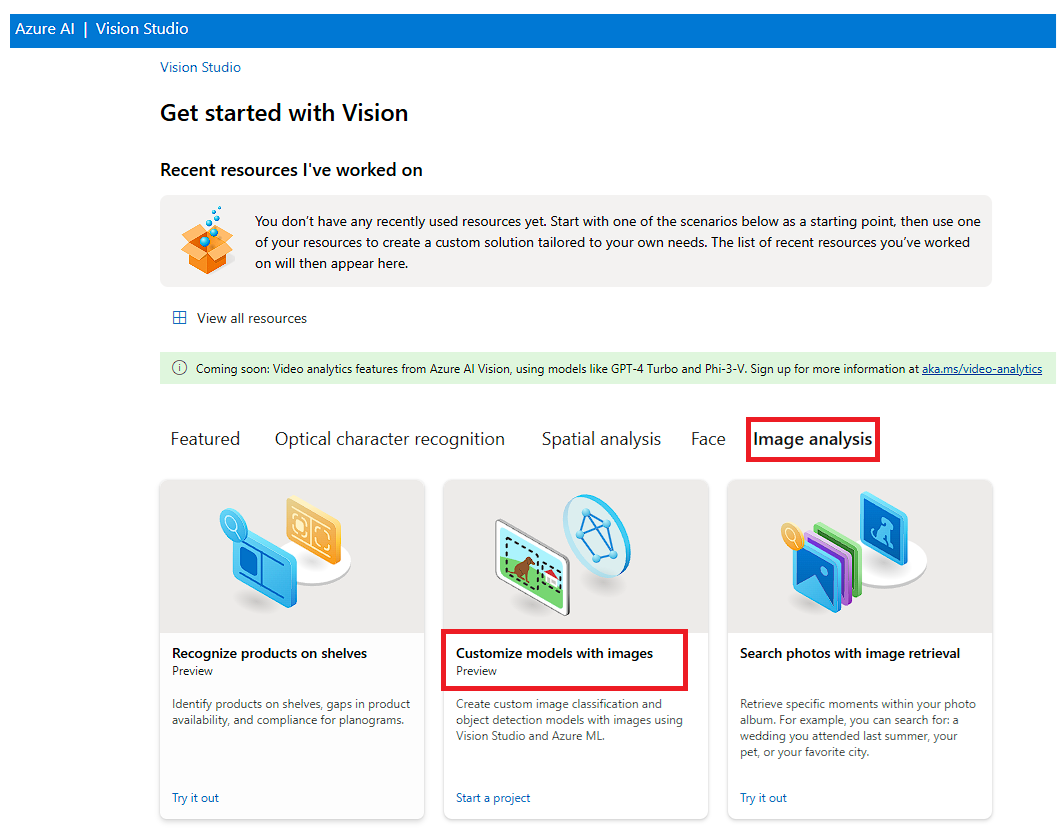

Vision Studio で画像分類プロジェクトを作成します。まず、使用する Azure AI サービスリソースを選択します。

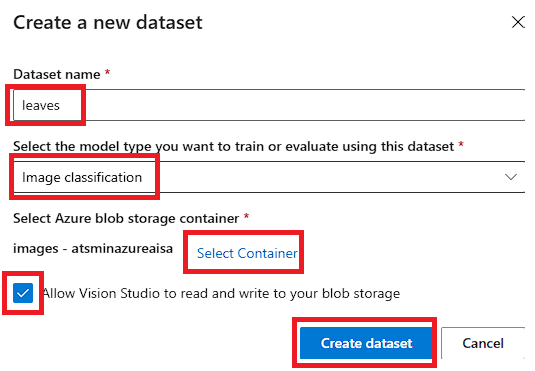

次に、データセットを作成します。データセットの作成時に、 画像ファイルをアップロードした Blob ストレージのコンテナを指定します。

データセットのラベル付け

サンプル画像をラベル付けします。今回は 2 種類の画像があるので "hemlock" または "cherry" とラベル付けします。

まず、プロジェクトとワークスペースを作成します。

次に、ラベルのカテゴリを指定します。ラベルとして "hemlock" と "cherry" を追加します。

最後に、各サンプル画像をラベル付けします。

カスタム画像モデルをトレーニングする

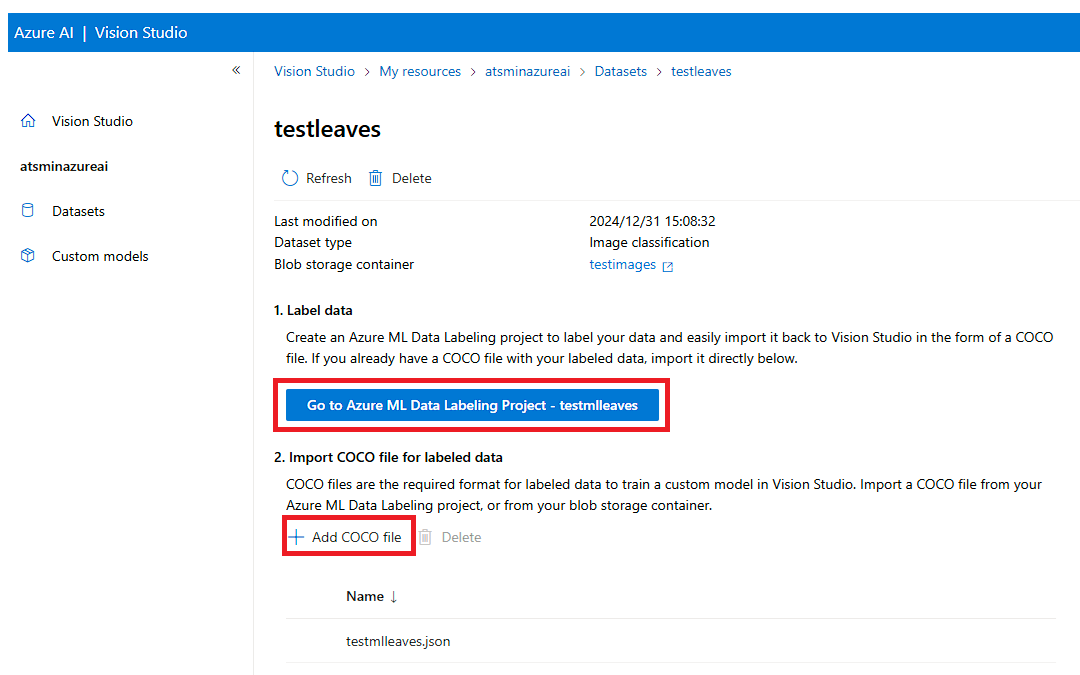

以下の画面で [+ Add COCO file] ボタンから、ラベル付けした結果をインポートします。

その後、[Custom Models] からモデルの作成を行います。

モデル作成の際は訓練に利用する最大時間を指定します。

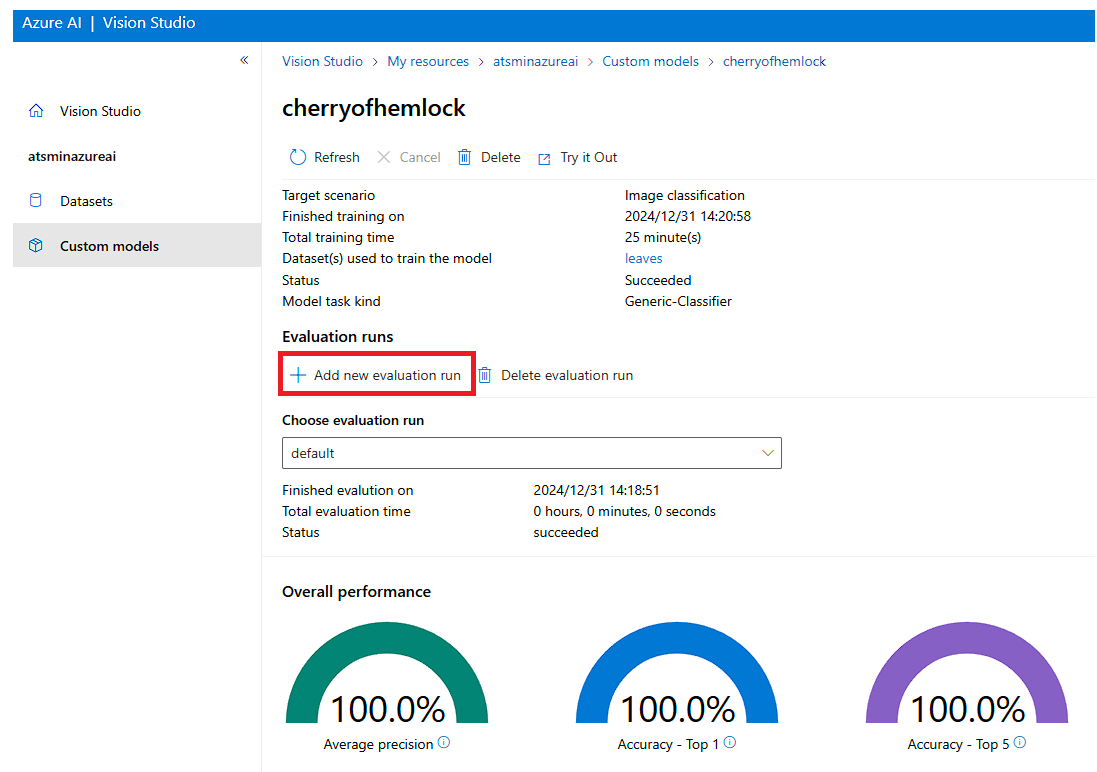

学習が完了すると、ステータスが Succeeded になります。

カスタム ビジョン モデルのメトリックを評価する

学習したモデルをテストするには、まず、同じ手順でテスト用のデータセットを作成します。

その後、テスト用のデータセットを指定してモデルの評価を実行します。

カスタム ビジョン モデルを使用する

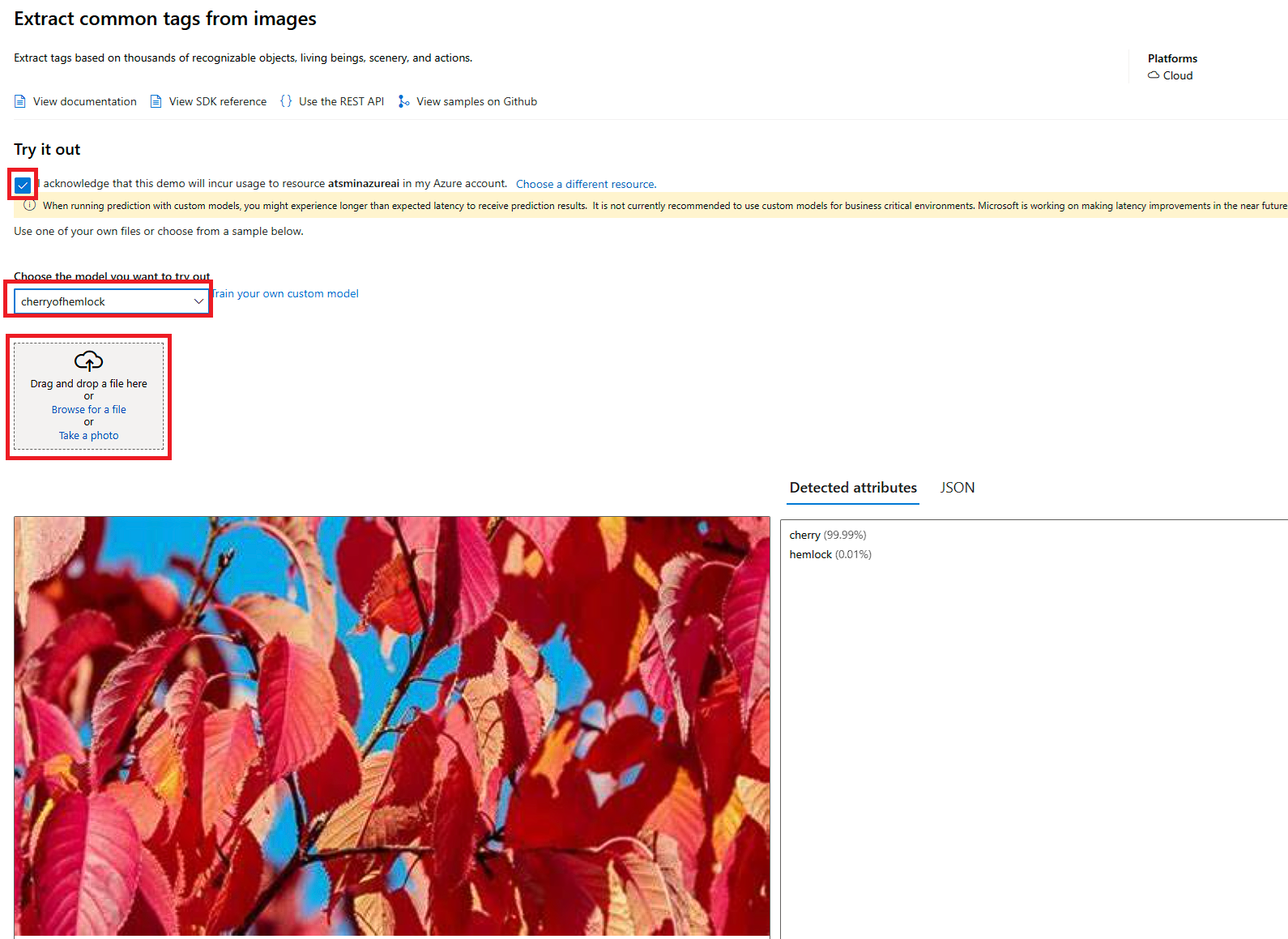

[Try it Out] ボタンから、作成したモデルをテストすることができます。画像をアップロードして応答を確認したり、モデルを使用するサンプルコードを確認することができます。

ビデオを分析する

Azure AI Video Indexer

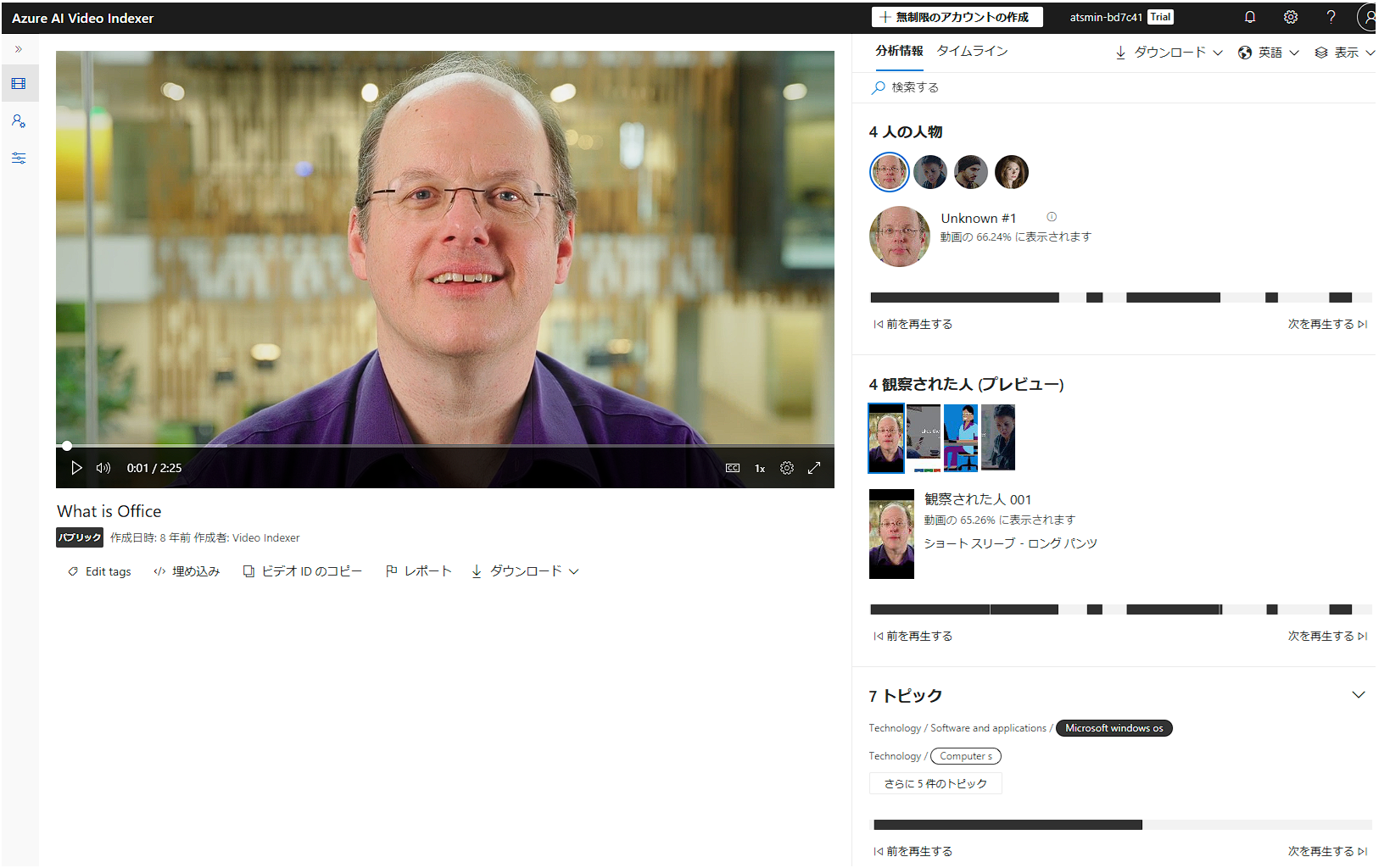

Azure AI Vision ではビデオの分析も行うことができます。 Azure AI Video Indexer を利用すると、ビデオの登場人物やトピックを抽出することができます。

Azure AI 空間分析

Azure AI 空間分析により、ビデオ内に人の移動を追跡する、といったこともできます。

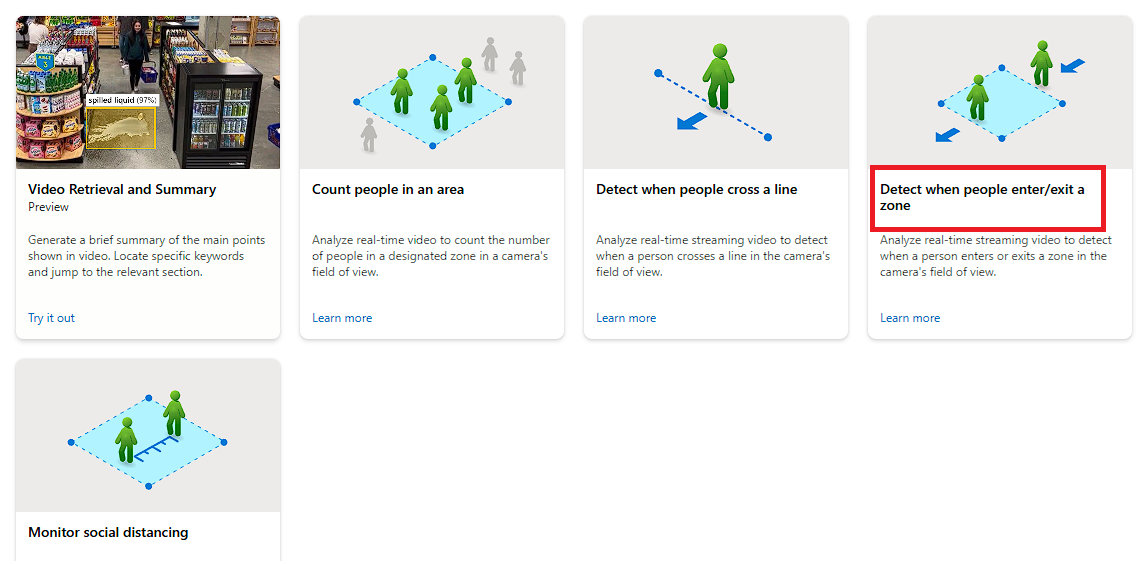

Vision Studioに用意されているサンプルデータで簡単に試すことができます。

人の出入りの分析

[Spatial analysis] - [Detect when people enter/exit a zone] を選択します。

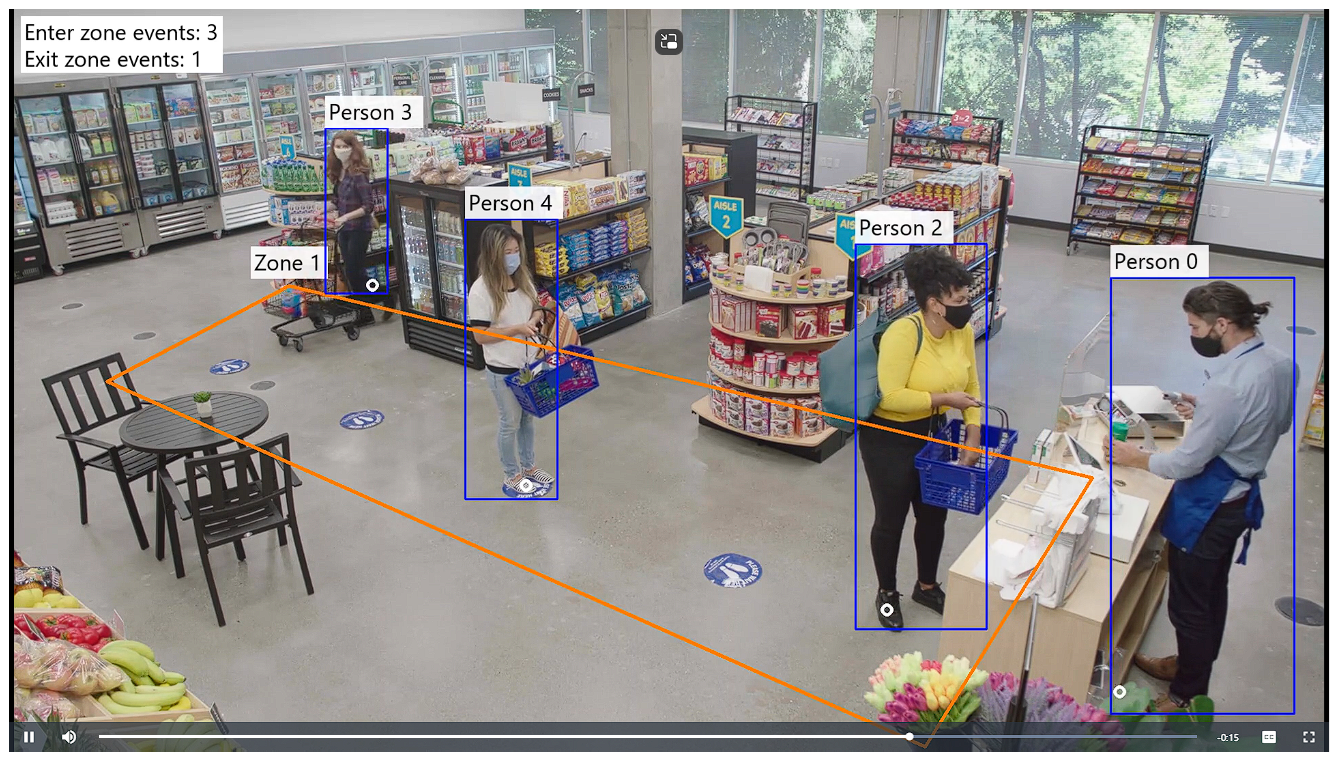

サンプルのビデオを選択すると、人物が検知されて、枠内の人数がカウントされていることが確認できます。

ビデオの要約

ビデオの内容をシーンごとに要約し、キーワードでビデオ内のシーンを検索することができます。

サンプルデータについて、キーワード検索によって一致するシーンを表示されることを確認できます。

次の投稿