本記事は下記の続きです。

経営、方針など

2015年のGoogle I/Oで、自社が提供するAndroid、Google Now、Google PhotoなどのサービスにAIや機械学習の技術を利用し始めていることを発表した1。また、10月の第3四半期決算発表では、CEOのSundar Pichai氏は機械学習と人工知能への投資が今後も同社の優先事項であると強調し、AIと機械学習をより多く取り入れるために、すべての製品を「再考」していると言及している2さらに、2016年4月に公開された株主へのレターにて、モバイルファーストからAIファーストの世界へ移行すると言及があるなど3、ますますAIの実用化に向けて注力する意向を示した。

We will move from mobile first to an AI first world.

Sundar Pichai, Google CEO in 20163

Distillation

機械学習モデルの性能を上げるため、異なるモデルのアンサンブルや大規模モデルを用いるなどの手法が取られるが、それらが獲得している知識を小規模なモデルへ移行するDistillation(蒸留)という手法を、2015年3月に発表した。

Distillationは、目的関数にSoft target(大規模モデルの出力との誤差)とHard target(正解ラベルとの誤差)の2種類の誤差を含ませることで小規模なモデルを学習させることで、同等の性能を発揮させるという手法である6。

Tensorflow

Google社内で用いられてきたニューラルネットワーク向けの機械学習開発システムであるDistBeliefは、設定や外部との連携の煩雑さなどから7、より多様なモデルへの対応、迅速なプロトタイピングと実験が可能なライブラリとして、Tensorflowが2015年11月にオープンソースで公開された8。

この時、Tensorflowは基盤がC++で構築されており、C++に加えてPythonでも利用可能な状態だった9。

AlphaGo

ボードゲームの中でもシステムが複雑な囲碁は、AIにとって大きな挑戦となると言われていた中、DeepMindはディープラーニングと高度な探索アルゴリズムを組み合わせたAIシステムであるAlphaGoが、2015年10月にヨーロッパチャンピオンだったFan Hui氏を(AlphaGo Fan)、2016年3月に世界チャンピオンだったLee Sedol氏を破った(AlphaGo Lee)。Fan Hui氏との対局での37手目で1万分の1の確率で使われる独創的な手(Move 37)、Lee Sedol氏との対局の78手目の“God’s Touch(神の手)”と言われる手(Move 78)は棋士にも非常に大きな衝撃を与えた10。

AlphaGoは、膨大な探索空間をより扱いやすいサイズに縮小するため、Policy NetworkとValue Networkという2種類のDNNと、Monte Calro Tree Search(MCTS、モンテカルロ木探索)を組み合わせている11。DNNとM CTSを組み合わせるというアプローチはAIの大きな進歩とされている12。

それぞれの特徴は下記の通り1113。

- Policy Network

- 次の手を予測し、探索範囲を絞り込み、賢明な手を提案

- 人間の専門家がプレイした3000万手を使って学習させ、強化学習により戦略を改善することで、自ら新しい戦略を発見することを学ぶ

- Value Network

- 探索木の深さを減らすため局面を評価し、最終的な勝者を予測

- Policy Networkを用いて学習する

- Monte Calro Tree Search

- 適当な回数ランダムに実行してみてその結果から結論を導くアルゴリズム

- 残りの局面を想像の中で何度も繰り返しプレイすることで先読みを行う

TPU

Googleは、2006年ごろからニューラルネットワーク向けASIC(Application-Specific Integrated Circuit)の開発を検討していたが、2013年ごろにデータセンターの数を倍増させる必要があると判断し、TPU(Tensor Processing Unit)と呼ばれる機械学習用途に特化したASICを開発した。通常であればASICの開発に数年かかるところ、約15ヶ月という短期間で設計から導入までが完了され、2016年に発表された1415。

重要要素(追記の可能性あり)

- Tensorflow Quantization

- processing system (CPU vs GPU vs TPU)

- Systolic Array (MXU)

GNMT

Google Brainは、従来のGoogle翻訳でも用いられており精度の限界が囁かれていたフレーズベースの翻訳システム16に変わる翻訳システムとして、Google Neural Machine Translation(GNMT)を開発し、翻訳エラーを 60%削減したと発表した17。

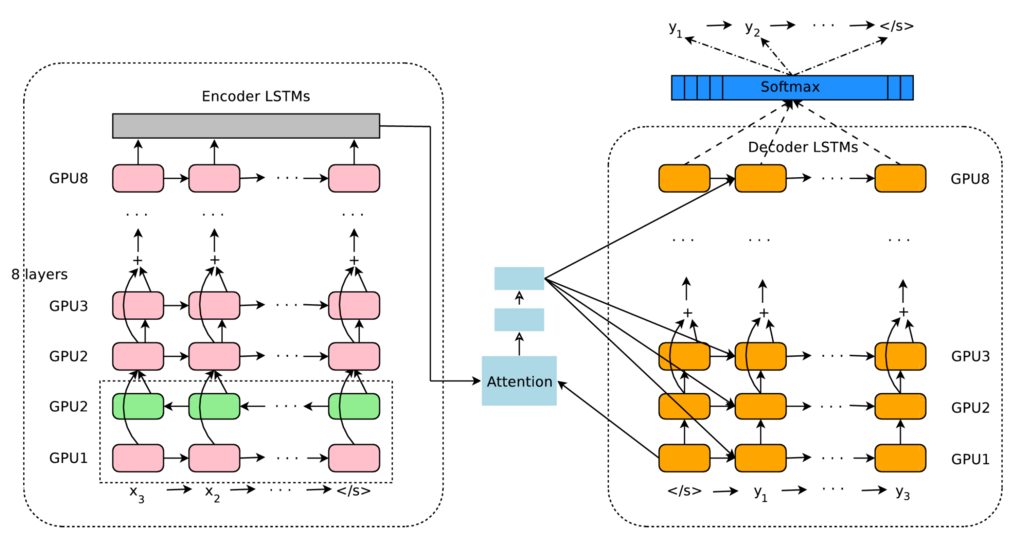

GNMTはSeq2Seqフレームワークにアテンションモジュールを加えたもの(Encoderネットワーク、Attentionモジュール、Decoderネットワーク)で構成されている。

- Encoderネットワーク

- 入力シンボル(wordpieces)ごとに1つのベクトルを持つベクトルのリストに変換

- LSTM(Long Short-Term Memory)

- Attentionモジュール

- デコーダーが単一の固定長ベクトルだけでなく、エンコーダーのすべての隠れ状態へアクセスできるようにすることで、長い入力シーケンスに効果的に対処する

- 翻訳生成の各ステップにおいて、モデルは原文の最も関連性の高い部分に動的に焦点を当てることができ

- Decoderネットワーク

- LSTM

- 翻訳された出力テキストを生成

- 特別な文末シンボル(EOS)が生成されるまで、一度に1つのシンボルを生成

続きはこちら

-

Google I/O 2015: Google bets machine learning can create an edge with Android, apps, cloud ↩

-

Google is 're-thinking' all of its products to include machine learning ↩

-

What is Google’s new company Alphabet and what does it mean for you? ↩

-

How TensorFlow Came To Be the Most Important Library in Machine Learning ↩

-

Google Just Open Sourced TensorFlow, Its Artificial Intelligence Engine ↩

-

AlphaGo: Mastering the ancient game of Go with Machine Learning ↩ ↩2

-

Monte Carlo Tree Search: a review of recent modifications and applications ↩

-

Google supercharges machine learning tasks with TPU custom chip ↩

-

An in-depth look at Google’s first Tensor Processing Unit (TPU) ↩

-

Phrase-Based Statistical Translation of Programming Languages ↩

-

Google's Neural Machine Translation System: Bridging the Gap between Human and Machine Translation ↩